1.本发明涉及服务器资源控制技术领域,尤其涉及一种绿色节能型服务器及其控制策略。

背景技术:

2.当前,随着云、分布式、虚拟化等技术的发展,多层级、分布式、多中心的服务体系架构已经普遍存在于公司、企业、政府等多种单位机构中。服务器在服务体系架构中扮演着重要的角色,并且会影响该体系架构的服务质量。因此,为了保障服务体系架构的稳定运行,运维人员需要通过对服务器进行监控的方式,时刻记录服务器资源的状态信息,

3.然而,随着服务体系架构的不断扩大,对服务器集群的运维和监管变得日益复杂。另外,由于服务器集群上的数据量巨大,服务器处于就绪状态,长时间处于就绪状态产生大量的能耗,造成资源极大的浪费。

技术实现要素:

4.本发明提供了一种绿色节能型服务器,支撑杆支撑在架体上,并通过多组安装隔板,间隔套设在支撑杆上,用于支撑服务器,能够起到减震作用,并通过设置服务器连接组件,监控并控制分配所述服务器的资源耗,起到节能作用。

5.第一方面,本发明实施例提供了一种绿色节能型服务器,包括:

6.架体;

7.支撑杆,其支撑在所述架体上;

8.多组安装隔板,其间隔套设在所述支撑杆上;

9.多组服务器,其可拆卸设置在所述安装隔板上;

10.服务器连接组件,其设置在所述安装隔板上,连接并监控所述服务器的能耗状态;

11.微控制器,其连接所述服务器连接组件,能够通过所述服务器连接组件,分配所述服务器的资源。

12.优选的是,所述支撑杆包括:

13.杆体,其为柱形;

14.多个弹性套筒,其间隔套设在所述杆体上,以支撑在所述安装隔板。

15.优选的是,所述服务器组件包括:

16.数据通信模块,其用于连接所述服务器,能够实现所述服务器之间的数据通信;

17.数据检测模块,其用于检测服务器的各项运行状态数据;

18.数据分析模块,其用于对所述数据检测模块检测到的运行状态数据进行统计分析。

19.第二方面,本发明实施例提供了一种绿色节能型服务器的控制策略,根据服务器工作模式建立服务器能耗模型,采集用户的阶段资源需求,从而预测服务器的阶段负载,并生成智能控制策略,以控制服务器运行模式,从而提高服务器的利用率,达到节能环保的效

果,包括:

20.实时监测所述服务器的运行状态数据,对所述数据检测模块检测到的运行状态数据进行统计分析;

21.筛选所述运行状态数据作为训练样本,并对所述训练样本进行预处理得到训练数据;

22.将所述训练数据进行分类,构建神经网络模型,得到训练完成的神经网络模型;

23.采集用户的阶段资源需求,并输入训练完成的神经网络模型,对所述服务器的阶段负载进行预测;

24.并根据所述阶段负载预测值,生成所述服务器的资源分配控制策略。

25.优选的是,所述运行状态数据包括:

26.系统信息,其包括服务器名、操作系统名称、用户数和负载量;

27.cpu信息,其包括cpu个数和cpu使用率;

28.内存类信息,其包括内存总量、空闲内存量、内存使用率、和缓存内存量;

29.网络信息,其包括网络发送速率、网络接收速率、网络发送字节数和网络接收字节数;

30.进程信息,其包括进程总数、线程总数、休眠进程数和终止进程数。

31.优选的是,对所述数据检测模块检测到的运行状态数据进行统计分析,其包括:

32.获取单位时间内各类运行状态数据;

33.对所述运行状态数据进行均值计算,得到多个状态均值;

34.并根据所述状态均值计算状态参数,进而计算得到服务器的阶段负载参数。

35.优选的是,所述神经网络模型的训练包括:

36.建立三层神经网络模型;

37.定义目标函数;

38.提取出所述训练数据中有效的隐藏特征;

39.调整模型参数,优化预测精度,直至模型内部参数收敛,满足所述目标函数。

40.优选的是,所述三层神经网络模型包括:

41.输入层,建立输入节点,所述输入节点关联用户阶段需求,并将其直接传导到下一层;

42.隐含层,其用于计算所述输入节点函数的激励值;

43.输出层,其采用线性计算确定神经网络的输出值,所述输出值为所述服务器的阶段负载参数。

44.优选的是,所述激励函数值采用sigmoid函数计算获得。

45.优选的是,所述根据所述阶段负载预测值,生成所述服务器的资源分配控制策略,其包括:

46.获取每组服务器的阶段负载参数,并按照负载参数值降序排列所述服务器;

47.设定最大负载阈值和最小负载阈值;

48.若任一组服务器负载参数大于所述最大负载阈值,将资源优先配备给排在队列尾的服务器。

49.有益效果

50.本发明提供了一种绿色节能型服务器,支撑杆支撑在架体上,并通过多组安装隔板,间隔套设在支撑杆上,用于支撑服务器,能够起到减震作用,并通过设置服务器连接组件,监控并控制分配所述服务器的资源耗,起到节能作用。

51.本发明还提供了一种绿色节能型服务器的控制策略,根据服务器工作模式建立服务器能耗模型,采集用户的阶段资源需求,从而预测服务器的阶段负载,并生成智能控制策略,以控制服务器运行模式,从而提高服务器的利用率,达到节能环保的效果。

附图说明

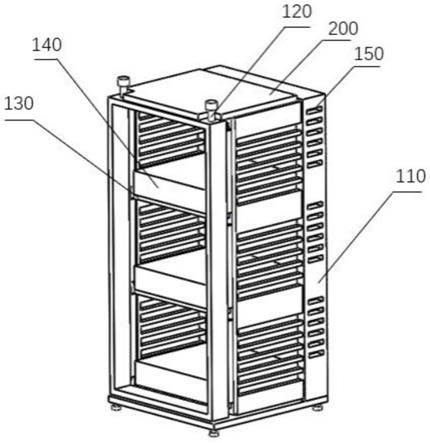

52.图1为本发明所述的绿色节能型服务器的结构示意图。

53.图2为本发明所述的支撑杆的结构示意图。

54.图3为本发明所述的服务器组件的结构示意图。

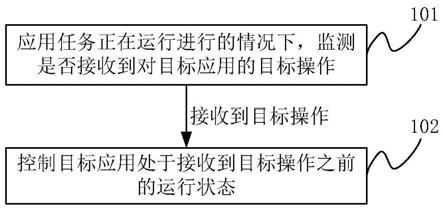

55.图4为本发明所述的绿色节能型服务器的控制策略流程图。

56.图5为本发明所示的神经网络模型的训练过程的流程图。

具体实施方式

57.以下由特定的具体实施例说明本发明的实施方式,熟悉此技术的人士可由本说明书所揭露的内容轻易地了解本发明的其他优点及功效,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

58.需要说明的是,在本发明的描述中,术语“中”、“上”、“下”、“横”、“内”等指示的方向或位置关系的术语是基于附图所示的方向或位置关系,这仅仅是为了便于描述,而不是指示或暗示所述装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本发明的限制。此外,术语“第一”、“第二”仅用于描述目的,而不能理解为指示或暗示相对重要性。

59.此外,还需要说明的是,在本发明的描述中,除非另有明确的规定和限定,术语“设置”、“安装”、“相连”、“连接”应做广义理解,例如,可以是固定连接,也可以是可拆卸连接,或一体地连接;可以是机械连接;可以是直接相连,也可以通过中间媒介间接相连,可以是两个元件内部的连通。对于本领域技术人员而言,可根据具体情况理解上述术语在本发明中的具体含义。

60.如图1所示,基于背景技术提出的技术问题,本发明提供了一种绿色节能型服务器,包括:架体110、支撑杆120、安装隔板130、服务器140、服务器连接组件150和微控制器200。

61.其中,支撑杆120支撑在架体110上;多组安装隔板130间隔套设在支撑杆120上;多组服务器140可拆卸设置在安装隔板130上;服务器连接组件150设置在安装隔板130上,连接并监控服务器140的能耗状态;微控制器200,其连接所述服务器连接组件,能够通过所述服务器连接组件,分配服务器的资源。其中,支撑杆120支撑在架体110上,并通过多组安装隔板130,用于支撑服务器140,能够起到减震作用,并通过设置服务器连接组件150,监控并控制分配服务器140的资源耗,起到节能作用。

62.如图2所示,支撑杆120包括:杆体121和多个弹性套筒122,杆体121为柱形;多个弹

性套筒122间隔套设在杆体121上,以支撑在安装隔板130。

63.作为一种优选,弹性套筒122采用橡胶海绵或弹簧制成。当服务器140安装在安装隔板130上,架体或服务器震动时安装隔板130沿支撑杆120滑动,以压缩弹性套筒122,弹性套筒122起到缓冲效果,起到减震作用。

64.如图3所示,服务器组件150包括:数据通信模块151、数据检测模块152和数据分析模块153。

65.其中,数据通信模块151用于连接服务器140,能够实现服务器之间的数据通信;数据检测模块152用于检测服务器的各项运行状态数据;数据分析模块153其用于对数据检测模块检测到的运行状态数据进行统计分析。

66.如图4所示,在一个优选实施例中,本发明还提供了一种绿色节能型服务器的控制策略,包括:

67.步骤s110、实时监测所述服务器的运行状态数据;对所述数据检测模块检测到的运行状态数据进行统计分析,其中,运行状态数据包括:

68.系统信息,其包括服务器名、操作系统名称、用户数和负载量;

69.cpu信息,其包括cpu个数和cpu使用率;

70.内存类信息,其包括内存总量、空闲内存量、内存使用率、和缓存内存量;

71.网络信息,其包括网络发送速率、网络接收速率、网络发送字节数和网络接收字节数;

72.进程信息,其包括进程总数、线程总数、休眠进程数和终止进程数。

73.在一个优选实施例中,运行状态数据与用户阶段资源需求相对应,因此可以在采集时设置程序建立运行状态数据和用户阶段资源需求的对应表或建立行状态数据和用户阶段资源需求的二维矩阵。

74.步骤s120、筛选运行状态数据作为训练样本,并对训练样本进行预处理得到训练数据,在一个优选实施例中,首先将样本进行分类,然后以该类中样本的均值来插补缺失值。

75.步骤s130、将训练数据进行分类,构建神经网络模型,得到训练完成的神经网络模型;

76.如图5所示,神经网络模型的训练包括:

77.步骤s131、建立三层神经网络模型,三层神经网络模型包括:

78.定义网络的第n层,在本实施例选用三层神经网络,n=3分别定义每一层的输入节点和输出节点,定义每一层的输入为net

n

,输出为out

n

;n=1,2,3。

79.输入层,建立输入节点,输入节点关联用户阶段需求re,并将其直接传导到下一层;out1=net1=re;

80.隐含层,其用于计算所述输入节点函数的激励值,作为一种优选,激励函数值采用sigmoid函数计算获得;

[0081][0082][0083]

其中,ω

1,i

为神经网络输入层与隐含层的第i个节点相连的权值,i=1,

…

m

…

m;m

为神经网络隐含层神经元的数目,λ为常数因子。

[0084]

输出层,其采用线性计算确定神经网络的输出值,所述输出值为所述服务器的阶段负载参数;

[0085][0086][0087]

其中,ω

2,i

为神经网络输出层与隐含层的第i个节点相连的权值。

[0088]

步骤s132、定义目标函数;

[0089][0090]

式中,v为目标函数,n为样本个数,u为实际控制时控制系统的实际控制量,u

n

为神经网络辨识器或神经网络补偿控制器的输出u1或u

c

。

[0091]

步骤s133、提取出所述训练数据中有效的隐藏特征;调整模型参数,优化预测精度,直至模型内部参数收敛,满足所述目标函数。

[0092]

其中,神经网络的学习目标为使目标函数做小,神经网络函数的训练过程如下:

[0093]

输出层的误差梯度量为:

[0094][0095]

目标函数的隐含层与输出层权向量ω2=(ω

2,1

…

ω

2,m

…

ω

2,m

)的梯度量为:

[0096][0097]

隐含层的误差梯度量为:

[0098][0099]

目标函数对输入层与隐含层的权向量ω1=(ω

1,1

…

ω

1,m

…

ω

1,m

)的梯度量为:

[0100][0101]

综合上述公式,得到神经网络参数的学习公式为:

[0102][0103][0104]

其中,η

ω1

、η

ω2

、μ

ω1

、μ

ω2

分别为网络参数的学习率与附加动能因子,且η

ω1

、η

ω2

、μ

ω1

、μ

ω2

∈(0,1)

[0105]

因此,基于神经网络辨识器与神经我昂罗反馈补偿控制器的在线学习,并根据控制系统当前时刻误差,对pid控制器的输出进行在线补偿。

[0106]

步骤s140、采集用户的阶段资源需求,并输入训练完成的神经网络模型,对所述服

务器的阶段负载进行预测;

[0107]

步骤s150、根据阶段负载预测值,生成服务器的资源分配控制策略。

[0108]

步骤s160、获取每组服务器的阶段负载参数,并按照负载参数值降序排列所述服务器;

[0109]

设定最大负载阈值和最小负载阈值;

[0110]

若任一组服务器负载参数大于所述最大负载阈值,将资源优先配备给排在队列尾的服务器。

[0111]

在一个优选实施例中,对数据检测模块检测到的运行状态数据进行统计分析,其包括:

[0112]

获取单位时间内各类运行状态数据;

[0113]

对所述运行状态数据进行均值计算,得到多个状态均值;

[0114]

并根据所述状态均值计算状态参数,进而计算得到服务器的阶段负载参数。

[0115]

本发明还提供了一种绿色节能型服务器的控制策略,根据服务器工作模式建立服务器能耗模型,采集用户的阶段资源需求,从而预测服务器的阶段负载,并生成智能控制策略,以控制服务器运行模式,从而提高服务器的利用率,达到节能环保的效果。

[0116]

至此,已经结合附图所示的优选实施方式描述了本发明的技术方案,但是,本领域技术人员容易理解的是,本发明的保护范围显然不局限于这些具体实施方式。在不偏离本发明的原理的前提下,本领域技术人员可以对相关技术特征做出等同的更改或替换,这些更改或替换之后的技术方案都将落入本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。