1.本发明涉及图像处理技术领域,特别是涉及一种多尺度通道注意力网络的图像纹理合成方法及系统。

背景技术:

2.纹理合成(texture synthesis)是指基于给定的小区域纹理样本,按照表面的几何形状,拼合生成任意大小的纹理图像,其目的是解决在纹理映射(texture mapping)中获得的图像大小有限等问题。目前纹理合成方法主要分为过程纹理合成(pts:procedural texture synthesis)和基于样图的纹理合成(tsfs:texture synthesis from sample)技术。pts通过对物体物理生成过程的仿真直接在表面上生成纹理,如云雾、树纹、羽毛等,但是需要反复测试,其结果有时也不尽如人意;tsfs通过给定样本图,提取它的纹理特征,生成大面积的纹理图像,该技术克服传统纹理映射的缺点,又避免了pts调整参数的繁琐,因而受到越来越多研究人员的关注,并逐渐成为计算机视觉的研究热点之一。丰富的纹理信息是展现图像细节的重要方面,会使图像拥有更强的信息表达能力,所以纹理合成具有应用和研究价值,如图像修复方面,若图像的非残缺部分中具有重复性、周期性的部分,则可以利用纹理合成方法推测出残缺部分的纹理,实现对图像的修复;动画生成方面,纹理合成技术可以缩短人们的工作量,每一帧动画可以由计算机生成,而不再是人为一帧一帧地用手画。除此之外,纹理合成技术也可以帮助提高其他计算机视觉任务的性能,比如图像超分辨率重建,图像风格迁移等。

3.随着计算机硬件和软件技术的发展,尤其是gpu的快速发展,深度学习已经广泛应用于纹理合成技术,推动了纹理合成的发展。在纹理合成公知的技术中,gates等利用卷积神经网络和图像的gram矩阵,通过梯度下降算法来进行纹理合成工作(<texture synthesis using convolutional neural networks,proceedings of the ieee conference on computer vision and pattern recognition,2015,arxiv:1505.07376>);jetchev等提出的sgan网络,将输入噪声分布空间从单个向量扩展到整个空间张量,并创建了一个非常适合纹理合成任务的生成对抗网络架构,它也是第一个无监督纹理合成算法(<texture synthesis with spatial generative adversarial networks,neurips,2016,arxiv:1611.08207>);bergmann等提出了psgan,该算法可以从一个或多个复杂的大型图像数据集学习多个纹理并获得很好的结果(<learning texture manifolds with the periodic spatial gan,international conference onmachine learning,2017,arxiv:1705.06566>);zhou等提出了使用gan网络进行非均匀纹理的合成算法,该方法结合了vgg网络计算风格损失来更好的约束纹理生成过程(<non

‑

stationary texture synthesis byadversarial expansion,acm transactions on graphics,2018,arxiv:1805.04487>);shaham等提出了singan,该算法从单幅图像学习生成模型,可应用于多种图像处理操作,如合成任意大小的纹理图像(<singan:learning a generative model from asingle natural image,ieee international conference on computer vision,2019,arxiv:

1905.01164>);huang等针对纹理合成过程中存在的离散化问题和耗时问题,提出了一种基于离散实例元素的纹理合成框架(<fasttexture synthesis for discrete example

‑

based elements,ieee access,2020,8(1):76683

‑

76691>);liu等提出一个自相似图,可以捕获给定纹理图像不同区域之间的相似和相关信息来进行纹理合成工作(<transposer:universal texture synthesis using feature maps as transposed convolution filter,corr abs,2020,arxiv:2007.07243>);解筱娜等提出一种按比例扩大图像的纹理合成方法,提高了图像的细节信息(<纹理合成的方法以及使用该方法的图像处理设备,发明专利,2018,cn107886476a>);袁飞虎等提出一种使用着色器将多个待合成纹理并行处理合成相应纹理的方法(<一种纹理合成的方法、装置及设备,发明专利,2018,cn108010095a>)。但采用上述公开方法生成的纹理图像存在局部失真或细节丢失的现象。

技术实现要素:

4.本发明的目的是提供一种多尺度通道注意力网络的图像纹理合成方法及系统,避免生成的纹理图像存在局部失真或细节丢失的现象。

5.为实现上述目的,本发明提供了一种多尺度通道注意力网络的图像纹理合成方法,所述方法包括:

6.步骤s1:获取噪声图像;

7.步骤s2:将所述噪声图像输入至生成器模型进行特征提取与融合,获得特征融合图像;所述生成器模型包括浅层特征提取模块、深层特征提取模块和融合生成模块;

8.步骤s3:给定样本纹理图像,并将所述样本纹理图像进行随机裁剪,获得训练集;所述训练集中包括多个经过裁剪后的图像块;

9.步骤s4:将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数优化生成器模型和判别器模型,获得多尺度通道注意力图像纹理合成模型;多尺度通道注意力图像纹理合成模型包括优化后的生成器模型和判别器模型;

10.步骤s5:将待合成纹理图像输入所述多尺度通道注意力图像纹理合成模型进行纹理合成,获得纹理合成图像。

11.可选地,所述将所述噪声图像输入至生成器模型进行特征提取与融合,获得特征融合图像,具体包括:

12.将所述噪声图像输入所述浅层特征提取模块进行浅层特征提取,获得第一特征图;

13.将所述第一特征图输入所述深层特征提取模块进行深层特征提取,获得第二特征图;

14.将所述第二特征图输入所述融合生成模块进行融合,获得特征融合图像。

15.可选地,所述将所述第一特征图输入所述深层特征提取模块进行深层特征提取,获得第二特征图,具体包括:

16.对所述第一特征图进行卷积及归一化处理后,获得第三特征图;

17.对所述第三特征图进行全局平均池化操作、多尺度操作以及拼接处理后,获得第二特征图。

18.可选地,所述将所述噪声图像输入所述浅层特征提取模块进行浅层特征提取,获

得第一特征图,具体计算公式为:

[0019][0020]

其中,l()表示子像素卷积运算,h()表示卷积运算和归一化计算,δ()表示relu激活函数,i

z

表示噪声图像,sfg

n

()表示第n个浅层特征生成单元对应的函数,e

n

表示经过n个浅层特征生成单元输出的第一特征图,e1表示经过1个浅层特征生成单元输出的特征图。

[0021]

可选地,所述对所述第一特征图进行卷积及归一化处理后,获得第三特征图,具体计算公式为:

[0022][0023]

其中,e

n

表示经过n个浅层特征生成单元输出的第一特征图,dp1()表示第二卷积层卷积运算、batchnorm归一化和relu激活函数运算,resnet

m

()表示第m个带有归一化的残差单元对应的函数,dp2()表示第三卷积层卷积运算和batchnorm归一化运算,s

m

表示经过m个带有归一化的残差单元输出的特征图,l()表示子像素卷积运算,s

up

表示依次经过m个归一化残差运算以及子像素卷积运算后获得的第三特征图。

[0024]

可选地,所述对所述第三特征图进行全局平均池化操作、多尺度操作以及拼接处理后,获得第二特征图,具体计算公式为:

[0025][0026]

其中,s

up

表示依次经过m个归一化残差运算以及子像素卷积运算后获得的第三特征图,avg()表示对输入全局平均池化操作,r()表示1

×

1卷积操作,γ()表示sigmoid激活函数,表示使用膨胀率为1的扩张卷积,表示使用膨胀率为2的扩张卷积,表示使用膨胀率为4的扩张卷积,表示使用膨胀率为6的扩张卷积,cat[]表示对四种扩张卷积的结果进行拼接操作,y表示经过全局平均池化、1

×

1卷积和sigmoid后输出的特征图,z表示特征图拼接后再经过1

×

1卷积运算输出的特征图,mul()表示矩阵相乘操作,x

i

表示经过多尺度通道注意力单元输出的第二特征图。

[0027]

可选地,所述将所述第二特征图输入所述融合生成模块进行融合,获得特征融合图像,具体计算公式为:

[0028]

i

m

=θ(r(x

i

))=f(i

z

);

[0029]

其中,x

i

表示经过多尺度通道注意力单元输出的第二特征图,f()表示特征融合图

像i

m

与噪声图像i

z

之间的映射关系,r()表示卷积操作,θ()表示tanh激活函数。

[0030]

可选地,所述将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数优化生成器模型和判别器模型,获得多尺度通道注意力图像纹理合成模型,具体包括:

[0031]

步骤s41:将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数计算损失值;

[0032]

步骤s42:判断所述损失值是否满足收敛条件;如果所述损失值满足收敛条件,则输出多尺度通道注意力图像纹理合成模型;如果不满足收敛条件,则重新返回“步骤s2”,继续优化生成器模型和判别器模型。

[0033]

本发明还提供一种多尺度通道注意力网络的图像纹理合成系统,所述系统包括:

[0034]

获取模块,用于获取噪声图像;

[0035]

特征提取与融合模块,用于将所述噪声图像输入至生成器模型进行特征提取与融合,获得特征融合图像;所述生成器模型包括浅层特征提取模块、深层特征提取模块和融合生成模块;

[0036]

裁剪模块,用于给定样本纹理图像,并将所述样本纹理图像进行随机裁剪,获得训练集;所述训练集中包括多个经过裁剪后的图像块;

[0037]

优化模块,用于将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数优化生成器模型和判别器模型,获得多尺度通道注意力图像纹理合成模型;多尺度通道注意力图像纹理合成模型包括优化后的生成器模型和判别器模型;

[0038]

纹理合成模块,用于将待合成纹理图像输入所述多尺度通道注意力图像纹理合成模型进行纹理合成,获得纹理合成图像。

[0039]

可选地,所述浅层特征提取模块包括:n个浅层特征生成单元,其中,n为大于或等于1的正整数;各所述浅层特征生成单元包括第一子像素卷积层、第一卷积层和第一归一化及函数激活层;所述第一归一化及函数激活层采用batchnorm归一化与relu激活函数;

[0040]

所述深层特征提取模块包括:m个带有归一化的残差单元、第二子像素卷积层和多尺度通道注意力单元;其中,m为大于或等于1的正整数;各所述带有归一化的残差单元包括:第二卷积层、第二归一化及函数激活层、第三卷积层和归一化层;所述第二归一化及函数激活层采用batchnorm归一化与relu激活函数;所述归一化层采用batchnorm归一化操作;

[0041]

所述多尺度通道注意力单元包括:全局平均池化层、第四卷积层、第一函数激活层、多尺度卷积层、拼接层、第五卷积层和乘积层;所述多尺度卷积层包括膨胀率为1的1

×

1的卷积核、膨胀率为2的3

×

3的卷积核、膨胀率为4的3

×

3的卷积核和膨胀率为6的3

×

3的卷积核;所述第一函数激活层采用sigmoid激活函数;

[0042]

所述融合生成模块包括:第六卷积层和第二函数激活层;所述第六卷积层采用3

×3×

3的卷积核,所述第二函数激活层采用tanh激活函数。

[0043]

根据本发明提供的具体实施例,本发明公开了以下技术效果:

[0044]

本发明公开一种多尺度通道注意力网络的图像纹理合成方法及系统,利用多尺度通道注意力图像纹理合成模型进行纹理合成后获得的纹理合成图像能够较好地恢复出任意大小的纹理细节信息,在视觉感知上具有优越性,避免存在局部失真或细节丢失的现象。

附图说明

[0045]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

[0046]

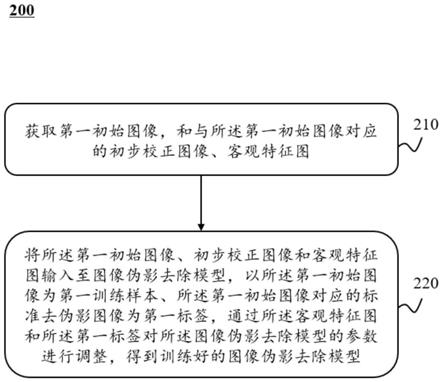

图1为本发明多尺度通道注意力网络的图像纹理合成方法流程图;

[0047]

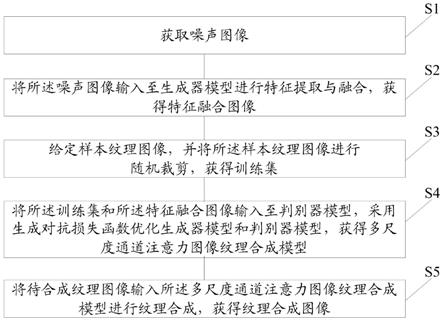

图2为本发明多尺度通道注意力网络的图像纹理合成系统结构图;

[0048]

图3为本发明生成器模型结构示意图;

[0049]

图4为本发明浅层特征生成单元结构示意图;

[0050]

图5为本发明带有归一化的残差单元结构示意图;

[0051]

图6为本发明多尺度通道注意力单元结构示意图;

[0052]

图7为本发明判别器网络结构示意图;

[0053]

图8为本发明与已有方法的主观效果对比图。

具体实施方式

[0054]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0055]

本发明的目的是提供一种多尺度通道注意力网络的图像纹理合成方法及系统,避免生成的纹理图像存在局部失真或细节丢失的现象。

[0056]

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

[0057]

实施例1

[0058]

如图1所示,本发明公开一种多尺度通道注意力网络的图像纹理合成方法,所述方法包括:

[0059]

步骤s1:获取噪声图像;所述噪声图像为带有周期噪声的图像。

[0060]

步骤s2:将所述噪声图像输入至生成器模型进行特征提取与融合,获得特征融合图像;所述生成器模型包括浅层特征提取模块、深层特征提取模块和融合生成模块。

[0061]

步骤s3:给定样本纹理图像,并将所述样本纹理图像进行随机裁剪,获得训练集;所述训练集中包括多个经过裁剪后的图像块。本实施例按照128

×

128进行随机裁剪。

[0062]

步骤s4:将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数优化生成器模型和判别器模型,获得多尺度通道注意力图像纹理合成模型。所述多尺度通道注意力图像纹理合成模型包括优化后的生成器模型和判别器模型。

[0063]

步骤s5:将待合成纹理图像输入所述多尺度通道注意力图像纹理合成模型进行纹理合成,获得纹理合成图像。

[0064]

下面对各个步骤进行详细论述:

[0065]

步骤s21:将所述噪声图像输入所述浅层特征提取模块进行浅层特征提取,获得第一特征图,具体计算公式为:

[0066][0067]

其中,l()表示子像素卷积运算,h()表示卷积运算和归一化计算,δ()表示relu激活函数,i

z

表示噪声图像,sfg

n

()表示第n个浅层特征生成单元对应的函数,e

n

表示经过n个浅层特征生成单元输出的特征图,即第一特征图,e1表示经过1个浅层特征生成单元输出的特征图。

[0068]

步骤s22:将所述第一特征图输入所述深层特征提取模块进行深层特征提取,获得第二特征图,具体包括:

[0069]

步骤s221:对所述第一特征图进行卷积及归一化处理后,获得第三特征图,具体计算公式为:

[0070][0071]

其中,e

n

表示经过n个浅层特征生成单元输出的第一特征图,dp1()表示第二卷积层卷积运算、batchnorm归一化和relu激活函数运算,resnet

m

()表示第m个带有归一化的残差单元对应的函数,dp2()表示第三卷积层卷积运算和batchnorm归一化运算,s

m

表示经过m个带有归一化的残差单元输出的特征图,l()表示子像素卷积运算,s

up

表示依次经过m个归一化残差运算以及子像素卷积运算后获得的特征图,即第三特征图。

[0072]

步骤s222:对所述第三特征图进行全局平均池化操作、多尺度操作以及拼接处理后,获得第二特征图,具体计算公式为:

[0073][0074]

其中,s

up

表示依次经过m个归一化残差运算以及子像素卷积运算后获得的第三特征图,avg()表示对输入全局平均池化操作,r()表示1

×

1卷积操作,γ()表示sigmoid激活函数,表示使用膨胀率为1的扩张卷积,表示使用膨胀率为2的扩张卷积,表示使用膨胀率为4的扩张卷积,表示使用膨胀率为6的扩张卷积,cat[]表示对四种扩张卷积的结果进行拼接操作,y表示经过全局平均池化、1

×

1卷积和sigmoid后输出的特征图,z表示特征图拼接后再经过1

×

1卷积运算输出的特征图,mul()表示矩阵相乘操作,x

i

表示经过多尺度通道注意力单元输出的特征图,即第二特征图。

[0075]

步骤s23:将所述第二特征图输入所述融合生成模块进行融合,获得特征融合图像,具体计算公式为:

[0076]

i

m

=θ(r(x

i

))=f(i

z

);

[0077]

其中,x

i

表示经过多尺度通道注意力单元输出的特征图,即第二特征图,f()表示特征融合图像i

m

与噪声图像i

z

之间的映射关系,r()表示卷积操作,θ()表示tanh激活函数。

[0078]

步骤s4:将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数优化生成器模型和判别器模型,获得多尺度通道注意力图像纹理合成模型,具体包括:

[0079]

步骤s41:将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数计算损失值。

[0080]

步骤s42:判断所述损失值是否满足收敛条件;如果所述损失值满足收敛条件,则输出多尺度通道注意力图像纹理合成模型;如果不满足收敛条件,则重新返回“步骤s2”,继续优化生成器模型和判别器模型。

[0081]

本实施例中提到的收敛条件为小于设定阈值,或者为与相邻两次损失值之间的差值在某一设定范围内。

[0082]

生成对抗损失函数具体公式为:

[0083][0084]

其中,l

gen

表示生成对抗损失函数计算的损失值,表示生成器模型,表示判别器模型,i

z

表示噪声图像,x表示对样本纹理图像裁剪得到的训练集,表示最小化生成器模型,表示最大化判别器模型,n表示训练样本的个数。

[0085]

实施例2

[0086]

如图2所示,本发明还提供一种多尺度通道注意力网络的图像纹理合成系统,所述系统包括:

[0087]

获取模块201,用于获取噪声图像。

[0088]

特征提取与融合模块202,用于将所述噪声图像输入至生成器模型进行特征提取与融合,获得特征融合图像;所述生成器模型包括浅层特征提取模块、深层特征提取模块和融合生成模块。

[0089]

裁剪模块203,用于给定样本纹理图像,并将所述样本纹理图像进行随机裁剪,获得训练集;所述训练集中包括多个经过裁剪后的图像块。本实施例按照128

×

128进行随机裁剪。

[0090]

优化模块204,用于将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数优化生成器模型和判别器模型,获得多尺度通道注意力图像纹理合成模型;多尺度通道注意力图像纹理合成模型包括优化后的生成器模型和判别器模型。

[0091]

纹理合成模块205,用于将待合成纹理图像输入所述多尺度通道注意力图像纹理合成模型进行纹理合成,获得纹理合成图像。

[0092]

如图3所示,所述生成器模型包括浅层特征提取模块、深层特征提取模块和融合生成模块。所述浅层特征提取模块包括:4个浅层特征生成单元,分别为sfg1、sfg2、sfg3和sfg4;所述深层特征提取模块包括:3个带有归一化的残差单元、第二子像素卷积层sub

‑

pixel conv和多尺度通道注意力单元ese;3个带有归一化的残差单元分别为resnet1、

resnet2和resnet3。噪声图像经过第1个浅层特征生成单元后输出的特征图为e1,经过第2个浅层特征生成单元后输出的特征图为e2,经过第3个浅层特征生成单元后输出的特征图为e3,经过第4个浅层特征生成单元后输出的特征图为e4(又称第一特征图),经过第1个带有归一化的残差单元后输出的特征图为s1,经过第2个带有归一化的残差单元后输出的特征图为s2,经过第3个带有归一化的残差单元后输出的特征图为s3,经过第二子像素卷积层后输出的特征图为s

up

,经过多尺度通道注意力单元ese后输出的特征图为第二特征图,经过融合生成模块后输出的特征图为特征融合图像i

m

。

[0093]

如图4所示,各所述浅层特征生成单元包括第一子像素卷积层sub

‑

pixel conv、第一卷积层conv和第一归一化及函数激活层;所述第一归一化及函数激活层采用batchnorm归一化与relu激活函数;第一卷积层conv采用5

×

5的卷积核;所述第一子像素卷积层使用放大因子为2的子像素卷积层。

[0094]

如图3所示,将所述噪声图像依次输入多个浅层特征生成单元进行浅层特征提取,获得第一特征图,具体计算公式为:

[0095][0096]

其中,l()表示子像素卷积运算,h()表示卷积运算和归一化计算,δ()表示relu激活函数,i

z

表示噪声图像,sfg

n

()表示第n个浅层特征生成单元对应的函数,e

n

表示经过n个浅层特征生成单元输出的第一特征图,e1表示经过1个浅层特征生成单元输出的特征图。此公式中的n为4。

[0097]

所述深层特征提取模块包括:3个带有归一化的残差单元、第二子像素卷积层sub

‑

pixel conv和多尺度通道注意力单元ese;如图5所示,各所述带有归一化的残差单元包括:第二卷积层、第二归一化及函数激活层、第三卷积层和归一化层;所述第二归一化及函数激活层采用batchnorm归一化与relu激活函数;所述归一化层采用batchnorm归一化操作;所述第二卷积层采用5

×

5的卷积核,所述第三卷积层采用5

×

5的卷积核,第二子像素卷积层使用放大因子为2的子像素卷积层。

[0098]

计算第三特征图的具体计算公式为:

[0099][0100]

其中,e

n

表示经过n个浅层特征生成单元输出的第一特征图,dp1()表示第二卷积层卷积运算、batchnorm归一化和relu激活函数运算,表示经过第二卷积层卷积运算、batchnorm归一化和relu激活函数运算后输出的特征图,resnet

m

()表示第m个带有归一化的残差单元对应的函数,dp2()表示第三卷积层卷积运算和batchnorm归一化运算,s

m

表示经过m个带有归一化的残差单元输出的特征图,l()表示子像素卷积运算,s

up

表示依次经过m个归一化残差运算以及子像素卷积运算后获得的特征图,即第三特征图。

[0101]

如图6所示,所述多尺度通道注意力单元包括:全局平均池化层avg_pool、第四卷积层、第一函数激活层、多尺度卷积层、拼接层、第五卷积层和乘积层;所述多尺度卷积层包括膨胀率为1的1

×

1的卷积核、膨胀率为2的3

×

3的卷积核、膨胀率为4的3

×

3的卷积核和膨胀率为6的3

×

3的卷积核;所述第一函数激活层采用sigmoid激活函数;所述第四卷积层和所述第五卷积层均采用1

×

1的卷积核。

[0102]

将第三特征图s

up

输入多尺度通道注意力单元,通过设置不同的膨胀率实现多尺度操作,另外将输入的第三特征图通过全局平均池化经过sigmoid函数激活后得到带有注意力权值的特征向量,与通过多尺度扩张卷积提取的不同区域的特征图矩阵相乘,得到带有通道权值的特征图,即第二特征图。

[0103]

计算第二特征图的具体计算公式为:

[0104][0105]

其中,s

up

表示依次经过m个归一化残差运算以及子像素卷积运算后获得的第三特征图,avg()表示对输入全局平均池化操作,r()表示1

×

1卷积操作,γ()表示sigmoid激活函数,表示使用膨胀率为1的扩张卷积,表示使用膨胀率为2的扩张卷积,表示使用膨胀率为4的扩张卷积,表示使用膨胀率为6的扩张卷积,cat[]表示对四种扩张卷积的结果进行拼接操作,y表示经过全局平均池化、1

×

1卷积和sigmoid后输出的特征图,z表示特征图拼接后再经过1

×

1卷积运算输出的特征图,mul()表示矩阵相乘操作,x

i

表示经过多尺度通道注意力单元输出的特征图,即第二特征图。

[0106]

本发明多尺度通道注意力单元在融合注意力权值前引入多尺度卷积层进行多尺度卷积操作,扩大网络的感受野,使网络能够利用更多的上下文信息,提取图像更多的高频细节信息。本发明将提取浅层特征后的第一特征图即e4输入到深层特征提取模块进行深层特征提取,以使提取出更具有代表性的图像特征。另外将第一特征图e4经过三层残差模块与一层子像素卷积操作后输入多尺度通道注意力模块,进而提高网络的表达能力。

[0107]

如图3所示,所述融合生成模块包括:第六卷积层和第二函数激活层,所述第六卷积层采用3

×3×

3的卷积核,所述第二函数激活层采用tanh激活函数。

[0108]

在模型的融合生成过程中,通过一个尺寸为3

×3×

3的卷积核对融合后的特征图x

i

进行细化并恢复到原始的图像通道数,再经过tanh激活函数减少生成图像的噪声点得到融合特征图像i

m

,具体计算公式为:

[0109]

i

m

=θ(r(x

i

))=f(i

z

);

[0110]

其中,x

i

表示经过多尺度通道注意力单元输出的特征图,即第二特征图,f()表示特征融合图像i

m

与噪声图像i

z

之间的映射关系,r()表示卷积操作,θ()表示tanh激活函数。

[0111]

本发明将生成器模型生成的融合特征图像输入判别器模型,由判别器模型通过交叉熵损失计算网络生成的融合特征图像与输入的样本纹理图像之间的差异,最小化该差异得到模型参数的最优解,本发明使用对抗损失优化网络模型,更新参数。如图7所示,本发明

判别器模型包括卷积 函数激活层conv leakyrelu、3个卷积 bn 函数激活层conv bn leakyrelu、卷积层conv和函数激活层;卷积 函数激活层中采用leakyrelu激活函数,卷积 bn 函数激活层conv bn leakyrelu采用leakyrelu激活函数,函数激活层采用sigmoid激活函数。

[0112]

作为一种可选的实施方式,所述优化模块204包括:

[0113]

损失值计算单元,用于将所述训练集和所述特征融合图像输入至判别器模型,采用生成对抗损失函数计算损失值。

[0114]

判断单元,用于判断所述损失值是否满足收敛条件;如果所述损失值满足收敛条件,则输出多尺度通道注意力图像纹理合成模型;如果不满足收敛条件,则重新返回“特征提取与融合模块202”,继续优化生成器模型和判别器模型。本实施例中提到的收敛条件为小于设定阈值,或者为与相邻两次损失值之间的差值在某一设定范围内。

[0115]

对抗损失通过对生成器模型和判别器模型交替迭代训练对参数进行优化,但是一切损失计算都是在处产生,而的输出一般是0或1,所以采用二进制交叉熵计算损失,对抗损失包含两部分,分别是最小化生成器和最大化判别器因此生成对抗损失函数具体公式为:

[0116][0117]

其中,l

gen

表示生成对抗损失函数计算的损失值,表示生成器模型,表示判别器模型,i

z

表示噪声图像,x表示对样本纹理图像裁剪得到的训练集,表示最小化生成器模型,表示最大化判别器模型,n表示训练样本的个数。

[0118]

本发明公开的浅层特征提取模块包含四个全卷积层和四个子像素卷积层,扩大特征图的尺寸并提高分辨率,采用5

×

5的卷积核提取图像低级特征,利用归一化及函数激活层使网络模型更好的学习训练数据的分布;另外,带有归一化的残差单元即在基本残差单元中增加归一化操作,防止梯度消失或爆炸,进一步使网络模型更好的学习训练数据的分布;通过残差单元后生成的特征图再次进入子像素卷积层,进一步扩大特征图的尺寸,并提高分辨率,扩大网络的感受野。本发明多尺度通道注意力单元由四个不同大小的扩张卷积提取图像的多尺度信息并进行特征拼接,从而获得图像更多不同区域的高频细节信息,另一方面输入特征图由全局平均池化后经过sigmoid激活函数获取图像通道注意力权重,最后将带有通道注意力权值的特征图与拼接后的多尺度信息进行融合,得到图像的深层特征;通过引入多尺度扩张卷积来扩大网络感受野的同时关注通道注意力权重,通过残差连接能够充分利用图像的上下文和通道信息,从而提高网络生成图像的性能,通过调整输入噪声图像的尺寸,生成任意大小的纹理图像,避免出现生成的纹理图像存在局部失真或细节丢失的现象。

[0119]

实施例3

[0120]

为了验证本发明的有效性,使用多张图像进行测试,在描述纹理数据集(describable textures dataset)中进行对比实验,并与psgan方法以及singan方法生成的纹理图像进行对比,结果如图8所示。

[0121]

将利用本发明公开的方案获得的结果与psgan方法对比,可以看出,psgan生成的结果缺乏纹理细节信息,图像较为平滑,在纹理连接处易出现扭曲。将利用本发明公开的方案获得的结果与singan方法对比,singan合成与输入相同大小纹理时结果清晰、细节丰富,当使用放大因子为1.5倍时,合成的样本纹理细节丢失并出现较大扭曲,而本发明公开的方案能够较好地恢复出任意大小的纹理细节信息,在视觉感知上具有优越性,避免存在局部失真或细节丢失的现象。

[0122]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0123]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。