1.本发明属于计算机视觉技术领域,具体为一种结合特征点和锚框共同预测和回归的目标检测算法。

背景技术:

2.目标检测旨在对一张给定的输入图像,定位图像上包含的目标并对其进行分类。由于其在城市安防、遥感图像、医学诊断等领域有着广泛的应用,目前已经成为计算机视觉领域中的一个热门研究课题,随着最近几年深度学习在计算机视觉领域的快速发展,基于深度学习的目标检测算法得到了广泛的研究和应用。

3.目前常见的基于深度学习的目标检测算法框架可以分为:特征提取模块,特征融合模块和特征检测模块。特征提取模块利用卷积神经网络提取图像的不同层级的特征;特征融合模块对不同层级的特征进行融合,因为通常深层特征包含较为丰富的语义信息,浅层特征包含较为丰富的空间信息;特征检测模块对融合后的特征进行检测任务,以得到图像包含的目标信息。

4.现有的目标检测算法根据特征检测模块的不同分为两类,一类是基于特征点检测的算法,一类是基于锚框检测的算法。但是基于锚框检测的算法需要手工设计锚框的尺寸,对于同一数据集,不同的锚框尺寸对检测的精度影响很大,因此带来了两个问题,一个是锚框尺寸参数的确定;另一个是模型的泛化能力,即当训练好的模型迁移到另一个数据集上时原有的锚框尺寸可能会不匹配。

5.本发明提出了一种新的结合特征点和锚框共同预测和回归的目标检测算法,利用特征点来获得更加精确的锚框,使得算法不需要根据特定的数据集来设置不同的锚框尺寸,提高算法的泛化能力。

技术实现要素:

6.为了克服现有基于锚框的目标检测算法的不足(锚框的尺寸需要根据经验手工设计,并且不同的数据集锚框的尺寸要求不一致等),本发明提出一种结合特征点和锚框共同预测和回归的目标检测算法,使得网络在训练的过程中可以通过特征点来自动学习获得更加精准的锚框,从而提高检测精度。

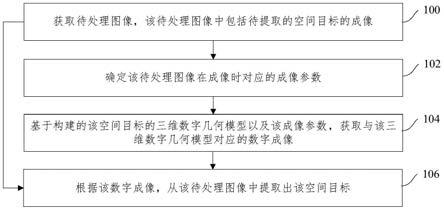

7.本发明提出的结合特征点和锚框共同预测和回归的目标检测算法,具体步骤如下:步骤1.获取并处理数据集,具体过程为:(1.1)使用目标检测数据集mscoco,构建对应的图像信息标签,组成图像

‑

目标标签样本对;(1.2)利用图像增强对输入图片进行预处理,以扩充数据集和增加样本的随机性;步骤2.根据算法搭建目标检测神经网络,分为特征提取模块、特征融合模块、关键点预测分支和锚框预测分支四个部分;特征提取模块用于提取图像上的目标特征,由多个

残差模块构成,根据网络的大小需求可更改残差模块的数量;特征融合模块分两次进行,第一次对深层特征进行递归上采样与浅层特征融合,第二次对第一次融合后的浅层特征进行递归下采样与深层特征融合;关键点检测分支利用第一次特征融合后的特征进行关键点检测,预测输出锚框并对其进行前景背景分类;锚框检测分支利用关键点检测分支输出的锚框进行检测,以得到最终的检测结果;步骤3. 训练检测神经网络;利用步骤1得到的训练集和步骤2搭建好的网络来训练模型,通过梯度反向传播算法更新参数,直至网络收敛;步骤4.网络收敛后进入测试阶段,输入待检测图像即可输出图像包含的目标信息(包括类别和坐标)。

8.本发明可以通过更加精准的锚框来提高检测的精度,并且模型具有更好的泛化性能。

具体实施方式

9.本发明中,采用提出的结合特征点和锚框共同预测和回归的目标检测算法模型,用于目标检测网络的训练,该算法的具体如下。

10.1.对目标检测数据集mscoco进行预处理。首先读取数据标签,得到图像

‑

目标标签信息样本对。然后对训练集图片进行随机翻转、随机缩放处理来扩充样本的多样性。

11.2.搭建目标检测卷积神经网络,分为特征提取模块、特征融合模块、关键点预测分支和锚框预测分支四个部分。其中:特征提取模块用于提取图像上的目标特征,由多个残差模块构成,根据网络的大小需求可更改残差模块的数量;特征融合模块分两次进行融合,第一次对深层特征进行递归上采样与浅层特征融合,第二次对第一次融合后的浅层特征进行递归下采样与深层特征融合;关键点检测分支利用第一次特征融合后的特征进行关键点检测任务,预测输出锚框并对其进行前景背景分类,其具体由4个卷积层构成,前三个卷积层每个都有256个卷积核,最后一个卷积层有5个卷积核,即关键点检测分支输出通道数为5,第一个通道代表该目标为前景的概率,第2到5个通道代表目标的中心点坐标(x,y)和长宽(w,h);锚框检测分支利用关键点检测分支输出的锚框进行检测任务,以得到最终的检测结果,其具体也由4个卷积层构成,前三个卷积层每个都有256个卷积核,最后一个卷积层有(c 4)个卷积核,c表示训练集的目标总类别数,第1到第c个通道表示目标分别为该种类的概率,最后4个坐标表示中心点坐标和长宽相对于锚框的偏移值。

12.3.训练目标检测网络,具体步骤如下:3.1初始化网络参数,特征提取模块采用在imagenet上预训练好的分类网络模型的参数初始化,其余部分采用kaiming初始化;3.2学习率初始化为0.01,每当训练时的损失函数值不在下降时,学习率降低为之前的十分之一;3.3 将训练集图片输入网络训练,关键点检测分支得到预测的锚框;锚框预测分支根据预测的相对偏移量得到最终的目标坐标框;3.4分别对关键点检测分支输出的锚框和锚框预测分支输出的目标坐标框与真实

框求损失,损失函数采用giou,并且同时求分类损失,损失函数采用focal loss;然后通过梯度反向传播算法对网络参数进行优化更新,网络训练的优化器选择sgd,其中参数设置为momentum=0.9;3.5重复上述步骤3.3

‑

3.4,在训练集上迭代24个epoch(192k次),网络收敛,得到训练好的模型。

13.4.测试阶段,将待检测的图片输入到训练好的网络中,关键点检测分支得到预测的锚框坐标和其对应为前景的概率p1;锚框检测分支得到相对于锚框的偏移量和其对应为某一具体目标种类的概率p2;最终根据锚框坐标和偏移量计算得到最终的目标坐标信息,并且将概率p1*p2作为该目标为某一目标种类的真实概率值。

14.参考文献[1]zhi tian, tong he, chunhua shen, and youliang yan.

ꢀ“

fcos: fully convolutional one

‑

stage object detection,

”ꢀ

in proc. ieee int. conf. comp. vis., 2019[2]s. ren, k. he, r. girshick, and j. sun. faster rcnn:towards real

‑

time object detection with region proposal networks. in proc. adv. neural inf. process.syst., pages 91

–

99, 2015.[3] k. he, x. zhang, s. ren, and j. sun. deep residuallearning for image recognition. in proc. ieee conf.comp. vis. patt. recogn., pages 770

–

778, 2016[4] t.

‑

y. lin, p. goyal, r. girshick, k. he, and p. doll

´

ar.focal loss for dense object detection. in proc. ieeeconf. comp. vis. patt. recogn., pages 2980

–

2988,2017.[5] rezatofighi, h.; tsoi, n.; gwak, j.; sadeghian, a.; reid, i.; andsavarese, s. 2019. generalized intersection over union: a metricand a loss for bounding box regression. in the ieee conferenceon computer vision and pattern recognition (cvpr)。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。