1.本发明涉及遥感领域,特别是一种基于拼图引导的深度特征融合的高分辨率遥感图像场景分类方法。

背景技术:

2.高分辨率遥感图像场景分类是指根据给定的一组语义类别对图像区域进行自动标注,如海洋、陆地、河流等,为目标检测、识别等任务提供有效的上下文信息。目前,高分辨率遥感图像场景分类已经被广泛应用于交通旅游规划、山火损失评估、查违拆违、地址调查以及城市规划等重大领域。与普通的图像分类任务不同,遥感图像场景中地物目标的形式多样、空间分布复杂,一幅遥感图像场景中可能包含着多种地物类型,例如密集住宅区场景中可能包含房屋建筑、道路、树木等一些地物目标,具有类间相似性大、类内差异性大的特点。因此,如果直接使用主流的深度学习网络模型,会导致网络倾向于关注图像中对象的某个区域或某一结构,导致分类结果不够精细。

3.为了提高场景分类准确性,需要跳出仅仅使用单一特征类型进行场景描述的思想,从遥感图像场景的自身特性出发,提取合适的特征并选择高效的融合策略对多特征进行融合,使得融合后的特征能够涵盖有图像中对象的整体结构。并且由于高分辨率遥感图像场景分类的标记成本较高,因此若想将训练好的模型迁移到实际应用中,所训练的模型需具备尽可能高的泛化能力。因此,如何获得有较强场景描述能力、区分能力的场景级特征和尽可能高的模型泛化能力成为了有效提高场景分类性能的关键所在。

技术实现要素:

4.有鉴于此,针对高分辨率遥感图像场景分类中直接使用现有的网络模型获得的单一特征描述符不能有效表达高分遥感图像的语义信息,造成分类精度不高和泛化能力不强的问题,本发明的目的是提供一种基于拼图引导的深度特征融合的高分辨率遥感图像场景分类方法,能够训练网络关注图像的局部信息和全局语义信息,获取更为全面的特征描述,最终获得更好的分类结果。

5.本发明采用以下方案实现:一种基于拼图引导的深度特征融合的高分辨率遥感图像场景分类方法,包括以下步骤:步骤s1:令采用的主干特征提取网络模型f共有l层卷积块;首先,输入高分辨率遥感图像数据即原始图像,通过一个拼图生成器,将图像数据的布局随机分块后再拼接,生成原始图像的一个随机拼图,然后送入到主干特征提取网络模型f的前l

⁄

2层卷积块,进行对浅层卷积块的训练,用以促进主干特征提取网络模型f对于图像局部信息的关注;步骤s2:将输入的高分辨率遥感图像数据即原始图像送入主干特征提取网络模型f的所有卷积块,即对主干特征提取网络模型f所有的l层卷积块进行训练,用以促进主干特征提取网络模型f对于深层特征的关注和图像语义信息的学习,将主干特征提取网络模型f

的整个聚焦区域扩大到整个图像;步骤s3:通过将主干特征提取网络模型f的第l

⁄

2层卷积块的输出特征和第l层卷积块的输出特征分别送入由二维卷积conv2d和归一化函数batchnorm2d组成的卷积块进行维数处理,将两个输出特征的维数均处理成相同维数后进行concatenate通道特征融合,用以使整个模型能够学习到图像的全局语义信息和局部信息;步骤s4:将融合后的特征送入经过归一化函数batchnorm、全连接层、归一化函数batchnorm、elu激活函数以及全连接层组成的分类模块进行分类,即对前层的特征进行一个加权和,将特征空间通过线性变换映射到样本标记空间,得到最终的分类结果。

6.进一步地,步骤s1中所述的主干特征提取网络模型f能够采用包括但不限于resnet或vggnet。

7.进一步地,步骤s1中所述拼图生成器生成原始图像的一个随机拼图的具体内容如下:通过一个拼图生成器,先对原始图像进行均匀分割,然后将分割后的图块随机组合成一个和原来尺寸大小一样的图像,即为原始图像的一个随机拼图。

8.与现有技术相比,本发明具有以下有益效果:(1)本发明提出的方法能够训练网络关注图像的局部信息和全局语义信息,获取更为全面的特征描述,最终获得更好的分类结果。

9.(2)本发明能引导网络更加关注模型浅层特征的学习,融合后的特征包含更为丰富的场景信息,增加了目标的可区分性,相比已有方法,本发明能够有效提高分类精度,同时提高模型的泛化能力。

附图说明

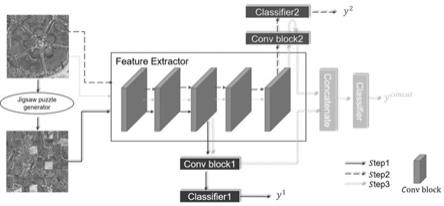

10.图1为本发明实施例的原理示意图。

具体实施方式

11.下面结合附图及实施例对本发明做进一步说明。

12.应该指出,以下详细说明都是例示性的,旨在对本技术提供进一步的说明。除非另有指明,本文使用的所有技术和科学术语具有与本技术所属技术领域的普通技术人员通常理解的相同含义。

13.需要注意的是,这里所使用的术语仅是为了描述具体实施方式,而非意图限制根据本技术的示例性实施方式。如在这里所使用的,除非上下文另外明确指出,否则单数形式也意图包括复数形式,此外,还应当理解的是,当在本说明书中使用术语“包含”和/或“包括”时,其指明存在特征、步骤、操作、器件、组件和/或它们的组合。

14.如图1所示,本实施例提供一种基于拼图引导的深度特征融合的高分辨率遥感图像场景分类方法,包括以下步骤:步骤s1:令采用的主干特征提取网络模型f共有l层卷积块;首先,输入高分辨率遥感图像数据即原始图像,通过一个拼图生成器,将图像数据的布局随机分块后再拼接,生成原始图像的一个随机拼图,然后送入到主干特征提取网络模型f的前l

⁄

2层卷积块,进行对浅层卷积块的训练,用以促进主干特征提取网络模型f对于图像局部信息的关注;步骤s2:将输入的高分辨率遥感图像数据即原始图像送入主干特征提取网络模型

f的所有卷积块,即对主干特征提取网络模型f所有的l层卷积块进行训练,用以促进主干特征提取网络模型f于深层特征的关注和图像语义信息的学习,将主干特征提取网络模型f的整个聚焦区域扩大到整个图像;步骤s3:通过将主干特征提取网络模型f的第l

⁄

2层卷积块的输出特征和第l层卷积块的输出特征分别送入由二维卷积conv2d和归一化函数batchnorm2d组成的卷积块进行维数处理,将两个输出特征的维数均处理成相同维数后进行concatenate通道特征融合,用以使整个模型能够学习到图像的全局语义信息和局部信息;步骤s4:将融合后的特征送入经过归一化函数batchnorm、全连接层、归一化函数batchnorm、elu激活函数以及全连接层组成的分类模块进行分类,即对前层的特征进行一个加权和,将特征空间通过线性变换映射到样本标记空间,得到最终的分类结果。

15.在本实施例中,步骤s1中所述的主干特征提取网络模型f能够采用包括但不限于resnet或vggnet。

16.在本实施例中,步骤s1中所述拼图生成器生成原始图像的一个随机拼图的具体内容如下:通过一个拼图生成器,先对原始图像进行均匀分割,然后将分割后的图块随机组合成一个和原来尺寸大小一样的图像,即为原始图像的一个随机拼图。

17.通过拼图的方式,促进网络关注图像中的局部信息,降低网络模型对于输入图像训练中语义信息的过度关注,提高模型在场景分类中的泛化能力。

18.较佳的,本实施例包括一个拼图生成器,对图像进行分块后随机拼接,是通过代码自动实现的,以促进网络关注图像中对象的整体结构,得到更多图像的局部信息,提高网络模型的泛化性。

19.一种深度特征融合的训练策略,该策略分为三个步骤。第一步先通过拼图生成器生成原始图像的一个随机拼图,然后送入网络架构的浅层卷积块进行训练,促进网络关注图像的每一个图块区域;第二步将原始图像送入完整的网络模型进行训练,将网络的整个聚焦区域扩大到整个图像;第三步将浅层卷积块和最后一层卷积块的输出特征进行融合,使得整个模型能够学习到图像的全局语义信息和局部信息,提高模型的泛化能力。

20.较佳的,在本实施例中,在网络模型的训练过程中,每迭代训练一个epoch都经过三个不同的步骤,首先在网络模型中的浅层卷积块中进行梯度传播,训练网络模型对于图像中对象的整体结构的关注;然后再训练一次完整的网络,将网络的整个聚焦区域扩大到整个图像,促进网络模型对于全局语义信息的关注;最后,对浅层卷积块的输出和最后一层卷积块的输出进行特征融合,以得到语义信息和局部信息更强、泛化性能更好的特征描述。

21.较佳的,在本实施例中,通过对网络模型采用jdff训练策略,提高对高分辨率遥感图像场景的分类结果。

22.具体包括以下步骤:步骤s1:假设我们使用的主干特征提取网络模型f共有l层卷积块。首先,输入高分辨率遥感图像数据即原始图像,通过一个拼图生成器,将图像数据的布局随机分块后再拼接,生成原始图像的一个随机拼图,然后送入到主干特征提取网络模型f的前

⌈

l

⁄2⌉

层卷积块,进行对浅层卷积块的训练,用于促进网络模型对于图像局部信息的关注;步骤s2:将输入的高分辨率遥感图像数据即原始图像送入主干特征提取网络模型f的所有卷积块,即对主干特征提取网络模型f所有的l层卷积块进行训练,用于促进网络模

型对于深层特征的关注和图像语义信息的学习,将网络的整个聚焦区域扩大到整个图像;步骤s3:通过将主干特征提取网络模型f的第l

⁄

2层卷积块的输出特征和第l层卷积块的输出特征分别送入由二维卷积conv2d和归一化函数batchnorm2d组成的卷积块进行维数处理,将两个输出特征的维数均处理成相同维数后进行concatenate通道特征融合,用以使整个模型能够学习到图像的全局语义信息和局部信息;步骤s4:将融合后的特征送入经过归一化函数batchnorm、全连接层、归一化函数batchnorm、elu激活函数以及全连接层组成的分类模块进行分类,即对前层的特征进行一个加权和,将特征空间通过线性变换映射到样本标记空间,得到最终的分类结果。

23.本发明有以下有益效果:本发明提出的方法能够训练网络关注图像的局部信息和全局语义信息,获取更为全面的特征描述,最终获得更好的分类结果。

24.综上,针对高分辨率遥感图像场景分类中直接使用现有的网络模型获得的单一特征描述符不能有效表达高分遥感图像的语义信息,造成分类精度不高和泛化能力不强的问题,本实施例提出的基于拼图引导的深度特征融合(jdff)策略用于高分辨率遥感图像场景分类。jdff首先对原始图像生成一个拼图,将拼图送入网络模型的浅层卷积块进行浅层特征的学习,然后将原始图像送入整个网络模型学习深度全局语义特征,最后将浅层卷积块的输出特征和最后一层卷积块的输出特征进行融合,进行分类。实验数据采用常用的高分辨率遥感图像场景分类数据集aid。本实施例的策略能引导网络更加关注模型浅层特征的学习,融合后的特征包含更为丰富的场景信息,增加了目标的可区分性,相比已有方法,本实施例能够有效提高分类精度,同时提高模型的泛化能力。

25.以上所述仅为本发明的较佳实施例,凡依本发明申请专利范围所做的均等变化与修饰,皆应属本发明的涵盖范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。