用于虚拟现实和增强现实的系统和方法

1.相关申请的交叉引用

2.本技术要求于2018年12月27日提交的美国临时申请号62/785,370的优先权,其内容通过引用整体并入在此。

技术领域

3.本发明涉及连接的移动计算系统、方法和配置,并且更具体地涉及以可用于虚拟和/或增强现实操作的至少一个可穿戴组件为特征的移动计算系统、方法和配置。

背景技术:

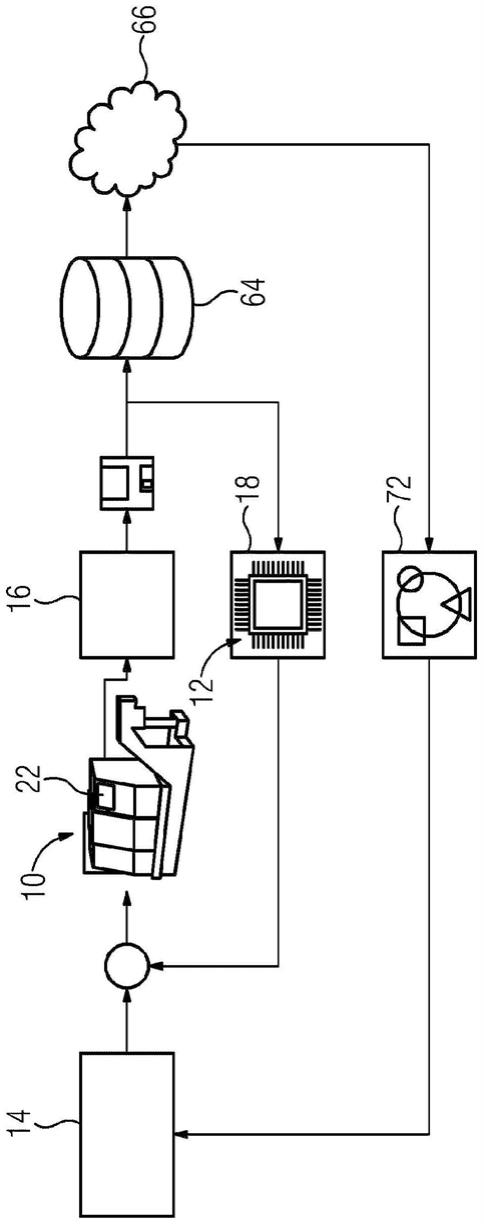

4.希望混合现实(“mr”)或增强现实(“ar”)、近眼显示器重量轻、成本低、具有小的形状因子、具有宽的虚拟图像视野,并尽可能透明。此外,希望具有在多个焦平面(例如,两个或更多)中呈现虚拟图像信息的配置,以便在不超过辐辏调节失配的可接受容限的情况下适用于各种用例。参考图1,增强现实系统被图示为以如下部件为特征:头戴式观看组件(2)、手持控制器组件(4)和可以被配置为作为腰包等佩戴在用户身上的互连辅助计算或控制器组件(6)。这些组件中的每一个组件可以经由有线或无线通信配置(诸如由ieee 802.11、蓝牙(rtm)和其它连接标准和配置指定的那些)可操作地彼此耦合(10、12、14、16、17、18)并耦合到其它连接的资源(8),诸如云计算或云存储资源。例如,如在美国专利申请序列号14/555,585、14/690,401、14/331,218、15/481,255、62/518,539、62/693,891和62/743,49中所述的,它们中的每一个通过引用整体并入在此,描述了此类组件的各个方面,诸如两个所描绘的光学元件(20)的各种实施例,通过它们,用户可以看到它们周围的世界以及可以由相关联的系统组件产生的视觉组件,用于增强现实体验。

5.市场上有各种虚拟现实(“vr”)系统和一些有效的ar系统。许多这些系统被配置为利用本地数据(诸如存储在本地闪存上的游戏软件),或连接某些远程数据(诸如存储在远程位置处的云存储资源上的高分),但很少被配置为不仅与各种类型的其他用户节点互连,而且有效地利用和平衡本地和云资源以进行处理/操作和存储。

6.大多数vr系统基本上是近距离监视器,类似于靠近眼睛放置的计算机或电视监视器,为会聚提示提供立体视角,并经由连接的计算设备连接到计算和存储资源,诸如高性能游戏膝上型计算机或台式计算机。vr系统在许多人类操作场景中的能力有限,因为用户通常无法看到他们周围的世界,因此用户将面临移除头戴式显示组件以查看他或她在做什么的挑战,并且然后将头戴式显示组件戴回到眼睛上方,以继续查看计算机开发或显示的信息。vr系统的某些变体可以容纳所谓的“直通”视频,从而前向相机捕获可以在vr可穿戴组件中广播给用户的视频,但由于延迟、视角偏移、图像保真度和负面生理提示,在许多关键的人类操作场景中,此类系统可能不太理想。另一个限制是计算资源的大小,对于大多数现代可穿戴vr显示系统,通常需要连接该计算机资源。即使存在计算,满足vr系统生理需求的电源要求也需要背包大小的电池。此外,缺乏足够安全和稳健以用于关键操作场景(诸如紧急医疗响应、火灾响应、警察行动和/或军事行动)的此类技术。在此描述的系统、配置和方

法旨在解决便携式、稳健、高度连接和高性能的可穿戴计算部署在各种人类场景中的各种挑战。需要优化以用于可穿戴计算系统的紧凑且持久连接的系统和组件。

技术实现要素:

7.本公开的示例描述了用于混合现实系统的分布式计算和/或联网的系统和方法。根据本公开的示例,一种方法可以包括经由头戴式设备的相机捕获图像。惯性数据可以经由头戴式设备的惯性测量单元来捕获。可经由头戴式设备的一个或多个处理器基于图像和惯性数据估计头戴式设备的位置。图像可以传输到远程服务器。可以经由远程服务器基于图像来训练神经网络。训练的神经网络可以传输到头戴式设备。

附图说明

8.图1示出根据一些实施例的示例混合现实系统。

9.图2示出根据一些实施例的示例混合现实系统。

10.图3示出根据一些实施例的示例混合现实环境。

11.图4示出根据一些实施例的示例混合现实系统。

12.图5示出根据一些实施例的用于构建虚拟模型的示例过程。

13.图6示出根据一些实施例的混合现实系统的示例头戴式组件。

14.图7示出根据一些实施例的混合现实系统的示例可穿戴包组件。

15.图8示出根据一些实施例的示例混合现实计算架构。

16.图9示出根据一些实施例的示例混合现实计算架构。

17.图10示出根据一些实施例的示例混合现实计算架构。

18.图11示出根据一些实施例的示例混合现实计算架构。

19.图12示出根据一些实施例的连接混合现实系统的示例使用。

20.图13示出根据一些实施例的连接混合现实系统的示例使用。

21.图14示出根据一些实施例的连接混合现实系统的示例使用。

22.图15示出根据一些实施例的连接混合现实系统的示例使用。

23.图16示出根据一些实施例的连接混合现实系统的示例使用。

24.图17示出根据一些实施例的连接混合现实系统的示例使用。

25.图18示出根据一些实施例的连接混合现实系统的示例使用。

26.图19示出根据一些实施例的连接混合现实系统的示例使用。

27.图20示出根据一些实施例的连接混合现实系统的示例使用。

28.图21示出根据一些实施例的连接混合现实系统的示例使用。

29.图22示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

30.图23示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

31.图24示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

32.图25示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

33.图26示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

34.图27示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

35.图28示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

36.图29示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

37.图30示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

38.图31示出根据一些实施例的示例混合现实网络架构。

39.图32示出根据一些实施例的示例混合现实计算架构。

40.图33示出根据一些实施例的混合现实系统的示例使用。

41.图34示出根据一些实施例的示例混合现实计算架构。

42.图35示出根据一些实施例的混合现实系统的示例传感器组件。

43.图36示出根据一些实施例的混合现实系统的示例传感器组件。

44.图37示出根据一些实施例的混合现实系统的示例使用。

45.图38示出根据一些实施例的混合现实系统的示例使用。

46.图39示出根据一些实施例的混合现实系统的示例使用。

47.图40示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

48.图41示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

49.图42示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

50.图43示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

51.图44示出根据一些实施例的在紧急情况下混合现实系统的示例使用。

52.图45示出根据一些实施例的示例混合现实计算架构。

53.图46示出根据一些实施例的示例混合现实计算架构。

54.图47示出根据一些实施例的示例混合现实计算架构。

55.图48示出根据一些实施例的示例混合现实计算架构。

56.图49示出根据一些实施例的示例混合现实计算架构。

57.图50示出根据一些实施例的示例混合现实计算架构。

58.图51示出根据一些实施例的示例混合现实计算架构。

59.图52示出根据一些实施例的示例混合现实计算架构。

60.图53示出根据一些实施例的示例混合现实计算架构。

61.图54示出根据一些实施例的示例混合现实计算架构。

62.图55示出根据一些实施例的示例混合现实计算架构。

63.图56示出根据一些实施例的示例混合现实计算架构。

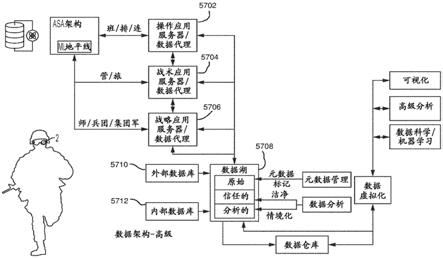

64.图57示出根据一些实施例的示例混合现实计算架构。

65.图58示出根据一些实施例的示例混合现实计算架构。

66.图59示出根据一些实施例的示例混合现实计算架构。

67.图60示出根据一些实施例的示例混合现实计算架构。

68.图61示出根据一些实施例的示例混合现实计算架构。

69.图62示出根据一些实施例的示例混合现实计算架构。

70.图63示出根据一些实施例的示例混合现实计算架构。

71.图64示出根据一些实施例的混合现实系统的示例训练使用。

72.图65示出根据一些实施例的混合现实系统的示例训练使用。

73.图66示出根据一些实施例的混合现实系统的示例训练使用。

74.图67示出根据一些实施例的混合现实系统的示例训练使用。

75.图68示出根据一些实施例的混合现实系统的示例训练使用。

76.图69示出根据一些实施例的混合现实系统的示例训练使用。

77.图70示出根据一些实施例的混合现实系统的示例使用。

78.图71示出根据一些实施例的混合现实系统的示例权限架构。

79.图72示出根据一些实施例的混合现实系统的示例权限架构。

80.图73示出根据一些实施例的混合现实系统的示例权限架构。

81.图74a

‑

74d示出根据一些实施例的混合现实系统的示例性调光功能。

82.图75示出根据一些实施例的混合现实系统的示例性目标功能。

83.图76示出根据一些实施例的混合现实系统的示例性目标功能。

84.图77示出根据一些实施例的示例混合现实计算架构。

85.图78示出根据一些实施例的混合现实系统的示例传感器组件。

86.图79示出根据一些实施例的混合现实系统的示例传感器组件。

87.图80示出根据一些实施例的混合现实系统的示例传感器组件。

88.图81示出根据一些实施例的示例混合现实计算架构。

89.图82示出根据一些实施例的示例混合现实计算架构。

90.图83示出根据一些实施例的示例混合现实计算架构。

91.图84a

‑

84b示出根据一些实施例的示例混合现实计算架构。

92.图85示出根据一些实施例的混合现实系统的示例可穿戴组件。

93.图86a

‑

86d示出根据一些实施例的混合现实系统的示例传感器组件。

94.图87示出根据一些实施例的示例混合现实计算架构。

95.图88示出根据一些实施例的示例混合现实计算架构。

96.图89示出根据一些实施例的示例混合现实计算架构。

97.图90示出根据一些实施例的示例虚拟助理。

98.图91示出根据一些实施例的混合现实系统的示例地图绘制组件。

99.图92示出根据一些实施例的示例虚拟模型。

100.图93示出根据一些实施例的混合现实系统的示例袖带组件。

101.图94示出根据一些实施例的示例混合现实计算架构。

102.图95示出根据一些实施例的示例混合现实计算架构。

103.图96示出根据一些实施例的示例混合现实计算架构。

104.图97示出根据一些实施例的示例混合现实计算架构。

105.图98示出根据一些实施例的示例混合现实计算架构。

106.图99示出根据一些实施例的示例混合现实计算架构。

107.图100示出根据一些实施例的示例混合现实计算架构。

108.图101示出根据一些实施例的示例混合现实计算架构。

109.图102示出根据一些实施例的示例混合现实计算架构。

110.图103示出根据一些实施例的混合现实系统的示例头戴式组件。

111.图104示出混合现实系统的示例可穿戴包组件。

112.图105a

‑

105c示出根据一些实施例的示例混合现实环境。

113.图106a

‑

106d示出根据一些实施例的可用于生成混合现实环境并与之交互的示例

混合现实系统的组件。

114.图107a示出根据一些实施例的可用于向混合现实环境提供输入的示例混合现实手持控制器。

115.图107b示出根据一些实施例的可以与示例混合现实系统一起使用的示例辅助单元。

116.图108示出根据一些实施例的示例混合现实系统的示例功能框图。

具体实施方式

117.参考图2,示出佩戴头戴式显示器组件(2)、腰带或“计算”包(6)并握持手持控制器组件(4)的用户。通过系统例如通过802.11wifi连接可操作地连接到其它资源,用户或操作员可以在他的环境周围导航并利用系统的计算能力,同时还可以看到他周围的事物。图3示出当用户走过公园环境(22)并通过头戴式可穿戴组件(2)(诸如在此所述的那些)观看(24)世界时,用户如何在增强现实体验中看到和/或感知事物的一些基本概念;在该图示中,用户可以看到实际世界的各个方面,诸如树木、混凝土高架垫(1120)和公园环境(22)的其余部分,同时还可以在三个维度中看到昆虫角色(26)和雕像(1110),它们不存在于实际的物理世界中,但通过使用本系统的增强现实能力而呈现给用户看起开像存在实际物理世界中一样。参考图4,如上面参考图1所述,本ar系统可以操作地耦合到许多不同的资源,诸如存储和计算资源,以及其它重要的操作资源,诸如其它便携式计算系统、智能电话、智能手表、存储和/或处理中心、无线连接中心或节点、各种类型的个人无线电、飞机或空中支援、应急响应车辆、网络操作中心或操作控制中心、诸如无人机的无人驾驶交通工具、移动或可穿戴相机设备和/或传感器或多种类型,包括激光雷达和其它传感器。在各种实施例中,优选地,用户与许多资源连接。

118.参考图5,在一个实施例中,在具有许多连接的资源的情况下,连接的集合体可以用作各种3

‑

d传感器来重建一个或多个对象的网格或模型,该一个或多个对象可以定位于多个发射/接收设备(诸如具有5g天线阵列等的手机)之一之间或被其包围。换句话说,每个手机、平板计算机、可穿戴设备或其它连接的设备都可以用作传感器;例如,可以利用每个信号源对的方向和强度、散射、穿透和吸光度来创建干涉图,该干涉图然后可以例如由用户在可穿戴计算系统的视野中可视化。在5g连接环境的情况下,源/信号配对可以提供周围世界的毫米波重建;这可能是计算量相当大的,但它是使用现代频率到空间域全息重建来创建可更新的通用世界模型的一种方法。

119.参考图6和图7,如在上述并入的参考文献中指出的,在各种实施例中,可能需要将许多类型的传感器和技术集成到可穿戴组件(2)和/或腰包/计算包组件(6)中。例如,在图6的所示实施例中,偏转或弯曲传感器可以包括具有两个不同方向的内部干涉仪;基于相变检测,可以关联和确定弯曲偏转;还示出混合动态视觉

‑

可见光传感器,其中差分传感器和可见光传感器可用于相同的光路,诸如采用分束器;可以一起分析信号以处理差异/相似性。如图7中所示,在一个实施例中,腰包组件(6)可以从头戴式组件可拆卸地耦合,并且可以从电池组件可拆卸地耦合/交换以确保连续操作。腰包组件(6)可具有接口,诸如如果需要可用作手机的lcd触摸屏/显示器,并且可以具有集成在其中的一个或多个相机或感测设备,例如为操作者提供附加感测,诸如向后或相对于操作员的其它方向。

120.参考图8,示出系统连接的各个方面,具有操作员耳机(2)、腰包(6)、通信无线电和可操作地耦合到各种其它资源的其它元件。例如,在各种实施例中,“袖带助手”元件可以包括袖带或带式设备,在某些场景(诸如如逃离危险的关键操作)中可安装在用户的手腕周围;此类设备可以被配置为感测温度、血压、位置(诸如通过gps和/或移动连接三角测量和/或ip地址映射)、血氧分压以及与此类操作员及其位置和状况相关的其它变量;这些可以报告成紧急医疗服务或其它系统或人员,使得他们可以将资源分配给操作员,协助管理场景等。图8还示出与通用或半通用数据库集合和与操作员世界有关的信息的连接概念(可称为“magicverse”);这可包括,例如,通过紧急和预防网络或可包含例如具有有关过敏或医疗状况的信息的完整患者记录的其它医疗网络与紧急医疗系统的连接;还可以连接各种类型的家庭、企业或城市规模的网络,诸如网络摄像头组、包含相关信息和数据的服务器,以及来自可称为“保护网”(“guardian net”)的资源,该保护网可以是执法人员和某些军事人员可以访问的资源网络,该执法人员和某些军事人员可以出于某些调查、紧急情况和其它目的访问网络摄像头、麦克风、卫星和大型存储设备。

121.参考图9、10和11,消防员、执法人员或军事操作员可以分别利用可穿戴计算系统(2、6)作为各种移动操作中心,用于集成大量其它连接资源的效用,诸如智能电话;ems无线电;家庭、企业或其它地方的连接和/或存储中心;各种相机和相关传感器;gps;医疗和紧急数据库;执法;保护网连接;武器系统连接;与其它有人或无人驾驶交通工具的连接等。

122.参考图12

‑

21,本技术也可以被利用和适于办公室生产力场景。例如,参考图12和13,可以进行6人开会讨论一些事情,诸如视觉上复杂的东西,诸如3d汽车零件,其可以通过他或她的头戴式计算组件(2)显示给每个参与者;一名或多名与会者可以亲自出现在房间内(“本地”),而一名或多名与会者可以亲自出现在其它地方,但在会议中(“远程”)以呈现的图像(诸如他们自己的头像)表示。与会者不仅可以利用移动计算技术(2)参加会议,还可以利用各种其它“物联网”连接设备,如图14中所示,诸如房间内的显示器、照明、麦克风、扬声器、相机等;在各种实施例中,来自特定房间或环境的可用设备可以被映射到此类房间或环境中,以使得当用户实际或虚拟地出现在此类房间中时它们是可用的。参考图15,在各种实施例中,诸如可用于将语言翻译成文本和文本到不同语言的那些翻译技术可用于促进说着与会议中其他参与者的语言不同的语言的成员的实时或接近实时的参与。参考图16和17,该系统可以被配置为使得参与者可以选择他们自己的头像的方面,诸如他们自己的面部或其部分的定制视图、诸如所选卡通人物的角色和/或针对其他参与者的类似处理。例如,用户a可能决定在特定会议上向其他人显示知名人物的头像,同时自动将动物头像分配给会议的另一个成员(用户b),并且同时自动在会议的第三位成员(用户c)的其他标准头像上放置一顶有趣的帽子和假胡子演示。参考图18,各种用户界面配置可以被配置为在每个参与者上方显示其他参与者可以看到和利用的菜单,例如,以共享笔记、共享视频透视图和/或共享某些会议或信息控件。参考图19,该系统可以被配置为在会议与会者的子组之间提供私人聊天消息传递用户界面,或者提供对所有与会者可见的更公开的聊天,例如用于分享来自会议的笔记。如上所述,语言可以诸如通过自动设置被翻译,以在多语言会议环境中提供访问和利用。参考图20,在各种实施例中,系统可以被配置为在每个参与者的实际或虚拟呈现的办公桌上呈现用户界面,以使得他们可以利用他们的手来四处移动东西、致动或激活各种东西、控制房间的各个方面、相机视图、麦克风、扬声器、参与者正在观看的文

档、笔记的共享等。此类用户界面优选地可由每个用户配置以向每个用户提供会议环境中的信息和控制的定制且有效的视图。参考图21,如上面参考图12所述,可能具有某些版本的头戴式计算组件(2)的独特的3维观看能力为会议中的参与者呈现了在三维中一起“围着桌子”观看某些复杂材料或信息的独特机会,无论所有参与者是否实际都在房间里。

123.参考图22

‑

30,在消防环境中,可穿戴计算系统可以被配置用于高实用性。例如,参考图22,消防员可以佩戴头戴式组件(2),以使得他们可以可视化路线和事件地图。参考图23,物联网连接的资源,诸如门锁、烟雾报警器、相机、电力和气体资源以及照明可以被可视化(即,诸如通过头戴式组件2)并且可供现场或返回控制中心的消防员操作员进行紧急控制。参考图24,在各种实施例中,系统可以被配置为允许与移动计算系统连接的团队的每个成员(诸如允许免提使用的头戴式组件(2))可视化定位(即,基于gps、连接三角测量、ip地址、地图绘制/slam/计算机视觉等)和状态(诸如基于生物特征传感器的健康状态,当用户遇到压力、危险、烟雾等时,该生物特征传感器可以存在于用户的头戴式组件2上,该压力、危险、烟雾等可以通过此类头戴式组件上的各种传感器和相机检测和/或可视化,并经由无线连接与其他合作者共享)。例如,参考图26,用户的头戴式组件(2)可以被配置为监视基于眼睛和面部的压力指标以及心率、心率变异性等,并向他人报告出该信息;此外,用户的头戴式组件(2)可以被配置为利用计算机视觉资源,诸如相机和本地或远程/连接的计算资源,以不仅扫描他们周围的房间以进行地图绘制和机器学习功能,而且对人员(诸如在建筑物内受伤的患者)进行面部识别;此外,参考图27,可见光相机技术,诸如可操作地耦合到用户的头戴式组件(2)的那些技术,可被配置为捕获各种场景、人员等的图片,以与不同位置中(诸如在远程控制中心处)的其他操作员共享。参考图28,热/红外(即,诸如长或正常波长的红外)、可见光和/或短波长红外成像技术(“swir”;具有能够相当成功地通过烟雾成像的优点,该烟雾视觉上对其它想象模态不可见)可以组合以促进紧急操作员环境中各种事物(诸如火热点的位置、人、宠物的位置等)的可视化。前面参考图86a

‑

86d,取决于环境场景,swir成像可以用于显著增强相对于正常可见光的用户可见性。参考图29,操作员可以利用用户的头戴式组件(2)来标记紧急环境内的各种人的情况,诸如患有各种疾病或受伤的患者,以与其他操作员共享。参考图30,连接系统(诸如可穿戴组件)可以被配置为提供关于操作员状况的传出信息,该操作员状况不仅与操作员生物特征和环境问题有关,而且与其它关键的连接设备(诸如氧气罐填充水平传感器)有关。

124.参考图31

‑

39,在警察/执法环境中,可穿戴计算系统可以被配置为高实用性。参考图31,可穿戴计算系统(2)可以被配置用于警察行动团队的各个成员以利用去往/来自各个不同位置的免提消息传递。参考图32,在各种实施例中,每个成员都是连接的,并且每个成员成为到整个系统的另一感测“节点”,不仅提供与操作员生物特征相关的数据,还提供与此类操作员周围环境相关的信息,诸如用于证据收集、人员或结构识别、视频/音频/照片捕获、热/ir/swir成像、同步定位和地图绘制(“slam”)、经由无线连接三角测量的定位、gps和/或ip地址、交通或拥堵感测/报告、访问远程数据库(诸如犯罪或医疗保健数据库)、感测或接收与每个操作员周围世界相关的地图数据等。例如,参考图33,当警察操作员带着他或她的连接的头戴式计算组件(2)走动时,该系统可以被配置为分析与警官在附近视觉接触的每个面部,以进行生物特征分析,诸如面部或虹膜识别。此类信息可与连接的数据库搜索一起使用,例如,向警官通知他们刚刚在人行道上走过的人是具有有效逮捕令的重罪犯,并

且可能持有武器且危险。参考图34,利用连接的资源,诸如犯罪/位置数据库,以及例如通过gps、无线连接定位、ip地址和/或使用连接的头戴式计算组件(2)的slam/计算机视觉技术确定的位置,该系统可以配置为向现场、行动总部或其它任何地方的操作员提供有关特定区域内的犯罪率的指示;例如,在一个实施例中,当操作员在当地时间凌晨2点30分处于芝加哥南部犯罪率高的黑暗小巷区域时,操作员周围的一切都可能被染成红色或以其它方式指示为相对较高的犯罪率;在其它位置中,基于最近的数据,街道的一侧可指示为比街道的另一侧相对低的犯罪率。因此,即使一名警官正在步行或驾车穿过已知的犯罪区,至少这不会让人感到意外;此外,可以为操作员标记最近的事件或信息,诸如指向:上周高密度街边裂缝交易的已知位置。参考图35

‑

37,传感器(诸如头戴式计算组件(2)上的面向内相机)可用于跟踪与操作员的瞬态压力水平相关的变量,诸如瞳孔直径随时间的变异性;已经示出,当针对入射光变异性进行归一化时随时间的显著变异性是个体压力状态的相对较好的指标(例如,小的恒定瞳孔直径可能与相对静止状态相关,而高变异性和相对较大的瞳孔直径可能与相对较高的压力状态相关)。瞳孔直径可随着时间推移被测量并报告给连接的系统和人员;例如,在一个实施例中,涉及扫描横跨捕获的场景(诸如眼睛)的线并寻找变化/增量以及用于识别眼睛的瞳孔与巩膜的分割等的欧拉视频放大技术可以为某些生物特征变异性提供有效的窗口。参考图37,此类技术可用于佩戴适当组件(2)的操作员(诸如警官)的生物特征,但也可在足够接近以使用面向外传感器分析其他人的生物特征的情况下使用。参考图38,已经示出处于极端压力情况下的人们在处理被认为在无压力情况下相对简单的某些事情时可能具有困难或低下效率,并且因此可以配置各种实施例以协助各种信息相关的任务,诸如将具有特定伤口的人标记为此类,或将尸体标记为尸体,使得每个操作员无需走上检查脉搏进行确认等。参考图39,犯罪活动可以实时或接近实时地绘制,并通过操作员佩戴适当的组件(2)在诸如ar地图绘制用户界面中可视化。在一个实施例中,ar地图绘制界面可以被配置为也向操作员提供时域控制,使得他们可以倒退一小时或任何时间帧以可视化当时的场景是什么样的。

125.某些操作员或响应者(诸如消防员、警察或紧急医疗响应者)还可以在各种情况下通过其连接的可穿戴计算组件(2)利用连接的医疗资源。例如,参考图40

‑

44,操作员可以利用其连接的可穿戴计算组件(2)对其周围的环境问题(诸如烟雾、气体、化学品;使用诸如可以耦合到操作员的耳机2的swir设备的技术)进行光谱分析;直接访问可能能够连接到他们的耳机(2)以高分辨率分享他们的患者视图和音频馈送(即,经由耳机2上的面向外麦克风)的专家医生和/或患者病史;进行生物特征分析(诸如通过面部、虹膜和/或患者智能电话上特殊资源的瞬时连接等进行患者识别);了解患者的过敏或重要病史等。例如,操作员利用连接的可穿戴计算组件(2)与远程专家直接连接,可能会遇到看起来心脏骤停的无意识患者;操作员可以请求专家急诊医学分诊帮助,并且专家可以进入场景,诸如视频电话会议和/或出现在操作员计算组件(2)视野的一部分中的头像演示以及音频;面部识别、其它生物特征、专门的急救人员患者智能电话访问和/或简单的患者钱包识别卡信息可用于识别患者,并且可利用安全连接的资源来确定患者是已知的海洛因成瘾者,并且从该情况中,出现的急诊医学专家从操作员的共享视野中可以看出,似乎是服药过量并且接近死亡,是时候紧急服用抗阿片类盐酸纳洛酮注射液药品了,诸如以narcan为商标出售的药品。

126.参考图45

‑

63,可以利用许多配置来在无数场景中帮助各种类型的军事操作员。例

如,参考图45

‑

46,具有连接的可穿戴计算系统(2、6)的军事操作员可以与各种其它资源无线连接,诸如安全通信无线电(诸如军事操作员可用的超宽带无线电)、一个或多个远程武器瞄准器、被配置为可拆卸地耦合到可穿戴计算系统的一个或多个电池组、数据库、地图、图像、视频、音频和多种通信,所有这些都可以由军事操作员相互连接和操作;此类配置可以被告知和/或与军事系统(诸如被称为atac和网络战士(netwarrior)的那些系统)相互耦合。可穿戴计算系统还可以被配置为向操作员提供某些保护,诸如通过头戴式组件(2)的激光眼睛保护,以及通过被配置为仅通过一定强度的音频的耳塞式耳机进行的听力保护,此后传输被分流并且耳塞阻挡声音(换句话说,耳塞可以可操作地耦合到麦克风,诸如定向麦克风或其阵列,其能够捕获和处理声音并选择性地再现在有源耳塞中的那些声音,或者不再现)。参考图48和55,以类似于参考在上述并入的参考文献中详细描述的手持组件(4)的6自由度(“dof”)跟踪描述的方式,武器或其一部分可以被跟踪,并且控制系统可以被配置为协助将操作员引导至期望目标和/或仅当武器处于相对于期望目标的正确位置/取向时才促使武器激活或开火。前面参考图52,该系统还可以被配置为使用面向外相机和/或传感器和/或来自其它来源的与视野中特定对象有关的先前信息,在识别之后提供关于每个可视化对象的相关信息(诸如敌方战斗人员状态、交战规则、可疑武器情况、任何可检测或已知的压力或医疗信息等)。

127.在另一实施例中,一个或多个定向麦克风可操作地耦合到高度复杂的信号处理能力以协助定向和识别声音捕获;例如,在夜间部队战车周围,部队可以将他们的耳机(2)放置在周边作为声音捕获视野计,其可以在本地或远程(即,作为一组单独的声音捕获设备,或作为阵列)进行监视,用于特定的声音模式,诸如,“当地时间凌晨1点39分向北的声音模式

‑

我们的一辆柴油运输卡车”;或者,“86%的置信度;当地时间凌晨2点58分正南的声音模式

‑

ak

‑

47轻武器射击以及小型摩托车活动;83%的置信度;唤醒部队领导人,以提供有关潜在叛乱活动的最新信息”。

128.参考图49

‑

53,优选地,操作员(2)利用的系统与其他操作员的系统以及远程系统和资源连接,以使得例如本地地面操作员可以获得与无人驾驶飞机、其它车辆、其他操作员和远程指挥中心的使用有关的视频、音频和其它分析和活动的益处,所有这些都可以通过各种技术连接,包括但不限于超宽带收发机、802.11/wifi配置、3g、4g、5g、lte和其它移动连接模式、卫星等。例如,在图49中,可以看到地面操作员使用由无人驾驶飞机捕获的图像从操作员以其它方式将无法看到三个武装敌人(例如,因为他们在山脊的另一侧等)的位置可视化此类敌人。参考图51,可以利用短波长红外(“swir”)或基于nir(近红外)的飞行时间传感器或结构光配置、lidar、radar等来了解周围环境和寻找特定的事物,诸如人。参考图53,在各种实施例中,连接的系统可以被配置为向地面上的每个操作员以及其它位置的其他操作员提供与给定情况有关的活动和事件的实时或接近实时馈送。参考图54,这可包括与医疗后送有关的信息,诸如通过使用空气资源(所谓的“med

‑

evac”空气资源)。例如,在各种实施例中,系统可以被配置为使得在空中和地面佩戴其连接的计算系统(2)的操作员(以及在大本营、总部等处的连接的操作员)可以能够共享以其它方式很难以免提方式进行有效通信的有价值的信息,诸如空中交通规避的近似锥形(或其它几何形状),以避免接触来自敌方战斗人员的轻武器火力,同时仍然能够达到并捡起伤员;地面上的操作员能够通过使用他们的耳机和创建手势的指针、他们连接的武器或武器瞄准器等来调节或改变该规避

区的几何形状和/或位置。参考图56,当gps、移动电信三角测量、ip地址和其它定位技术不容易可用或可操作时,佩戴他的计算系统(2)的操作员可能能够通过使用计算机视觉、对象识别、slam和其它基于图像的技术来定位自己和其它资源,诸如武器。

129.参考图57

‑

58、81和87

‑

89,通过事实和性能而不是推荐或全面的标准化测试,操作员和通过本配置可用的资源的连接水平提供了前所未有的军事行动的各个方面的详细定量分析。该系统可以被配置为使得最低等级的操作员具有对与他们及其同行相关的信息的最小子集的访问权,其中操作员在指挥链上一直到顶部,具有对越来越多的信息的访问权,分类的和其它方式。参考图59

‑

63,操作中的每个人都可以从以有效方式(诸如主要是免提的方式)共享和捕获信息中受益。操作员可以彼此合作,以前所未有的方式可视化事物,与其它资源(诸如飞机、其它成像系统、数据库资源、专家、团队成员和/或健康相关信息)进行通信并利用这些其他资源,所有这些都通过位于功能和启用的中心处的他们的可穿戴计算系统,优选通过头戴式ar可视化组件来利用。

130.参考图64

‑

69,本可穿戴计算系统可用于支持几乎任何位置中的复杂训练练习

‑

提供可重复性、增强的访问以及诊断/评估可视化工具。例如,参考图64,在一个实施例中,用户可以能够从各种准备好的训练场景中选择一个场景。参考图65,在几乎任何环境中,可穿戴计算资产(2)可用于向用户呈现预定的训练/操作场景,其中他们遇到并可视化一个或多个反攻成员,例如,如图66和67中所示,其中关于反攻的内容/图像通过他们的头戴式组件(2)作为增强现实内容显示给练习中的操作员。参考图68和69,可以在3维与时间的关系中回顾练习,以增强诊断和学习。

131.在各种实施例中,模拟/训练配置的核心是训练模拟软件配置(“tss”),其表示精确的模拟引擎;换句话说,tss本质上是一组规则,该组规则管理合成版本的世界如何运作;子弹下落多快;战士、警察、消防员和其他人站在某个位置时能看到什么;敌人、开火、嫌疑人移动多快,等等。在各种实施例中,tss的服务器端组件“tss/s”可以被配置为允许用户连接到出于训练的目的正在进行的模拟并与之交互。tss/s可以被配置为向连接的用户提供合成环境、从用户那里接收关于他们动作的信息、将这些动作纳入模拟、并且然后基于这些动作及其模拟结果更新合成环境。tss的客户端组件、“tss/c”可以被配置为允许用户与tss交互。在服务器(tss/s)上运行的模拟可以被配置为向每个连接的客户端(tss/c)提供关于模拟世界的状态的信息。例如,在magic leap人体计算机上运行的tss/c可以利用来自tss/s的信息来确定如何将世界呈现给头戴式组件(2)后面的眼睛和耳朵。tss/c还可以配置为提供输入机制,从用户捕获传感器数据并将这些数据传送到tss/s,在该tss/s中,该模拟处理这些数据并确定它们如何改变模拟世界的状态。训练管理工具(“tmt”)可以被配置为提供具有对被设计用于支持训练/模拟操作的应用的访问权的工具套件。例如,在各种实施例中,tmt可以被配置为提供:服务器工具,其用于配置和部署tss/s实例,从而允许作战人员、执法人员、消防员和其他人员快速规划和组织训练活动;场景编辑器,其用于创建或修改训练场景;事后回顾(“aar”)工具,其被配置为向用户提供各种机制来回放训练课程和评估所涉及的这些的表现;数据客户端,其管理对训练期间捕获的数据的访问权,生成通用表现报告并允许任意查询以根据需要创建专门的报告;模拟编辑器,其提供修改模拟的基本规则的能力(例如,为新弹药提供弹道数据或调节合成敌人的行为,或火灾、化学品泄漏等);用于管理用户帐户的管理工具。

132.在各种实施例中,训练系统服务可以是远程托管的资源,并且可以包括例如:相对全面的数据库,其可以被称为“数据湖”,用于存储用户账户和训练表现数据;用于收集和共享训练场景的文件存储;根据需要指定用于tss/s训练服务器的云托管的可用服务器资源;对可称为“权威生命流世界地图”(或“lwm”)的内容的访问权,其中包含用于创建训练场景并将从可穿戴组件(2)捕获的原始数据流处理为优选lwm格式的数据。该系统还可以配置为提供某些“训练辅助工具”,该训练辅助工具可以是用于支持训练系统训练的任何物品(例如,武器、泰瑟枪、消防设备和例如cdc设备的训练版本)。在各种实施例中,训练系统本身不涉及定制训练工具,而是提供用于将各种设备集成到训练中的机制,并且表示可扩展的生态系统。在各种实施例中,tss/s是训练环境的模拟引擎并且可以被配置为生成支持集体训练所必需的操作环境的准确合成表示。这可包括:武器和弹药的真实爆炸和弹道模拟;对合成实体和受训者的命中/伤害的确定(例如,tss/s了解射击何时击中合成敌方、合成平民或参与训练的真实世界代理人);允许合成实体了解模拟空间的可通行和受阻区域的通用寻路功能;单元级行为

‑‑

合成实体基于模拟感官了解其周围环境、具有移动能力、具有反应时间、受条件影响(例如,如果被击中,它们可能会被压制)、可以做出基本决定(例如,战斗或逃跑)、并具有一般的熟练程度(例如,他们在交火中的准确性或纪律性);组级行为

‑‑

使用脚本,多个合成实体可以基于if/then条件确定动作过程并协调它们的行为。在各种实施例中,tss/s可以具体地配置为支持针对平民、森林与房屋火灾、毒贩和敌方狙击手团队的组行为;针对环境、实体和动作的音频数据的模拟和在头戴式组件(2)或其它输出上的回放。

133.在各种实施例中,可以部署tss/s来进行训练。参加训练的用户然后连接到旨在用于他们练习的tss/s。可以同时部署多个tss/s实例,从而允许不同的组同时进行不同的训练。在各种实施例中,可以设计tss/s以允许部署的灵活性。使用tmt中的服务器浏览器,tss/s实例可以托管在专用平台(云中为tss/s使用保留的服务器)或常用本地硬件(典型的膝上型计算机)上。

134.tss/s和tss/c在同一平台上操作的自托管是一种替代配置,其允许通过仅使用头戴式组件(2)和计算包(6)对进行单独训练。

135.这些配置选项允许训练系统在需要时和在各种互联网可用环境中提供训练。在具有稳定互联网访问的感知需求点处,tss/s可以在云中运行。在零连接的领域中,tss/s可以在操作员的膝上型计算机上,并且即使没有连接(即,诸如经由802.11的互联网连接,或经由5g、4g、lte等的移动无线连接),操作员也可以仅使用操作员的移动计算系统(2、6)进行单独训练。

136.在各种实施例中,tss/s的目标是允许最终用户客户端无关系统。通过正确格式化的数据,tss/s可以从任何客户端(本可穿戴计算系统2、6;膝上型计算机;智能电话等)接收动作并向任何客户端发送模拟状态信息。这样做的一个目的是适应其它训练模拟系统

‑

现有的或计划中的

‑

在最小集成后允许与该模拟/训练环境(也可以简称为“ste”)的最大兼容性。在没有网络访问的情况下进行训练的变体中,tss/s可以配置为临时存储与训练相关的数据,并且当下次能够建立与ste服务的连接时,将该存储的数据上传到数据湖。在各种实施例中的一个级别处,与训练系统的任何交互发生在客户端上并通过“启动器”开始。启动器可以配置为当经由可穿戴组件(2)访问时使用生物特征或如果从膝上型计算机访问则使用标准用户名和密码来检查用户的凭据。一旦授权,如果可以连接到训练服务,则启动器将

检查训练相关软件的更新,并在必要时应用这些更新。tss/c可以被配置为包括用于显示视觉内容的渲染引擎。在主要用例中,tss/c连接到tss/s,服务器可以配置为向客户端描述合成环境,并且客户端通过可穿戴耳机(2)向用户投射世界。可替代地,渲染引擎的一个版本可以在膝上型计算机或pc或其它设备上执行,从而提供世界数据的“平面屏幕”、非混合现实渲染。在各种实施例中,tss/c的目标是允许用户以不同模式体验世界数据以支持不同目标:混合现实客户端显示器可以被配置为仅在使用特定头戴式耳机(2)时才可操作。该显示模式可以采用专有的空间计算技术,将逼真的合成内容插入用户的视野中。在该模式中,用户可以身体上移动通过真实世界空间;此类模式可能主要用于战术。虚拟客户端显示器可与可穿戴组件(2)或与膝上型计算机/pc一起使用。在pc上,该模式可以配置为示出世界内容的平坦的非混合现实显示,类似于现有的基于pc的训练模拟中使用的内容。在可穿戴耳机上,诸如在此描述的那些可穿戴耳机(2)上,该模式可以被配置为在虚拟现实模式中呈现内容。无论使用何种显示器,当在该模式中时,用户可能身体上是静止的,并且可以经由连接到其客户端的控件(即键盘和鼠标、方向键或手持控制器4)将头像导航通过合成环境。该模式可用于虚拟探索空间(例如,大量的lwm数据)或在训练练习中控制合成实体。

137.混合客户端显示器可能仅在使用特定耳机(诸如在此描述的耳机(2))时才可操作。与混合现实显示一样,该显示模式利用专有的空间计算技术。在混合显示模式中,耳机并没有尝试将内容真实地插入用户的视野中,而是呈现物理空间,并未考虑它在真实世界中的投影位置。在该模式中,用户通过身体上行走而移动通过投影空间,就像在混合现实显示模式中一样。该模式主要用于排练。例如,该模式将允许用户在空仓库内投影从lwm取出的村庄的一部分,并且然后在该位置的按比例投影内走动。

138.在各种实施例中,当连接到tss/s进行训练时,客户端连接分配的特定角色:作为受训者、作为训练员或作为观察者。客户的角色可能会规定向客户呈现的信息以及对客户端可用的控件。例如,训练员看到表现数据并具有更改训练场景的控制,而受训者则看不到。

139.tss/c可以被配置为管理用户输入的接收(例如,当受训者使他们的武器开火时)并捕获相关数据(用户的位置、步枪的取向、采取的射击、触发endex的教官等),以与连接的tss/s通信。

140.当客户端在本可穿戴计算耳机(2)上操作时,耳机可以被配置为捕获生物特征数据,包括心率、眼睛注视和感知的瞳孔扩张。该数据在aar中用于向教官呈现信息,以解决表现问题并指导表现改进。服务器浏览器可用于查找或部署训练服务器。

141.在各种实施例中,当部署时,用户可以指定部署的类型、授权的参与者和要使用的训练场景。完成该操作后,用户可能看到添加到可用服务器列表的训练服务器。

142.当连接到tss/s时,可以向用户呈现已知tss/s实例的列表以及关于每个实例的基本信息。用户选择要连接的服务器以进行训练或观察。

143.提供选项以调节已部署服务器的广告和访问,从而允许开放的“无论何人希望加入的”服务器和仅对某些用户可见的受限服务器之间的所有内容。

144.tmt可以被配置为提供训练场景编辑器,从而允许用户定制创建训练练习。

145.场景创建可以从用于训练的地理位置的规范开始。lwm的部分可用于此,或者用户可以使用耳机(诸如本可穿戴计算耳机(2))上的深度传感器创建网格。经由操作系统提供

的服务,该网格可以上传到lwm中供其他人使用。

146.一旦指定了训练区域,场景编辑器就可以被配置为允许用户为训练区域中的对象选择外观并放置用于训练的合成实体。

147.一旦完成,可以在以后保存和加载场景。该场景与训练位置相关联,允许在同一位置中训练的其他人访问现有训练场景库。可以利用常见练习的模板来指导标准训练场景的创建。此外,所谓的“促成因素”(“enables”)可用于修改任何训练场景。促成因素可包括模块化的“子场景”,旨在允许改变的训练。例如,如果一个班早些时候使用手榴弹炸毁了一个掩体,在下一次演变期间,教官希望他们使用cas完成目标。在各种实施例中,期望的是,几乎任何人都可以通过最少的训练来使用该编辑器。具有足够凭据的用户可以访问底层模拟数据资源。该数据可以扩展和参数化,以允许修改核心模拟“规则”。此类配置允许在报告更准确的细节时快速修改现有模拟数据,并在引入新系统时创建新的模拟实体。“条令编辑器”可以配置为允许具有足够凭据的用户修改和创建控制合成实体在模拟中如何行动的行为。

148.在各种实施例中,这可以是训练员将用来例如创建“对方战斗机”实体并为其分配特征以使其在模拟中以与在战场上观察到的相同的方式执行。

149.行为的基线元素可以被参数化并且可易于调节(例如,“这些敌人通常配备这些武器并在这些范围内展示该准确性水平”)。

150.更复杂的行为(例如,定义特定的伏击技术)可能需要编写脚本,但也可以从条令编辑器内寻址。

151.一旦完成,这里定义的行为可以与特定实体一起保存。这意味着当用户在编辑器中放置特定实体时,该实体会与其一起携带这些行为。因此,更多技术用户可以定义行为,而较少技术用户可以轻松利用它们。

152.训练管理工具可以被配置为为ste提供核心管理功能。具有适当凭据的用户可以使用管理工具来管理用户帐户、更改权限、回顾日志、推广新的应用版本以及执行其它管理功能。

153.在各种实施例中,访问ste的每个用户都可以具有ste账户。帐户工具可用于设置或修改该帐户,以提供有关按日程的训练的提醒并示出性能数据。

[0154]“aar”工具可由训练员在训练课程期间(以在训练发生时回顾表现)或从历史数据(以回顾过去的训练或由不同组执行的训练的表现)访问。此类工具可以被配置为向训练员提供用于显示训练练习的回放的选项。这可以“按比例缩放”(训练的真人大小的再现)或“在地图上”(训练的按比例缩小的图像上的顶视图)完成。

[0155]

回放控制可以被配置为允许修改回放,使得训练员可以以较慢的速度示出训练的部分、可以跳到时间线中的不同点、从某个点倒带、或者为章节设定书签以供回顾。

[0156]

过滤器可以被配置为允许训练员在回放中可视化详细的表现信息。例如,该系统可用于可视化特定操作员在给定点处的心率,或者特定操作员在进入房间时是否清除了给定角落。

[0157]

数据工具可以被配置为提供对存储在数据湖中的训练表现数据的访问权。各种常见的报告可以从该工具自动生成。这些可以针对不同的访问级别(个人、班长、排长等)进行组织。

[0158]

此外,该工具可以被配置为管理对数据池的访问权以允许更多涉及的定制查询。由于已经存在许多商用数据可视化工具,因此这可能旨在管理所需数据到可视化器的接收和传输,而不是重新创建该功能。

[0159]

认证服务器可以是在启动客户端时处理认证请求的服务。当批准时,允许用户访问其它服务。

[0160]

在用户无法连接到认证服务器的拒绝环境中,认证可以被配置为在本地级别发生并且仅允许使用特定设备或本地网络。

[0161]

服务器资源可以被保留用于tss/s使用,从而允许用于训练事件的服务器的云部署。

[0162]

训练操作的几个不同方面可能需要lwm信息。对该信息的访问权可由服务管理。以版本化的原始数据流的形式,来自装有传感器的可穿戴计算耳机(2)的网格传感器数据可以发送到该服务以在发送lwm之前进行预处理。

[0163]

如上所述,用于tse的基于云的数据存储可以包括“数据湖”,该“数据湖”可以例如包含所有账户信息、日志和训练表现数据。前面参考图77,数据湖信息可以从几乎任何连接的位置可用,从而利用访问点,诸如安全的膝上型pc。

[0164]

可以维护驱动空间以提供场景、应用安装、补丁、档案和训练备份的云存储。

[0165]

在此设想的各种合成训练环境实现方式可以结合与军队使用的任何和所有装备有关的信息。下面列出了各种示例。

[0166]

各种实施例涉及步兵战车(“ifv”)乘员训练器。这可以是完整的乘员训练器,该训练器可以在乘员组、ifv、可穿戴计算技术(2、6)、训练场景和时间之前,在没有任何附加资源的情况下在电机池内实现。ifv的驾驶员可以利用可穿戴系统(2、6)并基于控制仪表或可见/可扫描标记的模式识别来定位他在驾驶员座椅中的位置。然后,这可以为设备提供世界框架,以基于区域的控制布局进行数字叠加,这对于ifv内的所有位置(炮手、跟踪指挥官(tc)、装弹手和车载步兵(dismount))都是相同的。现在,可穿戴计算系统(2、6)可以被配置为叠加控制面板读数(炮手视线、驾驶员潜望镜等)的渲染副本,并跟踪用户移动以用于用户和ifv的交互。例如,该设备然后可以被配置为在正确的深度(如通过炮手的视线所见)处渲染正确的刺激信息,以使得炮手可以在与乘员组的其他人员交互的同时练习目标采集和交战。该设备可以被配置为基于该设备的定位位置和随后的头部姿势来跟踪这一点。武器系统可以由车辆命令进行跟踪,该车辆命令通过定向麦克风和耳朵保护主动降噪耳机来记录。这可以被配置为记录发现并交战的敌人开火的射击。敌人交战的理论程序可以彼此口头喊叫,诸如:接触左车载步兵(炮手(g))

‑

识别(tc)

‑

获取目标(g)

‑

开火(tc)

‑

摧毁目标(g)。取决于目标和弹药选择(例如高爆(he)、穿甲和机枪),炮手可能会发射三发连发或很少的二连发。然后该数据可能被收集并发送到tmt,在那里乘员和用户表现与之前的训练、战斗和正交数据聚合,以更新他们的整体杀伤力分数和未来训练场景的训练路线图。在各种实施例中,这可能涉及从用户身上的可穿戴计算系统(2、6)取得传感器数据并创建环境的密集网格模型,并且还跟踪该环境内用户头部的位置/取向(用户的“头部姿势”)。此类信息可以通过应用编程接口(“api”)传递给系统的应用层,其中系统中可以存在扫描模式,其被配置为允许在没有任何外部信息的情况下本地查看该3d网格的选项。在非本地,系统可以被配置为从信息框架内的其它节点提取数据,该数据包括来自其它已卸除、已装入、情报

监视侦察(“isr”)和包括到作战人员可见的世界的3d网格中的外部源的位置和航向信息。这可包括在给定情况下存在的所有陆地、空中、海上和太空部队。该数据可以加时间戳和地理标记,以使得空间数据所在位置到用户眼睛的变换能够受到可穿戴计算系统(2、6)的用户的位置和注视约束。

[0167]

为了从外部源对用户的视角进行正确的信息叠加,可以以可重复的方式识别和重叠特征,否则时间和空间混叠的伪影将提供混淆数据。为了正确叠加,可以使用事实数据,并且也可以使用可通行世界类型架构,以便将不同的虚拟对象和真实对象分割和取向到同一位置。

[0168]

来自外部源到内部源的该世界地图也可用于在变换被计算后查看其他人从他们的设备角度以及从特定用户的角度正在看什么。这促进了诸如穿墙增强现实视觉或远程捕获信息的观察(诸如来自无人驾驶飞机的视频馈送)的功能。采用具有足够分辨率的红/绿/蓝(“rgb”)图片相机或单色图片相机,系统可以被配置为将图像信息叠加在密集网格信息上。为用户提供有关通过网络战士或一些其它信息传输协议和系统共享的环境内包含的内容的更多背景理解。

[0169]

再次参考执法、消防和/或危险材料环境,在本地,很像上述军事风格的实现方式,用户可以通过头部和用户身上的传感器从世界收集数据,创建世界网格,并将其显示叠加在真实世界以及所显示的并具有所包含的交互元素的数据的微型地图中。所有这些都通过api汇集并通过设备的应用层为用户运行。非本地地,系统可以被配置为利用许多相同种类的非用户外围设备和信息向设备的用户中继数据,诸如在远程森林消防场景中。

[0170]

学习网络、神经网络和/或所谓的“人工智能”(或“ai”)计算配置可用于直播流自适应士兵架构,以了解哪些行动信息可能会增加杀伤力、生存能力和流动性。这可以经由机器学习来完成,其中,士兵被给予训练任务,并且模型运行一系列参数和测试用例;基于来自训练事件的输出数据,系统可以被配置为基于向个人示出的数据水平来优化可穿戴计算系统(2、6)的平视显示方面。这是将显示的数据保真度级别个性化到特定用户的方式。另一种实现方式是使用机器学习模型动态更改在压力情况下接收和显示的数据,减少用户的认知负担。虚拟助手或人工合成的角色,诸如图90中描绘的和上述并入的参考文献中描述的角色,可用于使用本可穿戴计算配置(2、6)以诸如一般助理、主管、同事等的角色来协助高效通信。

[0171]

利用本系统的配置也可以增强规划能力。例如,与世界有关的信息可以通过传感器捕获,并且然后发送到权威服务器,一旦通过身份验证,则发送给行动总部或驻地的指挥官。警察、消防员、军队和/或其他服务能够使用此类系统配置在到达现场或行动环境之前进行事件的途中规划和情境演练。参考图71

‑

73,该系统可以被配置为使得指挥官可以使用他们连接的可穿戴计算系统(2、6)观看在他们的地板或咖啡桌上展开的一切,并且可以例如使用手势来协助控制战斗/团队/资源;使用手势来重定向建筑物内的团队等。换句话说,系统可以被配置为使得指挥官通过他的可穿戴计算系统(2、6)观看多视角信息馈送,并且然后通过脑海中的整体画面为他的本地设备提供手势,其中,手势识别机器学习技术配置捕获该动作,并基于该手势的应用定义进行解释,以基于该预先确定的交互方法执行所需的任务。

[0172]

如上所述,系统配置可以涉及与操作员利用的其它通信系统的集成,并且可以显

示用于要避免的障碍物或危险、敌方战斗人员位置和状态等的各种标记类型的可视化,所有这些都可以使用可视化的航路点、标记、音频等对操作员的行动区域进行地理注册。如图70中所示,可穿戴系统可被配置为创建与操作员周围对象的几何形状和位置有关的网格。

[0173]

如上面所述和在上述并入的参考文献中所述,全局和局部动态调光可用于增强在本地环境中采用头戴式组件(2)的各种呈现图像的可视化。参考图74a

‑

74d,示出全局动态调光,其中,整个显示器调暗或变暗(即,从图74a到图74b变暗,并且类似地,结果示为从图74c到图74d变暗)以协助增强某些呈现的图像或内容的可视化。局部动态调光涉及特别是围绕所呈现图像或内容的一个或多个特定部分(诸如操作员眼睛注视指向的区域)周围的对比度调节。此类配置可以协助操作员避免视觉冲刷、闪光失明和对可被称为“定向能武器”的某些武器的光学易损性。当操作员通常处于黑暗环境中时,动态调光也可用于选择性地防止漏光(也称为“光安全维护”或仅是“类似安全性”),因为泄漏可能会被对手方检测到,并且短暂泄漏的强光可能会导致用户瞳孔收缩的变化,这对于通过耳机(2)观看的其余部分变得次优;因此,在许多场景中,有理由阻止光从用户的观看区域的漏入或漏出。

[0174]

参考图75和76,如上所述,该系统可以与各种本地目标可视化和瞄准工具集成,诸如热、红外和/或rbg相机配置,其可以可操作地耦合到武器或其它实现方式,诸如图81

‑

82中所示的那些,并且还通过硬件和软件配置(诸如在此描述和示出的那些,诸如在图83和84中)耦合到数据湖和许多其它资源。

[0175]

参考图78,头戴式组件(2)可以与热和/或红外相机物理集成,如上所讨论,以协助识别附近的某些对象,诸如在其它情况下黑暗环境中的人或动物,如图79中所示。图80示出以cmos传感器技术为特征的低照度相机传感器配置的某些方面,其中,固件、系统软件和硬件针对低照度配置进行了优化。

[0176]

热成像设备可以在在此讨论的许多配置中使用,例如在手势跟踪中协助识别人手相对于其它空间或对象的边界,观察手接触(诸如墙上的手印)之后衰减的热量,去除某些特征(诸如人类或动物)或“漂浮物”以创建房间的网格(即,可以假设98华氏度的人形对象不是墙或其它固定对象)。可以识别其它已知对象,诸如加热器通风口、暴露在阳光下的窗户、热水器、熔炉、壁炉等,并且此类识别可用于提高质量、准确性和速度,据此该可穿戴计算资源(2、6)可用于了解它们周围的世界和相关联用户。例如,在可穿戴组件(2)可以被配置为参与面部识别分析,而不是在整个房间中搜索与给定数据库匹配的面部特征的实施例中,系统可以被配置为首先识别易于接近的面部,该面部可能未被覆盖并且易于热识别为约98华氏度;然后一旦定位一个或多个面部,将更多的计算资源花费在这些像素上,而不是整个房间;换句话说,在进行面部识别时,应关注面部,而不是用户本地事物超集中的所有内容,并且为此,能够使用热配置来识别面部的系统是有价值的。对于急救人员或消防员来说,物品可能会被标记为太烫而无法触摸。面向内传感器可用于检测操作员的体温,或面向外传感器用于感测其他人的状况(例如,不仅指出横跨房间的另一个人的存在,而且指出他们似乎发烧,或他们似乎拿着似乎最近被射击过的长枪;或者可能他们的包里似乎具有类似于最近已经操作的膝上型计算机的一些类型的放热对象;或者可能基于体温,被观看的人似乎在8小时前已经死亡)。热传感器配置也可用于协助标记某些对象,诸如狗、猫或人,并且甚至在视觉上将某些内容或图像与它们相关联(例如,系统可配置为将亮红色的帽子放在每个识别的敌方战斗人员上;或者留一个粉红色的小胡子,该小胡子随着特定的狗或

猫的面部四处移动)。例如对于遇到未知情况的消防员,热条件和梯度可以被可视化和颜色编码。

[0177]

在其它实施例中,热成像可用于协助给定房间中的照明条件(即,一个或多个照明源的位置和方向性)的地图绘制,以协助ar中呈现的虚拟内容的阴影模拟。此外,一些对象会随着温度的变化而改变形状,如果该信息已知,则会提供另一个数据点。在各种实施例中,如果具有可穿戴计算系统(2)的用户在房间中并且基于可见光相机姿势检测被注册到房间

‑

并且还将某些热元件(诸如加热器通风口、鱼缸、一个或多个灯、电器)映射到房间的该空间理解中,并且然后灯突然熄灭,则用户可以通过使用热元件保持对房间的注册。热成像还可用于协助地平线确定和匹配

‑

其中,世界的阳光暴露部分在温度上升高。

[0178]

在诸如图78中所示的各种实施例中,基于用户的实际注视针对视差校正图像,或者进行实时或近实时雅可比变换以解决一个或多个成像设备可能没有在与用户眼睛注视的相同捕获位置处定位的事实;这可以基于一个成像设备对每只眼睛进行,只要此类成像设备捕获双眼的两个注视视野即可。

[0179]

各种实施例可以被配置为也快速识别作为平面元件的窗口,该平面元件对于传统可见光相机至少部分地透明,但是可以具有将它们与开放空间区分开的飞行时间信号、散射和热特性。传统上,窗口的识别对计算机视觉系统来说是特定挑战。

[0180]

参考图85,示出集成了各种复杂的传感器的可穿戴组件(2)的另一实施例。各种配置可以直接耦合到操作员的头部、头盔、车辆、飞机内部等。

[0181]

参考图91,示出地图绘制设备实施例,其中可移除地耦合到充电器基座的地图绘制/成像单元被配置为创建房间的点云并且将rbg图像叠加在此类房间的捕获点云网格上,并在操作时实时或近实时地更新它。图92示出也可以例如通过rgb相机在充足的光线下观看的人的几何形状的点云版本。

[0182]

参考图93,示出袖带辅助模块的实施例,其中在需要某些类型的生物特征监视时(诸如在紧急或危险情况下)可将类似于稍大的表带的可手腕佩戴的袖带耦合到用户,以使得其他人可以利用收集和可用的数据(即诸如通过云连接)来监视诸如位置(诸如通过gps、移动收发机三角测量和/或ip地址)、心脏状况/输出、温度等的因素。袖带还可以包含某些医疗成分,诸如镇痛剂,其可以手动或自动(即,诸如远离操作中心或连接的同事)通过袖带引入用户身体。在各种实施例中,它可以无线耦合到在此描述的可穿戴计算资产(2、6)。

[0183]

混合现实环境

[0184]

像所有人一样,混合现实系统的用户存在于真实环境中,也就是说,用户可感知的“真实世界”的三维部分及其所有内容。例如,用户使用普通人的感官—视觉、听觉、触觉、味觉、嗅觉—感知真实环境,并通过在真实环境中移动自己的身体来与真实环境交互。真实环境中的位置可以描述为坐标空间中的坐标;例如,坐标可以包括相对于海平面的纬度、经度和海拔;与参考点的三个正交维度的距离;或其它合适的值。同样,矢量可以描述在坐标空间中具有方向和大小的量。

[0185]

计算设备可以在例如与该设备相关联的存储器中维持虚拟环境的表示。如在此所使用,虚拟环境是三维空间的计算表示。虚拟环境可以包括与该空间相关联的任何对象、动作、信号、参数、坐标、矢量或其它特征的表示。在一些示例中,计算设备的电路(例如,处理器)可以维持和更新虚拟环境的状态;也就是说,处理器可以在第一时间t0基于与虚拟环境

相关联的数据和/或用户提供的输入,确定在第二时间t1的虚拟环境的状态。例如,如果虚拟环境中的对象在时间t0位于第一坐标,并且具有某些编程的物理参数(例如,质量、摩擦系数);并且从用户接收到的输入指示应该在方向矢量中向对象施加力;则处理器可以应用运动学定律使用基本力学来确定对象在时间t1的位置。处理器可以使用关于虚拟环境已知的任何合适的信息和/或任何合适的输入来确定虚拟环境在时间t1的状态。在维持和更新虚拟环境的状态时,处理器可以执行任何合适的软件,包括与虚拟环境中虚拟对象的创建和删除相关的软件;用于定义在虚拟环境中虚拟对象或角色的行为的软件(例如脚本);用于定义虚拟环境中信号(例如音频信号)行为的软件;用于创建和更新与虚拟环境相关联的参数的软件;用于在虚拟环境中生成音频信号的软件;用于处理输入和输出的软件;用于实现网络操作的软件;用于应用资产数据的软件(例如,随着时间推移移动虚拟对象的动画数据);或许多其它可能性。

[0186]

诸如显示器或扬声器的输出设备可以向用户呈现虚拟环境的任何或所有方面。例如,虚拟环境可以包括可以呈现给用户的虚拟对象(其可以包括无生命对象;人;动物;灯的表示等)。处理器可以确定虚拟环境的视图(例如,对应具有原点坐标、视图轴和视锥体的“相机”);并且将与该视图对应的虚拟环境的可视场景渲染到显示器。为此可以使用任何合适的渲染技术。在一些示例中,可视场景可以仅包括虚拟环境中的一些虚拟对象,而排除某些其它虚拟对象。类似地,虚拟环境可以包括可以作为一个或多个音频信号呈现给用户的音频方面。例如,虚拟环境中的虚拟对象可以生成源自对象的位置坐标的声音(例如,虚拟角色可以说话或引起声音效果);或者虚拟环境可与音乐提示或环境声音相关联,该音乐提示或环境声音可与或者可不与特定位置相关联。处理器可以确定与“听者”坐标对应的音频信号—例如,与虚拟环境中的声音合成对应、并被混合和处理以模拟听者在听者坐标处听到的音频信号的音频信号—并经由一个或多个扬声器向用户呈现音频信号。

[0187]

由于虚拟环境仅作为计算结构存在,因此用户无法使用普通感官直接感知虚拟环境。相反,用户仅可间接感知例如通过显示器、扬声器、触觉输出设备等呈现给用户的虚拟环境。类似地,用户不能直接触摸、操纵或以其它方式与虚拟环境交互;但可以经由输入设备或传感器向处理器提供输入数据,该处理器可以使用设备或传感器数据来更新虚拟环境。例如,相机传感器可以提供指示用户正试图移动虚拟环境中的对象的光学数据,并且处理器可以使用该数据使对象在虚拟环境中相应地响应。作为另一示例,加速度计、陀螺仪传感器或外围设备(例如,下面描述的控制器300)中的其它类型的传感器可以提供指示用户正试图使用外围设备来操纵虚拟环境中的对象的运动数据和/或设备取向数据,并且处理器可以使用该数据使对象在虚拟环境中相应地响应。也可以采用其它合适类型的传感器数据。

[0188]

混合现实系统可以例如使用透射式显示器和/或一个或多个扬声器(其可以例如并入可穿戴头部设备中)向用户呈现结合真实环境和虚拟环境的各方面的混合现实环境(“mre”)。在一些实施例中,一个或多个扬声器可以在头戴式可穿戴单元的外部。如在此所使用的,mre是真实环境和对应的虚拟环境的同时表示。在一些示例中,对应的真实和虚拟环境共享单个坐标空间;在一些示例中,真实坐标空间和对应的虚拟坐标空间通过变换矩阵(或其它合适的表示)彼此相关。因此,单个坐标(在一些示例中,连同变换矩阵)可以定义真实环境中的第一位置,以及虚拟环境中的第二对应位置;反之亦然。

[0189]

在mre中,虚拟对象(例如,在与mre相关联的虚拟环境中)可以对应于真实对象(例如,在与mre相关联的真实环境中)。例如,如果mre的真实环境包括位置坐标处的真实灯柱(真实对象),则mre的虚拟环境可以包括对应位置坐标处的虚拟灯柱(虚拟对象)。如在此所使用的,真实对象与其对应的虚拟对象组合在一起构成“混合现实对象”。虚拟对象没有必要与对应的真实对象完美匹配或对齐。在一些示例中,虚拟对象可以是对应的真实对象的简化版本。例如,如果真实环境包括真实灯柱,则对应的虚拟对象可以包括与真实灯柱高度和半径大致相同的圆柱体(反映灯柱在形状上可以是大致圆柱体)。以该方式简化虚拟对象可以允许计算效率,并且可以简化对此类虚拟对象执行的计算。此外,在mre的一些示例中,并非真实环境中的所有真实对象都可以与对应的虚拟对象相关联。同样,在mre的一些示例中,并非虚拟环境中的所有虚拟对象都可以与对应的真实对象相关联。也就是说,一些虚拟对象可能仅在mre的虚拟环境中,而没有任何真实世界的对应物。

[0190]

在一些示例中,虚拟对象可具有与对应的真实对象的特性不同的特性,有时甚至是截然不同的特性。例如,虽然mre中的真实环境可包括绿色的双臂仙人掌—带刺的无生命对象—但mre中对应的虚拟对象可具有带有人类面部特征和一副凶相的绿色双臂虚拟角色的特征。在该示例中,虚拟对象在某些特征(颜色、手臂数量)方面与其对应的真实对象相似;但在其它特征(面部特征、个性)方面与真实对象有所不同。这样,虚拟对象就有可能以创造性的、抽象的、夸张的或幻想的方式来表示真实对象;或将行为(例如,人类个性)赋予其它无生命的真实对象。在一些示例中,虚拟对象可以是不具有真实世界对应物的纯幻想创作(例如,虚拟环境中的虚拟怪物,可能位于与真实环境中的空白空间对应的位置处)。

[0191]

与向用户呈现虚拟环境同时遮蔽真实环境的vr系统相比,呈现mre的混合现实系统提供的优势在于在呈现虚拟环境的同时真实环境保持可感知。因此,混合现实系统的用户能够使用与真实环境相关联的视觉和音频提示来体验对应的虚拟环境并与之交互。例如,虽然vr系统的用户可能难以感知虚拟环境中显示的虚拟对象或与之交互—因为如上所述,用户无法直接感知虚拟环境或与之交互—但mr系统的用户可能会发现通过在他或她自己的真实环境中看、听和触摸对应的真实对象来与虚拟对象交互是直观和自然的。该级别的交互性可以增强用户对虚拟环境的沉浸感、联系感和参与感。同样,通过同时呈现真实环境和虚拟环境,混合现实系统可以减少与vr系统相关联的负面心理感受(例如认知失调)和负面身体感受(例如晕车)。混合现实系统进一步为可能增强或改变我们对真实世界的体验的应用提供了许多可能性。

[0192]

图105a示出用户110使用混合现实系统112的示例真实环境100。例如如下所述,混合现实系统112可以包括显示器(例如,透射式显示器)和一个或多个扬声器,以及一个或多个传感器(例如,相机)。所示的真实环境100包括用户110站在其中的矩形房间104a;以及真实对象122a(灯)、124a(桌子)、126a(沙发)和128a(画)。房间104a进一步包括位置坐标106,该位置坐标106可以被认为是真实环境100的原点。如在图105a中所示,其原点在点106处(世界坐标)的环境/世界坐标系108(包括x轴108x、y轴108y和z轴108z)可以定义用于真实环境100的坐标空间。在一些实施例中,环境/世界坐标系108的原点106可以对应于混合现实系统112被通电的位置。在一些实施例中,环境/世界坐标系108的原点106可以在操作期间被重置。在一些示例中,用户110可以被认为是真实环境100中的真实对象;类似地,用户110的身体部位(例如,手、脚)可以被认为是真实环境100中的真实对象。在一些示例中,其

原点在点115处(例如用户/听者/头部坐标)的用户/听者/头部坐标系114(包括x轴114x、y轴114y和z轴114z)可以定义混合现实系统112所在的用户/听者/头部的坐标空间。可以相对于混合现实系统112的一个或多个组件来定义用户/听者/头部坐标系114的原点115。例如,诸如在混合现实系统112的初始校准期间,可以定义用户/听者/头部坐标系114相对于混合现实系统112的显示器的原点115。矩阵(其可以包括平移矩阵和四元数矩阵或其它旋转矩阵)或其它合适的表示可以表征用户/听者/头部坐标系114空间和环境/世界坐标系108空间之间的变换。在一些实施例中,可以相对于用户/听者/头部坐标系114的原点115定义左耳坐标116和右耳坐标117。矩阵(其可以包括平移矩阵和四元数矩阵或其它旋转矩阵),或其它合适的表示可以表征左耳坐标116和右耳坐标117与用户/听者/头部坐标系114空间之间的变换。用户/听者/头部坐标系114可以简化相对于用户头部或头戴式设备(例如相对于环境/世界坐标系108)的位置表示。使用同时定位和地图绘制(slam)、视觉里程计或其它技术,可以实时确定和更新用户坐标系114和环境坐标系108之间的变换。

[0193]

图105b示出与真实环境100对应的示例虚拟环境130。所示的虚拟环境130包括与真实矩形房间104a对应的虚拟矩形房间104b;与真实对象122a对应的虚拟对象122b;与真实对象124a对应的虚拟对象124b;以及与真实对象126a对应的虚拟对象126b。与虚拟对象122b、124b、126b相关联的元数据可以包括从对应的真实对象122a、124a、126a导出的信息。虚拟环境130另外包括不与真实环境100中的任何真实对象对应的虚拟怪物132。真实环境100中的真实对象128a不对应于虚拟环境130中的任何虚拟对象。其原点在点134处(持久坐标)的持久坐标系133(包括x轴133x、y轴133y和z轴133z)可以定义用于虚拟内容的坐标空间。持久坐标系133的原点134可以相对于/关于一个或多个真实对象(诸如真实对象126a)来定义。矩阵(其可以包括平移矩阵和四元数矩阵或其它旋转矩阵)或其它合适的表示可以表征持久坐标系133空间和环境/世界坐标系108空间之间的变换。在一些实施例中,虚拟对象122b、124b、126b和132中的每一个可以具有相对于持久坐标系133的原点134它们自己的持久坐标点。在一些实施例中,可以存在多个持久坐标系并且虚拟对象122b、124b、126b和132中的每一个可以具有相对于一个或多个持久坐标系的它们自己的持久坐标点。

[0194]

关于图105a和105b,环境/世界坐标系108定义了用于真实环境100和虚拟环境130二者的共享坐标空间。在所示的示例中,坐标空间具有在点106处的原点。此外,坐标空间由相同的三个正交轴(108x、108y、108z)定义。因此,可以关于相同的坐标空间来描述真实环境100中的第一位置和虚拟环境130中的第二对应位置。这简化了在真实和虚拟环境中识别和显示对应位置,因为相同的坐标可用于识别两个位置。然而,在一些示例中,对应的真实和虚拟环境不需要使用共享坐标空间。例如,在一些示例(未示出)中,矩阵(其可以包括平移矩阵和四元数矩阵或其它旋转矩阵)或其它合适的表示可以表征真实环境坐标空间和虚拟环境坐标空间之间的变换。

[0195]

图105c示出经由混合现实系统112向用户110同时呈现真实环境100和虚拟环境130的各方面的示例mre 150。在所示示例中,mre 150同时向用户110呈现来自真实环境100的真实对象122a、124a、126a和128a(例如,经由混合现实系统112的显示器的透射部分);以及来自虚拟环境130的虚拟对象122b、124b、126b和132(例如,经由混合现实系统112的显示器的主动显示部分)。如上所述,原点106充当与mre 150对应的坐标空间的原点,并且坐标系108定义用于坐标空间的x轴、y轴和z轴。

[0196]

在所示示例中,混合现实对象包括占据坐标空间108中对应位置的对应真实对象和虚拟对象对(即,122a/122b、124a/124b、126a/126b)。在一些示例中,真实对象和虚拟对象二者可以同时对用户110可见。例如,在虚拟对象呈现设计为增强对应真实对象的视图的信息的情况下(诸如在博物馆应用中,其中虚拟对象呈现古代损坏的雕塑的缺失部分),这可能是可取的。在一些示例中,可以显示虚拟对象(122b、124b和/或126b)(例如,经由使用像素化遮挡快门的主动像素化遮挡)以便遮挡对应的真实对象(122a、124a和/或126a)。例如,在虚拟对象充当对应的真实对象的视觉替代品的情况下(诸如在交互式讲故事应用中,其中无生命的真实对象变成“活的”角色),这可能是可取的。

[0197]

在一些示例中,真实对象(例如,122a、124a、126a)可以与不一定构成虚拟对象的虚拟内容或助手数据相关联。虚拟内容或助手数据可以促进混合现实环境中虚拟对象的处理或处置。例如,此类虚拟内容可以包括对应真实对象的二维表示;与对应真实对象相关联的自定义资产类型;或与对应真实对象相关联的统计数据。该信息可以启用或促进涉及真实对象的计算,而不会产生不必要的计算开销。

[0198]

在一些示例中,上述演示还可以结合音频方面。例如,在mre 150中,虚拟怪物132可以与一个或多个音频信号(诸如当怪物在mre 150周围走动时生成的脚步声效果)相关联。如在此进一步描述的,混合现实系统112的处理器可以计算与mre 150中所有此类声音的混合和处理的合成对应的音频信号,并经由混合现实系统112中包括的一个或多个扬声器和/或一个或多个外部扬声器向用户110呈现音频信号。

[0199]

示例混合现实系统

[0200]

示例混合现实系统112可以包括:可穿戴头部设备(例如,可穿戴增强现实或混合现实头部设备),其包括显示器(其可以包括可以是近眼显示器的左透射显示器和右透射显示器,以及用于将来自显示器的光耦合到用户眼睛的相关联组件);左扬声器和右扬声器(例如,分别邻近用户的左耳和右耳定位);惯性测量单元(imu)(例如,安装到头部设备的镜腿);正交线圈电磁接收机(例如,安装到左镜腿件);远离用户取向的左相机和右相机(例如,深度(飞行时间)相机);以及朝向用户取向的左眼相机和右眼相机(例如,用于检测用户的眼睛运动)。然而,混合现实系统112可以结合任何合适的显示技术和任何合适的传感器(例如,光学、红外、声学、lidar、eog、gps、磁)。此外,混合现实系统112可以结合联网特征(例如,wi

‑

fi能力)以与包括其它混合现实系统的其它设备和系统进行通信。混合现实系统112可以进一步包括电池(其可以安装在辅助单元中,诸如设计为佩戴在用户腰部周围的腰包)、处理器和存储器。混合现实系统112的可穿戴头部设备可以包括跟踪组件,诸如imu或其它合适的传感器,其被配置为输出可穿戴头部设备相对于用户环境的一组坐标。在一些示例中,跟踪组件可以向执行同时定位和地图绘制(slam)和/或视觉里程计算法的处理器提供输入。在一些示例中,如下面进一步描述的,混合现实系统112还可以包括手持控制器300和/或可以是可穿戴腰包的辅助单元320。

[0201]

图2a

‑

2d示出可用于向用户呈现mre(其可对应于mre 150)或其它虚拟环境的示例混合现实系统200(其可对应于混合现实系统112)的组件。图106a示出示例混合现实系统200中包括的可穿戴头部设备2102的透视图。图106b示出佩戴在用户头部2202上的可穿戴头部设备2102的顶视图。图106c示出可穿戴头部设备2102的前视图。图106d示出可穿戴头部设备2102的示例目镜2110的边缘视图。如图2a

‑

2c中所示,示例可穿戴头部设备2102包括

示例左目镜(例如,左透明波导组目镜)2108和示例右目镜(例如,右透明波导组目镜)2110。每个目镜2108和2110可以包括通过其可以看到真实环境的透射元件,以及用于呈现与真实环境重叠的显示(例如,经由图像调制光)的显示元件。在一些示例中,此类显示元件可以包括用于控制图像调制光的流动的表面衍射光学元件。例如,左目镜2108可以包括左入耦合光栅组2112、左正交瞳孔扩展(ope)光栅组2120和左出射(输出)光瞳扩展(epe)光栅组2122。类似地,右目镜2110可以包括右入耦合光栅组2118、右ope光栅组2114和右epe光栅组2116。图像调制光可以经由入耦合光栅2112和2118、ope 2114和2120以及epe 2116和2122传输到用户的眼睛。每个入耦合光栅组2112、2118可以被配置为将光朝向其对应的ope光栅组2120、2114偏转。每个ope光栅组2120、2114可以被设计为将光逐渐向下朝向其相关联的epe 2122、2116偏转,从而水平地延伸形成的出瞳。每个epe 2122、2116可以被配置为将从其对应的ope光栅组2120、2114接收的光的至少一部分逐渐地向外重定向到限定在目镜2108、2110后面的用户眼动范围位置(未示出),从而垂直延伸在眼动范围处形成的出瞳。可替代地,代替入耦合光栅组2112和2118、ope光栅组2114和2120以及epe光栅组2116和2122,目镜2108和2110可以包括用于控制图像调制光到用户眼睛的耦合的光栅和/或折射和反射特征的其它布置。

[0202]

在一些示例中,可穿戴头部设备2102可以包括左镜腿2130和右镜腿2132,其中,左镜腿2130包括左扬声器2134并且右镜腿2132包括右扬声器2136。正交线圈电磁接收机2138可位于左镜腿件中,或可穿戴头部单元2102中的另一合适位置。惯性测量单元(imu)2140可位于右镜腿2132中,或可穿戴头部单元2102中的另一合适位置。可穿戴头部设备2102还可以包括左深度(例如,飞行时间)相机2142和右深度相机2144。深度相机2142、2144可以适当地在不同的方向中取向以便共同覆盖更广阔的视野。

[0203]

在图2a

‑

2d中所示的示例中,左图像调制光源2124可以通过左入耦合光栅组2112光学耦合到左目镜2108中,并且右图像调制光源2126可以通过右入耦合光栅组2118光学耦合到右目镜2110中。图像调制光源2124、2126可以包括例如光纤扫描仪;投影仪,其包括电子光调制器,诸如数字光处理(dlp)芯片或硅基液晶(lcos)调制器;或发射显示器,诸如每侧使用一个或多个透镜耦合到入耦合光栅组2112、2118中的微型发光二极管(μled)或微型有机发光二极管(μoled)面板。输入耦合光栅组2112、2118可以将来自图像调制光源2124、2126的光偏转至目镜2108、2110的全内反射(tir)临界角以上的角度。ope光栅组2114、2120逐渐偏转通过tir向下朝向epe光栅组2116、2122传播的光。epe光栅组2116、2122将光朝向用户的面部(包括用户的眼睛的瞳孔)逐渐耦合。

[0204]

在一些示例中,如图2d中所示,左目镜2108和右目镜2110中的每一个包括多个波导2402。例如,每个目镜2108、2110可以包括多个单独的波导,每个都专用于相应的颜色通道(例如,红色、蓝色和绿色)。在一些示例中,每个目镜2108、2110可以包括多组此类波导,每组被配置为将不同的波前曲率赋予发射光。波前曲率可以关于用户的眼睛是凸面的,例如以呈现位于用户前方一定距离处(例如,与波前曲率的倒数对应的距离)的虚拟对象。在一些示例中,epe光栅组2116、2122可以包括弯曲的光栅凹槽以通过改变跨每个epe的出射光的坡印廷矢量来实现凸波前曲率。

[0205]

在一些示例中,为了创建所显示的内容是三维的感知,立体调节的左眼和右眼图像可以通过图像光调制器2124、2126和目镜2108、2110向用户呈现。可以通过选择波导(并

因此对应波前曲率)以使得虚拟对象显示在与立体左图像和右图像指示的距离近似的距离处来增强三维虚拟对象的呈现的感知真实感。该技术还可以减少一些用户经历的晕动病,这可能是由立体左眼和右眼图像提供的深度感知提示与人眼的自主调节(例如,对象距离相关的焦点)之间的差异引起的。

[0206]

图106d示出从示例可穿戴头部设备2102的右目镜2110的顶部看的面向边缘的视图。如在图2d中所示,多个波导2402可以包括三个波导的第一子集2404和三个波导的第二子集2406。波导的两个子集2404、2406可以通过以不同光栅线曲率为特征的不同epe光栅来区分,以将不同的波前曲率赋予出射光。在波导子集2404、2406中的每一个子集内,每个波导可以用于将不同的光谱通道(例如,红色、绿色和蓝色光谱通道之一)耦合到用户的右眼2206。尽管在图2d中未示出,左目镜2108的结构类似于右目镜2110的结构。

[0207]

图107a示出混合现实系统200的示例手持控制器组件300。在一些示例中,手持控制器300包括抓握部分346和沿着顶表面348设置的一个或多个按钮350。在一些示例中,按钮350可以被配置为用作光学跟踪目标,例如,用于与相机或其它光学传感器(其可以安装在混合现实系统200的头部单元(例如,可穿戴头部设备2102)中)结合跟踪手持控制器300的六自由度(6dof)运动。在一些示例中,手持控制器300包括用于检测位置或取向(诸如相对于可穿戴头部设备2102的位置或取向)的跟踪组件(例如,imu或其它合适的传感器)。在一些示例中,此类跟踪组件可以定位在手持控制器300的手柄中,和/或可以机械耦合到手持控制器。手持控制器300可被配置为提供与按钮的一种或多种按下状态或手持控制器300的位置、取向和/或运动对应的一种或多种输出信号(例如,经由imu)。此类输出信号可以用作混合现实系统200的处理器的输入。此类输入可以对应于手持控制器的位置、取向和/或移动(并且,通过扩展,对应于握住控制器的用户的手的位置、取向和/或移动)。此类输入也可以对应于用户按压按钮350。

[0208]

图107b示出混合现实系统200的示例辅助单元320。辅助单元320可以包括电池以提供操作系统200的能量,并且可以包括用于执行程序以操作系统200的处理器。如图所示,示例辅助单元320包括夹子2128,诸如用于将辅助单元320附接到用户的腰带。其它形状因素适用于辅助单元320并且将是明显的,包括不涉及将单元安装到用户腰带的形状因素。在一些示例中,辅助单元320通过可以包括例如电线和光纤的多导管电缆耦合到可穿戴头部设备2102。也可以使用辅助单元320和可穿戴头部设备2102之间的无线连接。

[0209]

在一些示例中,混合现实系统200可以包括一个或多个麦克风以检测声音并向混合现实系统提供对应的信号。在一些示例中,麦克风可以附接到可穿戴头部设备2102或与其集成,并且可以被配置为检测用户的语音。在一些示例中,麦克风可以附接到手持控制器300和/或辅助单元320或与手持控制器300和/或辅助单元320集成。此类麦克风可以被配置为检测环境声音、环境噪声、用户或第三方的声音或其它声音。

[0210]

图108示出示例功能框图,其可以对应于示例混合现实系统,诸如上述混合现实系统200(其可以对应于关于图1的混合现实系统112)。如图108中所示,示例手持控制器400b(其可以对应于手持控制器300(“图腾”))包括图腾到可穿戴头部设备六自由度(6dof)图腾子系统404a,并且示例可穿戴头部设备400a(其可以对应于可穿戴头部设备2102)包括图腾到可穿戴头部设备6dof子系统404b。在示例中,6dof图腾子系统404a和6dof子系统404b合作来确定手持控制器400b相对于可穿戴头部设备400a的六个坐标(例如,三个平移方向中

420可以包括耦合到左图像调制光源424的左通道输出和耦合到右图像调制光源426的右通道输出。例如如上面关于图2a

‑

2d所述,gpu 420可以将立体图像数据输出到图像调制光源424、426。dsp音频空间化器422可以将音频输出到左扬声器412和/或右扬声器414。dsp音频空间化器422可以接收来自处理器419的输入,该输入指示从用户到虚拟声源(其可以由用户例如经由手持控制器320移动)的方向矢量。基于该方向矢量,dsp音频空间化器422可以确定对应的hrtf(例如,通过访问hrtf,或通过内插多个hrtf)。dsp音频空间化器422然后可以将确定的hrtf应用于音频信号,诸如与由虚拟对象生成的虚拟声音对应的音频信号。这可以通过在混合现实环境中结合用户相对于虚拟声音的相对位置和取向—也就是说,通过呈现与虚拟声音听起来就像是真实环境中的真实声音的用户期望匹配的虚拟声音,来增强虚拟声音的可信度和真实感。

[0214]

在一些示例中,诸如图108中所示,处理器416、gpu 420、dsp音频空间化器422、hrtf存储器425和音频/视觉内容存储器418中的一个或多个可被包括在辅助单元400c(其可对应于上述辅助单元320)中。辅助单元400c可以包括电池427以为其组件供电和/或向可穿戴头部设备400a或手持控制器400b供电。在可以安装到用户腰部的辅助单元中包括此类组件,可以限制可穿戴头部设备400a的大小和重量,这转而可以减少用户头部和颈部的疲劳。

[0215]

虽然图108呈现了与示例混合现实系统的各种组件对应的元素,但是这些组件的各种其它合适的布置对于本领域技术人员将变得明显。例如,如与辅助单元400c相关联的图108中呈现的元件可以替代地与可穿戴头部设备400a或手持控制器400b相关联。此外,一些混合现实系统可以完全放弃手持控制器400b或辅助单元400c。此类改变和修改应理解为包括在所公开示例的范围内。

[0216]

系统架构

[0217]

混合现实系统的目标可以是合成真实世界的信息并向用户提供以其他方式用户可能不可用和/或不易于访问的信息。当用户需要在短时间段内处理大量信息以做出决定时,混合现实系统的优势可能特别明显。在这些情况下,通过让用户轻松访问相关信息,混合现实系统特别适合帮助用户做出决策。例如,在战斗情况下,士兵可能从诸如其武器弹匣中的剩余弹药、班成员的位置和/或敌方战斗人员的位置的信息中受益。可以经由例如混合现实系统的透视显示器向士兵呈现该信息—以其他方式士兵可能无法获得该信息。

[0218]

因为混合现实系统可以接收和解析大量真实世界的信息,所以高效的计算架构可以为混合现实系统产生改进的用户体验和增强的能力。高效的计算架构可以允许混合现实系统快速处理来自各种真实世界信息源的输入。例如,返回参考图8,包括耳机2和腰包6(其可以对应于mr系统112、200)的混合现实系统可以从一个或多个武器接收真实世界的输入,该一个或多个武器可以可通信地耦合到混合现实系统。一个或多个武器可以各自包括耦合到微处理器的一个或多个传感器。例如,传感器可以检测弹匣中剩余的弹药量,并且该信息可以发送到微处理器。武器的微处理器可以经由有线和/或无线通信将该信息传送给混合现实系统。例如,武器的微处理器可以使用通用串行总线(“usb”)连接和/或射频通信(例如,wifi、蓝牙、蜂窝网络、5g)与混合现实系统通信。

[0219]

在一些实施例中,混合现实系统与包括微处理器的设备通信可能更有效。例如,消防员套件监视器可以包括灭火器,并且灭火器可以包括被配置为检测灭火器中剩余的抑制

剂的量的一个或多个传感器。在一些实施例中,灭火器可以包括被配置为与一个或多个传感器通信的微处理器。微处理器可以被配置为接收来自传感器的原始输入(例如,电压水平)并相应地计算抑制剂的剩余量。然后,灭火器的微处理器可以将该信息以混合现实系统可以读取的数据结构传送给混合现实系统。该计算架构可以通过将一个或多个计算卸载到连接设备的微处理器来减轻放置在混合现实系统上的计算负担。

[0220]

在一些实施例中,混合现实系统直接与所连接的设备上的传感器通信可能更有效。例如,可以将cuff assistant设备佩戴在用户的手腕上,并且cuff assistant可以包括配置为测量用户心率的传感器。在一些实施例中,传感器可以使用有线和/或无线方式直接与混合现实系统(例如,没有中间设备微处理器)通信。混合现实系统可以被配置为从传感器接收原始输入(例如,电压水平)并相应地计算心率。可能更经济有效的是,连接设备包括直接与混合现实系统通信的传感器,以及连接设备省略单独的微处理器。在一些实施例中,省略设备专用微处理器可以降低所连接设备的制造成本,但是可能增加用作所连接设备的集线器的混合现实系统上的计算负担。例如,可能需要混合现实系统根据电压读数计算心率,而不是将计算卸载到设备专用微处理器。

[0221]

图57示出用于大规模混合现实应用的示例性计算架构。在一些实施例中,多个混合现实系统(例如,mr系统112、200)可以彼此连接和/或连接到外部计算系统(例如,基于云的服务器)。互连的计算架构可以实现可能依赖大量数据和计算资源的大规模混合现实应用。在一些实施例中,高效的计算架构可以平衡对快速、低延迟计算和复杂、处理密集型计算的需求。在一些实施例中,高效的计算架构可以实现边缘计算原理。边缘计算原理可以包括跨多个系统划分计算任务和/或战略性地定位计算系统以最小化系统之间的通信延迟。

[0222]

例如,图57中所示的示例性计算架构可用于军事训练演习。在大规模混合现实的战争游戏应用中,可以部署许多士兵(例如,100、1,000或10,000)来测试、开发和/或实现军事战略。单独的士兵可能配备他们自己的混合现实系统,其中可包括头戴式设备(例如,mr系统112、200)。单独的混合现实系统可以捕获大量真实世界的数据。例如,单独的混合现实系统可以捕获士兵生命体征、剩余弹药、士兵定位、通信、武器状态等。混合现实系统还可以捕获关于真实对象的位置和/或士兵关于真实对象的位置/取向(例如,经由slam)的信息。在一些实施例中,由混合现实系统(例如,由单独士兵使用的混合现实系统)捕获的信息可以彼此通信和/或与外部计算系统(例如,一个或多个服务器)通信。混合现实系统可以经由任何合适的方式彼此通信和/或与外部计算系统通信。例如,混合现实系统可以经由有线和/或无线连接通信,包括但不限于:usb连接、蜂窝网络、wifi、蓝牙、5g(毫米波和/或低于6ghz)等。

[0223]

在一些实施例中,可以将单独的混合现实系统组织到一个或多个组中。例如,如图57中所示,一组10名士兵可被分配到特定的班/排/连。由那10名士兵使用的混合现实系统可以与远程操作服务器5702通信。在一些实施例中,远程操作服务器5702可以聚合由班的混合现实系统收集的数据。在一些实施例中,可能不需要低延迟操作的计算复杂的任务可以在远程操作服务器5702上执行。例如,每个单独的混合现实系统可以生成它自己对真实对象位置和定位的了解(例如,经由slam)。在一些实施例中,该信息可以被传输到远程操作服务器5702,该远程操作服务器5702可以优化跨多个混合现实系统确定的对象位置和定位。多个士兵可从不同的视角对同一真实对象进行重复观察,并且合成多个slam数据流可

产生对真实世界对象位置和定位的更准确估计。

[0224]

在一些实施例中,单独的混合现实系统可以根据本地的初步的slam计算来显示虚拟对象。单独的混合现实系统执行“第一遍”slam估计可能是有益的,因为混合现实系统可依赖slam来视觉上显示与真实对象相关的虚拟对象(例如,当士兵四处走动时,虚拟目标可以出现在同一真实位置)。本地计算slam可以允许混合现实系统以低延迟的方式视觉上显示虚拟对象,这可以改善用户体验(例如,通过允许混合现实系统实时显示虚拟对象)。在一些实施例中,可以远程执行slam优化(例如,在远程操作服务器5702处)。在一些实施例中,可以将优化数据发送回混合现实系统,该混合现实系统可以使用该数据来更新虚拟对象的视觉显示。在美国临时专利申请序列号62/923,317中可以找到关于使用附加观察优化slam计算和/或使用优化数据更新slam计算的更多细节,其内容通过引用整体并入在此。

[0225]

可能不需要低延迟通信的其它计算密集型任务也可以卸载到远程服务器,该远程服务器可以将结果传输回单独的混合现实系统。例如,可以将机器学习算法卸载到远程服务器(例如,远程操作服务器5702、远程战术服务器5704、远程战略服务器5706和/或数据湖5708)。在一些实施例中,机器学习算法可以基于从混合现实系统收集的数据将对象识别为目标。例如,混合现实系统上的一个或多个相机可以捕获近似士兵视野的视频。混合现实系统可以连接到武器,该武器可以具有可以确定武器瞄准的方向的一个或多个传感器。例如,来自武器的激光瞄准器可以由混合现实系统的一个或多个相机检测到,以确定武器瞄准方向。在一些实施例中,诸如武器上的加速度计的传感器可用于确定武器瞄准方向。在一些实施例中,关于士兵视野的数据和关于武器瞄准方向的数据可以馈入机器学习算法中(例如,可以通过深度卷积神经网络馈入具有武器瞄准区域的图像)以确定什么可能成为目标。

[0226]

在一些实施例中,可以在远程服务器处执行机器学习计算(例如,卷积、前向传播、反向传播等)以训练神经网络。在一些实施例中,混合现实系统可以利用机器学习来视觉上识别(例如,经由彩色轮廓)可能是目标的对象。混合现实系统可以将图像馈送给远程服务器,该远程服务器可以通过训练的神经网络运行图像以确定区域是否可能成为目标。在一些实施例中,训练的神经网络(例如,已经在远程服务器处训练的神经网络)可以本地存储在混合现实系统上,以用于可能目标的低延迟识别。在一些实施例中,本地存储的训练的神经网络可以通过远程服务器周期性地更新,该远程服务器可以用附加训练数据连续训练神经网络。

[0227]

远程计算和/或完成计算的本地存储的类似方法可以用于其它机器学习/计算复杂的应用,包括自动语音识别。例如,混合现实系统可以记录用户说话的音频并将音频传输到远程服务器以进行语音处理(例如,语音识别和/或自然语言处理)。在一些实施例中,作为处理用户说话的音频的结果,混合现实系统可以从远程服务器接收指令以执行一个或多个功能。在一些实施例中,在混合现实系统上本地执行语音处理可能是期望的。例如,士兵可能希望对混合现实系统执行语音指令(例如,关闭夜视功能),并且期望尽快执行指令。在一些实施例中,语音识别系统可以在远程服务器处训练并本地存储在混合现实系统上。

[0228]

在一些实施例中,一些混合现实功能可以在混合现实系统上本地执行。例如,混合现实系统可以采用眼睛跟踪技术(例如,经由指向用户眼睛的一个或多个相机)来识别用户正在看什么方向。在一些实施例中,眼睛跟踪计算可以在混合现实系统上本地执行。可能期望的是,以低延迟方式计算眼睛跟踪,因为视觉效果可能会作为眼睛跟踪的结果显示给用

户,而高延迟(例如,大约50ms或更长)可能会给用户造成过多的延迟。在一些实施例中,可以在混合现实设备处本地完成空间化音频渲染。例如,应该呈现为源自用户背后的虚拟声音可以在混合现实设备上本地渲染和/或空间化。可能期望的是,以低延迟方式渲染和/或空间化虚拟音频使得虚拟音频看起来与真实或虚拟视觉事件“同步”(例如,与真实或虚拟视觉事件大致同时呈现)。在一些实施例中,图形渲染可以在混合现实系统上本地执行。可能期望的是,向用户快速呈现和显示虚拟对象,并且卸载计算(例如,到远程服务器)可能产生不可接受的延迟。

[0229]

混合现实边缘计算架构还可依赖于相对物理位置以进行高效计算。例如,附近混合现实系统之间的通信可能比混合现实系统和远程服务器之间的通信更低延迟。在一些实施例中,可以卸载到远程服务器的计算可以跨连接的混合现实系统分布(例如,如果远程服务器不可达到)。例如,混合现实系统可能彼此传送slam数据,这可增加可用的观察池,这可导致更准确的slam计算。在一些实施例中,可以在单个混合现实系统处执行slam优化,该单个混合现实系统可以包括比其它标准混合现实系统更强大的处理器。在一些实施例中,slam优化可以横跨连接的混合现实系统分布,并且计算能力可以汇集在一起。

[0230]

在一些实施例中,远程服务器(例如,远程操作服务器5702)可以物理地位于连接的混合现实系统附近,这可以减少通信延迟。例如,部署有士兵的混合现实系统可以与位于行动基地的远程服务器通信,该远程服务器可能在物理上靠近混合现实系统(例如,距离不到50英里)。在一些实施例中,与位于混合现实系统附近的远程服务器通信可以产生比与位于更远(例如,2000英里之外和/或在不同大陆上)的远程服务器通信更低的延迟。

[0231]

在一些实施例中,部署在大规模混合现实应用中的混合现实系统可能具有个性化的许可/网络连接。例如,虽然每个士兵的混合现实系统可以将数据(例如,slam、机器学习和/或生命体征数据)传输到远程操作服务器5702,但只有班长的混合现实系统可以具有每个班成员的生命体征数据的读取权。可以经由任何合适的方式来实现受限访问结构。例如,每个混合现实系统都可以具有唯一的标识符,并且远程服务器可以只将敏感数据传输到适当的混合现实系统。在一些实施例中,班长的混合现实系统可以存储加密/解密密钥,该加密/解密密钥可以用于加密/解密混合现实系统和远程服务器之间的通信。

[0232]

在一些实施例中,可以将一组1000名士兵分配给一个营,并且每个士兵都可以配备单独的混合现实系统。在一些实施例中,从整个营收集的数据可以聚集到远程服务器(例如,远程战术服务器5704,其可以与远程操作服务器5702或单独的服务器相同)。在一些实施例中,关于营聚集的数据(例如,班状态、整体部队移动、伤亡等)可以由部署的混合现实系统的有限子集(例如,由指挥官使用的混合现实系统)访问。在一些实施例中,可以通过通用计算系统(例如,通过指挥官使用的膝上型计算机)访问关于营聚集的数据。

[0233]

在一些实施例中,由一个或多个远程服务器(例如,远程操作服务器5702、远程战术服务器5704和/或远程战略服务器5706)聚合的数据可以进一步聚合到单独的远程服务器(例如,数据湖5708)中。在一些实施例中,除了从部署的混合现实系统收集的数据之外,数据湖5708可以进一步访问更多的外部资源(例如,互联网)和内部资源(例如,军事数据库)。在一些实施例中,数据湖5708可以物理地位于被认为远离敌方战斗人员的区域(例如,近海)和/或可以是分散的(例如,数据湖5708可以包括位于不同位置的一个或多个服务器群)。利用数据湖5708来执行可能不需要低延迟通信的计算复杂的任务可能是有益的(例

如,以计算可以在混合现实系统和远程操作服务器5702之间划分的类似方式)。例如,远程操作服务器5702可以运行相对简单的机器学习算法(例如,视觉对象是否可能是目标)和复杂的机器学习算法(例如,什么类型的部队移动更有可能赢得战斗)和/或神经网络训练可以使用在数据湖5708处聚合的数据来执行。

[0234]

虽然关于军事应用描述了本公开的一些实施例,但是技术人员将理解,所公开实施例的其它应用(包括与军事技术或紧急服务不直接相关的应用)是合适的并且在本公开的范围内。

[0235]

图84示出根据一些实施例的示例性混合现实计算架构。在一些实施例中,混合现实计算架构8400可以包括一个或多个模块,该一个或多个模块可以是混合现实计算架构8400的组件。在一些实施例中,模块可以包括被配置为执行指令和/或存储一个或多个数据结构的一个或多个计算机系统(例如,mr系统112、200或远程服务器)。例如,由模块执行的指令可以是在混合现实计算架构8400内运行的进程和/或子进程。在一些实施例中,由模块执行的指令可以是在混合现实计算架构8400内运行的线程。在一些实施例中,由模块执行的指令可以在与混合现实计算架构8400的其它组件相同的进程地址空间和/或存储器空间内运行。在一些实施例中,由模块执行的指令可以在与混合现实计算架构8400的其它组件不同的进程地址空间和/或存储器空间中运行。在一些实施例中,由模块执行的指令可以在与混合现实计算架构8400的其它组件不同的硬件上运行。例如,由混合现实计算架构8400的一个或多个模块执行的指令可以在混合现实系统112和/或200上运行,而混合现实计算架构8400的其它组件可以在远程服务器上运行。在一些实施例中,由混合现实计算架构8400的一个或多个模块执行的指令可以在混合现实计算架构8400内实例化。在一些实施例中,由混合现实计算架构8400内的模块执行的指令和/或存储在这些模块中的数据结构可以与混合现实计算架构8400的其它组件通信(例如,与由其它模块执行的指令和/或存储在其它模块中的数据结构通信)。

[0236]

在一些实施例中,混合现实计算架构8400可以包括一个或多个模块并且该一个或多个模块可以包括一个或多个子模块。在一些实施例中,子模块可以包括被配置为执行指令和/或存储一个或多个数据结构的一个或多个计算机系统。例如,由子模块执行的指令可以是在混合现实计算架构8400内运行的进程和/或子进程。在一些实施例中,由子模块执行的指令可以是在混合现实计算架构8400内运行的线程。在一些实施例中,由子模块执行的指令可以在与混合现实计算架构8400的其它组件相同的进程地址空间和/或存储器空间内运行。在一些实施例中,由子模块执行的指令可以在与混合现实计算架构8400的其它组件不同的进程地址空间和/或存储器空间中运行。在一些实施例中,由子模块执行的指令可以在与混合现实计算架构8400的其它组件不同的硬件上运行。例如,由混合现实计算架构8400的一个或多个子模块执行的指令可以在音频专用处理器(例如,dsp)上运行,而混合现实计算架构8400的其它组件可以在通用处理器上运行。在一些实施例中,由混合现实计算架构8400的一个或多个子模块执行的指令可以在混合现实计算架构8400内实例化。在一些实施例中,由混合现实计算架构8400内的子模块执行的指令和/或存储在这些子模块中的数据结构可以与混合现实计算架构8400的其它组件通信(例如,与由其它模块执行的指令和/或存储在其它模块中的数据结构通信)。

[0237]

在一些实施例中,由可穿戴软件模块8402执行的指令可以在混合现实系统(例如,

mr系统112、200)上运行。在一些实施例中,由可穿戴软件模块8402执行的指令可以在混合现实系统的组件(例如,混合现实系统的头戴式设备)上运行。由可穿戴软件模块8402执行的指令可以包括低延迟有益的功能。例如,由可穿戴软件模块8402执行的指令可以包括跟踪子模块8406。在一些实施例中,跟踪子模块8406可以跟踪用于产生混合现实体验的真实和/或虚拟对象。例如,跟踪子模块8406可以跟踪头部姿势,该头部姿势可以包括用户头部的位置和/或取向。头部姿势可用于确定应向用户呈现什么虚拟对象(例如,因为仅应呈现位于用户视野内真实位置中的虚拟对象)。在一些实施例中,仅完全远程地(例如,在远程服务器处)估计头部姿势可能会在当用户转身时与当混合现实系统已确定视野已移动时之间产生延迟。对于用户来说,在他们应该已经看到新的虚拟对象100ms后转身并出现该新的虚拟对象可能会令人不安。在一些实施例中,头部姿势可以在混合现实耳机本地初步确定并使用远程计算进行优化。例如,头部姿势数据(例如,由安装在头戴式设备上的相机捕获的图像和/或惯性测量单元数据)可以被发送到云模块8410。在一些实施例中,由云模块8410执行的指令可以在远程服务器(例如,远程操作服务器5702)上运行。例如,云模块8410可以包括数据管理模块8410。在一些实施例中,数据管理模块8410可以管理复杂的计算(例如,神经网络的训练和/或slam优化)。在一些实施例中,云模块8410可以包括集成子模块8414。集成子模块8414可以管理服务器和/或数据库(例如,内联网内和/或互联网内的其它计算系统)之间的连接。

[0238]

其它功能,例如由快速目标采集子模块8408执行的功能,也可以在混合现实系统上运行。在一些实施例中,混合现实系统以低延迟快速显示目标采集视觉效果(例如,用红色勾勒目标)可能是有益的,特别是在用户快速改变视野的情况下。快速变化的视野可导致目标快速移入和移出视线,并且可能非常期望的是,混合现实系统识别和/或向用户视觉地显示目标指示。在一些实施例中,可以通过远程执行的计算来优化由快速目标采集子模块8408执行的指令。例如,可以在远程服务器处训练深度卷积神经网络,并且可以将训练的模型部署到快速目标采集子模块8408并在其上运行。

[0239]

在一些实施例中,在混合现实系统上运行由os子模块8404执行的指令可能是有益的。在一些实施例中,os子模块8404可以执行与基本操作系统功能(例如,驱动、服务等)相关的指令。在一些实施例中,os子模块8404可以允许混合现实系统112、200用作计算系统,并可以允许混合现实系统运行应用。在一些实施例中,

[0240]

图94示出根据一些实施例的示例性网络和/或计算架构。在一些实施例中,数据可以由士兵9402佩戴的一个或多个混合现实系统9404传输。在一些实施例中,混合现实系统9404与远程服务器通信可能是不可行的(例如,因为没有蜂窝网络连接可用)。在一些实施例中,大规模混合现实应用可以利用分散网络(例如,自组织和/或对等网络)来促进大规模系统的组件之间的通信。例如,单独的混合现实系统可以向附近的车辆9406传输数据(例如,无线地使用蓝牙、wifi、5g和/或其它射频通信)。在一些实施例中,车辆9406可以包括可能比混合现实系统9404中的通信阵列更强大的通信阵列。在一些实施例中,车辆9406可以将数据中继和/或传输到可能在通信范围内正经过的飞行器9408和/或飞行器9414。在一些实施例中,飞行器9408和/或飞行器9414可以向卫星9410中继和/或传输数据。

[0241]

在一些实施例中,卫星9410可以向远程服务器和/或航天器9412中继和/或传输数据。在一些实施例中,数据可以被传输和/或中继到通信阵列9416,该通信阵列9416可以足

够便携以安装在士兵(例如,通信官)身上。预期组件的任何组合可以与其它组件双向通信(例如,2路通信)。

[0242]

在一些实施例中,自组织和/或网格网络可以有效地传输来自混合现实系统的数据,其中网络基础设施可以充分满足大规模混合现实应用的需要。在一些实施例中,自组织和/或网格通信可以适用于延迟不可知的传输,例如,slam优化、神经网络训练、地图绘制/导航、非实时通信(例如,消息)等。在一些实施例中,自组织和/或网格通信可产生延迟,该延迟阻碍对延迟敏感的传输,例如图形和/或音频渲染、初步slam计算、语音命令处理、眼睛跟踪等。

[0243]

图95示出根据一些实施例的示例性网络和/或计算架构。在一些实施例中,通信阵列9502(其可以耦合到一个或多个混合现实系统)可以与一个或多个无人机9504通信。在一些实施例中,一个或多个无人机9504可以形成网络(例如,网格网络和/或自组织网络),这可以促进一个或多个混合现实系统和/或一个或多个远程计算系统(例如,远程服务器)之间的通信。例如,通信阵列9502可能无法直接与通信阵列9506通信,但可以能够经由一个或多个无人机9504(例如,经由跨多个无人机和/或经由网格网络中继数据)与通信阵列9506通信。

[0244]

图96示出根据一些实施例的示例性网络和/或计算架构。在一些实施例中,通信阵列9602可以安装在可能正在移动的士兵身上。一个或多个无人机9604可以形成网络(例如,网格网络和/或自组织网络),这可以促进一个或多个混合现实系统和/或一个或多个远程计算系统(例如,远程服务器)之间的通信。在一些实施例中,由一个或多个无人机9604形成的网络可以借助于与通信阵列9602一起移动的一个或多个无人机9604而移动。在一些实施例中,一个或多个无人机9604可以根据预期的部队移动以预定图案飞行。在一些实施例中,一个或多个无人机9604可以被配置为跟随具有安装的通信阵列9602的士兵。在一些实施例中,一个或多个无人机9604可以被配置为保持其它无人机之间的静态和/或动态间距(例如,间距可以根据部队密度、战斗危险、网络覆盖范围等而变化)。

[0245]

图97

‑

102示出根据一些实施例的示例性网络和/或计算架构。在一些实施例中,可穿戴组件9702可以对应于图6中描绘的可穿戴组件2。在一些实施例中,腰包9704可以对应于图7中描绘的腰包6。在一些实施例中,可穿戴组件9702和/或腰包9704可以对应于mr系统112、200。在一些实施例中,可穿戴组件9702和/或腰包9704可以连接(例如,通过有线和/或无线连接)到通信单元9706。在一些实施例中,通信单元9706可以包括移动设备(例如,智能电话)。在一些实施例中,移动设备可以被配置为提供附加处理和/或通信能力。例如,移动设备可以包括其自己的处理器,该处理器可以被配置为执行计算。在一些实施例中,移动设备可以被配置为充当混合现实系统和其它计算系统(例如,附件、传感器、其它混合现实系统和/或远程服务器)之间的接口。在一些实施例中,移动设备可以包括被配置为与一个或多个蜂窝塔通信的射频天线和/或网络调制解调器。移动设备可以充当中继器以将信息从混合现实系统传输到其它计算设备(例如,远程服务器)。

[0246]

在一些实施例中,通信单元9706可以包括互连包。在一些实施例中,互连包可以包括大功率天线(例如,射频天线)和/或收发机。在一些实施例中,互连包能够进行高带宽传输。例如,互连包可被配置为与可穿戴组件9702和/或腰包9704通信。在一些实施例中,互连包可被配置为接收由可穿戴组件9702和/或腰包9704捕获的所有数据的全部或部分(例如,

视频馈送、深度信息、slam数据、音频馈送、生命体征信息等)。在一些实施例中,互连包可以比其它电子设备受到更少的约束。例如,智能电话可能会受到功率和/或传输限制,因为智能电话可被配置为在用户头部附近使用。在一些实施例中,互连包可以被配置为远离用户和/或用户的敏感部分使用。在一些实施例中,互连包可以耦合(例如,通过有线和/或无线方式)到移动设备。在一些实施例中,一个或多个混合现实系统可以耦合到互连包,并且互连包可以被配置为与其它计算系统通信。

[0247]

在一些实施例中,通信单元9706可以与其它计算系统通信。例如,通信单元9706可以与中间收发机9708通信。在一些实施例中,中间收发机9708可以是蜂窝塔。在一些实施例中,中间收发机9708可以是安装在士兵身上的通信阵列。在一些实施例中,中间收发机9708可以向一个或多个云服务器9712传输信息。在一些实施例中,中间收发机9708可以直接向一个或多个云服务器传输信息。在一些实施例中,中间收发机9708可以经由一个或多个边缘节点9710传输信息。边缘节点9710可以是分散的和/或物理地位于中间收发机9708附近的网络设备。例如,混合现实系统可以是边缘节点,移动设备可以是边缘节点,无线接入点可以是边缘节点,安装在士兵身上的通信阵列可以是边缘节点等。物理接近可以减少通信延迟,这对于各种混合现实功能(包括slam计算、对象识别、语音识别等)很重要。

[0248]

图98描绘了混合现实网络通信的示例性实施例。在一些实施例中,通信单元9706可以直接与一个或多个边缘节点9710通信。图99描绘了混合现实网络通信的示例性实施例。在一些实施例中,通信9706可以直接与一个或多个云服务器9712通信。图100描绘了混合现实网络通信的示例性实施例。在一些实施例中,可穿戴组件9702和/或腰包9704可以经由中间收发机9708与通信单元9706通信。图101描绘了混合现实网络通信的示例性实施例。在一些实施例中,可穿戴组件9702和/或腰包9704可以与通信单元9706无线通信(例如,经由蓝牙、wifi、5g和/或其它射频通信)。图102描绘了混合现实网络通信的示例性实施例。在一些实施例中,通信单元9706可以与一个或多个连接设备9714通信。在一些实施例中,连接设备9714可以是具有非常好的本地连接的连接资源。例如,企业可能在每个房间中都具有连接设备9714。在一些实施例中,连接设备9714可以具有存储能力,由本地it管理等。例如,在一个实施例中,每个连接设备可能不仅具有很好的连接性以从建筑物管道式引出,而且还存储特定房间的一个或多个高分辨率网格(例如,前一天期间由该区域的混合现实系统捕获/刷新的一个或多个网格)。

[0249]

图103描绘了示例性可穿戴组件,该可穿戴组件可对应于图6中描绘的示例性可穿戴组件。在一些实施例中,可穿戴组件可包括电磁传感器1、光场相机2、蓝牙天线3、wimax天线4、wifi天线5、4g/lte天线6、主动制冷风扇7、可变焦元件8、热电偶9、惯性测量单元10、可见光rgb/单色相机11、近红外相机12、长波红外相机13、短波红外相机14、红外眼睛跟踪相机15、神经形态差分传感器16、热敏电阻17、5g天线18、偏转传感器19、半球相机20、飞行时间深度传感器21、lidar传感器22、结构光深度传感器23、全局动态调光器24、本地动态调光器25、折射自由形式光学器件26、衍射透镜光学器件27、mems扫描仪单光源28、mems扫描仪双光源29、数字全息显示器30、光电二极管31、ccd传感器32、cmos传感器33、电子轰击有源像素传感器34、混合动态视觉可见光传感器35、内部干涉仪36、有源噪声消除设备37和/或麦克风阵列38。

[0250]

图104描绘了示例性腰包组件,其可以对应于图7中描绘的示例性腰包组件。在一

些实施例中,腰包组件可以包括近场指纹读取器1、多用途外部连接器2、hdmi端口3、显示端口4、短波红外相机5、5g天线6、wifi天线7、内置qi充电器8、usb

‑

c连接器9、usb

‑

a(版本2和/或3)连接器10、光场相机11、4g天线12、超宽带天线13、可见rgb和/或单色相机14、蓝牙相机15、wimax天线16、内置电池17、内部存储器18、内部计算19、长波红外相机20、lcd触摸屏21、内部热电偶22、内部gpu 23、内部电磁传感器24和/或近红外相机25。

[0251]

在此描述了本发明的各种示例实施例。以非限制性的方式参考这些示例。提供它们是为了说明本发明更广泛适用的方面。在不脱离本发明的真实精神和范围的情况下,可以对所描述的本发明进行各种改变并且可以替换等同物。例如,虽然关于军事或紧急服务应用描述了一些实施例,但本领域技术人员将理解其它合适的应用在本公开的范围内。此外,可以进行许多修改以使特定情况、材料、物质组成、过程、过程行为或步骤适应本发明的目的、精神或范围。此外,本领域技术人员将理解,在此描述和图示的各个变体中的每一个都具有分立的组件和特征,该分立的组件和特征可以容易地与其它几个实施例中的任一个实施例的特征分离或组合而不脱离本发明的范围或精神。所有此类修改都旨在落入与本公开相关联的权利要求的范围内。

[0252]

本发明包括可以使用本设备执行的方法。该方法可以包括提供此类合适的设备的动作。此类提供可以由终端用户执行。换句话说,“提供”动作仅需要终端用户获得、访问、接近、定位、设置、激活、通电或以其它方式动作以提供本方法中的必要设备。可以以逻辑上可能的所列举事件的任何顺序以及以所列举的事件顺序来执行在此所述的方法。

[0253]

已经在上面阐述了本发明的示例方面以及关于材料选择和制造的细节。至于本发明的其它细节,这些可以结合上面引用的专利和出版物以及本领域技术人员公知或领会的来领会。关于本发明的基于方法的方面,就通常或逻辑上采用的附加动作而言,这同样适用。

[0254]

此外,虽然本发明已经参考可选地结合各种特征的几个示例进行了描述,但是本发明不限于关于本发明的每个变体所预期的描述或指示的内容。在不脱离本发明的真正精神和范围的情况下,可以对所描述的发明进行各种改变并且可以替换等效物(无论是在此引用还是为了某种简洁而未包括在内)。此外,在提供值范围的情况下,应当理解,在该范围的上限和下限与该规定范围内的任何其它规定或中间值之间的每个中间值都包含在本发明内。

[0255]

此外,预期所描述的本发明变体的任何可选特征可以独立地提出和要求保护,或者与在此描述的任何一个或多个特征组合。对单数项的引用包括具有存在多个相同项的可能性。更具体地,如在此和与其相关的权利要求中使用的,单数形式“一(a)”、“一(an)”、“所述”和“该”包括复数所指对象,除非另有具体说明。换句话说,物品的使用允许上述描述以及与本公开相关联的权利要求中的本项目的“至少一个”。进一步应注意,可以起草此类权利要求以排除任何可选元素。因此,该陈述旨在作为与权利要求要素的叙述相关联的诸如“仅”、“只”等专有术语的使用或“否定”限制的使用的先行基础。

[0256]

在不使用此类专有术语的情况下,与本公开相关联的权利要求中的术语“包括”应允许包含任何附加元素—无论此类权利要求中是否列举了给定数量的元素,或者特征的添加可被视为转变了此类权利要求中阐述的元素的性质。除非在此明确定义,否则在此使用的所有技术和科学术语都应被给予与普遍理解的含义一样尽可能宽的含义,同时保持权利

要求的有效性。

[0257]

本发明的范围不限于所提供的示例和/或本说明书,而是仅限于与本公开相关联的权利要求语言的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。