1.本发明涉及文本处理技术领域,尤其是一种基于依赖门控融合机制的多模态文本摘要系统。

背景技术:

2.文本摘要任务旨在将文本或文本集合转换为包含关键信息的简短摘要,该简短摘要保证能够反映原文档的重要内容情况下,尽可能地保持简明扼要。早期的文本摘要研究主要以单模态文本数据为处理对象,摘要方法大体上可以分为两类:抽取式和生成式。前者生成摘要的主要不足是语言质量相对较差,比如,语句中包含较多的语法错误;后者生成的摘要具备简明、内聚、信息丰富等优点,不足之处在于主要使用浅层自然语言处理技术。近年来随着深度学习的进步,学术界提出了一系列基于seq2seq的生成式摘要模型,对编码器、解码器以及训练方法等开展了卓有成效的研究工作。基于该模型生成的摘要在语言流畅性、连贯性等方面让学界看到自动摘要实用化的希望。

3.伴随着互联网多媒体大数据的发展,网络中存在着大量的多模态数据,多模态信息过载问题日益严重,对多模态信息进行概况总结显得非常必要,多模态摘要便是其中一个重要的手段。多模态摘要是文本摘要领域的一个下游方向,一些科研工作者近年来重点研究多模态摘要,在现有的文本摘要模型基础上,加入图像和音视频等多模态信息,以期对多模态数据生成摘要,满足当前社会发展的需要。

4.多模态摘要研究重点在于其研究重点围绕各模态的语义信息展开,通过分析各模态数据间的关联关系和互补关系,为摘要模型提供能够融合多模态数据的上下文信息。现有的多模态摘要模型围绕编码器

‑

解码器结构进行了大量的研究,针对多模态数据特点,采用多种深度神经网络模型对文本和图像进行编码,提取文本和图像等数据的特征表示,而后通过层次化注意力将不同模态的数据映射到统一的维度空间进行融合,较好的解决了模态特征表示间的差异性问题。现有方法围绕多模态注意力机制进行大量研究,通过注意力机制能够较好的通过关联图文相关内容进行分析,但未考虑注意力结果分布是否正确,存在不相关或误导性的注意力结果。且未考虑图文是否相关,融合策略存在文本与图像融合不协调或模态偏差问题。如何过滤不相关的注意力结果和挖掘更好的多模态融合策略,是多模态摘要任务存在的主要挑战。

技术实现要素:

5.本发明提出一种基于依赖门控融合机制的多模态文本摘要系统,能够提取图文模态数据的特征表示及图文数据中的深层语义信息,通过依赖门控融合机制融合多模态数据,最终生成包含两种模态信息的关键摘要。

6.本发明采用以下技术方案。

7.一种基于依赖门控融合机制的多模态文本摘要系统,所述摘要系统的编码器模块包括文本编码器和图像编码器,分别用于获取输入文本的隐藏表示和提取图像的全局特

征;所述摘要系统工作时,以注意力模块提取文本上下文单词之间的注意力关系和视觉上下文的注意力关系,并根据注意力权重加权计算得到文本和视觉上下文向量,通过依赖门控融合模块融合文本上下文向量和视觉上下文向量,最后以摘要解码器生成文本摘要。

8.所述文本编码器采用双向长短期记忆网络生成文本编码信息,用于获取输入文本的整体历史上下文的隐含层表示作为文本特征向量。

9.所述图像编码器采用vgg19深度神经网络,用于提取输入图像数据的全局特征向量,并投影到与文本编码信息相同的向量空间。

10.所述文本编码器首先利用单层双向lstm作为编码器,根据词汇表矩阵将文档按词编码成对应的词嵌入向量t={t1,t2,...,t

n

},其中,为单词i的词嵌入表示,再将词向量输入到编码器中,将双向lstm输出的前向隐含层表示和反向隐含层表示拼接作为最终的文本隐含层表示对于图像数据,则采用vgg19网络模型进行特征提取,得到图像的全局特征集g。

11.所述注意力模块利用自注意力从文本历史上下文中提取不同细粒度的编码信息,利用视觉注意力的注意力过滤掉视觉上下文中不相关的关注信息,只保留有用的注意力结果。

12.所述注意力模块在文本注意力层引入文本注意力机制计算文本上下文向量,具体方法为:

13.首先计算注意力分布,公式如下:

[0014][0015]

α

t

=softmax(e

t

)

ꢀꢀꢀ

公式二;

[0016]

v

t

、w

h

、w

s

为模型学习参数,h

i

文本的隐藏状态,s

t

是解码器当前时间步的当前状态;后续的解码器通过α

t

值明确当前时间的解码输出应该重点关注的单词,之后计算得到文本上下文向量:

[0017][0018]

在视觉注意力引入图像注意力机制计算视觉上下文向量;方法为:

[0019]

首先将特征集g转化为矩阵g*,之后进行视觉注意力计算,计算过程如下:

[0020][0021][0022][0023]

视觉上下文向量计算为:

[0024][0025]

为了滤掉不相关的关注信息且只保留有用的注意力结果,在视觉注意力的基础上

追加注意力模块,即aoa模块,对视觉注意力的结果进行过滤;

[0026]

aoa模块通过两个单独的线性变换生成一个信息向量i和一个注意力门g

att

,

[0027]

两者均以注意力结果和当前的上下文为条件,表述为:

[0028][0029][0030]

其中d是q和c的维数,c是上层视觉注意力的结果,即视觉上下文向量;

[0031]

条件中的当前的上下文即查询所得上下文;

[0032]

然后,aoa模块通过使用逐元素乘法将注意力门应用于信息向量来增加另一个注意力,并获得关注信息,即更新过后的视觉上下文向量,表述为

[0033][0034]

所述依赖门控融合模块利用依赖门控机制融合文本和图像模态的编码信息,生成兼具文本和图像信息的多模态上下文表示。

[0035]

所述依赖门控融合模块融合文本和图像的信息时,采用的方法为:

[0036]

定义文本上下文向量为c

txt

,更新后的视觉上下文向量为c

img

;先引入多模态注意力计算一个文档全局表示向量d,该向量同时包含文本和图像信息;计算公式如下:

[0037][0038][0039]

α

txt

=softmax(e

txt

)

ꢀꢀꢀ

公式十三;

[0040]

α

img

=softmax(e

img

)

ꢀꢀꢀ

公式十四;

[0041]

d=α

txt

c

txt

α

img

c

img

ꢀꢀꢀ

公式十六;

[0042]

其中v,w,u为参数矩阵,α

txt

、α

img

分别为文本和图像的注意力权重;

[0043]

同时为了衡量模态间的重要性,在计算权重时考虑两种模态信息的主次关系和互补关系,引入依赖融合门控,融合文档全局表示和文本上下文信息通过以下公式进行融合:

[0044][0045]

c

mm

=g

⊙

c

txt

(1

‑

g)

⊙

d

ꢀꢀꢀ

公式十八;

[0046]

门控值g来控制模型侧重依赖于文档全局表示在解码过程发挥指导作用,还是依赖于文本上下文,突出文本上下文信息的主要指导地位,而文档中对应的图像特征造成少量影响作用。最终融合形成多模态上下文向量c

mm

。

[0047]

所述摘要解码器模块采用单向的长短期记忆网络作为解码器,结合指针概率,利用融合文本和图像两种模态信息的多模态上下文表示,结合覆盖向量解码生成包含核心信息的文本摘要。

[0048]

所述摘要解码器在解码过程中,采用单层单向lstm作为解码器,将解码器当前状态s

t

和融合向量输入到两层的线性层后,再通过softmax函数来产生整个词汇表的分布p

v

;摘要解码器在每个时间步解码时会计算一个生成概率p

gen

,用来指导解码生成的单词从词

汇表中生成;而(1

‑

p

gen

)表示是从源输入中复制一个单词的概率;

[0049]

所述解码器定义词汇表和所有不在词汇表中的源输入单词的并集为扩展词汇表,以统一最终单词的概率分布,由此可计算最终的单词概率分布为:

[0050][0051]

解码过程中,每个时间步最终的解码结果是由解码器选择扩展词汇表分布中概率最高的单词输出;摘要解码器的整体编解码器框架和基于注意力机制的序列到序列模型(seq2seq att)保持一致。

[0052]

本发明所述方法针对新闻媒体领域的多模态数据,包含图像、文本内容,能够针对不同模态数据提取相应数据的隐藏表示,同时采用基于注意力到注意力机制提取各模态数据的上下文语义信息;最后根据依赖门控融合策略融合各模态的上下文信息,对不同模态数据间的潜在共享特征进行学习,生成概括多种模态关键信息的多模态上下文信息,使解码器生成包含核心信息的摘要。这种基于依赖门控融合的多模态摘要方法,相较于传统方法,能够过滤不相关或误导性的注意力结果,保留有用的数据上下文信息;能够融合图文关联语义信息,充分有效的利用不同模态的信息,实现不同模态的信息是相互补充和验证,缓解融合过程中模态偏差问题。

附图说明

[0053]

下面结合附图和具体实施方式对本发明进一步详细的说明:

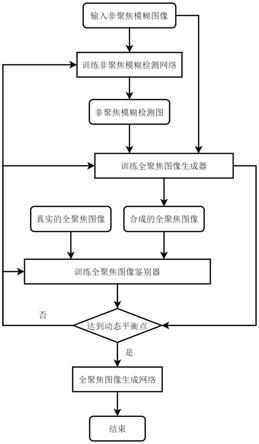

[0054]

附图1是本发明的原理示意图。

具体实施方式

[0055]

如图所示,一种基于依赖门控融合机制的多模态文本摘要系统,所述摘要系统的编码器模块包括文本编码器和图像编码器,分别用于获取输入文本的隐藏表示和提取图像的全局特征;所述摘要系统工作时,以注意力模块提取文本上下文单词之间的注意力关系和视觉上下文的注意力关系,并根据注意力权重加权计算得到文本和视觉上下文向量,通过依赖门控融合模块融合文本上下文向量和视觉上下文向量,最后以摘要解码器生成文本摘要。

[0056]

所述文本编码器采用双向长短期记忆网络生成文本编码信息,用于获取输入文本的整体历史上下文的隐含层表示作为文本特征向量。

[0057]

所述图像编码器采用vgg19深度神经网络,用于提取输入图像数据的全局特征向量,并投影到与文本编码信息相同的向量空间。

[0058]

所述文本编码器首先利用单层双向lstm作为编码器,根据词汇表矩阵将文档按词编码成对应的词嵌入向量t={t1,t2,...,t

n

},其中,为单词i的词嵌入表示,再将词向量输入到编码器中,将双向lstm输出的前向隐含层表示和反向隐含层表示拼接作为最终的文本隐含层表示对于图像数据,则采用vgg19网络模型进行特征提取,得到图像的全局特征集g。

[0059]

所述注意力模块利用自注意力从文本历史上下文中提取不同细粒度的编码信息,利用视觉注意力的注意力过滤掉视觉上下文中不相关的关注信息,只保留有用的注意力结果。

[0060]

所述注意力模块在文本注意力层引入文本注意力机制计算文本上下文向量,具体方法为:

[0061]

首先计算注意力分布,公式如下:

[0062][0063]

α

t

=softmax(e

t

)

ꢀꢀꢀ

公式二;

[0064]

v

t

、w

h

、w

s

为模型学习参数,h

i

文本的隐藏状态,s

t

是解码器当前时间步的当前状态;后续的解码器通过α

t

值明确当前时间的解码输出应该重点关注的单词,之后计算得到文本上下文向量:

[0065][0066]

在视觉注意力引入图像注意力机制计算视觉上下文向量;方法为:

[0067]

首先将特征集g转化为矩阵g*,之后进行视觉注意力计算,计算过程如下:

[0068][0069][0070][0071]

视觉上下文向量计算为:

[0072][0073]

为了滤掉不相关的关注信息且只保留有用的注意力结果,在视觉注意力的基础上追加注意力模块,即aoa模块,对视觉注意力的结果进行过滤;

[0074]

aoa模块通过两个单独的线性变换生成一个信息向量i和一个注意力门g

att

,

[0075]

两者均以注意力结果和当前的上下文为条件,表述为:

[0076][0077][0078]

其中d是q和c的维数,c是上层视觉注意力的结果,即视觉上下文向量;

[0079]

条件中的当前的上下文即查询所得上下文;

[0080]

然后,aoa模块通过使用逐元素乘法将注意力门应用于信息向量来增加另一个注意力,并获得关注信息,即更新过后的视觉上下文向量,表述为

[0081]

[0082]

所述依赖门控融合模块利用依赖门控机制融合文本和图像模态的编码信息,生成兼具文本和图像信息的多模态上下文表示。

[0083]

所述依赖门控融合模块融合文本和图像的信息时,采用的方法为:定义文本上下文向量为c

txt

,更新后的视觉上下文向量为c

img

;先引入多模态注意力计算一个文档全局表示向量d,该向量同时包含文本和图像信息;计算公式如下:

[0084][0085][0086]

α

txt

=softmax(e

txt

)

ꢀꢀꢀ

公式十三;

[0087]

α

img

=softmax(e

img

)

ꢀꢀꢀ

公式十四;

[0088]

d=α

txt

c

txt

α

img

c

img

ꢀꢀꢀ

公式十六;

[0089]

其中v,w,u为参数矩阵,α

txt

、α

img

分别为文本和图像的注意力权重;

[0090]

同时为了衡量模态间的重要性,在计算权重时考虑两种模态信息的主次关系和互补关系,引入依赖融合门控,融合文档全局表示和文本上下文信息通过以下公式进行融合:

[0091][0092]

c

mm

=g

⊙

c

txt

(1

‑

g)

⊙

d

ꢀꢀꢀ

公式十八;

[0093]

门控值g来控制模型侧重依赖于文档全局表示在解码过程发挥指导作用,还是依赖于文本上下文,突出文本上下文信息的主要指导地位,而文档中对应的图像特征造成少量影响作用。最终融合形成多模态上下文向量c

mm

。

[0094]

所述摘要解码器模块采用单向的长短期记忆网络作为解码器,结合指针概率,利用融合文本和图像两种模态信息的多模态上下文表示,结合覆盖向量解码生成包含核心信息的文本摘要。

[0095]

所述摘要解码器在解码过程中,采用单层单向lstm作为解码器,将解码器当前状态s

t

和融合向量输入到两层的线性层后,再通过softmax函数来产生整个词汇表的分布p

v

;摘要解码器在每个时间步解码时会计算一个生成概率p

gen

,用来指导解码生成的单词从词汇表中生成;而(1

‑

p

gen

)表示是从源输入中复制一个单词的概率;

[0096]

所述解码器定义词汇表和所有不在词汇表中的源输入单词的并集为扩展词汇表,以统一最终单词的概率分布,由此可计算最终的单词概率分布为:

[0097][0098]

解码过程中,每个时间步最终的解码结果是由解码器选择扩展词汇表分布中概率最高的单词输出;摘要解码器的整体编解码器框架和基于注意力机制的序列到序列模型(seq2seq att)保持一致。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。