1.本公开涉及测距成像系统、测距成像方法和程序,并且更具体地,涉及用于获取目标空间的亮度信息和距离信息的测距成像系统、测距成像方法和程序。

背景技术:

2.专利文献1公开了一种图像相关方法。

3.在该图像相关方法中,通过激光扫描仪获取测量对象的3d点组数据,并且通过捕获测量对象来获取2d彩色图像。然后,在2d彩色图像上任意选择三个或更多点,并且基于3d点组数据为所选点中的每个点提供3d位置信息。然后基于与所选点有关的3d位置信息来计算在捕获测量对象时相机与激光扫描仪之间的相对位置关系。基于计算出的相对位置关系和与所选点有关的3d位置信息,将彩色图像的图像数据与包含在点组数据中的每个点的数据相关联。

4.引文列表

5.专利文献

6.专利文献1:jp2005

‑

77385a

技术实现要素:

7.在单独设置相机和激光扫描仪的情况下,很难在相机捕获的图像(亮度信息)与激光扫描仪获取的数据(距离信息)之间建立关联,这是因为这些设备在数据的捕获/获取时间、观测点、数据格式等方面是不同的。

8.本公开旨在提出能够获取将亮度信息和距离信息彼此相关联的数据的测距成像系统、测距成像方法和程序。

9.本公开的一个方面的一种测距成像系统包括第一获取单元、第二获取单元、第三获取单元和计算单元。第一获取单元被配置为从获取目标空间的第一二维(2d)图像的成像单元获取第一2d数据。第二获取单元被配置为从获取所述目标空间的第一三维(3d)图像的测距单元获取第一3d数据。第三获取单元被配置为从利用同轴光学系统获取所述目标空间的第二2d图像和第二3d图像的检测单元获取第二2d数据和第二3d数据。计算单元被配置为执行在所述第一2d数据与所述第二2d数据之间建立关联的处理以及在所述第一3d数据与所述第二3d数据之间建立关联的处理。

10.本公开的一个方面的一种测距成像方法包括第一获取步骤、第二获取步骤、第三获取步骤和处理步骤。第一获取步骤包括从获取目标空间的第一2d图像的成像单元获取第一2d数据。第二获取步骤包括从获取所述目标空间的第一3d图像的测距单元获取第一3d数据。第三获取步骤包括从利用同轴光学系统获取所述目标空间的第二2d图像和第二3d图像的检测单元获取第二2d数据和第二3d数据。处理步骤包括执行在所述第一2d数据与所述第二2d数据之间建立关联的处理以及在所述第一3d数据与所述第二3d数据之间建立关联的处理。

11.本公开的一个方面的一种测距成像系统包括第一获取单元、第二获取单元和计算单元。第一获取单元被配置为获取第一2d数据。第二获取单元被配置为利用同轴光学系统获取第二2d数据和第一3d数据。计算单元被配置为执行在所述第一2d数据与所述第二2d数据之间建立关联的处理以及在所述第一2d数据和所述第一3d数据之间建立关联的处理。

12.本公开的一个方面的一种测距成像方法包括第一获取步骤、第二获取步骤和处理步骤。第一获取步骤包括获取第一2d数据。第二获取步骤包括利用同轴光学系统获取第二2d数据和第一3d数据。处理步骤包括执行在所述第一2d数据与所述第二2d数据之间建立关联的处理以及在所述第一2d数据和所述第一3d数据之间建立关联的处理。

13.本公开的一个方面的一种程序是被配置为使一个或多个处理器执行测距成像方法的程序。

附图说明

14.图1是示出了实施例的测距成像系统的框图;

15.图2是示出了实施例的测距成像系统的成像单元的框图;

16.图3是示出了实施例的测距成像系统的测距单元的框图;

17.图4是示出了实施例的测距成像系统的检测单元的框图;

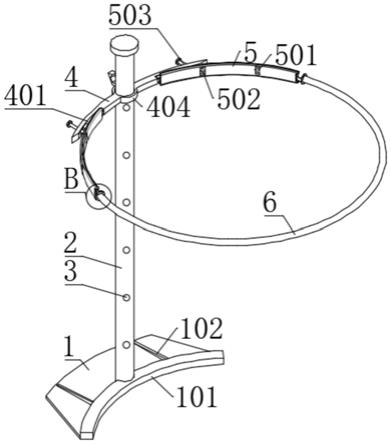

18.图5是示出了实施例的测距单元的操作的示意图;

19.图6是示出了实施例的测距成像系统的信号处理单元的框图;

20.图7a是示出了实施例的成像单元所获取的第一亮度图像的示例的示意图;

21.图7b是图7a中a1部分的放大视图;

22.图8a是示出了实施例的测距单元所获取的第一距离图像的示例的示意图;

23.图8b是图8a中a2部分的放大图;

24.图9a是示出了实施例的检测单元所获取的第二亮度图像的示例的示意图;

25.图9b是图9a中a3部分的放大图;

26.图10a是示出了实施例的检测单元所获取的第二距离图像的示例的示意图;

27.图10b是图10a中a4部分的放大图;

28.图11是示出了第一变体的测距成像系统的框图;以及

29.图12是示出了第一变体的测距成像系统的生成融合数据的过程的示意图。

具体实施方式

30.将参考附图来说明本公开的实施例的测距成像系统1。然而,下面所描述的实施例仅仅是本公开的各个实施例的示例。只要能够实现本公开的目的,就可以根据设计等以各种方式修改下面所描述的实施例。

31.(1)实施例

32.(1.1)概述

33.如图1所示,本实施例的测距成像系统1包括第一获取单元21、第二获取单元22、第三获取单元23和计算单元3。

34.第一获取单元21包括通信接口。第一单元21连接到计算单元3。第一获取单元21被配置为连接到成像单元4。第一获取单元21被配置为从成像单元4获取第一2d数据。例如,第

一2d数据包括与目标空间s1的第一2d图像有关的信息。第一2d图像由成像单元4获取。例如,第一获取单元21从成像单元4获取与目标空间s1的第一2d图像相关的第一2d数据。

35.第二获取单元22包括通信接口。第二获取单元22连接到计算单元3。第二获取单元22被配置为连接到测距单元5。第二获取单元22被配置为从测距单元5获取第一3d数据。例如,第一3d数据包括与目标空间s1的第一3d图像有关的信息。第一3d图像由测距单元5获取。第一3d图像是对到存在于目标空间s1中的对象o1的距离加以指示的图像。例如,第二获取单元22从测距单元5获取与目标空间s1的第一3d图像相关的第一3d数据。

36.第三获取单元23包括通信接口。第三获取单元23连接到计算单元3。第三获取单元23被配置为连接到检测单元6。第三获取单元23被配置为从检测单元6获取第二2d数据和第二3d数据。例如,第二2d数据包括与目标空间s1的第二2d图像有关的信息。第二2d图像由检测单元6获取。例如,第二3d数据包括与目标空间s1的第二3d图像有关的信息。第二3d图像由检测单元6获取。例如,第二3d图像是对到存在于目标空间s1中的对象o1的距离加以指示的图像。检测单元6被配置为利用同轴光学系统获取第二2d图像和第二3d图像。例如,第三获取单元23从检测单元6获取与目标空间s1的第二2d图像相关的第二2d数据和与目标空间s1的第二3d图像相关的第二3d数据。

37.计算单元3被配置为执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一3d数据和第二3d数据之间建立关联的处理。

38.根据本实施例的测距成像系统1,计算单元3在第一2d数据与第二2d数据之间建立关联并并在第一3d数据和第二3d数据之间建立关联。结果是,通过检测单元6所获取的第二2d数据和第二3d数据将第一2d数据和第一3d数据彼此相关联。因此能够获取将2d数据(第一2d图像)和3d数据(第一3d图像)彼此相关联的数据。

39.(2)配置

40.参考图1至图10b更详细地说明本实施例的测距成像系统1。在实施例中,假设测距成像系统1安装在诸如汽车等车辆上,作为检测障碍物的对象检测系统。然而,测距成像系统1不限于用于此。例如,测距成像系统1可以用于监视相机或安全相机以检测对象(人)。

41.如图1所示,本实施例的测距成像系统1包括信号处理单元10、成像单元4、测距单元5和检测单元6。信号处理单元10包括第一获取单元21至第三获取单元23和计算单元3。在实施例中,成像单元4、测距单元5和检测单元6具有互不相同的光接收单元和光学系统,并且具有互不相同的光轴。然而,成像单元4、测距单元5和检测单元6被设置为使得它们的光轴几乎彼此对准,并且从相同的目标空间s1接收光。

42.成像单元4被配置为获取目标空间s1的第一2d图像。在实施例中,成像单元4捕获目标空间s1的图像以获取第一亮度图像100(参见图7a)作为第一2d图像。例如,成像单元4包括诸如电荷耦合器件(ccd)图像传感器或互补金属氧化物半导体(cmos)图像传感器之类的固态成像器件。成像单元4接收外部光。外部光可以包括从发光对象(太阳、灯具等)辐射的辐射光、辐射光被对象o1散射的散射光等。

43.如图2所示,成像单元4包括光接收单元(在下文中,也被称为“第一光接收单元”)41、控制器(在下文中,也被称为“第一控制器42”)和光学系统(在下文中,也被称为“第一光学系统”)43。

44.第一光接收单元41包括以2d阵列布置的多个像素单元。多个像素单元中的每个像

素单元包括诸如光电二极管的光接收器件。光接收器件包括将光子转换为电荷的光电转换器。多个像素单元中的每个像素单元仅在曝光时接收光。像素单元的曝光时间由第一控制器42控制。多个像素单元中的每个像素单元输出对光接收器件所接收的光加以指示的电信号。电信号的信号电平对应于光接收器件接收到的光量。

45.例如,第一光学系统43包括将外部光聚焦在第一光接收单元41上的透镜。第一光学系统43可以包括用于选择要入射到像素单元上的光的波长的滤色器。

46.第一控制器42可以由包括一个或多个存储器和一个或多个处理器的计算机系统实现。第一控制器42的功能通过计算机系统的一个或多个处理器执行存储在一个或多个存储器中的程序来实现。程序可以预先存储在存储器中,或者可以通过互联网等电信网络提供,或者可以通过诸如存储卡的非暂时性存储介质提供。

47.第一控制器42被配置为控制第一光接收单元41。第一控制器42基于从第一光接收单元41的像素单元提供的电信号来生成第一亮度图像100(是2d图像)。第一控制器42生成第一2d数据,并且将所生成的第一2d数据输出到信号处理单元10。第一2d数据包括指示所生成的第一亮度图像100的第一亮度信息。第一控制器42将第一亮度信息作为第一2d数据输出到信号处理单元10(第一获取单元21)。

48.测距单元5被配置为获取目标空间s1的第一3d图像。在实施例中,第一3d图像是第一距离图像200。在实施例中,测距单元5基于飞行时间(tof)方法来测量到对象o1的距离以获取第一距离图像200(参见图8a)。如图3所示,测距单元5包括光接收单元(在下文中,也被称为“第二光接收单元”)51、控制器(下文中也被称为“第二控制器”)52、光学系统(在下文中,也被称为“第二光学系统”)53,以及发光单元(在下文中,也被称为“第一发光单元”)54。

49.下文中所描述的示例中的测距单元5使用tof方法,但是不限于此。例如,测距单元5可以使用发射激光的脉冲光并检测来自对象的反射光的lidar方法来基于反射时间确定距离。

50.第一发光单元54包括发射脉冲光的第一光源。从第一发光单元54发射的光可以是单色的,具有相对短的脉冲宽度和相对较高的峰值强度。从第一发光单元54发射的光的波长可以在近红外波段的波长范围内,在该波长范围内,人类视觉敏感度低且不易受来自阳光的干扰光影响。在本实施例中,第一发光单元54例如包括激光二极管并发射脉冲激光。第一发光单元54的发射定时、脉冲宽度、发射方向等由第二控制器52控制。

51.第二光接收单元51包括固态成像器件。第二光接收单元51接收反射光,该反射光是从第一发光单元54发射并被对象o1反射的光。第二光接收单元51包括以2d阵列布置的多个像素单元。多个像素单元中的每个像素单元包括诸如光电二极管的光接收器件。光接收器件可以是雪崩光电二极管。多个像素单元中的每个像素单元仅在曝光的同时接收光。像素单元的曝光时间由第二控制器52控制。多个像素单元中的每个像素单元输出对光接收器件所接收的光加以指示的电信号。电信号的信号电平对应于光接收器件接收到的光量。

52.例如,第二光学系统53包括将反射光聚焦在第二光接收单元51上的透镜。

53.第二控制器52可以由包括一个或多个存储器和一个或多个处理器的计算机系统实现。第二控制器52的功能通过计算机系统的一个或多个处理器执行存储在一个或多个存储器中的程序来实现。程序可以预先存储在存储器中,或者可以通过诸如互联网等电信网络提供,或者可以通过诸如存储卡的非暂时性存储介质提供。

54.第二控制器52被配置为控制第一发光单元54和第二光接收单元51。第二控制器52控制第一发光单元54的发光定时、脉冲宽度、发射方向等。第二控制器52控制第二光接收单元51的曝光定时、曝光时间等。

55.第二控制器52生成对到存在于目标空间s1中的对象o1的距离加以指示的第一距离图像200作为目标空间s1的第一3d图像。例如,第二控制器52通过以下方法获取第一距离图像200。

56.第二控制器52确定第一发光单元54的脉冲光的发射方向。确定发射方向导致确定第二光接收单元51的多个像素单元中的能够接收被对象o1反射的脉冲光的反射光的像素单元。利用一次测距,第二控制器52从该像素单元获取电信号。

57.如图5所示,第二控制器52划分与一次测距相对应的时间段(下文中,被称为“帧f1”),使得在其中包括“n”个测量时段(“n”是大于或等于2的整数)。即,第二控制器52划分一个帧f1,使得其包括“n”个测量时段,被称为第一测量时段tm1至第n测量时段tmn。例如,将测量时段的长度设置为彼此相同。

58.如图5所示,第二控制器52进一步将每个测量时段划分为“n”个分时段。在实施例中,第二控制器52将每个测量时段划分为“n”个分时段,被称为第一分时段ts1至第n分时段tsn。

59.在每个测量时段中,第二控制器52控制第一发光单元54在分时段中的第一分时段期间(即,在第一分时段tsl期间)发射脉冲光。

60.在每个测量时段中,第二控制器52控制第二光接收单元51在第一分时段tsl至第n分时段tsn中的任一分时段期间使(所有)像素单元曝光。对于第一测量时段tm1至第n测量时段tmn,第二控制器52使像素单元曝光的定时从第一分时段ts1顺序地移位到第n分时段tsn。

61.具体地,第二控制器52控制像素单元的曝光定时,使得:在第一测量时段tml中,像素单元在第一分时段tsl期间曝光;在第二测量时段tm2中,像素单元在第二分时段ts2期间曝光;......;并且在第n测量时段tmn中,像素单元在第n分时段tsn期间曝光(参见图5)。结果是,在一个帧f1中看到,在任何测量时段中的第一分时段ts1至第n分时段tsn中的每个分时段期间执行像素单元的曝光。

62.只有在执行曝光的同时,第二光接收单元51的像素单元才能检测到从对象o1反射的反射光。从第一光发射单元54发射光到反射光到达第二光接收单元51的持续时间取决于从测距单元5到对象o1的距离而变化。在从第一发光单元54发光的时间点经过了时间“t=2d/c”之后,反射光到达第二光接收单元51,其中“d”表示从距测单元5到对象o1的距离,“c”表示光速。因此,第二控制器52可以基于以下项来计算到存在于发射方向上的对象o1的距离:第二光接收单元51的像素单元接收反射光的分时段的信息,换言之,第二光接收单元51的像素单元接收反射光的测量时段的信息。

63.在图5的示例中,例如,在每个测量时段中,来自对象o1的反射光在桥接第二分时段ts2和第三分时段ts3的时段期间到达。在这种情况下,在第一分时段ts1期间像素单元曝光的第一测量时段tm1中,第二光接收单元51不检测反射光。结果是,从像素单元输出的电信号的信号电平应低于预定阈值电平。另一方面,在第二分时段ts2期间像素单元曝光的第二测量时段tm2中以及在第三分时段ts3期间像素单元曝光的第三测量时段tm3中,像素单

元在反射光到达第二光接收单元51时的定时处曝光。因此,第二光接收单元51在这些测量时段中检测反射光。结果是,从像素单元输出的电信号的信号电平高于或等于阈值电平。指示第二控制器52可以确定对象o1存在于与第二分时段ts2相对应的距离范围和与第三分时段ts3相对应的距离范围内。换言之,第二控制器52可以确定对象o1存在于以下距离之间的距离范围内:与第一发光单元54发射光后第二分时段ts2开始的时间相对应的距离(c*ts/2);以及与第一发光单元54发射光后第三分时段ts3结束的时间相对应的距离(3*c*ts/2),其中“ts”表示每个分时段的长度。

64.由上面的说明可知,测距单元5的可测量距离(测距单元5能够测量的距离的上限)由“n*ts*c/2”表示。而且,测距单元5的距离分辨率由“ts*c/2”表示。

65.第二控制器52改变第一发光单元54的发射方向(水平面和/或垂直方向),并且从与如此改变的发射方向相对应的像素单元获取电信号。因此,在与每个像素单元相对应的发射方向上,可以测量存在于目标空间s1中的对象o1的距离。

66.第二控制器52基于从第二光接收单元51的各个像素单元输出的电信号,生成第一距离图像200,第一距离图像200是像素的像素值对应于到存在于目标空间s1中的对象o1的距离的图像。

67.在不同视角下说明,测距单元5基于距测距单元5的距离,将可测距离划分为多(“n”)个距离范围。多个距离范围包括:与第一分时段ts1相对应的第一距离范围(0至ts*c/2);与第二分时段ts2相对应的第二距离范围(ts*c/2至2*ts*c/2);......;以及与第n分时段tsn相对应的第n距离范围((n

‑

1)*ts*c/2至n*ts*c/2)。此外,测距单元5针对每个距离范围生成具有与多个像素单元相对应的单位像素的2d图像。针对每个距离范围生成的2d图像例如为二值图像,其中如果像素单元在与所讨论的距离范围相对应的测量时段接收到来自对象o1的反射光(即,该像素单元的信号电平大于或等于阈值电平),则该像素单元在二值图像中的像素值为“1”,并且如果像素单元没有接收到反射光,则该像素单元在二值图像中的像素值为“0”。然后,第二控制器52基于距离范围,对与多个距离范围相对应的多个2d图像进行着色,例如,施加不同的颜色,并且对基于信号电平超过阈值的程度而加权的这些着色图像进行求和,从而生成第一距离图像200。

68.第二控制器52生成第一3d数据,并且将所生成的第一3d数据输出到信号处理单元10。在实施例中,第一3d数据包括对如此生成的第一距离图像200加以指示的第一距离信息。第二控制器52将第一距离信息作为第一3d数据输出到信号处理单元10(第二获取单元22)。

69.检测单元6被配置为获取目标空间s1的第二2d图像。在实施例中,检测单元6获取目标空间s1的第二亮度图像300(参见图9a)作为第二2d图像。检测单元6还被配置为获取目标空间s1的第二3d图像。在实施例中,第二3d图像为第二距离图像400。检测单元6基于飞行时间(tof)方法测量到对象o1的距离以获取第二距离图像400(参见图10a)。如图4所示,检测单元6包括光接收单元(在下文中,也被称为“第三光接收单元”)61、控制器(在下文中,也被称为“第三控制器”)62、光学系统(在下文中,也被称为“第三光学系统”)63,以及发光单元(在下文中,也被称为“第二发光单元64”)。

70.与第一发光单元54一样,第二发光单元64包括发射脉冲光的光源(第二光源)。从第二发光单元64发出的光可以是单色的,具有相对短的脉冲宽度和相对较高的峰值强度。

从第二发光单元64发射的光的波长可以在近红外波段的波长范围内,在该波长范围内,人类视觉敏感度低且不易受到来自太阳光的干扰光的影响。在本实施例中,第二发光单元64例如包括激光二极管并发射脉冲激光。第二发光单元64的发射定时、脉冲宽度、发射方向等由第三控制器62控制。

71.与第二光接收单元51一样,第三光接收单元61包括固态成像器件。第三光接收单元61接收反射光,该反射光是从第二发光单元64发射并被对象o1反射的光。第三光接收单元61包括以2d阵列布置的多个像素单元。例如,第三光接收单元61包括的像素单元的数量小于第一光接收单元41包括的像素单元的数量,也小于第二光接收单元51包括的像素单元的数量。多个像素单元中的每个像素单元包括诸如光电二极管的光接收器件。光接收器件可以是雪崩光电二极管。多个像素单元中的每个像素单元仅在曝光时接收光。像素单元的曝光时间由第三控制器62控制。多个像素单元中的每个像素单元输出对光接收器件所接收的光加以指示的电信号。电信号的信号电平对应于光接收器件接收到的光量。

72.例如,第三光学系统63包括将外部光和反射光聚焦在第三光接收单元61上的透镜。

73.第三控制器62可以由包括一个或多个存储器和一个或多个处理器的计算机系统实现。第三控制器62的功能通过计算机系统的一个或多个处理器执行一个或多个存储器中存储的程序来实现。程序可以预先存储在存储器中,或者可以通过诸如互联网等电信网络提供,或者可以通过诸如存储卡等非暂时性存储介质提供。

74.第三控制器62被配置为控制第二发光单元64和第三光接收单元61。第三控制器62控制第二发光单元64的发光定时、脉冲宽度、发光方向等。第三控制器62控制第三光接收单元61的曝光定时、曝光时间等。

75.第三控制器62确定从第二发光单元64发射的脉冲光的发射方向,并且指定第三光接收单元61的多个像素单元中的能够接收脉冲光的反射光的像素单元。利用一次测距,第三控制器62从该像素单元获取电信号。

76.第三控制器62将与一次测距相对应的时间段进行划分,使得在其中包括“x”个测量时段(“x”是大于或等于2的整数),并且进一步将每个测量时段划分为“x”个分时段。在每个测量时段中,第三控制器62控制第二发光单元64在分时段中的第一分时段期间发射脉冲光。第三控制器62还控制第三光接收单元61使像素单元在针对多个测量时段的互不相同的分时段期间曝光。在实施例中,检测单元6执行距离测量的分时段的长度tt长于测距单元5的分时段的长度ts。第三控制器62针对每个测量时段获取来自与第三光接收单元61的发射方向相对应的像素单元的电信号。

77.第三控制器62改变第二发光单元64的发射方向,并且改变第三光接收单元61的多个像素单元中要从其获取电信号的像素单元,并且对多个像素单元中的每个像素单元执行上面的测量。因此,第三控制器62生成分别与多个测量时段相对应的多个2d图像。如针对测距单元5所解释的,多个测量时段分别对应于基于距检测单元6的距离划分目标空间s1的多个距离范围。每个2d图像的像素单元的像素值对应于在对应的测量时段期间所讨论的像素单元所接收的光量。

78.第三控制器62针对每个像素单元,对所讨论的像素单元在多个2d图像(对应于多个距离范围)中的像素值进行求和,从而生成第二亮度图像300。换言之,检测单元6通过将

多个2d图像组合在一起而不识别多个2d图像的距离范围来生成第二亮度图像300(第二2d图像)。

79.此外,第三控制器62基于每个像素单元的像素值与预定阈值之间的比较,从多个2d图像生成多个二值图像。多个二值图像与多个2d图像(即,多个距离范围)一一对应。二值图像是以下图像:如果对应的2d图像的像素单元的像素值大于或等于阈值则像素值为“1”,如果其像素值小于阈值则像素值为“0”。此外,针对每个二值图像,第三控制器62将根据所讨论的二值图像的距离范围(即,测量时段)确定的像素值分配给像素值为“1”的像素。例如,第三控制器62确定多个二值图像的像素值,使得远离检测单元6的二值图像具有较大的像素值。即,第三控制器62根据它们的距离范围对多个二值图像着色。第三控制器62针对每个像素单元,对基于像素值超过阈值水平的程度而加权的多个二值图像的像素值进行求和,从而生成第二距离图像400。简而言之,检测单元6通过在识别多个2d图像的距离范围的同时将多个2d图像组合在一起来生成第二距离图像400(第二3d图像)。

80.如上所述,检测单元6基于由同一像素单元所接收的光量来生成第二亮度图像300和第二距离图像400两者。此外,第二亮度图像300和第二距离图像400是从同一组2d图像生成的。这意味着,目标空间s1中与第二亮度图像300的像素相对应的位置和目标空间s1中与第二距离图像400的像素相对应的位置彼此是一一对应的。此外,第二亮度图像300(第二2d图像)的多个像素和第二距离图像400(第二3d图像)的多个像素彼此是一一对应的。

81.第三控制器62生成第二2d数据并将所生成的第二2d数据输出到信号处理单元10。在实施例中,第二2d数据包括对所生成的第二亮度图像300加以指示的第二亮度信息。第三控制器62将第二亮度信息作为第二2d数据输出到信号处理单元10(第三获取单元23)。第三控制器62生成第二3d数据并将所生成的第二3d数据输出到信号处理单元10。在实施例中,第二3d数据包括对所生成的第二距离图像400加以指示的第二距离信息。第三控制器62将第二距离信息作为第二3d数据输出到信号处理单元10(第三获取单元23)。

82.如图6所示,信号处理单元10包括第一获取单元21至第三获取单元23和计算单元3。

83.第一获取单元21从成像单元4获取第一2d数据。在实施例中,第一获取单元21从成像单元4获取指示第一亮度图像100的第一亮度信息作为第一2d数据。第一亮度信息包括如下信息:例如,将指示亮度大小的数值分配给第一亮度图像100的每个像素的位置(坐标)作为像素值。

84.第二获取单元22从测距单元5获取第一3d数据。在实施例中,第二获取单元22从测距单元5获取指示第一距离图像200的第一距离信息作为第一3d数据。第一距离信息包括以下信息:例如将指示距离量的数值分配给第一距离图像100的每个像素的位置(坐标)作为像素值。

85.第三获取单元23从检测单元6获取第二2d数据。在实施例中,第三获取单元23从检测单元6获取指示第二亮度图像300的第二亮度信息作为第二2d数据。第二亮度信息包括以下信息:例如,将指示亮度大小的数值分配给第二亮度图像300的每个像素的位置(坐标)作为像素值。第三获取单元23从检测单元6获取第二3d数据。在实施例中,第三获取单元23从检测单元6获取指示第二距离图像400的第二距离信息作为第二3d数据。第二距离信息包括以下信息:例如,将指示距离量的数值分配给第二距离图像400的每个像素的位置(坐标)作

为像素值。

86.如图6所示,计算单元3包括:亮度图像转换单元31,用作2d图像转换单元;距离图像转换单元32,用作3d图像转换单元;以及融合数据生成单元33。计算单元3可以由包括一个或多个存储器和一个或多个处理器的计算机系统实现。计算单元3的单元(亮度图像转换单元31、距离图像转换单元32和融合数据生成单元33)的功能是通过计算机系统的一个或多个处理器执行存储在一个或多个存储器中的程序来实现的。程序可以预先存储在存储器中,或者可以通过诸如互联网等电信网络提供,或者可以通过诸如存储卡等非暂时性存储介质提供。

87.亮度图像转换单元31执行将第一亮度图像100的每个像素的像素值分配给第二亮度图像300的关联像素区域的转换以生成计算出的亮度图像。即,2d图像转换单元执行将第一2d图像的每个像素的像素值分配给第二2d图像的关联像素区域的转换以生成计算出的2d图像。

88.距离图像转换单元32执行将第一距离图像200的每个像素的像素值分配给第二距离图像400的关联像素区域的转换以生成计算出的距离图像。即,3d图像转换单元执行将第一3d图像的每个像素的像素值分配给第二3d图像的关联像素区域的转换以生成计算出的3d图像。

89.融合数据生成单元33基于计算出的亮度图像和计算出的距离图像,生成将第一亮度信息和第一距离信息彼此相关联的融合数据。即,融合数据生成单元33基于计算出的2d图像和计算出的3d图像,生成将第一2d数据和第一3d数据彼此相关联的融合数据。

90.将参考图7a至图10b说明计算单元3的操作。

91.在实施例中,测距成像系统1(包括成像单元4、测距单元5、检测单元6和信号处理单元10)被安装在汽车上,并且作为对象o1的人存在于汽车前方的目标空间s1中。

92.例如,成像单元4捕获目标空间s1的图像以获取如图7a和图7b所示的第一亮度图像100。如图7a和图7b所示,成像单元4生成包括对象o1的第一亮度图像100,其分辨率取决于例如第一光接收单元41的像素数量(像素单元的数量)而确定。注意,第一亮度图像100不具有与到对象o1的距离有关的信息。

93.测距单元5利用第二光接收单元51的多个像素单元接收从第一发光单元54发射且被目标空间s1反射的光的反射光,并且对接收到的光执行处理,以生成如图8a和图8b所示的第一距离图像200。第一距离图像200可以以取决于例如测距单元5的分时段的长度ts而确定的分辨率识别到对象o1的距离。例如,当分时段的长度ts为20[ns]时,分辨率可以是3[m]。图8a示出了从测距单元5到第一距离图像200中存在的对象的距离,使得远离测距单元5的对象着色更深。

[0094]

检测单元6利用第三光接收单元61接收第二发光单元64发射、并且被目标空间s1反射的光的反射光,并且对接收到的光执行处理,以生成如图9a和图9b所示的第二亮度图像300以及如图10a和图10b所示的第二距离图像400。如上所述,第二亮度图像300的像素和第二距离图像400的像素彼此一一对应。检测单元6的第三光接收单元61的像素数量小于成像单元4的第一光接收单元41的像素数量,因此第二亮度图像300的分辨率小于第一亮度图像100的分辨率。即成像单元4和检测单元6具有互不相同的空间分辨率(在实施例中,成像单元4具有相对较大的空间分辨率)。用于检测单元6的距离测量的分时段的长度tt比用于

测距单元5的距离测量的分时段的长度ts长,因此第二距离图像400的分辨率(距离分辨率)小于第一距离图像200的分辨率。即,测距单元5和检测单元6具有互不相同的距离分辨率(在实施例中,测距单元5具有相对高的距离分辨率)。例如,检测单元6的分时段的长度tt可以是100[ns],距离的分辨率可以是15[m]。

[0095]

亮度图像转换单元31从第一亮度图像100和第二亮度图像300中的每个亮度图像中提取诸如对象o1的轮廓之类的特征量,并且执行亮度图像的特征量之间的匹配,以例如在第一亮度图像100的多个像素与第二亮度图像300的多个像素之间建立关联。例如,亮度图像转换单元31基于提取到的特征量,确定图7b的像素范围a11对应于图9b的像素范围a31,并将第一亮度图像100的像素范围a1l的像素与第二亮度图像300的像素范围a31的像素相关联。此外,亮度图像转换单元31基于提取到的特征量,确定图7b的像素范围a12对应于图9b的像素范围a32,并且将第一亮度图像100的像素范围a12的像素与第二亮度图像300的像素范围a32的像素彼此相关联。这样,第一亮度图像100和多个第二亮度图像300的多个像素彼此相关联。在第一亮度图像100的像素数量和第二亮度图像300的像素数量彼此相同且成像单元4和检测单元6捕获同一目标空间s1的图像的示例情况下,第一亮度图像100的多个像素和第二亮度图像300的多个像素可以彼此一一相关联。在第一亮度图像100的像素数量在侧向方向和横向方向上都是第二亮度图像300的像素数量的两倍且成像单元4和检测单元6捕获同一目标空间s1的图像的另一示例情况下,第二亮度图像300的一个像素可以与第一亮度图像100的四个(2

×

2)像素相关联。

[0096]

在关联完成后,亮度图像转换单元31执行将第一亮度图像100的每个像素的像素值分配给第二亮度图像300的关联像素区域的转换以生成计算出的亮度图像。因此,在第二亮度图像300的像素的每个坐标与第一亮度图像100的像素的像素值相关联的情况下能够生成计算出的亮度图像。即,在第二2d图像的像素的每个坐标与第一2d图像的像素的像素值相关联的情况下能够生成计算出的2d图像。

[0097]

根据如此生成的计算出的亮度图像(计算出的2d图像),将第一亮度图像100(第一2d图像)的像素的像素值分配给第二亮度图像300(第二2d图像)的任何像素区域。

[0098]

距离图像转换单元32将包含在第一距离图像200中的对象o1的距离信息与包含在第二距离图像400中的对象o1的距离信息进行比较,并且例如在包含在第一距离图像200中的对象o1与包含在第二距离图像400中的对象o1之间建立关联。在实施例中,距离图像转换单元32确定当在第二距离图像400中存在同一距离范围内信号电平大于阈值电平且彼此连续的多个像素时,单个对象o1存在于与这些连续像素相对应的区域中(见图10b所示的对象o1)。此外,距离图像转换单元32确定当第一距离图像200中包含的对象o1的距离包含在第二距离图像400中包含的对象o1的距离中或反之亦然时,这些对象o1可以是彼此相同的对象。在示例情况下,假设在第一距离图像200中的区域a2内存在对在294[m]至297[m]的距离范围内存在对象o1加以指示的多个像素,如图8a所示。在示例情况下,还假设在第二距离图像400中的区域a4内,存在对在270[m]至300[m]的距离范围内存在对象o1加以指示的连续像素,如图10a所示。在这种情况下,距离图像转换单元32确定区域a2内的对象o1和区域a4内的对象o1可以是同一对象o1。距离图像转换单元32对多个对象执行这样的确定,并基于该确定,确定第一距离图像200中包含的多个对象o1与第二距离图像400中包含的多个对象o1之间的位置关系。基于这些对象的位置关系,距离图像转换单元32在第一距离图像200的

多个像素与第二亮度图像300的多个像素之间建立关联,以提高距离的准确度。具体地,图10b的上述对象o1的距离范围从270[m]到300[m]校正到294[m]到297[m]。与上述针对计算出的亮度图像的情况一样,在第一距离图像200的像素数量和第二距离图像400的像素数量彼此相同并且测距单元5和检测单元6接收来自同一目标空间s1的反射光的示例情况下,第一距离图像200的多个像素与第二距离图像400的多个像素可以彼此一一相关联。在第一距离图像200的像素数量在侧向方向和横向方向上都是第二距离图像400的像素数量的两倍并且测距单元5和检测单元6接收来自同一目标空间s1的反射光的另一示例情况下,第二距离图像400的一个像素可以与第一距离图像200的四个(2

×

2)个像素相关联。

[0099]

在关联完成后,距离图像转换单元32执行将第一距离图像200的每个像素的像素值分配给第二距离图像400的关联像素区域的转换以生成计算出的距离图像。因此,在第二距离图像400的像素的每个坐标与第一距离图像200的像素的像素值相关联的情况下能够生成计算出的距离图像。即,在第二3d图像的像素的每个坐标与第一3d图像的像素的像素值相关联的情况下能够生成计算出的距离图像。

[0100]

根据如此生成的计算出的距离图像(计算出的3d图像),将第一距离图像200(第一3d图像)的像素的像素值优先分配给第二距离图像400(第二3d图像)的任何像素区域。

[0101]

融合数据生成单元33基于计算出的亮度图像和计算出的距离图像,生成将关于第一亮度图像100的信息和关于第一距离图像200的信息彼此相关联的融合数据。

[0102]

如上所述,第二亮度图像300和第二距离图像400具有相同的像素数量,并且第二亮度图像300的多个像素和第二距离图像400的多个像素彼此一一对应。融合数据生成单元33在以下之间建立关联:第一亮度图像100的与第二亮度图像300的特定像素区域相关联的像素的像素值;和第一距离图像200的与第二距离图像400的像素区域相关联的像素的像素值,该像素区域已与(第二亮度图像300的)特定像素区域相关联。简而言之,融合数据生成单元33在第一亮度图像100的多个像素和第一距离图像200的多个像素之间建立关联,而第二亮度图像300和第二距离图像400由检测单元6用作桥接。

[0103]

融合数据生成单元33因此生成将第一亮度信息和第一距离信息彼此相关联的融合数据(将第一2d数据和第一3d数据彼此相关联的融合数据)。例如,可以将由此生成的融合数据所指示的信息显示为立体图像。

[0104]

如上所述,根据本实施例的测距成像系统1,第一2d数据和第一3d数据通过检测单元6所获取的第二2d数据和第二3d数据彼此相关联。因此,能够获得将亮度信息(第一亮度信息)和距离信息(第一距离信息)彼此相关联的数据(融合数据),换言之,能够获得将2d数据(第一2d数据)和3d数据(第一3d数据)彼此相关联的数据(融合数据)。

[0105]

此外,即使当第一亮度图像100的像素数量和第一距离图像200的像素数量彼此不相同,也能够利用第二亮度信息和第二距离信息在第一亮度图像100和第二亮度图像300之间建立关联。即,第一2d图像和第二3d图像能够通过第二2d数据和第二3d数据彼此相关联。

[0106]

(3)变体

[0107]

上述实施例仅仅是本公开的各个实施例的示例。只要能够实现本公开的目的,可以根据设计等以各种方式修改以上实施例。

[0108]

(3.1)第一变体

[0109]

参考图11描述本变体的测距成像系统1a和测距方法。

[0110]

如图11所示,本变体的测距成像系统1a包括信号处理单元10a。信号处理单元10a包括第一获取单元21a、第二获取单元23a和计算单元3a。第二获取单元23a相当于上述实施例的第三获取单元23。因此,本变体的测距成像系统1a不包括与上述实施例的测距成像系统1的第二获取单元22和测距单元5相对应的组件。本变体的测距成像系统1a的与上述实施方式的测距成像系统1的组件共同的组件被赋予相同的数字,后跟字母“a”,并且可以适当地省略对其的说明。

[0111]

第一获取单元21a被配置为获取第一2d数据。例如,第一获取单元21a被配置为连接到成像单元4a。例如,第一获取单元21a从成像单元4a获取第一2d数据。例如,第一2d数据包括与目标空间s1的第一2d图像有关的信息。例如,第一2d图像是目标空间s1的第一亮度图像100a。

[0112]

第二获取单元23a被配置为通过同轴光学系统获取第二2d数据和第一3d数据。例如,第二获取单元23a被配置为连接到检测单元6a。例如,第二获取单元23a利用同轴光学系统从检测单元6a获取第二2d数据和第一3d数据。例如,第二2d数据包括与目标空间s1的第二2d图像有关的信息。例如,第二2d图像是目标空间s1的第二亮度图像300a。例如,第一3d数据包括与目标空间s1的第一3d图像有关的信息。第一3d图像是对到存在于目标空间s1中的对象o1的距离加以指示的图像。例如,第一3d图像是目标空间s1的第一距离图像400a。

[0113]

计算单元3a被配置为执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一2d数据和第一3d数据之间建立关联的处理。

[0114]

具体地,计算单元3a包括2d数据转换单元和融合数据生成单元。

[0115]

如图12所示,2d数据转换单元在第一获取单元21a获取的第一2d数据和第二获取单元23a获取的第二2d数据之间建立关联以生成计算出的2d数据。具体地,2d数据转换单元执行将第一2d图像(第一亮度图像100a)的每个像素的像素值分配给第二2d图像(第二亮度图像300a)的相关像素区域的转换以生成计算出的2d图像(计算出的亮度图像)。即,2d数据转换单元通过执行将第一2d数据的每个像素的像素值分配给第二2d数据的关联像素区域的转换以生成计算出的2d数据,来执行用于在第一2d数据与第二2d数据之间建立关联的处理。

[0116]

如图12所示,融合数据生成单元基于计算出的2d图像和第一3d图像(第一距离图像400a)生成将第一2d数据和第一3d数据彼此相关联的融合数据。即,融合数据生成单元基于计算出的2d数据和第一3d数据生成将第一2d数据和第一3d数据彼此相关联的融合数据。

[0117]

与检测单元6一样,检测单元6a基于同一像素单元接收的光量生成第二亮度图像300a和第一距离图像400a两者。此外,第二亮度图像300a和第一距离图像400a是从同一组2d图像生成的。这意味着,第二亮度图像300a(第二2d数据)的多个像素与第一距离图像400a(第一3d数据)的多个像素彼此一一对应。

[0118]

根据本变体的测距成像系统1a,第一2d数据和第一3d数据通过检测单元6a获取的第二2d数据彼此相关联。因此,能够获得将2d数据(第一2d图像)和3d数据(第一3d图像)彼此相关联的数据。

[0119]

根据本变体的测距成像系统1a,通过第二获取单元23a能够利用同轴光学系统一一对应地获取第二2d数据和第一3d数据,这引起省略复杂的机制。此外,与在3d数据和另一3d数据之间建立关联的情况相比,可以容易地在第一获取单元21a的第一2d数据和第二获

取单元23a的第二2d数据之间建立关联。

[0120]

(3.2)其他变体

[0121]

测距成像系统1、1a、计算单元3或3a的功能可以通过测距成像方法、(计算机)程序、记录程序的非暂时性存储介质来实现。

[0122]

根据一个方面的测距成像方法包括第一获取步骤、第二获取步骤、第三获取步骤和处理步骤。第一获取步骤包括从获取目标空间s1的第一2d图像的成像单元4获取第一2d数据。第二获取步骤包括从获取目标空间s1的第一3d图像的测距单元5获取第一3d数据。第三获取步骤包括从利用同轴光学系统获取目标空间s1的第二2d图像和第二3d图像的检测单元6获取第二2d数据和第二3d数据。处理步骤包括执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一3d数据和第二3d数据之间建立关联的处理。

[0123]

根据一个方面的测距成像方法包括第一获取步骤、第二获取步骤和处理步骤。第一获取步骤包括获取第一2d数据。第二获取步骤包括获取第二2d数据和第一3d数据。处理步骤包括执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一2d数据和第一3d数据之间建立关联的处理。

[0124]

根据一个方面的程序是被配置为使一个或多个处理器执行上述测距成像方法的程序。

[0125]

以下将描述其他变体。这些变体主要基于实施例的测距成像系统1进行说明,但也可以适用于变体1的测距成像系统1a。

[0126]

本公开的测距成像系统1包括计算机系统,例如成像单元4的第一控制器42、测距单元5的第二控制器52、检测单元6的第三控制器62、计算单元3等。计算机系统包括作为主组件的处理器和作为硬件的存储器。根据本公开的作为第一控制器42、第二控制器52、第三控制器62、计算单元3等的功能可以作为处理器执行计算机系统的存储器中存储的程序的结果来实现。该程序可以预先存储在计算机系统的存储器中,也可以通过电信网络提供,也可以通过诸如存储卡、光盘或硬盘驱动器等记录程序的非暂时性计算机可读存储介质而分布。计算机系统的处理器包括:一个或多个电子电路,包括半导体集成电路(ic)或大规模集成电路(lsi)。本文所记载的诸如ic或lsi等集成电路根据集成度的不同而称呼,并且可以包括被称为系统lsi、特大规模集成(vlsi)或超大规模集成(ulsi)的集成电路。此外,也可以采用lsi生产后要编程的现场可编程门阵列(fpga),或允许重新配置lsi内部连接关系或重构lsi内部的电路分区的逻辑器件作为处理器。电子电路可以集成在一个芯片上,也可以以分布式的方式设置在芯片上。这些芯片可以集成到一个设备中,也可以以分布式的方式设置在多个设备中。本文所记载的计算机系统包括一个包含一个或多个处理器和一个或多个存储器的微控制器。因此,微控制器可以由包括半导体集成电路或大规模集成电路在内的一个或多个电子电路组成。

[0127]

对于测距成像系统1来说,为测距成像系统1提供的功能被合并到一个壳体中不是必要的。测距成像系统1的组件可以以分布式方式设置在壳体中。此外,测距成像系统1的至少一部分功能(例如计算单元3)可以通过例如服务器系统、云(云计算)服务等来实现。备选地,如上述实施例那样,测距成像系统1的所有功能可以合并到一个壳体中。

[0128]

第一获取单元21至第三获取单元23可以通过相同的通信接口来实现,也可以通过互不相同的通信接口来实现。第三获取单元23可以包括用于获取第二亮度信息的通信接口

和用于获取第二距离信息的另一通信接口。第一获取单元21至第三获取单元23中的任一个不限于通信接口,也可以是将成像单元4、测距单元5或检测单元6互连到计算单元3的电线。

[0129]

第一控制器42不限于生成第一亮度图像100(第一2d图像)。第一控制器42可以输出能够从中生成第一亮度图像100(第一2d图像)的信息作为第一亮度信息(第一2d数据)。第二控制器52不限于生成第一距离图像200(第一3d图像)。第二控制器52可以输出能够从中生成第一距离图像200(第一3d图像)的信息作为第一距离信息(第一3d数据)。第三控制器62不限于生成第二亮度图像300(第二2d图像)。第三控制器62可以输出能够从中生成第二亮度图像300(第二2d图像)的信息作为第二亮度信息(第二2d数据)。第三控制器62不限于生成第二距离图像400(第二3d图像)。第三控制器62可以输出能够从中生成第二距离图像400(第二3d图像)的信息作为第二距离信息(第二3d数据)。检测单元6a的控制器不限于生成第一距离图像400a(第一3d图像)。检测单元6a的控制器可以输出能够从中生成第一距离图像400a(第一3d图像)的信息作为第一距离信息(第一3d数据)。

[0130]

融合数据包括作为其内部数据的第二亮度图像300的各个像素的像素值、第二距离图像400的各个像素的像素值等。在这种情况下,如果第一亮度图像100中的某个像素具有错误的像素值,则该像素的像素值例如可以是第二亮度图像300的像素值。

[0131]

第一亮度图像100的分辨率(像素数量)和第二亮度图像300的分辨率(像素数量)可以彼此相同或可以彼此不同。第一距离图像200的分辨率(距离分辨率)和第二距离图像400的分辨率(距离分辨率)可以彼此相同或可以彼此不同。

[0132]

成像单元4的多个像素单元和检测单元6的多个像素单元可以预先彼此相关联。计算单元3可以基于成像单元4的像素单元和检测单元6的像素单元之间初步确定的关系,将第一亮度图像100和第二亮度图像彼此相关联。测距单元5的多个像素单元和检测单元6的多个像素单元可以预先彼此相关联。计算单元3可以根据测距单元5的像素单元与检测单元6的像素单元之间初步确定的关系,在第一距离图像200和第二距离图像400之间建立关联。

[0133]

(4)总结

[0134]

从上述实施例和变体中可以明显看出,本公开公开了以下方面。

[0135]

第一方面的测距成像系统(1)包括第一获取单元(21)、第二获取单元(22)、第三获取单元(23)和计算单元(3)。第一获取单元(21)被配置为从成像单元(4)获取第一2d数据。成像单元(4)被配置为获取目标空间的第一2d图像(s1)。第二获取单元(22)被配置为从测距单元(5)获取第一3d数据。测距单元(5)被配置为获取目标空间(s1)的第一3d图像。第三获取单元(23)被配置为从检测单元(6)获取第二2d数据和第二3d数据。检测单元(6)被配置为利用同轴光学系统获取目标空间(s1)的第二2d图像和第二3d图像。计算单元(3)被配置为执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一3d数据和第二3d数据之间建立关联的处理。

[0136]

在该方面,第一2d数据和第一3d数据通过检测单元(6)获取的第二2d数据和第二3d数据彼此相关联。因此,能够获得将2d数据(第一2d数据)和3d数据(第一3d数据)彼此相关联的数据。

[0137]

在第二方面的测距成像系统(1)中,根据第一方面,计算单元(3)包括2d图像转换单元(亮度图像转换单元31)、3d图像转换单元(距离图像转换单元32)和融合数据生成单元(33)。2d图像转换单元被配置为执行将第一2d图像的每个像素的像素值分配给第二2d图像

的关联像素区域的转换,以生成计算出的2d图像。3d图像转换单元被配置为执行将第一3d图像的每个像素的像素值分配给第二3d图像的关联像素区域的转换以生成计算出的3d图像。融合数据生成单元(33)被配置为基于计算出的2d图像和计算出的3d图像生成将第一2d数据和第一3d数据彼此相关联的融合数据。

[0138]

在该方面,能够获得将第一2d数据和第一3d数据彼此相关联的数据。

[0139]

在第三方面的测距成像系统(1)中,根据第一方面或第二方面,检测单元(6)被配置为基于距检测单元(6)的距离将目标空间(s1)划分为多个距离范围,并生成分别对应于多个距离范围的多个2d图像。检测单元(6)被配置为在不识别多个2d图像的距离范围的情况下,通过将多个2d图像组合在一起来生成第二2d图像。检测单元(6)被配置为通过在识别多个2d图像的距离范围的同时将多个2d图像组合在一起来生成第二3d图像。第二2d图像的多个像素与第二3d图像的多个像素彼此一一对应。

[0140]

在该方面,从同一组2d图像生成第二2d图像和第二3d图像,使得容易地在第二2d图像和第二3d图像之间建立关联。

[0141]

在第四方面的测距成像系统(1)中,根据第一方面至第三方面中的任一方面,成像单元(4)和检测单元(6)具有互不相同的光轴,并且测距单元(5)和检测单元(6)具有互不相同的光轴。

[0142]

在该方面,能够在2d图像(第一2d图像)和3d图像(第一3d图像)之间建立关联,这是利用其中第一2d图像、第一3d图像、第二2d图像和第二3d图像是利用具有互不相同的光轴的成像单元(4)、测距单元(5)和检测单元(6)来生成的系统。

[0143]

在第五方面的测距成像系统(1)中,根据第一方面至第四方面中的任一方面,成像单元(4)和检测单元(6)具有互不相同的空间分辨率,并且测距单元(5)和检测单元(6)具有互不相同的距离分辨率。

[0144]

在该方面,能够在2d图像(第一2d图像)和3d图像(第一3d图像)之间建立关联,这是利用其中成像单元(4)和检测单元(6)具有互不相同的空间分辨率并且测距单元(5)和检测单元(6)具有互不相同的距离分辨率的系统。

[0145]

第六方面的测距成像系统(1),根据第一方面至第五方面中的任一方面,还包括成像单元(4)、测距单元(5)或检测单元(6)中的至少一个。

[0146]

在该方面,能够获得将2d数据(第一2d数据)和3d数据(第一3d数据)彼此相关联的数据。测距成像系统(1)还可以包括成像单元(4)、测距单元(5)和检测单元(6)中的任意两个,或成像单元(4)、测距单元(5)和检测单元(6)的全部。

[0147]

第七方面的测距成像方法包括第一获取步骤、第二获取步骤、第三获取步骤和处理步骤。第一获取步骤包括从获取目标空间的第一2d图像(s1)的成像单元(4)获取第一2d数据。第二获取步骤包括从获取目标空间的第一3d图像的测距单元(5)获取第一3d数据(s1)。第三获取步骤包括从检测单元(6)获取第二2d数据和第二3d数据。检测单元(6)利用同轴光学系统获取目标空间(s1)的第二2d图像和第二3d图像。处理步骤包括执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一3d数据和第二3d数据之间建立关联的处理。

[0148]

在该方面,能够获得在2d数据(第一2d数据)和3d数据(第一3d数据)之间相关联的数据。

[0149]

第八方面的程序是被配置为使一个或多个处理器执行第七方面的测距成像方法的程序。

[0150]

在该方面,能够获得将2d数据(第一2d数据)和3d数据(第一3d数据)彼此相关联的数据。

[0151]

第九方面的测距成像系统(1a)包括第一获取单元(21a)、第二获取单元(23a)和计算单元(3a)。第一获取单元(21a)被配置为获取第一2d数据。第二获取单元(23a)被配置为利用同轴光学系统获取第二2d数据和第一3d数据。计算单元(3a)被配置为执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一2d数据和第一3d数据之间建立关联的处理。

[0152]

在该方面,能够获得将2d数据(第一2d数据)和3d数据(第一3d数据)彼此关联的数据。

[0153]

在第十方面的测距成像系统(1a)中,根据第九方面,计算单元(3a)包括2d数据转换单元和融合数据生成单元。2d数据转换单元被配置为通过执行将第一2d数据的每个像素的像素值分配给第二2d数据的关联像素区域的转换以生成计算出的2d数据,来执行在第一2d数据与第二2d数据之间建立彼此关联的处理。融合数据生成单元被配置为基于计算出的2d数据和第一3d数据生成将第一2d数据和第一3d数据彼此相关联的融合数据。

[0154]

在该方面,能够获得将2d数据(第一2d数据)和3d数据(第一3d数据)彼此相关联的融合数据。

[0155]

在第十一方面的测距成像系统(1a)中,根据第九或第十方面,第二2d数据的多个像素和第一3d数据的多个像素彼此一一对应。

[0156]

在该方面,容易地在第二2d数据和第二3d数据之间建立关联。

[0157]

在第十二方面的测距成像系统(1a)中,根据第九方面至第十一方面中的任一方面,第一获取单元(21a)和第二获取单元(23a)具有互不相同的光轴。

[0158]

在第十三方面的测距成像系统(1a)中,根据第九方面至第十二方面中的任一方面,第一获取单元(21a)和第二获取单元(23a)具有互不相同的空间分辨率。

[0159]

第十四方面的测距成像方法包括第一获取步骤、第二获取步骤和处理步骤。第一获取步骤包括获取第一2d数据。第二获取步骤包括利用同轴光学系统获取第二2d数据和第一3d数据。处理步骤包括执行在第一2d数据与第二2d数据之间建立关联的处理以及在第一2d数据和第一3d数据之间建立关联的处理。

[0160]

在该方面,能够获得将2d数据(第一2d数据)和3d数据(第一3d数据)彼此相关联的数据。

[0161]

第十五方面的程序是被配置为使一个或多个处理器执行第十四方面的测距成像方法的程序。

[0162]

在该方面,能够获得将2d数据(第一2d数据)和3d数据(第一2d数据)彼此相关联的数据。

[0163]

附图标记列表

[0164]

1、1a 测距成像系统

[0165]

21 第一获取单元

[0166]

22 第二获取单元

[0167]

23a 第二获取单元

[0168]

23 第三获取单位

[0169]

3、3a 计算单元

[0170]

31 亮度图像转换单元

[0171]

32 距离图像转换单元

[0172]

33 融合数据生成单元

[0173]

4、4a 成像单元

[0174]

5 测距单元

[0175]

6、6a 检测单元

[0176]

s1 目标空间

[0177]

o1 对象。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。