1.本发明涉及对内窥镜拍摄到的图像进行处理的技术。

背景技术:

2.在内窥镜观察中,将具有挠性的细长的插入部插入到被检体内,对被检体内进行拍摄。近年来,进行了使插入部的操作自动化的研究,专利文献1公开了如下技术:在设置有能够向上下左右弯曲的弯曲部的电子内窥镜装置中,控制弯曲部的弯曲角度以使插入部的前端部朝向所拍摄的管腔的中心。

3.近年来,作为与深度学习有关的技术,提出了根据图像估计深度方向的信息的方法(非专利文献1),还进行了根据内窥镜图像生成深度方向的信息的研究(非专利文献2)。

4.现有技术文献

5.专利文献

6.专利文献1:日本专利第3645223号公报

7.非专利文献

8.非专利文献1:lei he,guanghui wang and zhanyi hu,“learning depth from single images with deep neural network embedding focal length”,27mar2018《url:https://arxiv.org/pdf/1803.10039.pdf》

9.非专利文献2:faisal mahmood,richard chen,nicholas j.durr,“unsupervised reverse domain adaptation for synthetic medical images via adversarial training”,29nov2017url:https://arxiv.org/pdf/1711.06606.pdf

技术实现要素:

10.发明所要解决的课题

11.在专利文献1中,将影像输出信号中最暗的部分判断为管腔中心,控制弯曲部的弯曲角度,以使内窥镜前端部朝向该管腔中心。因此,由于相对于内窥镜前端部伸出的构造(例如褶皱)而成为阴影的暗部被判断为管腔中心,有可能使内窥镜前端部朝向该暗部。另外,即使在正确地确定了管腔中心的情况下,根据内窥镜前端部周边的状况,也存在不优选使内窥镜前端部朝向管腔中心前进的情况。

12.本发明是鉴于上述情况而完成的,其目的在于提供一种用于根据内窥镜图像生成与内窥镜的动作或操作有关的适当信息的技术。

13.用于解决课题的手段

14.为了解决上述课题,本发明的一种方式的内窥镜图像处理装置具备:图像取得部,其取得内窥镜拍摄到的内窥镜图像;区域分割部,其将图像取得部取得的内窥镜图像分割为多个区域;深度信息生成部,其生成表示图像取得部取得的内窥镜图像的深度的深度信息;以及识别部,其根据表示区域分割部进行区域分割的结果的区域信息和深度信息生成部生成的内窥镜图像的深度信息,确定内窥镜能够行进的方向。

15.本发明的另一方式的内窥镜图像处理装置具有:图像取得部,其取得内窥镜拍摄到的内窥镜图像;操作内容选择部,其根据图像取得部取得的内窥镜图像,从规定的多个操作内容中选择一个以上的操作内容;区域分割部,其将图像取得部取得的内窥镜图像分割为多个区域;识别部,其根据表示区域分割部进行区域分割的结果的区域信息,识别内窥镜前端部周边的状况;以及操作内容决定部,其根据由操作内容选择部选择出的操作内容和由识别部识别出的状况,决定要实施的操作内容。

16.本发明的另一方式的处理内窥镜图像的方法中,取得内窥镜拍摄到的内窥镜图像,将所取得的内窥镜图像分割为多个区域,生成表示所取得的内窥镜图像的深度的深度信息,根据表示区域分割的结果的区域信息及内窥镜图像的深度信息,确定内窥镜能够行进的方向。

17.另外,以上的构成要素的任意的组合、将本发明的表现在方法、装置、系统、记录介质、计算机程序等之间进行了转换的方式也作为本发明的方式而有效。

附图说明

18.图1是表示实施方式的内窥镜系统的结构的图。

19.图2是表示实施方式的内窥镜系统的功能块的图。

20.图3是表示内窥镜图像的一例的图。

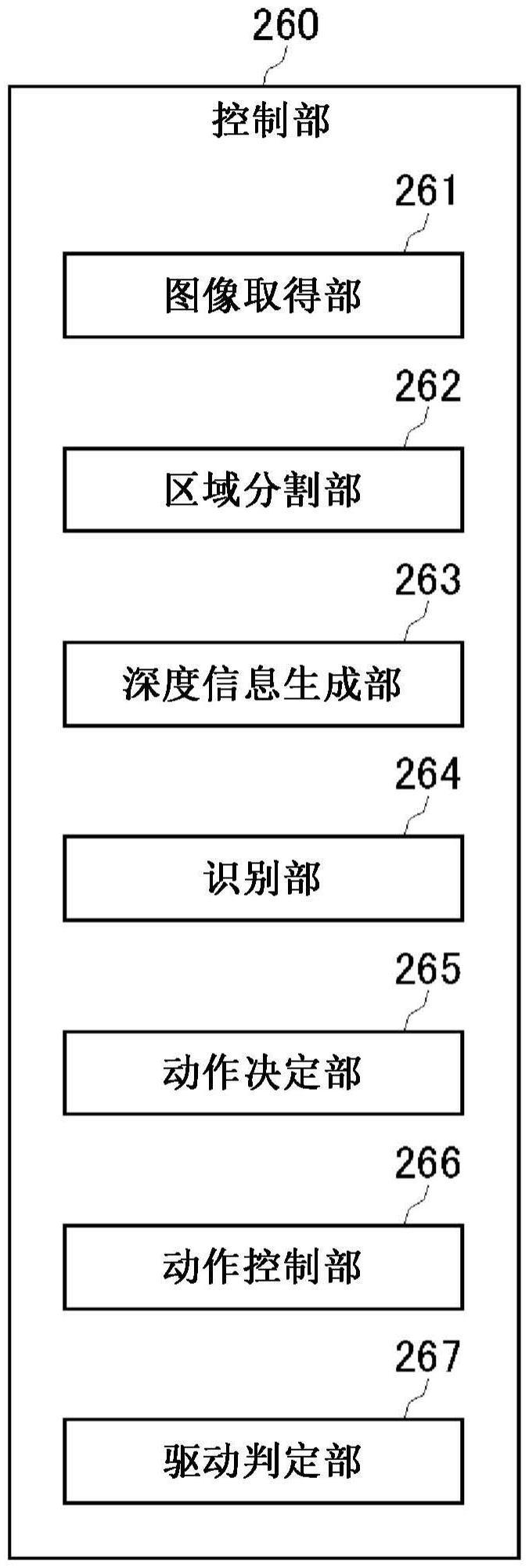

21.图4是表示实施例1的控制部的功能块的图。

22.图5是表示内窥镜图像的一例的图。

23.图6是表示区域分割结果的例子的图。

24.图7是表示深度信息估计结果的例子的图。

25.图8是表示通过将区域分割结果图像和深度估计结果图像重叠而得到的重叠图像的例子的图。

26.图9是表示重叠图像中的识别结果的例子的图。

27.图10是表示内窥镜图像的另一例的图。

28.图11是表示区域分割结果的例子的图。

29.图12是表示深度信息估计结果的例子的图。

30.图13是表示内窥镜图像的另一例的图。

31.图14是表示区域分割结果的例子的图。

32.图15是表示深度信息估计结果的例子的图。

33.图16是表示内窥镜图像的另一例的图。

34.图17是表示区域分割结果的例子的图。

35.图18是表示深度信息估计结果的例子的图。

36.图19是表示实施例2的控制部的功能块的图。

37.图20是表示训练数据的例子的图。

38.图21是表示训练数据的另一例的图。

39.图22是表示训练数据的另一例的图。

40.图23是表示训练数据的另一例的图。

41.图24是表示训练数据的另一例的图。

42.图25是表示训练数据的另一例的图。

43.图26是表示训练数据的另一例的图。

44.图27是表示训练数据的另一例的图。

45.图28是表示训练数据的另一例的图。

46.图29是表示训练数据的另一例的图。

47.图30是表示训练数据的另一例的图。

48.图31中(a)是表示内窥镜图像的一例的图,(b)是表示区域分割结果图像的一例的图。

49.图32是表示将区域分割结果图像分割为多个部分区域的状态的图。

50.图33中(a)是表示内窥镜图像的一例的图,(b)是表示区域分割结果图像的一例的图。

51.图34是表示将区域分割结果图像分割为多个部分区域的状态的图。

52.图35中(a)是表示内窥镜图像的一例的图,(b)是表示区域分割结果图像的一例的图。

53.图36是表示将区域分割结果图像分割为多个部分区域的状态的图。

54.图37是表示弯折部的褶皱边缘的2个端点及其中间点的图。

55.图38是表示内窥镜图像的另一例的图。

56.图39是表示区域分割结果的例子的图。

57.图40是表示深度信息估计结果的例子的图。

58.图41是表示深度估计结果图像的识别例的图。

具体实施方式

59.以下,参照附图对本发明的实施方式进行说明。

60.图1表示实施方式的内窥镜系统1的结构。内窥镜系统1设置于内窥镜检查室,具备内窥镜控制装置2、内窥镜10、输入装置50以及显示装置60。内窥镜控制装置2具有处理装置20、插入形状检测装置30以及外力信息取得装置40,并具有对插入到被检者的体内的内窥镜10进行自动操作的功能。内窥镜10的自动操作通过具备一个以上的处理器22及存储介质24的处理装置20来实施。

61.输入装置50是由用户操作的输入接口,构成为向处理装置20输出与用户的操作相应的指示。输入装置50例如可以包括鼠标、键盘、触摸面板等那样的操作装置。显示装置60是对从处理装置20输出的内窥镜图像等进行画面显示的设备,可以是液晶显示器、有机el显示器。

62.内窥镜10具备包含固体摄像元件(例如ccd图像传感器或cmos图像传感器)的摄像部。固体摄像元件将入射光转换为电信号并输出至处理装置20。处理装置20具有信号处理部,生成内窥镜图像,该信号处理部对由固体摄像元件进行光电转换后的摄像信号实施a/d转换、噪声去除等信号处理。另外,信号处理部也可以设置于内窥镜10侧,由内窥镜10生成内窥镜图像。处理装置20使显示装置60实时地显示由内窥镜10拍摄的影像。

63.内窥镜10具备插入到被检体内的插入部11、设置于插入部11的基端侧的操作部16及从操作部16延伸设置的通用缆线17。内窥镜10通过设置于通用缆线17的端部的镜体连接

器(未图示)而装卸自如地连接于处理装置20。

64.细长形状的插入部11从前端侧朝向基端侧依次具有硬质的前端部12、弯曲自如地形成的弯曲部13以及具有挠性的长条的挠性管部14。在前端部12、弯曲部13以及挠性管部14的内部沿着插入部11的长度方向以预定的间隔配置有多个源线圈18,源线圈18产生与从处理装置20提供的线圈驱动信号相应的磁场。

65.在内窥镜10插入到被检体内的状态下,当医生等用户对操作部16的释放开关进行操作时,处理装置20捕获内窥镜图像,并将其发送到图像服务器(未图示)进行记录。释放开关也可以设置于输入装置50。在内窥镜10的内部设置有用于传输从处理装置20提供的照明光而对被检体内进行照明的光导(未图示),在前端部12设置有用于向被摄体射出由光导传输的照明光的照明窗和以规定的周期拍摄被摄体并将摄像信号输出到处理装置20的摄像部。

66.在实施方式的内窥镜系统1中,处理装置20自动操作内窥镜10来自动控制被检体内的内窥镜10的动作,但用户也能够把持操作部16来手动操作内窥镜10。

67.操作部16可以具备用于供用户操作内窥镜10的操作部件。操作部16至少包括用于使弯曲部13向与插入部11的长度轴交叉的8个方向弯曲的弯角钮。

68.以下,表示内窥镜10的基本操作例。

69.·

用于使插入部11前进的“前进操作(按压操作)”70.·

用于使插入部11后退的“后退操作(拉动操作)”71.·

用于使弯曲部13弯曲的“角度操作”72.·

用于使插入部11绕插入轴旋转的“扭转操作”73.·

用于向前端部12的前方喷出气体的“送气操作”74.·

用于向前端部12的前方喷出液体的“送水操作”75.·

用于吸引存在于前端部12附近的组织片等物体的“吸引操作”76.·

用于使弯曲部13向多个方向弯曲而使前端部12朝向多个方向搜索管腔中心的“搜索操作”77.此外,在实施方式中,前端部12的上下方向被设定为与插入部11的插入轴正交的方向,并且被设定为与设置于摄像部的固体摄像元件的垂直方向对应的方向。另外,前端部12的左右方向被设定为与插入部11的插入轴正交的方向,并且被设定为与设置于摄像部的固体摄像元件的水平方向对应的方向。因此,在实施方式中,前端部12的上下方向与从信号处理部220输出的内窥镜图像的上下方向一致,前端部12的左右方向与该内窥镜图像的左右方向一致。

78.处理装置20相对于插入形状检测装置30、外力信息取得装置40、输入装置50以及显示装置60的各结构装卸自如地连接。处理装置20受理从输入装置50输入的用户的指示,实施与该指示对应的处理。另外,处理装置20取得从内窥镜10周期性地输出的摄像信号,使内窥镜图像显示于显示装置60。

79.插入形状检测装置30具有如下功能:检测设置于插入部11的多个源线圈18各自产生的磁场,并基于该检测出的磁场的强度取得多个源线圈18各自的位置。插入形状检测装置30生成表示所取得的多个源线圈18的位置的插入形状信息,并输出至处理装置20及外力信息取得装置40。

80.外力信息取得装置40存储有未施加外力的状态下的插入部11的规定的多个位置的曲率(或曲率半径)和弯曲角度的数据、以及在从假定的所有方向对插入部11的任意位置施加了规定的外力的状态下所取得的该规定的多个位置的曲率(或曲率半径)和弯曲角度的数据。外力信息取得装置40基于从插入形状检测装置30输出的插入形状信息来确定设置于插入部11的多个源线圈18的位置,取得该多个源线圈18各自的位置处的曲率(或曲率半径)和弯曲角度。外力信息取得装置40可以根据所取得的曲率(或曲率半径)和弯曲角度以及预先存储的各种数据,取得表示该多个源线圈18各自的位置处的外力的大小和方向的外力信息。外力信息取得装置40将所取得的外力信息输出至处理装置20。

81.图2表示实施方式的内窥镜系统1的功能块。内窥镜系统1具备内窥镜10、处理装置20、插入形状检测装置30、外力信息取得装置40、输入装置50以及显示装置60。

82.内窥镜10具备源线圈18、摄像部110、进退机构141、弯曲机构142、aws机构143及旋转机构144。进退机构141、弯曲机构142、aws机构143以及旋转机构144构成内窥镜10中的动作机构。

83.摄像部110具有:观察窗,来自被照明光照明的被摄体的返回光入射到该观察窗;以及固体摄像元件(例如ccd图像传感器或cmos图像传感器),其拍摄该返回光并输出摄像信号。

84.进退机构141具有用于实现使插入部11前进和后退的动作的机构。进退机构141例如可以构成为具有配置于隔着插入部11对置的位置的一对辊和使该一对辊旋转的马达。进退机构141根据从处理装置20输出的进退控制信号来驱动马达,使一对辊旋转,由此执行使插入部11前进的动作和使插入部11后退的动作中的任一方。

85.弯曲机构142具有用于实现使弯曲部13弯曲的动作的机构。弯曲机构142例如可以构成为具有设置于弯曲部13的多个弯曲块、与该多个弯曲块连结的多个线、以及用于牵引该多个线的马达。弯曲机构142根据从处理装置20输出的弯曲控制信号来驱动马达,使多个线的牵引量变化,由此能够使弯曲部13向与插入部11的长度轴交叉的8个方向中的任意方向弯曲。

86.aws(air feeding,water feeding,and suction:送气、送水、吸引)机构143具有用于实现送气动作、送水动作以及吸引动作的机构。例如,aws机构143可以构成为具有:设置于插入部11、操作部16以及通用缆线17的内部的送气送水管路以及吸引管路这两个管路;以及进行将该两个管路中的一方打开并且将另一方封闭的动作的电磁阀。

87.在根据从处理装置20输出的aws控制信号使电磁阀动作以打开送气送水管路的情况下,aws机构143使包含从处理装置20提供的水及空气中的至少一方的流体在该送气送水管路中流通,并从形成于前端部12的排出口排出该流体。另外,在根据从处理装置20输出的aws控制信号使电磁阀动作以打开吸引管路的情况下,aws机构143使在处理装置20中产生的吸引力作用于该吸引管路,利用该吸引力吸引存在于在前端部12形成的吸引口附近的物体。

88.旋转机构144具有用于实现以插入部11的插入轴为旋转轴使插入部11旋转的动作的机构。旋转机构144例如可以构成为具有在挠性管部14的基端侧将插入部11支承为能够旋转的支承部件和用于使该支承部件旋转的马达。旋转机构144根据从处理装置20输出的旋转控制信号来驱动马达,使支承部件旋转,由此使插入部11绕插入轴旋转。

89.插入形状检测装置30具备接收天线310及插入形状信息取得部320。接收天线310构成为具有三维地检测多个源线圈18各自产生的磁场的多个线圈。接收天线310当检测到多个源线圈18各自产生的磁场时,将与该检测到的磁场的强度对应的磁场检测信号输出到插入形状信息取得部320。

90.插入形状信息取得部320基于从接收天线310输出的磁场检测信号,取得多个源线圈18各自的位置。具体而言,插入形状信息取得部320取得以被检体的规定位置(肛门等)为原点或基准点的假想的空间坐标系中的多个三维坐标值,作为多个源线圈18的位置。插入形状信息取得部320生成包含多个源线圈18的三维坐标值的插入形状信息,并输出至控制部260及外力信息取得装置40。

91.外力信息取得装置40基于从插入形状检测装置30输出的插入形状信息,取得该多个源线圈18各自的位置处的曲率(或曲率半径)和弯曲角度。外力信息取得装置40可以根据所取得的曲率(或曲率半径)和弯曲角度以及预先存储的各种数据,取得表示该多个源线圈18各自的位置处的外力的大小和方向的外力信息。外力信息取得装置40将所取得的外力信息输出至控制部260。

92.处理装置20具备光源部210、信号处理部220、线圈驱动信号生成部230、驱动部240、显示处理部250以及控制部260。在实施方式中,处理装置20具有作为对内窥镜图像进行处理的图像处理装置的作用。具体而言,处理装置20根据内窥镜图像生成与内窥镜10的动作或操作相关的信息,自动控制内窥镜10的动作。

93.光源部210生成用于对被检体内进行照明的照明光,并将该照明光供给到内窥镜10。光源部210可以具有一个以上的led或一个以上的灯作为光源。光源部210可以根据从控制部260提供的动作控制信号使照明光的光量变化。

94.信号处理部220具有信号处理电路,对从内窥镜10输出的摄像信号实施规定的处理而生成内窥镜图像,将该生成的内窥镜图像输出到显示处理部250和控制部260。

95.线圈驱动信号生成部230生成用于驱动源线圈18的线圈驱动信号。线圈驱动信号生成部230具有驱动电路,基于从控制部260提供的动作控制信号生成线圈驱动信号,并提供给源线圈18。

96.驱动部240根据从控制部260提供的动作控制信号,生成与内窥镜10的基本操作对应的控制信号,驱动内窥镜10的动作机构。具体而言,驱动部240控制进退机构141的进退动作、弯曲机构142的弯曲动作、aws机构143的aws动作以及旋转机构144的旋转动作中的至少一个动作。驱动部240具备进退驱动部241、弯曲驱动部242、aws驱动部243以及旋转驱动部244。

97.进退驱动部241基于从控制部260提供的动作控制信号,生成并输出用于控制进退机构141的动作的进退控制信号。具体而言,进退驱动部241基于从控制部260提供的动作控制信号,生成并输出用于控制设置于进退机构141的马达的旋转的进退控制信号。

98.弯曲驱动部242基于从控制部260提供的动作控制信号,生成并输出用于控制弯曲机构142的动作的弯曲控制信号。具体而言,弯曲驱动部242基于从控制部260提供的动作控制信号,生成并输出用于控制设置于弯曲机构142的马达的旋转的弯曲控制信号。

99.aws驱动部243基于从控制部260提供的动作控制信号,生成并输出用于控制aws机构143的动作的aws控制信号。具体而言,aws驱动部243基于从控制部260提供的动作控制信

号,生成并输出aws控制信号,该aws控制信号用于控制设置于aws机构143的电磁阀的动作状态。

100.旋转驱动部244基于从控制部260提供的动作控制信号,生成并输出用于控制旋转机构144的动作的旋转控制信号。具体而言,旋转驱动部244基于从控制部260提供的动作控制信号,生成并输出旋转控制信号,该旋转控制信号用于控制设置于旋转机构144的马达的旋转。

101.显示处理部250生成包含从信号处理部220输出的内窥镜图像的显示图像,并将该生成的显示图像显示于显示装置60。另外,显示处理部250也可以使显示装置60显示控制部260对内窥镜图像进行处理的结果图像。

102.控制部260具有如下功能:在内窥镜10的手动插入模式被设定为开启的情况下,生成用于使内窥镜10进行与来自操作部16和输入装置50的指示等对应的动作的动作控制信号,并输出到驱动部240。并且,控制部260具有如下功能:在内窥镜10的自动插入模式被设定为开启的情况下,根据由信号处理部220生成的内窥镜图像,自动控制内窥镜10的动作。以下,在对实施方式中的自动操作控制进行说明之前,对医生对内窥镜的手动操作进行说明。

103.在手动插入模式中,医生根据各种判断来操作内窥镜。医生观察内窥镜图像,瞬间判断例如避开存在于内窥镜前端部附近的障碍物、使内窥镜前端部不与粘膜表面接触、不对肠道施加负荷、假定此后的路径来决定本次的路径等,从而操作内窥镜。

104.图3的(a)表示内窥镜图像的一例。内窥镜图像70a是用内窥镜拍摄由橡胶形成的肠道(橡胶肠道)而得到的图像。医生观察内窥镜图像70a,确认管腔(即管腔的中心,换言之管腔方向)存在于图像中央时,判断可以使内窥镜前端部前进,使内窥镜前端部向前方行进。

105.图3的(b)表示内窥镜图像的另一例。内窥镜图像70b也同样是拍摄橡胶肠道而得到的图像。医生观察内窥镜图像70b,确认管腔中心存在于图像上部,判断为若在该状态下使内窥镜前端部前进则与图像中央部的褶皱接触。因此,医生以使弯曲部13向上方弯曲的方式操作弯角钮,使得在图像中央拍摄到管腔中心。当在图像中央拍摄到管腔中心时,成为与图2的(a)所示的内窥镜图像70a相同的状态,因此医生判断为可以使内窥镜前端部前进,使内窥镜前端部向前方行进。

106.以上的判断和操作只有医生才能够简单地实施,当想要通过装置实现该判断和操作时,需要根据内窥镜图像确定管腔中心,并且识别并掌握内窥镜前端部周边的状况。因此,在实施方式中,提出用于根据内窥镜图像适当地决定内窥镜10的动作的技术。

107.《实施例1>

108.图4表示实施例1中的控制部260的功能块。控制部260包括图像取得部261、区域分割部262、深度信息生成部263、识别部264、动作决定部265、动作控制部266和驱动判定部267。

109.图4所示的控制部260在硬件上能够通过一个以上的处理器22、存储器、辅助存储装置、其他lsi来实现,在软件上通过加载到存储器的程序等来实现,但在此描绘了通过它们的协作来实现的功能块。因此,本领域技术人员可以理解,这些功能块能够通过仅硬件、仅软件、或者它们的组合以各种形式实现。例如,也可以将用于执行控制部260的至少一部

分功能的程序存储于存储介质24,处理器22将程序从存储介质24加载到存储器,实现控制部260的各功能。

110.图像取得部261从信号处理部220取得插入到被检体内的内窥镜10所拍摄的内窥镜图像。内窥镜10的摄像部110以规定的周期(例如30帧/秒)将摄像信号提供给信号处理部220,信号处理部220根据摄像信号生成内窥镜图像,提供给图像取得部261。因此,图像取得部261以规定的周期取得内窥镜图像。图像取得部261将所取得的内窥镜图像提供给区域分割部262和深度信息生成部263。

111.(内窥镜图像的区域分割处理)

112.区域分割部262具有将图像取得部261取得的内窥镜图像分割为多个区域的功能。具体而言,区域分割部262执行对内窥镜图像内的各像素附加标签的语义分割,将内窥镜图像分割为与规定的多个构造对应的区域。区域分割部262定义具有想要分割的类别(class)的构造的区域,生成对各种构造的像素进行了标签赋予的区域分割结果。语义分割使用fcn(fully convolutional neural network:全卷积神经网络)、bisenet(bilateral segmentation network:双边语义分割网络)等来实现,但实施例1中的区域分割部262可以利用fcn来执行语义分割。

113.作为分割的区域的类别(class),可以准备0~255的标签值。在实施例1中,对以下的构造分配标签值。

114.设定

115.标签值0:背景像素

116.标签值1:通常管腔

117.标签值2:褶皱边缘(轮廓)

118.标签值3:弯折部的管腔

119.标签值4:弯折部的褶皱边缘。

120.在语义分割中,标签值0一般意味着“不提取的区域”,但在实施例1中定义的标签值0意味着粘膜表面。被分配标签值1的“通常管腔”意味着在内窥镜图像中内窥镜能够行进的构造,被定义为表示内窥镜前端部的行进方向的构造。具体而言,定义为“通常管腔”的构造表现管腔的延伸方向。另外,除了这些类别以外,也可以对大肠内窥镜检查中出现的残渣、息肉、血管等的构造设定类别,对这些类别分别分配标签值。

121.(内窥镜图像的深度信息生成处理)

122.深度信息生成部263具有如下功能:生成表示由图像取得部261取得的内窥镜图像的深度的信息。以往提出了各种估计图像中包含的像素或块的深度的方法。在非专利文献2中,作为距离信息的训练数据,利用了基于ct电晕术的三维信息,但深度信息生成部263也可以利用非专利文献2所公开的技术,生成表示内窥镜图像的各像素的深度的信息。

123.另外,深度信息生成部263可以基于简单制作的训练数据来生成用于深度估计处理的学习模型。例如训练数据的制作者可以通过目视对图像的各区域指定与深度方向的位置关系对应的标签值0~4的各阶段,由此制作训练数据。在这种情况下,基于人的感觉得到深度方向上的相对位置关系。从通常的内窥镜图像得到作为绝对的数值的距离信息并不容易,但熟练于观察内窥镜图像的人容易在感觉上判断是接近或远景,此外,由于医生实际上使用从图像得到的感觉上的距离信息来实施插入操作,所以这样制作的训练数据的可靠性

较高,能够生成能够估计正确的深度的学习模型。

124.在深度信息生成部263的深度估计方法中,设定与距内窥镜前端部12的距离范围对应的类别。在实施例1中,对各距离范围分配标签值。

125.标签值0:深度《第一距离

126.标签值1:第一距离≤深度《第二距离

127.标签值2:第二距离≤深度《第三距离

128.标签值3:第三距离≤深度《第四距离

129.标签值4:第四距离≤深度标签值0意味着距前端部12的距离最近的区域,标签值4意味着距前端部12的距离最远的区域。

130.图5表示内窥镜图像的一例。内窥镜图像具有720

×

480的尺寸,rgb的各像素由8位表现。在该内窥镜图像中,管腔在深度方向上被直线拍摄,多个褶皱包围管腔。其中,在右下拍摄的褶皱存在于接近内窥镜前端部的距离。

131.当从信号处理部220取得由内窥镜10拍摄到的内窥镜图像时,图像取得部261将内窥镜图像提供给区域分割部262和深度信息生成部263。区域分割部262执行语义分割,将内窥镜图像分割为多个区域。同时,深度信息生成部263执行深度估计处理以生成表示内窥镜图像的深度的深度信息。

132.图6表示区域分割部262的区域分割结果的例子。区域分割部262将内窥镜图像分割为多个区域,导出表示区域分割的结果的区域信息。在此,区域信息可以作为与构造相关的各像素的标签值导出。在实施例1中,区域分割部262使用导出的标签值,生成区域分割结果图像。如后所述,区域分割结果图像可以显示于显示装置60而提示给用户。

133.区域分割部262可以如下那样设定与分割区域的标签值对应的(r,g,b)的像素值。此外,为了区别于与深度信息有关的标签值,以下,将分割区域的标签值0~4表现为标签值a0~a4。

134.标签值a0(背景像素)

→

(0,0,0)

135.标签值a1(通常管腔)

→

(128,0,0)

136.标签值a2(褶皱边缘)

→

(0,0,128)

137.标签值a3(弯折部的管腔)

→

(192,0,0)

138.标签值a4(弯折部的褶皱边缘)

→

(128,128,128)

139.区域分割部262通过这样设定像素值,生成占据大部分的粘膜表面(标签值e0)被涂黑、所提取的构造部分被涂色的区域分割结果图像。区域分割部262将区域分割结果图像作为表示区域分割的结果的区域信息提供给识别部264。在图6所示的例子中,以用户能够看到的方式显示同心圆状的褶皱边缘的区域和通常管腔的区域。在另一例中,区域分割部262可以将每个像素的标签值作为表示区域分割结果的区域信息提供给识别部264。

140.图7表示深度信息生成部263的深度信息估计结果的例子。深度信息生成部263对内窥镜图像执行深度估计处理,以生成表示内窥镜图像的深度的深度信息。在此,深度信息可以作为与深度(距内窥镜前端部的距离)相关的各像素的标签值来导出。在实施例1中,深度信息生成部263使用导出的标签值来生成深度估计结果图像。如稍后将描述的,深度估计结果图像可以与区域分割结果图像一起显示在显示装置60上以提示给用户。

141.深度信息生成部263可以如下那样设定与表示深度等级的标签值对应的(r,g,b)

像素值。另外,为了区别于与分割区域有关的标签值,以下,将深度信息的标签值0~4表现为标签值d0~d4。

142.标签值d0(小于第一距离)

→

(40,0,0)

143.标签值d1(第一距离以上且小于第二距离)

→

(80,0,0)

144.标签值d2(第二距离以上且小于第三距离)

→

(120,0,0)

145.标签值d3(第三距离以上且小于第四距离)

→

(160,0,0)

146.标签值d4(第四距离以上)

→

(200,0,0)

147.通过这样设定像素值,深度信息生成部263生成深度估计结果图像,深度估计结果图像中越深的区域被赋予越亮的红色。深度信息生成部263将深度估计结果图像作为内窥镜图像的深度信息提供给识别部264。在另一例中,深度信息生成部263可以将每个像素的标签值作为内窥镜图像的深度信息提供给识别部264。

148.识别部264从区域分割部262接收内窥镜图像的区域信息,从深度信息生成部263接收内窥镜图像的深度信息,识别内窥镜前端部周边的状况。具体而言,识别部264使用区域信息和深度信息,对内窥镜图像中包含的管腔方向、褶皱等构造与深度方向的位置关系一起进行识别。

149.图8表示通过将区域分割结果图像和深度估计结果图像重叠而得到的重叠图像的例子。在高精度地生成区域分割结果图像和深度估计结果图像的情况下,在区域分割结果图像中提取的褶皱边缘与在深度估计结果图像中所示的边界线基本上一致。另外,在区域分割结果图像中提取的通常管腔区域和在深度估计结果图像中所示的最深部区域也基本上一致。识别部264能够根据重叠图像来识别与由区域分割部262分割出的各种构造对应的各个区域在深度方向上位于何种程度的深度。

150.接着,对伴随深度方向的位置关系的各种构造的识别进行说明。

151.图9表示图8所示的重叠图像中的识别结果的例子。在图9所示的重叠图像中,作为与深度方向有关的信息,对区域附加了标签值d0~d4。另外,对由区域分割部262提取为褶皱边缘的区域(标签值a2)分配e1~e5的附图标记。

152.当参照图6所示的区域分割结果图像时,褶皱边缘e2、e3、e4连续,因此,如果仅根据区域分割结果图像的信息分配,则对褶皱边缘e2、e3、e4分配一个附图标记。但是,识别部264通过参照内窥镜图像的深度信息,确定与各像素的深度相关的标签值d0~d4,能够识别出褶皱边缘e2、e3、e4相互不同。另外,在褶皱边缘存在于与深度有关的不同标签值的边界的情况下,识别部264优选应用更浅的标签值。

153.说明识别任意的像素p(x,y)的状况的方法。另外,0≤x<720,0≤y<480。关于像素p(x,y),与区域分割相关的标签值pa(x,y)为“a2”,与深度相关的标签值pd(x,y)为“d0”。这里,标签值a2表示是褶皱边缘,标签值d0表示是估计为在深度方向上最接近内窥镜前端部的区域。识别部264识别出这样的像素p是构成褶皱边缘e1或e3的像素。另外,区域d0包含褶皱边缘e1和e3,因此,识别部264识别为拍摄有包含褶皱的粘膜表面的区域。与褶皱边缘e2、e4、e5的深度相关的标签值pd(x,y)分别是“d1”、“d2”、“d3”,因此,识别部264将区域d1、d2和d3也识别为拍摄有包含深度不同的褶皱的粘膜表面的区域。

154.识别部264确定具有表示最深部区域的标签值d4的像素p(x,y),参照与分配给该像素p(x,y)的区域分割相关的标签值pa(x,y)。此时,如果具有标签值d4的区域与具有标签

值a1的区域实质上一致,则识别部264识别出具有标签值d4和标签值a1的区域是最深部,并且示出表示行进方向的构造。另外,作为标签值d4的最深部区域的边界的褶皱边缘e3属于标签值d0的最浅的区域,因此,识别部264识别出在图像右下存在可能对内窥镜前端部的前进动作造成障碍的褶皱。即,识别部264识别出图像右下所示的方向是内窥镜不能行进的方向。

155.如上所述,识别部264基于表示由区域分割部262进行区域分割的结果的区域信息和由深度信息生成部263生成的内窥镜图像的深度信息,识别内窥镜图像中包括的各种构造以及深度方向上的位置关系。由此,识别部264确定内窥镜能够行进的方向和不能行进的方向,并且确定在内窥镜行进时可能成为障碍的构造的存在位置。识别部264将表示这些识别结果的信息提供给动作决定部265。

156.动作决定部265基于识别部264中的识别结果,生成与内窥镜10的行进方向相关的信息。具体而言,动作决定部265可以根据在内窥镜前端部能够行进的方向及不能行进的方向,生成与内窥镜10的行进方向相关的信息。在该例子中,动作决定部265可以生成与内窥镜10的行进方向有关的信息,使得避开存在于比最深部的通常管腔区域靠近前侧的位置的褶皱而使前端部12向上前进。

157.图10表示内窥镜图像的另一例。在该内窥镜图像中,拍摄有大肠的弯折部。当从信号处理部220取得由内窥镜10拍摄到的内窥镜图像时,图像取得部261将内窥镜图像提供给区域分割部262和深度信息生成部263。区域分割部262将内窥镜图像分割为多个区域,生成区域分割结果图像。同时,深度信息生成部263执行深度估计处理而生成表示内窥镜图像的深度的深度信息,并且基于深度信息生成深度估计结果图像。

158.图11表示区域分割部262的区域分割结果的例子。区域分割部262将内窥镜图像分割为多个区域,导出表示区域分割的结果的区域信息。区域信息作为与构造相关的各像素的标签值pa(x,y)被导出,区域分割部262使用导出的标签值,生成区域分割结果图像。在该区域分割结果图像中包含在中央附近沿纵向延伸的弯折部的褶皱边缘的区域和沿着弯折部的褶皱边缘的上部提取出的弯折部的管腔的区域。区域分割部262将区域分割结果图像作为表示区域分割的结果的区域信息提供给识别部264。

159.图12表示深度信息生成部263的深度信息估计结果的例子。深度信息生成部263对内窥镜图像执行深度估计处理,而生成表示内窥镜图像的深度的深度信息。导出深度信息作为关于深度的每个像素的标签值pd(x,y),并且深度信息生成部263使用导出的标签值来生成深度估计结果图像。深度信息生成部263将深度估计结果图像作为内窥镜图像的深度信息提供给识别部264。

160.识别部264从区域分割部262接收内窥镜图像的区域信息,从深度信息生成部263接收内窥镜图像的深度信息,识别内窥镜前端部周边的状况。具体而言,识别部264使用区域信息和深度信息,识别内窥镜图像中包含的管腔方向、褶皱等构造以及深度方向的位置关系。由此,识别部264确定在内窥镜前进时可能成为障碍的构造的存在位置,确定内窥镜能够行进的方向和不能行进的方向。在该例子中,识别部264识别出图像左侧是能够行进的方向,图像右侧是不能行进的方向,并且识别出管腔在右方向上连续。识别部264将识别结果提供给动作决定部265,动作决定部265根据内窥镜能够行进的方向和不能行进的方向,生成与内窥镜的行进方向有关的信息。具体而言,动作决定部265以使内窥镜前端部朝向左

并向所朝向的方向前进的方式决定内窥镜前端部的行进方向。

161.图13表示内窥镜图像的另一例。在该内窥镜图像中,在右侧拍摄到较大的褶皱。当从信号处理部220取得内窥镜图像时,图像取得部261将内窥镜图像提供给区域分割部262和深度信息生成部263。

162.图14表示区域分割部262的区域分割结果的例子。区域分割部262将内窥镜图像分割为多个区域,导出表示区域分割的结果的区域信息,生成区域分割结果图像。在该区域分割结果图像中包含褶皱边缘的区域和通常管腔的区域。区域分割部262将区域分割结果图像作为表示区域分割的结果的区域信息提供给识别部264。

163.图15表示深度信息生成部263的深度信息估计结果的例子。深度信息生成部263对内窥镜图像执行深度估计处理,生成表示内窥镜图像的深度的深度信息,并且生成深度估计结果图像。深度信息生成部263将深度估计结果图像作为内窥镜图像的深度信息提供给识别部264。

164.识别部264从区域分割部262接收内窥镜图像的区域信息,从深度信息生成部263接收内窥镜图像的深度信息,识别内窥镜前端部周边的状况。在该例子中,识别部264识别出在图像的右侧存在较大的褶皱,对内窥镜的前进动作造成障碍,从而识别出图像左侧是能够行进的方向,图像右侧是不能行进的方向。识别部264将识别结果提供给动作决定部265,动作决定部265根据内窥镜能够行进的方向和不能行进的方向,生成与内窥镜的行进方向有关的信息。具体而言,动作决定部265以使内窥镜前端部朝向左并向所朝向的方向前进的方式决定内窥镜前端部的行进方向。

165.图16表示内窥镜图像的另一例。在该内窥镜图像中,从上侧到左侧拍摄有较大的褶皱。当从信号处理部220取得内窥镜图像时,图像取得部261将内窥镜图像提供给区域分割部262和深度信息生成部263。

166.图17表示区域分割部262的区域分割结果的例子。区域分割部262将内窥镜图像分割为多个区域,导出表示区域分割的结果的区域信息,生成区域分割结果图像。在该区域分割结果图像中包含褶皱边缘的区域和通常管腔的区域。区域分割部262将区域分割结果图像作为表示区域分割的结果的区域信息提供给识别部264。

167.图18表示深度信息生成部263的深度信息估计结果的例子。深度信息生成部263对内窥镜图像执行深度估计处理,生成表示内窥镜图像的深度的深度信息,并且生成深度估计结果图像。深度信息生成部263将深度估计结果图像作为内窥镜图像的深度信息提供给识别部264。

168.识别部264从区域分割部262接收内窥镜图像的区域信息,从深度信息生成部263接收内窥镜图像的深度信息,识别内窥镜前端部周边的状况。对图17所示的区域分割结果图像和图18所示的深度估计结果图像进行比较时,在区域分割结果图像中作为通常管腔(标签值a1)提取出的区域在深度估计结果图像中跨越标签值d3和d4的区域。因此,识别部264将区域分割结果图像中的标签值a1的区域与深度估计结果图像中的标签值d4的区域的重复区域确定为内窥镜能够行进的区域。识别部264将识别结果提供给动作决定部265,并且动作决定部265生成关于内窥镜的行进方向的信息。具体而言,动作决定部265以使内窥镜前端部朝向右并向所朝向的方向前进的方式决定内窥镜前端部的行进方向。

169.在实施例1中,可以在每个图像取得部261取得内窥镜图像的时机,动作决定部265

决定内窥镜10的动作内容,动作控制部266生成与所决定的动作内容对应的动作控制信号,并提供给驱动部240。

170.另外,作为另一时机例,也可以是,驱动部240根据动作控制部266的动作控制信号来驱动内窥镜10的动作机构,在结束了该驱动的时机,动作决定部265决定内窥镜10的动作内容,动作控制部266生成动作控制信号。

171.例如在驱动部240驱动内窥镜10的动作机构时,驱动判定部267判定为驱动部240正在驱动动作机构。当驱动部240的驱动结束时,驱动判定部267判定动作机构的驱动已结束。此时,驱动判定部267向识别部264通知应该决定新的动作内容。识别部264生成内窥镜图像中包含的各种构造的识别结果,动作决定部265根据识别结果决定内窥镜10的动作内容。动作决定部265可以在动作机构的驱动完成之后或即将完成之前决定内窥镜10的动作内容。

172.在实施例1中,由区域分割部262进行的区域分割处理结果和由深度信息生成部263进行的深度估计处理结果可以通过使用频率成分信息、像素值的亮度信息等的各种公知技术来校正,然后被提供给识别部264。

173.动作控制部266具有根据在动作决定部265中决定的动作内容来控制内窥镜10的动作的功能。动作控制部266也可以基于从插入形状检测装置30输出的插入形状信息和从外力信息取得装置40输出的外力信息中的至少一个,设定所决定的动作内容中的动作量。动作控制部266生成与由动作决定部265决定的动作内容和该动作内容中的动作量相应的动作控制信号,并输出到驱动部240。

174.对实施例1的作用进行说明。以下,对从肛门插入到大肠的肠道内的插入部11的插入操作的控制进行说明。

175.用户在连接内窥镜系统1的各部并接通电源后,将内窥镜10的前端部12插入被检体的肛门。此时,用户操作输入装置50而将内窥镜10的自动插入模式设定为开启,由此处理装置20执行内窥镜10的自动操作功能。

176.光源部210向内窥镜10提供照明光,摄像部110以规定的周期拍摄被照射了该照明光的被摄体,并将摄像信号发送到处理装置20。信号处理部220根据摄像信号生成内窥镜图像,并提供给显示处理部250和图像取得部261。

177.线圈驱动信号生成部230将线圈驱动信号向多个源线圈18提供,接收天线310检测由多个源线圈18分别产生的磁场,插入形状信息取得部320生成插入部11的插入形状信息。插入形状信息被提供给控制部260以及外力信息取得装置40。外力信息取得装置40根据插入形状信息生成多个源线圈18各自的位置处的外力信息,并提供给控制部260。

178.区域分割部262将图像取得部261取得的内窥镜图像分割为多个区域,生成内窥镜图像的区域信息。深度信息生成部263生成表示由图像取得部261取得的内窥镜图像的深度的信息。识别部264从区域分割部262接收内窥镜图像的区域信息,从深度信息生成部263接收内窥镜图像的深度信息,识别内窥镜前端部周边的状况。识别部264使用内窥镜图像的区域信息和内窥镜图像的深度信息,识别内窥镜图像中包含的管腔方向、褶皱等构造、以及深度方向的位置关系。

179.动作决定部265根据识别部264识别出的内窥镜前端部周边的状况,生成与内窥镜的行进方向相关的信息。具体而言,动作决定部265根据识别部264识别出的内窥镜前端部

能够行进的方向和不能行进的方向,生成与内窥镜的行进方向有关的信息,决定内窥镜前端部的动作内容。

180.动作控制部266根据在动作决定部265中决定的动作内容,生成控制内窥镜10的动作的动作控制信号。此时,动作控制部266可以基于从插入形状检测装置30输出的插入形状信息和从外力信息取得装置40输出的外力信息中的至少一个,进行用于设定所决定的动作内容中的动作量的处理。动作控制部266生成与所决定的动作内容和所设定的动作量相应的动作控制信号并向驱动部240输出。

181.动作控制部266根据在动作决定部265中决定的操作内容,生成控制内窥镜10的动作的动作控制信号。此时,动作控制部266可以基于从插入形状检测装置30输出的插入形状信息和从外力信息取得装置40输出的外力信息中的至少一个,进行用于设定所决定的操作内容中的动作量的处理。动作控制部266生成用于进行与所决定的操作内容和所设定的动作量相应的动作控制的动作控制信号并向驱动部240输出。

182.在由动作决定部265决定的动作内容是角度操作的情况下,动作控制部266设定弯曲部13的弯曲角度cds作为该操作内容中的动作量。然后,动作控制部266生成执行使弯曲部13弯曲弯曲角度cds的控制的动作控制信号,并输出到驱动部240。

183.在由动作决定部265决定的动作内容为前进操作的情况下,动作控制部266设定插入部11的移动量mes作为该操作内容中的动作量。然后,动作控制部266生成执行使插入部11前进移动量mes的控制的动作控制信号,并向驱动部240输出。另外,移动量mes优选设定为能够使插入到肠道内的插入部11安全地前进的范围内的值。

184.在由动作决定部265决定的动作内容为后退操作的情况下,动作控制部266设定插入部11的移动量mfs作为该操作内容中的动作量。然后,动作控制部266生成执行使插入部11后退移动量mfs的控制的动作控制信号,并向驱动部240输出。另外,移动量mfs优选设定为能够使插入到肠道内的插入部11安全地后退的范围内的值。

185.在由动作决定部265决定的操作内容为搜索操作的情况下,动作控制部266设定插入部11的移动量mgs作为该操作内容中的动作量。然后,动作控制部266生成使插入部11后退移动量mgs之后执行使前端部12朝向多个方向的控制的动作控制信号,并向驱动部240输出。此时,动作控制部266可以生成执行使前端部12朝向四个或八个方向的控制的动作控制信号。在与搜索操作ses相关的处理中,使前端部12朝向多个方向,实施从在各个方向上拍摄到的内窥镜图像中找到通常管腔的处理。

186.动作控制部266基于从插入形状检测装置30输出的插入形状信息和从外力信息取得装置40输出的外力信息中的至少一个来设定动作量,但也可以读入预先存储在存储介质24中的设定值来设定动作量。

187.《实施例2>

188.图19表示实施例2中的控制部260的功能块。控制部260包括图像取得部261、操作内容选择部270、区域分割部262、深度信息生成部263、识别部264、操作内容决定部271、动作控制部266、驱动判定部267和操作选择模型272。

189.图19所示的控制部260在硬件上能够通过一个以上的处理器22、存储器、辅助存储装置、其他lsi来实现,在软件上通过加载到存储器的程序等来实现,但在此描绘了通过它们的协作来实现的功能块。因此,本领域技术人员可以理解,这些功能块能够通过仅硬件、

仅软件、或者它们的组合以各种形式实现。例如,也可以将用于执行控制部260的至少一部分功能的程序存储于存储介质24,处理器22将程序从存储介质24加载到存储器,实现控制部260的各功能。

190.实施例2中的图像取得部261、区域分割部262、深度信息生成部263、识别部264、动作控制部266和驱动判定部267具有与实施例1中说明的图像取得部261、区域分割部262、深度信息生成部263、识别部264、动作控制部266和驱动判定部267相同或相似的功能,因此将适当地省略重复的说明。

191.图像取得部261从信号处理部220取得插入到被检体内的内窥镜10所拍摄的内窥镜图像。在实施例2中,图像取得部261将所取得的内窥镜图像提供给操作内容选择部270、区域分割部262和深度信息生成部263。

192.操作内容选择部270具有根据图像取得部261取得的内窥镜图像,从规定的多个操作内容中选择一个以上的操作内容的功能。换言之,操作内容选择部270根据对被检体内进行拍摄而得到的内窥镜图像,从内窥镜操作的多个选项中选择此后应该实施的操作内容。规定的多个操作内容可以由前进操作、后退操作、角度操作、扭转操作、送气操作、送水操作、吸引操作中的至少一种操作构成。

193.操作内容选择部270通过向操作选择模型272输入从在图像取得部261中取得的内窥镜图像中取得的输入数据,来选择对拍摄了该内窥镜图像的内窥镜10推荐的操作内容。操作选择模型272是通过将学习用图像和标签用作训练数据的机器学习而生成的学习完毕模型,该学习用图像是过去拍摄的内窥镜图像,该标签表示对拍摄了学习用图像的内窥镜的操作内容。

194.在实施例2中,操作选择模型272通过利用深度学习等学习方法学习与包括输入层、一个以上的卷积层以及输出层的多层神经网络相当的cnn(convolutional neural network:卷积神经网络)中的各连接系数(权重)而生成。

195.区域分割部262具有将图像取得部261取得的内窥镜图像分割为多个区域的功能。具体而言,区域分割部262执行对内窥镜图像内的各像素附加标签的语义分割,将内窥镜图像分割成各构造的区域。区域分割部262定义具有想要分割的类别(class)的构造的区域,生成对各种构造的像素进行了标签赋予的区域分割结果。区域分割部262将表示区域分割的结果的区域信息提供给识别部264。

196.深度信息生成部263具有如下功能:生成表示由图像取得部261取得的内窥镜图像的深度的信息。以往提出了各种估计图像中包含的像素或块的深度的方法。深度信息生成部263例如可以利用非专利文献2所公开的技术,生成表示内窥镜图像的各像素的深度的信息。深度信息生成部263将内窥镜图像的深度信息提供给识别部264。

197.识别部264根据表示区域分割部262进行区域分割的结果的区域信息和/或深度信息生成部263生成的内窥镜图像的深度信息,识别内窥镜前端部周边的状况。具体而言,识别部264至少确定内窥镜10能够行进的方向和不能行进的方向作为内窥镜前端部周边的状况。

198.操作内容决定部271根据在操作内容选择部270中选择出的操作内容和由识别部264识别出的内窥镜前端部周边的状况,决定要实施的操作内容。

199.在实施例2中,可以在图像取得部261取得内窥镜图像的每个时机,操作内容决定

部271决定内窥镜10的操作内容,动作控制部266生成与所决定的操作内容对应的动作控制信号,并提供给驱动部240。另外,作为另一时机例,也可以是,驱动部240根据动作控制部266的动作控制信号来驱动内窥镜10的动作机构,在结束了该驱动的时机,操作内容决定部271决定内窥镜10的操作内容,动作控制部266生成动作控制信号。

200.(操作内容的选择处理)

201.在生成操作选择模型272时,进行使用了包含学习用图像和标签的训练数据的机器学习,该学习用图像是过去用内窥镜拍摄肠道或结肠模型的内部而得到的内窥镜图像,该标签表示最适合于由该学习用图像表示的状况的操作内容是12个操作内容中的哪一个。

202.其中,12个操作内容包括:

203.·

用于使弯曲部13弯曲而使前端部12朝向上方的角度操作ups

204.·

用于使弯曲部13弯曲而使前端部12朝向右方的角度操作ris

205.·

用于使弯曲部13弯曲而使前端部12朝向下方的角度操作dos

206.·

用于使弯曲部13弯曲而使前端部12朝向左方的角度操作les

207.·

用于使弯曲部13弯曲而使前端部12朝向右上方向的角度操作urs

208.·

用于使弯曲部13弯曲而使前端部12朝向右下方向的角度操作drs

209.·

用于使弯曲部13弯曲而使前端部12朝向左下方向的角度操作dls

210.·

用于使弯曲部13弯曲而使前端部12朝向左上方向的角度操作uls

211.·

用于使前端部12前进的前进操作pss

212.·

用于使前端部12后退的后退操作pls

213.·

用于使前端部12朝向多个方向搜索管腔的搜索操作ses

214.》

·

用于固定弯曲部13的弯曲角度而将前端部12的朝向维持为当前的朝向的角度维持操作ams

215.在制作训练数据时,有经验者观察学习用图像,从上述12个操作内容中主观地选择在该学习用图像所示的状况下最可能进行的一个操作内容,并将所选择的操作内容的标签赋予该学习用图像。有经验者可以是医生。例如在图3的(b)所示的内窥镜图像70b为学习用图像的情况下,由于管腔中心存在于图像上部,因此有经验者决定应进行使内窥镜前端部朝向上方的操作、即角度操作ups,并对内窥镜图像70b赋予角度操作ups的标签。通过对多个过去的内窥镜图像实施该标签赋予作业,制作训练数据。

216.以下,表示包含学习用图像以及标签的训练数据的例子。

217.图20表示训练数据的例子。对图20所示的学习用图像均赋予表示上方向的角度操作的“角度操作ups的标签”。图20所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向上方弯曲的图像。

218.图21表示训练数据的另一例。对图21所示的学习用图像均赋予表示右方向的角度操作的“角度操作ris的标签”。图21所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向右方向弯曲的图像。

219.图22表示训练数据的另一例。对图22所示的学习用图像均赋予表示下方向的角度操作的“角度操作dos的标签”。图22所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向下方弯曲的图像。

220.图23表示训练数据的另一例。对图23所示的学习用图像均赋予表示左方向的角度

操作的“角度操作les的标签”。图23所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向左方向弯曲的图像。

221.图24表示训练数据的另一例。对图24所示的学习用图像均赋予表示右上方向的角度操作的“角度操作urs的标签”。图24所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向右上方向弯曲的图像。

222.图25表示训练数据的另一例。对图25所示的学习用图像均赋予表示右下方向的角度操作的“角度操作drs的标签”。图25所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向右下方向弯曲的图像。

223.图26表示训练数据的另一例。对图26所示的学习用图像均赋予表示左下方向的角度操作的“角度操作dls的标签”。图26所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向左下方向弯曲的图像。

224.图27表示训练数据的另一例。对图27所示的学习用图像均赋予表示左上方向的角度操作的“角度操作uls的标签”。图27所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向左上方向弯曲的图像。

225.图28表示训练数据的另一例。对图28所示的学习用图像均赋予表示前进操作的“按压操作(前进操作)pss的标签”。图28所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使前端部12前进的图像。

226.图29表示训练数据的另一例。对图29所示的学习用图像均赋予表示后退操作的“拉动操作(后退操作)pls的标签”。图29所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使前端部12后退的图像。这里,作为需要后退操作的状况的典型例,存在前端部12过度接近大肠的粘膜表面的状况、以及在内窥镜医生之间被称为“红球”的前端部12与粘膜表面接触的状况等。

227.图30表示训练数据的另一例。对图30所示的学习用图像均赋予表示搜索操作的“搜索操作ses的标签”。图30所示的学习用图像是作为此后进行的内窥镜操作而判断为应该使弯曲部13向多个方向弯曲来拍摄多个方向的图像。

228.关于用于将弯曲部13的弯曲角度固定而使前端部12的朝向维持为当前的朝向的角度维持操作ams的训练数据,省略图示,但例如也可以对图28所示的学习用图像赋予“角度维持操作ams”的标签。

229.实施例2的操作选择模型272通过使用图20~图30所示的训练数据进行机器学习而生成。

230.操作内容选择部270通过将从在图像取得部261中取得的内窥镜图像取得的输入数据输入到一个以上的操作选择模型272,来选择一个以上的操作内容,该操作选择模型272通过将学习用图像和标签用作训练数据的机器学习而生成的,该标签表示针对拍摄了学习用图像的内窥镜的操作内容。具体而言,操作内容选择部270取得在图像取得部261中取得的内窥镜图像中包含的各像素的像素值等多维数据,将该多维数据作为输入数据输入到操作选择模型272的神经网络的输入层。操作选择模型272从神经网络的输出层输出与能够选择为内窥镜10的操作内容的12个操作内容分别对应的12个似然度。操作内容选择部270能够得到与输出数据所包含的12个似然度中最高的一个似然度对应的操作内容作为内窥镜10的操作内容的选择结果。

231.如上所述,操作内容选择部270构成为,通过将从在图像取得部261中取得的内窥镜图像中取得的输入数据输入到操作选择模型272中进行处理,得到表示从12个操作内容中选择出的一个操作内容的选择结果,该12个操作内容包含用于使前端部12的朝向为与插入部11的插入轴正交的8个方向的操作、用于使前端部12前进或后退的操作、用于使前端部12的朝向维持为当前朝向的操作、以及用于搜索前端部12附近的管腔的操作。操作内容选择部270将所选择的操作内容提供给操作内容决定部271。

232.操作选择模型272优选通过充分的学习来构建,以便能够输出适当的操作内容,但其精度依赖于训练数据。因此,在实施例2中,实现根据识别部264识别的内窥镜前端部周边的状况来判断由操作内容选择部270选择的操作内容是否适当的方法。

233.(内窥镜图像的区域分割处理)

234.与操作内容选择部270中的处理并行地,区域分割部262将图像取得部261取得的内窥镜图像分割为多个区域。如实施例1中说明的那样,区域分割部262执行对内窥镜图像内的各像素附加标签的语义分割,将内窥镜图像分割成各构造的区域。区域分割部262可以利用fcn执行语义分割。

235.图31的(a)表示内窥镜图像的一例。当从信号处理部220取得由内窥镜10拍摄到的内窥镜图像时,图像取得部261将内窥镜图像提供给操作内容选择部270和区域分割部262。操作内容选择部270将从图31的(a)的内窥镜图像取得的输入数据输入到操作选择模型272的结果是,作为操作内容,选择了使前端部12前进的“前进操作pss”。操作内容选择部270将所选择的操作内容提供给操作内容决定部271。

236.区域分割部262执行语义分割,将内窥镜图像分割为多个区域。

237.图31的(b)表示区域分割部262的区域分割结果的例子。区域分割部262将内窥镜图像分割为多个区域,导出表示区域分割的结果的区域信息。在此,区域信息可以作为与构造相关的各像素的标签值pa(x,y)导出。区域分割部262使用导出的标签值,生成区域分割结果图像。在实施例2中,内窥镜图像具有720

×

480的尺寸,区域分割结果图像也同样具有720

×

480的尺寸。区域分割部262将区域分割结果图像作为表示区域分割的结果的区域信息提供给识别部264。在该区域分割结果图像中,包含同心圆状的褶皱边缘的区域和通常管腔的区域。在另一例中,区域分割部262可以将每个像素的标签值作为表示区域分割结果的区域信息提供给识别部264。

238.识别部264将720

×

480的尺寸的区域分割结果图像分割为多个部分区域,识别各部分区域中包含的通常管腔区域的比例。在实施例2中,将内窥镜图像在水平方向和垂直方向上分别5等分,分割为5

×

5的部分区域,用sub(i,j)表现各部分区域。另外,i、j=1、2、3、4、5。在另一例中,识别部264也可以以5

×

5以外的分割数分割区域分割结果图像。

239.图32表示将区域分割结果图像分割为多个部分区域的状态。在该例子中,被作为通常管腔提取的区域跨越部分区域sub(3,2)、sub(2,3)、sub(3,3)、sub(2,4)、sub(3,4)而存在。识别部264导出在各部分区域sub(i,j)中通常管腔的像素数所占的比例。该比例通过下式计算。在此,将部分区域的总像素数表现为an,在该例中an=144

×

96。

240.通常管腔比例(a)=(部分区域中的通常管腔区域的像素数)/an

241.识别部264可以将该比例(a)超过规定的阈值(例如0.4)的部分区域所包含的通常管腔区域判定为内窥镜能够行进的区域。在该例子中,针对sub(3,3)计算出的通常管腔比

例(a)超过阈值,因此,识别部264识别出在内窥镜图像中的sub(3,3)中存在内窥镜能够行进的区域。识别部264通过确定内窥镜能够行进的区域来识别内窥镜能够行进的方向。识别部264将识别结果提供给操作内容决定部271。

242.另外,在上述例子中,识别部264根据在各部分区域sub(i,j)中通常管腔的像素数所占的比例,判定内窥镜能够行进的区域。在另一例中,识别部264也可以将包含通常管腔的总像素数中的规定比例以上的部分区域sub(i,j)识别为内窥镜能够行进的部分区域。在该情况下,识别部264对被区域分割为通常管腔的像素数pl进行计数。识别部264导出各部分区域sub(i,j)所包含的通常管腔区域相对于通常管腔区域整体所占的比例。该比例通过以下的式子导出。

243.通常管腔比例(b)=(部分区域中的通常管腔区域的像素数)/pl

244.识别部264可以将该比例(b)超过规定的阈值(例如0.6)的部分区域判定为内窥镜能够行进的区域。在该例子中,针对sub(3,3)计算出的通常管腔比例(b)超过阈值,因此,识别部264识别出在内窥镜图像中的sub(3,3)中存在内窥镜能够行进的区域。另外,识别部264也可以将比例(b)最大的部分区域确定为内窥镜能够行进的区域。识别部264通过确定内窥镜能够行进的区域来识别内窥镜能够行进的方向。识别部264将其识别结果提供给操作内容决定部271。识别部264可以根据通常管腔比例(a)或通常管腔比例(b)中的任意一方,确定内窥镜能够行进的区域和方向。

245.操作内容决定部271从操作内容选择部270接收所选择的操作内容,从识别部264接收前端部周边的状况的识别结果。操作内容决定部271基于由识别部264识别出的状况来判断由操作内容选择部270选择出的操作内容是否适当。这里,操作内容决定部271选择使前端部12前进的“前进操作pss”作为操作内容,识别部264识别出在位于内窥镜图像的中央的sub(3,3)中存在内窥镜前端部能够行进的区域。sub(3,3)存在于内窥镜前端部的前进方向,因此操作内容决定部271判断为由操作内容选择部270选择的前进操作pss是适当的,将前进操作pss决定为要实施的操作内容。

246.图33的(a)表示内窥镜图像的另一例。当从信号处理部220取得由内窥镜10拍摄到的内窥镜图像时,图像取得部261将内窥镜图像提供给操作内容选择部270和区域分割部262。操作内容选择部270将从图33的(a)的内窥镜图像取得的输入数据输入到操作选择模型272的结果是,作为操作内容,选择了使前端部12前进的“前进操作pss”。操作内容选择部270将所选择的操作内容提供给操作内容决定部271。

247.图33的(b)表示区域分割部262的区域分割结果的例子。区域分割部262将内窥镜图像分割为多个区域,导出表示区域分割的结果的区域信息。区域信息作为与构造相关的各像素的标签值pa(x,y)被导出,区域分割部262使用导出的标签值,生成区域分割结果图像。区域分割部262将区域分割结果图像作为表示区域分割的结果的区域信息提供给识别部264。识别部264将区域分割结果图像分割为5

×

5的部分区域,识别各部分区域中包含的通常管腔区域的比例。

248.图34表示将区域分割结果图像分割为多个部分区域的状态。在该例子中,被作为通常管腔提取的区域跨越部分区域sub(2,2)、sub(3,2)、sub(2,3)、sub(3,3)而存在。识别部264导出在各部分区域sub(i,j)中通常管腔的像素数所占的比例。在该例子中,识别部264计算通常管腔比例(b),在sub(3,2)中,识别出通常管腔比例(b)超过规定的阈值(例如

0.6)。因此,识别部264识别出在内窥镜图像中的sub(3,2)中存在内窥镜能够行进的区域。识别部264将其识别结果提供给操作内容决定部271。

249.操作内容决定部271从操作内容选择部270接收所选择的操作内容,从识别部264接收前端部周边的状况的识别结果。这里,操作内容选择部270选择使前端部12前进的“前进操作pss”作为操作内容,识别部264识别出在存在于比内窥镜图像的中央部分高的位置的sub(3,2)中存在内窥镜能够行进的区域。sub(3,2)存在于内窥镜前端部的前进方向的上侧,因此操作内容决定部271判断为由操作内容选择部270选择的前进操作pss不适当。在判断为所选择的前进操作pss不适当的情况下,操作内容决定部271可以强制地结束(中断)内窥镜10的操作的自动控制。

250.此时,操作内容决定部271可以将用于使弯曲部13弯曲而使前端部12朝向上方的“角度操作ups”决定为要实施的操作内容。或者,操作内容决定部271可以将在“角度操作ups”之后进行“前进操作pss”决定为要实施的操作内容。这样,操作内容决定部271根据识别部264的识别结果来判断由操作内容选择部270选择出的操作内容是否适当,由此能够对内窥镜前端部的状况校正不适当的操作内容。

251.图35的(a)表示内窥镜图像的另一例。当从信号处理部220取得由内窥镜10拍摄到的内窥镜图像时,图像取得部261将内窥镜图像提供给操作内容选择部270和区域分割部262。操作内容选择部270将从图35的(a)的内窥镜图像取得的输入数据输入到操作选择模型272的结果是,作为操作内容,选择了使前端部12前进的“前进操作pss”。操作内容选择部270将所选择的操作内容提供给操作内容决定部271。

252.图35的(b)表示区域分割部262的区域分割结果的例子。区域分割部262生成区域分割结果图像,并提供给识别部264。识别部264将区域分割结果图像分割为5

×

5的部分区域,识别各部分区域中包含的通常管腔区域的比例。

253.图36表示将区域分割结果图像分割为多个部分区域的状态。在该例子中,不存在通常被作为管腔提取的区域,而提取弯折部的褶皱边缘的区域和沿着弯折部的褶皱边缘的弯折部的管腔的区域。识别部264识别出在各部分区域sub(i,j)中不存在通常管腔区域、以及存在弯折部的管腔区域。

254.首先,识别部264提取部分区域,该部分区域包含被作为弯折部的管腔而提取的区域。在该例中,识别部264识别弯折部的管腔区域跨越部分区域sub(2,2)、sub(3,2)、sub(4,2)、sub(2,3)、sub(3,3)、sub(4,3)、sub(5,3)、sub(5,4)而存在。由此,识别部264识别出弯折部的管腔区域存在于垂直方向上的中央部分。

255.接着,识别部264提取弯折部的褶皱边缘的像素,根据2个端点及其中间点确定弯折部的管腔的圆弧的朝向。

256.图37表示弯折部的褶皱边缘的2个端点及其中间点。识别部264通过确定相对于连结2个端点k1、k2的线段从中间点c垂下的垂线的朝向,来确定由弯折部的褶皱边缘形成的圆弧的朝向。在该例子中,相对于连结端点k1、k2的线段,从中间点c向左下方向引出垂线,因此,识别部264识别出弯折部的褶皱边缘具有相对于中间点c朝向左下方向的开口部、即管腔的延伸方向是内窥镜图像的右上方向。

257.如上所述,识别部264根据图37所示的区域分割结果图像,识别出在内窥镜图像的大致中央部存在管腔的弯折部,管腔延伸方向是图像右上方向,将识别结果提供给操作内

容决定部271。

258.操作内容决定部271在从识别部264接收到识别结果时,判断为操作内容选择部270选择的前进操作pss不适当。操作内容决定部271根据识别结果确认优选进行使前端部12相对于弯折部朝向左下的操作。因此,操作内容决定部271可以将用于使弯曲部13弯曲而使前端部12朝向左下方向的“角度操作dls”决定为要实施的操作内容。或者,操作内容决定部271可以将在“角度操作dls”之后进行“前进操作pss”决定为要实施的操作内容。这样,操作内容决定部271根据识别部264的识别结果来判断由操作内容选择部270选择出的操作内容是否适当,由此能够对内窥镜前端部的状况校正不适当的操作内容。

259.以上说明了操作内容决定部271基于识别部264对区域分割部262的区域分析结果进行识别的结果,判断操作内容选择部270选择的操作内容是否适当的方法。以下,进一步考虑深度信息生成部263生成的内窥镜图像的深度信息,说明操作内容决定部271判断操作内容选择部270选择的操作内容是否适当的方法。

260.图38表示内窥镜图像的另一例。在该内窥镜图像的下部,管腔在深度方向上被直线地拍摄,多个褶皱包围管腔而存在。当从信号处理部220取得由内窥镜10拍摄到的内窥镜图像时,图像取得部261将内窥镜图像提供给操作内容选择部270、区域分割部262和深度信息生成部263。操作内容选择部270将从图38的内窥镜图像取得的输入数据输入到操作选择模型272的结果,作为操作内容,选择使弯曲部13弯曲而使前端部12朝向下方的“角度操作dos”。操作内容选择部270将所选择的操作内容提供给操作内容决定部271。

261.图39表示区域分割部262的区域分割结果的例子。区域分割部262将内窥镜图像分割为多个区域,导出表示区域分割的结果的区域信息,生成区域分割结果图像。在图39所示的区域分割结果图像中,包含褶皱边缘的区域和通常管腔的区域。区域分割部262将区域分割结果图像作为表示区域分割的结果的区域信息提供给识别部264。

262.图40表示深度信息生成部263的深度信息估计结果的例子。深度信息生成部263对内窥镜图像执行深度估计处理,生成表示内窥镜图像的深度的深度信息,并且生成深度估计结果图像。深度信息生成部263将深度估计结果图像作为内窥镜图像的深度信息提供给识别部264。

263.识别部264从区域分割部262接收内窥镜图像的区域信息,从深度信息生成部263接收内窥镜图像的深度信息,识别内窥镜前端部周边的状况。

264.图41表示深度估计结果图像的识别例。识别部264根据区域分割结果图像识别出通常管腔区域存在于图像中央下部。此外,根据深度估计结果图像,识别部264识别出在图像的右下存在最接近内窥镜前端部的区域n,并且存在与区域n相邻的最远离内窥镜前端部的区域f。另外,识别部264参照区域分割结果图像和深度估计结果图像,识别出在区域n与区域f的边界存在褶皱边缘区域,并且在区域f中存在通常管腔区域。

265.如上所述,识别部264根据图39所示的区域分割结果图像和图40所示的深度估计结果图像,识别出在内窥镜图像的中央下部存在通常管腔区域,在其右侧相邻有与内窥镜前端部的距离非常近的褶皱区域,将识别结果提供给操作内容决定部271。

266.操作内容决定部271从操作内容选择部270接收所选择的操作内容,从识别部264接收前端部周边的状况的识别结果。在此,操作内容决定部271选择使前端部12朝向下方的“角度操作dos”作为操作内容。操作内容决定部271根据从识别部264接收到的识别结果,确

认在内窥镜图像的右下部存在前端部12朝向下方时有可能接触的褶皱。操作内容决定部271可以预先掌握被分配了标签值d0的褶皱区域接触可能性高的情况。因此,操作内容决定部271判断为由操作内容选择部270选择的角度操作dos不适当,将操作内容变更为使前端部12朝向左下方向的角度操作dls。此外,操作内容决定部271也可以决定向上方进行角度操作后前进的操作内容,使得越过存在于右下的褶皱。

267.以上,说明了操作内容决定部271基于识别部264对区域分割部262的区域分析结果以及深度信息生成部263的深度推定处理结果进行识别的结果,判断操作内容选择部270选择的操作内容是否适当的方法。在另一例中,操作内容决定部271还可以基于识别部264对深度信息生成部263的深度估计处理结果进行识别的结果,来确定由操作内容选择部270选择的操作内容是否适当。这样,在实施例2中,操作内容决定部271可以根据识别部264对内窥镜前端部周边的识别状况,判断操作内容选择部270所选择的操作内容是否适当。

268.以上,基于多个实施例对本发明进行了说明。本领域技术人员应理解,这些实施方式和实施例是例示,这些各构成要素、各处理过程的组合能够有各种变形例,并且这样的变形例也在本发明的范围内。在实施例中,对将内窥镜10插入大肠时的图像处理进行了说明,但内窥镜10也可以插入其他脏器,还可以插入配管等。

269.在实施例中,说明了对内窥镜图像进行处理来决定内窥镜10的动作内容或操作内容并应用自动插入控制的例子。在变形例中,所决定的动作内容或操作内容也可以作为医生手动操作内窥镜10时的引导信息而显示于显示装置60。另外,所决定的动作内容或操作内容可以记录为日志信息。

270.产业上的可利用性

271.本发明可用于处理内窥镜图像的技术领域。

272.附图标记说明

273.1...内窥镜系统、2

…

内窥镜控制装置、10

…

内窥镜、20

…

处理装置、22

…

处理器、24

…

存储介质、260

…

控制部、261

…

图像取得部、262

…

区域分割部、263

…

深度信息生成部、264

…

识别部、265

…

动作决定部、266

…

动作控制部、267

…

驱动判定部、270

…

操作内容选择部、271

…

操作内容决定部、272

…

操作选择模型。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。