1.本发明涉及一种用于训练人工神经网络的方法。此外,本发明还涉及一种借助根据本发明的用于训练的方法来训练的人工神经网络,以及涉及这种人工神经网络的应用。除此以外,本发明还涉及一种相对应的计算机程序、一种相对应的机器可读的存储介质以及一种相对应的设备。

背景技术:

2.自动化驾驶的支柱是行为预测,该行为预测涉及预报交通智能体(如例如车辆、骑行者、行人)的行为的问题领域。对于至少部分自动化运行的车辆而言重要的是,知道围绕该车辆的交通智能体的可能的未来轨迹的概率分布,以便以如下方式来执行安全规划、尤其是运动规划:控制至少部分自动化运行的车辆,使得碰撞风险最小。行为预测可以分配给预测连续时间序列的一般性问题,该问题又可以被当作生成式建模的情况。生成式建模涉及概率分布的近似、例如借助人工神经网络(knn)对概率分布的近似,以便以受数据控制的方式来学习概率分布:目标分布通过数据集表示,该数据集由多个来自该分布的抽样组成,并且knn被训练为输出如下分布:所述分布以高概率对应于数据样本,或产生与训练数据集的样本相似的样本。目标分布可以(例如针对图像生成)是无条件的,或者可以(例如针对预测,其中未来状态的分布取决于过去的状态)是有条件的。在行为预测中,任务在于,根据确定数目的过去的状态来预测确定数目的未来状态。例如,根据确定的车辆在过去5秒中的位置,预测该车辆在接下来的5秒中的位置的概率分布。在假设为10hz的时间扫描的情况下,这可能会意味着,要根据对50个过去的状态的了解来预测50个未来的状态。用于对这种问题进行建模的一种可能的着手方式是利用递归人工神经网络(英语:recurrent neural network;rnn)或者一维卷积人工神经网络(英语:1d convolutional neural network;1d-cnn)对时间序列进行建模,其中输入是过去位置的序列,并且输出是(例如呈二维正态分布的平均值和参数形式的)未来位置的分布序列。

3.如变分自编码器(vae,variational autoencoder)之类的具有深度隐变量的模型是用于借助人工神经网络进行生成式建模的广泛流行的工具。尤其是,条件vae(英语:conditional vae;cvae)可被用于学习条件分布(也就是说以y为条件的x的分布),其方式是:优化对数分布的下边界(英语:evidence lower bound(证据下界),elbo)的随后估计。如下优化对数概率的下边界:。

4.通过最大化该下边界,所基于的概率分布也变得更高。通过应用最大概率估计(英语:maximum likelihood estimation(最大似然估计),mle)方法,该式子可以被用作针对要训练的人工神经网络的训练对象。为此,要由所述网络对三个分量进行建模:1)先验概率分布(先验(prior)):表示隐变量z在变量y的条件下的概率分

布。

5.2)后验概率分布(推断(inference)):在此表示隐变量z在变量y和可观测到的输出x的条件下的概率分布。

6.3)其他概率分布(生成(generation)):在此表示可观测到的输出x在变量y以及隐变量z的条件下的概率分布。

7.如果rnn被用作人工神经网络,则要附加地实施隐状态(英语hidden states),所述隐状态是将过去的时间步概括为先验、推断和生成概率分布的条件。

8.必须以能够实现库尔贝克-莱布勒(kullbeck-leibler)散度的采样和分析计算的方式来实施这些分量。例如,这对于所学习的正态分布来说是这种情况(人工神经网络典型地为此输出由平均值和方差参数构成的向量)。要学会的条件概率分布是,该可以被扩展为,以便使用隐变量z。在训练时间,在此这两个变量x和y都是已知的。在推断时间,只还有变量y是已知的。

9.针对时间序列的建模,已公开了许多针对连续隐变量的模型。摘录在下面:1)基于rnn:

•ꢀ

storn: https://arxiv.org/abs/1411.7610

•ꢀ

vrnn: https://arxiv.org/abs/1506.02216

•ꢀ

srnn: https://arxiv.org/abs/1605.07571

•

z-forcing: https://arxiv.org/abs/1711.05411

•

variational bi-lstm: https://arxiv.org/abs/1711.057172)基于1d-cnn:

•

stochastic wavenet: https://arxiv.org/abs/1806.06116

•ꢀ

stcn: https://arxiv.org/abs/1902.06568。

10.所有这些模型都基于在每个时间步中采用cvae。条件变量在此表示对以前的时间步的可观测到的变量和隐变量的概括,例如借助rnn的隐状态对以前的时间步的可观测到的变量和隐变的概括。与常见的cvae相比,这些模型为此需要附加分量,以便实施概括。在此可能发生,先验概率分布提供了隐变量在过去的可观测到的变量的条件下的未来概率分布,而推断概率分布提供了隐变量在过去的以及当前可观测到的变量的条件下的未来概率分布。由此,推断概率分布通过了解当前的可观测到的变量来“作弊”,该推断概率分布对于先验概率分布不是已知的。在下面给出了针对序列长度为t的时间elbo的目标函数:。

11.该目标函数已针对vrnn被定义,然而已表明:其他变型也可以使用相同的目标函数、必要时具有相对应的附加项的目标函数。

技术实现要素:

12.本发明基于如下认知:为了训练用于预测时间序列的人工神经网络或人工神经网络系统,针对损失函数所使用的先验概率分布(先验)基于与要预测的时间步的训练数据无关的信息,或先验概率分布(先验)仅仅基于在要预测的时间步之前的信息。

13.此外,本发明基于如下认知:借助将对下界(英语:evidence lower bound,elbo)

的估计一般化为损失函数,可以对所提到的人工神经网络或人工神经网络系统进行训练。

14.借此,现在可能的是,在任意的预测范围(vorhersagehorizont)h(也就是说任意数目的时间步)内,对时间序列作出预测,而没有逐渐丧失预测质量,因此以经过改善的预测质量来作出预测。

15.这导致了,在应用于控制机器、尤其是至少部分自动化运行的机器、如自动化运行的车辆的情况下,对控制的明显改善是可能的。

16.因而,本发明提出了一种用于训练人工神经网络的方法,用以为了控制技术系统而根据过去的连续时间序列来预测在时间步中的未来的连续时间序列。在此,训练基于训练数据集。

17.在此,该方法包括根据损失函数来适配要训练的人工神经网络的参数的步骤。

18.在此,损失函数包括第一项,该第一项具有对在关于至少一个隐变量(英语:latent variable)的先验概率分布(先验)与关于至少一个隐变量(英语:latent variable)的后验概率分布(推断)之间的间距的下界(elbo)的估计。

19.训练方法的特征在于,先验概率分布(先验)与未来的连续时间序列无关。

20.在此,该训练方法适合于训练贝叶斯神经网络。该训练方法也适合于训练递归人工神经网络。在此,特别适合于根据开头概述的现有技术的虚拟递归神经网络(vrnn,virtual recurrent neural network)。

21.根据本发明的方法的实施形式,先验概率分布(先验)并不取决于未来的连续时间序列。

22.延续本发明的主权利要求的主题,按照该实施形式,未来的连续时间序列没有进入对先验概率分布(先验)的确定。在主权利要求的主题中,未来的连续时间序列虽然可以进入对先验概率(先验)的确定,但是该概率分布基本上与这些时间序列无关。

23.根据本发明的方法的一个实施形式,借助下面的损失函数,根据随后的规则来估计下界(elbo):。

24.在此:表示关于直至范围的未来的时间步的可观测到的变量在过去的时间步的可观测到的变量的条件下的目标概率分布。

25.表示推断,也就是说表示关于在整个观测时段内(也就是说针对过去的时间步和直至范围的未来的时间步)的隐变量在整个观测时段内的可观测到的变量的条件下的后验概率分布(推断)。

26.表示生成,也就是说表示关于直至范围的未来的时间步的可观测到的变量在过去的时间步的可观测到的变量和在整个观测时段内的隐变量的条件下的概率分布。

27.表示先验,也就是说表示关于在整个观测时段内的隐变量在

过去的时间步的可观测到的变量的条件下的先验概率分布(先验)。

28.该规则对应于根据如从现有技术中已知的条件变分编码器(conditional variational encoder:cvae)对下界(elbo)的估计,其中,是在时间步t之后的可观测到的状态、也就是说未来的状态;是直至时间步t且包括时间步t在内的可观测到的状态、也就是说已知的状态;是人工神经网络的隐状态。

29.本发明的另一方面是一种计算机程序,该计算机程序设立为,执行根据本发明的方法的所有步骤。

30.本发明的另一方面是一种机器可读的存储介质,在所述机器可读的存储介质上存储有根据本发明的计算机程序。

31.本发明的另一方面是人工神经网络,该人工神经网络借助根据本发明的用于训练人工神经网络的方法来训练。

32.在本发明,在此特别是针对根据开头概述的现有技术的vrnn,该人工神经网络可以是贝叶斯神经网络或递归人工神经网络。

33.本发明的另一方面是根据本发明的人工神经网络用于控制技术系统的应用。

34.在本发明的范围内,技术系统此外可以是机器人、车辆、工具或者工厂机器(werkmaschine)。

35.计算机程序,该计算机程序设立为,执行将根据本发明的人工神经网络用于控制技术系统的应用的所有步骤。

36.本发明的另一方面是一种机器可读的存储介质,在所述机器可读的存储介质上存储有根据本发明的一个方面的计算机程序。

37.本发明的另一方面是一种用于控制技术系统的设备,所述设备设立用于使用根据本发明的人工神经网络。

附图说明

38.随后,依据附图更详细地阐述本发明的实施形式。

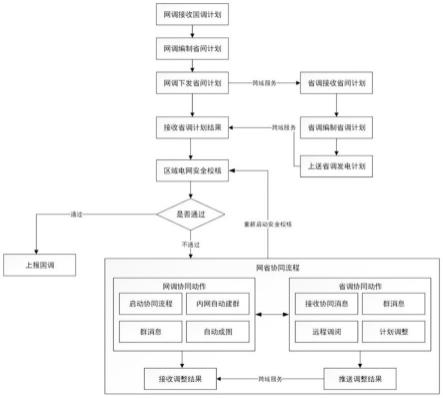

39.图1示出了根据本发明的训练方法的实施形式的流程图;图2示出了根据本发明对用于训练人工神经网络的连续数据序列的处理的图表;图3示出了借助根据现有技术的人工神经网络对输入数据的处理的图表;图4示出了借助如下人工神经网络对输入数据的处理的图表:所述人工神经网络借助根据本发明的训练方法来训练;图5示出了借助如下人工神经网络对输入数据的处理的图表的细节片段:所述人工神经网络借助根据本发明的训练方法来训练;图6示出了根据本发明的训练方法的实施形式的迭代的流程图。

具体实施方式

40.图1示出了根据本发明的训练方法100的实施形式的流程图。

41.在步骤101中,借助训练数据集(x1直至x

t h

),利用根据损失函数来适配人工神经

网络的参数的步骤,训练人工神经网络,用以为了控制技术系统而根据过去的连续时间序列(x1直至x

t

)来预测在时间步(t 1直至t h)中的未来的连续时间序列(x

t 1

直至x

t h

),其中损失函数包括第一项,所述第一项表示对在关于至少一个隐变量(z1至z

t h

)的先验概率分布(先验)与关于至少一个隐变量(z1直至z

t h

)的后验概率分布(推断)之间的间距的下界(elbo)的估计。

42.在此,该训练方法的特点在于,先验概率分布(先验)与未来的连续时间序列(x

t 1

直至x

t h

)无关。

43.图2示出了根据现有技术对用于训练rnn的连续数据序列(x1直至x4)的处理的图表。

44.在该图表中,方形代表基本数据(英语:ground truth data(地面真实数据))。圆圈代表随机数据,或代表概率分布。离开圆圈的箭头代表从概率分布中抽取(英语sampling)样本(英语:sample)、也就是说随机的数据(datums)。菱形代表确定性节点。

45.该图表示出了在处理连续数据序列(x1直至x4)之后的计算的状态。

46.在时间步t中,首先将先验概率分布(先验)确定为隐变量z

t

在概括在rnn的隐状态h

t-1

中所表示的过去的条件下的条件概率分布。

47.进一步,将后验概率分布(推断)确定为隐变量z

t

在对如下过去的概括的条件下的条件概率分布:所述过去在rnn的隐状态h

t-1

中和在连续时间序列(x1直至x4)的分配给时间步t的数据x

t

中被表示。

48.基于后验概率分布(推断)的样本z

t

,确定可观测到的变量x

t

在概括在rnn的隐状态h

t-1

中和在样本z

t

中所表示的过去的条件下的另一条件概率分布(生成)。

49.接着,给rnn输送来自另一概率分布(生成)的样本x

t

,并且输送连续时间序列(x1直至x4)的分配给时间步t的数据x

t

,以便更新rnn的分配给时间步t的隐状态h

t

。

50.根据下面的规则,rnn的分配给时间步t的隐状态h

t

表示先前的时间步《t的模型的状态:。

51.根据所使用的模型,也就是说根据所使用的人工神经网络,也就是说根据所使用的rnn,要选择函数f。选择合适的函数处于相关专业人员的专业知识之内。

52.rnn的初始隐状态可以被任意选择,并且例如可以是。

53.借助另一概率分布(生成)和连续时间序列(x1直至x4)的分配给时间步t的数据x

t

,可以根据本发明估计下界(elbo)的估计的“似然性”部分。为此,可以使用下面的规则:。

54.借助关于rnn的分配给时间步t的隐状态h

t

的先验概率(先验)和后验概率(推断),可以估计下界(elbo)的kl散度部分。为此,可以使用库尔贝克-莱布勒散度(kl散度)的下面的规则:。

55.图3示出了在采用人工神经网络期间对输入数据的处理的图表。

56.在所示的图表中,从两个输入数据x1、x2开始,预测两个未来的时间步的数据x3、

x4,所述两个输入数据x1、x2是两个过去的时间步的数据。该图表指明了在预测两个未来的时间步之后的状态x3、x4。

57.在处理输入数据x1、x2以预测时间序列的未来的数据x3、x4时,首先在分配给先前的时间步t-1的隐状态h

t-1

和分配给当前时间步的输入数据x

t

的条件下,从后验概率分布(推断)中推导出隐变量(英语,latent variables)z

t

。

58.接着,输入数据x

t

和来自后验概率分布(推断)的所推导出的隐变量z

t

被使用,以便更新分配给当前时间步t的隐状态h

t

。

59.一旦为了更新各自的隐藏状态h

t

可能会必需预测数据x3、x4,就可能会只从关于隐状态h

t-1

的先验概率分布(先验)中推导出隐变量z3和z4。接着,可以使用来自先验概率分布(先验)的样本,以便借助另一概率分布(生成)在分配给当前时间步的隐变量z

t

和分配给之前的时间步t-1的隐状态h

t-1

的条件下导出分配给当前时间步t的预测数据x

t

。

60.现在,为了更新分配给当前时间步t的隐状态h

t

,使用来自先验概率分布(先验)的隐变量z

t

和来自另一概率分布(生成)的预测数据x

t

。

61.在更新隐状态h

t

时的根本性变动导致了弱的长期预测性能。

62.图4示出了借助如下人工神经网络对输入数据的处理的图表:所述人工神经网络借助根据本发明的训练方法来训练。

63.相对于借助根据来自现有技术的方法训练过的人工神经网络的处理的中心差异在于,关于在时间步i》t中的隐变量zi的先验概率分布(先验)只还取决于直至时间步t所观测到的变量x1直至x

t

,并且不再如在现有技术中那样取决于所有先前的时间步的可观测到的变量x1直至x

i-1

。由此,先验概率(先验)只还取决于连续数据序列的(已知)数据x1直至x

t

,而不取决于连续数据序列的在处理期间导出的数据x

t 1

直至x

t h

。

64.在图4中所示的图表中,示意性地示出了vrnn中的处理,用于从连续数据序列x1直至x4的两个已知数据x1、x2开始来预测连续数据序列x1直至x4的两个未来的数据x3、x4。

65.在处理连续数据序列x1直至x4的已知数据x1、x2期间,关于隐变量zi的概率分布(亦即先验概率分布(先验)和后验概率分布(推断))分别取决于连续数据序列x1直至x4的(已知数据xi,其中i《3。

66.为了预测未来的时间步i的数据xi(其中i》t),仅仅后验概率分布(推断)取决于所预测的隐变量z3、z4,而先验概率分布(先验)不取决于所预测的隐变量z3、z4。

67.在该图示中,这通过向下的分支来示出。

68.在隐状态hi上方的部分基本上对应于根据图4的处理。在隐状态hi下方的部分表示本发明对如下处理的影响:所述处理为对连续数据序列x1直至x4的数据xi的处理,用于借助相对应的人工神经网络、如例如vrnn来预测未来的时间步i(其中i》t)的数据。

69.对下界(elbo)的估计的“似然性”份额从这些概率分布和连续数据序列x1直至x4的未来数据x3、x4中来计算。在下支路中,与连续数据序列的未来数据x3、x4无关地,确定隐变量、。实现这一点的简单途径是:基于隐变量zi的先验概率分布(先验)的样本来计算连续数据序列的数据xi,从该概率分布中抽取样本并将这些样本馈入到rnn的隐状态中。可以使用概括在x1、x2、z1、z2中表示的过去的隐状态h2,以便获得关于z3的隐分布,但是此后必须构建“并行的”隐状态zi、,所述“并行的”隐状态zi、不包括连续数据序列x1直至x4的未来数据x3、x4的信息,而是作为替代馈入和的生成值,以更新并行的隐状态。

70.即使关于zi的数据可能会间接地与xi有关,但是这不是这种情况,因为对于zi使用kl散度。因而,zi几乎不包含任何关于xi的重要信息。

71.由于kl散度的应用,zi的关于未来的信息必须等于关于未来的在过去的条件下的信息。

72.以这种方式,除了馈入rnn中的隐变量的来自后验概率分布(推断)而不是来自先验概率分布的样本以外,训练时间的计算流中的下部轨道与推断时间的计算流更好地相一致。

73.图5示出了来自图4中所示的处理图表的片段。

74.在该片段中,示出了针对处理的下支路的替选实施形式。该替选方案一方面在于,上支路的信息没有被馈入到下支路中。此外,该替选方案在于,在训练期间也将以前的样本馈入到rnn中,这是另一完全有效的方案,该方案完美地对应于推断时间的计算流。

75.图6示出了根据本发明的训练方法的实施形式的迭代的流程图。

76.在步骤610中,规定训练算法的参数。此外,预测范围h和(已知的)过去的数据集的大小或长度t属于这些参数。

77.这些数据一方面被转发给训练数据集数据库db,而另一方面在步骤630中被转发。

78.在步骤620中,根据这些参数,从训练数据集数据库db中提取出由如下基本数据构成的数据样本:所述基本数据表示(已知的)过去的时间步x1直至x

t

,并且表示未来的时间步的要预测的数据x

t 1

直至x

t h

。

79.在步骤630中,参数和数据样本被输送给预测模型、例如vrnn。该模型由此导出三个概率分布:1)在步骤641中,关于x

t 1

直至x

t h

根据已知的可观测到的数据x1直至x

t

和隐变量z1直至z

t h

的要预测的可观测到的数据的概率分布。

80.2)在步骤642中,关于隐变量z1直至z

t h

根据所提供的数据集x1直至x

t h

的后验概率分布(推断)3)在步骤643中,关于隐变量z1直至z

t h

根据过去的时间步的已知数据x1直至x

t

的先验概率分布(先验)。

81.随后,在步骤650中估计下界,以便在步骤660中导出损失函数。

82.从所导出的损失函数中,接着在未示出的部分中,根据已知方法、例如按照反向传播,可以适配人工神经网络(例如vrnn)的参数。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。