1.本发明涉及一种进行以下的机器学习的机器学习装置、包含该机器学习装置的控制装置以及机器学习方法,其中,上述机器学习用于使控制电动机的伺服控制装置中设置的至少一个滤波器的系数和反馈增益中的至少一方最优化。

背景技术:

2.例如在专利文献1中记载了基于位置偏差等对滤波器的系数以及速度控制部的增益进行机器学习的机器学习装置。

3.具体而言,在专利文献1中记载了一种机器学习装置,其对伺服电动机控制装置进行机器学习,该伺服电动机控制装置具有对控制伺服电动机的控制部的参数、位置指令以及转矩指令中的至少一方的校正值进行变更的变更部,该机器学习装置具有:状态信息取得单元,其通过使伺服电动机控制装置执行预定的程序来取得状态信息,该状态信息包含位置指令、含有位置偏差的伺服状态、参数以及校正值的组合;行为信息输出单元,其输出包含状态信息中所包含的参数和校正值的组合的调整信息的行为信息;回报输出单元,其输出基于状态信息中包含的所述位置偏差的强化学习中的回报的值;以及价值函数更新单元,其根据回报输出单元输出的回报的值、状态信息和行为信息来更新价值函数。

4.而且,在专利文献1中记载了如下内容:伺服电动机控制装置的控制部具备:位置控制部,其基于位置指令来生成速度指令;速度控制部,其基于从位置控制部输出的速度指令来生成转矩指令;以及滤波器,其使从速度控制部输出的转矩指令的预定频率范围的频率的信号衰减,变更部基于行为信息来变更位置控制部和速度控制部中的至少一方的增益、滤波器的滤波器系数、以及与位置指令或转矩指令相加的转矩补偿值和摩擦校正值中的至少一方。

5.另外,例如在专利文献2中记载了一种机器学习装置,其根据滤波器部的输出信号的噪声成分、噪声量以及对输入信号的响应性中的至少一个,学习与滤波器部相关联的条件。

6.具体而言,在专利文献2中记载了一种机器学习装置,其学习与对模拟的输入信号进行滤波的滤波器部相关联的条件,该机器学习装置的特征为具备:状态观测部,其观测由滤波器部的输出信号的噪声成分、噪声量以及针对输入信号的响应性中的至少一个构成的状态变量;以及学习部,其按照由状态变量构成的训练数据集,学习与滤波器部相关联的条件。

7.现有技术文献

8.专利文献

9.专利文献1:日本特开2019-128830号公报

10.专利文献2:日本特开2017-34852号公报

技术实现要素:

11.发明所要解决的课题

12.在调整速度增益或滤波器时,作为稳定裕度的基准,以相位裕度及增益裕度进行评价。但是,若分别评价相位裕度和增益裕度,则各个评价成为“点”的评价,因此即使将这些指标导入机器学习的评价函数,也容易受到测定的波动等的影响。

13.因此,期望考虑相位裕度和增益裕度这两者来调整速度增益和滤波器中的至少一方。

14.用于解决课题的手段

15.(1)本公开的一个方式是一种机器学习装置,其设置在控制电动机的伺服控制装置中,进行使至少一个滤波器的系数和反馈增益中的至少一方最优化的机器学习,该机器学习装置具备,

16.状态信息取得部,其取得状态信息,该状态信息包含所述滤波器的系数和所述反馈增益中的至少一方、以及所述伺服控制装置的输入输出增益和输入输出的相位延迟;

17.行为信息输出部,其输出行为信息,该行为信息包含所述状态信息中包含的所述系数和所述反馈增益中的至少一方的调整信息;

18.回报输出部,其基于根据所述输入输出增益和所述输入输出的相位延迟计算出的奈奎斯特轨迹是否通过闭合曲线的内侧来求出回报并输出,所述闭合曲线在内侧包含复平面上的(﹣1,0),且经过预定的增益裕度和相位裕度;以及

19.价值函数更新部,其根据由所述回报输出部输出的回报的值、所述状态信息以及所述行为信息来更新价值函数。

20.(2)本公开的其他方式是一种控制装置,其具备:

21.上述(1)的机器学习装置;

22.伺服控制装置,其具有至少一个滤波器以及设定反馈增益的控制部,对电动机进行控制;以及

23.频率特性计算装置,其计算所述伺服控制装置中的所述伺服控制装置的输入输出增益和输入输出的相位延迟。

24.(3)本公开的另一方式是一种机器学习装置的机器学习方法,该机器学习装置设置在控制电动机的伺服控制装置中,进行使至少一个滤波器的系数和反馈增益中的至少一方最优化的机器学习,其中,在所述机器学习方法中,

25.取得状态信息,该状态信息包含所述滤波器的系数和所述反馈增益中的至少一方、以及所述伺服控制装置的输入输出增益和输入输出的相位延迟;

26.输出行为信息,该行为信息包含所述状态信息中包含的所述系数和所述反馈增益中的至少一方的调整信息;

27.基于根据所述输入输出增益和所述输入输出的相位延迟计算出的奈奎斯特轨迹是否通过闭合曲线的内侧来求出回报并输出,所述闭合曲线在内侧包含复平面上的(﹣1,0),且经过预定的增益裕度和相位裕度;以及

28.根据所述回报的值、所述状态信息以及所述行为信息来更新价值函数。

29.发明效果

30.根据本公开的各方式,能够考虑相位裕度和增益裕度这两方来调整反馈增益以及

滤波器的系数中的至少一方,能够不受测定的波动等的影响地确保伺服系统的稳定性,并且提高响应性。

附图说明

31.图1是表示包含本公开的一实施方式的机器学习装置的控制装置的框图。

32.图2是表示本公开的一实施方式的机器学习部的框图。

33.图3在复平面上表示奈奎斯特轨迹、单位圆、以及经过增益裕度和相位裕度的圆。

34.图4是增益裕度和相位裕度、以及经过增益裕度和相位裕度的圆的说明图。

35.图5是闭环的伯德图。

36.图6是表示闭环的规范模型的框图。

37.图7是表示规范模型的伺服控制部与学习前后的伺服控制部的输入输出增益的频率特性的特性图。

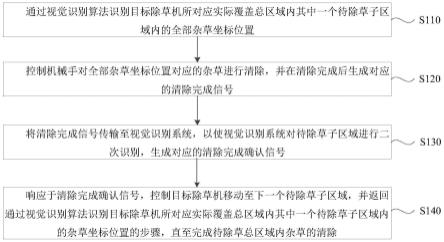

38.图8是表示本实施方式的q学习时的机器学习部的动作的流程图。

39.图9是说明本发明的一实施方式的机器学习部的最优化行为信息输出部的动作的流程图。

40.图10是表示直接连接多个滤波器而构成滤波器的例子的框图。

41.图11是表示控制装置的另一构成例的框图。

具体实施方式

42.以下,使用附图对本公开的实施方式进行详细说明。

43.图1是表示包含本公开的一实施方式的机器学习装置的控制装置的框图。

44.控制装置10具备伺服控制部100、频率生成部200、频率特性计算部300以及机器学习部400。伺服控制部100对应于伺服控制装置,频率特性计算部300对应于频率特性计算装置,机器学习部400对应于机器学习装置。

45.另外,频率生成部200、频率特性计算部300以及机器学习部400中的一个或多个可以设置在伺服控制部100内。频率特性计算部300也可以设置在机器学习部400内。

46.伺服控制部100具备减法器110、速度控制部120、滤波器130、电流控制部140以及电动机150。减法器110、速度控制部120、滤波器130、电流控制部140以及电动机150构成闭环的速度反馈环的伺服系统。电动机150能够使用进行直线运动的直线电动机、具有旋转轴的电动机等。由电动机150驱动的对象例如是机床、机器人、工业机械的机构部。电动机150也可以设置为机床、机器人、工业机械等的一部分。控制装置10也可以设置为机床、机器人、工业机械等的一部分。

47.减法器110求出所输入的速度指令与速度反馈的检测速度之差,将该差作为速度偏差输出到速度控制部120。

48.速度控制部120将对速度偏差乘以积分增益k1v来进行积分而得到的值与对速度偏差乘以比例增益k2v而得到的值进行相加,作为转矩指令向滤波器130输出。速度控制部120成为设定反馈增益的控制部。

49.滤波器130是使特定的频率成分衰减的滤波器,例如使用陷波滤波器、低通滤波器或者带阻滤波器。在具有由电动机150驱动的机构部的机床等机械中存在谐振点,有时在伺

服控制部100中谐振增大。陷波滤波器等滤波器能够降低谐振。将滤波器130的输出作为转矩指令输出到电流控制部140。

50.数学式1(以下表示为数式1)表示作为滤波器130的陷波滤波器的传递函数f(s)。参数表示系数ωc、τ、δ。

51.数学式1的系数δ是衰减系数,系数ωc是中心角频率,系数τ是相对频带。若将中心频率设为fc,将带宽设为fw,则系数ωc由ωc=2πfc表示,系数τ由τ=fw/fc表示。

52.[数式1]

[0053][0054]

电流控制部140基于转矩指令生成用于驱动电动机150的电流指令,并将该电流指令输出到电动机150。

[0055]

在电动机150为直线电动机的情况下,可动部的位置由设置在电动机150的线性标尺(未图示)检测,通过对位置检测值进行微分来求出速度检测值,将求出的速度检测值作为速度反馈输入到减法器110。

[0056]

在电动机150是具有旋转轴的电动机的情况下,旋转角度位置由设置在电动机150的旋转编码器(未图示)检测,将速度检测值作为速度反馈输入到减法器110。

[0057]

如以上那样构成伺服控制部100,但为了对速度控制部120的增益的最佳增益以及滤波器130的最佳参数中的至少一个进行机器学习,控制装置10还具备频率生成部200、频率特性计算部300以及机器学习部400。

[0058]

频率生成部200一边使频率变化一边将正弦波信号作为速度指令输出到伺服控制部100的减法器110和频率特性计算部300。

[0059]

频率特性计算部300使用由频率生成部200生成的成为输入信号的速度指令(正弦波)和从旋转编码器(未图示)输出的成为输出信号的检测速度(正弦波)或从线性标尺输出的成为输出信号的检测位置的积分(正弦波),针对由速度指令规定的各频率,求出输入信号与输出信号的振幅比(输入输出增益)和相位延迟。

[0060]

机器学习部400使用从频率特性计算部300输出的输入输出增益(振幅比)以及相位延迟,对速度控制部120的积分增益k1v以及比例增益k2v中的一个或两个增益、以及滤波器130的传递函数的系数ωc、τ、δ中的至少一个系数进行机器学习(以下,称为学习)。机器学习部400的学习在出厂前进行,但也可以在出厂后进行再学习。

[0061]

以下,对机器学习部400的结构以及动作的详细内容进一步说明。在以下的说明中,以通过电动机150对机床的机构部进行驱动的情况为例进行说明。

[0062]

《机器学习部400》

[0063]

在以下的说明中,对机器学习部400进行强化学习的情况进行说明,但机器学习部400进行的学习并不特别限于强化学习,例如,在进行监督学习的情况下也能够应用本发明。

[0064]

在说明机器学习部400中包含的各功能块之前,首先说明强化学习的基本机制。智能体(相当于本实施方式中的机器学习部400)观测环境的状态,选择某行为,环境根据该行为而变化。伴随着环境的变化,给予某种回报,智能体学习更好的行为的选择(决策)。

[0065]

相对于监督学习表示完全的正解,强化学习中的回报大多是基于环境的一部分的

变化的零散的值。因此,智能体学习行为的选择以使将来的回报的合计成为最大。

[0066]

这样,在强化学习中,智能体通过学习行为,基于行为对环境赋予的相互作用来学习适当的行为,即学习用于使将来得到的回报为最大的学习方法。这表示在本实施方式中,智能体能够获得例如选择用于抑制机械端的振动的行为信息这样的对未来造成影响的行为。

[0067]

在此,作为强化学习,能够使用任意的学习方法,但在以下的说明中,以使用q学习(q-learning)的情况为例进行说明,该q学习(q-learning)是在某个环境的状态s下学习选择行为a时的价值q(s,a)的方法。

[0068]

q学习的目的在于,在某种状态s时,从能够采取的行为a中选择价值q(s,a)最高的行为a来作为最佳行为。

[0069]

然而,智能体在最初开始进行q学习的时间点,对于状态s与行为a的组合,完全不知道价值q(s,a)的正确值。因此,智能体在某个状态s下选择各种行为a,根据所赋予的回报来选择相对于此时的行为a更好的行为,由此来学习正确的价值q(s,a)。

[0070]

另外,智能体想要使将来得到的回报的合计最大化,因此以最终成为q(s,a)=e[σ(γ

t

)r

t

]为目标。在此,e[]表示期待值,t是时刻,γ是后述的被称为折扣率的参数,r

t

是时刻t的回报,σ是时刻t的合计。该式中的期待值是按照最佳的行为进行了状态变化时的期待值。但是,在q学习的过程中,不清楚最佳的行为是什么,因此智能体通过进行各种行为,一边探索一边进行强化学习。这样的价值q(s,a)的更新式例如能够通过以下的数学式2(以下表示为数式2)来表示。

[0071]

[数式2]

[0072][0073]

在上述的数学式2中,s

t

表示时刻t的环境的状态,a

t

表示时刻t的行为。通过行为a

t

,状态变化为s

t 1

。r

t 1

表示通过该状态的变化而得到的回报。另外,带有max的项是在状态s

t 1

下选择了此时已知的q值最高的行为a时的q值乘以γ而得到的值。在此,γ是0<γ≤1的参数,被称为折扣率。另外,α是学习系数,设为0<α≤1的范围。

[0074]

上述的数学式2表示根据作为试行a

t

的结果而返回的回报r

t 1

来更新状态s

t

下的行为a

t

的价值q(s

t

,a

t

)的方法。

[0075]

该更新式表示:如果基于行为a

t

的下一状态s

t 1

下的最佳行为的价值max

a q(s

t 1

,a)大于状态s

t

下的行为a

t

的价值q(s

t

,a

t

),则使q(s

t

,a

t

)增大,反之,如果小于则使q(s

t

,a

t

)减小。即,更新式使某个状态下的某个行为的价值接近基于该行为的下一个状态下的最佳行为的价值。其中,虽然其差根据折扣率γ和回报r

t 1

的方式而变化,但某个状态下的最佳行为的价值传播到此前的前一个状态下的行为的价值。

[0076]

在此,在q学习中具有生成与所有的状态行为对(s,a)有关的q(s,a)的表来进行学习的方法。但是,当使用该学习方法时,为了求出所有的状态行为对的q(s,a)的值,状态数过多,q学习收敛需要很多时间。

[0077]

因此,也可以利用公知的被称为dqn(deep q-network)的技术。具体而言,可以利用dqn,使用适当的神经网络构成价值函数q,通过调整神经网络的参数,利用适当的神经网络对价值函数q进行近似,由此计算价值q(s,a)的值。通过利用dqn,能够缩短q学习收敛所

需的时间。另外,关于dqn,例如在以下的非专利文献中有详细的记载。

[0078]

《非专利文献》

[0079]“human-level control through deep reinforcementlearning”、volodymyrmnih1著[online]、[2017年1月17日检索],互联网《url:http://files.davidqiu.com/research/nature14236.pdf》

[0080]

机器学习部400进行以上说明的q学习。具体而言,机器学习部400将速度控制部120的积分增益k1v和比例增益k2v、滤波器130的传递函数的各系数ωc、τ、δ的值、以及从频率特性计算部300输出的输入输出增益(振幅比)和相位延迟作为状态s,学习作为行为a而选择以下的调整时的价值q,其中,该调整是与上述状态s有关的速度控制部120的积分增益k1v和比例增益k2v以及滤波器130的传递函数的各系数ωc、τ、δ的值的调整。

[0081]

机器学习部400观测通过基于速度控制部120的积分增益k1v和比例增益k2v、以及滤波器130的传递函数的各系数ωc、τ、δ,使用上述频率变化的正弦波即速度指令来驱动伺服控制部100而从频率特性计算部300得到的包含每个频率的输入输出增益和相位延迟的状态信息s,来决定行为a。机器学习部400每当进行行为a时返回回报。

[0082]

机器学习部400例如试错性地探索最优的行为a,以使将来的回报的合计成为最大。由此,机器学习部400能够针对基于速度控制部120的积分增益k1v和比例增益k2v、以及滤波器130的传递函数的各系数ωc、τ、δ,使用频率变化的正弦波即速度指令来驱动伺服控制部100而从频率特性计算部300得到的包含每个频率的输入输出增益和相位延迟的状态s,选择最优的行为a(即,速度控制部120的积分增益k1v和比例增益k2v、以及滤波器130的传递函数的最佳的系数ωc、τ、δ)。

[0083]

即,机器学习部400基于学习到的价值函数q,选择对于与某个状态s有关的速度控制部120的积分增益k1v和比例增益k2v、以及滤波器130的传递函数的各系数ωc、τ、δ应用的行为a中的q的值最大的行为a。然后,机器学习部400通过选择q的值最大的行为a,能够选择出通过执行用于生成频率变化的正弦波信号的程序而产生的伺服控制部100的稳定裕度成为预定值以上的行为a(即,速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ)。

[0084]

图2是表示本公开的一实施方式的机器学习部400的框图。

[0085]

为了进行上述的强化学习,如图2所示,机器学习部400具备状态信息取得部401、学习部402、行为信息输出部403、价值函数存储部404以及最优化行为信息输出部405。学习部402具备回报输出部4021、价值函数更新部4022以及行为信息生成部4023。

[0086]

状态信息取得部401从频率特性计算部300取得通过基于速度控制部120的积分增益k1v和比例增益k2v、以及滤波器130的传递函数的各系数ωc、τ、δ,使用速度指令(正弦波)驱动伺服控制部100而得到的包含输入输出增益(振幅比)和相位延迟的状态s。该状态信息s相当于q学习中的环境状态s。

[0087]

状态信息取得部401将取得的状态信息s输出到学习部402。

[0088]

预先由用户生成最初开始q学习的时间点的速度控制部120的积分增益k1v和比例增益k2v、以及滤波器130的传递函数的各系数ωc、τ、δ。在本实施方式中,机器学习部400通过强化学习将用户生成的速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ的初始设定值调整为最优的值。

[0089]

关于积分增益k1v、比例增益k2v以及系数ωc、τ、δ,在操作者预先调整了机床的情况下,可以将调整完毕的值作为初始值来进行机器学习。

[0090]

学习部402学习在某个环境状态s下选择某个行为a时的价值q(s,a)。

[0091]

首先,对学习部402的回报输出部4021进行说明。

[0092]

回报输出部4021求出在某个状态s下选择了行为a时的回报。

[0093]

速度反馈环由减法器110和传递函数h的开环的回路构成。开环的回路由图1所示的速度控制部120、滤波器130、电流控制部140以及电动机150构成。在将某个频率ω0时的速度反馈环的输入输出增益设为c,将相位延迟设为θ时,闭环频率特性g(jω0)为c

·ejθ

。关于闭环频率特性g(jω0),使用开环频率特性h(jω0)表示为g(jω0)=h(jω0)/(1 h(jω0))。因此,能够通过h(jω0)=g(jω0)/(1﹣g(jω0))=c

·ejθ

/(1﹣c

·ejθ

)求出某个频率ω0时的开环频率特性h(jω0)。

[0094]

回报输出部4021从状态信息取得部401得到通过根据积分增益k1v和比例增益k2v以及系数ωc、τ、δ,使用频率变化的速度指令(正弦波)驱动伺服控制部100而得到的输入输出增益和相位延迟。在将变化的频率设为ω时,如上所述,能够通过关系式h(jω)=g(jω)/(1﹣g(jω))求出开环频率特性h(jω)。回报输出部4021使用从状态信息取得部401得到的输入输出增益和相位延迟,在复平面上描绘开环频率特性h(jω),由此生成奈奎斯特轨迹。

[0095]

通过基于用户设定的积分增益k1v和比例增益k2v以及系数ωc、τ、δ,使用速度指令(正弦波)驱动伺服控制部100而得到初始状态的奈奎斯特轨迹。q学习过程中的奈奎斯特轨迹是通过修正积分增益k1v和比例增益k2v、和/或系数ωc、τ、δ,使用速度指令(正弦波)驱动伺服控制部100而得到的。图3表示复平面上的奈奎斯特轨迹、单位圆、以及经过增益裕度和相位裕度的圆。图3表示初始状态的奈奎斯特轨迹(虚线)以及将比例增益和积分增益分别设为1.5倍时的奈奎斯特轨迹(实线)。图4是增益裕度和相位裕度以及经过增益裕度和相位裕度的圆的说明图。

[0096]

用户预先设定开环的回路100a的增益裕度和相位裕度的值。如图3以及图4所示,当在复平面上描绘了经过(﹣1,0)的单位圆时,能够在实轴上表示用户设定的增益裕度,在单位圆上表示用户设定的相位裕度。

[0097]

回报输出部4021在复平面上生成在内侧包含(﹣1,0)且经过实轴上的增益裕度和单位圆上的相位裕度的闭合曲线。

[0098]

在以下的说明中,如图3以及图4所示,将闭合曲线设为圆,将圆的半径设为半径r,将圆与奈奎斯特轨迹的最短距离设为最短距离d来进行说明。在此,将最短距离d设为圆的中心(图4的黑点)与奈奎斯特轨迹的最短距离,但并不限于此,例如也可以设为圆的外周与奈奎斯特轨迹的最短距离。

[0099]

另外,闭合曲线不限于圆,也可以是圆以外的闭合曲线,例如菱形、四边形或椭圆等。

[0100]

回报输出部4021在最短距离d比半径r小(d<r),奈奎斯特轨迹经过闭合曲线的内侧的情况下给予负值的回报。另一方面,回报输出部4021在最短距离d等于或大于半径r(d≥r),奈奎斯特轨迹不经过圆的内侧的情况下给予零或正值的回报。

[0101]

机器学习部400通过如上述那样给予回报,试错性地搜索奈奎斯特轨迹不经过圆

的内侧,且增益裕度以及相位裕度成为用户设定的值以上的速度控制部120的积分增益k1v和比例增益k2v以及滤波器130的传递函数的系数ωc、τ、δ。

[0102]

在以上说明的例子中,基于圆与奈奎斯特轨迹的最短距离来决定奈奎斯特轨迹是否经过成为闭合曲线的圆的内侧,但并不限于该方法,也可以使用其他方法,例如,也可以根据奈奎斯特轨迹是否与成为闭合曲线的圆的外周相切或与圆相交来进行判断。

[0103]

(考虑了响应速度的例子)

[0104]

在奈奎斯特轨迹经过圆上(d=r)或圆的外侧(d>r)的情况下,奈奎斯特轨迹越远离圆,增益裕度和相位裕度越大,伺服系统的稳定度增加,但反馈增益降低,响应速度降低。

[0105]

因此,优选回报输出部4021给予回报,使得在用户决定的增益裕度和相位裕度以上,反馈增益尽可能大。以下,对于回报输出部4021以在用户决定的增益裕度和相位裕度以上使反馈增益尽可能大的方式决定回报的方法的3个例子进行说明。

[0106]

(1)基于截止频率来决定回报的方法

[0107]

回报输出部4021根据通过基于积分增益k1v和比例增益k2v以及系数ωc、τ、δ,使用速度指令(正弦波)驱动伺服控制部100而得到的闭环的输入输出增益(振幅比)和相位延迟来生成伯德图。图5表示闭环的伯德图的一例。

[0108]

截止频率例如是伯德图的增益特性为-3db的频率,或者相位特性为-180度的频率。在图5中,将增益特性为-3db的频率表示为截止频率。

[0109]

回报输出部4021以截止频率变大的方式决定回报。

[0110]

具体而言,回报输出部4021对积分增益k1v和比例增益k2v、和/或系数ωc、τ、δ进行修正,在从修正前的状态s成为状态s

′

的情况下,根据截止频率fcut变大、或者相同或者变小来决定回报。在以下的说明中,将状态s时的截止频率fcut记载为fcut(s),将状态s

′

时的截止频率fcut记载为fcut(s

′

)。

[0111]

在从状态s变为状态s

′

的情况下,在截止频率fcut变大时,回报输出部4021赋予正值的回报来作为截止频率fcut(s

′

)>截止频率fcut(s)。

[0112]

在从状态s变为状态s

′

的情况下,在截止频率fcut不变时,回报输出部4021赋予零值的回报来作为截止频率fcut(s

′

)=截止频率fcut(s)。

[0113]

在从状态s变为状态s

′

的情况下,在截止频率fcut变小时,回报输出部4021赋予负值的回报来作为截止频率fcut(s

′

)<截止频率fcut(s)。

[0114]

通过如以上那样决定回报,机器学习部400在奈奎斯特轨迹经过圆上或圆的外侧时,试错性地探索速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的系数ωc、τ、δ,以使截止频率fcut变大。

[0115]

通过截止频率fcut变大,反馈增益增大,响应速度变快。

[0116]

(2)基于闭环特性来决定回报的方法

[0117]

回报输出部4021根据通过基于积分增益k1v和比例增益k2v以及系数ωc、τ、δ,使用速度指令(正弦波)驱动伺服控制部100而得到的闭环的输入输出增益(振幅比)和相位延迟,来求出闭环的传递函数g(jω)。回报输出部4021能够应用f=σ|1﹣g(jω)|2来作为预先设定的频域中的评价函数f。

[0118]

回报输出部4021以评价函数f的值变小的方式决定回报。

[0119]

具体而言,回报输出部4021对积分增益k1v和比例增益k2v、和/或系数ωc、τ、δ进

行修正,在从修正前的状态s变为状态s

′

的情况下,根据评价函数f的值变小、或者相同或者变大来决定回报。在以下的说明中,将状态s时的评价函数f的值记载为f(s),将状态s

′

时的评价函数f的值记载为f(s

′

)。

[0120]

若评价函数f的值变小,则图5所示的闭环的伯德图的截止频率变大。

[0121]

在从状态s变为状态s

′

的情况下,在评价函数f的值变小时,回报输出部4021赋予正值的回报,来作为评价函数的值f(s

′

)<评价函数的值f(s)。

[0122]

在从状态s变为状态s

′

的情况下,在评价函数f的值不变时,回报输出部4021赋予零值的回报,来作为评价函数的值f(s

′

)=评价函数的值f(s)。

[0123]

在从状态s变为状态s

′

的情况下,在评价函数f的值变大时,回报输出部4021赋予负值的回报,来作为评价函数的值f(s

′

)>评价函数的值f(s)。

[0124]

通过如以上那样决定回报,机器学习部400在奈奎斯特轨迹经过圆上或圆的外侧的情况下,试错地探索速度控制部120的积分增益k1v和比例增益k2v、以及滤波器130的传递函数的系数ωc、τ、δ,以使得评价函数f的值变小。

[0125]

通过评价函数f的值变小,反馈增益增大,响应速度变快。

[0126]

(3)以最短距离d接近半径r的方式决定回报的方法

[0127]

在奈奎斯特轨迹经过圆上(d=r)或者圆的外侧(d>r)的情况下,以使奈奎斯特轨迹接近闭合曲线的方式决定回报。

[0128]

具体而言,回报输出部4021对积分增益k1v和比例增益k2v、和/或系数ωc、τ、δ进行修正,在从修正前的状态s成为状态s

′

的情况下,根据圆的中心与奈奎斯特轨迹的最短距离d变小、或者相同或者变大来决定回报。在以下的说明中,将状态s时的最短距离d记载为d(s),将状态s

′

时的最短距离d记载为d(s

′

)。

[0129]

在从状态s变为状态s

′

的情况下,在最短距离d变小时,回报输出部4021赋予正值的回报,来作为最短距离d(s

′

)<最短距离d(s)。

[0130]

在从状态s变为状态s

′

的情况下,在最短距离d不变时,回报输出部4021赋予零值的回报,来作为最短距离d(s

′

)=最短距离d(s)。

[0131]

在从状态s变为状态s

′

的情况下,在最短距离d变大时,回报输出部4021赋予负值的回报,来作为最短距离d(s

′

)>最短距离d(s)。

[0132]

通过如以上那样决定回报,机器学习部400试错地探索速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的系数ωc、τ、δ,以使奈奎斯特轨迹经过圆上或者接近圆的外周。

[0133]

通过奈奎斯特轨迹经过圆上或接近圆的外周,反馈增益增大,响应速度变快。

[0134]

基于最短距离d的信息来决定回报的方法并不限于上述方法,能够应用其他方法。

[0135]

(考虑了谐振的例子)

[0136]

即使在奈奎斯特轨迹经过圆上(d=r)或圆的外侧(d>r)的情况下,也存在由于成为控制对象的机械的机械端的谐振而使输入输出增益增大的情况。

[0137]

因此,期望回报输出部4021以在用户决定的增益裕度和相位裕度以上抑制谐振的方式决定回报。以下,对于通过开环特性与规范模型的比较来决定回报的方法进行说明。

[0138]

以下,使用图6和图7对回报输出部4021在所生成的频率特性中的每个频率的输入输出增益大于规范模型的输入输出增益的情况下赋予负的回报的动作进行说明。

[0139]

回报输出部4021保存输入输出增益的规范模型。规范模型是具有无谐振的理想特性的伺服控制部的模型。例如,能够根据图6所示的模型的惯性ja、转矩常数k

t

、比例增益k

p

、积分增益ki、微分增益kd通过计算来求出规范模型。惯性ja是电动机惯性和机械惯性的加法运算值。

[0140]

图7是表示规范模型的伺服控制部与学习前后的伺服控制部100的输入输出增益的频率特性的特性图。如图7的特性图所示,规范模型具备成为一定的输入输出增益以上例如﹣20db以上的理想的输入输出增益的频率区域即区域fa、和小于一定的输入输出增益的频率区域即区域fb。在图7的区域fa中,用曲线mc1(粗线)表示规范模型的理想的输入输出增益。在图7的区域fb中,用曲线mc

11

(虚线的粗线)表示规范模型的理想的虚拟输入输出增益,用直线mc

12

(粗线)将规范模型的输入输出增益表示为一定值。在图7的区域fa以及fb中,分别用曲线rc1、rc2表示学习前后的伺服控制部的输入输出增益的曲线。

[0141]

回报输出部4021在区域fa中,在所生成的频率特性中的每个频率的输入输出增益的学习前的曲线rc1超过了规范模型的理想的输入输出增益的曲线mc1的情况下,赋予负的回报。

[0142]

在超过输入输出增益足够小的频率的区域fb中,即使学习前的输入输出增益的曲线rc1超过了规范模型的理想的虚拟输入输出增益的曲线mc

11

,对稳定性的影响也变小。因此,在区域fb中,如上所述,关于规范模型的输入输出增益,不使用理想的增益特性的曲线mc

11

,而使用一定值的输入输出增益(例如,﹣20db)的直线mc

12

。但是,在学习前的测定出的输入输出增益的曲线rc1超过了一定值的输入输出增益的直线mc

12

的情况下,有可能变得不稳定,因此回报输出部4021赋予负值来作为回报。

[0143]

此外,在调整输入输出增益的增益的情况下,行为信息输出部403调整速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的系数ωc、τ、δ。在滤波器130的特性中,增益和相位根据滤波器130的带宽fw而变化,并且增益和相位根据滤波器130的衰减系数k而变化。因此,行为信息输出部403可通过调整滤波器130的系数来调整输入输出增益的增益。

[0144]

回报输出部4021在最短距离d比半径r小(d<r),奈奎斯特轨迹经过闭合曲线的内侧时赋予了负值的回报的情况下,将该负值的回报输出到价值函数更新部4022。回报输出部4021在最短距离d等于或大于半径r(d≥r),奈奎斯特轨迹未经过圆的内侧时赋予了正值的回报的情况下,将该正值的回报输出到价值函数更新部4022。

[0145]

回报输出部4021在考虑了响应速度的3个例子或者考虑了谐振的例子中赋予了回报的情况下,将对该回报加上在奈奎斯特轨迹未经过圆的内侧时赋予的正值的回报而得到的合计的回报输出到价值函数更新部4022。

[0146]

另外,在对回报进行加法运算的情况下,可以对回报赋予权重。例如,在重视伺服系统的稳定性的情况下,在奈奎斯特轨迹不经过圆的内侧的情况下赋予的正值的回报能够被赋予使重要度比在考虑了响应速度的3个例子或者考虑了谐振的例子中赋予的回报高的权重。

[0147]

以上,对回报输出部4021进行了说明。

[0148]

价值函数更新部4022根据状态s、行为a、将行为a应用于状态s时的状态s

′

以及如上所述求出的回报来进行q学习,由此更新价值函数存储部404存储的价值函数q。

[0149]

价值函数q的更新可以通过在线学习来进行,也可以通过批量学习来进行,还可以通过小批量学习来进行。

[0150]

在线学习是通过将某行为a应用于当前的状态s,每当状态s转移到新的状态s

′

时,立即进行价值函数q的更新的学习方法。另外,批量学习是如下的学习方法:通过反复进行将某行为a应用于当前的状态s,使状态s转移到新的状态s

′

的处理来收集学习用数据,使用收集到的全部学习用数据来进行价值函数q的更新。而且,小批量学习是在线学习与批量学习中间的每当积存了某种程度的学习用数据时进行价值函数q的更新的学习方法。

[0151]

行为信息生成部4023针对当前的状态s,选择q学习过程中的行为a。行为信息生成部4023在q学习过程中,为了进行速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ的修正动作(相当于q学习中的行为a),生成行为信息a并将生成的行为信息a输出到行为信息输出部403。

[0152]

更具体而言,行为信息生成部4023例如针对状态s中包含的速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ,使行为a中包含的速度控制部120的积分增益k1v和比例增益k2v以及滤波器130的传递函数的各系数ωc、τ、δ递增或递减。

[0153]

行为信息生成部4023可以通过将速度控制部120的积分增益k1v和比例增益k2v以及滤波器130的各系数ωc、τ、δ全部修正的方式生成行为信息a,但也可以通过修正一部分系数的方式生成行为信息a。在修正滤波器130的各系数ωc、τ、δ的情况下,例如容易发现产生谐振的中心频率fc,并容易确定中心频率fc。因此,行为信息生成部4023可以为了进行将中心频率fc暂时固定来修正带宽fw和衰减系数δ,即固定系数ωc(=2πfc)来修正系数τ(=fw/fc)和衰减系数δ的动作,生成行为信息a并将生成的行为信息a输出到行为信息输出部403。

[0154]

另外,行为信息生成部4023也可以采取如下对策:通过在当前推定的行为a的价值中选择价值q(s,a)最高的行为a

′

的贪婪算法、或者以某个小的概率ε随机地选择行为a

′

,除此以外选择价值q(s,a)最高的行为a

′

的ε贪婪算法这样的公知的方法来选择行为a

′

。

[0155]

行为信息输出部403将从学习部402输出的行为信息a发送给速度控制部120和滤波器130。如上所述,基于该行为信息对当前状态s,即当前设定的速度控制部120的积分增益k1v和比例增益k2v、和/或各系数ωc、τ、δ进行微修正,由此当前的状态s转移到下一状态s’(即修正后的速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的各系数)。

[0156]

价值函数存储部404是存储价值函数q的存储装置。价值函数q例如也可以按每个状态s、每个行为a作为表(以下,称为行为价值表)来存储。存储在价值函数存储部404中的价值函数q由价值函数更新部4022更新。另外,存储在价值函数存储部404中的价值函数q也可以与其他机器学习部400共享。如果由多个机器学习部400共享价值函数q,则各机器学习部400能够分散地进行强化学习,因此能够提高强化学习的效率。

[0157]

最优化行为信息输出部405基于通过价值函数更新部4022进行q学习而更新的价值函数q,生成用于使速度控制部120以及滤波器130进行价值q(s,a)为最大的动作的行为信息a(以下,称为“最优化行为信息”)。

[0158]

更具体而言,最优化行为信息输出部405取得价值函数存储部404所存储的价值函数q。该价值函数q是如上那样价值函数更新部4022进行q学习而更新后的价值函数。然后,

最优化行为信息输出部405根据价值函数q生成行为信息,并将生成的行为信息输出到速度控制部120和/或滤波器130。在该最优化行为信息中,与行为信息输出部403在q学习过程中输出的行为信息同样地,包含对速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ进行修正的信息。

[0159]

在速度控制部120中,基于该行为信息修正积分增益k1v和比例增益k2v,在滤波器130中,基于该行为信息修正传递函数的各系数ωc、τ、δ。

[0160]

机器学习部400通过以上的动作,进行速度控制部120的积分增益k1v和比例增益k2v和/或滤波器130的传递函数的各系数ωc、τ、δ的最优化,能够以伺服控制部100的稳定裕度成为预定值以上的方式进行动作。

[0161]

另外,机器学习部400通过以上的动作,进行速度控制部120的积分增益k1v和比例增益k2v和/或滤波器130的传递函数的各系数ωc、τ、δ的最优化,能够以伺服控制部100的稳定裕度成为预定的值以上,并且增大反馈增益从而提高响应速度和/或抑制谐振的方式进行动作。

[0162]

如上所述,通过利用本公开的机器学习部400,能够简化速度控制部120的增益以及滤波器130的参数调整。

[0163]

以上,对控制装置10包含的功能块进行了说明。

[0164]

为了实现这些功能块,控制装置10具备cpu(central processing unit:中央处理单元)等运算处理装置。另外,控制装置10还具备存储有应用软件、os(operating system:操作系统)等各种控制用程序的hdd(hard disk drive:硬盘驱动器)等辅助存储装置、用于存储运算处理装置执行程序时暂时所需的数据的ram(random access memory:随机存取存储器)等主存储装置。

[0165]

然后,在控制装置10中,运算处理装置从辅助存储装置读入应用软件、os,一边使读入的应用软件、os在主存储装置中展开,一边进行基于这些应用软件、os的运算处理。另外,基于该运算结果,控制各装置所具备的各种硬件。由此,实现本实施方式的功能块。即,本实施方式能够通过硬件与软件的协作来实现。

[0166]

关于机器学习部400,伴随机器学习的运算量大,例如,若个人计算机搭载gpu(graphics processing units:图形处理单元),通过被称为gpgpu(general-purpose computing on graphics processing units:通用图形处理器)的技术,将gpu用于伴随机器学习的运算处理,则能够高速处理。而且,为了进行更高速的处理,也可以使用多台搭载了这样的gpu的计算机来构建计算机集群,通过该计算机集群中包含的多个计算机来进行并行处理。

[0167]

接着,参照图8的流程图对本实施方式中的q学习时的机器学习部400的动作进行说明。以下说明的流程图对如下动作进行说明:在为了提高伺服系统的稳定性,机器学习部400根据奈奎斯特轨迹是否经过闭合曲线的内侧而赋予回报后,为了提高响应速度以根据截止频率来赋予回报的方式进行学习。

[0168]

在步骤s11中,状态信息取得部401从伺服控制部100和频率生成部200取得初始的状态信息s。将取得的状态信息输出到价值函数更新部4022和行为信息生成部4023。如上所述,该状态信息s是相当于q学习中的状态的信息。

[0169]

最初开始进行q学习的时间点的状态s0下的输入输出增益(振幅比)gs(s0)以及相

位延迟θs(s0)是通过使用频率变化的正弦波即速度指令来驱动伺服控制部100而从频率特性计算部300获得的。将速度指令和检测速度输入到频率特性计算部300,并将从频率特性计算部300输出的输入输出增益(振幅比)gs(s0)以及相位延迟θs(s0)作为初始的状态信息依次输入到状态信息取得部401。速度控制部120的积分增益k1v和比例增益k2v以及滤波器130的传递函数的各系数ωc、τ、δ的初始值预先由用户生成,将积分增益k1v和比例增益k2v以及系数ωc、τ、δ的初始值作为初始的状态信息而发送到状态信息取得部401。

[0170]

在步骤s12中,行为信息生成部4023生成新的行为信息a,并将生成的新的行为信息a经由行为信息输出部403输出至速度控制部120和/或滤波器130。行为信息生成部4023基于上述的对策,输出新的行为信息a。接收到行为信息a的伺服控制部100通过基于接收到的行为信息对与当前状态s有关的速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ进行修正后的状态s

′

,使用频率变化的正弦波即速度指令来驱动电动机150。如上所述,该行为信息是相当于q学习中的行为a的信息。

[0171]

在步骤s13中,状态信息取得部401取得新的状态s

′

下的输入输出增益(振幅比)gs(s

′

)和相位延迟θs(s

′

)、速度控制部120的积分增益k1v和比例增益k2v以及滤波器130的传递函数的各系数ωc、τ、δ,来作为新的状态信息。将取得的新的状态信息输出至回报输出部4021。

[0172]

在步骤s14中,回报输出部4021根据从频率特性计算部300输出的输入输出增益(振幅比)和相位延迟的数据,求出开环频率特性h(jω)。然后,回报输出部4021通过在复平面上描绘开环频率特性h(jω)来生成奈奎斯特轨迹。回报输出部4021在复平面上生成在内侧包含(﹣1,0)且经过实轴上的增益裕度和单位圆上的相位裕度的闭合曲线,判断最短距离d小于半径r(d<r)还是(d≥r)。

[0173]

在步骤s14中,回报输出部4021判断为最短距离d小于半径r的情况下(d<r),在步骤s15中,回报输出部4021将回报设为负的值,并返回到步骤s12。

[0174]

在步骤s14中,回报输出部4021判断为最短距离d与半径r相等或比半径r大的情况下(d≥r),在步骤s16中,回报输出部4021将回报设为零的值,并转移到步骤s17。

[0175]

在步骤s17中,回报输出部4021判断截止频率fcut的大小关系,即截止频率fcut变大、相同还是变小。将状态s时的截止频率fcut记载为fcut(s),将状态s

′

时的截止频率fcut记载为fcut(s

′

)。

[0176]

在步骤s17中,回报输出部4021判断为截止频率fcut(s

′

)>截止频率fcut(s)时,在步骤s18中,回报输出部4021赋予正值的回报。

[0177]

在步骤s17中,回报输出部4021判断为截止频率fcut(s

′

)=截止频率fcut(s)时,在步骤s19中,回报输出部4021给予零值的回报。

[0178]

在步骤s17中,回报输出部4021判断为截止频率fcut(s

′

)<截止频率fcut(s)时,在步骤s20中,回报输出部4021给予负值的回报。

[0179]

当步骤s18、步骤s19和步骤s20中的任意一个步骤结束时,在步骤s21中,回报输出部4021将在步骤s16中赋予的回报与在步骤s18、步骤s19和步骤s20中的任意一个步骤中赋予的回报相加。

[0180]

接着,在步骤s22中,价值函数更新部4022根据在步骤s21中计算出的合计回报的值,更新在价值函数存储部404中存储的价值函数q。然后,再次返回到步骤s12重复上述处

理,由此价值函数q收敛到适当的值。也可以将上述处理重复了预定次数或重复了预定时间作为条件来结束处理。

[0181]

此外,步骤s22例示了在线更新,但也可以代替在线更新而置换为批量更新或者小批量更新。

[0182]

通过以上参照图8说明的动作,在本实施方式中,起到如下效果:通过利用机器学习部400,能够得到用于调整速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ的适当的价值函数,能够简化速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ的最优化。

[0183]

接着,参照图9的流程图对最优化行为信息输出部405生成最优化行为信息时的动作进行说明。

[0184]

首先,在步骤s23中,最优化行为信息输出部405取得在价值函数存储部404中存储的价值函数q。价值函数q是如上那样价值函数更新部4022进行q学习而更新后的价值函数。

[0185]

在步骤s24中,最优化行为信息输出部405根据该价值函数q生成最优化行为信息,并将所生成的最优化行为信息输出到速度控制部120和/或滤波器130。

[0186]

另外,通过参照图9说明的动作,在本实施方式中,根据由机器学习部400进行学习而求出的价值函数q来生成最优化行为信息,根据该最优化行为信息,能够简化当前设定的速度控制部120的积分增益k1v和比例增益k2v、和/或滤波器130的传递函数的各系数ωc、τ、δ的调整,并且能够实现伺服控制部100的稳定,并能够提高响应速度。

[0187]

另外,使用上述的图8以及图9说明的动作为了提高伺服系统的稳定性,根据奈奎斯特轨迹是否经过闭合曲线的内侧来给予回报,之后通过提高响应速度的上述方法(1)根据截止频率来给予回报,但在本实施方式中,为了提高响应速度,也可以使用根据闭环特性来决定回报的方法(2)或者以最短距离d接近半径r的方式来决定回报的方法(3)。

[0188]

另外,在本实施方式中,为了提高伺服系统的稳定性,根据奈奎斯特轨迹是否经过闭合曲线的内侧来给予回报之后,可以如在上述的考虑了谐振的例子中说明的那样,为了抑制谐振而采用通过开环特性与规范模型的比较来决定回报的方法。

[0189]

上述控制装置所包含的各构成部能够通过硬件、软件或者它们的组合来实现。另外,通过上述控制装置所包含的各结构部的协作来进行的伺服控制方法也能够通过硬件、软件或者它们的组合来实现。在此,通过软件实现是指通过由计算机读入并执行程序来实现。

[0190]

程序能够使用各种类型的非暂时性的计算机可读介质(non-transitory computer readable medium)来存储,并提供给计算机。非暂时性的计算机可读介质包括各种类型的有实体的记录介质(tangible storage medium)。作为非暂时性的计算机可读介质的例子,包括磁记录介质(例如,硬盘驱动器)、光磁记录介质(例如,光磁盘)、cd-rom(只读存储器)、cd-r、cd-r/w和半导体存储器(例如,掩模rom、prom(可编程rom)、eprom(可擦除prom)、闪存rom和ram(随机存取存储器))。另外,程序也可以通过各种类型的暂时性的计算机可读介质(transitory computer readable medium)提供给计算机。

[0191]

上述的实施方式是本发明的优选实施方式,但本发明的范围并不仅限于上述实施方式,在不脱离本发明的主旨的范围内能够以实施了各种变更的方式来实施。

[0192]

在上述实施方式中,对设置了1个滤波器的情况进行了说明,但也可以将分别与不

同的频段对应的多个滤波器串联连接来构成滤波器130。图10是表示将多个滤波器串联连接而构成滤波器的例子的框图。在图10中,在存在m个(m为2以上的自然数)谐振点的情况下,滤波器130通过将m个滤波器130-1~130-m串联连接而构成。针对m个滤波器130-1~130-m各自的系数ωc、τ、δ,通过机器学习求出最优值。

[0193]

另外,关于控制装置的结构,除了图1的结构以外还具有以下的结构。

[0194]

《机器学习部设置在伺服控制部外部的变形例》

[0195]

图11是表示控制装置的另一结构例的框图。图11所示的控制装置10a与图1所示的控制装置10的不同点在于,n(n为2以上的自然数)个伺服控制部100-1~100-n经由网络500与n个机器学习部400-1~400-n连接,以及伺服控制部100-1~100-n分别具备频率生成部200和频率特性计算部300。机器学习部400-1~400-n具有与图2所示的机器学习部400相同的结构。伺服控制部100-1~100-n分别对应于伺服控制装置,另外,机器学习部400-1~400-n分别对应于机器学习装置。当然也可以将频率生成部200和频率特性计算部300中的一方或双方设置在伺服控制部100-1~100-n外。

[0196]

在此,使伺服控制部100-1和机器学习部400-1为1对1的组,以可通信的方式连接。对于伺服控制部100-2~100-n和机器学习部400-2~400-n,也与伺服控制部100-1和机器学习部400-1同样地连接。在图11中,伺服控制部100-1~100-n和机器学习部400-1~400-n的n个组经由网络500连接,但在伺服控制部100-1~100-n和机器学习部400-1~400-n的n个组中,各组的伺服控制部和机器学习部可以经由连接接口直接连接。关于这些伺服控制部100-1~100-n和机器学习部400-1~400-n的n个组,例如可以在相同的工厂中设置多组,也可以分别设置在不同的工厂中。

[0197]

此外,网络500例如是在工厂内构建的lan(local area network:局域网)、因特网、公共电话网、或者它们的组合。关于网络500中的具体的通信方式、或者是有线连接以及无线连接中的哪一个等,没有特别限定。

[0198]

《系统结构的自由度》

[0199]

在上述的实施方式中,将伺服控制部100-1~100-n和机器学习部400-1~400-n分别设为1对1的组并以可通信的方式连接,但例如也可以将1台机器学习部经由网络500与多个伺服控制部可通信地连接,实施各伺服控制部的机器学习。

[0200]

此时,也可以设为将1台机器学习部的各功能适当地分散到多个服务器的分散处理系统。另外,也可以在云上利用虚拟服务器功能等来实现1台机器学习部的各功能。

[0201]

另外,也可以构成为在存在分别与n台相同的型号名称、相同规格、或者同一系列的伺服控制部100-1~100-n对应的n个机器学习部400-1~400-n的情况下,控制装置10a共享各机器学习部400-1~400-n中的学习结果。由此,能够构筑更优的模型。

[0202]

本公开的机器学习装置、控制装置以及机器学习方法包括上述的实施方式,能够采取具有如下结构的各种实施方式。

[0203]

(1)一种机器学习装置(例如,机器学习部400),其设置在控制电动机(例如,电动机150)的伺服控制装置(例如,伺服控制部100)中,进行使至少1个滤波器(例如,滤波器130)的系数与反馈增益中的至少一方最优化的机器学习,所述机器学习装置具备:

[0204]

状态信息取得部(例如,状态信息取得部401),其取得状态信息,该状态信息包含所述滤波器的系数和所述反馈增益中的至少一方、以及所述伺服控制装置的输入输出增益

和输入输出的相位延迟;

[0205]

行为信息输出部(例如,行为信息输出部403),其输出行为信息,该行为信息包含所述状态信息中包含的所述系数和所述反馈增益中的至少一方的调整信息;

[0206]

回报输出部(例如,回报输出部4021),其基于根据所述输入输出增益和所述输入输出的相位延迟计算出的奈奎斯特轨迹是否经过闭合曲线的内侧来求出回报并输出,所述闭合曲线在内侧包含复平面上的(-1,0),且经过预定的增益裕度和相位裕度;以及

[0207]

价值函数更新部(价值函数更新部4022),其根据由所述回报输出部输出的回报的值、所述状态信息以及所述行为信息来更新价值函数。

[0208]

根据该机器学习装置,能够考虑相位裕度和增益裕度双方来调整反馈增益与滤波器的系数中的至少一方,能够提高伺服系统的稳定度。

[0209]

(2)根据上述(1)所述的机器学习装置,所述回报输出部根据所述闭合曲线与所述奈奎斯特轨迹之间的距离来求出回报并输出。

[0210]

(3)根据上述(1)或(2)所述的机器学习装置,所述闭合曲线是圆。

[0211]

(4)根据上述(1)~(3)中的任意一项所述的机器学习装置,所述回报输出部输出对所述回报加上根据截止频率计算出的回报而得到的合计回报。

[0212]

根据该机器学习装置,能够增大反馈增益来提高响应速度。

[0213]

(5)根据上述(1)~(3)中的任意一项所述的机器学习装置,所述回报输出部输出对所述回报加上根据闭环特性计算出的回报而得到的合计回报。

[0214]

根据该机器学习装置,能够增大反馈增益来提高响应速度。

[0215]

(6)根据上述(1)至(3)中的任意一项所述的机器学习装置,所述回报输出部输出对所述回报加上通过所述输入输出增益与预先计算出的成为规范的增益的比较而计算出的回报而得到的合计回报。

[0216]

根据该机器学习装置,能够抑制谐振。

[0217]

(7)根据上述(1)至(6)中的任意一项所述的机器学习装置,由频率特性计算装置(例如,频率特性计算部300)计算所述输入输出增益和所述输入输出的相位延迟,

[0218]

所述频率特性计算装置使用频率变化的正弦波的输入信号和所述伺服控制装置的速度反馈信息,计算所述输入输出增益和所述输入输出的相位延迟。

[0219]

(8)根据上述(1)至(7)中的任意一项所述的机器学习装置,其中,所述机器学习装置具备:最优化行为信息输出部(例如,最优化行为信息输出部405),其根据由所述价值函数更新部更新后的价值函数,输出所述系数以及所述反馈增益中的至少一方的调整信息。

[0220]

(9)一种控制装置,其具备:

[0221]

上述(1)至(8)中的任意一项所述的机器学习装置(机器学习部400);

[0222]

控制电动机的伺服控制装置(例如,伺服控制部100),其具有至少一个滤波器以及设定反馈增益的控制部(例如,速度控制部120);以及

[0223]

频率特性计算装置(例如频率特性计算部300),其计算所述伺服控制装置中的所述伺服控制装置的输入输出增益和输入输出的相位延迟。

[0224]

根据该控制装置,能够考虑相位裕度和增益裕度这两者来调整反馈增益和滤波器的系数中的至少一方,能够提高伺服系统的稳定度。

[0225]

(10)一种机器学习装置(例如,机器学习部400)的机器学习方法,该机器学习装置

设置在控制电动机(例如,电动机150)的伺服控制装置(例如,伺服控制部100)中,进行使至少一个滤波器(例如,滤波器130)的系数与反馈增益中的至少一方最优化的机器学习,在所述机器学习方法中,

[0226]

取得状态信息,该状态信息包含所述滤波器的系数和所述反馈增益中的至少一方、以及所述伺服控制装置的输入输出增益和输入输出的相位延迟;

[0227]

输出行为信息,该行为信息包含所述状态信息中包含的所述系数和所述反馈增益中的至少一方的调整信息;

[0228]

基于根据所述输入输出增益和所述输入输出的相位延迟计算出的奈奎斯特轨迹是否通过闭合曲线的内侧来求出回报并输出,所述闭合曲线在内侧包含复平面上的(﹣1,0),且经过预定的增益裕度和相位裕度;以及

[0229]

根据所述回报的值、所述状态信息以及所述行为信息来更新价值函数。

[0230]

根据该机器学习方法,能够考虑相位裕度和增益裕度双方来调整反馈增益和滤波器的系数中的至少一方,能够提高伺服系统的稳定度。

[0231]

附图标记的说明

[0232]

10、10a 控制装置

[0233]

100、100-1~100-n 伺服控制部

[0234]

110 减法器

[0235]

120 速度控制部

[0236]

130 滤波器

[0237]

140 电流控制部

[0238]

150 电动机

[0239]

200 频率生成部

[0240]

300 频率特性计算部

[0241]

400、400-1~400-n 机器学习部

[0242]

401 状态信息取得部

[0243]

402 学习部

[0244]

403 行为信息输出部

[0245]

404 价值函数存储部

[0246]

405 最优化行为信息输出部

[0247]

500 网络。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。