1.本发明属于城市轨道交通运输调度领域,具体涉及一种列车运行方案调整方法、装置、电子设备及存储介质。

背景技术:

2.城市轨道交通调度是城市轨道交通的重要组成部分,通过计算机实现轨道交通的信息化和自动化是当前的轨道交通发展的重点和难点。并且轨道交通运输的调度问题,是一个复杂的,大规模,多参数的优化问题,目前,在相关调度模型的建立和求解上都存在空缺和局限,并且在实际应用到生产环境方面,还缺少令人满意的解决方法。因此,本发明对城市轨道交通运行方案的优化,在实际应用方面和理论研究方面都有广泛的前景。

3.目前关于城市轨道调度方案主要有:(1)启发式算法。该算法通过粒子群算法,元胞自动机等模拟仿真算法,求得问题近似解。(2)严格数学模型。该算法通过搭建数学模型,进而来设计城市轨道交通的调度方案。

4.上述方案都存在一定的局限性,启发式算法等模拟仿真算法,虽然仿真效果很好,但是很容易陷入局部最优,并且对于城市轨道交通应用场景,存在大规模的人群需要进行模拟,搜索效率过低。严格的数学模型,虽然可以以精确的算法得出准确的结果,但是在算法设计过程中,很容易出现遗漏,难以设计出一个满足复杂且多参数的精确模型。

技术实现要素:

5.为了解决上述背景技术提到的技术问题,本发明提出了一种列车运行方案调整方法、装置、电子设备及存储介质。

6.为了实现上述技术目的,本发明的技术方案为:

7.一种基于深度强化学习的列车运行方案调整方法,包括以下步骤:

8.s1,从轨道交通自动售检票系统中获取乘客进、出站站点及时间,以进站时间为基准按粒度提取并构建客流od矩阵;

9.s2,设计对抗神经网络,利用s1中构建的客流od矩阵训练对抗神经网络,生成不同时段od客流矩阵;

10.s3,根据步骤s2生成的不同时段od客流矩阵,生成所有乘客的路径,所述路径包括乘客的进站时间、进站站点、出站站点,以及所选择的乘车线路和换乘站站点;

11.s4、设计城市轨道交通线网仿真模型,将s3中的乘客路径、列车时刻表方案输入线网仿真模型中,模拟乘客、列车、站点在城市轨道交通系统内的运行,统计城市轨道交通系统运行状态,包括线网中各站点站台等待乘客人数、等待时间和列车在各时间段内的运载率;

12.s5、设计列车运行调度方案深度强化学习模型,利用s4的城市轨道交通线网仿真模型训练深度强化学习模型;

13.s6、利用步骤s5中训练完成的深度强化学习模型,生成新的列车运行调度方案。

14.优选地,所述步骤s1中的粒度选择五分钟或十分钟或半小时。

15.优选地,所述步骤s2中的对抗神经网络包括一个生成器和一个判别器。其中,生成器的输入范围是0-1的小数,对应一天的零点到24点;生成器输出客流od矩阵;判别器用于判断输入的od矩阵是否是真实的客流od矩阵还是生成器生成的客流od矩阵,判别器还用于判断输入的od矩阵对应的时间。

16.优选地,所述步骤s3中具体包括:

17.s31,在od客流矩阵基础上,以泊松概率分布生成每个乘客的进站时间,泊松概率分布为:

[0018][0019]

其中t为非负整数,表示乘客的进站偏移时间,其值加上对应od矩阵的起始时间就是乘客的进站时间,p(t)为乘客进站概率,λ为乘客进站的数量,即od客流矩阵中对应车站的值,e为自然底数;

[0020]

s32,生成每个乘客的进站时间后,利用logit模型每一个乘客分配路径:

[0021][0022]

其中为表示乘客的在od对rs选择路径k的概率,k

rs

表示od对rs间的所有可选路径,表示od对rs间路径k的出行费用,θ放映的是乘客对城市轨道交通网络的熟悉程度。

[0023]

优选地,所述步骤s4中城市轨道交通线网仿真模型包括乘客、车站、列车的仿真交互,具体包括:

[0024]

依据步骤s3中的进站时间模拟乘客进入站点,利用正态分布模拟乘客由进站通道到达站台候车的时间,正态分布f(y)公式表达如下:

[0025][0026]

其中μ

ci

和σ

ci

为进站通道ci的步行时间的均值和方差;

[0027]

依据设定好的列车时刻表,模拟从起始站点开始,模拟列车一次通过各车站,列车每次到达车站时,需要模拟乘客的下车和上车过程;乘客的下车需要结合乘客的路径进行判断,乘客的上车需要依据列车方向、列车人数、乘客路径判断乘客是否能够上车,不能上车的乘客继续在站台候车;

[0028]

乘客从列车下来后,依据乘客路径中的目的站点,若乘客到达目的站点,则利用利用正态分布(μ

co

,σ

co

)模拟乘客由出站通道出站的时间;否则,利用正态分布(μ

ct

,σ

ct

)模拟乘客经由换乘通道到达下一列车的候车站台;

[0029]

城市轨道交通线网仿真过程中,需要计算各车站的候车乘客数和拥挤状态、各类通道乘客数、列车载客数、列车满载率以及各乘客的候车时间。

[0030]

优选地,所述步骤s5中具体包括:

[0031]

s51,基于为advantage actor-critic方法设计用于列车运行时刻表优化的深度强化学习模型,包括一个策略网络π(a|s;θ),用于控制列车时刻表,具体动作包括提前或者

延迟列车发车时间,还设有一个价值网络v(s;w),用于评估城市轨道交通状态,其评分可以帮助策略网络改进性能;

[0032]

s52,将城市轨道交通状态s

t

作为策略网络模型π(a|s;θ)的输入,模型的输出为列车动作a

t

,即调整了列车运行时刻表;

[0033]

s53,利用s4中获得的线网仿真模型,获得乘客在当前运行时刻表下的等待时间和换乘等待时间,并利用下述奖励函数,得到此列车运行时刻表的奖励值,公式表达如下:

[0034]

r=ω1f1 ω2f2[0035]

其中r为奖惩值,f1和f2分别表示进站乘客和换乘乘客的等待时间评估分,ω1和ω2为权重值;

[0036]

对于进站乘客,所述时间评估分表示为:

[0037][0038]

其中n为调整时间段内的所有进站乘客数量,为调整时间段内第i个进站乘客的上车时刻,为调整时间段内第i个进站乘客的进站时刻,为调整时间段内第i个进站乘客由进站闸机到站台的步行时间;

[0039]

对于换乘乘客,所述时间评估分表示为:

[0040][0041]

其中m为调整时间段内的所有换乘乘客数量,为调整时间段内第i个换乘乘客在换乘站的上车时刻,为调整时间段内第i个换乘乘客在换乘站下车时刻,为调整时间段内第i个换乘乘客在换乘通道的步行时间;

[0042]

s54,从仿真模型中获取奖励r

t

和新的状态s

t 1

;

[0043]

s55,利用价值网络对城市轨道交通运行状态进行评估和

[0044]

s56,计算td目标和td误差

[0045]

s57,更新价值网络,公式表达如下:

[0046][0047]

s58,更新策略网络,公式表达如下:

[0048][0049]

s59,不断重复s52至s58,直至该模型整体收敛,得到更新后的列车运行时刻表。

[0050]

一种基于深度强化学习的列车运行方案调整方法的装置,包括:

[0051]

乘客处理模块,其被配置用于根据乘客进、出站站点及时间生成所有乘客的路径,所述路径包括乘客的进站时间、进站站点、出站站点,以及所选择的乘车线路和换乘站站点;

[0052]

环境交互模块,其包括两种模式,一是仿真模式,即将生成的乘客路径、列车时刻

表方案输入线网仿真模型中,模拟乘客、列车、站点在城市轨道交通系统内的运行,二是实时模式,即利用接口接入真实城市轨道交通的运行状态,展示或推演城市轨道交通的运行。两种模式下,该模块均可统计城市轨道交通系统运行状态,包括线网中各站点站台等待乘客人数、等待时间和列车在各时间段内的运载率;

[0053]

列车调整模块,其被配置用于根据得到的乘客、列车、站点在城市轨道交通系统内的运行状态,生成新的列车运行调度方案。

[0054]

一种电子设备,包括:存储器和处理器,所述存储器存储由所述处理器可执行的计算机程序,所述处理器执行所述计算机程序时实现上述的列车运行方案调整方法。

[0055]

一种存储介质,所述存储介质上存储有计算机程序,所述计算机程序被读取并执行时,实现上述的列车运行方案调整方法。

[0056]

采用上述技术方案带来的有益效果:

[0057]

本发明采用基于policy-based的深度强化学习模型,使用深度神经网络,对函数π(a|s)进行拟合,得到在每个不同state下最优action方案选择网络。该网络的输入参数为列车运行时刻表,网络的输出为调整过后的时刻表。为了最大化return,模型采用gradient ascent梯度上升方法,对深度强化模型进行训练。

附图说明

[0058]

图1为本发明中一种基于深度强化学习的列车运行方案调整系统实施流程图;

[0059]

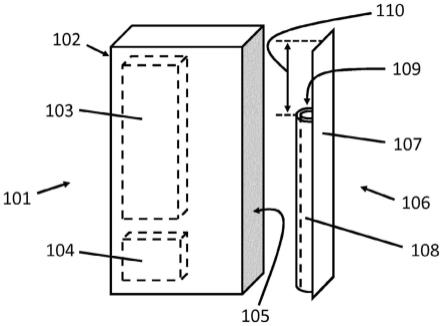

图2为本发明中城市轨道交通列车运行方案系统组成。

具体实施方式

[0060]

以下将结合附图,对本发明的技术方案进行详细说明。

[0061]

本发明公开了一种基于深度强化学习的列车运行方案调整方法,如图1所示,具体步骤如下:

[0062]

s1,从轨道交通自动售检票系统中获取乘客进、出站站点及时间,以进站时间为基准按粒度提取并构建客流od矩阵。

[0063]

s2,设计对抗神经网络,包括一个生成器和一个判别器。其中,生成器的输入范围是0-1的小数,对应一天的零点到24点;生成器输出客流od矩阵;判别器用于判断输入的od矩阵是否是真实的客流od矩阵还是生成器生成的客流od矩阵,以及输入的od矩阵对应的时间。利用s1中构建的客流od矩阵训练对抗神经网络,生成不同时段od客流矩阵。

[0064]

s3,根据步骤s2生成的不同时段od客流矩阵,生成所有乘客的路径,所述路径包括乘客的进站时间、进站站点、出站站点,以及所选择的乘车线路和换乘站站点;进站时间以泊松概率分布生成,具体详细的路径则在可选路径中由logit模型进行分配。

[0065]

s4、设计城市轨道交通线网仿真模型,将s3中的乘客路径、列车时刻表方案输入线网仿真模型中,模拟乘客、列车、站点在城市轨道交通系统内的运行,统计城市轨道交通系统运行状态,包括线网中各站点站台等待乘客人数、等待时间和列车在各时间段内的运载率。

[0066]

s5、设计列车运行调度方案深度强化学习模型,利用s4的城市轨道交通线网仿真模型训练深度强化学习模型。

[0067]

s51,基于为advantage actor-critic(缩写a2c)方法设计用于列车运行时刻表优化的深度强化学习模型,包括一个策略网络π(a|s;θ),相当于演员,用于控制列车时刻表,具体动作包括提前或者延迟列车发车时间,还有一个价值网络v(s;w),相当于评委,用于评估城市轨道交通状态,其评分可以帮助策略网络(演员)改进性能;

[0068]

s52,将城市轨道交通状态s

t

作为策略网络模型π(a|s;θ)的输入,模型的输出为列车动作a

t

,即调整了列车运行时刻表;

[0069]

s53,利用s4中获得的线网仿真模型,获得乘客在当前运行时刻表下的等待时间和换乘等待时间,并利用下述奖励函数,得到此列车运行时刻表的奖励值,公式表达如下:

[0070]

r=ω1f1 ω2f2[0071]

其中r为奖惩值,f1和f2分别表示进站乘客和换乘乘客的等待时间评估分,ω1和ω2为权重值;

[0072]

对于进站乘客,所述时间评估分表示为:

[0073][0074]

其中n为调整时间段内的所有进站乘客数量,为调整时间段内第i个进站乘客的上车时刻,为调整时间段内第i个进站乘客的进站时刻,为调整时间段内第i个进站乘客由进站闸机到站台的步行时间;

[0075]

对于换乘乘客,所述时间评估分表示为:

[0076][0077]

其中m为调整时间段内的所有换乘乘客数量,为调整时间段内第i个换乘乘客在换乘站的上车时刻,为调整时间段内第i个换乘乘客在换乘站下车时刻,为调整时间段内第i个换乘乘客在换乘通道的步行时间;

[0078]

s54,从仿真模型中获取奖励r

t

和新的状态s

t 1

;

[0079]

s55,利用价值网络对城市轨道交通运行状态进行评估和

[0080]

s56,计算td目标和td误差

[0081]

s57,更新价值网络

[0082][0083]

s58,更新策略网络

[0084][0085]

s59,不断重复s52至s58,直至该模型整体收敛,得到更新后的列车运行时刻表;

[0086]

s6、利用步骤s5中训练完成的深度强化学习模型,依据列车资源限制、乘客需求、城市轨道交通运行装填等生成新的列车运行调度方案。

[0087]

实施例仅为说明本发明的技术思想,不能以此限定本发明的保护范围,凡是按照

本发明提出的技术思想,在技术方案基础上所做的任何改动,均落入本发明保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。