1.本发明涉及计算机视觉技术领域,具体涉及一种视频面签中人脸微表情识 别方法、装置、设备和存储介质。

背景技术:

2.随着消费观念的改变,信贷业务量剧增,需要对信贷的各个环节进行审批, 需要核实用户身份,现有的面签审核方式是面审员与借款人通过全线上视频进 行面签,面审员通过审核借款人提供的面签视频进行风险评估。

3.然而,通过全线上视频进行面签,在业务量巨大的情况下,面审员对客户 的面签视频进行审核时,不能准确的察觉到客户的表情变化,从而不能准确把 控风险,增加了坏帐的可能性。

技术实现要素:

4.本发明实施例提供一种视频面签中人脸微表情识别方法、装置、设备和存 储介质,以提高现有面签审核中表情识别的准确度。

5.一方面,本技术实施例提供一种视频面签中人脸微表情识别方法,所述方 法包括:

6.获取视频中每一帧人脸图像对应的低分辨率图像和高分辨率图像;

7.对所述低分辨率图像和所述高分辨率图像分别进行特征提取,得到所述低 分辨率图像对应的低分辨率特征图以及所述高分辨率图像对应的高分辨率特 征图;

8.根据所述低分辨率特征图和所述高分辨率特征图,确定得到关键点特征图;

9.根据所述关键点特征图,确定所述人脸图像的人脸表情识别结果;

10.根据所述人脸图像的人脸表情识别结果,确定视频面签风险评估结果。

11.另一方面,本技术实施例提供一种视频面签中人脸微表情识别装置,所述 装置包括:

12.分解模块,用于获取视频中每一帧人脸图像对应的低分辨率图像和高分辨 率图像;

13.特征提取模块,用于对所述低分辨率图像和所述高分辨率图像分别进行特 征提取,得到所述低分辨率图像对应的低分辨率特征图以及所述高分辨率图像 对应的高分辨率特征图;

14.特征图提取模块,用于对所述低分辨率特征图和所述高分辨率特征图进行 注意力特征提取,得到关键点特征图;

15.识别模块,用于将根据所述关键点特征图,确定所述人脸图像的人脸表情 识别结果;

16.评估模块,用于根据所述人脸图像的人脸表情识别结果,确定视频面签风 险评估结果。

17.另一方面,本技术实施例提供一种视频面签中人脸微表情识别设备,包括 存储器和处理器;所述存储器存储有应用程序,所述处理器用于运行所述存储 器内的应用程序,以执行所述的视频面签中人脸微表情识别方法中的操作。

18.另一方面,本技术实施例提供一种存储介质,所述存储介质存储有多条指 令,所述指令适于处理器进行加载,以执行所述的视频面签中人脸微表情识别 方法中的步骤。

19.本发明实施例获取视频中每一帧人脸图像对应的低分辨率图像和高分辨 率图像;对低分辨率图像和高分辨率图像分别进行特征提取,得到低分辨率图 像对应的低分辨率特征图以及高分辨率图像对应的高分辨率特征图;根据低分 辨率特征图和高分辨率特征图,确定得到关键点特征图;根据关键点特征图, 确定人脸图像的人脸表情识别结果;根据人脸图像的人脸表情识别结果,确定 视频面签风险评估结果;本技术实施例通过低分辨率图像和高分辨率图像得到 关键点特征图,提高人脸关键点检测的准确率,抗干扰能力强,如此,通过关 键点特征图确定人脸表情识别结果,提高表情识别结果的准确度。

附图说明

20.为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所 需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明 的一些实施例,对于本领域技术人员来讲,在不付出创造性劳动的前提下,还 可以根据这些附图获得其他的附图。

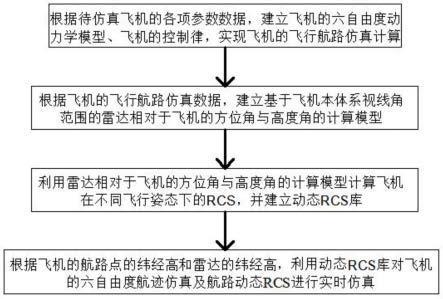

21.图1是本发明实施例提供的视频面签中人脸微表情识别方法的应用场景;

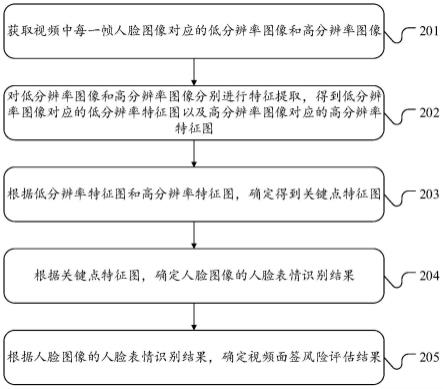

22.图2是本发明实施例提供的视频面签中人脸微表情识别方法的流程示意图;

23.图3是本发明实施例提供的微表情识别网络的结构示意图;

24.图4是本发明实施例提供的微表情识别网络中关键点提取层的结构示意图;

25.图5是本发明实施例提供的视频面签中人脸微表情识别装置的结构示意图;

26.图6是本发明实施例提供的视频面签中人脸微表情识别设备的结构示意图。

具体实施方式

27.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清 楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是 全部的实施例。基于本发明中的实施例,本领域技术人员在没有作出创造性劳 动前提下所获得的所有其他实施例,都属于本发明保护的范围。

28.请参阅图1,图1是本技术实施例提供的视频面签中人脸微表情识别方法的 应用场景,图1所示的仅为可以应用本发明实施例提供的应用场景的示意,以 帮助本领域技术人员了解本发明的技术内容,但不意味着本发明实施例不可以 应用其他设备、系统、环境或场景。

29.如图1所示,本技术实施例提供的应用场景包括服务器101、网络102、第 一终端设备103和第二终端设备104。

30.其中,网络102可以在服务器101、第一终端设备103和第二终端设备104 之间提供通信链路的介质。网络102可以是因特网,也可以是任何网络,包括 但不限于广域网、城域网、区域网、第三代合作伙伴计划(3rd generationpartnership project,3gpp)、长期演

进(long term evolution lte)、全球互通 微波访问(worldwide interoperability for microwave access wimax)的移动通 信,或基于tcp/ip协议族(tcp/ipprotocol suite tcp/ip)、用户数据报协议(userdatagram protocol udp的计算机网络通信等。

31.用户可以使用第二终端设备104通过第一终端设备103通过网络102与服务 器101交互,发送面签视频至服务器101等,服务器101根据上传的面签视频进 行视频面签中人脸微表情识别,得到视频面签风险评估结果,并将视频面签风 险评估结果通过网络102返回至第二终端设备104;工作人员可以使用第二终端 设备104分别与第一终端设备103和服务器101进行交互,例如访问服务器101 进行数据查询,返回面签审核结果至第一终端设备103等。可以理解的是,在 对视频面签中人脸微表情识别中,服务器101可以对一个或多个终端设备发送 的面签视频进行表情识别。

32.第一终端设备103和第二终端设备104可以是具有显示功能的各种电子设 备,以向用户、工作人员展示视频面签风险评估结果,其包括但不限于计算机、 pc端、便携式计算机、平板电脑、智能手机等。

33.服务器101可以是提供各种服务的服务器,例如对用户利用第一终端设备 103所进行视频面签提供支持的后台管理服务器。后台管理服务器可以对接收 到的面签视频进行表情识别,根据表情识别结果确定视频面签风险评估结果, 并将视频面签风险评估结果发送至第二终端设备104以及将面签审核结果返回 至第一终端103。

34.应该理解的是,图1示出的第一终端设备103、第二终端设备104、网络102 和服务器101的数目和连接方式仅仅是示意性,根据实际应用场景,可以有任 意数目的第一终端设备103、第二终端设备104、网络102和服务器101。

35.请参阅图2,图2是本技术实施例提供的视频面签中人脸微表情识别方法的 流程示意图,所示的视频面签中人脸微表情识别方法包括步骤201~205:

36.201,获取视频中每一帧人脸图像对应的低分辨率图像和高分辨率图像。

37.视频可以是用户提交的面签视频,也可以是从用户提交的面签视频中提取 出的多帧人脸图像组成的视频。

38.在本技术一些实施例中,在接收到用户提交的面签视频后,可以将面签视 频划分为多组帧图像,将每一组帧图像设置为视频。在本技术一些实施例中, 可以从面签视频的第一帧图像开始每间隔预设帧数,提取出一组帧图像,得到 多组帧图像,其中,预设帧数可以是10、20或30。

39.在本技术一些实施例中,在接收到用户提交的面签视频后,可以进行抽帧 处理,从面签视频提取出多帧图像,将提取出的多帧图像设置为视频。在本申 请一些实施例中,在接收到用户提交的面签视频后,从面签视频的第一帧图像 开始逐帧进行人脸检测,确定面签视频的每一帧图像是否都存在人脸;若面签 视频的每一帧图像都存在人脸,则将该面签视频设置为视频;若面签视频中存 在检测不到人脸的帧图像时,则将该面签视频中不存在人脸的帧图像从面签视 频中剔除,将剔除不存在人脸的帧图像后的面签视频设置为视频。在本技术一 些实施例中,在接收到用户提交的面签视频后,对面签视频中的每一帧图像进 行人脸检测,以首张检测到人脸的帧图像为起始帧图像,从面签视频中提取出 存在人脸的多帧图像,将提取出的存在人脸的多帧图像设置为视频。

40.低分辨率图像可以是对该帧人脸图像进行图像退化处理后,得到人脸图像, 也可

以是该帧人脸图像。高分辨率图像可以是对该帧人脸图像进行超分辨率重 建得到的图像。图像退化处理可以是图像模糊处理、图像平滑处理、图像降采 样处理中的一种或多种。在本技术一些实施例中,受到面签视频的采集设备以 及采集环境的影响,采集到的面签视频中图像的存在成像模糊、边缘模糊的问 题,使得获得的视频中人脸图像中可能缺失精细化的纹理特征,这就使得后续 在微表情视频中,不能准确识别出人脸表情,进而影响视频面签风险评估结果。 因此,可以对视频的每一帧人脸图像进行超分辨率重建,得到高分辨率图像, 以克服或补偿由于图像采集系统或采集环境本身的限制,导致的人脸图像模糊、 质量低下、感兴趣区域不显著等问题,同时考虑到高分辨率图像对于图像局部 纹理细节特征具有更好的表现能力,但是受到高分辨率图像数据量较大的影响, 可能提取图像结构特征、色彩特征、对比度等图像全局特征时,计算量较大, 影响视频面签中人脸微表情识别方法的识别效率,而低分辨率图像的图像结构 特征、色彩特征、对比度等图像全局特征与高分辨率图像的图像全局特征时相 似的,因此为了提高视频面签中人脸微表情识别方法的识别效率同时提高人脸 微表情识别中的识别准确度,可以分别对低分辨率图像和高分辨率图像进行特 征提取,并通过将低分辨率图像和高分辨率图像各自提取的特征进行融合,进 而可以提取出更多的人脸图像的图像特征,从而使得人脸表情识别结果的更加 准确。因此,本技术实施例对每一帧人脸图像,通过图像退化处理获取该帧人 脸图像对应的低分辨率图像,并通过超分辨率图像重建得到该帧人脸图像对应 的高分辨率图像。

41.在本技术一些实施例中,存在多种方式获取该帧人脸图像对应的高分辨率 图像,具体地包括:

42.(1)可以通过预定义的变换函数或者预设插值对该帧人脸图像中的每个 像素点进行插值处理,得到该帧人脸图像对应的高分辨率图像。

43.(2)可以通过预设的重建方法对该帧人脸图像进行超分辨率重建,得到 该帧人脸图像对应的高分辨率图像。其中,预设的重建方法包括但不限于凸集 投影法、贝叶斯分析方法、迭代反投影法、后验概率方法、正规化法和混合方 法。

44.(3)可以通过预设的映射关系对该帧人脸图像进行预测,得到该帧人脸 图像对应的高分辨率图像。其中预设的映射关系表征低分辨率图像与高分辨率 图像之间的对应关系。在本技术一些实施例中,可以通过流形学习、稀疏编码 方法从训练数据中学习分辨率图像与高分辨率图像之间的对应关系,得到映射 关系。

45.(4)可以通过预设的超分辨率模型对该帧人脸图像进行超分辨率重建, 得到该帧人脸图像对应的高分辨率图像。其中超分辨率模型可以是神经网络模 型,例如,基于srcnn的模型、基于子像素卷积(sub-pixel convolution)的 模型、基于卷积神经网络(convolutional neural networks,cnn)、基于反卷 积神经网络(de-convolutional networks,dn)、深度神经网络(deep neuralnetworks,dnn)、基于深度卷积逆向图网络(deep convolutional inversegraphics networks,dcign)、基于区域的卷积网络(region-based convolutionalnetworks,rcnn)、基于区域的快速卷积网络(faster region-basedconvolutional networks,faster rcnn)和基于双向编解码(bidirectionalencoder representations from transformers,bert)模型。

46.需要说明的是,上述高分辨率图像的获取方法仅为示例性说明,不构成对 本技术实施例提供的视频面签中人脸微表情识别方法的限定。

47.202,对低分辨率图像和高分辨率图像分别进行特征提取,得到低分辨率 图像对应的低分辨率特征图以及高分辨率图像对应的高分辨率特征图。

48.低分辨率特征图指的是对低分辨率图像进行关键点粗略预测的低精度关 键点热力图,该低分辨率特征图可以用于提取关键点似然区域;高分辨率特征 图指的是对高分辨率图像进行特征提取得到高分辨率特征图,该高分辨率特征 图用于确定低分辨率特征图上各关键点似然区域的权重。

49.在本技术一些实施例中,可以通过预设的第一特征提取模型对低分辨率图 像进行关键点粗略预测,得到低分辨率图像对应的低分辨率特征图;通过预设 的第二特征提取模型对高分辨率图像进行特征提取,得到高分辨率图像对应的 高分辨率特征图。其中,第一特征提取模型可以是resnet50网络模型,第二特 征提取模型可以是resnet18网络模型。

50.203,根据低分辨率特征图和高分辨率特征图,确定得到关键点特征图。

51.关键点特征图指的是该帧人脸图像对应的高精度关键点热力图。在本技术 一些实施例中,每一帧人脸图像中每一个关键点对应有一张关键点热力图,该 关键点热力图用于确定关键点的坐标。

52.在本技术一些实施例中,步骤203包括:将低分辨率特征图和高分辨率特 征图输入预设的第三特征提取模型进行特征提取,得到关键点特征图。其中, 第三特征提取模型中设置有自注意力机制,其中,注意力机制是一类有效增强 网络特征表达的机制,自注意力机制是注意力机制的一种,能够对长距离的特 征依赖进行建模,在多种计算机视觉任务,比如检测和识别领域中均有所运用, 能够弥补由卷积等操作带来的全局上下文信息缺失的问题。

53.在本技术一些实施例中,步骤203包括:将低分辨率特征图和高分辨率特 征图融合得到融合特征图,将融合特征图设置为关键点特征图。

54.在本技术一些实施例中,步骤203包括:将低分辨率特征图和高分辨率特 征图融合得到融合特征图,根据融合特征图对该帧人脸图像进行关键点提取, 得到关键点特征图。在本技术一些实施例中,可以将融合特征图映射到该帧人 脸图像进行关键点提取,得到关键点特征图;还可以将融合特征图和该帧人脸 图像输入至第三特征提取模型进行关键点提取,得到关键点特征图。

55.204,根据关键点特征图,确定人脸图像的人脸表情识别结果。

56.在本技术一些实施例中,步骤204包括:根据关键点特征图进行坐标回归, 确定该帧人脸图像中每一个关键点的坐标,通过预设的表情识别模型对该帧人 脸图像中关键点的坐标进行表情识别,得到人脸图像的人脸表情识别结果。

57.其中,关键点是预先规定的能够反映人脸的一些器官特征的点,如左内眼 角点、右嘴角点、鼻尖点、下颌边缘点等。需要说明的是,本发明实施例对面 部特征点的数量不作限定,例如关键点的数量可以是68、478。

58.其中,坐标回归指的是将关键点特征图映射到人脸图像中,确定每一个关 键点在人脸图像中的位置。

59.在本技术一些实施例中,表情识别模型可以是基于机器学习的表情识别模 型,例如基于逻辑回归的表情识别模型、基于随机森林的表情识别模型、基于 字典学习的表情识别模型等。

60.在本技术一些实施例中,表情识别模型可以是概率模型,通过概率模型对 该帧人脸图像中的关键点的坐标进行概率计算,得到该帧人脸图像对应的人脸 表情的概率,根据该帧人脸图像对应的人脸表情类型的概率得到人脸表情识别 结果。其中,概率模型可以是高斯模型、正态分布模型等。

61.在本技术一些实施例中,表情识别模型可以是数学计算模型,通过数学计 算模型对该帧人脸图像中的关键点的坐标进行计算,得到该帧人脸图像中关键 点之间的距离、角度,根据关键点之间的距离、角度得到该帧人脸图像的人脸 表情识别结果。

62.在本技术一些实施例中,表情识别模型可以是基于神经网络的表情识别模 型,例如基于卷积神经网络(convolutional neural networks,cnn)、基于反 卷积神经网络(de-convolutional networks,dn)、深度神经网络(deep neuralnetworks,dnn)、基于深度卷积逆向图网络(deep convolutional inversegraphics networks,dcign)、基于区域的卷积网络(region-based convolutionalnetworks,rcnn)、基于区域的快速卷积网络(faster region-basedconvolutional networks,faster rcnn)和基于双向编解码(bidirectionalencoder representations from transformers,bert)模型。

63.205,根据人脸图像的人脸表情识别结果,确定视频面签风险评估结果。

64.视频面签风险评估结果用于表征视频的风险程度。在本技术一些实施例中, 当视频面签风险评估结果符合预设风险评估结果时,输出提示信息,提示工作 人员当前面签审核存在坏账风险。在本技术一些实施例中,当视频面签风险评 估结果符合预设风险评估结果时,输出视频面签风险评估结果,并停止面签审 核,输出面签核验不通过的提示信息至用户,提示用户重新发起视频面签,提 交新的面签视频,并记录提交次数。其中,预设风险评估结果表征存在坏账风 险。

65.在本技术一些实施例中,在用户接收到面签核验不通过的提示信息,重新 发起视频面签时,获取已记录的提交次数,若已记录的提交次数大于或等于预 设次数阈值,则关闭用户远程面签权限;若已记录的提交次数小于预设次数阈 值,则接收用户提交的面签视频,执行步骤201-步骤205再次进行风险评估。

66.在本发明一些实施例中,关闭用户远程面签权限后,可以响应用户输入的 权限申请请求,重新开启用户远程面签权限;也可以关闭用户远程面签权限预 设时间段后,开启用户远程面签权限。其中,预设时间段可以是1小时、12小 时、24小时或48小时。

67.在本技术一些实施例中,步骤205包括:查询预设的风险评估数据,获取 每一帧人脸图像的人脸表情识别结果对应的评估结果,统计该视频中每一种评 估结果出现次数,确定出现次数最大的评估结果;将该出现次数最大的评估结 果设置为视频面签风险评估结果。其中,预设的风险评估数据存储有多种人脸 表情识别结果以及每种人脸表情识别结果对应的评估结果。

68.在本技术一些实施例中,在得到每一帧人脸图像的人脸表情识别结果对应 的评估结果后,确定是否存在评估结果符合预设风险评估结果的评估结果,若 不存在符合预设风险评估结果的评估结果,则统计该视频中每一种评估结果出 现次数,确定出现次数最大的评估结果;若存在符合预设风险评估结果的评估 结果,则将预设风险评估结果设置为视频面签风险评估结果,并输出视频面签 风险评估结果,并停止面签审核,输出面签核验不通过的提示信息至用户,提 示用户重新发起视频面签,提交新的面签视频,并记录提交次

数。

69.本技术实施例通过低分辨率图像和高分辨率图像得到关键点特征图,提高 人脸关键点检测的准确率,抗干扰能力强,如此,通过关键点特征图确定人脸 表情识别结果,提高表情识别结果的准确度。

70.在本技术一些实施例中,在得到视频后,为了提高视频面签中人脸微表情 识别方法的识别效率,可以对视频中每一帧人脸图像进行图像预处理,按照步 骤201对预处理后的图像进行分辨率调整,得到每一帧人脸图像对应的低分辨 率图像和高分辨率图像。其中,图像预处理包括但不限于图像裁剪、图像归一 化、图像对比度增强、图像灰度均衡、图像颜色空间变换、亮度调整、图像翻 转、平滑处理、图像去噪等。

71.在本技术一些实施例中,在得到每一帧人脸图像对应的低分辨率图像和高 分辨率图像之后,可以按照步骤202中步骤对分别对低分辨率图像和高分辨率 图像进行特征提取,得到分辨率图像对应的低分辨率特征图以及高分辨率图像 对应的高分辨率特征图。

72.在本技术一些实施例中,为了提高视频面签中人脸微表情识别方法的识别 效率,可以在对每一帧人脸图像进行图像预处理后,将每一帧预处理后的人脸 图像输入至第一特征提取模型进行关键点粗略提取,得到低分辨率特征图,将 每一帧预处理后的人脸图像输入至第二特征提取模型进行特征提取,得到高分 辨率特征图。

73.在本技术一些实施例中,为了进一步提高视频面签中人脸微表情识别方法 的准确度,在得到低分辨率特征图以及高分辨率特征图之后,可以将低分辨率 特征图与高分辨率特征图进行特征融合,得到融合特征图,将融合特征图输入 至注意力特征提取模型对融合特征图进行特征提取,得到该帧人脸图像对应的 关键点特征图。

74.其中,注意力特征提取模型可以是基于卷积神经网络的模型,在本技术一 些实施例中,由于人脸的关键点的主要特征集中在空间维度上,而卷积神经网 络的感受野集中在局部,缺少全局上下文的关联,进而影响提取得到的关键点 特征图中关键点的准确度,基于此,在卷积神经网络中增加注意力单元,通过 注意力单元添加空间上下文信息提高关键点特征图中的关键点的准确度,进而 增加视频面签中人脸微表情识别方法的识别准确率。

75.在本技术一些实施例中,通过在卷积神经网络中添加注意力单元建立的注 意力特征提取模型可以为提取的关键点特征图添加空间上下文信息,但是对于 面部遮挡和光照变化等复杂场景下的特征提取来说,缺少整体的人脸结构信息, 进而使得在负载场景下提取得到的关键点特征度的可靠性不高,为了解决上述 问题,本技术实施例基于人脸样本图像和人脸样本图像的结构先验特征训练得 到注意力特征提取模型,具体地,注意力特征提取模型的训练过程包括步骤 a1~a6:

76.步骤a1,获取人脸样本图像,以及每一张人脸样本图像对应的人脸关键点 数据。

77.在本技术一些实施例中,可以通过对每一张人脸样本图像中的关键点进行 标注,得到每一张人脸样本图像对应的人脸关键点数据。其中标注可以是人工 标注。

78.步骤a2,基于高斯分布,确定每一张人脸样本图像对应的人脸关键点数据 中每一个关键点的掩膜。

79.在本技术一些实施例中,人脸关键点数据中的关键点可以有n个,将每一 个关键点为中心,基于高斯分布,通过公式

①

确定每一个关键点的掩膜。其中, n是大于或等于1的整数。

[0080][0081]

其中,a

(j)

和b

(j)

分别表示每一张人脸样本图像对应的人脸关键点数据中第 j个关键点的横坐标和纵坐标,a和b分别表示每一张人脸样本图像对应的人脸 关键点数据中第j个关键点为中心的邻域内的任意关键点的横坐标和纵坐标,r 是每一张人脸样本图像对应的人脸关键点数据中第j个关键点为中心的领域的 半径,σ是每一张人脸样本图像对应的人脸关键点数据中第j个关键点为中心的 邻域内的任意关键点标准差。

[0082]

步骤a3,基于该人脸样本图像对应的人脸关键点数据中的每个关键点的掩 膜,得到人脸样本图像的结构先验特征。

[0083]

在本技术一些实施例中,可以将每一个关键点的掩膜进行累加,得到每一 张人脸样本图像对应的人脸关键点数据中所有关键点的掩膜总值,将该掩膜总 值设置为该人脸样本图像的结构先验特征。

[0084]

步骤a4,通过初始检测模型对每一张人脸样本图像进行特征提取,得到每 一张人脸样本图像对应的关键点样本特征。

[0085]

步骤a5,根据每一张人脸样本图像对应的关键点样本特征和每一张人脸样 本图像的结构先验特征得到训练损失值。

[0086]

步骤a6,根据训练损失值对初始检测模型进行参数调整,直至初始检测模 型满足预设收敛条件,得到注意力特征提取模型。

[0087]

在本技术一些实施例中,对每一张人脸样本图像输入至初始检测模型进行 特征提取得到每一张人脸样本图像对应的关键点样本特征,根据每一张人脸样 本图像对应的关键点样本特征和每一张人脸样本图像的结构先验特征,通过预 设的损失函数确定训练损失值,根据训练损失值对初始检测模型进行参数调整, 直至该初始检测模型满足预设收敛条件,得到注意力特征提取模型。

[0088]

其中,预设的损失函数可以是l2范数、均方误差、平方差中的一种或多种。 预设的收敛条件可以是训练损失小于或等于预设损失阈值,也可以是训练次数 大于或等于预设次数阈值。

[0089]

在本技术一些实施例中,可以根据训练损失值,通过随机梯度下降法对初 始检测模型进行参数调整,还可以根据训练损失值,通过牛顿法对初始检测模 型进行参数调整。其中,参数可以是初始检测模型的权重参数。

[0090]

在本技术一些实施例中,在得到注意力特征提取模型之后,对低分辨率特 征图和高分辨率特征图进行图像融合,得到融合特征图;将融合特征图输入至 注意力特征提取模型进行特征提取,得到每一帧人脸图像对应的关键点特征图。

[0091]

在本技术一些实施例中,可以通过基于小波分解的融合方法、基于轮廓波 分解的融合方法、基于金字塔分解的融合方法、基于非下采样轮廓波的融合方 法或基于离散复小波分解的融合方法对低分辨率特征图和高分辨率特征图进 行图像融合,得到融合特征图。

[0092]

在本技术一些实施例中,在得到关键点特征图之后,可以通过坐标变换得 到每一帧人脸图像对应的人脸关键点以及每一帧人脸图像的人脸关键点之间 的位置关系,将每

一帧人脸图像的人脸关键点、每一帧人脸图像的人脸关键点 之间的位置关系输入至表情识别模型,得到每一帧人脸图像的微表情识别结果。

[0093]

在本技术一些实施例中,可以通过坐标变换将关键点特征图中的特征点坐 标映射到对应的人脸图像中,得到每一帧人脸图像的人脸关键点,具体地,人 脸关键点地确定方法包括:

[0094]

(1)对关键点特征图进行坐标变换,得到关键点特征图中的特征点坐标。

[0095]

(2)将关键点特征图中的特征点坐标映射到人脸图像中,得到人脸图像 的人脸关键点。

[0096]

(3)根据人脸图像的每一个人脸关键点之间的距离,得到每一帧人脸图 像的人脸关键点之间的位置关系。

[0097]

在本技术一些实施例中,可以对关键点特征图进行高斯模糊,从高斯模糊 处理后的关键点特征图中提取最大值所在的位置坐标x=(x,y)和次最大值所在 的位置坐标x

p

=(x

p

,y

p

);获取预设的参数δ,通过得到 关键点特征图中的特征点坐标xk。

[0098]

在本技术一些实施例中,在得到关键点特征图中的特征点坐标xk后,通过 公式

②

将关键点特征图中的特征点坐标xk映射到该帧人脸图像中,得到该帧人 脸图像的人脸关键点的坐标xf。

[0099][0100]

其中,xj=(xf,yf),xk=(xk,yk),(x1,y1)和(x2,y2)分别为人脸图像中的 预先标记的第一像素点的坐标值和预先标记的第二像素点的坐标值。

[0101]

在本技术一些实施例中,可以根据每一帧人脸图像中每个人脸关键点的坐 标,计算一帧人脸图像中每个人脸关键点之间的欧式距离、马氏距离、l1范数 和l2范数得到每一帧人脸图像中每个人脸关键点之间的距离。

[0102]

在本技术一些实施例中,表情识别模型可以是通过目标应用场景的样本数 据对预训练的识别模型进行迁移学习训练得到的。其中,识别模型可以是人脸 识别模型,也可以是目标识别模型。目标应用场景的样本数据可以是包含人脸 表情的人脸样本图像。

[0103]

在本技术一些实施例中,表情识别模型可以是通过目标应用场景的样本数 据对预训练的识别器的模型参数进行调整得到的,其中识别器是基于元学习训 练得到的。

[0104]

在本技术一些实施例中,在得到每一帧人脸图像的人脸表情识别结果之后, 可以通过预存的风险等级数据得到每一帧人脸图像的人脸表情识别结果对应 的表情风险等级,根据表情风险等级得到视频面签风险评估结果。其中,风险 等级数据存储有多种人脸表情识别结果以及每一种人脸表情识别结果对应的 表情风险等级。具体地,视频面签风险评估结果的确定方法包括:

[0105]

(1)根据每一帧人脸图像的人脸表情识别结果确定每一帧人脸图像对应 的表情

点提取单元;关键点提取单元对输入的关键点特征图进行坐标变换和映射处理, 得到每一帧人脸图像对应的人脸关键点以及每一帧人脸图像的人脸关键点之 间的位置关系;输出每一帧人脸图像对应的人脸关键点以及每一帧人脸图像的 人脸关键点之间的位置关系至表情识别层303进行表情识别,表情识别层303 输出微表情识别结果至输出层304,由输出层304输出。

[0114]

本技术实施例提供的微表情识别网络通过低分辨率图像和高分辨率图像 得到关键点特征图,提高人脸关键点检测的准确率,抗干扰能力强,如此,通 过关键点特征图确定人脸表情识别结果,提高表情识别结果的准确度。

[0115]

为了更好实施本技术实施例提供的视频面签中人脸微表情识别方法,在视 频面签中人脸微表情识别方法基础上,提供一种视频面签中人脸微表情识别装 置,如图5所示,图5是本技术实施例提供的视频面签中人脸微表情识别装置的 结构示意图,所示的视频面签中人脸微表情识别装置包括:

[0116]

分解模块501,用于获取视频中每一帧人脸图像对应的低分辨率图像和高 分辨率图像;

[0117]

特征提取模块502,用于对低分辨率图像和高分辨率图像分别进行特征提 取,得到低分辨率图像对应的低分辨率特征图以及高分辨率图像对应的高分辨 率特征图;

[0118]

特征图提取模块503,用于对低分辨率特征图和高分辨率特征图进行特征 提取,得到关键点特征图;

[0119]

识别模块504,用于将根据关键点特征图,确定人脸图像的人脸表情识别 结果;

[0120]

评估模块505,用于根据人脸图像的人脸表情识别结果,确定视频面签风 险评估结果。

[0121]

在本技术一些实施例中,特征图提取模块503,用于:

[0122]

对低分辨率特征图和高分辨率特征图进行图像融合,得到融合特征图;

[0123]

将融合特征图输入至注意力特征提取模型进行特征提取,得到人脸图像对 应的关键点特征图。

[0124]

在本技术一些实施例中,视频面签中人脸微表情识别装置还包括训练模块506,训练模块506,用于:

[0125]

像对应的关键点特征图步骤之前,方法包括:

[0126]

获取人脸样本图像,以及每一张人脸样本图像对应的人脸关键点数据;

[0127]

基于高斯分布,确定每一张人脸样本图像对应的人脸关键点数据中每一个 关键点的掩膜;

[0128]

基于该人脸样本图像对应的人脸关键点数据中的每个关键点的掩膜,得到 人脸样本图像的结构先验特征;

[0129]

通过初始检测模型对每一张人脸样本图像进行特征提取,得到每一张人脸 样本图像对应的关键点样本特征图;

[0130]

根据每一张人脸样本图像对应的关键点样本特征图和每一张人脸样本图 像的结构先验特征得到训练损失值;

[0131]

根据训练损失值对初始检测模型进行参数调整,直至初始检测模型满足预 设收敛条件,得到特征提取模型。

理器601中。

[0150]

存储器602可用于存储软件程序以及模块,处理器601通过运行存储在存 储器602的软件程序以及模块,从而执行各种功能应用以及数据处理。存储器 602可主要包括存储程序区和存储数据区,其中,存储程序区可存储操作系统、 至少一个功能所需的应用程序(比如声音播放功能、图像播放功能等)等;存 储数据区可存储根据视频面签中人脸微表情识别设备的使用所创建的数据等。 此外,存储器602可以包括高速随机存取存储器,还可以包括非易失性存储器, 例如至少一个磁盘存储器件、闪存器件、或其他易失性固态存储器件。相应地, 存储器602还可以包括存储器控制器,以提供处理器601对存储器602的访问。

[0151]

视频面签中人脸微表情识别设备还包括给各个部件供电的电源603,优选 的,电源603可以通过电源管理系统与处理器601逻辑相连,从而通过电源管 理系统实现管理充电、放电、以及功耗管理等功能。电源603还可以包括一个 或一个以上的直流或交流电源、再充电系统、电源故障检测电路、电源转换器 或者逆变器、电源状态指示器等任意组件。

[0152]

该视频面签中人脸微表情识别设备还可包括输入单元604,该输入单元 604可用于接收输入的数字或字符信息,以及产生与用户设置以及功能控制有 关的键盘、鼠标、操作杆、光学或者轨迹球信号输入。

[0153]

尽管未示出,视频面签中人脸微表情识别设备还可以包括显示单元等,在 此不再赘述。具体在本实施例中,视频面签中人脸微表情识别设备中的处理器 601会按照如下的指令,将一个或一个以上的应用程序的进程对应的可执行文 件加载到存储器602中,并由处理器601来运行存储在存储器602中的应用程序, 从而实现各种功能,如下:

[0154]

获取视频中每一帧人脸图像对应的低分辨率图像和高分辨率图像;

[0155]

对低分辨率图像和高分辨率图像分别进行特征提取,得到低分辨率图像对 应的低分辨率特征图以及高分辨率图像对应的高分辨率特征图;

[0156]

根据低分辨率特征图和高分辨率特征图,确定得到关键点特征图;

[0157]

根据关键点特征图,确定人脸图像的人脸表情识别结果;

[0158]

根据人脸图像的人脸表情识别结果,确定视频面签风险评估结果。

[0159]

本领域普通技术人员可以理解,上述实施例的各种方法中的全部或部分步 骤可以通过指令来完成,或通过指令控制相关的硬件来完成,该指令可以存储 于一计算机可读存储介质中,并由处理器进行加载和执行。

[0160]

为此,本发明实施例提供一种存储介质,其中存储有多条指令,该指令能 够被处理器进行加载,以执行本发明实施例所提供的任一种虚拟资源的转移方 法中的步骤。例如,该指令可以执行如下步骤:

[0161]

获取视频中每一帧人脸图像对应的低分辨率图像和高分辨率图像;

[0162]

对低分辨率图像和高分辨率图像分别进行特征提取,得到低分辨率图像对 应的低分辨率特征图以及高分辨率图像对应的高分辨率特征图;

[0163]

根据低分辨率特征图和高分辨率特征图,确定得到关键点特征图;

[0164]

根据关键点特征图,确定人脸图像的人脸表情识别结果;

[0165]

根据人脸图像的人脸表情识别结果,确定视频面签风险评估结果。

[0166]

以上各个操作的具体实施可参见前面的实施例,在此不再赘述。

[0167]

其中,该存储介质可以包括:只读存储器(rom,read only memory)、 随机存取记

忆体(ram,random access memory)、磁盘或光盘等。

[0168]

由于该存储介质中所存储的指令,可以执行本发明实施例所提供的任一种 虚拟资源的转移方法中的步骤,因此,可以实现本发明实施例所提供的任一种 虚拟资源的转移方法所能实现的有益效果,详见前面的实施例,在此不再赘述。

[0169]

以上对本发明实施例所提供的一种浏览器页面数据过滤方法、装置和系统 进行了详细介绍,本文中应用了具体个例对本发明的原理及实施方式进行了阐 述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时, 对于本领域的技术人员,依据本发明的思想,在具体实施方式及应用范围上均 会有改变之处,综上所述,本说明书内容不应理解为对本发明的限制。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。