1.本公开涉及云计算技术领域,尤其涉及一种冷启动资源处理方法及装置。

背景技术:

2.webassembly(简称wasm)是一种新的字节码格式,能够为c、c 、rust等高级语言提供一个高效的编译目标,且可以在安全的、可移植、轻量化、高效率的虚拟机中执行,在不同平台上能够以接近本地速度运行。函数即服务(function-as-a-service,faas)是一种云计算形式,faas函数为开发者节省了后端基础设施的大量麻烦,还简化了开发过程,使开发者只需关注业务本身的逻辑。其中,wasm运行时是faas运行时中极其轻量级的运行时,需要更少的资源以及更快的冷启动速度。

3.目前,常通过预留资源来提升冷启动速度,其中,目前的容器faas预留资源是以函数实例(pod)为最小资源粒度,无法适用于wasm函数,因此,如何实现wasm函数的资源预留,以提升冷启动速度是当前亟待解决的问题。

技术实现要素:

4.为了解决上述技术问题,本公开提供了一种冷启动资源处理方法及装置。

5.第一方面,本公开提供了一种冷启动资源处理方法,包括:

6.获取资源池创建指令,其中,所述资源池创建指令包含faas应用请求方指定的冷启动资源池的资源要求;

7.响应所述资源池创建指令,从公共资源池包括的wasm运行时中选择符合所述资源要求的目标wasm运行时;所述目标wasm运行时中能够运行至少一个wasm虚拟机,所述wasm虚拟机用于所述faas应用请求方部署的wasm函数的冷启动;

8.为所述目标wasm运行时设置第一标签得到所述faas应用请求方对应的冷启动资源池;所述第一标签用于指示所述目标wasm运行时属于所述faas应用请求方对应的冷启动资源池,在对应的faas应用冷启动时被调用。

9.第二方面,本公开提供了一种冷启动资源处理装置,包括:

10.获取模块,用于获取资源池创建指令,其中,所述资源池创建指令包含faas应用请求方指定的冷启动资源池的资源要求;

11.资源处理模块,用于响应所述资源池创建指令,从公共资源池包括的wasm运行时中选择符合所述资源要求的目标wasm运行时;所述目标wasm运行时中能够运行至少一个wasm虚拟机,所述wasm虚拟机用于所述faas应用请求方部署的wasm函数的冷启动;

12.标签设置模块,用于为所述目标wasm运行时设置第一标签得到所述faas应用请求方对应的冷启动资源池;所述第一标签用于指示所述目标wasm运行时属于所述faas应用请求方对应的冷启动资源池,在对应的faas应用冷启动时被调用。

13.第三方面,本公开提供了一种电子设备,其特征在于,包括:存储器和处理器;所述存储器被配置为存储计算机程序指令;所述处理器被配置为执行所述计算机程序指令,使

得所述电子设备实现如第一方面所述的冷启动资源处理方法。

14.第四方面,本公开提供一种可读存储介质,其特征在于,包括:计算机程序指令;电子设备的至少一个处理器执行所述计算机程序指令,使得所述电子设备实现如第一方面所述的冷启动资源处理方法。

15.第五方面,本公开提供一种计算机程序产品,其特征在于,电子设备的至少一个处理器执行所述计算机程序产品,使得所述电子设备实现如第一方面所述的冷启动资源处理方法。

16.本公开提供一种冷启动资源处理方法及装置,其中,该方法包括:获取资源池创建指令,资源池创建指令包括faas应用请求方指定的冷启动资源池的资源要求;响应资源池创建指令,从公共资源池包括的wasm运行时中选择符合资源要求的目标wasm运行时;再为选择的目标wasm运行时设置第一标签,以将目标wasm运行时与faas应用请求方绑定。其中,faas应用请求方对应的冷启动资源池中,目标wasm运行时下能够运行多个wasm虚拟机,资源粒度满足wasm函数的需求。解决了wasm函数的资源预留问题,进而能够实现减小wasm函数的冷启动时间。

附图说明

17.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。

18.为了更清楚地说明本公开实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,对于本领域普通技术人员而言,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

19.图1为本公开一实施例提供的基于wasm函数的云服务系统的架构图;

20.图2为本公开一实施例提供的冷启动资源处理方法的整体框架图;

21.图3为本公开一实施例提供的冷启动资源处理方法的流程示意图;

22.图4为本公开一实施例提供的冷启动资源处理方法的流程示意图;

23.图5为本公开一实施例提供的冷启动资源处理方法的流程示意图;

24.图6为本公开一实施例提供的冷启动资源处理方法的流程示意图;

25.图7为本公开一实施例提供的冷启动资源处理方法的流程示意图;

26.图8为本公开一实施例提供的云服务系统的整体架构图;

27.图9为本公开一实施例提供的冷启动资源处理方法的流程示意图;

28.图10为本公开一实施例提供的冷启动资源处理方法的流程示意图;

29.图11为本公开一实施例提供的冷启动资源处理装置的结构示意图;

30.图12为本公开一实施例提供的电子设备的结构示意图。

具体实施方式

31.为了能够更清楚地理解本公开的上述目的、特征和优点,下面将对本公开的方案进行进一步描述。需要说明的是,在不冲突的情况下,本公开的实施例及实施例中的特征可以相互组合。

32.在下面的描述中阐述了很多具体细节以便于充分理解本公开,但本公开还可以采

用其他不同于在此描述的方式来实施;显然,说明书中的实施例只是本公开的一部分实施例,而不是全部的实施例。

33.图1为本公开一实施例提供的基于wasm函数的云服务系统的架构示意图。请参阅图1所示,faas应用请求方在云服务系统中部署wasm函数(也可以理解为faas应用),向用户提供faas服务。用户可以通过网关接入云服务系统,通过网关能够将用户的函数请求调度至云服务系统的wasm运行时,进而被wasm运行时下的虚拟机执行。其中,wasm运行时是一种进程级别的虚拟机,wasm运行时中可以运行多个虚拟机,每个虚拟机可以运行一个wasm函数。其中,一个物理机中可以部署多个wasm运行时,多个wasm运行时之间是相互隔离的,彼此之间不会产生影响。其中,云服务系统可以为faas系统。

34.传统的冷启动资源预留是以pod为最小资源粒度的,然而,wasm函数需要在pod内部启动多个函数实例,最小资源粒度需求为wasm虚拟机,传统以pod为最小粒度的资源预留方式已无法适用于图1所示的云服务系统。

35.为了解决wasm函数的冷启动资源预留问题,减小wasm函数的冷启动时间,本公开提供一种适用于wasm函数的冷启动资源处理方法及装置。请参照图2所示,本公开提供的方法主要包括以下两个阶段:创建冷启动资源池和资源预留。其中,创建冷启动资源池是指基于faas应用请求方的需求在云服务系统中新建一个冷启动资源池,用于运行faas应用请求方部署在云服务系统中的wasm函数,加速wasm函数的冷启动。资源预留是指从创建好的冷启动资源池中为faas应用请求方部署在云服务系统中的各wasm函数分别分配冷启动资源作为预留资源。

36.此外,针对已创建好的冷启动资源池还可以根据faas应用请求方需求进行维护,例如,扩容、缩容、删除等等。执行资源预留之后,还可以根据faas应用请求方需求灵活调整冷启动资源池中的资源分配,以保证为各wasm函数分配的资源满足相应的资源预留要求;此外,还可以预加载wasm函数代码,实例化wasm函数,以进一步提升冷启动速度。

37.接下来,将通过几个具体实施例对本公开提供的冷启动资源处理方法进行详细介绍。下述实施例中,以冷启动资源处理装置执行本公开提供的方法为例进行介绍。其中,冷启动资源处理装置可以为云服务系统中具有执行的功能模块或者组件。

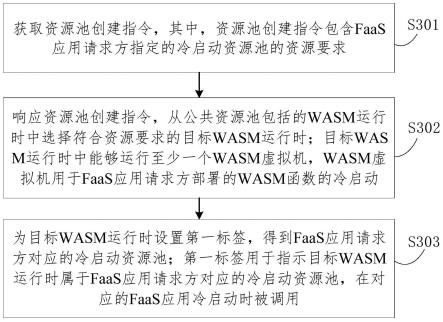

38.图3为本公开一实施例提供的冷启动资源处理方法的流程示意图。本实施例主要介绍如何创建冷启动资源池。请参阅图3所示,本实施例的方法包括:

39.s301、获取资源池创建指令,其中,资源池创建指令包含faas应用请求方指定的冷启动资源池的资源要求。

40.faas应用请求方可以向云服务系统输入对于冷启动资源池的资源要求,faas应用请求方输入的信息传输至冷启动资源处理装置,该装置基于此生成资源创建指令。其中,资源要求可以包括faas应用请求方指定的wasm运行时的数量、内存大小、处理器内核数量等等。

41.s302、响应资源池创建指令,从公共资源池包括的wasm运行时中选择符合资源要求的目标wasm运行时;目标wasm运行时中能够运行至少一个wasm虚拟机,wasm虚拟机用于faas应用请求方部署的wasm函数的冷启动。

42.公共资源池是云服务提供商在云服务系统中配置的用于满足faas应用请求方部署的函数的冷启动需求的冷启动资源池,其中,公共资源池可以包括多种不同类型的运行

时,例如,wasm运行时、golang运行时、python运行时、rust运行时、java运行时等等,且各种运行时的数量、内存大小等可以灵活设置。

43.冷启动资源处理装置响应资源池创建指令,从公共资源池中选择符合faas应用请求方提出的资源要求的目标wasm运行时作为faas应用请求方对应的冷启动资源池。

44.一些实施例中,冷启动资源处理装置可以先从公共资源池中过滤已被使用的wasm运行时,预选一批符合资源要求的候选wasm运行时;若没有符合资源要求的候选wasm运行时,可以等待符合资源要求的wasm运行时的存量函数运行结束之后,继续执行预选操作。再从候选wasm运行时中采用随机的方式或者基于其他选择策略确定目标wasm运行时。

45.采用该方式,预选阶段确定的候选wasm运行时的数量可以多于faas应用请求方所需的数量,这可以满足下一级筛选策略以为faas应用请求方选择更加适合的wasm运行时。

46.例如,faas应用请求方a需要创建一个包含5个wasm运行时的冷启动资源池,每个wasm运行时下可以运行10个wasm虚拟机,且faas应用请求方a对于wasm运行时的要求为:内存大小为8g、处理器内核数量为4核;则首先从公共资源池中预先10个4核8g的wasm运行时,之后,再基于从10个预选的wasm运行时中确定5个作为目标wasm运行时。

47.另一些实施例中,冷启动资源处理装置也可以从公共资源池中选择符合资源要求的目标wasm运行时,即不设置下一级的筛选策略,该方式简单方便。

48.s303、为目标wasm运行时设置第一标签,得到faas应用请求方对应的冷启动资源池;第一标签用于指示目标wasm运行时属于faas应用请求方对应的冷启动资源池,在对应的faas应用冷启动时被调用。

49.第一标签(label)可以为faas应用请求方的标识,例如,faas应用请求方在云服务系统中的注册账号、云服务系统为faas应用请求方分配的其他id标识等等,能够唯一标识faas应用请求方即可。

50.其中,冷启动资源处理装置在本地存储选择的各目标wasm运行时的信息以及相应的第一标签,此外,再向各目标wasm运行时发送消息,以发送第一标签,目标wasm运行时接收到包含第一标签的消息后在本地进行标记,在处理函数请求时,便可以基于第一标签准确调度冷启动资源。

51.通过本实施例的方法解决了wasm函数的资源预留问题,进而能够实现减小wasm函数的冷启动时间。

52.图4为本公开另一实施例提供的冷启动资源处理方法的流程示意图。本实施例主要介绍如何维护已创建好的冷启动资源池。其中,维护可以但不限于包括:扩容、缩容以及删除,相当于是对冷启动资源池的容量进行修改。请参阅图4所示,本实施例的方法在图3所示实施例的基础上,还包括:

53.s304、接收并响应资源池扩容指令,从公共资源池中选择当前工作负载为零且符合资源要求的wasm运行时添加至冷启动资源池,以扩大冷启动资源池的容量。

54.云服务系统中,公共资源池中各运行时可以定期通过心跳汇报资源信息给冷启动资源处理装置进行存储,可以存储至冷启动资源处理装置的内存中,以减少在进行冷启动资源池容量修改时所需数据读取以及写入内存的时间。其中,wasm运行时汇报的资源信息可以包括wasm运行时下正在执行函数请求的虚拟机的数量(即wasm运行时的工作负载)。

55.冷启动资源处理装置接收到资源池扩容指令后,可以从内存中查询公共资源池中

各运行时的工作负载,筛选得到当前未运行任何wasm虚拟机,且符合用户的资源要求的wasm运行时,接着在本地为所选择的wasm运行时设置第一标签,且向选择的wasm运行时发送包含第一标签的消息,以使接收消息的wasm运行时在本地进行标记,从而扩大faas应用请求方对应的冷启动资源池的容量。

56.s305、接收并响应资源池缩容指令,则将冷启动资源池中当前工作负载为零的目标wasm运行时释放至公共资源池,以缩小冷启动资源池的容量。

57.冷启动资源处理装置接收到资源池缩容指令后,可以从内存中查询faas应用请求方对应的冷启动资源池中各目标wasm运行时的工作负载,筛选得到当前未运行任何wasm虚拟机,且符合用户的资源要求的目标wasm运行时作为释放对象,再冷启动资源处理装置本地删除所选择的目标wasm运行时的第一标签,且向所选择的目标wasm运行时发送删除第一标签的消息,以使接收到消息的目标wasm运行时删除相应的标签,从而缩小用户对应的冷启动资源池的容量。

58.s306、接收并响应资源池删除指令,释放冷启动资源池中的所有目标wasm运行时至公共资源池。

59.冷启动资源处理装置接收到资源池删除指令后,可以采用与缩容类似的方式,将faas应用请求方对应的冷启动资源池中的所有目标wasm运行时进行释放。需要说明的是,若接收到资源池删除指令时,一些目标wasm运行时中还存在正在执行函数请求的wasm虚拟机,则等待这些存量函数运行完之后再释放至公共资源池。

60.本实施例的方法,能够根据faas应用请求方需求灵活进行冷启动资源池容量调整,满足用户的函数请求。

61.图5为本公开一实施例提供的冷启动资源处理方法的流程示意图。本实施例的方法主要介绍如何实现冷启动资源池的资源预留。请参阅图5所示,本实施例的方法包括:

62.s501、获取资源预留指令,所述资源预留指令包括:所述冷启动资源池的资源分配策略。

63.资源分配策略用于指示如何为faas应用请求方部署在云服务系统中的各wams函数分配冷启动池中的冷启动资源。本公开提供的方法,可以采用两种资源预留模式,分别为:按照内存大小分配和按照比例分配。

64.1、按照内存大小分配

65.wasm函数使用内存规格来描述消耗的资源,通常所有函数的内存采用固定值描述,例如,固定值为128m,但是不同业务的函数资源的消耗是具备差异的,且随着运行时开始接入便开始计算用户成本,资源“一刀切”的方式会给使用云服务系统的用户带来额外的成本。

66.因此,本公开的方法能够实现让faas应用请求方依据业务的特点,选择不同的预留方案,一方面能够按需使用内存,满足不同业务的资源需求,减少oom的问题,另一方面还能够降低使用成本。

67.示例性地,wasm函数可以分为16m、32m、64m、128m、256m多种规格。用户选择了每个wasm函数的内存规格之后,可以指定预留的冷启动资源的内存大小为wasm函数的内存规格的整数倍,且不能大于冷启动资源池的最大容量。其中,针对一个wasm函数来说为其预留的冷启动资源的内存大小为16的整数倍。

68.2、按照比例分配

69.按照比例预留资源,假设faas应用请求方在云服务系统中部署了n个wasm函数,n个wasm函数分别预留的冷启动资源的比例为x1、x2

…

xn,且满足x1 x2

…

xn<=1。

70.在一些实施例中,若faas应用请求方选择按照内存大小预留资源,则资源预留策略中包含faas应用请求方输入的各wasm函数所需的内存大小。

71.另一些实施例中,若faas应用请求方选择按照比例预留资源,则资源预留策略中包含faas应用请求方输入的各wasm函数所需的内存占整个冷启动资源池的内存的比例。

72.s502、响应资源预留指令,基于各目标wasm运行时的资源占用情况以及资源分配策略,为各wasm函数确定相匹配的目标wasm运行时。

73.可以通过下述步骤实现:

74.步骤a、基于第一标签确定faas应用请求方所对应的冷启动资源池中的wasm运行时。

75.步骤b、从步骤a中过滤出携带指定第二标签的wasm运行时。

76.步骤c、过滤掉并发数达到最大并发数的wasm运行时。其中,并发数是指wasm运行时下的wasm虚拟机的数量。

77.步骤d、从步骤c确定的多个wasm运行时中,依据随机调度策略、依据并发数以及内存大小、以及、依据资源预留指令中各wasm函数所需的冷启动资源的内存大小/比例,为各wasm函数选择出可以分配的目标wasm运行时,即选择出可以执行创建第二标签操作的wasm运行时。

78.s503、控制所述目标wasm运行时创建相应的wasm虚拟机,并为所述wasm虚拟机设置第二标签,第二标签用于指示创建的wasm虚拟机与相应wasm函数之间的绑定关系。

79.冷启动资源处理装置可以发送超文本传输协议(hyper text transfer protocol,http)请求给能够进行资源预留的目标wasm运行时,目标wasm运行时响应http请求创建wasm虚拟机,并为创建的wasm虚拟机设置第二标签,以将创建的wasm虚拟机与wasm函数绑定。

80.通过本实施例的方法能够为faas应用请求方部署在云服务系统中的各wasm函数合理预留冷启动资源,节约资源调度时间,且合理的资源分配方式能够有效降低成本。

81.在图5所实施例基础上,随着业务需求的变化,为各wasm函数预留的冷启动资源可能需要进行调整,例如,在有新的wasm函数部署至云服务系统,或者,删除了一些现有的wasm函数等场景中,需要调整各wasm函数的冷启动资源分配。调整冷启动资源分配时,可以向云服务系统输入新的资源分配指令指示相应的资源分配策略,云服务系统按照新的资源分配策略重新分配冷启动资源。

82.图6为本公开另一实施例提供的冷启动资源处理方法的流程示意图。参照图6所示实施例,本实施例的方法在图5所示实施例的基础上,还包括:

83.s504、控制所述目标wasm运行时下的各wasm虚拟机分别加载相应的所述wasm函数的代码,实例化所述wasm函数。

84.在预留wasm虚拟机的基础上,通过进一步提前将wasm函数的代码加载至相应wasm虚拟机的内存中,去除了冷启动阶段,进一步降低了函数执行时间,极大地减小了冷启动时间。

85.在一个具体实施例中,以hello wasm的wasm函数为例,冷启动耗时数据如下表所示:

86.编号每次请求总耗时(ms)冷启动耗时(ms)12.570.4022.620.3432.600.3042.590.4052.630.37平均值2.600.36

87.通过资源预留以及提前加载函数代码的预留模式去除了冷启动的耗时之后,总耗时减少了14%。可以理解的是,函数的代码包越大以及代码运行过程中会下载大量资源的场景,预留模式的提升效果更加明显。

88.图7为本公开一实施例提供的冷启动资源处理方法的流程示意图。在图5所示实施例的基础上,为了保证各wasm函数的冷启动资源始终满足需求,需要进行定期的检查以及维护。例如,在云服务系统中,wasm运行时配置有回收逻辑(可以理解为是gc逻辑),则可能会定期销毁wasm运行时下未执行函数请求的wasm虚拟机回收相应的内存资源,可能导致为一些wasm函数预留的冷启动资源不满足需求。参照图7所示,本实施例的方法在图5所示实施例的基础上,还包括:

89.s505、周期性地检测为各所述wasm函数分别预留的冷启动资源是否满足相应的预留要求。

90.冷启动资源处理装置可以周期性地比较当前为wasm函数预留的wasm虚拟机的数量(也可以理解为目标wasm运行时下第二标签的数量)与wasm函数所需的wasm虚拟机的数量是否一致,从而给确定为wasm函数预留的冷启动资源是否符合预留要求。若不一致,则确定不满足预留要求,执行步骤s506;若一致,则确定满足预留要求,则不做处理。

91.其中,冷启动资源处理装置可以基于各目标wasm运行时通过心跳汇报的资源情况确定第二标签的数量。

92.s506、检测到不满足时,调整所述冷启动资源池中的资源分配,直至满足各所述wasm函数分别对应的预留要求。

93.通过步骤s506中的对比结果能够确定当前预留的冷启动资源大于需求的资源还是少于需求的资源。若当前预留的冷启动资源多于需求,可以删除一部分具有第二标签的虚拟机,释放该部分资源;若当前预留的冷启动资源少于需求的资源,则可以采用如图5所示的方式,选择出可以创建wasm虚拟机的目标wasm运行时,向其发送请求,以在所选择的目标wasm运行时中创建所需数量的wasm虚拟机,并设置相应的第二标签。

94.本实施例,通过定期检测以及冷启动资源的分配调整,能够保证为各wasm函数分配的冷启动资源始终能够满足用户的需求。

95.图8为本公开一实施例提供的云服务系统的架构图。请参阅图8所示,云服务系统800包括:接入服务组件(api server)801、网关802、wasm运行时803以及与wasm运行时对应的主机代理组件804。

96.接入服务组件801主要用于处理所有api请求,例如,创建冷启动资源池的请求、调

整冷启动资源池容量的请求、预留资源的请求、函数请求等等。且用于同步元数据给网关802。

97.网关802,主要用于对冷启动资源池进行操作以及进行流量调度。

98.主机代理组件804主要用于对出入wasm运行时803的相关数据进行处理,例如,可以下载函数代码、汇报wasm运行时803的资源信息、地址信息等等给网关802。

99.接下来通过图9以及图10示例性示出通过图8所示的云服务系统框架如何实现冷启动资源处理。

100.图9为本公开一实施例提供的冷启动资源处理方法的流程图。图9主要介绍创建冷启动资源池的过程。请参阅图9所示,包括以下步骤:

101.s901、用户向接入服务组件发送资源池信息。

102.接入服务组件接收到资源池信息后,将资源池信息写入数据库中。资源池信息可以包括:创建资源池的指令、修改资源池容量的指令、调整资源池容量的指令等等。

103.s902、网关周期性地从接入服务组件的数据库中同步元数据。

104.元数据包括各用户发送的资源池信息。

105.本实施例中,网关采用异步同步数据的机制,因此,需要定期轮询数据库得到元数据,写入网关的缓存池。需要说明的是,云服务系统中通常网关数量较多,多个网关均可以采用异步同步数据的机制从数据库得到元数据。

106.网关也可以采用订阅机制从数据库获取元数据,本公开对此不作限定。

107.s903、wasm运行时定期通过心跳汇报资源信息给主机代理组件。

108.s904、主机代理组件将资源信息转发给网关。

109.网关将接收的资源信息存储到内存结构中。

110.s905、网关进行选主操作。

111.云服务系统通常会包括多个网关,为了避免多个网关重复创建冷启动资源池,因此,需要从多个网关中选择一个主节点,由主节点进行所有的资源池操作,其他网关作为从节点,冷启动资源池创建完成后将相关资源池的信息同步给从节点。

112.s906、若选主失败,则等待下次重试。

113.在选主成功的情况下,作为主节点的网关周期性检查缓存池中资源池相关的元数据相比上个周期的变化,基于变化分别执行下述新建冷启动资源池/修改冷启动资源池容量/删除冷启动资源池的操作。

114.s907、执行wasm运行时预选、优选以及选定操作,并为选定的wasm运行时设置用户冷启动资源池标签(即第一标签)。

115.本步骤为新建冷启动资源池的操作,可以包括以下步骤:

116.1、预选:从公共资源池中过滤掉已被使用的wasm运行,如果没有符合要求的,网关流量调度的时候要选择部分wasm运行时禁止进行增量调度,等待wasm运行时的存量函数运行结束之后,继续冷启动资源池的创建操作。

117.2、优选:从预选后的wasm运行时中随机找到符合资源要求的wasm运行时作为优选结果。

118.3、选定:将优选的结果存入网关的内存中。

119.s908、修改冷启动资源池的容量。

120.用户可以输入指令以调整冷启动资源池容量,可以是扩容也可以是缩容。可参照图7所示实施例的描述,简明起见,此处不再赘述。

121.s909、删除冷启动资源池。

122.s910、网关同步用户冷启动资源池的信息给其他从节点。

123.以保证各网关中的冷启动资源池信息在内存中保持一致。在一些实施例中,作为主节点的网关可以通过raft协议和其他从节点同步冷启动资源池信息。

124.图10为本公开一实施例提供的冷启动资源处理方法的流程图。图10主要介绍资源预留的实现方式。请参阅图10所示,包括以下步骤:

125.s1001、用户向接入服务组件输入资源预留策略。

126.其中,接入服务组件提供分配策略的操作api,并将用户输入的资源预留策略写入数据库中。结合前文所述,资源预留策略可以是基于按照内存大小预留的模式或者按照比例分配的模式生成的策略。

127.s1002、网关周期性地从接入服务组件的数据库中同步资源预留策略。

128.s1003、按照资源预留策略分配wasm运行时,并为wasm运行时设置第二标签。具体地,为wasm运行时下创建的wasm虚拟机设置第二标签,可参照前文详细描述。

129.s1004、修改资源预留策略。

130.s1005、删除预留资源策略。

131.即删除wasm运行时的第二标签。

132.s1006、wasm运行时定期通过心跳汇报资源信息至主机代理组件。

133.s1007、主机代理组件将资源信息转发给网关。即汇报资源信息给网关。

134.资源预留进行修改或者删除资源预留策略之后,wasm运行时反馈资源信息至网关,网关进行存储,保证网关中记录的各wasm运行的状态与实际状态一致。

135.在图10所示实施例的基础上,wasm运行时创建相应的wasm虚拟机并设置第二标签之后,主机代理组件还可以加载相应的wasm函数代码,以去除冷启动的过程。

136.通过图10所示实施例,通过为各wasm函数预留冷启动资源,且提前加载函数代码,能够有效减小函数请求的总耗时。

137.应理解,图9以及图10所示实施例中的用户即为前文中提及的faas应用请求方。

138.图11为本公开一实施例提供的冷启动资源处理装置的结构示意图。请参阅图11所示,本实施例提供的装置1100包括:

139.获取模块1101,用于获取资源池创建指令,其中,所述资源池创建指令包含faas应用请求方指定的冷启动资源池的资源要求。

140.资源处理模块1102,用于响应所述资源池创建指令,从公共资源池包括的wasm运行时中选择符合所述资源要求的目标wasm运行时;所述目标wasm运行时中能够运行至少一个wasm虚拟机,所述wasm虚拟机用于所述faas应用请求方部署的wasm函数的冷启动。

141.标签设置模块1103,用于为所述目标wasm运行时设置第一标签,得到所述faas应用请求方对应的冷启动资源池;所述第一标签用于指示所述目标wasm运行时属于所述faas应用请求方对应的冷启动资源池,在对应的faas应用冷启动时被调用。

142.在一些实施例中,获取模块1101,还用于获取资源池扩容指令。

143.资源处理模块1102,还用于响应所述资源池扩容指令,从所述公共资源池中选择

logic device,pld)或其组合。上述pld可以是复杂可编程逻辑器件(complex programmable logic device,cpld),现场可编程逻辑门阵列(field-programmable gate array,fpga),通用阵列逻辑(generic array logic,gal)或其任意组合。

161.存储器1201可以包括易失性存储器(volatile memory),例如随机存取存储器(random-access memory,ram);存储器也可以包括非易失性存储器(non-volatile memory),例如快闪存储器(flash memory),硬盘(hard disk drive,hdd)或固态硬盘(solid-state drive,ssd);存储器还可以包括上述种类的存储器的组合。

162.本公开还提供一种可读存储介质,包括:计算机程序指令,所述计算机程序指令被电子设备的至少一个处理器执行时,使得所述电子设备实现如上任一方法实施例提供的冷启动资源处理方法。

163.本公开还提供一种计算机程序产品,当所述计算机程序产品在计算机上运行时,使得所述计算机实现如上任一方法实施例提供的冷启动资源处理方法。

164.需要说明的是,在本文中,诸如“第一”和“第二”等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

165.以上所述仅是本公开的具体实施方式,使本领域技术人员能够理解或实现本公开。对这些实施例的多种修改对本领域的技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本公开的精神或范围的情况下,在其它实施例中实现。因此,本公开将不会被限制于本文所述的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。