1.本发明涉及基于人工智能的图像处理领域,具体涉及一种红外与可见光图像跨尺度注意力对抗融合方法及终端。

背景技术:

2.红外传感器通过感知热源辐射捕获前景目标信息,能够全天时全天候工作,但获得的红外图像通常缺乏结构特征和纹理细节。相反,可见光传感器通过光反射成像,能够获取场景信息和纹理细节,且具有较高的空间分辨率,但易受到外界环境影响,特别在低照度或遮挡情况下,缺乏感知目标特性能力。

3.由于不同的成像机制和工作模态,两类传感器获得的图像具有较强的互补信息。因此,图像融合技术旨在综合两类传感器的优势,有效提高两类成像传感器的协同探测能力,互补生成的融合图像更利于人眼观察和后续计算处理,在遥感探测、医疗诊断、智能驾驶、安全监控等领域有广泛应用。

4.目前,红外和可见光图像融合技术大致可以分为传统融合方法和深度学习融合方法。传统图像融合方法通常以固定数学表示模型提取图像特征,采用合适的融合规则进行特征整合,再通过逆变换重构获得最终融合图像。事实上,从图像特点来看,红外图像以像素强度表征目标特征,而可见光图像以边缘和梯度表征纹理细节,两类图像表征模态信息存在较大差异。传统融合方法不考虑源图像的不同模态特征,采用固定数学模型无差别地提取图像特征,不可避免地造成融合性能低、视觉效果差的结果。此外,融合规则是人为设计,且越来越复杂,计算成本高,限制了图像融合的实际应用。

5.近年来,深度学习融合方法已经成为研究主流方向,其方法大致可分为自编码器融合方法、卷积神经网络融合方法和生成对抗融合方法。自编码器融合方法通常采用预先训练好的网络进行特征编码和解码,然后设计相应的特征融合层。这些方法需要手工设计融合策略,无法实现端到端融合。卷积神经网络融合方法是一种端到端模式,通常在输入阶段通道连接(concatenate)源图像或在融合层通道连接深度特征。但通过简单的通道连接,没有充分考虑不同模态图像的内在特征,导致图像融合性能有限。生成对抗融合方法是在生成器和鉴别器之间建立对抗博弈,但生成器的框架类似于卷积神经网络融合模型,依然采用通道连接源图像或者深度特征。同时,这些方法还忽略了不同尺度的特征信息交互,不可避免地限制了融合性能。

技术实现要素:

6.为了克服上述现有技术中的不足,本发明提供的红外与可见光图像跨尺度注意力对抗融合方法,融合方法可以随两类图像模态特征的变化而自适应地跨尺度特征学习,增强有用信息而抑制无关信息,进而提高红外与可见光图像的融合性能。

7.本发明提供的第一方面内容涉及红外与可见光图像跨尺度注意力对抗融合方法,方法包括:

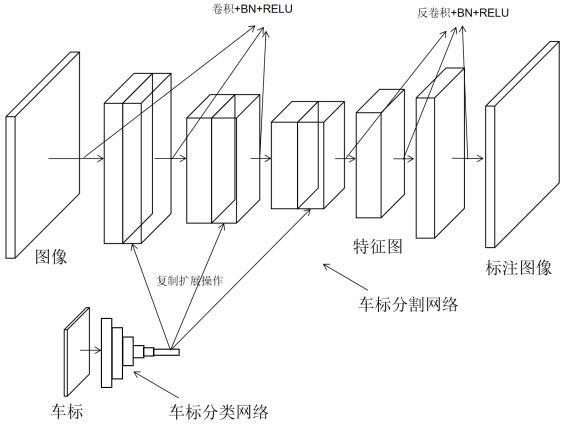

s1、将待融合红外图像、待融合可见光图像输入预先训练好的跨模态跨尺度迭代生成器,直接生成最终的融合图像;通过跨模态跨尺度迭代生成器建立了双编码-单解码网络框架,包括多尺度编码网络、初始融合层和跨尺度特征迭代解码网络;s2、通过多尺度编码网络采用的四个多尺度卷积模块,记作mcb1,mcb2,mcb3和mcb4,提取红外和可见光图像的多尺度深度特征,记为与;其中,;每个mcb包含两个卷积核大小为3

×

3的卷积层,相应的步长分别设置为1和2;s3、通过初始融合层将第四尺度的红外图像特征和可见光图像特征进行相加操作,得到初始融合特征,即;s4、通过跨尺度特征迭代解码网络采用的四个跨模态注意力集成模型,记作caim1,caim2,caim3和caim4,进行特征重构;其中,首先将第四尺度的红外图像特征、可见光图像特征和初始融合特征输入对应的跨模态注意力集成模型caim4,输出中间融合特征;然后,经过上采样后,作为上一尺度跨模态注意力集成模型caim3的初始融合特征,依次类推,最终输出融合图像。

8.本发明提供的第二方面内容涉及终端,终端包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,其特征在于,所述处理器执行所述程序时实现红外与可见光图像跨尺度注意力对抗融合方法的步骤。

9.从以上技术方案可以看出,本发明具有以下优点:1、本发明构造了跨模态注意力集成模型。初始融合特征通过通道注意力独立路径和空间注意力独立路径计算获得注意力权重系数,用于测量同一尺度的红外与可见光图像活动水平,采用加权平均运算输出中间融合特征。模型能够以学习的方式整合不同模态图像的内在特征信息。

10.2、本发明开发了跨尺度特征迭代解码网络。利用跨模态注意力集成模型建立起不同尺度不同模态特征之间的桥梁,以迭代的方式不断优化红外与可见光图像的活动水平。解码网络能够充分利用不同尺度特征信息,使得融合结果更聚焦红外目标感知和可见光细节描述。

11.3、本发明提出了一种端到端的红外与可见光图像对抗融合方法。得益于跨模态特征整合和跨尺度迭代设计,生成器包含更少的卷积层,且不需要跳过连接和通道增加,网络模型简单而有效,具有更高的计算效率和更好的融合性能。该方法也可以应用于多模态图像、多聚焦图像和医学图像融合,对图像融合领域具有很高的应用价值。

convolutional block),记作mcb1,mcb2,mcb3和mcb4,提取红外和可见光图像的多尺度深度特征,记为与,其中,。每个mcb包含两个卷积核大小为3

×

3的卷积层,相应的步长分别设置为1和2。

21.其中,多尺度编码网络包括红外图像和可见光图像两个编码器路径,每个路径包含四个多尺度卷积模块,且每个模块中第一个卷积的输出通道数与第二个卷积的输入输出通道数相同。每个卷积模块的是输入通道数分别为1、16、32、64,输出通道数为16、32、64、128,激活函数为prelu。

22.s3,通过初始融合层将第四尺度的红外图像特征和可见光图像特征进行相加操作,得到初始融合特征,即。

23.s4,通过跨尺度特征迭代解码网络采用的四个跨模态注意力集成模型(cross-modal attention integrated module),记作caim1,caim2,caim3和caim4,进行特征重构,其中,首先将第四尺度的红外图像特征、可见光图像特征和初始融合特征输入对应的跨模态注意力集成模型(caim4),输出中间融合特征。然后,经过上采样后,作为上一尺度跨模态注意力集成模型(caim3)的初始融合特征,依次类推,最终输出融合图像。

24.其中,跨尺度特征迭代解码网络包含四个跨模态注意力集成模型,相应的输入通道分别为128、64、32、16,输出通道数分别为64、32、16、1,激活函数为prelu。

25.可选地,跨模态注意力集成模型,包括通道注意力独立路径和空间注意力独立路径。在通道注意力独立路径中,对于输入的初始融合特征,首先使用最大和平均池化层分别将初始融合特征转换为初始通道注意力向量。然后,初始通道注意力向量通过两个卷积层和一个prelu激活层后,进行通道连接输入下一个卷积层中,生成通道注意力向量,表示为:,其中,表示卷积运算,、和分别表示全局最大池化、平均池化操作和通道连接运算。表示prelu激活函数。

26.相似地,在空间注意力独立路径中,对于输入的初始融合特征,依然采用最大和平均池化操作来获得相应的初始空间注意力矩阵,然后将进行通道连接后输入

一个卷积层中,产生空间注意矩阵,表示为。

27.然后,将通道注意力向量与空间注意力矩阵按元素化的方式进行相乘,得到初始融合特征的注意力特征图。随后,利用sigmod激活函数进行归一化处理,生成相应的注意力权重,表示为。其中,表示sigmod激活函数。

28.最后,将注意力权值分配给红外图像深度特征,给可见光图像深度特征,同时进行平均加权处理得到相应的中间融合特征,表示为。

29.上述过程即为对待融合红外图像和待融合可见光图像进行图像融合的相关内容。为了能够通过跨模态跨尺度迭代生成器对待融合红外图像和待融合可见光图像进行图像融合,需要预先训练生成器。下述内容即为训练跨模态跨尺度迭代生成器的过程。

30.具体地,在训练跨模态跨尺度迭代生成器时包括:s01,构建跨模态跨尺度迭代生成器:以红外图像和可见光图像作为输入,建立双编码-单解码网络框架,包括多尺度编码网络、初始融合层和跨尺度特征迭代解码网络,用于生成初始融合图像;所述多尺度编码网络分别采用四个多尺度卷积模块(multi-scale convolutional block),记作mcb1,mcb2,mcb3和mcb4,提取红外和可见光图像的多尺度深度特征,记为与,其中,。每个mcb包含两个卷积核大小为3

×

3的卷积层,相应的步长分别设置为1和2,且每个模块中第一个卷积的输出通道数与第二个卷积的输入输出通道数相同。每个卷积模块的是输入通道数分别为1、16、32、64,输出通道数为16、32、64、128,激活函数为prelu;所述融合层,直接将第四尺度()的红外图像特征和可见光图像特征进行相加操作,得到初始融合特征,即;所述跨尺度特征迭代解码网络包含四个跨模态注意力集成模型(cross-modal attention integrated module),记作caim1,caim2,caim3和caim4,进行特征重构,其中,首先将第四尺度()的红外图像特征、可见光图像特征和初始融合特征输入对应的跨模态注意力集成模型(caim4),输出中间融合特征。然后,经过上采样后,作为上一尺度()跨模态注意力集成模型(caim3)的初始融合特征,依次类推,最终输出初始融合图像。四个跨模态注意力集成模型,相应的输入通道分别为128、64、32、16,输出通道数分别为64、32、16、1,激活函数为prelu;

s02,构建红外与可见光双鉴别器模型;在训练过程中,将跨模态跨尺度迭代生成器获得的初始融合图像与红外图像、可见光图像输入对应的鉴别器,以约束融合图像分别与红外图像、可见光图像同时具有相似的数据分布;当跨模态跨尺度迭代生成器能够欺骗红外与可见光双鉴别器,表明对抗博弈达到平衡,得到最终的融合结果;所述红外鉴别器与可见光鉴别器具有相同的网络结构,均由4个卷积层和1个全连接层组成,所有卷积层均采用3

×

3核大小和leakyrelu激活函数,步长为2,相应的卷积层的输入通道分别为1、16、32、64,输出通道数分别为16、32、64、128;s03,网络模型训练:以红外图像与可见光图像作为训练数据集,采用l2范数约束融合结果与红外图像之间数据分布相似度,l1范数来约束融合结果与可见光图像之间数据分布相似度,设计的损失函数监督网络模型训练,获得最优的网络模型参数;所述损失函数包括生成器损失函数和鉴别器损失函数;生成器损失函数由内容损失和对抗损失两部分组成,表示为,其中,表示生成器损失函数,和分别表示内容损失函数和对抗损失函数,参数用于控制两个损失函数之间的平衡。对于内容损失函数,分别采用l1范数和l2范数来约束融合结果与源图像之间的分布相似性,表示为,其中,、和分别表示融合结果、红外图像和可见光图像,和分别表示l1范数和l2范数,参数为平衡系数。在鉴别器设计中,采用红外鉴别器和可见光鉴别器来区分融合结果与可见光图像、红外图像的数据分布,相应的对抗损失函数表示为。此外,双鉴别器按照梯度约束的原理,设计相应各自的损失函数,分别表示为和。其中,表示梯度算子。第一项和第二项分别表示wasserstein距离估计和梯度惩罚,为正则化参数。

31.其中,所述训练数据集采用tno数据集中的25组红外与可见光图像对,并且使用步长为12的滑动窗口,将原始图像分割成尺寸大小为256

×

256图像块,相应的灰度值进行中心化处理,将其像素值转换为[-1, 1],最终获得10563组图像作为训练集;训练过程中使用adam优化器更新生成器和鉴别器网络模型参数,学习率分别设置为1

×

10

−4和4

×

10

−4,相应的迭代次数分别设置为1和2;batchsize和epoch分别设置为4和14;损失函数参数,和

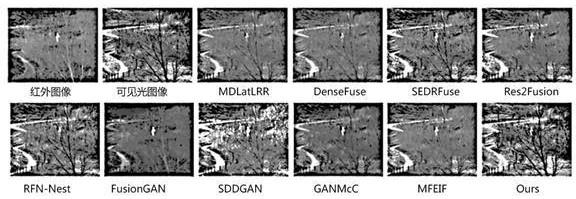

此外,表2给出了在tno数据上的计算效率,单位为秒(s)。可以看出,本发明具有最高的计算效率,说明本发明构建的网络模型新颖而有效。一方面由于迭代网络框架,生成器包含更少的多尺度卷积层,且不需要跳过连接,这样不会导致特征冗余和提高模型参数。其次,与其他采用通道连接的方法不同,跨模态注意力集成模型可以在不增加通道数的情况下,以学习方式更有效地整合特征。因此,本发明具有更高的计算效率和更好的融合性能。

[0037]

表2为在tno数据上的计算效率

methods mdlat

ꢀ‑

lrr dense

ꢀ‑

fuse sedr

ꢀ‑

fuse res2

ꢀ‑

fusion rfn

ꢀ‑

nest fusion

ꢀ‑

gan sdd

ꢀ‑

gan gan

ꢀ‑

mcc mfe

ꢀ‑

if ours time 79.41 0.085 2.676 18.86 0.178 2.015 0.271 4.210 3.634 0.063 对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。