一种瓶颈缩边模型、神经元网络及其构建方法

1.本发明是申请号为201910894420.1,发明名称为一种包括周边环境的图像识别方法及装置,申请日为2019年9月20日,申请类型为发明的专利申请的分案。

技术领域

2.本发明涉及信息技术领域,尤其涉及一种瓶颈缩边模型、神经元网络模型及其构建方法。

背景技术:

3.通过深度学习来进行图像识别是当今人工智能最热门的发展方向和最成功的应用方向。在身份认证、安防、自动驾驶,甚至集成电路设计和垃圾分类等方面,利用深度学习来识别图像都有巨大的价值。

4.利用深度学习来进行图像识别的具体做法是构造卷积神经元网络;收集海量的图像(数据)及其分类标记;用这些数据及标记来对卷积神经元网络进行训练,建立相应的模型;在实际应用中用建立好的模型来对输入图像进行识别。

5.最近几年,随着人们对卷积神经元网络结构的改进和优化,深度学习的图像识别能力突飞猛进。其中,最著名的卷积神经元网络结构之一是2015年底由微软中国研究院的he kaiming等人提出的残差网络(resnet),它在imagenet大规模视觉识别挑战赛(ilsvrc)上的识别率已经超过了人类识别的水平。残差网络是由残差模块垒叠而成。残差网络的核心思想是用处理卷积与输入的残差f(x)=h(x)

–

x来替代卷积神经元网络中的卷积层h(x),这样能够增加系统的稳定性,从而避免在神经元网络过深(层数过多)时出现的退化现象。以这个思路可以构造残差模块(包括基本残差模块和进一步减少参数增加层次的瓶颈残差模块),以残差模块为基础构造网络层次大幅多于以往的神经元网络模型的残差神经元网络,达到图像识别效果的大幅提升。

6.在对一幅图像中央的物体进行识别时,图像上的每一个像素的价值并非相同的。要建立一个高质量的卷积神经元网络来识别图像中的物体,图像中央物体本身的像素对神经元网络的参数产生影响的权重应该大于物体周围背景对应的像素。

7.但是,已有的卷积神经元网络,包括he kaiming等人的残差网络,图像上所有的像素对网络参数影响的权重都是相同的,从而造成要么参数不足而不能足够的抓取图像上物体的特征,要么参数过多而产生过拟合现象;同时,建模和识别的计算量也更大。

8.但若简单的剪切掉图像的边缘,去掉周围背景对应的像素,则图像的信息不足,造成识别的困难。如图4和图5所示,带背景的原图如图4a和图5a所示,剪切掉图像边缘后如图4b和图5b所示。图像中的物体比带背景的原图更难识别。

9.例如,中国专利cn108985236a公开了一种基于深度化可分离卷积模型的人脸识别方法,包括以下步骤:第一步、读取人脸图像样本数据集;第二步、建立深度化可分离卷积模型,所述深度化可分离卷积模型在相邻的两个卷积模块之间级联了多个残差瓶颈模块;第三步、利用梯度下降算法更新深度化可分离卷积模型参数;第四步、通过更新参数后的深度

化可分离卷积模型进行人脸识别。该专利可以在保证人脸识别准确率的基础上提高识别速度。但是,该专利并没有对人脸图像和背景图像进行权重的区分,导致计算量较大。

10.例如,中国专利108921788a公开了一种基于深层残差cnn的图像超分辨率方法,包括:构建深层残差cnn模型,将低分辨率图像输入所述深层残差cnn模型进行识别,得到识别后的图像;将所述识别后的图像输入vgg损失网络进行识别效果评价,获取具备超分辨率的识别图像。该专利是对获得的图像的识别效果进行评价来获得分辨率较高的识别图像,也没有预先对识别图像和背景图像进行权重的区分,导致计算量较大。

11.例如,中国专利cn 110163260 a公开了一种基于残差网络的图像识别方法,所述方法包括:构建残差网络,采用预设的训练样本对所述残差网络进行训练;获取待识别图像;对所述待识别图像执行预处理;将预处理后的所述待识别图像划分为不重叠的两个分块,依次作为输入传入所述残差网络,获取每一分块经过所述残差网络后的预测值;根据所述两个分块的预测值输出识别结果,所述识别结果包括所述待识别图像为目标图像和所述待识别图像为非目标图像。该专利通过残差网络提取出关键特征,能够减低噪声干扰,以高准确率判断出目标图像。但是,该专利依然无法降低建模和识别的计算量。

12.例如,中国专利108765449a公开了一种基于卷积神经网络的图像背景分割和识别方法,该方法利用卷积神经网络学习样本图像,训练得到背景分割模型和识别分类模型,然后依据该模型进行图像的背景分割和识别分类。该专利将卷积神经网络应用于图像识别分类时结合图像背景对识别分类所产生的影响,并且背景分割模型中将卷积神经网络中全连接层替转化为卷积层。该专利是通过使用卷积神经网络模型来实现图像背景分割后,将图像再用于图像识别分类,以提升识别分类的准确率。但是分割背景后,与背景具有相对意义的信息被忽略,导致图像识别不准确。

13.例如,中国专利cn102694961b公开一种对图像边缘进行单边缩边的方法和装置,包括:将原始图像与所述原始图像的键信号进行合成,在所述合成的过程中,所述原始图像与所述键信号中的物体位置对齐,合成后得到处理后前景;确定所述处理后前景中黑边的位置;保持所述原始图像的位置不动,将所述原始图像的键信号相对于所述原始图像按照指定的移动距离向所述黑边位置相反的方向移动;将原始图像与移动后的键信号再次进行合成;对再次合成得到的图像进行整体缩边。该专利虽然通过对图像的边缘进行单边缩边,增强了图像的显示效果。但是,该专利描述的是一种图像加强的方法和装置,不涉及图像的识别,或者说它是在通过其他图像识别装置区分出前景与背景之后再进行的图像加强手段。不仅如此,该专利中进行缩边的动作是指在图像处理后直接去掉图像边缘的像素,而不是神经元网络中的矩阵边缘的特征元素。而神经元网络中,除输入层的矩阵是图像信息外,其它层的矩阵已经不能称作图像了,而是特征元素。

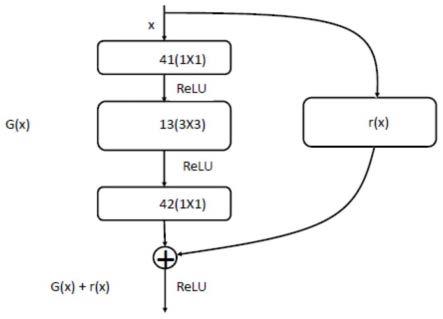

14.此外,一方面由于对本领域技术人员的理解存在差异;另一方面由于申请人做出本发明时研究了大量文献和专利,但篇幅所限并未详细罗列所有的细节与内容,然而这绝非本发明不具备这些现有技术的特征,相反本发明已经具备现有技术的所有特征,而且申请人保留在背景技术中增加相关现有技术之权利。

技术实现要素:

15.针对现有技术之不足,本发明提供一种包括周边环境的图像识别方法,其特征在

于,所述方法至少包括以下步骤:基于卷积层提取图像矩阵;将所述图像矩阵进行至少一次缩边处理;将缩边处理后的图像矩阵进行至少一次非缩边的残差处理;基于全连接层输出识别的图像数据。与现有技术中的神经元网络相比,由于设置了缩边模块,本发明的神经元网络获得更好的图像识别效果的优势方面在于:第一,缩边模块的引入提取了图像边缘部分代表周边环境像素的特征信息,帮助提高对图像中物体的识别质量。第二,缩边模块的引入又使得这些图像边缘像素特征信息对应的参数数量小于图像中部关于待识别物体像素特征信息的参数数量,从而在不减少图像中部关于待识别物体像素特征信息参数数量的前提下,减少整个神经元网络的参数数量,提高网络的稳定性与识别质量。第三,缩边模块的引入又使得这些图像边缘像素特征信息的权重小于图像中部关于待识别物体像素特征信息的权重,从而提高了图像中部物体的识别率,并且减少了对图像边缘部分无关物体的误识别情况。

16.根据一个优选实施方式,所述方法还包括步骤:构建缩边模块;所述缩边模块的缩边方法包括:基于所述卷积层提取图像矩阵的中间和/或边缘特征元素,去掉所述图像矩阵的边缘k层的特征元素,缩边后,卷积层的卷积核的大小为:m=k*2 1,其中,m,k为正整数。本发明的缩边方法的优势在于,能够通过无padding的卷积变换截取输入的图像矩阵x的中间和边缘像素的特征元素,既减少了计算量,又使得中间和边缘像素的信息对输出影响的权重确不相同:边缘像素的影响权重低于中间像素的影响权重。

17.根据一个优选实施方式,所述缩边模块为基本缩边模块,所述基本缩边模块至少包括两层m*m卷积层,所述基本缩边模块的缩边方法包括:g(x)=conv_2(σ(conv_1(x))) r(x),

18.其中,conv_1(x),conv_2(x)表示对图像矩阵x进行无padding的m*m卷积变换,m≥1;σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。基本缩边模块的优势在于,能够去掉边缘两层的像素,从而降低边缘像素的影响权重,使得边缘像素的影响权重低于中间像素的影响权重。

19.根据一个优选实施方式,所述缩边模块为瓶颈缩边模块,所述瓶颈缩边模块至少包括两层1*1卷积层和一层m*m卷积层,其中m*m卷积层设置在两个1*1卷积层之间,所述瓶颈缩边模块的缩边方法包括:

20.g(x)=c_2(σ(conv(σ(c_1(x))))) r(x)

21.其中,conv(x)表示对图像矩阵x进行无padding的m*m卷积变换,m>1;c_1(x)与c_2(x)表示对图像矩阵x进行1*1卷积变换,σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。瓶颈缩边模块的优势或技术效果在于,通过1

×

1的卷积层c_1减少图像矩阵的通道数,使得3

×

3的卷积核的参数数量和计算量都大幅减少,从而使瓶颈缩边模块的参数数量少于相应的基本缩边模块,而同时又使相应的网络深度增加50%。

22.根据一个优选实施方式,所述r(x)去掉所述图像矩阵的边缘k层的特征元素的函数为:

23.即去掉矩阵x的第1~k行,第1~k列,第(n-k 1)~n行和第(n-k 1)~n列。

24.根据一个优选实施方式,所述基本缩边模块的m*m卷积层为包含3x3卷积核的卷积层;所述瓶颈缩边模块中的m*m卷积层为包含3x3卷积核的卷积层。

25.根据一个优选实施方式,所述方法还包括:在进行所述非缩边的残差处理之前或之中,将图像矩阵进行至少一次池化处理和/或卷积处理以改变通道数量。

26.本发明还提供一种包括周边环境的图像识别装置,其特征在于,所述装置至少包括:卷积模块,用于基于卷积层提取图像矩阵;缩边单元,用于将所述图像矩阵进行至少一次缩边处理;残差单元,用于将缩边处理后的图像矩阵进行至少一次非缩边的残差处理;全连接层模块,用于基于全连接层输出识别的图像数据。其中,所述缩边单元设置在所述卷积模块与所述残差单元之间,所述残差单元与所全连接层模块连接。

27.根据一个优选实施方式,所述缩边单元包括若干缩边模块;所述缩边模块的缩边方法包括:基于所述卷积层提取图像矩阵的中间和/或边缘特征元素,去掉所述图像矩阵的边缘k层的特征元素,缩边后,卷积层的卷积核的大小为:m=k*2 1,其中,m,k为正整数。

28.根据一个优选实施方式,所述缩边模块包括基本缩边模块和瓶颈缩边模块,所述基本缩边模块至少包括两层m*m卷积层,所述基本缩边模块的缩边方法包括:g(x)=conv_2(σ(conv_1(x))) r(x),

29.其中,conv_1(x),conv_2(x)表示对图像矩阵x进行无padding的m*m,卷积变换,m>1;σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边;

30.所述瓶颈缩边模块至少包括两层1*1卷积层和一层m*m卷积层,其中m*m卷积层设置在两个1*1卷积层之间,所述瓶颈缩边模块的缩边方法包括:g(x)=c_2(σ(conv(σ(c_1(x))))) r(x)

31.其中,conv(x)表示对图像矩阵x进行无padding的m*m卷积变换,m≥1;c_1(x)与c_2(x)表示对图像矩阵x进行1*1积变换,σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。

32.本发明还提供一种瓶颈缩边模型,设置于瓶颈缩边模块中,所述瓶颈缩边模型至少包括两层1*1卷积层和一层m*m卷积层,其中m*m卷积层设置在两个1*1卷积层之间,所述瓶颈缩边模块的缩边方法包括:

33.g(x)=c_2(σ(conv(σ(c_1(x))))) r(x)

34.其中,conv(x)表示对图像矩阵x进行无padding的m*m卷积变换,m>1;c_1(x)与c_2(x)表示对图像矩阵x进行1*1卷积变换,σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。

35.优选地,所述r(x)去掉图像矩阵的边缘k层的特征元素的函数为:

[0036][0037]

即去掉原矩阵x的第1~k行,第1~k列,第(n-k 1)~n行和第(n-k 1)~n列。

[0038]

优选地,第二卷积层为3x3卷积核的卷积层。

[0039]

本发明还提供一种神经元网络,至少包括:

[0040]

卷积模块,设置与图像信息输入端并用于基于卷积层提取图像矩阵;

[0041]

缩边单元,包括至少一个缩边模块,用于将图像矩阵进行至少一次缩边处理;

[0042]

残差单元,包括至少一个残差模块,用于提取图像非边缘部分待识别区域的相对比较抽象的特征;

[0043]

全连接层模块,用于基于全连接层输出识别的图像数据;

[0044]

卷积模块、缩边单元、残差单元和全连接层模块依次连接。

[0045]

本发明的神经元网络中,所述缩边模块为瓶颈缩边模块,

[0046]

所述瓶颈缩边模块至少包括两层1*1卷积层和一层m*m卷积层,其中m*m卷积层设置在两个1*1卷积层之间,

[0047]

所述瓶颈缩边模块的缩边方法包括:

[0048]

g(x)=c_2(σ(conv(σ(c_1(x))))) r(x)

[0049]

其中,conv(x)表示对图像矩阵x进行无padding的m*m卷积变换,m>1;c_1(x)与c_2(x)表示对图像矩阵x进行1*1卷积变换,σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。

[0050]

本发明的神经元网络中,所述r(x)去掉图像矩阵的边缘k层的特征元素的函数为:

[0051][0052]

即去掉原矩阵x的第1~k行,第1~k列,第(n-k 1)~n行和第(n-k 1)~n列。

[0053]

本发明还提供一种神经元网络的构建方法,所述方法包括:

[0054]

将卷积模块与缩边单元连接;

[0055]

所述缩边单元为瓶颈缩边单元(20);在所述瓶颈缩边单元(20)与瓶颈残差单元(50)之间设置有第一池化模块(31)和第一1x1卷积模块(41);

[0056]

第一池化模块(31)设置在第一1x1卷积模块(41)的数据上游;

[0057]

将瓶颈残差单元(50)与全连接层模块(60)连接;

[0058]

所述全连接层模块(60)用于输出最后的图像数据。

[0059]

本发明的神经元网络的构建方法中,所述瓶颈缩边单元(20)包括依次连接的第一瓶颈缩边模块(21)、第二瓶颈缩边模块(22)、第三瓶颈缩边模块(23)和第四瓶颈缩边模块(24);

[0060]

每个瓶颈缩边模块去掉1层边缘特征元素,第一瓶颈缩边模块(21)、第二瓶颈缩边模块(22)、第三瓶颈缩边模块(23)和第四瓶颈缩边模块(24)能够去掉图像矩阵边缘4层特征元素,使图像矩阵的行数和列数各减少8。

[0061]

本发明的神经元网络的构建方法中,所述瓶颈残差单元(50)中的任意两个非缩边的瓶颈残差模块之间设置有第二池化模块(32)和第二1x1卷积模块(42);第二池化模块(32)设置在第二1x1卷积模块(42)的数据上游;

[0062]

其中,在残差模块之间设置的池化模块的作用在于改变图像矩阵的大小。

[0063]

本发明的神经元网络的构建方法中,瓶颈残差模块至少包括三层卷积层,瓶颈残差模块的表达式可写为:h(x)=c_2(σ(conv(σ(c_1(x))))) x,其中,conv(x)表示对图像矩阵x进行padding=1的3

×

3卷积变换;

[0064]

c_1(x)与c_2(x)表示对图像矩阵x进行1

×

1卷积变换,

[0065]

σ(x)表示对图像矩阵x进行非线性变换。

附图说明

[0066]

图1是本发明的基本缩边模块的缩边方法逻辑示意图;

[0067]

图2是本发明的瓶颈缩边模块的缩边方法逻辑示意图;

[0068]

图3是本发明的一个优选实施方式法的逻辑示意图;

[0069]

图4a是本发明其中一个带背景原图的示意图;

[0070]

图4b是本发明其中一个无边缘的图像的示意图;

[0071]

图5a是本发明另一个带背景原图的示意图;和

[0072]

图5b是本发明另一个无边缘的图像的示意图。

[0073]

附图标记列表

[0074]

11:第一3x3卷积模块12:第二3x3卷积模块

[0075]

13:第三3x3卷积模块r(x):缩边模块

[0076]

10:5x5卷积模块20:瓶颈缩边单元

[0077]

21:第一瓶颈缩边模块22:第二瓶颈缩边模块

[0078]

23:第三瓶颈缩边模块24:第四瓶颈缩边模块

[0079]

31:第一池化模块32:第二池化模块

[0080]

41:第一1x1卷积模块42:第二1x1卷积模块

[0081]

50:瓶颈残差单元51:第一瓶颈残差模块

[0082]

52:第二瓶颈残差模块53:第三瓶颈残差模块

[0083]

54:第四瓶颈残差模块55:第五瓶颈残差模块

[0084]

60:全连接层模块

具体实施方式

[0085]

下面结合附图进行详细说明。

[0086]

本发明中,padding是指(填充)属性定义元素边框与元素内容之间的空间。当元素的padding(填充)内边距被清除时,所释放的区域将会受到元素背景颜色的填充。单独使用padding属性可以改变上下左右的填充。

[0087]

残差网络:残差网络的特点是容易优化,并且能够通过增加相当的深度来提高准确率。其内部的残差块使用了跳跃连接,缓解了在深度神经网络中增加深度带来的梯度消失问题。

[0088]

基本残差模块:残差网络中的模块;模块至少包括两层卷积层,模块的表达式可写为:h(x)=conv_2(σ(conv_1(x))) x,其中,conv_1(x),conv_2(x)表示对图像矩阵x进行padding=1的3

×

3卷积变换;σ(x)表示对图像矩阵x进行非线性变换。

[0089]

瓶颈残差模块:残差网络中的模块;模块至少包括三层卷积层,模块的表达式可写为:h(x)=c_2(σ(conv(σ(c_1(x))))) x,其中,conv(x)表示对图像矩阵x进行padding=1的3

×

3卷积变换;c_1(x)与c_2(x)表示对图像矩阵x进行1

×

1卷积变换,σ(x)表示对图像矩阵x进行非线性变换。

[0090]

卷积层:用于提取图像的特征,并且卷积核的权重是可以学习的。每层卷积层(convolutionallayer)由若干卷积单元组成,每个卷积单元的参数都是通过反向传播算法最佳化得到的。卷积运算的目的是提取输入的不同特征,第一层卷积层可能只能提取一

些低级的特征如边缘、线条和角等层级,更多层的网路能从低级特征中迭代提取更复杂更抽象的特征。

[0091]

池化层:用于减小下一层输入大小,进而减小计算量和参数个数,从而可以预防网络过拟合。

[0092]

全连接层:全连接层中的每个神经元与其前一层的所有神经元进行全连接.全连接层可以整合卷积层或者池化层中具有类别区分性的局部信息.为了提升cnn网络性能,全连接层每个神经元的激励函数一般采用relu函数。最后一层全连接层的输出值被传递给一个输出,可以采用softmax逻辑回归(softmax regression)进行该层也可称为softmax层(softmax layer)。

[0093]

实施例1

[0094]

现有技术中,残差网络所用的核心卷积层是预先对图像添加了padding的,此卷积层的输入和输出矩阵的大小相同,进行残差操作f(x)=h(x)-x。其中,f(x)是残差函数,指模块输出与输出之间的差,h(x)是指模块的输出矩阵,x是指模块的输入矩阵(图像矩阵)。

[0095]

现有技术中,提及“缩边”的技术方案仅有中国专利cn102694961b,但是该专利的“缩边”是指在图像处理后直接去掉图像边缘的像素。这与本发明的缩边定义完全不同,使用目的也是毫不相关。本发明的缩边是指,去掉神经元网络中的矩阵边缘的特征元素。其中,在神经元网络中,除输入层的矩阵是图像外,其它层的矩阵已经不能称作图像了,而是特征元素。本发明的缩边与神经元网络中的两个或三个无padding卷积配合出现,以保证缩边后的矩阵与卷积后的矩阵大小相同。

[0096]

本发明在残差网络的基础上提出了缩边操作方法。本发明的缩边方法,是指不对图像添加padding,使得此卷积层的输出矩阵比输入矩阵尺度小。此时,在进行残差操作时,需要对输入的图像矩阵进行缩边。即g(x)=h(x)-r(x)。其中,r(x)为对输入图像矩阵x进行的缩边操作。缩边方法包括:基于卷积层提取图像矩阵的中间和/或边缘特征元素,去掉图像矩阵的边缘k层的特征元素信息。缩边后,卷积层的卷积核的大小为:m=k*2 1。其中,m,k为正整数。本发明的缩边方法的优势在于,能够通过卷积截取输入的图像矩阵x的中间和边缘的特征元素,使得中间和边缘的特征元素对输出影响的权重确不相同:边缘特征元素的影响权重低于中间特征元素的影响权重。

[0097]

载有缩边操作方法的装置定义为缩边模块。缩边模块包括基本缩边模块和瓶颈缩边模块。

[0098]

基本缩边模块至少包括两层m*m卷积层。基本缩边模块的缩边方法包括:g(x)=conv_2(σ(conv_1(x))) r(x)。其中,conv_1(x),conv_2(x)表示对图像矩阵x进行无padding的m*m卷积变换,m≥1。σ(x)表示对图像矩阵x进行非线性变换。例如,σ(x)为relu函数。r(x)表示对图像矩阵x进行缩边。

[0099]

当卷积层优选为包含3x3卷积核的卷积层时,conv_1(x),conv_2(x)表示对图像矩阵x进行无padding的3x3卷积变换。r(x)表示去掉其边缘两层的特征元素,以保证r(x)的尺度与conv_2(σ(conv_1(x)))的尺度相同。基本缩边模块的优势在于,能够去掉边缘两层的特征元素,从而降低边缘特征元素的影响权重,使得边缘特征元素的影响权重低于中间特征元素的影响权重,即边缘像素的影响权重低于中间像素的影响权重。本发明的基本缩边模块中至少要包含两个卷积层,否则其缩边及残差操作就能与卷积层合并,使得操作是线

性的,不能提升识别效果。

[0100]

如图1所示,根据一个优选实施方式,基本缩边模块的卷积层优选为包含3x3卷积核的卷积层。如图1所示,输入的图像矩阵x经第一3x3卷积模块11进行第一次无padding的3x3卷积变换,经过relu(rectified linear units)激活函数进行线性变换后输入第二3x3卷积模块12。第二3x3卷积模块12对图像矩阵进行第二次无padding的3x3卷积变换后,通过r(x)对输入图像矩阵进行缩边,去掉其边缘两层的特征元素。根据一个优选实施方式,缩边模块为瓶颈缩边模块。瓶颈缩边模块至少包括两层1*1卷积层和一层m*m卷积层。其中m*m卷积层设置在两个1*1卷积层之间。瓶颈缩边模块的缩边方法包括:

[0101]

g(x)=c_2(σ(conv(σ(c_1(x))))) r(x)。

[0102]

其中,conv(x)表示对图像矩阵x进行无padding的m*m卷积变换,m>1。c_1(x)与c_2(x)表示对图像矩阵x进行1*1卷积变换,σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。

[0103]

优选的,如图2所示,瓶颈缩边模块中,第二卷积层为3x3卷积核的卷积层。则conv(x)表示对图像矩阵x进行无padding的3*3卷积变换。

[0104]

具体地,如图2所示,卷积层为3x3卷积核的第三3x3卷积模块13设置在第一1x1卷积模块41和第二1x1卷积模块42之间。图像矩阵x输入第一1x1卷积模块41进行第一次无padding的1x1卷积变换。第一1x1卷积模块41输出的图像矩阵经过relu(rectified linear units)激活函数进行线性变换后输入第三3x3卷积模块13,以进行无padding的3x3卷积变换。第三3x3卷积模块13输出的图像矩阵经过relu(rectified linear units)激活函数进行线性变换后输入第二1x1卷积模块42,以进行第二次无padding的1x1卷积变换。第二1x1卷积模块42输出的图像矩阵通过r(x)进行缩边,去掉其边缘一层的特征元素,以保证r(x)的尺度与c_2(σ(conv(σ(c_1(x)))))的尺度相同。与基本缩边模块相比,瓶颈缩边模块的优势或技术效果在于,通过1

×

1的卷积层c_1减少图像矩阵的通道数,使得3

×

3的卷积核的参数数量和计算量都大幅减少,从而使瓶颈缩边模块的参数数量少于相应的基本缩边模块,同时又使相应的网络深度增加50%。减少参数数量能够提高整个神经元网络的稳定性,而增加网络深度能够提高的图像识别率。实践表明,用瓶颈缩边模块替代基本缩边模块能够达到更好的识别效果。

[0105]

优选的,在基本缩边模块和瓶颈缩边模块中,卷积模块的卷积核不局限于3x3的卷积核,还可以是其他奇数大小的卷积核,例如5x5的,7x7的卷积核。缩边模块的缩边操作随着卷积核的变化,相应的去掉特征元素层数作相应改变,以保证r(x)的尺度合适。在实际缩边操作过程中,选取3x3的卷积核的卷积模块,最有利于避免过度拟合问题,并且计算效率相对较高。

[0106]

优选的,本发明的r(x)去掉图像矩阵的边缘k层的特征元素的函数为:

[0107][0108]

即去掉矩阵x的第1~k行,第1~k列,第(n-k 1)~n行和第(n-k 1)~n列。其中,图像矩阵x为a

nn

矩阵。

[0109]

优选的,去掉边缘一层特征元素的r(x)函数可以写为

即去掉原矩阵x的第一行,第一列,最后一行和最后一列。类似的,去掉边缘两层特征元素的r(x)函数就是去掉原矩阵x的第一、二行,第一、二列,最后两行和最后两列。优选的,利用基本缩边模块、瓶颈缩边模块构建神经元网络,能够降低突下边缘的影响权重,从而获得更好的图像识别效果。

[0110]

优选的,神经元网络至少包括卷积模块、缩边模块、残差模块、全连接模块。优选的,神经元网络还包括池化模块,以及其他的基本线性/非线性变换。

[0111]

优选的,神经元网络中的图像信息输入端设置卷积层,用于提取图像的基本几何特征,例如各种方向的边界等等。与卷积层相邻设置有包含若干缩边模块的缩边单元。缩边模块的数量由输入图像的大小和待识别物体周边环境在图中的相对大小决定。缩边单元用来截取图像矩阵中边缘层特征元素。与缩边单元相邻设置非缩边的残差单元。残差单元包括若干残差模块。残差模块包括基本残差模块和瓶颈残差模块。与残差模块相邻设置有全连接层模块。残差模块用于缩边模块之后,全连接层之前,用于提取图像非边缘部分待识别区域的相对比较抽象的特征。全连接层模块用于神经元网络的最后一层,以提取图像最终分类的特征信息。

[0112]

与现有技术中的神经元网络相比,由于设置了缩边模块,本发明的神经元网络获得更好的图像识别效果的优势方面在于:第一,缩边模块的引入提取了图像边缘部分代表周边环境像素的特征信息,帮助提高对图像中物体的识别质量。第二,缩边模块的引入又使得这些图像边缘像素特征信息对应的参数数量小于图像中部关于待识别物体像素特征信息的参数数量,从而在不减少图像中部关于待识别物体像素特征信息参数数量的前提下,减少整个神经元网络的参数数量,提高网络的稳定性与识别质量。第三,缩边模块的引入又使得这些图像边缘像素特征信息的权重小于图像中部关于待识别物体像素特征信息的权重,从而提高了图像中部物体的识别率,并且减少了对图像边缘部分无关物体的误识别情况。

[0113]

优选的,神经元网络中,缩边模块与非缩边残差模块之间可以设置池化层来缩小图像,或者设置1x1的卷积层来改变通道的数量。

[0114]

优选的,缩边模块设置在非缩边的残差模块之前,具有相对的优势。对应于周边环境的像素位于图像矩阵的边缘,而图像矩阵的靠内的特征元素对应待识别的物体本身的像素。输入图像矩阵最边缘的特征元素对最终的输出有权重低的影响,去掉后不仅能够降低计算量,还能够降低图像边缘的影响。而输入图像的靠近中间和正中间的特征元素都对图像中物体的识别同样重要,此时用非缩边残差模块,能够保留靠近图像矩阵中间和正中间的特征元素不受影响。因此,缩边模块设置在非缩边的残差模块之前,使得图像的区域中间的信息与边缘信息的对比度增加,凸显中间图像信息。

[0115]

图3是本发明的神经元网络的一种具体实施例。图3所示为识别图像矩阵32x32的单通道图像(俗称黑白图像)中的数字(0~10)的实施例。图3中,m(32x32),ch(1)表示图像矩阵为32x32,通道为1。以此类推。

[0116]

卷积核为5x5的5x5卷积模块10与瓶颈缩边单元20连接。瓶颈缩边单元20与瓶颈残差单元50之间设置有第一池化模块31和第一1x1卷积模块41。并且,第一池化模块31设置在

第一1x1卷积模块41的数据上游。瓶颈残差单元50中的任意两个非缩边的残差模块之间可以设置有第二池化模块32和第二1x1卷积模块42。并且,第二池化模块32设置在第二1x1卷积模块42的数据上游。瓶颈残差单元50与全连接层模块60连接。全连接层模块60将最后的图像数据输出。

[0117]

优选的,瓶颈缩边单元20包括依次连接的第一瓶颈缩边模块21、第二瓶颈缩边模块22、第三瓶颈缩边模块23和第四瓶颈缩边模块24。每个瓶颈缩边模块去掉1层边缘特征元素,4个瓶颈缩边模块能够去掉图像矩阵边缘4层特征元素,就是使图像矩阵的行数和列数各减少8,图像矩阵大小由瓶颈缩边单元20输入的28

×

28变为单元输出的20

×

20。

[0118]

优选的,非缩边的瓶颈残差单元50内的残差模块均为非缩边的残差模块。优选的,非缩边的瓶颈残差单元50包括依次连接的第一瓶颈残差模块51、第二瓶颈残差模块52、第三瓶颈残差模块53、第四瓶颈残差模块54和第五瓶颈残差模块。其中,第三瓶颈残差模块53、第四瓶颈残差模块54之间设置有第二池化模块32和第二1x1卷积模块42。优选的,瓶颈残差模块之间设置池化模块的作用在于改变图像矩阵的大小。例如,图3中池化模块将图像矩阵的行列数减半,并在网络中添加了非线性层。1

×

1卷积模块的作用在于改变图像通道的数量。例如,图3中图像通道的数量被加倍。

[0119]

如图3所示,本发明的神经元网络对包括周边环境的图像识别方法,包括以下步骤:

[0120]

s1:基于卷积层提取图像矩阵;

[0121]

s2:将图像矩阵进行至少一次缩边处理;

[0122]

s3:将缩边处理后的图像矩阵进行至少一次非缩边的残差处理;

[0123]

s4:基于全连接层输出识别的图像数据。

[0124]

本发明对包括周边环境的图像识别方法进行详细论述。

[0125]

卷积核为5x5的5x5卷积模块10对输入的图像数据提取图像矩阵,即图像的几何特征。5x5卷积模块10输出的如下矩阵变化为m(28x28),ch(16)。第一瓶颈缩边模块21、第二瓶颈缩边模块22、第三瓶颈缩边模块23和第四瓶颈缩边模块24依次对图像矩阵的边缘特征元素层进行缩边,每次去掉边缘一层的特征元素,共去掉边缘四层的特征元素。相应地,图像矩阵从m(28x28),ch(16)变化为m(20x20),ch(16)。第一池化模块31通过池化对图像进行缩小,使得图像矩阵从m(20x20),ch(16)变化为m(10x10),ch(16)。第一1x1卷积模块41对图像矩阵进行卷积变换以改变通道的数量,将通道数量从16变化为32。第一瓶颈残差模块51、第二瓶颈残差模块52、第三瓶颈残差模块53依次对图像矩阵依次进行特征提取。此过程图像矩阵的大小不变。第二池化模块32通过池化对图像进行缩小,使得图像矩阵从m(10x10),ch(32)变化为m(5x5),ch(16)。第二1x1卷积模块42对图像矩阵进行卷积变换以改变通道的数量,将通道数量从32变化为64。此时图像矩阵为m(5x5),ch(64)。第四瓶颈残差模块54、第五瓶颈残差模块55对图像矩阵进行瓶颈残差处理,处理后的图像矩阵输入全连接层模块60。全连接层模块60将图像矩阵中的每个神经元与其前一层的所有神经元进行全连接,提取最终将图像分类的特征信息。全连接层模块60将整合后的图像识别信息进行输出。

[0126]

优选的,在构建神经元网络完成后,将若干训练样本输入神经元网络进行深度学习训练。在大量训练完成后,神经元网络能够准确识别包括环境的图像。并且,大量减少图像识别的计算量。

[0127]

实施例2

[0128]

本实施例是对前述实施例的进一步补充和说明,重复的内容不再赘述。

[0129]

本实施例提供一种包括周边环境的图像识别装置,其特征在于,装置至少包括:

[0130]

卷积模块,用于基于卷积层提取图像矩阵;

[0131]

缩边单元,用于将图像矩阵进行至少一次缩边处理;

[0132]

残差单元,用于将缩边处理后的图像矩阵进行至少一次非缩边的残差处理;

[0133]

全连接层模块,用于基于全连接层输出识别的图像数据。其中,所述缩边单元设置在所述卷积模块与所述残差单元之间。即所述卷积模块设置在数据输入端并与所述缩边单元连接,以将基于卷积层提取的图像矩阵输入缩边单元。所述缩边单元与所述残差单元连接,以将去掉边缘层矩阵元素的图像矩阵输入残差单元。所述残差单元与所全连接层模块连接,用于提取图像非边缘部分待识别区域的相对比较抽象的特征,并且将提取的非边缘部分的图像矩阵的相对比较抽象的特征输入全连接层模块。全连接层模块用于神经元网络的最后一层,以提取图像最终分类的特征信息并输出。

[0134]

与现有技术中的神经元网络相比,由于设置了缩边模块,本发明的神经元网络获得更好的图像识别效果的优势方面在于:第一,缩边模块的引入提取了图像边缘部分代表周边环境像素的特征信息,帮助提高对图像中物体的识别质量。第二,缩边模块的引入又使得这些图像边缘像素特征信息对应的参数数量小于图像中部关于待识别物体像素特征信息的参数数量,从而在不减少图像中部关于待识别物体像素特征信息参数数量的前提下,减少整个神经元网络的参数数量,提高网络的稳定性与识别质量。第三,缩边模块的引入又使得这些图像边缘像素特征信息的权重小于图像中部关于待识别物体像素特征信息的权重,从而提高了图像中部物体的识别率,并且减少了对图像边缘部分无关物体的误识别情况。

[0135]

优选的,本发明的各种模块,可以是服务器、处理机和/或集成芯片等硬件,也可以是载有相应计算处理方法的服务器。

[0136]

例如,卷积模块为具有卷积变换功能的服务器、处理器或集成芯片。缩边单元包括若干具有缩边处理功能的服务器、处理器或集成芯片。缩边模块为载有缩边计算方法的服务器、处理器或集成芯片。残差单元包括若干具有残差处理功能的服务器、处理器或集成芯片。残差模块为载有残差处理算法的服务器、处理器或集成芯片。全连接层模块为载有全连接层计算方法的服务器、处理器或集成芯片。

[0137]

缩边单元包括若干缩边模块。缩边模块的缩边方法包括:基于卷积层提取图像矩阵的中间和/或边缘特征元素,去掉图像矩阵的边缘k层的特征元素,缩边后,卷积层的卷积核的大小为:m=k*2 1。

[0138]

优选的,缩边模块包括基本缩边模块和瓶颈缩边模块。基本缩边模块至少包括两层m*m卷积层。基本缩边模块的缩边方法包括:g(x)=conv_2(σ(conv_1(x))) r(x)。其中,conv_1(x),conv_2(x)表示对图像矩阵x进行无padding的m*m卷积变换,m>1;σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。

[0139]

瓶颈缩边模块至少包括两层1*1卷积层和一层m*m卷积层。其中m*m卷积层设置在两个1*1卷积层之间。瓶颈缩边模块的缩边方法包括:g(x)=c_2(σ(conv(σ(c_1(x))))) r(x)。其中,conv(x)表示对图像矩阵x进行无padding的m*m卷积变换,m≥1;c_1(x)与c_2(x)

表示对图像矩阵x进行1*1积变换,σ(x)表示对图像矩阵x进行非线性变换;r(x)表示对图像矩阵x进行缩边。

[0140]

r(x)去掉图像矩阵的边缘k层的特征元素的函数为:

[0141]

即去掉原矩阵x的第1~k行,第1~k列,第(n-k 1)~n行和第(n-k 1)~n列。

[0142]

需要注意的是,上述具体实施例是示例性的,本领域技术人员可以在本发明公开内容的启发下想出各种解决方案,而这些解决方案也都属于本发明的公开范围并落入本发明的保护范围之内。本领域技术人员应该明白,本发明说明书及其附图均为说明性而并非构成对权利要求的限制。本发明的保护范围由权利要求及其等同物限定。本发明说明书包含多项发明构思,诸如“优选地”、“根据一个优选实施方式”或“可选地”均表示相应段落公开了一个独立的构思,申请人保留根据每项发明构思提出分案申请的权利。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。