1.本发明属于医学图像处理技术领域,具体涉及一种跨模态内镜图像转换及病灶区域分割方法。

背景技术:

2.随着医疗技术的快速发展,内窥镜已被广泛应用于临床诊断、治疗和手术领域。内窥镜可以直接插入体腔进行观察,显示内部器官的组织形态

1.。结肠癌和食管癌是世界上晚期死亡率较高的两种疾病。幸运的是,它们可以通过结肠镜检查和消化道镜检查在早期阶段进行诊断,从而可以有效地提高生存率

[2,3]

。

[0003]

在内窥镜成像技术中,白光内镜成像(wli)是最广泛使用的,可以很好地观察到血管结构和周围粘膜。然而,早期癌症的病变一般局限于粘膜层和粘膜下层。wli的诊断效果相对有限,显示出较低的敏感性和特异性。因此,窄带成像(nbi)成为早期癌症诊断的新趋势。nbi可以观察到病变边缘的边界,清楚地观察微血管的形态和分布。在nbi下,浅表血管呈棕色,中央内部血管呈蓝绿色,这增强了毛细血管和粘膜形态的可视化。它可以显著增加病变与周围粘膜之间的差异,从而提高对病变区域的判断准确度

[4]

。

[0004]

wli可以帮助医生定位病变,而nbi可以更好地看到病变的边界和范围。因此,如果可以同时看到wli和nbi,则可以发挥这两种模式的优势。事实上,由于nbi需要过滤掉很多光线,大多数内窥镜设备无法同时显示wli和nbi。因此通过深度学习技术,将wli转换成nbi具有很大的社会价值。

[0005]

在计算机视觉领域,图像到图像转换任务旨在学习不同域之间的映射,从而生成与目标相似的图像。一些深度学习方法取得了较大的进展,pix2pix

[5]

提出了一种基于像素级对应数据集的成对图像变换方法。由于难以获得成对数据集,cyclegan

[6]

提出了一种基于循环一致性的非成对图像变换方法。现有的图像转换方法只考虑风格转换,而没有关注两种模态之间的关联,更不能学习与医学信息相关的本征表示。因此,它们无法服务于医学下游任务,例如异常检测和病变区域分割。

[0006]

本发明基于无监督的本征表示学习方法,提出了一种新的wli图像到nbi图像的转换方法,充分学习两种模态之间的本征表示,能够将wli图像转换成高质量的nbi图像,为医生诊断提供有效的依据,同时能够用于病灶区域的分割,提高消化道疾病的检测率。

技术实现要素:

[0007]

为了克服现有技术的不足,本发明的目的在于提供一种基于无监督本征表示学习的跨模态内镜图像转换及病灶区域分割方法,以排除人为因素影响,实现wli内窥镜图像到nbi内窥镜图像的转换,同时进行病灶区域的分割。

[0008]

本发明提供的基于无监督本征表示学习的跨模态内镜图像转换及病灶区域分割方法,具体步骤为:

[0009]

(一)通过构建的基于本征表示学习的神经网络,将消化道内窥镜白光图像(wli)

转换成高质量的窄带图像(nbi);

[0010]

(二)通过一个空洞空间卷积池化金字塔网络(aspp),使用步骤(一)得到的本质特征提取器获取白光图像的本质特征,进行白光图像的病灶区域预测,得到病灶区域的分割结果。

[0011]

步骤(一)中,对于给定白光图像(wli),目标是生成相应的窄带图像(nbi)。以前的图像翻译方法通常考虑将跨模态图像转换作为风格转移任务。这样处理,虽然可以产生看似真实的结果,但可能会破坏原始的高层信息和图像的基本特征,而这些信息和特征不适用于医学图像。这不仅可能导致有用信息的丢失,也会影响下游任务或医生的判断。根据光模型,本发明假设内窥镜图像可以解耦为光学信息和本质特征。本发明通过采用神经网络,将另一模态的光学信息与本模态的本质特征进行重组,得到相应的跨模态图像。

[0012]

所述的神经网络是一个对称的网络结构。对于白光图像i

wli

,经过一个获取光学信息的特定模态特征编码器e

ms

,得到白光光学特征同时,白光图像i

wli

经过一个获取模态不变特征的模态不变特征编码器得到白光图像的本质特征同理,对于窄带图像i

nbi

经过一个获取光学信息的特定模态特征编码器e

ms

得到nbi的光学特征经过一个获取模态不变特征的模态不变特征编码器得到nbi图像的本质特征得到nbi图像的本质特征和组合输入白光图像生成器g

wli

中生成白光图像中生成白光图像和组合输入窄带图像生成器g

nbi

中生成窄带成像图像两个本质特征和分别输入本征生成器g

eigen

中,均可生成本征表示i

eigen

。和共享权重。将生成的白光图和nbi图像分别送入区分生成图像和真实图像的鉴别器d

gen

,得到一个分类结果,用于对抗学习生成逼真的医学图像。

[0013]

为了增加样本的多样性,以推广到不同的设备和模态,本发明采用的神经网络具有循环结构,即是一个循环网络,而不是使用像素级损失来约束变换后的图像。具体来说,循环方式如下:将生成的白光图像经过一个获取光学信息的特定模态特征编码器e

ms

得到新的白光光学特征经过获取模态不变特征的模态不变特征编码器得到新的白光图像本质特征同理,可得新的nbi图像的光学特征和本质特征和本质特征和组合输入白光图像生成器g

wli

中,生成得到白光图像和组合输入窄带图像生成器g

nbi

中,生成得到窄带像图像循环后得到的白光图像和窄带像图像应和原始输入的白光图像i

wli

和窄带图像i

nbi

一致,即可以使用像素级的损失来约束。

[0014]

进一步地,由于本质特征不能直接约束,为了更好地获取医学本质特征,本发明采用本征对抗学习策略来生成合理的本征图像。由于本征图像没有真实的地面真相,本发明采用循环的方式让网络学习一种高效合理的表示。首先,为了确保e

mi

提取有意义的本质表示,提出了一种本征图像生成器g

eigen

。希望e

mi

具有良好的通用性,可以观察到内窥镜图像的本质,从而使得跨模态、跨设备图像能保留更好的一致性。以wli为例,假设本质特征

可以有效地表达wli图像中的组织,我们可以得到一个本质图与输入wli具有相同的深度特征。类似地,将本质图送入e

mi

,可以编码出与输入wli具有相同本质特征的中间特征。仅由本质特征生成,不应包含任何光的信息。因此将本质图送入e

ms

可产生一个完整的零向量。

[0015]

进一步地,虽然循环网络可以学习一个合理的表达式,但深度神经网络在训练过程中往往会变得懒惰,从而使生成的本质图像不真实。此外,由于光照条件和显示设备的限制,我们无法获得真实的本质图像。因此,本发明构造了一个特征鉴别器d

eigen

,对生成的特征图像进行分类。由于本质图像展示了wli和nbi图像的真正共同特征,我们期望本征分布能够同时接近wli和nbi。d

eigen

将生成的特征图像与真实的wli和nbi图像区分开来,而g

eigen

用来生成真实的本质图像来迷惑鉴别器。通过对抗性学习,不仅可以获得更真实的本质图像,而且还可以鼓励e

mi

更好地捕获wli和nbi的本质特征,用于下游医疗任务。

[0016]

本发明中,在神经网络测试时,输入内镜白光图像i

wli

,经过本质特征提取器e

mi

提取本质特征,输入一张额外的内镜窄带成像图像,经过光学特征提取器,提取窄带光学特征,两个特征组合送入输入窄带图像生成器g

nbi

中,经过一次前向传播即可获得窄带成像图像

[0017]

本发明中,所述神经网络,其在训练过程中,使用的损失具体设计如下:

[0018]

两个本质特征和输入本征生成器g

eigen

中分别生成白光图像本征表示和窄带图像本征表示使用lpips损失来约束这两个本征表示,如下:

[0019][0020]

窄带成像分支中,光学特征和窄带本质特征组合输入白光图像生成器g

wli

中生成白光图像通过判别器d

gen

计算gan损失l

gan

。白光图像本征表示重新输入本质特征提取器e

mi

中再次提取本征表示与最初的白光图像光学特征组合输入白光图像生成器g

wli

中生成重构的白光图像在和原始白光图像i

wli

之间计算循环损失l

cycle

。生成的白光图像本征表示和窄带图像本征表示输入本征判别器d

eigen

中,计算一个模态不变性损失,如下:

[0021]

l

eigen

=e[logd

eigen

(i

wli

,i

nbi

)] e[log(1-d

eigen

(i

eigen

))],

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0022]

理想的本质特征不应该包含光学特征,因此,将生成的白光图像本征表示重新输入光学特征提取器中e

ms

提取该本质特征的光学特征计算特征损失,如下:

[0023][0024]

因此,神经网络训练时,最终的损失函数为:

[0025]

l=λ1l

perceptual

λ2l

eigen

λ3l

feature

λ4l

cycle

λ5l

gan

,

ꢀꢀꢀꢀꢀ

(4)

[0026]

其中,λi是用来平衡各个损失函数的权重,i=1,2,

…

,5;本发明中,根据经验,取λ1=10,λ2=1,λ3=1,λ4=10,λ5=1。

[0027]

步骤(二)中,使用步骤(一)得到的本质特征提取器获取白光图像的本质特征,本发明通过一个空洞空间卷积池化金字塔(aspp)网络

[7]

,对消化道病灶区域进行分割;具体过程如下:

[0028]

所述空洞空间卷积池化金字塔(aspp)网络连接在固定本质特征提取器e

mi

后面;aspp对所给定的输入以不同采样率的空洞卷积并行采样。内镜白光图像经过e

mi

提出本质特征,输入到aspp网络中,直接输出病灶区域的分割结果。不同于传统的语义分割网络,首先,本发明不是以图像作为分割网络的输入,而是使用本质特征提取器e

mi

提取到的中间特征。其次,本质特征提取器e

mi

是通过无监督的方式训练的,在训练语义分割任务时,本质特征提取器e

mi

的参数固定,这大大减少了训练的参数量和需要的时间。最后,由于无监督训练在泛化能力上的优势,本发明的语义分割网络可以在不经过任何重训或者微调的情况下,直接应用于别的数据集,实现较好的跨设备效果。

[0029]

本发明中,本质特征提取器可以将不同模态的图像映射到同一个特征空间里,因此,针对跨设备的图像,本发明可以生成相似的本质特征,使得本发明的病灶检测具有更好的跨设备效果。

[0030]

本发明中,使用白光图像转换网络可以得到转换后的窄带图像,使用网络生成的窄带图像和原始白光图像同时做分割网络的输入,可以输出精确的白光图像病灶分割结果。使用unet作为基础网络框架,一个编码器提取白光图像的特征,另一个编码器提取白光图像转换得到的窄带图像的特征,两个特征共同输入解码器中预测病灶区域的分割结果。

[0031]

本发明还提供首个多模态(wli和nbi)食管内窥镜视频数据集和像素级对齐的配对食管内窥镜图像数据集。所用数据集基于宾得(pentax)设备收集,包括34个视频和8700对wli和nbi图像,并且测试集所用图像对对应的病人与训练集不重合。数据集的构建具体包括:

[0032]

(1)数据对象的选择。缺乏大规模配对数据集是阻碍内窥镜图像转换任务的关键挑战之一。由于其特殊的结构设计,宾得内窥镜几乎可以实时同步显示wli和nbi。因此,我们从上海某大学附属医院收集了一个包含34个视频的食管内镜视频数据集,其中包括29个正常食管视频和5个食管异常食管的视频数据。时间跨度从2021年4月到5月。每个视频长度约为1至5分钟,异常食管视频长度一般更长些。正常视频的总持续时间为39分57秒,异常视频的总持续时间为12分52秒;

[0033]

(2)通过内窥镜检查法拍摄。所有患者在静脉麻醉后接受胃镜检查。拍摄工具采用宾得epk-i7000。内窥镜医生选择pentax的双模式,以实现wli和nbi双屏幕显示。通过回归式进行食管内窥镜检查并记录。内窥镜师从贲门(离门牙40厘米)开始检查,然后慢慢推动镜像,直到食管开始的地方(离门牙15厘米)。对于疑似病变,内窥镜检查人员可以反复观察和拍摄,并在不同角度进行多次拍摄。每组视频作为一个案例使用,并包含在分析中。请注意,为了确保录制视频的质量,内窥镜医生尽量避免拍摄时的失焦,并避免呼吸、心跳、粘液、气泡、血液等造成的干扰。如果视频模糊,则重新拍摄;

[0034]

(3)成对多模态数据集的构建。pentax的wli图像通过三种颜色信号读取,而nbi图像通过数字图像技术获取,这需要一些时间来处理。当镜头缓慢移动时,这种处理时间可以忽略不计,因此可以获得几乎对齐的交叉模式图像。然而,当镜头快速移动或患者的呼吸和心跳导致严重的食管抖动时,视频帧中显示的两种模式的图像将出现明显的偏差、模糊等。

因此,我们对采集到的视频帧进行预处理。

[0035]

首先,我们手动删除一些明显模糊的帧,以及每个视频的开始和结束帧。由于调试设备,这些帧通常会出现异常图像。其次,根据视频帧的成像原理和运动规律,wli将出现在同一位置的nbi之前。因此,比较wli和nbi的三个相邻帧,并使用图像残差来找到相应的wli和nbi图像。基于该视频数据集,使用11个正常和5个异常视频来平衡样本,并构建了一个包含8700对wli和nbi图像的成对多模态食管内窥镜数据集。wli和nbi图像几乎可以实现像素级对齐。据我们所知,这是首个多模态(wli和nbi)食管内窥镜视频数据集和像素级对齐的成对食管内窥镜图像数据集。

[0036]

本发明的有益效果在于:本发明设计了一个基于本征表示学习的图像转换网络,能够将消化道内窥镜wli图像转换成高质量的nbi图像,同时该nbi图像能够辅助wli图像实现病灶区域的分割。待测wli图像只需要和一张辅助的nbi图像经过一次前向传播,即可获得wli图像对应的nbi图像。该方法采用无监督学习的方式,拥有很好的泛化性,在不同内窥镜设备上效果优异。本发明能够为wli内窥镜设备提供额外的nbi成像,为医生诊断提供更好的参考,基于nbi图像辅助的病灶区域分割能够自动定位病灶区域,从而大大提高疾病诊断效率,降低发病率和死亡率。

附图说明

[0037]

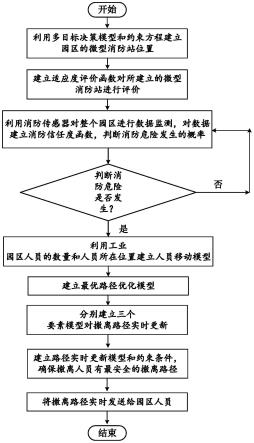

图1为本发明的网络框架图。

[0038]

图2为配对wli和nbi数据集展示。

[0039]

图3为同数据集wli和nbi的图像转换结果。

[0040]

图4为跨数据集wli和nbi的图像转换结果。

[0041]

图5为转换生成的nbi图辅助wli病变分割的结果。

[0042]

图6为本质特征用于病变分割的结果。

具体实施方式

[0043]

下面对本发明实施方案进行详细说明,但是本发明的保护范围不局限于所述实施例。

[0044]

采用图1中的网络结构,用6947对wli、nbi图像训练图像转换网络,获得训练好的图像转换网络和本质特征提取器。

[0045]

具体步骤为:

[0046]

(1)测试时,输入内镜白光图像i

wli

,经过本质特征提取器e

mi

提取本质特征,输入一张额外的内镜窄带成像图像,经过光学特征提取器,提取窄带光学特征,两个特征组合送入输入窄带图像生成器g

nbi

中,经过一次前向传播即可获得窄带成像图像

[0047]

(2)固定本质特征提取器e

mi

,在其后增加一个aspp网络,用于语义分割。内镜白光图像经过e

mi

提出本质特征,输入到aspp网络中,直接输出病灶区域的分割结果;

[0048]

(3)使用白光图像转换网络可以得到转换后的窄带图像,使用网络生成的窄带图像和原始白光图像同时做分割网络的输入,可以输出精确的白光图像病灶分割结果。使用unet作为基础网络框架,一个编码器提取白光图像的特征,另一个编码器提取白光图像转换得到的窄带图像的特征,两个特征共同输入解码器中预测病灶区域的分割结果。

[0049]

图3、图4为同数据集和跨数据集wli和nbi的图像转换结果。由于pix2pix和cyclegan方法直接将任务视为风格转换,没有考虑医学图像的本质特征,因此结果更像是带有一些人工伪影的色调转换,而没有生成有用的信息。因此,它们的跨数据集结果很差。本发明在数据集内和跨数据集实验中都具有稳定的性能。

[0050]

图5为转换生成的nbi图辅助wli病变分割的结果。本发明不仅可以生成更真实的nbi图像,还可以生成准确的病变分割结果。这表明我们生成的nbi图像最接近真实的nbi图像,内窥镜图像的重要信息可以通过特征提取来聚焦,从而有助于下游任务。

[0051]

图6为本质特征用于病变分割的结果。即使是有监督训练的端到端分割方法也难以区分某些扁平病变。在本发明中,内窥镜图像的特征表示是通过无监督训练获得的,它忽略了不同设备给医学图像带来的变化,并将所有图像映射到同一特征域。因此,即使没有微调,我们的本质特征也可以输出良好的病变预测结果。

[0052]

参考文献

[0053]

[1]mamonov a v,figueiredo i n,figueiredo p n,et al.automated polyp detection in colon capsule endoscopy[j].ieee transactions on medical imaging,2014,33(7):1488-1502.

[0054]

[2]ghatwaryn,zolgharni m,ye x.early esophageal adenocarcinoma detection using deep learning methods[j].international journal of computer assisted radiology and surgery,2019,14(4):611-621.

[0055]

[3]mesejop,pizarro d,abergel a,et al.computer-aided classification of gastrointestinal lesions in regular colonoscopy[j].ieee transactions on medical imaging,2016,35(9):2051.

[0056]

[4]gai w,jin x f,du r,et al.efficacy of narrow-band imaging in detecting early esophageal cancer and risk factors for its occurrence[j].indian journal of gastroenterology,2018.

[0057]

[5]p.isola,j.zhu,t.zhou and a.a.efros,image-to-image translation with conditional adversarial networks[c].2017ieee conference on computer vision and pattern recognition(cvpr),2017,pp.5967-5976,doi:10.1109/cvpr.2017.632.

[0058]

[6]j.zhu,t.park,p.isola and a.a.efros,unpaired image-to-image translation using cycle-consistent adversarial networks[c].2017ieee international conference on computer vision(iccv),2017,pp.2242-2251,doi:10.1109/iccv.2017.244.

[0059]

[7]he k,zhang x,ren s,et al.spatial pyramid pooling in deep convolutional networks for visual recognition[j].ieee transactions on pattern analysis and machine intelligence,2015。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。