1.本发明涉及养殖技术领域,尤其是一种基于深度学习的桑蚕检测方法。

背景技术:

2.蚕是蚕蛾的幼虫,蚕的各种产出如蚕丝,蚕砂均是化工、医药、食品工业的重要原料。蚕养殖业在中国例如广西有着非常重要的经济价值和现实意义。而当前蚕养殖业大部分以私人个体户养殖为主,各家蚕产量规模不同,蚕业养殖的过程中需要养殖户细心照料才能保证蚕的生长和蚕茧的产量,而这种传统的生产管理式制约了蚕养殖业智能化和产业化进程。蚕养殖业规范化产业化能大幅度确保蚕的存活率、蚕茧的生产量、提高蚕的经济效益。

3.目前的人工养殖对于桑蚕养殖依赖人力,费时费力,蚕养殖过程中需要投入大量精力,在蚕养殖的过程中,一般是通过人工的方式确定蚕所在位置和数量,以对蚕进行投喂合适数量的桑叶,这种传统的生产管理式制约了蚕养殖业智能化和产业化进程。

技术实现要素:

4.为了解决上述问题,本发明提供一种基于深度学习的桑蚕检测方法,能够自动检测饲养蚕所在位置和数量,以便于后续自动化养殖的开展。

5.为了实现上述目的,本发明采用的技术方案为:

6.一种基于深度学习的桑蚕检测方法,包括下述步骤,

7.s1、采集蚕场中饲养蚕的总体图像,且对所述总体图像中饲养蚕的位置信息及类别信息进行标记;

8.s2、获取每一所述饲养蚕的位置对应的区域图像,且在所述区域图像中标注对应的位置信息及类别信息;

9.s3、将所述区域图像的尺寸修改为统一像素后获得信息图像,将所述信息图像构建蚕数据集,且将所述蚕数据集划分为训练集及测试集;

10.s4、基于yolov4算法建立蚕检测模型,将所述训练集的信息图像输入至所述蚕检测模型进行训练,以获得训练模型;

11.s5、将所述测试集的信息图像输入至所述训练模型,获得所述训练模型的预测结果,以识别饲养蚕所在位置及数量。

12.进一步地,在步骤s4中,所述蚕检测模型包括主干特征提取网络、金字塔池化结构及特征融合层,

13.所述主干特征提取网络将输入的3通道图像通过卷积化输出16通道图像,且将所述16通道图像分别通过3

×

3及5

×

5的深度可分离卷积层进行提取图像特征,以获得特征图像;

14.所述金字塔池化结构用于所述特征图像的最大池化处理,以获得显著特征图像;

15.所述特征融合层用于通过所述特征图像与所述显著特征图像进行特征融合获得

检测头,将所述检测头的预测层所获得的锚框与k-means算法所获得的锚框相结合,对实际图片中的所述锚框的位置及所述锚框的高宽进行调整,且删除预测评分值低于设置标准值的锚框,以获得预测锚框,通过非极大值抑制nms将所述预测锚框进行结合,以获得预测结果。

16.进一步地,在步骤s3中,所述信息图像的像素为416

×

416。

17.进一步地,所述主干特征提取网络的特征图像获取步骤为:

18.a1、将416

×

416像素3通道的(416,416,3)图片进行1

×1×

16卷积始化,以获得(416,416,16)图片,将所述(416,416,16)图片通过3

×

3卷积标准化后进行激活函数计算,以获得(208,208,16)图片;

19.a2、将所述(208,208,16)图片分别输入3

×

3及5

×

5的深度可分离卷积层进行图像特征的提取,以输出像素为13

×

13、26

×

26、52

×

52的所述特征图像,且所述特征图像分别为13

×

13像素160通道的(13,13,160)图片、26

×

26像素112通道的(26,26,112)图片、52

×

52像素40通道的(52,52,40)图片;

20.所述金字塔池化结构的显著特征图像获取步骤为:将所述(13,13,160)图片通过四种不同大小的1、5、9、11的卷积核进行最大池化层融合图像特征,以获得的(13,13,160)池化特征图片为所述显著特征图像;

21.所述特征融合层的预测步骤为:

22.b1、将所述(13,13,160)池化特征图片进行上采样,以获得(26,26,160)图片及(52,52,160)图片,将所述(26,26,160)图片及所述(52,52,160)图片与所述(26,26,112)图片及(52,52,40)图片依次进行特征相加、上采样、卷积计算获得像素为(52,52)特征图片及(26,26)特征图片,且将较大像素的所述(52,52)特征图片作为大尺寸检测头;

23.b2、将所述(52,52)特征图片进行下采样后与所述(26,26)特征图片进行卷积计算及特征融合,以获得(26,26)卷积特征图片为中尺寸检测头;

24.b3、将所述(13,13,160)池化特征图片与所述(26,26)卷积特征图片进行下采样后的特征图片进行特征相加及卷积计算,以获得(13,13)特征图片作为小尺寸检测头;

25.b4、将所述大尺寸检测头、所述中尺寸检测头及所述小尺寸检测头的预测层所获得的锚框与k-means算法所获得的锚框相结合,对实际图片中的所述锚框的位置及所述锚框的高宽进行调整,且删除预测评分值低于设置标准值的锚框,以获得所述大尺寸检测头、所述中尺寸检测头及所述小尺寸检测头的预测层的预测锚框,通过非极大值抑制nms将所述大尺寸检测头、所述中尺寸检测头及所述小尺寸检测头的所述预测锚框进行结合,以获得预测结果。

26.进一步地,在步骤a1中,所述(416,416,16)图片通过图片卷积标准化进行3

×

3卷积标准化,其中,所述图片卷积标准化公式为:

[0027][0028]

式中,i输出图片尺寸,w为输入图片尺寸,f为卷积核大小,p为填充值,s为步长;

[0029]

所述激活函数为:

[0030][0031]

式中,x为函数输入,β为调整斜率常数,relu6的表达式为min(max(0,x),6)。

[0032]

进一步地,在步骤s3中,所述训练集与所述测试集的比例为8:2。

[0033]

进一步地,在步骤s4中,分别对所述训练集及所述测试集设置索引文件,以使所述蚕检测模型根据所述索引文件获得对应的所述训练集或所述测试集内的信息图像;所述索引文件包括所述信息图像的蚕位置信息及类别信息。

[0034]

进一步地,在步骤s4中,通过voc数据集对所述蚕检测模型加载预训练模型权重。

[0035]

进一步地,在步骤s4中,所述蚕检测模型的初始学习率为0.001,采用训练轮次为100。

[0036]

本发明的有益效果是:

[0037]

通过yolov4算法建立蚕检测模型,融合5

×

5深度可分离卷积层进行5

×

5深度卷积的特征提取,通过5

×

5深度卷积提取的特征信息与3

×

3深度卷积提取的信息进行融合,丰富其提取的特征信息提高桑蚕检测精度,同时使得蚕检测模型轻量化,实现了蚕检测模型大小能满足密集桑蚕数据集在移动端和嵌入端应用的同时提高其检测精度。而且通过检测头的预测层所获得的锚框与k-means算法所获得的锚框进行结合,能够加强图像特征的提取。本发明通过深度学习检测桑蚕所在位置和数量,与其他相关养殖设备配合完成桑蚕的规范化智能化自动喂养养殖,提高蚕的养殖率、存活率。

附图说明

[0038]

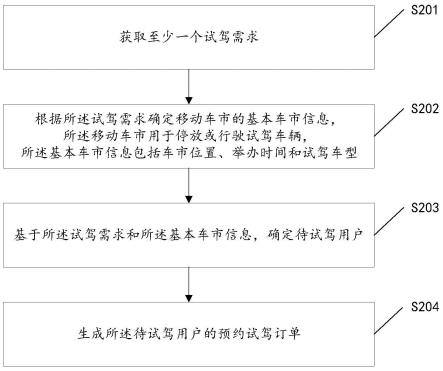

图1是本发明一较佳实施方式的基于深度学习的桑蚕检测方法的流程图。

[0039]

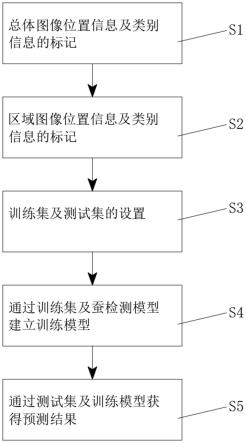

图2是本发明一较佳实施方式的基于深度学习的桑蚕检测方法的蚕检测模型框架图。

[0040]

图3是本发明一较佳实施方式的基于深度学习的桑蚕检测方法的蚕检测模型识别分类过程图。

具体实施方式

[0041]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0042]

需要说明的是,当组件被称为“固定于”另一个组件,它可以直接在另一个组件上或者也可以存在居中的组件。当一个组件被认为是“连接”另一个组件,它可以是直接连接到另一个组件或者可能同时存在居中组件。当一个组件被认为是“设置于”另一个组件,它可以是直接设置在另一个组件上或者可能同时存在居中组件。本文所使用的术语“垂直的”、“水平的”、“左”、“右”以及类似的表述只是为了说明的目的。

[0043]

除非另有定义,本文所使用的所有的技术和科学术语与属于本发明的技术领域的技术人员通常理解的含义相同。本文中在本发明的说明书中所使用的术语只是为了描述具

体的实施例的目的,不是旨在于限制本发明。本文所使用的术语“及/或”包括一个或多个相关的所列项目的任意的和所有的组合。

[0044]

请同时参见图1至图3,本发明较佳实施方式的基于深度学习的桑蚕检测方法,包括下述步骤,

[0045]

s1、采集蚕场中饲养蚕的总体图像,且对总体图像中饲养蚕的位置信息及类别信息进行标记。本实施例的类别信息为饲养蚕的蚕龄信息。

[0046]

s2、获取每一饲养蚕的位置对应的区域图像,且在区域图像中标注对应的位置信息及类别信息。

[0047]

s3、将区域图像的尺寸修改为统一像素后获得信息图像,本实施例的信息图像的像素为416

×

416。将信息图像构建蚕数据集,且将蚕数据集划分为训练集及测试集,训练集与测试集的比例为8:2

[0048]

s4、基于yolov4算法建立蚕检测模型,将训练集的信息图像输入至蚕检测模型进行训练,以获得训练模型。

[0049]

在步骤s4中,分别对训练集及测试集设置索引文件,以使蚕检测模型根据索引文件获得对应的训练集或测试集内的信息图像;索引文件包括信息图像的蚕位置信息及类别信息。

[0050]

其中,train.txt文件是训练集图像的索引文件,test.txt是测试集文件的索引文件,模型在进行训练和测试的时候会根据该文件找到相应的图像;xml文件是图像的注释文件,其蕴含了图像里目标的位置信息和类别信息。

[0051]

本实施例中,通过voc数据集对蚕检测模型加载预训练模型权重,以加快模型的训练速度,同时能提升一定的精度。

[0052]

本实施例的蚕检测模型的初始学习率为0.001,采用训练轮次为100。

[0053]

s5、将测试集的信息图像输入至训练模型,获得训练模型的预测结果,以识别饲养蚕所在位置及数量。

[0054]

本实施例中,蚕检测模型包括主干特征提取网络、金字塔池化结构及特征融合层。

[0055]

主干特征提取网络将输入的3通道图像通过卷积化输出16通道图像,且将16通道图像分别通过3

×

3及5

×

5的深度可分离卷积层进行提取图像特征,以获得特征图像。

[0056]

主干特征提取网络的特征图像获取步骤为:

[0057]

a1、将416

×

416像素3通道的(416,416,3)图片进行1

×1×

16卷积始化,以获得(416,416,16)图片,将(416,416,16)图片通过3

×

3卷积标准化后进行激活函数计算,以获得(208,208,16)图片。

[0058]

在a1中,(416,416,16)图片通过图片卷积标准化进行3

×

3卷积标准化,其中,图片卷积标准化公式为:

[0059][0060]

式中,i输出图片尺寸,w为输入图片尺寸,f为卷积核大小,p为填充值,s为步长;

[0061]

激活函数为:

[0062][0063]

式中,x为函数输入,β为调整斜率常数,relu6的表达式为min(max(0,x),6)。

[0064]

本实施例的激活函数由swish函数优化而来的h-swish函数,其中步长设置为2,填充为1,输出通道数为16。使用hswish函数能保持与swish函数相同的精度,并减小移动端的计算量。

[0065]

a2、将(208,208,16)图片分别输入3

×

3及5

×

5的深度可分离卷积层进行图像特征的提取,以输出像素为13

×

13、26

×

26、52

×

52的特征图像,且特征图像分别为13

×

13像素160通道的(13,13,160)图片、26

×

26像素112通道的(26,26,112)图片、52

×

52像素40通道的(52,52,40)图片。

[0066]

本实施例的深度可分离卷积可通过降低模型的参数量,来降低模型的内存大小。而且添加5

×

5的深度可分离卷积层进行模型优化。利用多尺度的深度可分离卷积层加强模型对于特征信息的提取来弥补损失的精度,

[0067]

金字塔池化结构用于特征图像的最大池化处理,以获得显著特征图像。

[0068]

金字塔池化结构的显著特征图像获取步骤为:将(13,13,160)图片通过四种不同大小的1、5、9、11的卷积核进行最大池化层融合图像特征,以获得的(13,13,160)池化特征图片为显著特征图像,实现了增加感受野,分离出上下文特征。

[0069]

特征融合层用于通过特征图像与显著特征图像进行特征融合获得检测头,将检测头的预测层所获得的锚框与k-means算法所获得的锚框相结合,对实际图片中的锚框的位置及锚框的高宽进行调整,且删除预测评分值低于设置标准值的锚框,以获得预测锚框,通过非极大值抑制nms将预测锚框进行结合,以获得预测结果。

[0070]

特征融合层的预测步骤为:

[0071]

b1、将(13,13,160)池化特征图片进行上采样,以获得(26,26,160)图片及(52,52,160)图片,将(26,26,160)图片及(52,52,160)图片与(26,26,112)图片及(52,52,40)图片依次进行特征相加、上采样、卷积计算获得像素为(52,52)特征图片及(26,26)特征图片,且将较大像素的(52,52)特征图片作为大尺寸检测头。

[0072]

b2、将(52,52)特征图片进行下采样后与(26,26)特征图片进行卷积计算及特征融合,以获得(26,26)卷积特征图片为中尺寸检测头。

[0073]

b3、将(13,13,160)池化特征图片与(26,26)卷积特征图片进行下采样后的特征图片进行特征相加及卷积计算,以获得(13,13)特征图片作为小尺寸检测头。

[0074]

b4、将大尺寸检测头、中尺寸检测头及小尺寸检测头的预测层所获得的锚框与k-means算法所获得的锚框相结合,对实际图片中的锚框的位置及锚框的高宽进行调整,且删除预测评分值低于设置标准值的锚框,以获得大尺寸检测头、中尺寸检测头及小尺寸检测头的预测层的预测锚框,通过非极大值抑制nms将大尺寸检测头、中尺寸检测头及小尺寸检测头的预测锚框进行结合,以获得预测结果,通过预测结果根据信息图像的位置信息及类别信息,以对蚕的位置及类别进行识别。

[0075]

本实施例中,k-means算法将数据集中所有图片的矩形框提取,通过数据处理得到所有训练数据矩形框的高宽数据,在这些数据中随机选取9个作为聚类中心,其余所有的矩

形框根据这9个聚类中心的高宽,依据各个锚框坐标点与聚类中心坐标点之间的交并比的值(iou)作为中心距离进行计算。将所有矩形框与当前9个聚类中心距离最近的聚类中心作为对应的锚框分类,分类完后将9个分类数据的中心坐标更新为下一次计算的聚类中心,不断重复上述操作。直到9个聚类中心不变,即可得到适合于密集物体图像的9个锚框,以此加强蚕检测模型对图像特征的提取。

[0076]

本实施例中,将预测结果使用训练模型进行map值计算得出蚕的识别准确率。检测精度由ap值和map值表示。ap值计算公式如下所示:

[0077][0078][0079][0080]

式中,tp表示真实框标注的,被模型正确识别出来的物体候选框;tn代表被模型识别的非物体候选框;fp表示被真实框标注的,未被模型检测的物体候选框;fn表示未被模型识别的非物体候选框。

[0081]

map值为不同类ap值总和的平均值。map计算为:

[0082][0083]

式中m为数据集中类别个数,apm代表模型对于某类识别物体的检测精度,而map代表模型对于数据集中单类或多类识别物体的总体检测精度。

[0084]

本实施例属于单目标识别,数据集属于小规模数据集,并且目标环境复杂,蚕密集高,识别难度大。在本实施例的基于深度学习的桑蚕检测方法中map达到了67%(复杂密集蚕检测),可以满足基本的识别需求。

[0085]

本实施例通的蚕识别模型加入了多尺度特征融合方法完成了对voc2007通用物,密集桑蚕的检测和识别。证明了增加不同大小的卷积核提取密集特征信息提高精度的可行性,蚕识别模型在voc2007通用数据集上与yolov4、mobilenetv3-yolov4性能精度检测速度上差异小,对于常见常用物体识别检测有着较好的稳定性,在密集桑蚕识别中对比mobilenetv3-yolov4精度提高1.82%,在模型大小方面对比yolov4减少74%,蚕识别模型相比mobilenetv3-yolov4在稳定性和对密集物体桑蚕的检测性能方面更适用于移动端和嵌入式端。本实施例蚕识别模型所对蚕的检测识别方法能贴近蚕场生产实际,该模型可用于蚕场的密集成年桑蚕的目标检测中,与其他相关养殖设备配合完成桑蚕的规范化智能化自动喂养养殖,对于减少蚕养殖过程中的人工精细化流程,减少大型监控设备成本,提高蚕的养殖率,存活率,提高蚕产业的经济效益有一定作用。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。