1.本发明涉及学习装置以及学习方法。

背景技术:

2.近年来,已知有将由照相机拍摄到的图像输入到深度神经网络(dnn)并通过dnn的推论处理来识别图像内的物标的技术。

3.为了提高dnn进行的物标识别的鲁棒性,需要实施使用了来自不同域的庞大且变化多样的数据集的学习(训练)。通过使用了庞大且变化多样的数据集的学习,dnn能够提取并非域所固有的鲁棒的图像特征,但从数据收集成本、庞大的处理成本的观点出发,这样的方法大多是困难的。

4.另一方面,研究了使用来自一个域的数据集使dnn学习来提取鲁棒特征的技术。例如,在用于物标识别的dnn中,有时除了本来应该关注的特征之外,还考虑与本来应该关注的特征不同的特征(被偏置的特征)来进行学习。在该情况下,在对新的图像数据进行了识别处理时,有时受到该被偏置的特征的影响而无法输出正确的识别结果(即无法提取鲁棒的特征)。

5.为了解决这样的问题,在非专利文献1中提出了如下技术:使用容易提取图像的局部特征的模型(dnn)来提取图像的被偏置的特征(在非专利文献1中为纹理的特征),使用hsic(hilbert-schmidt independence criterion,希尔伯特-施密特独立性准则)基准来从图像的特征中去除该被偏置的特征。

6.现有技术文献

7.非专利文献

8.非专利文献1:hyojin bahng,外4名,“learning de-biased representations with biased representations”,arxiv:1910.02806v2[cs.cv],2020年3月2日

技术实现要素:

[0009]

发明所要解决的问题

[0010]

在非专利文献1中提出的技术中,以被偏置的特征是纹理的特征为前提,通过设计来确定用于提取纹理的特征的特定的模型。即,在非专利文献1中,提出了在作为被偏置的特征而处理纹理的特征的情况下专用的技术。另外,在非专利文献1中,为了去除被偏置的特征而使用hsic基准,没有考虑用于去除被偏置的特征的其他方法。

[0011]

本发明是鉴于上述问题而完成的,其目的在于提供一种在物标识别中能够相对于域自适应地提取鲁棒的特征的技术。

[0012]

用于解决问题的手段

[0013]

根据本发明,提供了一种学习装置,所述学习装置包含处理机构,其特征在于,所述处理机构包含:

[0014]

第一神经网络,其提取图像数据内的物标的第一特征;

[0015]

第二神经网络,其使用与所述第一神经网络不同的网络结构来提取所述图像数据内的所述物标的第二特征;以及

[0016]

学习辅助神经网络,其从由所述第一神经网络提取出的所述第一特征中提取第三特征,

[0017]

所述第二特征和所述第三特征是相对于所述物标被偏置的特征,

[0018]

所述处理机构使所述学习辅助神经网络学习,以使得由所述第二神经网络提取出的所述第二特征与由所述学习辅助神经网络提取出的所述第三特征接近,并且,所述处理机构使所述第一神经网络学习,以使在所述第一神经网络提取的所述第一特征中出现的所述第三特征减少。

[0019]

另外,根据本发明,提供了一种学习装置,所述学习装置包含第一神经网络、第二神经网络、学习辅助神经网络以及损失输出部,其特征在于,

[0020]

所述第一神经网络从图像数据中提取该图像数据的特征,

[0021]

网络结构的规模小于所述第一神经网络的所述第二神经网络从所述图像数据中提取该图像数据的特征,

[0022]

所述学习辅助神经网络从由所述第一神经网络提取出的图像数据的特征中提取包含所述图像数据的偏置因子在内的特征,

[0023]

所述损失输出部对由所述第二神经网络提取出的特征与由所述学习辅助神经网络提取出的包含所述偏置因子在内的特征进行比较而输出损失。

[0024]

进一步地,根据本发明,提供了一种学习装置,所述学习装置包含处理机构,其特征在于,所述处理机构包含:

[0025]

第一神经网络,其提取图像数据内的物标的特征并对所述物标进行分类;

[0026]

学习辅助神经网络,其进行学习,以从由所述第一神经网络提取的特征所包含的用于对所述物标进行分类而本来应该关注的特征、以及与所述本来应该关注的特征不同的被偏置的特征中,提取所述被偏置的特征;以及

[0027]

第二神经网络,其提取所述图像数据内的所述物标的被偏置的特征,

[0028]

所述处理机构使所述学习辅助神经网络学习,以使得由所述学习辅助神经网络提取的所述被偏置的特征与由所述第二神经网络提取的所述被偏置的特征之差变小,并且,所述处理机构使所述第一神经网络学习,以使得从所述图像数据中提取使所述差变大的特征作为所述学习辅助神经网络所提取的结果。

[0029]

另外,根据本发明,提供了一种学习方法,所述学习方法在包含处理机构的学习装置中执行,其特征在于,

[0030]

所述处理机构包含:第一神经网络,其提取图像数据内的物标的第一特征;第二神经网络,其使用与所述第一神经网络不同的网络结构来提取所述图像数据内的所述物标的第二特征;以及学习辅助神经网络,其从由所述第一神经网络提取出的所述第一特征中提取第三特征,所述第二特征和所述第三特征是相对于所述物标被偏置的特征,

[0031]

所述学习方法具有处理步骤,在所述处理步骤中,通过所述处理机构使所述学习辅助神经网络学习,以使得由所述第二神经网络提取出的所述第二特征与由所述学习辅助神经网络提取出的所述第三特征接近,并且,通过所述处理机构使所述第一神经网络学习,以使得在所述第一神经网络提取的所述第一特征中出现的所述第三特征减少。

[0032]

发明效果

[0033]

根据本发明,在物标识别中,能够相对于域自适应地提取鲁棒的特征。

附图说明

[0034]

图1是表示实施方式1所涉及的信息处理服务器的功能构成例的框图。

[0035]

图2是用于说明在物标识别处理中包含被偏置的特征(偏置因子的特征)的特征提取的问题的图。

[0036]

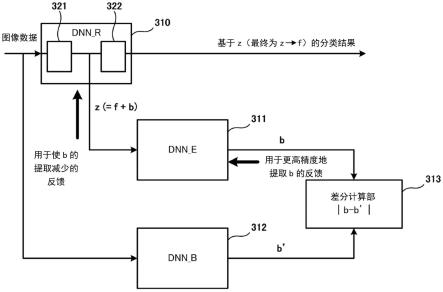

图3a是说明实施方式1所涉及的模型处理部的深度神经网络(dnn)的学习阶段中的构成例的图。

[0037]

图3b是说明实施方式1所涉及的模型处理部的深度神经网络的推论阶段中的构成例的图。

[0038]

图3c是表示实施方式1所涉及的模型处理部的输出的一个例子的图。

[0039]

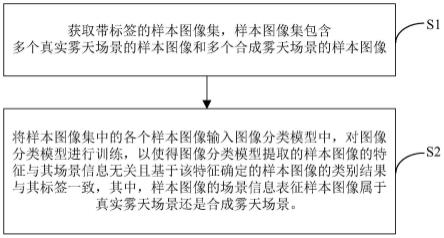

图4是表示实施方式1所涉及的学习数据的一个例子的图。

[0040]

图5a、图5b是表示实施方式1所涉及的模型处理部中的学习阶段的处理的一系列动作的流程图。

[0041]

图6是表示实施方式1所涉及的模型处理部中的推论阶段的处理的一系列动作的流程图。

[0042]

图7是表示实施方式2所涉及的车辆的功能构成例的框图。

[0043]

图8是表示实施方式2所涉及的用于车辆的行驶控制的主要构成的图。

[0044]

附图标记说明

[0045]

100:信息处理服务器;113:图像数据获取部;114:模型获取部;310:dnn_r;311:dnn_e;312:dnn_b;313:差分计算部。

具体实施方式

[0046]

以下,参照附图对实施方式进行详细说明。需要说明的是,以下的实施方式并不限定技术方案所涉及的发明,另外,实施方式中说明的特征的全部组合并不限定为发明所必须的内容。在实施方式中说明的多个特征中的两个以上的特征也可以任意地组合。另外,对相同或同样的构成标注相同的附图标记,并省略重复的说明。

[0047]

(实施方式1)

[0048]

《信息处理服务器的构成》

[0049]

接下来,参照图1对信息处理服务器的功能构成例进行说明。需要说明的是,参照以后的图进行说明的各个功能块可以被合并或分离,另外,说明的功能也可以通过其他的块来实现。另外,作为硬件说明的部件可以通过软件来实现,反之亦然。

[0050]

控制部104例如包含cpu110、ram111、rom112,对信息处理服务器100的各部分的动作进行控制。控制部104通过cpu110将存储在rom112或存储部103中的计算机程序在ram111中加载并执行,来发挥构成控制部104的各部分的功能。控制部104除了cpu110之外,还可以包含gpu、或者适于执行机器学习的处理、神经网络的处理的专用的硬件。

[0051]

图像数据获取部113获取从用户操作的信息处理装置、车辆等外部装置发送的图像数据。图像数据获取部113将所获取的图像数据存储在存储部103中。图像数据获取部113

所获取的图像数据既可以用于后述的学习数据,也可以为了根据新的图像数据得到推论结果而被输入到推论阶段的学习完毕模型。

[0052]

模型处理部114包含本实施方式所涉及的学习模型,执行该学习模型的学习阶段的处理、推论阶段的处理。学习模型例如进行使用了后述的深度神经网络(dnn)的深度学习算法的运算,进行识别图像数据所包含的物标的处理。物标可以包含图像内所包含的行人、车辆、两轮车、招牌、标识、道路、在道路上以白色或黄色描绘的线等。

[0053]

dnn通过进行后述的学习阶段的处理而成为学习完毕的状态,通过将新的图像数据输入到学习完毕的dnn,能够进行针对新的图像数据的物标的识别(推论阶段的处理)。在信息处理服务器100中执行使用了学习完毕模型的推论处理的情况下,执行推论阶段的处理。需要说明的是,信息处理服务器100既可以在信息处理服务器100侧执行学习到的学习完毕的模型,将推论结果发送到车辆、信息处理装置等外部装置,也可以根据需要在车辆、信息处理装置中进行基于学习模型的推论阶段的处理。在车辆、信息处理装置中进行基于学习模型的推论阶段的处理的情况下,模型提供部115向车辆、信息处理装置等外部装置提供学习完毕模型的信息。

[0054]

当在车辆、信息处理装置中执行使用了学习完毕模型的推论处理的情况下,模型提供部115将在信息处理服务器100中学习到的学习完毕模型的信息向车辆、信息处理装置发送。例如,当车辆从信息处理服务器100接收学习完毕模型的信息时,将车辆内的学习完毕模型更新为最新的学习模型,使用最新的学习模型来进行物标的识别处理(推论处理)。该学习完毕模型的信息包含该学习模型的版本信息、学习完毕的神经网络的权重系数的信息等。

[0055]

需要说明的是,信息处理服务器100一般能够使用与车辆等相比丰富的计算资源。另外,通过接收、蓄积由各种车辆拍摄到的图像数据,能够收集多种多用的状况下的学习数据,能够进行与更多的状况对应的学习。因此,如果能够将使用在信息处理服务器100上收集到的学习数据而学习到的学习完毕模型提供给车辆、外部的信息处理装置,则针对车辆、信息处理装置中的图像的推论结果变得更加鲁棒。

[0056]

学习数据生成部116基于来自学习数据的管理者用户操作的外部的预定的信息处理装置的访问,生成使用了存储部103中存储的图像数据的学习数据。例如,学习数据生成部116接收存储于存储部103的图像数据所包含的物标的类别、位置的信息(即,表示识别对象的物标的正解的标签),并将接收到的标签与图像数据建立关联地存储于存储部103。与图像数据相关联的标签例如以表的形式作为学习数据被保持在存储部103。稍后将参照图4描述学习数据的细节。

[0057]

通信部101例如是包含通信用电路等的通信设备,例如通过因特网等网络与车辆、信息处理装置等外部装置进行通信。通信部101除了接收从车辆、信息处理装置等外部装置发送的实际图像之外,还向车辆发送在预定的时机或周期成为学习完毕的学习完毕模型的信息。电源部102向信息处理服务器100内的各部分供给电力。存储部103是硬盘、半导体存储器等非易失性存储器。存储部103存储后述的学习数据、cpu110执行的程序、其他数据等。

[0058]

《模型处理部中的学习模型的例子》

[0059]

接下来,对本实施方式所涉及的模型处理部114中的学习模型的例子进行说明。首先,参照图2,对物标识别处理中的包含偏置因子的特征在内的特征提取的问题进行说明。

在该图2中,例示了在物标识别处理中本来应该关注的特征为形状的情况下,颜色成为偏置因子的情况。例如,图2所示的dnn是对图像数据内的物标是卡车还是乘用车进行推论的dnn,使用黑色卡车的图像数据、红色乘用车的图像数据进行学习。即,该dnn除了本来应该关注的形状的特征之外,还考虑与本来应该关注的特征不同的颜色的特征(被偏置的特征)来进行学习。在这样的dnn中,在推论阶段输入黑色卡车的图像数据、红色乘用车的图像数据的情况下,能够输出正确的推论结果(卡车或乘用车)。关于这样的推论结果,存在按照本来应该关注的特征输出正确的推论结果的情况,也存在按照与本来应该关注的特征不同的颜色的特征输出推论结果的情况。

[0060]

在dnn按照颜色的特征输出推论结果的情况下,如果将红色卡车的图像数据输入到该dnn,则推论结果成为乘用车,如果将黑色乘用车的图像数据输入到该dnn,则推论结果成为卡车。另外,在输入既不是黑色也不是红色的未知颜色的车辆的图像的情况下,不清楚得到怎样的分类结果。

[0061]

另一方面,在dnn根据形状的特征输出推论结果的情况下,如果将红色卡车的图像数据输入到该dnn,则推论结果成为卡车,如果将黑色乘用车的图像数据输入到该dnn,则推论结果成为乘用车。另外,在输入既不是黑色也不是红色的未知颜色的卡车的图像的情况下,推论结果成为卡车。这样,在dnn包含被偏置的特征而被学习的情况下,在进行针对新的图像数据的推论处理时无法输出正确的推论结果(即,无法提取鲁棒的特征)。

[0062]

为了能够降低这样的被偏置的特征的影响而对本来应该关注的特征进行学习,在本实施方式中,模型处理部114由图3a所示的dnn构成。具体而言,模型处理部114包含dnn_r310、dnn_e311、dnn_b312以及差分计算部313。

[0063]

dnn_r310是由一个以上的深度神经网络(dnn)构成的dnn,从图像数据中提取特征,输出图像数据所包含的物标的推论结果。在图3a所示的例子中,dnn_r310在内部具有两个dnn,即dnn321和dnn322。dnn321是对图像数据的特征进行编码的编码器的dnn,输出从图像数据中提取的特征(例如设为z)。该特征z包含本来应该关注的特征f和被偏置的特征b。dnn322是基于从图像数据中提取的特征z(通过学习最终成为z

→

f)对物标进行分类的分类器。

[0064]

dnn_r310例如输出图3c中作为一个例子而表示的推论结果的数据。图3c所示的推论结果的数据例如输出图像内的物标的有无(例如,在存在物标的情况下设定为1,在不存在物标的情况下设定为0)、物标区域的中心位置、大小。另外,针对每个物标类别包含其概率。例如,在识别出的物标是卡车、乘用车、铲车等的概率为0至1的范围内输出。

[0065]

需要说明的是,图3c所示的数据的例子示出了针对图像数据检测出一个物标的情况,但也可以针对每个预定的区域根据物标的有无而包含物体类别的概率在内的数据。

[0066]

另外,dnn_r310例如可以将图4所示的数据和图像数据用作学习数据来进行学习阶段的处理。图4所示的数据例如包含确定图像数据的标识符和对应的标签。标签表示针对图像id所指的图像数据所包含的物标的正解。标签例如表示对应的图像数据所包含的物标的类别(例如卡车、乘用车、铲车等)。另外,学习数据可以包含物标的中心位置以及大小的数据。dnn_r310被学习为当输入学习数据的图像数据并输出图3c所示的推论结果的数据时,对推论结果的数据与学习数据的标签进行比较,使该推论结果的误差最小化。但是,dnn_r310的学习被约束为使后述的特征的损失函数最大化。

[0067]

dnn_e311是从由dnn_r310输出的特征z(z=本来应该关注的特征f 被偏置的特征b)中提取被偏置的特征b的dnn。dnn_e311作为辅助dnn_r310的学习的学习辅助神经网络而发挥功能。dnn_e311被学习为通过在学习阶段与dnn_r310对抗地进行学习,能够更高精度地提取被偏置的特征b。另一方面,dnn_r310通过与dnn_e311对抗地学习,能够去除被偏置的特征b而更高精度地提取本来应该关注的特征f。即,从dnn_r310输出的特征z无限接近f。

[0068]

dnn_e311在内部具有能够进行对抗学习的例如公知的grl(gradient reversal layer,梯度反转层)。grl是在对dnn_e311和dnn_r310进行基于反向传播的权重系数的变更时,使针对dnn_e311的梯度的符号反转的层。由此,在对抗学习中,使dnn_e311的权重系数的梯度与dnn_r310的权重系数的梯度相关联地变动,能够使双方的神经网络同时学习。

[0069]

dnn_b312是输入图像数据并基于被偏置的特征来推论分类结果的dnn。dnn_b312被学习为进行与dnn_r310相同的推论任务(例如物标的分类)。即,dnn_b312被学习为使与dnn_r310所使用的目标损失函数相同的目标损失函数(例如物标的推论结果与学习数据的差异最小那样的损失函数)最小化。

[0070]

但是,被学习为在dnn_b312的内部提取被偏置的特征,并基于所提取的特征输出最佳的分类结果。在本实施方式中,向成为学习完毕的状态的dnn_b312输入图像数据,dnn_b312取出在内部提取的被偏置的特征b’。

[0071]

在使dnn_r310以及dnn_e311学习之前,dnn_b312就完成了其学习。因此,dnn_b312发挥如下功能:在dnn_r310以及dnn_e311的学习过程中,提取图像数据所包含的正确的偏置因子(被偏置的特征b’),并提供给dnn_e311。dnn_b312具有与dnn_r310不同的网络结构,构成为提取与dnn_r310提取的特征不同的特征。例如,dnn_b312构成为包含网络结构的规模比dnn_r所具有的神经网络小(参数数量少、复杂性低)的结构的神经网络,提取图像数据的表面特征(偏置因子)。也可以将dnn_e311的结构设为对分辨率比dnn_r310低的图像数据进行处理的结构,或者设为层数比dnn_r310少的结构。在dnn_e311中,例如提取图像内的主要颜色作为被偏置的特征。或者,为了将图像内的纹理的特征作为被偏置的特征来提取,也可以使其内核尺寸比dnn_r310小,以提取图像数据的局部的特征的方式构成dnn_b312。

[0072]

需要说明的是,虽然在图3a中未明示,但dnn_b312可以与dnn_r310的例子同样地在内部具备两个dnn。例如,也可以包含提取被偏置的特征b’的编码器的dnn、和基于被偏置的特征b’来推论分类结果的分类器的dnn。此时,dnn_b312的编码器dnn构成为通过与dnn_r310的编码器dnn不同的网络结构,从图像数据中提取(与dnn_r310的编码器dnn)不同的特征。

[0073]

差分计算部313将从dnn_b312输出的被偏置的特征b’与从dnn_e311输出的被偏置的特征b进行比较来计算差分。由差分计算部313计算出的差分用于计算特征的损失函数。

[0074]

在本实施方式中,使dnn_e311学习,以使基于差分计算部313的差分的特征的损失函数最小化。因此,使dnn_e311推进学习,以使dnn_e311提取的被偏置的特征b接近dnn_b312提取的被偏置的特征b’。即,使dnn_e311推进学习,以从dnn_r310提取的特征z中更高精度地提取被偏置的特征b。

[0075]

另一方面,使dnn_r310推进学习,以使基于差分计算部313的差分的特征的损失函数最大化,并使推论任务(例如物标的分类)的目标损失函数最小化。换言之,在本实施方式中,施加学习中的明确的制约,以让dnn_r310提取的特征z使本来应该关注的特征f最大化

并且使偏置因子b最小化。特别是,在本实施方式的学习方法中,使dnn_r310和dnn_e311对抗地学习,使dnn_r310和dnn_e311在如提取被偏置的特征b的dnn_e311难以提取被偏置的特征b(包括dnn_e311)那样的提取特征z的方向上学习dnn_r310的参数。

[0076]

在本实施方式中,以使用dnn_e311所包含的grl来同时进行dnn_r310和dnn_e311的更新的情况为例说明了这样的对抗学习,但也可以交替地进行dnn_r310和dnn_e311的更新。例如,首先,在固定了dnn_r310的基础上,对dnn_e311进行更新,以使基于差分计算部313的差分的特征的损失函数最小化。接下来,在固定了dnn_e311的基础上,对dnn_r310进行更新,以使基于差分计算部313的差分的特征的损失函数最大化,并使推论任务(例如物标的分类)的目标损失函数最小化。通过这样的学习,dnn_r310能够高精度地提取本来应该关注的特征f,能够提取鲁棒的特征。

[0077]

当通过上述的对抗的学习而dnn_r310的学习阶段的处理结束时,dnn_r310成为学习完毕模型,能够在推论阶段使用。在推论阶段,如图3b所示,图像数据仅被输入到dnn_r310,dnn_r310仅输出推论结果(物标的分类结果)。即,dnn_e311、dnn_b312以及差分计算部313在推论阶段不进行动作。

[0078]

《模型处理部中的学习阶段的处理的一系列动作》

[0079]

接下来,参照图5a以及图5b,对模型处理部114中的学习阶段中的一系列动作进行说明。需要说明的是,本处理通过控制部104的cpu110将存储于rom112或者存储部103的程序在ram111中加载并执行来实现。需要说明的是,控制部104的模型处理部114的各个dnn不是学习完毕,而是通过本处理而成为学习完毕的状态。

[0080]

在s501中,控制部104使模型处理部114的dnn_b312学习。dnn_b312可以使用与使dnn_r310学习的学习数据相同的学习数据来进行学习。向dnn_b312输入学习数据的图像数据,从dnn_b312计算出分类结果。如上所述,dnn_b312被学习为使基于分类结果与学习数据的标签的差分而得到的损失函数最小化。作为结果,dnn_b312被学习为提取在内部被偏置的特征。在本流程图中进行了简化记载,但在dnn_b312的学习中,也进行与学习数据的数量以及世代数相应的反复处理。

[0081]

在s502中,控制部104从存储部103读入与学习数据相关联的图像数据。在此,学习数据包含上述参照图4描述的数据。

[0082]

在s503中,模型处理部114对读入的图像数据应用当前的神经网络的权重系数,输出所提取的特征z和推论结果。

[0083]

在s504中,模型处理部114将在dnn_r310中提取的特征z输入到dnn_e311,提取被偏置的特征b。进一步地,在s505中,模型处理部114将图像数据输入到dnn_b312,从该图像数据中提取被偏置的特征b’。

[0084]

在s506中,模型处理部114通过差分计算部313,计算被偏置的特征b与被偏置的特征b’的差分(差分绝对值)。在s507中,模型处理部114基于dnn_r310的推论结果与学习数据的标签的差分,来计算上述的目标损失函数(lf)的损失。在s508中,模型处理部114基于被偏置的特征b与被偏置的特征b’的差分,计算上述的特征损失函数(lb)的损失。

[0085]

在s509中,模型处理部114判定是否对所有预定的学习数据执行了上述s502~s508的处理。模型处理部114在判定为对所有预定的学习数据执行了的情况下,使处理进入s510,在否定的情况下,为了使用进一步的学习数据执行s502~s508的处理而使处理返回

s502。

[0086]

在s510中,模型处理部114变更dnn_e311的权重系数,以使每个学习数据的特征损失函数(lb)的损失的总和减少(即,从dnn_r310所提取的特征z中更高精度地提取被偏置的特征b)。另一方面,在s511中,模型处理部114变更dnn_r的权重系数,以使特征损失函数(lb)的损失的总和增加,并使目标损失函数(lf)的损失的总和减少。即,模型处理部114被学习为一边让dnn_r310提取的特征z使本来应该关注的特征f最大化,一边使偏置因子b最小化。

[0087]

在s512中,模型处理部114判定是否结束了预定的世代数的处理。即,判定是否将s502~s511的处理重复了预先决定的次数。通过重复s502~s511的处理来进行变更,以使dnn_r310以及dnn_e311的权重系数逐渐收敛于最佳值。模型处理部114在判定为未结束预定的世代数的情况下,使处理返回到s502,在否定的情况下,结束本次一系列的处理。这样,当完成模型处理部114的学习阶段中的一系列动作时,模型处理部114中的各个dnn(特别是dnn_r310)成为学习完毕的状态。

[0088]

《模型处理部中的推论阶段的一系列动作》

[0089]

接下来,参照图6,对模型处理部114中的推论阶段的一系列动作进行说明。本处理是针对由车辆或者信息处理装置实际拍摄到的图像数据(即,没有正解的未知的图像数据)输出物标的分类结果的处理。需要说明的是,本处理通过控制部104的cpu110将存储于rom112或者存储部103的程序在ram111中加载并执行来实现。另外,本处理是模型处理部114的dnn_r310预先学习完毕的状态。即,以dnn_r310最大限度地检测本来应该关注的特征f的方式决定权重系数。

[0090]

在s601中,控制部104将从车辆或信息处理装置获取到的图像数据输入到dnn_r310。在s602中,模型处理部114进行基于dnn_r310的物标识别处理,并输出推论结果。当推论处理结束时,控制部104结束本处理所涉及的一系列动作。

[0091]

如以上说明的那样,在本实施方式中,信息处理服务器包含:dnn_r,其提取图像数据内的物标的特征;dnn_b,其使用与dnn_r不同的网络结构来提取图像数据内的物标的特征;以及dnn_e,其从在dnn_r中提取的特征中提取被偏置的特征。然后,使dnn_e311学习,以使在dnn_b312中提取出的被偏置的特征与在dnn_e311中提取出的被偏置的特征接近,并使dnn_r310学习,以使在dnn_r310提取的特征中出现的被偏置的特征减少。由此,在物标识别中,能够相对于域自适应地提取鲁棒的特征。

[0092]

(实施方式2)

[0093]

接下来,对本发明所涉及的实施方式2进行说明。在上述的实施方式中,以在信息处理服务器100中执行神经网络的学习阶段的处理和推论阶段的处理的情况为例进行了说明。但是,本实施方式不限于在信息处理服务器中执行学习阶段的处理的情况,也能够应用于在车辆中执行学习阶段的处理的情况。即,也可以将信息处理服务器100提供的学习数据输入到车辆的模型处理部,在车辆中使神经网络学习。并且,也可以使用学习完毕的神经网络来执行推论阶段的处理。以下,对这样的实施方式中的车辆的功能构成例进行说明。

[0094]

另外,在以下的例子中,以控制部708是组装于车辆700的控制机构的情况为例进行说明,但也可以在车辆700中搭载具有控制部708的构成的信息处理装置。即,车辆700也可以是搭载有具备控制部708所包含的cpu710、模型处理部714等构成的信息处理装置的车

辆。

[0095]

《车辆的构成》

[0096]

首先,参照图7,对本实施方式所涉及的车辆700的功能构成例进行说明。需要说明的是,参照以后的图进行说明的各个功能块可以被合并或分离,另外,说明的功能也可以通过其他的块来实现。另外,作为硬件说明的部件可以通过软件来实现,反之亦然。

[0097]

传感器部701包含输出对车辆的前方(或者,进一步地,后方方向、周围)进行拍摄而得到的拍摄图像的照相机(拍摄机构)。传感器部701还可以包含lidar(light detectionand ranging,激光探测和测距),该lidar输出测量车辆的前方(或者,进一步地,后方方向、周围)的距离而得到的距离图像。拍摄图像例如用于模型处理部714中的物标识别的推论处理。另外,也可以包含输出车辆700的加速度、位置信息、转向角等的各种传感器。

[0098]

通信部702例如是包含通信用电路等的通信设备,例如经由lte、lte-advanced等或者作为所谓5g而标准化的移动体通信,与信息处理服务器100、周围的交通系统等进行通信。通信部702从信息处理服务器100获取学习数据。此外,通信部702从其他信息处理服务器、周围的交通系统接收地图数据的一部分或全部、交通信息等。

[0099]

操作部703除了安装于车辆700内的按钮、触摸面板等操作构件之外,还包含方向盘、制动踏板等接受用于驾驶车辆700的输入的构件。电源部704包含例如由锂离子电池等构成的电池,向车辆700内的各部分供给电力。动力部705例如包含产生用于使车辆行驶的动力的发动机、马达。

[0100]

行驶控制部706基于从模型处理部714输出的推论处理的结果(例如物标识别的结果),例如以维持同一车道上的行驶、或者追随前方车辆行驶的方式控制车辆700的行驶。需要说明的是,在本实施方式中,该行驶控制能够使用已知的方法来进行。需要说明的是,在本实施方式的说明中,将行驶控制部706例示为与控制部708不同的构成,但也可以包含在控制部708中。

[0101]

存储部707包含半导体存储器等非易失性的大容量的存储设备。临时存储从传感器部701输出的实际图像以及从传感器部701输出的各种传感器数据。另外,后述的学习数据获取部713存储例如从外部的信息处理服务器100经由通信部702接收到的、用于模型处理部714的学习的学习数据。

[0102]

控制部708例如包含cpu710、ram711、rom712,控制车辆700的各部分的动作。另外,控制部708除了从传感器部701获取图像数据并执行包含物标识别处理等在内的上述推论处理之外,还使用从信息处理服务器100接收到的图像数据来执行模型处理部714的学习阶段的处理。控制部708通过cpu710将存储在rom712中的计算机程序在ram711中加载并执行,发挥控制部708所具有的模型处理部714等各部分的功能。

[0103]

cpu710包含一个以上的处理器。ram711例如由dram等易失性的存储介质构成,作为cpu710的工作存储器而发挥功能。rom712由非易失性的存储介质构成,存储由cpu710执行的计算机程序、使控制部708动作时的设定值等。需要说明的是,在以下的实施方式中,以cpu710执行模型处理部714的处理的情况为例进行说明,但模型处理部714的处理也可以由未图示的一个以上的其他处理器(例如gpu)执行。

[0104]

学习数据获取部713从信息处理服务器100获取图像数据和图4所示的数据作为学

习数据,并将其存储于存储部707。学习数据在学习阶段使模型处理部714学习时使用。

[0105]

模型处理部714具有结构与实施方式1中图3a所示的结构相同的深度神经网络,模型处理部714使用学习数据获取部713所获取的学习数据来执行学习阶段的处理和推论阶段的处理。模型处理部714执行的学习阶段的处理以及推论阶段的处理能够与实施方式1所示的处理同样地进行。

[0106]

《用于车辆的行驶控制的主要构成》

[0107]

接下来,参照图8,对用于车辆700的行驶控制的主要构成进行说明。传感器部701例如拍摄车辆700的前方,以每秒预定的张数输出拍摄到的图像数据。从传感器部701输出的图像数据被输入到控制部708的模型处理部714。被输入至模型处理部714的图像数据被用于对当前时间点的车辆的行驶进行控制的物标识别处理(推论阶段的处理)。

[0108]

模型处理部714输入从传感器部701输出的图像数据来执行物标识别处理,并将分类结果输出至行驶控制部706。分类结果可以与实施方式1中图3c所示的输出相同。

[0109]

行驶控制部706基于物标识别的结果以及从传感器部701得到的车辆的加速度、转向角等各种传感器信息,例如向动力部705输出控制信号,进行车辆700的车辆控制。如上所述,由行驶控制部706进行的车辆控制能够使用公知的方法来进行,因此在本实施方式中省略详细说明。动力部705根据行驶控制部706的控制信号来控制动力的产生。

[0110]

学习数据获取部713获取从信息处理服务器100发送的学习数据即图像数据以及图4所示的数据。所获取的数据用于使模型处理部714的dnn学习。

[0111]

车辆700可以使用存储部707的学习数据与图5a、图5b所示的处理同样地执行学习阶段中的一系列处理。另外,车辆700可以与图6所示的处理同样地执行推论阶段中的一系列处理。

[0112]

如以上说明的那样,在本实施方式中,在车辆700中的模型处理部714中使用于物标识别的深度神经网络学习。即,车辆具有:dnn_r,其提取图像数据内的物标的特征;dnn_b,其使用与dnn_r不同的网络结构来提取图像数据内的物标的特征;以及dnn_e,其从在dnn_r中提取的特征提取被偏置的特征。然后,使dnn_e311学习,以使在dnn_b312中提取的被偏置的特征与在dnn_e311中提取的被偏置的特征接近,并使dnn_r310学习,以使在dnn_r310提取的特征中出现的被偏置的特征减少。由此,在物标识别中,能够相对于域自适应地提取鲁棒的特征。

[0113]

需要说明的是,在上述的实施方式中,对在作为学习装置的一个例子的信息处理服务器以及作为学习装置的一个例子的车辆中执行图3a所示的dnn的处理的例子进行了说明。但是,学习装置并不限定于信息处理服务器以及车辆,也可以由其他装置执行图3a所示的dnn的处理。

[0114]

本发明并不限定于上述的实施方式,能够在发明的主旨的范围内进行各种变形、变更。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。