基于resnet34网络-注意力机制的连续手语识别方法及装置

技术领域

1.本发明涉及人工智能识别的技术领域,尤其是涉及一种基于resnet34网络-注意力机制的连续手语识别方法及装置。

背景技术:

2.手语作为聋哑人和听力障碍人群特定交流语言,融合了自然语言处理领域和计算机视觉领域的相关知识,而手语识别作为其中的一个子任务,也备受研究人员的关注。通常来说,手语识别分为孤立词识别和连续手语识别任务。尽管手语孤立词的识别任务已经取得了卓越的成果的,但是因其忽略了手语中的潜在语义关系以及一个手语句子中长期时序依赖关系,连续手语识别任务也逐渐被人们重视。

3.近年来,已经有各种各样的手语识别方法被设计出来,以提高连续手语识别的准确率。最初的手语识别研究常常依赖于数据手套和其他传感器设备来实时收集手势的运动变化和时间信息,并通过传统的隐马尔可夫模型对手语的时序信息进行建模,或是通过条件随机场提取手部信息。

4.后来随着深度学习(dl)的火热,越来越多的研究者通过使用神经网络进行连续手语的识别。神经网络的快速发展为手语识别、手语翻译、手语生成任务打开了新的研究大门。目前已经有研究人员使用卷积神经网络,循环卷积神经网络,图卷积神经网络结合骨架信息等模型识别手语,也有研究者通过使用连续时间分类的方法对手语视频与识别出的文本结果从而更好的收敛网络。但是目前的手语识别工作很少聚焦于多模态的输入上,对于一个神经网络而言,输入一个完全的手语序列,视频的冗余性很容易造成网络的过拟合,因此设计一个新型的连续手语识别方法是很有必要的。

技术实现要素:

5.有鉴于此,本发明的目的在于提供一种基于resnet34网络-注意力机制的连续手语识别方法及装置,以缓解视频冗余在成的神经网络结构过渡拟合的技术问题,提高了连续手语识别方法的泛化能力。

6.本发明一种基于resnet34网络-注意力机制的连续手语识别方法,包括:

7.s1:获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频,并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数据训练集,所述第二视频数据训练集具有标签;

8.s2:构建resnet34网络拓扑,将psa通道注意力机制和rcc空间注意力机制融合成pr注意力机制,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

9.s3:构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;

10.s4:构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网

络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

11.优选的,所述方法还包括:

12.获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试。

13.优选的,所述采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数据训练集的步骤包括:

14.获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心;

15.基于所述第一视频数据训练集的帧集合获取所述第一视频数据训练集的帧,并基于所述所有簇的簇质心以获取所述第一视频数据训练集的帧到簇质心的最近距离;

16.判定所述第一视频数据训练集的帧到簇质心的最近距离是否小于初始阈值;

17.若是,则将所述第一视频数据训练集的帧归至最近距离的簇质心的类中,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤;

18.若否,则将所述第一视频数据训练集的帧定义归至新的类别,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤。

19.优选的,所述resnet34网络拓扑包括初始层、第一残差层、第二残差层、第三残差层、第四残差层以及全局平均池化层;

20.所述第一残差层的卷积核数为64,所述第一残差层的数量为3;

21.所述第二残差层的卷积核数为128,所述第二残差层的数量为4;

22.所述第三残差层的卷积核数为256,所述第三残差层的数量为6;

23.所述第四残差层的卷积核数为512,所述第四残差层的数量为3;

24.将pr注意力机制与所述resnet34网络拓扑进行集成的步骤包括:

25.将所述第四残差层与全局平均池化层间引入所述pr注意力机制。

26.优选的,所述将psa通道注意力机制和rcc空间注意力机制融合成pr注意力机制的步骤中,其中所述psa通道注意力机制为:

27.[x0,x1,

…

,x

s-1

]=split(x);

[0028]fi

=conv(ki×ki

,gi)(xi);

[0029]

f=cat([f0,f1,

…

,f

s-1

]);

[0030]

x∈rc×w×

h-所述第二视频训练集经过resnet34网络前四个残差层计算后得到的第一特征图;

[0031]

c,w和h-第一特征图的通道、宽度和高度;

[0032]

split-在通道维度上对第一特征图x∈rc×w×h进行平等划分成s份的操作;

[0033]

xi∈r

c/s

×w×

h-所述第一特征图经过平等划分后的特征图,其通道为c/s;

[0034]ki-不同卷积核参数;

[0035]gi-分组卷积的参数;

[0036]fi

∈r

c/s

×w×

h-经过多尺度特征提取后的多尺度特征;

[0037]

cat-在通道维度上拼接不同感受野下的多尺度特征;

[0038]

f∈rc×w×

h-多尺度特征拼接后的特征向量;

[0039]

采用如下公式对所述多尺度特征拼接后的特征向量进行权值提取:

[0040]gi

=avgpool(fi);

[0041]

zi=σ(w1δ(w0(gi)));

[0042]

z=cat([z0,z1,

…

,z

s-1

]);

[0043]

avgpool(

·

)-代表了全局平均池化;

[0044]

σ(

·

)是sigmoid激活函数;

[0045]

δ(

·

)是relu激活函数;

[0046]gi

∈r

c/s

×1×

1-对多尺度特征进行全局平均池化的特征向量;

[0047]

w0和w1分别是维度为[c/s/r,c/s],[c/s,c/s/r]的权重矩阵,其中r代表为减小率;

[0048]zi-维度为[c/s,1,1]的不同部分注意力权值;

[0049]

z-维度为[c,1,1]的跨维度的通道注意力特征权重图;

[0050]

采用如下公式对所得注意力权值进行归一化,并将权值与经过多尺度特征提取的特征向量做张量积的操作:

[0051]

att=softmax(z);

[0052]

y=att

⊙

f;

[0053]

att-归一化后的通道注意力权值。

[0054]

所述rcc注意力机制是将criss-cross模块串联两次从而获得丰富的上下文信息,其中criss-cross通道注意力机制为:

[0055]

q=wqy;

[0056]

k=wky;

[0057]

v=wvy;

[0058]

wq和wk均是维度为[c

′

,c]的权重矩阵;

[0059]

wv是维度为[c,c]的权重矩阵;

[0060]

并采用如下公式将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息:

[0061]

进行affinity操作以获取大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系:

[0062]

d=affinity(q,k);

[0063][0064]

affinity-q,k都是维度为[c

′

,w,h]的特征图;

[0065]

ω

u-在q的空间维度中针对每一个位置u都存在特征向量

[0066]

其中是ωu的第i个元素,

[0067]di,u

∈d-特征qu和ω

i,u

,i=[1,

…

,h w-1]的相关度。

[0068]

基于大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系d在通道维度上应用softmax层从而计算特征图a:

[0069]

a=softmax(d);

[0070]

对特征图a进行aggregation操作从而收集上下文信息y

′

:

[0071][0072]

aggregation-在v的空间维度中针对每一个位置u都存在特征向量vu∈rc,集合φu∈r

(h w-1)

×c是从v矩阵中提取与位置u处于同一行与同一列的特征向量集合;

[0073]y′‑

所述为已捕捉到垂直方向和水平方向长连接的上下文信息;

[0074]

对已捕捉到垂直方向和水平方向长连接的上下文信息重复串联,如下列公式所示:

[0075]y″

=crisscross(y

′

);

[0076]y′

=crisscross(y);

[0077]y″‑

所述为已获取到全局像素信息的特征向量。

[0078]

优选的,所述采用lstm-ctc端对端网络结构拓扑以及所述第二视频数据训练集的标签对编码后所述第二视频数据集进行解码的步骤包括:

[0079]

计算lstm-ctc端对端网络的ctc损失函数,具体包括:

[0080]

定义一种多对一的映射函数β(

·

)来对应其目标序列y:

[0081]

其中

[0082][0083]

式中,π

n-n时刻的π标签;

[0084]-n时刻发生的概率;

[0085]

ctc损失函数为:

[0086][0087]

优选的,采用如下公式构建目标函数:

[0088][0089]

l-所构建的目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm编码器网络拓扑参数以及所述lstm-ctc解码器网络结构拓扑进行调整;

[0090]

s-给定第二视频数据集的维度;

[0091]

||ω||

2-避免过拟合的正则化项;

[0092]

λ-正则项的超参数。

[0093]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0094]

获取wer值表示识别的精度:

[0095][0096]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0097]

n表示标签的单词总数。

[0098]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与

所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0099]

获取准确率accuracy表示识别的精度:

[0100][0101]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0102]

n表示标签的单词总数。

[0103]

另一方面,一种基于resnet34网络-注意力机制的连续手语识别装置,包括:

[0104]

视频获取模块:用于获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数训练集,所述第二视频训练集具有标签;

[0105]

特征提取模块:用于构建resnet34网络拓扑,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

[0106]

解码模块:用于构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;

[0107]

参数调整模块:用于构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

[0108]

本发明实施例带来了以下有益效果:本发明提供了一种基于resnet34网络-注意力机制的连续手语识别方法及装置,包括:s1:获取第一视频数据训练集,第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取第一视频数据训练集的关键帧以获取第二视频数训练集,第二视频训练集具有标签;s2:构建resnet34网络拓扑,并将pr注意力机制与resnet34网络拓扑进行集成以提取第二视频数据集的特征信息;s3:构建bilstm网络拓扑以对第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后第二视频数据集进行解码;s4:构建目标函数,以对resnet34网络拓扑与pr注意力机制集成后的网络拓扑参数、bilstm网络拓扑参数以及lstm-ctc端对端网络结构拓扑参数进行调整。通过本发明提供的方法及装置可以缓解现有技术中视频冗余造成的神经网络结构过度拟合的技术问题,提高了连续手语识别方法的泛化能力。

[0109]

本发明的其他特征和优点将在随后的说明书中阐述,并且,部分地从说明书中变得显而易见,或者通过实施本发明而了解。本发明的目的和其他优点在说明书、权利要求书以及附图中所特别指出的结构来实现和获得。

[0110]

为使本发明的上述目的、特征和优点能更明显易懂,下文特举较佳实施例,并配合所附附图,作详细说明如下。

附图说明

[0111]

为了更清楚地说明本发明具体实施方式或现有技术中的技术方案,下面将对具体实施方式或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图是本发明的一些实施方式,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0112]

图1为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法流程图;

[0113]

图2为本发明实施例提供的基于resnet34网络-注意力机制网络结构图;

[0114]

图3为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法resnet34残差模块网络流程图;

[0115]

图4为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法resnet34残差模块网络结构图;

[0116]

图5为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法lstm基本单元模块的网络示意图;

[0117]

图6为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法bilstm编码器的网络结构图。

具体实施方式

[0118]

为使本发明实施例的目的、技术方案和优点更加清楚,下面将结合附图对本发明的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0119]

目前,手语识别工作很少聚焦于多模态的输入上,对于一个神经网络而言,输入一个完全的手语序列,视频的冗余性很容易造成网络的过拟合,基于此,本发明实施例提供的一种基于resnet34网络-注意力机制的连续手语识别方法及装置,可以缓解了视频冗余在成的神经网络结构过渡拟合的技术问题,提高了连续手语识别方法的泛化能力。

[0120]

为便于对本实施例进行理解,首先对本发明实施例所公开的基于resnet34网络-注意力机制的连续手语识别方法及装置进行详细介绍。

[0121]

实施例一:

[0122]

结合图1,本发明实施例一提供了一种基于resnet34网络-注意力机制的连续手语识别方法,包括:

[0123]

s1:获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数训练集,所述第二视频训练集具有标签;

[0124]

s2:构建resnet34网络拓扑,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

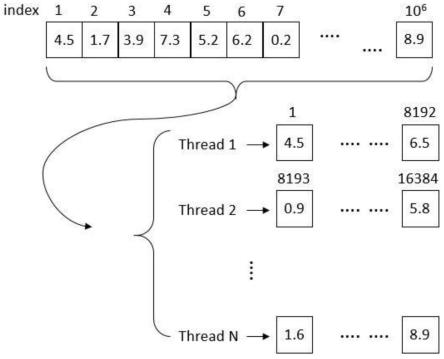

[0125]

结合图6,s3:构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;需要说明的是,lstm作为一种特殊的rnn网络,能够学习长距离的时间依赖。如图5所示,在t时刻,lstm的输入有三个:当前t时刻网络的输入值x

t

、上一时刻lstm的输出值h

t-1

、以及上一时刻的单元状态c

t-1

;lstm的输出有两个:当前时刻lstm输出值h

t

、当前时刻的单元状态c

t

。其运行机制由内部的输入门、遗忘门和输出门进行操作。

[0126]

结合图5,对lstm具备如下特点:

[0127]

1):遗忘门决定了上一时刻的单元状态有多少需要保留到当前时刻,通过遗忘门

可以得到f

t

;

[0128]ft

=σ(wf·

[h

t-1

,x

t

] bf);

[0129]

2):输入门决定了当前时刻网络的输入数据需要保存多少至单元状态,通过输入门可以得到i

t

,通过单元状态可以得到当前时刻暂时状态而后应用上个lstm细胞结构的单元状态c

t-1

、遗忘门的输出f

t

、输入门的输出i

t

以及暂时状态可以得到当前时刻的单元状态c

t

。

[0130]it

=σ(wi·

[h

t-1

,x

t

] bi)

[0131][0132][0133]

3):输出门控制当前单元状态有多少需要输出到当前的输出值,通过输出门可以得到o

t

,结合当前时刻的单元状态c

t

和o

t

可以得到最终的输出h

t

;

[0134]ot

=σ(wo·

[h

t-1

,x

t

] bo);

[0135]ht

=o

t

*tan(c

t

)

[0136]

bilstm是由前向lstm和后向lstm结合而成,以获得长时期的上下文信息。具体而言就是以lstm的方式将反转后的输入序列计算,最终将正向lstm的结果与反向lstm的结果进行堆叠;

[0137]

进一步的,pr注意力机制与所述resnet34网络拓扑进行集成模块提取到的高维手语视频特征向量送入bilstm-lstm的编码器解码器中。具体地说,我们将手语图片x={x1,x2,...,xi,...,x

t

}作为输入至pr注意力机制与所述resnet34网络拓扑进行集成后的网络以提取所述第二视频数据集的特征信息;

[0138]

结合图6,网络,网络将输出e={e1,e2,...,ei,...,e

t

},其中xi∈rc×h×w,ei∈rc′

,t代表手语视频的帧数。将特征提取网络的输出进行堆叠,得到的可以作为bilstm编码器的输入;

[0139]

s4:构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

[0140]

优选的,所述方法还包括:

[0141]

获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试。

[0142]

优选的,所述采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数据训练集的步骤包括:

[0143]

获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心;

[0144]

基于所述第一视频数据训练集的帧集合获取所述第一视频数据训练集的帧,并基于所述所有簇的簇质心以获取所述第一视频数据训练集的帧到簇质心的最近距离;

[0145]

判定所述第一视频数据训练集的帧到簇质心的最近距离是否小于初始阈值;

[0146]

若是,则将所述第一视频数据训练集的帧归至最近距离的簇质心的类中,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始

阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤;

[0147]

若否,则将所述第一视频数据训练集的帧定义归至新的类别,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤。

[0148]

结合图2至图4,优选的,所述resnet34网络拓扑包括初始层、第一残差层、第二残差层、第三残差层、第四残差层以及全局平均池化层;

[0149]

所述第一残差层的卷积核数为64,所述第一残差层的数量为3;

[0150]

所述第二残差层的卷积核数为128,所述第二残差层的数量为4;

[0151]

所述第三残差层的卷积核数为256,所述第三残差层的数量为6;

[0152]

所述第四残差层的卷积核数为512,所述第四残差层的数量为3;

[0153]

进一步的,作为cnn的一种骨干网络,resnet早已广泛应用到计算机视觉中的各种场景;

[0154]

resnet(deep residual network)名为深度残差网络,其最重要的特点便是由许多参数相同的残差单元连接起来组成basicblock,多个basicblock组合起来再加上预处理层和最后的全连接分类层便组成了resnet网络,其中残差单元residual如图3所示。考虑到神经网络深度的显著影响,本文选择使用resnet来解决该问题。具体来说,本技术使用如图4所示的resnet34作为本发明的骨干网络,再融合空间和通道的注意力机制,可以很好地提取手语视频的图像特征信息,同时避免深层网络梯度消失的问题。

[0155]

近一点的,将pr注意力机制与所述resnet34网络拓扑进行集成的步骤包括:

[0156]

将所述第四残差层与全局平均池化层间引入所述pr注意力机制。

[0157]

需要说明的是,在本发明提供的实施例中,因为特征图混合了冗余信息,所以本文突出了空间手部运动的重要区域,同时使用不同的权重表示不同的重要性。因为每个通道的功能代表一个独特的检测器,所以通道注意力的目的是关注哪种特征有意义。此外,本文引入的空间注意力模块,专注于哪些空间特征更有意义。

[0158]

优选的,所述将psa通道注意力机制和rcc空间注意力机制融合成pr注意力机制的步骤中,其中所述psa通道注意力机制为:

[0159]

[x0,x1,

…

,x

s-1

]=split(x);

[0160]fi

=conv(ki×ki

,gi)(xi);

[0161]

f=cat([f0,f1,

…

,f

s-1

]);

[0162]

x∈rc×w×

h-所述第二视频训练集经过resnet34网络前四个残差层计算后得到的第一特征图;

[0163]

c,w和h-第一特征图的通道、宽度和高度;

[0164]

split-在通道维度上对第一特征图x∈rc×w×h进行平等划分成s份的操作;

[0165]

xi∈r

c/s

×w×

h-所述第一特征图经过平等划分后的特征图,其通道为c/s;

[0166]ki-不同卷积核参数;

[0167]gi-分组卷积的参数;

[0168]fi

∈r

c/s

×w×

h-经过多尺度特征提取后的多尺度特征;

[0169]

cat-在通道维度上拼接不同感受野下的多尺度特征;

[0170]

f∈rc×w×

h-多尺度特征拼接后的特征向量;

[0171]

采用如下公式对所述多尺度特征拼接后的特征向量进行权值提取:

[0172]gi

=avgpool(fi);

[0173]

zi=σ(w1δ(w0(gi)));

[0174]

z=cat([z0,z1,

…

,z

s-1

]);

[0175]

avgpool(

·

)-代表了全局平均池化;

[0176]

σ(

·

)是sigmoid激活函数;

[0177]

δ(

·

)是relu激活函数;

[0178]gi

∈r

c/s

×1×

1-对多尺度特征进行全局平均池化的特征向量;

[0179]

w0和w1分别是维度为[c/s/r,c/s],[c/s,c/s/r]的权重矩阵,其中r代表为减小率;

[0180]zi-维度为[c/s,1,1]的不同部分注意力权值;

[0181]

z-维度为[c,1,1]的跨维度的通道注意力特征权重图;

[0182]

采用如下公式对所得注意力权值进行归一化,并将权值与经过多尺度特征提取的特征向量做张量积的操作:

[0183]

att=softmax(z);

[0184]

y=att

⊙

f;

[0185]

att-归一化后的通道注意力权值;

[0186]

需要说明的是,在本发明所提供的实施例中,所述rcc注意力机制是将criss-cross模块串联两次从而获得丰富的上下文信息,其中criss-cross通道注意力机制为:

[0187]

q=wqy;

[0188]

k=wky;

[0189]

v=wvy;

[0190]

wq和wk均是维度为[c

′

,c]的权重矩阵;

[0191]

wv是维度为[c,c]的权重矩阵;

[0192]

并采用如下公式将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息:

[0193]

进行affinity操作以获取大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系:

[0194]

d=affinity(q,k);

[0195][0196]

affinity-q,k都是维度为[c

′

,w,h]的特征图;

[0197]

ω

u-在q的空间维度中针对每一个位置u都存在特征向量

[0198]

其中是ωu的第i个元素,

[0199]di,u

∈d-特征qu和ω

i,u

,i=[1,

…

,h w-1]的相关度。

[0200]

进一步的,在q的空间维度中针对每一个位置u都存在特征向量进一步的,在q的空间维度中针对每一个位置u都存在特征向量与此同时,可以从k矩阵中提取与位置u处于同一行与同一列的特征向量集合其中是ωu的第i个元素,d

i,u

∈d是特征qu和ω

i,u

,i=[1,

…

,h w-1]的相关度;

[0201]

基于大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系d在通道维度上应用softmax层从而计算特征图a:

[0202]

a=softmax(d);

[0203]

对特征图a进行aggregation操作从而收集上下文信息y

′

:

[0204][0205]

aggregation-在v的空间维度中针对每一个位置u都存在特征向量vu∈rc,集合φu∈r

(h w-1)

×c是从v矩阵中提取与位置u处于同一行与同一列的特征向量集合;

[0206]y′‑

所述为已捕捉到垂直方向和水平方向长连接的上下文信息;

‘

[0207]

但此时,其像素级别的特征信息还略显稀疏,因此需要对已捕捉到垂直方向和水平方向长连接的上下文信息重复串联,如下列公式所示:

[0208]y″

=crisscross(y

′

);

[0209]y′

=crisscross(y);

[0210]y″‑

所述为已获取到全局像素信息的特征向量。

[0211]

优选的,所述采用lstm-ctc端对端网络结构拓扑以及所述第二视频数据训练集的标签对编码后所述第二视频数据集进行解码的步骤包括:

[0212]

计算lstm-ctc端对端网络的ctc损失函数,具体包括:

[0213]

定义一种多对一的映射函数β(

·

)来对应其目标序列y:

[0214]

其中

[0215][0216]

式中,π

n-n时刻的π标签;

[0217]-n时刻发生的概率;

[0218]

ctc损失函数为:

[0219][0220]

进一步的,ctc是一个集成了输入序列和目标序列之间对齐的所有可能性的目标函数。在本发明用到的数据集中,标签(-)已经被添加到手语注释中从而精确的模拟两个相邻手语词汇之间的过渡;

[0221]

输入序列的中间标签路径被表示为π=(π1,π2,

…

,π

t

,

…

,π

t

),其中π

t

∈{v∪{-}*};v是手语单词词汇表,星号是通配符;

[0222]

对于给定的输入x,路径π的概率计算公式如下所示

[0223][0224]

其中的πn是n时刻的π标签,是n时刻发生的概率。

[0225]

由于手语注释标签的各种细分,容易导致相同的输入序列和目标序列仍会产生不同的对齐方式,因此,ctc定义了一种多对一的映射函数β(

·

)来对其目标序列y,即y=β(π)。y的概率可以被定义为所有与之相符的对齐的总和概率,计算公式如下所示:

[0226][0227]

于是,可以将上述公式替换为ctc损失函数,定义如下公式:

[0228][0229]

优选的,采用如下公式构建目标函数:

[0230][0231]

l-所构建的目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm编码器网络拓扑参数以及所述lstm-ctc解码器网络结构拓扑进行调整;

[0232]

s-给定第二视频数据集的维度;

[0233]

||ω||

2-避免过拟合的正则化项;

[0234]

λ-正则项的超参数。

[0235]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0236]

获取wer值表示识别的精度:

[0237][0238]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0239]

n表示标签的单词总数。

[0240]

需要说明的是,在语音识别和机器翻译任务中,word error rate(wer)经常被用来当作实验的评价指标。在本发明中,我们通过采用不同的实验指标误词率wer和准确率accuracy进行网络质量的评估。通过观察评估指标可以判断模型效果,但在本发明中,未涉及到根据指标学习网络,因此本发明设计的crb-net仍采用梯度下降的方法进行网络的训练;

[0241]

wer通过替换、删除和插入操作的组合来测量序列转换。对于手语识别任务,一个低的wer值往往可以表示为识别的高精度,wer的计算公式如下

[0242][0243]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0244]

获取准确率accuracy表示识别的精度:

[0245][0246]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0247]

n表示标签的单词总数;

[0248]

实施例二:

[0249]

本发明提供了一种基于resnet34网络-注意力机制的连续手语识别装置,包括:

[0250]

视频获取模块:用于获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频

数训练集,所述第二视频训练集具有标签;

[0251]

特征提取模块:用于构建resnet34网络拓扑,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

[0252]

解码模块:用于构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;

[0253]

参数调整模块:用于构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

[0254]

实施例三:

[0255]

本发明实施例三为了证明本发明提出的网络模型在强监督学习下测试集的泛化性,本发明的方法在两个大型的手语数据集上均进行了评估,包括来自中国科学技术大学的csl数据集,以及自己的tjut手语识别和翻译的数据集(tjut-slrt)。实验结果表明本发明提出的算法对不同的数据集进行wer指标的评估,均有较高的精度,从而证明了本发明有着极高的泛化性。

[0256]

本发明具有如下优势:

[0257]

1)本算法分别在两个大规模的手语数据集上进行评估在由tjut-slrt数据集划分的测试集上进行实验测试,结果如下列表格所示,可以看到本技术提供的方法在误词率wer上要低于基于cbam注意力机制的连续手语识别方法,也验证了本方法的泛化程度好;

[0258]

本方法与基于cbam注意力机制的手语识别方法在tjut测试数据集上的wer训练结果:

[0259] resnet34 cbam bilstmresnet34 prr bilstm(ours)tjut11.45%11.26%

[0260]

本方法在csl数据集上的wer训练结果:

[0261]

datasetdevtestcsl2.01%1.76%

[0262]

本方法在csl数据集上不同设置下的准确率:

[0263]

methodaccuraycnn lstm0.873resnet18 lstm0.905resnet34 lstm0.926cnn bilstm0.896resnet18 bilstm0.928resnet34 bilstm0.943prr-resnet34 bilstm0.982

[0264]

2)使用rgb视频以及深度视频数据,利于网络更好学习图像特征表示;

[0265]

3)采用基于k-means算法的kfe聚类算法减少了视频的冗余,进一步缓解了神经网络结构过渡拟合的技术问题,提高了连续手语识别方法的泛化能力;

[0266]

4)在现有resnet34网络拓扑引入了pr注意力模块使得网络更聚焦于手部特征,pr

注意力模块在通道维度上捕获不同尺度的空间信息来丰富特征空间,并从全局空间信息出发建立远距离依赖;在空间维度上采用二阶注意力以生成具有密集且丰富的上下文信息的特征图,因其采用连续的两次稀疏自注意力计算来逼近一次稠密的自注意力计算,使其在保证先进性能的同时,不仅降低了内存消耗和时间复杂度,还减少了全域像素中冗余信息的干扰;

[0267]

5)使用编码器-解码器的网络模型实现端到端的连续手语识别,在捕获图像特征在时间维度上语义信息的同时,可以实现长度不相等源序列和目标序列之间的映射,;从纵向看,隐藏层包含了更多先前节点的信息,尤其是在视频帧数较多的手语序列中,模型具有更好的记忆性,有效避免了长序列中信息损失的问题。;

[0268]

除非另外具体说明,否则在这些实施例中阐述的部件和步骤的相对步骤、数字表达式和数值并不限制本发明的范围。

[0269]

本发明实施例所提供的装置,其实现原理及产生的技术效果和前述方法实施例相同,为简要描述,装置实施例部分未提及之处,可参考前述方法实施例中相应内容。

[0270]

应注意到:相似的标号和字母在下面的附图中表示类似项,因此,一旦某一项在一个附图中被定义,则在随后的附图中不需要对其进行进一步定义和解释。

[0271]

附图中的流程图和框图显示了根据本发明的多个实施例的系统、方法和计算机程序产品的可能实现的体系架构、功能和操作。在这点上,流程图或框图中的每个方框可以代表一个模块、程序段或代码的一部分,所述模块、程序段或代码的一部分包含一个或多个用于实现规定的逻辑功能的可执行指令。也应当注意,在有些作为替换的实现中,方框中所标注的功能也可以以不同于附图中所标注的顺序发生。例如,两个连续的方框实际上可以基本并行地执行,它们有时也可以按相反的顺序执行,这依所涉及的功能而定。也要注意的是,框图和/或流程图中的每个方框、以及框图和/或流程图中的方框的组合,可以用执行规定的功能或动作的专用的基于硬件的系统来实现,或者可以用专用硬件与计算机指令的组合来实现。

[0272]

所属领域的技术人员可以清楚地了解到,为描述的方便和简洁,上述描述的系统和装置的具体工作过程,可以参考前述方法实施例中的对应过程,在此不再赘述。

[0273]

另外,在本发明实施例的描述中,除非另有明确的规定和限定,术语“安装”、“相连”、“连接”应做广义理解,例如,可以是固定连接,也可以是可拆卸连接,或一体地连接;可以是机械连接,也可以是电连接;可以是直接相连,也可以通过中间媒介间接相连,可以是两个元件内部的连通。对于本领域的普通技术人员而言,可以具体情况理解上述术语在本发明中的具体含义。

[0274]

在本发明的描述中,需要说明的是,术语“中心”、“上”、“下”、“左”、“右”、“竖直”、“水平”、“内”、“外”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本发明的限制。此外,术语“第一”、“第二”、“第三”仅用于描述目的,而不能理解为指示或暗示相对重要性。

[0275]

最后应说明的是:以上所述实施例,仅为本发明的具体实施方式,用以说明本发明的技术方案,而非对其限制,本发明的保护范围并不局限于此,尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:任何熟悉本技术领域的技术人员

在本发明揭露的技术范围内,其依然可以对前述实施例所记载的技术方案进行修改或可轻易想到变化,或者对其中部分技术特征进行等同替换;而这些修改、变化或者替换,并不使相应技术方案的本质脱离本发明实施例技术方案的精神和范围,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应所述以权利要求的保护范围为准。

技术领域

1.本发明涉及人工智能识别的技术领域,尤其是涉及一种基于resnet34网络-注意力机制的连续手语识别方法及装置。

背景技术:

2.手语作为聋哑人和听力障碍人群特定交流语言,融合了自然语言处理领域和计算机视觉领域的相关知识,而手语识别作为其中的一个子任务,也备受研究人员的关注。通常来说,手语识别分为孤立词识别和连续手语识别任务。尽管手语孤立词的识别任务已经取得了卓越的成果的,但是因其忽略了手语中的潜在语义关系以及一个手语句子中长期时序依赖关系,连续手语识别任务也逐渐被人们重视。

3.近年来,已经有各种各样的手语识别方法被设计出来,以提高连续手语识别的准确率。最初的手语识别研究常常依赖于数据手套和其他传感器设备来实时收集手势的运动变化和时间信息,并通过传统的隐马尔可夫模型对手语的时序信息进行建模,或是通过条件随机场提取手部信息。

4.后来随着深度学习(dl)的火热,越来越多的研究者通过使用神经网络进行连续手语的识别。神经网络的快速发展为手语识别、手语翻译、手语生成任务打开了新的研究大门。目前已经有研究人员使用卷积神经网络,循环卷积神经网络,图卷积神经网络结合骨架信息等模型识别手语,也有研究者通过使用连续时间分类的方法对手语视频与识别出的文本结果从而更好的收敛网络。但是目前的手语识别工作很少聚焦于多模态的输入上,对于一个神经网络而言,输入一个完全的手语序列,视频的冗余性很容易造成网络的过拟合,因此设计一个新型的连续手语识别方法是很有必要的。

技术实现要素:

5.有鉴于此,本发明的目的在于提供一种基于resnet34网络-注意力机制的连续手语识别方法及装置,以缓解视频冗余在成的神经网络结构过渡拟合的技术问题,提高了连续手语识别方法的泛化能力。

6.本发明一种基于resnet34网络-注意力机制的连续手语识别方法,包括:

7.s1:获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频,并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数据训练集,所述第二视频数据训练集具有标签;

8.s2:构建resnet34网络拓扑,将psa通道注意力机制和rcc空间注意力机制融合成pr注意力机制,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

9.s3:构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;

10.s4:构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网

络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

11.优选的,所述方法还包括:

12.获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试。

13.优选的,所述采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数据训练集的步骤包括:

14.获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心;

15.基于所述第一视频数据训练集的帧集合获取所述第一视频数据训练集的帧,并基于所述所有簇的簇质心以获取所述第一视频数据训练集的帧到簇质心的最近距离;

16.判定所述第一视频数据训练集的帧到簇质心的最近距离是否小于初始阈值;

17.若是,则将所述第一视频数据训练集的帧归至最近距离的簇质心的类中,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤;

18.若否,则将所述第一视频数据训练集的帧定义归至新的类别,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤。

19.优选的,所述resnet34网络拓扑包括初始层、第一残差层、第二残差层、第三残差层、第四残差层以及全局平均池化层;

20.所述第一残差层的卷积核数为64,所述第一残差层的数量为3;

21.所述第二残差层的卷积核数为128,所述第二残差层的数量为4;

22.所述第三残差层的卷积核数为256,所述第三残差层的数量为6;

23.所述第四残差层的卷积核数为512,所述第四残差层的数量为3;

24.将pr注意力机制与所述resnet34网络拓扑进行集成的步骤包括:

25.将所述第四残差层与全局平均池化层间引入所述pr注意力机制。

26.优选的,所述将psa通道注意力机制和rcc空间注意力机制融合成pr注意力机制的步骤中,其中所述psa通道注意力机制为:

27.[x0,x1,

…

,x

s-1

]=split(x);

[0028]fi

=conv(ki×ki

,gi)(xi);

[0029]

f=cat([f0,f1,

…

,f

s-1

]);

[0030]

x∈rc×w×

h-所述第二视频训练集经过resnet34网络前四个残差层计算后得到的第一特征图;

[0031]

c,w和h-第一特征图的通道、宽度和高度;

[0032]

split-在通道维度上对第一特征图x∈rc×w×h进行平等划分成s份的操作;

[0033]

xi∈r

c/s

×w×

h-所述第一特征图经过平等划分后的特征图,其通道为c/s;

[0034]ki-不同卷积核参数;

[0035]gi-分组卷积的参数;

[0036]fi

∈r

c/s

×w×

h-经过多尺度特征提取后的多尺度特征;

[0037]

cat-在通道维度上拼接不同感受野下的多尺度特征;

[0038]

f∈rc×w×

h-多尺度特征拼接后的特征向量;

[0039]

采用如下公式对所述多尺度特征拼接后的特征向量进行权值提取:

[0040]gi

=avgpool(fi);

[0041]

zi=σ(w1δ(w0(gi)));

[0042]

z=cat([z0,z1,

…

,z

s-1

]);

[0043]

avgpool(

·

)-代表了全局平均池化;

[0044]

σ(

·

)是sigmoid激活函数;

[0045]

δ(

·

)是relu激活函数;

[0046]gi

∈r

c/s

×1×

1-对多尺度特征进行全局平均池化的特征向量;

[0047]

w0和w1分别是维度为[c/s/r,c/s],[c/s,c/s/r]的权重矩阵,其中r代表为减小率;

[0048]zi-维度为[c/s,1,1]的不同部分注意力权值;

[0049]

z-维度为[c,1,1]的跨维度的通道注意力特征权重图;

[0050]

采用如下公式对所得注意力权值进行归一化,并将权值与经过多尺度特征提取的特征向量做张量积的操作:

[0051]

att=softmax(z);

[0052]

y=att

⊙

f;

[0053]

att-归一化后的通道注意力权值。

[0054]

所述rcc注意力机制是将criss-cross模块串联两次从而获得丰富的上下文信息,其中criss-cross通道注意力机制为:

[0055]

q=wqy;

[0056]

k=wky;

[0057]

v=wvy;

[0058]

wq和wk均是维度为[c

′

,c]的权重矩阵;

[0059]

wv是维度为[c,c]的权重矩阵;

[0060]

并采用如下公式将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息:

[0061]

进行affinity操作以获取大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系:

[0062]

d=affinity(q,k);

[0063][0064]

affinity-q,k都是维度为[c

′

,w,h]的特征图;

[0065]

ω

u-在q的空间维度中针对每一个位置u都存在特征向量

[0066]

其中是ωu的第i个元素,

[0067]di,u

∈d-特征qu和ω

i,u

,i=[1,

…

,h w-1]的相关度。

[0068]

基于大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系d在通道维度上应用softmax层从而计算特征图a:

[0069]

a=softmax(d);

[0070]

对特征图a进行aggregation操作从而收集上下文信息y

′

:

[0071][0072]

aggregation-在v的空间维度中针对每一个位置u都存在特征向量vu∈rc,集合φu∈r

(h w-1)

×c是从v矩阵中提取与位置u处于同一行与同一列的特征向量集合;

[0073]y′‑

所述为已捕捉到垂直方向和水平方向长连接的上下文信息;

[0074]

对已捕捉到垂直方向和水平方向长连接的上下文信息重复串联,如下列公式所示:

[0075]y″

=crisscross(y

′

);

[0076]y′

=crisscross(y);

[0077]y″‑

所述为已获取到全局像素信息的特征向量。

[0078]

优选的,所述采用lstm-ctc端对端网络结构拓扑以及所述第二视频数据训练集的标签对编码后所述第二视频数据集进行解码的步骤包括:

[0079]

计算lstm-ctc端对端网络的ctc损失函数,具体包括:

[0080]

定义一种多对一的映射函数β(

·

)来对应其目标序列y:

[0081]

其中

[0082][0083]

式中,π

n-n时刻的π标签;

[0084]-n时刻发生的概率;

[0085]

ctc损失函数为:

[0086][0087]

优选的,采用如下公式构建目标函数:

[0088][0089]

l-所构建的目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm编码器网络拓扑参数以及所述lstm-ctc解码器网络结构拓扑进行调整;

[0090]

s-给定第二视频数据集的维度;

[0091]

||ω||

2-避免过拟合的正则化项;

[0092]

λ-正则项的超参数。

[0093]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0094]

获取wer值表示识别的精度:

[0095][0096]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0097]

n表示标签的单词总数。

[0098]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与

所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0099]

获取准确率accuracy表示识别的精度:

[0100][0101]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0102]

n表示标签的单词总数。

[0103]

另一方面,一种基于resnet34网络-注意力机制的连续手语识别装置,包括:

[0104]

视频获取模块:用于获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数训练集,所述第二视频训练集具有标签;

[0105]

特征提取模块:用于构建resnet34网络拓扑,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

[0106]

解码模块:用于构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;

[0107]

参数调整模块:用于构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

[0108]

本发明实施例带来了以下有益效果:本发明提供了一种基于resnet34网络-注意力机制的连续手语识别方法及装置,包括:s1:获取第一视频数据训练集,第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取第一视频数据训练集的关键帧以获取第二视频数训练集,第二视频训练集具有标签;s2:构建resnet34网络拓扑,并将pr注意力机制与resnet34网络拓扑进行集成以提取第二视频数据集的特征信息;s3:构建bilstm网络拓扑以对第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后第二视频数据集进行解码;s4:构建目标函数,以对resnet34网络拓扑与pr注意力机制集成后的网络拓扑参数、bilstm网络拓扑参数以及lstm-ctc端对端网络结构拓扑参数进行调整。通过本发明提供的方法及装置可以缓解现有技术中视频冗余造成的神经网络结构过度拟合的技术问题,提高了连续手语识别方法的泛化能力。

[0109]

本发明的其他特征和优点将在随后的说明书中阐述,并且,部分地从说明书中变得显而易见,或者通过实施本发明而了解。本发明的目的和其他优点在说明书、权利要求书以及附图中所特别指出的结构来实现和获得。

[0110]

为使本发明的上述目的、特征和优点能更明显易懂,下文特举较佳实施例,并配合所附附图,作详细说明如下。

附图说明

[0111]

为了更清楚地说明本发明具体实施方式或现有技术中的技术方案,下面将对具体实施方式或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图是本发明的一些实施方式,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0112]

图1为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法流程图;

[0113]

图2为本发明实施例提供的基于resnet34网络-注意力机制网络结构图;

[0114]

图3为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法resnet34残差模块网络流程图;

[0115]

图4为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法resnet34残差模块网络结构图;

[0116]

图5为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法lstm基本单元模块的网络示意图;

[0117]

图6为本发明实施例提供的基于resnet34网络-注意力机制的连续手语识别方法bilstm编码器的网络结构图。

具体实施方式

[0118]

为使本发明实施例的目的、技术方案和优点更加清楚,下面将结合附图对本发明的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0119]

目前,手语识别工作很少聚焦于多模态的输入上,对于一个神经网络而言,输入一个完全的手语序列,视频的冗余性很容易造成网络的过拟合,基于此,本发明实施例提供的一种基于resnet34网络-注意力机制的连续手语识别方法及装置,可以缓解了视频冗余在成的神经网络结构过渡拟合的技术问题,提高了连续手语识别方法的泛化能力。

[0120]

为便于对本实施例进行理解,首先对本发明实施例所公开的基于resnet34网络-注意力机制的连续手语识别方法及装置进行详细介绍。

[0121]

实施例一:

[0122]

结合图1,本发明实施例一提供了一种基于resnet34网络-注意力机制的连续手语识别方法,包括:

[0123]

s1:获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数训练集,所述第二视频训练集具有标签;

[0124]

s2:构建resnet34网络拓扑,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

[0125]

结合图6,s3:构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;需要说明的是,lstm作为一种特殊的rnn网络,能够学习长距离的时间依赖。如图5所示,在t时刻,lstm的输入有三个:当前t时刻网络的输入值x

t

、上一时刻lstm的输出值h

t-1

、以及上一时刻的单元状态c

t-1

;lstm的输出有两个:当前时刻lstm输出值h

t

、当前时刻的单元状态c

t

。其运行机制由内部的输入门、遗忘门和输出门进行操作。

[0126]

结合图5,对lstm具备如下特点:

[0127]

1):遗忘门决定了上一时刻的单元状态有多少需要保留到当前时刻,通过遗忘门

可以得到f

t

;

[0128]ft

=σ(wf·

[h

t-1

,x

t

] bf);

[0129]

2):输入门决定了当前时刻网络的输入数据需要保存多少至单元状态,通过输入门可以得到i

t

,通过单元状态可以得到当前时刻暂时状态而后应用上个lstm细胞结构的单元状态c

t-1

、遗忘门的输出f

t

、输入门的输出i

t

以及暂时状态可以得到当前时刻的单元状态c

t

。

[0130]it

=σ(wi·

[h

t-1

,x

t

] bi)

[0131][0132][0133]

3):输出门控制当前单元状态有多少需要输出到当前的输出值,通过输出门可以得到o

t

,结合当前时刻的单元状态c

t

和o

t

可以得到最终的输出h

t

;

[0134]ot

=σ(wo·

[h

t-1

,x

t

] bo);

[0135]ht

=o

t

*tan(c

t

)

[0136]

bilstm是由前向lstm和后向lstm结合而成,以获得长时期的上下文信息。具体而言就是以lstm的方式将反转后的输入序列计算,最终将正向lstm的结果与反向lstm的结果进行堆叠;

[0137]

进一步的,pr注意力机制与所述resnet34网络拓扑进行集成模块提取到的高维手语视频特征向量送入bilstm-lstm的编码器解码器中。具体地说,我们将手语图片x={x1,x2,...,xi,...,x

t

}作为输入至pr注意力机制与所述resnet34网络拓扑进行集成后的网络以提取所述第二视频数据集的特征信息;

[0138]

结合图6,网络,网络将输出e={e1,e2,...,ei,...,e

t

},其中xi∈rc×h×w,ei∈rc′

,t代表手语视频的帧数。将特征提取网络的输出进行堆叠,得到的可以作为bilstm编码器的输入;

[0139]

s4:构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

[0140]

优选的,所述方法还包括:

[0141]

获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试。

[0142]

优选的,所述采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频数据训练集的步骤包括:

[0143]

获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心;

[0144]

基于所述第一视频数据训练集的帧集合获取所述第一视频数据训练集的帧,并基于所述所有簇的簇质心以获取所述第一视频数据训练集的帧到簇质心的最近距离;

[0145]

判定所述第一视频数据训练集的帧到簇质心的最近距离是否小于初始阈值;

[0146]

若是,则将所述第一视频数据训练集的帧归至最近距离的簇质心的类中,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始

阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤;

[0147]

若否,则将所述第一视频数据训练集的帧定义归至新的类别,将所述第一视频数据训练集的帧从所述第一视频数据训练集的帧集合剔除,并执行所述获取初始阈值、所述第一视频数据训练集的帧集合、所有簇的簇质心的步骤。

[0148]

结合图2至图4,优选的,所述resnet34网络拓扑包括初始层、第一残差层、第二残差层、第三残差层、第四残差层以及全局平均池化层;

[0149]

所述第一残差层的卷积核数为64,所述第一残差层的数量为3;

[0150]

所述第二残差层的卷积核数为128,所述第二残差层的数量为4;

[0151]

所述第三残差层的卷积核数为256,所述第三残差层的数量为6;

[0152]

所述第四残差层的卷积核数为512,所述第四残差层的数量为3;

[0153]

进一步的,作为cnn的一种骨干网络,resnet早已广泛应用到计算机视觉中的各种场景;

[0154]

resnet(deep residual network)名为深度残差网络,其最重要的特点便是由许多参数相同的残差单元连接起来组成basicblock,多个basicblock组合起来再加上预处理层和最后的全连接分类层便组成了resnet网络,其中残差单元residual如图3所示。考虑到神经网络深度的显著影响,本文选择使用resnet来解决该问题。具体来说,本技术使用如图4所示的resnet34作为本发明的骨干网络,再融合空间和通道的注意力机制,可以很好地提取手语视频的图像特征信息,同时避免深层网络梯度消失的问题。

[0155]

近一点的,将pr注意力机制与所述resnet34网络拓扑进行集成的步骤包括:

[0156]

将所述第四残差层与全局平均池化层间引入所述pr注意力机制。

[0157]

需要说明的是,在本发明提供的实施例中,因为特征图混合了冗余信息,所以本文突出了空间手部运动的重要区域,同时使用不同的权重表示不同的重要性。因为每个通道的功能代表一个独特的检测器,所以通道注意力的目的是关注哪种特征有意义。此外,本文引入的空间注意力模块,专注于哪些空间特征更有意义。

[0158]

优选的,所述将psa通道注意力机制和rcc空间注意力机制融合成pr注意力机制的步骤中,其中所述psa通道注意力机制为:

[0159]

[x0,x1,

…

,x

s-1

]=split(x);

[0160]fi

=conv(ki×ki

,gi)(xi);

[0161]

f=cat([f0,f1,

…

,f

s-1

]);

[0162]

x∈rc×w×

h-所述第二视频训练集经过resnet34网络前四个残差层计算后得到的第一特征图;

[0163]

c,w和h-第一特征图的通道、宽度和高度;

[0164]

split-在通道维度上对第一特征图x∈rc×w×h进行平等划分成s份的操作;

[0165]

xi∈r

c/s

×w×

h-所述第一特征图经过平等划分后的特征图,其通道为c/s;

[0166]ki-不同卷积核参数;

[0167]gi-分组卷积的参数;

[0168]fi

∈r

c/s

×w×

h-经过多尺度特征提取后的多尺度特征;

[0169]

cat-在通道维度上拼接不同感受野下的多尺度特征;

[0170]

f∈rc×w×

h-多尺度特征拼接后的特征向量;

[0171]

采用如下公式对所述多尺度特征拼接后的特征向量进行权值提取:

[0172]gi

=avgpool(fi);

[0173]

zi=σ(w1δ(w0(gi)));

[0174]

z=cat([z0,z1,

…

,z

s-1

]);

[0175]

avgpool(

·

)-代表了全局平均池化;

[0176]

σ(

·

)是sigmoid激活函数;

[0177]

δ(

·

)是relu激活函数;

[0178]gi

∈r

c/s

×1×

1-对多尺度特征进行全局平均池化的特征向量;

[0179]

w0和w1分别是维度为[c/s/r,c/s],[c/s,c/s/r]的权重矩阵,其中r代表为减小率;

[0180]zi-维度为[c/s,1,1]的不同部分注意力权值;

[0181]

z-维度为[c,1,1]的跨维度的通道注意力特征权重图;

[0182]

采用如下公式对所得注意力权值进行归一化,并将权值与经过多尺度特征提取的特征向量做张量积的操作:

[0183]

att=softmax(z);

[0184]

y=att

⊙

f;

[0185]

att-归一化后的通道注意力权值;

[0186]

需要说明的是,在本发明所提供的实施例中,所述rcc注意力机制是将criss-cross模块串联两次从而获得丰富的上下文信息,其中criss-cross通道注意力机制为:

[0187]

q=wqy;

[0188]

k=wky;

[0189]

v=wvy;

[0190]

wq和wk均是维度为[c

′

,c]的权重矩阵;

[0191]

wv是维度为[c,c]的权重矩阵;

[0192]

并采用如下公式将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息:

[0193]

进行affinity操作以获取大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系:

[0194]

d=affinity(q,k);

[0195][0196]

affinity-q,k都是维度为[c

′

,w,h]的特征图;

[0197]

ω

u-在q的空间维度中针对每一个位置u都存在特征向量

[0198]

其中是ωu的第i个元素,

[0199]di,u

∈d-特征qu和ω

i,u

,i=[1,

…

,h w-1]的相关度。

[0200]

进一步的,在q的空间维度中针对每一个位置u都存在特征向量进一步的,在q的空间维度中针对每一个位置u都存在特征向量与此同时,可以从k矩阵中提取与位置u处于同一行与同一列的特征向量集合其中是ωu的第i个元素,d

i,u

∈d是特征qu和ω

i,u

,i=[1,

…

,h w-1]的相关度;

[0201]

基于大小为[w,h]的特征图中每一个像素点与其同行同列像素点的关系d在通道维度上应用softmax层从而计算特征图a:

[0202]

a=softmax(d);

[0203]

对特征图a进行aggregation操作从而收集上下文信息y

′

:

[0204][0205]

aggregation-在v的空间维度中针对每一个位置u都存在特征向量vu∈rc,集合φu∈r

(h w-1)

×c是从v矩阵中提取与位置u处于同一行与同一列的特征向量集合;

[0206]y′‑

所述为已捕捉到垂直方向和水平方向长连接的上下文信息;

‘

[0207]

但此时,其像素级别的特征信息还略显稀疏,因此需要对已捕捉到垂直方向和水平方向长连接的上下文信息重复串联,如下列公式所示:

[0208]y″

=crisscross(y

′

);

[0209]y′

=crisscross(y);

[0210]y″‑

所述为已获取到全局像素信息的特征向量。

[0211]

优选的,所述采用lstm-ctc端对端网络结构拓扑以及所述第二视频数据训练集的标签对编码后所述第二视频数据集进行解码的步骤包括:

[0212]

计算lstm-ctc端对端网络的ctc损失函数,具体包括:

[0213]

定义一种多对一的映射函数β(

·

)来对应其目标序列y:

[0214]

其中

[0215][0216]

式中,π

n-n时刻的π标签;

[0217]-n时刻发生的概率;

[0218]

ctc损失函数为:

[0219][0220]

进一步的,ctc是一个集成了输入序列和目标序列之间对齐的所有可能性的目标函数。在本发明用到的数据集中,标签(-)已经被添加到手语注释中从而精确的模拟两个相邻手语词汇之间的过渡;

[0221]

输入序列的中间标签路径被表示为π=(π1,π2,

…

,π

t

,

…

,π

t

),其中π

t

∈{v∪{-}*};v是手语单词词汇表,星号是通配符;

[0222]

对于给定的输入x,路径π的概率计算公式如下所示

[0223][0224]

其中的πn是n时刻的π标签,是n时刻发生的概率。

[0225]

由于手语注释标签的各种细分,容易导致相同的输入序列和目标序列仍会产生不同的对齐方式,因此,ctc定义了一种多对一的映射函数β(

·

)来对其目标序列y,即y=β(π)。y的概率可以被定义为所有与之相符的对齐的总和概率,计算公式如下所示:

[0226][0227]

于是,可以将上述公式替换为ctc损失函数,定义如下公式:

[0228][0229]

优选的,采用如下公式构建目标函数:

[0230][0231]

l-所构建的目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm编码器网络拓扑参数以及所述lstm-ctc解码器网络结构拓扑进行调整;

[0232]

s-给定第二视频数据集的维度;

[0233]

||ω||

2-避免过拟合的正则化项;

[0234]

λ-正则项的超参数。

[0235]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0236]

获取wer值表示识别的精度:

[0237][0238]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0239]

n表示标签的单词总数。

[0240]

需要说明的是,在语音识别和机器翻译任务中,word error rate(wer)经常被用来当作实验的评价指标。在本发明中,我们通过采用不同的实验指标误词率wer和准确率accuracy进行网络质量的评估。通过观察评估指标可以判断模型效果,但在本发明中,未涉及到根据指标学习网络,因此本发明设计的crb-net仍采用梯度下降的方法进行网络的训练;

[0241]

wer通过替换、删除和插入操作的组合来测量序列转换。对于手语识别任务,一个低的wer值往往可以表示为识别的高精度,wer的计算公式如下

[0242][0243]

优选的,所述获取第一视频数据测试集,对构建完成的所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑、所述bilstm网络拓扑以及所述lstm-ctc端对端网络结构拓扑进行测试的步骤包括:

[0244]

获取准确率accuracy表示识别的精度:

[0245][0246]

s、i(ins)和d(del)分别为最小替换、插入、删除操作;

[0247]

n表示标签的单词总数;

[0248]

实施例二:

[0249]

本发明提供了一种基于resnet34网络-注意力机制的连续手语识别装置,包括:

[0250]

视频获取模块:用于获取第一视频数据训练集,所述第一视频数据集包括rgb视频以及深度视频并采用kfe聚类算法提取所述第一视频数据训练集的关键帧以获取第二视频

数训练集,所述第二视频训练集具有标签;

[0251]

特征提取模块:用于构建resnet34网络拓扑,并将pr注意力机制与所述resnet34网络拓扑进行集成以提取所述第二视频数据集的特征信息;

[0252]

解码模块:用于构建bilstm网络拓扑以对所述第二视频数据集的特征信息进行编码,采用lstm-ctc端对端网络结构拓扑以对编码后所述第二视频数据集进行解码;

[0253]

参数调整模块:用于构建目标函数,以对所述resnet34网络拓扑与所述pr注意力机制集成后的网络拓扑参数、所述bilstm网络拓扑参数以及所述lstm-ctc端对端网络结构拓扑参数进行调整。

[0254]

实施例三:

[0255]

本发明实施例三为了证明本发明提出的网络模型在强监督学习下测试集的泛化性,本发明的方法在两个大型的手语数据集上均进行了评估,包括来自中国科学技术大学的csl数据集,以及自己的tjut手语识别和翻译的数据集(tjut-slrt)。实验结果表明本发明提出的算法对不同的数据集进行wer指标的评估,均有较高的精度,从而证明了本发明有着极高的泛化性。

[0256]

本发明具有如下优势:

[0257]

1)本算法分别在两个大规模的手语数据集上进行评估在由tjut-slrt数据集划分的测试集上进行实验测试,结果如下列表格所示,可以看到本技术提供的方法在误词率wer上要低于基于cbam注意力机制的连续手语识别方法,也验证了本方法的泛化程度好;

[0258]

本方法与基于cbam注意力机制的手语识别方法在tjut测试数据集上的wer训练结果:

[0259] resnet34 cbam bilstmresnet34 prr bilstm(ours)tjut11.45%11.26%

[0260]

本方法在csl数据集上的wer训练结果:

[0261]

datasetdevtestcsl2.01%1.76%

[0262]

本方法在csl数据集上不同设置下的准确率:

[0263]

methodaccuraycnn lstm0.873resnet18 lstm0.905resnet34 lstm0.926cnn bilstm0.896resnet18 bilstm0.928resnet34 bilstm0.943prr-resnet34 bilstm0.982

[0264]

2)使用rgb视频以及深度视频数据,利于网络更好学习图像特征表示;

[0265]

3)采用基于k-means算法的kfe聚类算法减少了视频的冗余,进一步缓解了神经网络结构过渡拟合的技术问题,提高了连续手语识别方法的泛化能力;

[0266]

4)在现有resnet34网络拓扑引入了pr注意力模块使得网络更聚焦于手部特征,pr

注意力模块在通道维度上捕获不同尺度的空间信息来丰富特征空间,并从全局空间信息出发建立远距离依赖;在空间维度上采用二阶注意力以生成具有密集且丰富的上下文信息的特征图,因其采用连续的两次稀疏自注意力计算来逼近一次稠密的自注意力计算,使其在保证先进性能的同时,不仅降低了内存消耗和时间复杂度,还减少了全域像素中冗余信息的干扰;

[0267]

5)使用编码器-解码器的网络模型实现端到端的连续手语识别,在捕获图像特征在时间维度上语义信息的同时,可以实现长度不相等源序列和目标序列之间的映射,;从纵向看,隐藏层包含了更多先前节点的信息,尤其是在视频帧数较多的手语序列中,模型具有更好的记忆性,有效避免了长序列中信息损失的问题。;

[0268]

除非另外具体说明,否则在这些实施例中阐述的部件和步骤的相对步骤、数字表达式和数值并不限制本发明的范围。

[0269]

本发明实施例所提供的装置,其实现原理及产生的技术效果和前述方法实施例相同,为简要描述,装置实施例部分未提及之处,可参考前述方法实施例中相应内容。

[0270]

应注意到:相似的标号和字母在下面的附图中表示类似项,因此,一旦某一项在一个附图中被定义,则在随后的附图中不需要对其进行进一步定义和解释。

[0271]

附图中的流程图和框图显示了根据本发明的多个实施例的系统、方法和计算机程序产品的可能实现的体系架构、功能和操作。在这点上,流程图或框图中的每个方框可以代表一个模块、程序段或代码的一部分,所述模块、程序段或代码的一部分包含一个或多个用于实现规定的逻辑功能的可执行指令。也应当注意,在有些作为替换的实现中,方框中所标注的功能也可以以不同于附图中所标注的顺序发生。例如,两个连续的方框实际上可以基本并行地执行,它们有时也可以按相反的顺序执行,这依所涉及的功能而定。也要注意的是,框图和/或流程图中的每个方框、以及框图和/或流程图中的方框的组合,可以用执行规定的功能或动作的专用的基于硬件的系统来实现,或者可以用专用硬件与计算机指令的组合来实现。

[0272]

所属领域的技术人员可以清楚地了解到,为描述的方便和简洁,上述描述的系统和装置的具体工作过程,可以参考前述方法实施例中的对应过程,在此不再赘述。

[0273]

另外,在本发明实施例的描述中,除非另有明确的规定和限定,术语“安装”、“相连”、“连接”应做广义理解,例如,可以是固定连接,也可以是可拆卸连接,或一体地连接;可以是机械连接,也可以是电连接;可以是直接相连,也可以通过中间媒介间接相连,可以是两个元件内部的连通。对于本领域的普通技术人员而言,可以具体情况理解上述术语在本发明中的具体含义。

[0274]

在本发明的描述中,需要说明的是,术语“中心”、“上”、“下”、“左”、“右”、“竖直”、“水平”、“内”、“外”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本发明的限制。此外,术语“第一”、“第二”、“第三”仅用于描述目的,而不能理解为指示或暗示相对重要性。

[0275]

最后应说明的是:以上所述实施例,仅为本发明的具体实施方式,用以说明本发明的技术方案,而非对其限制,本发明的保护范围并不局限于此,尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:任何熟悉本技术领域的技术人员

在本发明揭露的技术范围内,其依然可以对前述实施例所记载的技术方案进行修改或可轻易想到变化,或者对其中部分技术特征进行等同替换;而这些修改、变化或者替换,并不使相应技术方案的本质脱离本发明实施例技术方案的精神和范围,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应所述以权利要求的保护范围为准。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。