1.本发明属于语音识别领域,特别涉及一种基于红外微光望远镜的多源融合唇语识别方法和系统。

背景技术:

2.基于唇部图像的语音解析是通过唇部动作来解析说话者所说的内容。近年来,国内在唇语识别方面发展速度十分迅速。例如,搜狗联合清华天工研究院共同设计了基于模态重要程度的注意力机制,使模型可以自适应调整模态权重来融合音视觉特征。2019年,中科院计算所发布了目前最大规模的中文词级唇读数据集lrw-1000,其包含了复杂的变化条件,包括唇部角度、光照、语速等,模拟了自然条件下唇部样本的分布,为今后国内外中文唇读研究者提供了更丰富的标准研究样本。虽然唇语识别技术在性能方面有了较大突破,但其准确率受光线、角度、训练模型等因素的影响较大,特别是在光照亮度较低、距离使用者或被观察者较远时无法获取有效的图像数据。这种唇部图像的获取方式限制了唇语识别的应用环境与场合,无法满足如战术侦察、进攻目标信息获取等特殊应用需求。

3.基于红外和微光成像融合的望远镜可用于环境侦察、目标对象追踪、抢险救援等多种场合,具有侦察距离远、范围广,方便携带和适应性好等特点。红外热成像系统不受光照条件限制,可以全天候工作,具有较强的穿透雾、霾、雨、雪等极端气象条件的能力,作用距离更远。而微光成像响应速度快,敏感于目标对象的反射,分辨率较高。通过红外微光融合的望远镜进行不同光照条件下的远距离观测和目标视频图像获取,可以获取目标对象的多源面部图像数据,根据其面部信息进行唇语识别,从而更快速准确地得到目标对象的交互信息和意图。这种唇部图像获取方式弥补了传统唇语识别系统的数据采集限制,拓宽了唇语识别技术的应用领域与场合,提高了唇语识别系统的识别准确度,也为特殊应用场景如与特种作战提供了更加安全可靠的信息获取途径。

技术实现要素:

4.本发明提出了一种基于红外微光望远镜的多源融合唇语识别方法,包括:

5.获取红外热成像视频和微光视频,提取唇部区域的红外热成像图像数据和微光图像数据;

6.使用多源融合唇语识别模型对唇部区域的红外热成像图像数据和微光图像数据进行识别,得到识别出的文本;

7.将识别出的文本显示或发送至其他接收设备。

8.进一步地,所述对获取红外热成像视频和微光视频,提取唇部区域的红外热成像图像数据和微光图像数据包括:

9.采集红外热成像视频和微光成像视频后,将视频数据进行分帧,得到目标对象的红外热成像图像序列和微光图像序列;

10.根据所述目标对象的红外热成像图像和微光图像进行人脸检测和唇部区域标记,

得到目标对象唇部区域的红外热成像图像数据和微光图像数据;

11.所述根据所述目标对象的红外热成像图像序列和微光图像序列进行人脸检测和唇部区域标记,得到目标对象唇部区域的红外热成像图像数据和微光图像数据包括:

12.使用动态多帧平均算法对红外热成像图像序列进行降噪;使用帧间差分法确定目标对象开始说话时的图像起始点和终止点;根据人脸的几何结构比例定位唇部区域,得到目标对象唇部区域的红外热成像图像数据;

13.使用帧积分法对微光图像序列进行图像降噪;使用帧间差分法确定目标对象开始说话时的图像起始点和终止点;根据人脸的几何结构比例定位唇部区域,得到目标对象唇部区域的微光图像数据。

14.进一步地,所述多源融合唇语识别模型使用如下方式建立:

15.获取若干红外热成像视频和微光视频及对应的文本,提取其唇部区域的红外热成像图像数据和微光图像数据;

16.将提取的红外热成像图像数据和微光图像数据及对应的文本送入到双cnn-resnet-lstm-bi-lstm-rnn-lm网络中进行学习,其中,

17.提取的红外热成像图像数据和微光图像数据为输入数据,对应的文本为输出数据。

18.进一步地,所述双cnn-resnet-lstm-bi-lstm-rnn-lm网络,包括两个cnn-resnet-lstm网络,一个bi-lstm网络,一个rnn-lm网络;两个cnn-resnet-lstm网络输出部分分别与bi-lstm输入层连接; bi-lstm输出层与rnn-lm输入层连接;

19.其中,两个cnn-resnet-lstm网络分别用于对红外热成像图像数据和微光图像数据分别进行特征提取,得到基于红外热成像图像的特征和基于微光图像的特征;bi-lstm用于对基于红外热成像图像的特征和基于微光图像的特征进行融合,得到多源融合唇部图像特征;rnn-lm对融合后的多源融合唇部图像特征进行文本学习和匹配,通过集束搜索得到最大概率的输出文本。

20.进一步地,所述两个cnn-resnet-lstm分别对红外热成像图像数据和微光图像数据分别进行特征提取包括:

21.使用cnn对红外热成像图像数据进行空间特征提取;所述cnn由1 个3d卷积层、1个最大池化层堆叠组成;

22.所述cnn卷积层对输入特征做矩阵元素乘法求和并叠加偏差量,如式 (5)所示:

[0023][0024]

池化层如式6所示:

[0025][0026]

使用resnet对目标红外热成像图像空间特征进行数据降维;

[0027]

所述resnet网络共有三个残差单元后加自适应平均池化层,第一个残差单元采用三对64卷积核的卷积神经网络;第二个残差单元采用四对128 卷积核的卷积神经网络;第三个残差单元采用六对256卷积核的卷积神经网络;

[0028]

残差单元如式7所示:

[0029]

x

l 1

=h(x

l

) f(x

l

,w

l

)

ꢀꢀꢀ

(7)

[0030]

其中,x

l

表示残差模块中第l层的输入,w

l

是第l层的神经网络权重系数,f是第l层的输出函数,h(x

l

)=x

l

表示恒等映射,x

l 1

表示残差模块中第l 1层的输入;

[0031]

使用lstm增加红外热成像图像数据降维后空间特征的时序特征,得到基于红外热成像图像的特征;

[0032]

所述lstm的遗忘门输入为上一逻辑单元输出层的输出值h

t-1

和本层输入的序列数据x

t

,如式8所示:

[0033]ft

=σ(wf·

[h

t-1

,x

t

] bf)

ꢀꢀꢀ

(8)

[0034]

其中,σ表示激活函数sigmoid,bf是遗忘门偏置量,wf是遗忘门的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输出值和当前序列特征图共同作为输入,f

t

即为当前遗忘门层的输出;

[0035]

lstm的输入门包含两个部分,第一部分使用sigmoid作为激活函数,输出为i

t

,第二部分使用tanh作为激活函数,输出如式9所示:

[0036]it

=σ(wi·

[h

t-1

,x

t

] bi)

ꢀꢀꢀ

(9)

[0037]

其中,σ表示激活函数sigmoid,bi是输入门偏置量,wi是输入门的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输出值和当前序列特征图共同作为输入,i

t

即为当前输入门层的输出;

[0038]

lstm输入门的第二部分作为本层状态更新,如式10所示:

[0039][0040][0041]

其中,tanh是激活函数,bc是状态更新计算的偏置量,wc是状态更新的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输出值和当前序列特征图共同作为输入,为输入门的状态输出,c

t-1

为前序逻辑单元的状态值,c

t

为当前逻辑单元的状态值,它与前序逻辑单元的状态值c

t-1

、遗忘门输出f

t

、输入门输出i

t

和输入门层的状态相关。

[0042]

长短期记忆网络当前逻辑单元的输出如式11所示:

[0043]ht

={σ(wo[h

t-1

,x

t

] bo)}*tanh(c

t

)

ꢀꢀꢀ

(11)

[0044]

其中,σ表示激活函数sigmoid,bo是输出门偏置量,wo是输出门的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输出值和当前序列特征图共同作为输入,tanh(c

t

) 是当前逻辑单元的状态值c

t

经激活函数tanh计算后的结果,h

t

即为当前逻辑单元输出门层的输出;

[0045]

使用cnn对微光图像数据进行空间特征提取;使用resnet对微光图像空间特征进行数据降维;使用lstm增加微光图像数据特征的时序特征,得到基于微光图像的特征。

[0046]

进一步地,所述卷积层包含64个三维卷积核,每个三维卷积核大小为 (5,7,7),卷积步长为(1,2,2),填充步长为(2,3,3)。

[0047]

本发明还提供一种基于红外微光望远镜的多源融合唇语识别系统,所述多源融合

唇语识别系统包括,

[0048]

获取模块,用于获取红外热成像视频和微光视频;

[0049]

提取模块,用于从红外热成像视频和微光视频提取唇部区域的红外热成像图像数据和微光图像数据;

[0050]

识别模块,用于使用多源融合唇语识别模型对唇部区域的红外热成像图像数据和微光图像数据进行识别,得到识别出的文本;

[0051]

显示模块,用于将识别出的文本显示;

[0052]

输出模块,用于将识别出的文本发送至其他接收设备。

[0053]

进一步地,所述系统还包括:

[0054]

模型建立模块,用于建立多源融合唇语识别模型;

[0055]

所述多源融合唇语识别模型使用如下方式建立:

[0056]

获取若干红外热成像视频和微光视频及对应的文本,提取其唇部区域的红外热成像图像数据和微光图像数据;

[0057]

将提取的红外热成像图像数据和微光图像数据及对应的文本送入到双 cnn-resnet-lstm-bi-lstm-rnn-lm网络中进行学习,其中,

[0058]

提取的红外热成像图像数据和微光图像数据为输入数据,对应的文本为输出数据。

[0059]

进一步地,所述双cnn-resnet-lstm-bi-lstm-rnn-lm网络,包括两个cnn-resnet-lstm网络,一个bi-lstm网络,一个rnn-lm网络;两个cnn-resnet-lstm网络输出部分分别与bi-lstm输入层连接; bi-lstm输出层与rnn-lm输入层连接;

[0060]

其中,两个cnn-resnet-lstm网络分别用于对红外热成像图像数据和微光图像数据分别进行特征提取,得到基于红外热成像图像的特征和基于微光图像的特征;bi-lstm用于对基于红外热成像图像的特征和基于微光图像的特征进行融合,得到多源融合唇部图像特征;rnn-lm对融合后的多源融合唇部图像特征进行文本学习和匹配,通过集束搜索得到最大概率的输出文本。

[0061]

进一步地,所述两个cnn-resnet-lstm分别对红外热成像图像数据和微光图像数据分别进行特征提取包括:

[0062]

使用cnn对红外热成像图像数据进行空间特征提取;使用resnet对目标红外热成像图像空间特征进行数据降维;使用lstm增加红外热成像图像数据降维后空间特征的时序特征;得到基于红外热成像图像的特征;

[0063]

使用cnn对微光图像数据进行空间特征提取;使用resnet对微光图像空间特征进行数据降维;使用lstm增加微光图像数据特征的时序特征,得到基于微光图像的特征。

[0064]

本发明使用红外与微光融合的望远镜在不同光照环境,从远距离获取目标对象唇部区域的多源图像信息,通过机器学习和深度学习算法进行多源融合的唇部特征提取与建模,并使用语言模型进行文本合成和输出。这种唇语识别的数据获取与处理系统为复杂光照环境、远距离和特殊应用场合提供了更加安全可靠的信息获取与交互方式。弥补了单一视频数据来源特征提取和唇部图像识别的局限性,通过多源数据特征融合建模极大地提高了唇语识别的准确性。拓展了唇语识别技术的应用范围和场景,为唇语识别技术的发展提供了新的方向。

附图说明

[0065]

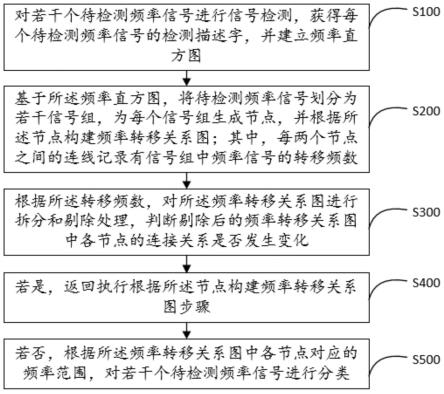

图1示出了本发明实施例中一种基于红外微光望远镜的多源融合唇语识别方法的流程示意图;

[0066]

图2示出了本发明实施例中双cnn-resnet-lstm-bi-lstm-rnn-lm 网络结构的示意图;

[0067]

图3本发明实施例中一种基于红外微光望远镜的多源融合唇语识别系统结构的示意图。

具体实施方式

[0068]

下面将参照附图更详细地描述本公开的示例性实施例。虽然附图中显示了本公开的示例性实施例,然而应当理解,可以以各种形式实现本公开而不应被这里阐述的实施例所限制。相反,提供这些实施例是为了能够更透彻地理解本公开,并且能够将本公开的范围完整地传达给本领域的技术人员。

[0069]

本发明设计一种基于红外微光望远镜的多源融合唇语识别方法,如图1 所示。本发明中建立模型或最终的识别,均需要通过红外微光望远镜获取目标对象的红外热成像视频和微光视频并进行相应视频预处理。

[0070]

通过红外微光望远镜获取目标对象的红外热成像视频和微光视频并进行相应视频预处理方法如下。

[0071]

s1:获取红外热成像视频和微光视频,提取唇部区域的红外热成像图像数据和微光图像数据。

[0072]

在不同的环境中,通过红外微光融合望远镜采集得到的红外热成像视频和微光成像视频可能不同。如在南方热带或亚热带地区,得到的红外热成像视频效果不佳;而目标对象如处于光线高度变换较剧烈场所,得到的微光成像视频效果不佳。同时获取红外热成像视频和微光视频,能够根据其面部信息进行唇语识别,从而更快速准确地得到目标对象的交互信息和意图。

[0073]

通过红外微光融合望远镜同步采集包含目标对象的红外热成像视频和微光成像视频,将视频数据进行分帧得到目标对象的红外热成像图像和微光图像。根据所述目标对象的红外热成像图像和微光图像进行人脸检测和唇部区域标记,得到目标对象唇部区域的红外热成像图像数据和微光图像数据。

[0074]

建立模型时,采集目标对象的红外热成像视频和微光成像视频的同时,收集对应的文本。可以使用但不限于以下方式采集视频和文本,找到若干实验者,在各种光线下,指定若干文本进行说话,并用红外微光融合望远镜拍摄;包括不同亮度的,不同色彩的,自然光或人工光等各种光线。

[0075]

采集红外热成像视频和微光成像视频后,将视频数据进行分帧,具体帧数取决于录像设备,如将红外热成像视频每1秒分85帧,微光视频数据每1秒分为60帧,得到目标对象的红外热成像图像序列和微光图像序列。图像序列是多个连续图像的组合。

[0076]

根据所述目标对象的红外热成像图像序列和微光图像序列进行人脸检测和唇部区域标记,得到目标对象唇部区域的红外热成像图像数据和微光图像数据,包括:

[0077]

对红外热成像图像序列进行图像降噪,采用动态帧间滤波提高红外热成像图像序

列的信噪比。使用动态多帧平均算法对红外热成像图像序列进行降噪,示例性的,使用20帧动态多帧平均算法对红外热成像图像序列进行降噪,如式1所示:

[0078][0079]

其中,k为第k帧图像序列中的图像,k≥20,j=20,19,

…

2,f(x,y,t) 表示原始图像在t时刻第k帧(x,y)坐标位置处的像素值。

[0080]

对降噪后的红外热成像图像序列,使用帧间差分法(temporal

ꢀꢀ

difference)确定目标对象开始说话时的图像起始点和终止点。帧间差分法是一种通过对视频图像序列连续两帧图像进行差分运算从而获得运动目标轮廓的方法,当相邻两帧图像之间出现较为明显的差别时,将两帧图像对应位置像素值相减,其绝对值将大于设定的阈值。通过对连续的降噪后的红外热成像图像序列进行帧间差分运算,得到目标对象开始说话和结束说话时唇部区域的运动轮廓变化,标记为唇语识别的起始点和终止点,帧间差分法如式2所示:

[0081][0082]

其中,d(x,y)为连续两帧红外热成像图像的差分图像,i(t)和i(t-1) 分别为t和(t-1)时刻的红外热成像图像在同一点的像素值,t为差分图像二值化时选取的像素阈值,t的值由操作人员根据红外热成像图像像素及经验设置,示例性的,t=20。

[0083]

通过帧间差分法保留目标对象说话过程中降噪后的红外热成像图像序列。

[0084]

根据人脸的几何结构比例定位唇部区域,得到目标对象唇部区域的红外热成像图像数据。由于脸部元素位置关系在任何情况下都不会改变,因此可以通过关键人脸元素的几何关系推断和检测嘴唇的区域。唇部区域位置如式3获示:

[0085][0086][0087]

其中,w

face

和h

face

分别表示人脸区域的宽度和高度,w

mouth

和h

mouth

分别表示提取的唇部区域宽度和高度。

[0088]

通过关键人脸元素检测目标对象说话过程中的唇部运动信息,根据唇部区域大小截取唇部区域运动图像序列。此时得到目标对象完整说话过程中唇部区域的红外热成像图像数据,该数据是多个连续图像的组合,即图像序列。在本技术中,使用红外热成像图像数据矩阵h(m,x,y)做为用于输入的红外热成像图像数据。红外热成像图像数据矩阵h是个三维矩阵,其中m表示帧数,(x,y)表示每帧图像的像素大小,第一维是帧数,第二三维共同组成每帧图像的像素大小,帧数m是包含在矩阵之内的。这里的红外热成像图像数据矩阵是经过视频预处理后直接输入后续神经网络的数据。由于进行了唇部区域提取和裁剪,最终的图像序列像素大小由唇部区域的大小决定。示例性的,此时m=85,(x,y)=(200,150)。

[0089]

对微光图像序列进行图像降噪,采用帧积分法提高图像信噪比。帧积分法对连续20帧微光图像序列进行积分,如式4所示:

[0090][0091]

其中,p表示微光图像序列累计m帧后图像的像素功率,0《i《j《 m;i=1,2,

…

m,v

ivj

分别是第i帧和第j帧在对应像素位置处的电压幅值, c

ij

是信号之间的关系系数,优选的,m=20。

[0092]

对降噪后的微光图像序列,使用帧间差分法确定目标对象开始说话时的图像起始点和终止点,保留目标对象说话过程中的微光图像序列;根据人脸的几何结构比例定位唇部区域,根据唇部区域大小截取唇部区域运动图像序列。此时得到目标对象完整说话过程中唇部区域的微光图像数据,使用微光图像数据矩阵w(m,x,y)做为用于输入的微光图像数据,其中m 表示帧数,(x,y)表示每帧图像的像素大小。示例性的,m=60,(x,y)=(200, 150)。

[0093]

s2:根据所述目标对象唇部区域红外热成像图像数据和微光图像数据确定多源唇部特征,建立多源融合唇语识别模型。

[0094]

本发明使用双cnn-resnet-lstm-bi-lstm-rnn-lm网络建立多源融合唇语识别模型。双cnn-resnet-lstm-bi-lstm-rnn-lm网络,如图2 所示,包括两个cnn-resnet-lstm网络,一个bi-lstm网络,一个 rnn-lm网络;两个cnn-resnet-lstm网络输出部分分别与bi-lstm输入层连接;bi-lstm输出层与rnn-lm输入层连接。

[0095]

本发明使用两个cnn-resnet-lstm分别对红外热成像图像数据和微光图像数据分别进行特征提取,使用双向长短期记忆网络(bi-lstm)对基于红外热成像图像的特征和基于微光图像的特征进行融合,使用 rnn-lm对融合后的多源融合唇部图像特征进行文本学习和匹配,最终学习生成多源融合唇语识别模型。

[0096]

使用两个cnn-resnet-lstm分别对红外热成像图像数据和微光图像数据分别进行特征提取如下:

[0097]

使用3d卷积神经网络(convolutionalneural network,cnn)对目标对象唇部区域的红外热成像图像数据矩阵h(85,200,150)进行空间特征提取。卷积神经网络由多个卷积层、池化层和全连接层堆叠组成。本发明的cnn 由1个3d卷积层、1个最大池化层堆叠组成。卷积层内部包含多个卷积核,组成卷积核的每个元素都对应一个权重系数和一个偏差量(bias vector),类似于一个前馈神经网络的神经元。本发明卷积层内部包含64个三维卷积核,即式5中的特征图通道数,每个三维卷积核大小为(5,7,7)。卷积层内每个神经元都与前一层中位置接近的区域的多个神经元相连,区域的大小取决于卷积核的大小,卷积核在工作时,会有规律地扫过输入特征,对输入特征做矩阵元素乘法求和并叠加偏差量,如式5所示:

[0098][0099]

其中,(i,j)∈{0,1,

…

,l

l 1

},b为偏差量,z

l

表示(i, j)位置处第l层卷积输入像素值,z

l 1

表示第l 1层相应位置的卷积运算输出像素值,z

l

和z

l 1

也被称为特征图(feature map),l

l 1

为z

l 1

的尺寸, (i,j)表示具体像素点的坐标位置;k表示总数,为特征图的通道数;k表示第k个特征通道;f、s0和p是卷积层参数,分别对应卷积核大小、卷积步长(stride)和填充(padding)步长,w

l 1

是第l 1层每个神经元的权值矩阵,k

l

表示第l层的第k个特征通道。示例性的,特征通道总数k取64。

[0100]

在本发明中,f=(5,7,7);s0=(1,2,2);p=(2,3,3)。

[0101]

池化层的如式6所示:

[0102][0103]

其中,表示第k个特征图层第l层的池化输出(像素值);s0表示卷积步长、(i,j)表示具体像素点的坐标位置,p是预指定参数。

[0104]

使用残差网络(resnet)对目标对象唇部区域的红外热成像图像空间特征进行数据降维。残差网络的提出解决了深度模型在训练时梯度消失或梯度爆炸的问题。

[0105]

本发明使用resnet34网络,优选的,采用resnet34的简化版本。所述残差网络共有三个残差单元后加自适应平均池化层。第一个残差单元采用三对(6个)64卷积核的卷积神经网络;第二个残差单元采用四对(8个) 128卷积核的卷积神经网络;第三个残差单元采用六对(12个)256卷积核的卷积神经网络,每个卷积核的大小是3*3(2d卷积)。

[0106]

其中,网络中的残差单元如式7所示:

[0107]

x

l 1

=h(x

l

) f(x

l

,w

l

)

ꢀꢀꢀ

(7)

[0108]

其中,x

l

表示残差模块中第l层的输入,w

l

是第l层的神经网络权重系数,f是第l层的输出函数,h(x

l

)=x

l

表示恒等映射,x

l 1

表示残差模块中第l 1层的输入。

[0109]

使用长短期记忆网络增加红外热成像图像数据降维后空间特征的时序特征。长短期记忆网络(lstm)是一种特殊的循环神经网络(recurrent

ꢀꢀ

neural network,rnn),但它的门结构(输入门、遗忘门和输出门)解决了循环神经网络长依赖的问题,使网络本身可以存储长期的信息。本技术中,用于对单模态时空特征提取的lstm网络隐藏层状态维数为512,模型结构不变。长短期记忆网络的遗忘门决定需要丢弃的信息,其输入为上一逻辑单元输出层的输出值h

t-1

和本层输入的序列数据x

t

,如式8所示:

[0110]ft

=σ(wf·

[h

t-1

,x

t

] bf)

ꢀꢀꢀ

(8)

[0111]

其中,σ表示激活函数sigmoid,bf是遗忘门偏置量,wf是遗忘门的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输出值和当前序列特征图共同作为输入,f

t

即为当前遗忘门层的输出。

[0112]

长短期记忆网络的输入门包含两个部分,第一部分使用sigmoid作为激活函数,输出为i

t

,第二部分使用tanh作为激活函数,输出如式9所示:

[0113]it

=σ(wi·

[h

t-1

,x

t

] bi)

ꢀꢀꢀ

(9)

[0114]

其中,σ表示激活函数sigmoid,bi是输入门偏置量,wi是输入门的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输出值和当前序列特征图共同作为输入,i

t

即为当前输入门层的输出;

[0115]

lstm输入门的第二部分作为本层状态更新,如式10所示:

[0116][0117][0118]

其中,tanh是激活函数,bc是状态更新计算的偏置量,wc是状态更新的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输

出值和当前序列特征图共同作为输入,为输入门的状态输出,c

t-1

为前序逻辑单元的状态值,c

t

为当前逻辑单元的状态值,它与前序逻辑单元的状态值c

t-1

、遗忘门输出f

t

、输入门输出i

t

和输入门层的状态相关。

[0119]

长短期记忆网络当前逻辑单元的输出如式11所示:

[0120]ht

={σ(wo[h

t-1

,x

t

] bo)}*tanh(c

t

)

ꢀꢀꢀ

(11)

[0121]

其中,σ表示激活函数sigmoid,bo是输出门偏置量,wo是输出门的权值。h

t-1

为上一逻辑单元输出层的输出值,x

t

为本层输入的序列数据,前序特征图经过输出门层的输出值和当前序列特征图共同作为输入,tanh(c

t

) 是当前逻辑单元的状态值c

t

经激活函数tanh计算后的结果,h

t

即为当前逻辑单元输出门层的输出。

[0122]

使用cnn-resnet-lstm对红外热成像图像数据进行特征提取后,得到基于红外热成像图像的特征。

[0123]

使用3d卷积神经网络,对目标对象唇部区域的微光图像像素数据矩阵 w(60,200,150)进行空间特征提取;使用残差网络对目标对象唇部区域的微光图像空间特征进行数据降维;使用长短期记忆网络增加微光图像数据特征的时序特征,得到基于微光图像的特征。

[0124]

将基于红外热成像图像的特征和基于微光图像的特征进行融合,得到多元融合唇部图像特征;

[0125]

lstm模型输出是单模态的特征。将基于红外热成像图像的特征提取模型后端长短期记忆网络(lstm)的输出作为红外热成像数据矩阵的时空特征向量,将基于微光图像的特征提取模型后端长短期记忆网络(lstm) 的输出作为微光数据矩阵的时空特征向量,对两种特征向量进行拼接,得到多源融合唇部图像特征;

[0126]

将多源融合唇部图像特征作为融合网络输入,使用隐藏层状态维数为 1024,层数为2层的双向长短期记忆网络(bi-lstm)作为融合网络,进一步对多元融合唇部图像特征建模。将双向长短期记忆网络的输出作为多源融合的特征建模数据,得到多源融合唇部图像特征。

[0127]

本发明使用双向长短期记忆网络(bi-lstm)对基于红外热成像图像的特征和基于微光图像的特征进行融合,得到目标对象的多源融合唇部图像特征,融合特征数据流正向和反向传播,主要用于对拼接后的特征进行进一步建模。

[0128]

本发明使用rnn-lm对融合后的多源融合唇部图像特征进行文本学习和匹配,通过集束搜索得到最大概率的输出文本。

[0129]

融合后的多源融合唇部图像特征进入rnn-lm网络,进行文本学习和匹配,合成文本输出。本发明在循环神经网络(rnn)引入了定向循环,用于处理输入之间前后关联的问题。lm指语言模型language model,是一种句法集合,简单的语言模型可以根据训练使用的实际文本构建语法库,从而计算模型上下文文字输出概率,lm语言模型使用bigram语言模型,即当前解码输出字符仅与前一字符相关。解码输出文本序列的概率如式12 所示:

[0130]

p(t)=p(w1|begin)

·

p(w2|w1)

·

p(w3|w2)

…

·

p(wn|w

n-1

)

ꢀꢀꢀ

(12)

[0131]

其中t为解码输出文本序列,p(w1|begin)表示输出文本第一个字(基于起始占位符)的概率,p(wn|w

n-1

)为基于前序字符的当前字符输出条件概率,p(t)为解码输出文本序列的概率,wn、w

n-1

分别表示输出文本的当前字符和前序字符。

[0132]

集束搜索采用宽度为4的集束搜索算法。即在当前所有的解码序列中选择概率最大的4个继续进行解码。

[0133]

本发明中,循环神经网络隐藏层之间的节点不再无连接而是有连接的,并且隐藏层的输入不仅包括输入层的输出还包括上一时刻隐藏层的输出。当前文本的输出取决于不定长度的前序网络输出,相比于基于前馈神经网络的语言模型,基于循环神经网络的语言模型可以形成短期记忆,从而更灵活地进行文本信息学习和文本输出。循环神经网络在t时刻接收到输入 x

t

之后,隐藏层的值是s

t

,输出层的值是o

t

,其中隐藏层的值不仅与当前时刻的输入值有关,还取决于前序时刻隐藏层的值,即s

t-1

。如式13所示:

[0134]ot

=g(vs

t

)

[0135]st

=f(ux

t

ws

t-1

)

ꢀꢀꢀ

(13)

[0136]

其中,u是输入层到隐藏层的权重矩阵,w是前序时刻隐藏层值的权重矩阵,f是隐藏层的激活函数;v是隐藏层到输出层的权重矩阵,g是输出层的激活函数。

[0137]

本发明使用双cnn-resnet-lstm-bi-lstm-rnn-lm网络建立模型,其中,将s1步骤中得到的红外热成像图像数据和微光图像数据作为输入,该红外热成像图像数据和微光图像数据对应的文本作为输出,学习生成多源融合唇语识别模型。

[0138]

s3:获取新的红外热成像视频和微光视频,提取新的唇部区域的红外热成像图像数据和微光图像数据,使用多源融合唇语识别模型对唇部区域的红外热成像图像数据和微光图像数据进行识别,得到相应文本。

[0139]

实际采集红外热成像视频和微光视频,提取其唇部区域的红外热成像图像数据和微光图像数据,将红外热成像图像数据和微光图像数据输入到多源融合唇语识别模型中,识别生成对应的文本。

[0140]

识别出的文本能够送到相应的设备进行显示,也可以发送至与其相连接的接收设备待后续处理。

[0141]

本发明实施例还提供了一种基于红外微光望远镜的多源融合唇语识别的系统,如图3所示,包括:

[0142]

获取模块,用于获取红外热成像视频和微光视频;

[0143]

提取模块,用于从红外热成像视频和微光视频提取唇部区域的红外热成像图像数据和微光图像数据;

[0144]

识别模块,用于使用多源融合唇语识别模型对唇部区域的红外热成像图像数据和微光图像数据进行识别,得到识别出的文本;

[0145]

显示模块,用于将识别出的文本显示;

[0146]

输出模块,用于将识别出的文本发送至其他接收设备。

[0147]

模型建立模块,用于建立多源融合唇语识别模型;

[0148]

所述多源融合唇语识别模型使用如下方式建立:

[0149]

获取若干红外热成像视频和微光视频及对应的文本,提取其唇部区域的红外热成像图像数据和微光图像数据;

[0150]

将提取的红外热成像图像数据和微光图像数据及对应的文本送入到双 cnn-resnet-lstm-bi-lstm-rnn-lm网络中进行学习,其中,

[0151]

提取的红外热成像图像数据和微光图像数据为输入数据,对应的文本为输出数

据。

[0152]

所述双cnn-resnet-lstm-bi-lstm-rnn-lm网络,包括两个 cnn-resnet-lstm网络,一个bi-lstm网络,一个rnn-lm网络;两个 cnn-resnet-lstm网络输出部分分别与bi-lstm输入层连接;bi-lstm 输出层与rnn-lm输入层连接;

[0153]

其中,两个cnn-resnet-lstm网络分别用于对红外热成像图像数据和微光图像数据分别进行特征提取,得到基于红外热成像图像的特征和基于微光图像的特征;bi-lstm用于对基于红外热成像图像的特征和基于微光图像的特征进行融合,得到多源融合唇部图像特征;rnn-lm对融合后的多源融合唇部图像特征进行文本学习和匹配,通过集束搜索得到最大概率的输出文本。

[0154]

所述两个cnn-resnet-lstm分别对红外热成像图像数据和微光图像数据分别进行特征提取包括:

[0155]

使用cnn对红外热成像图像数据进行空间特征提取;使用resnet对目标红外热成像图像空间特征进行数据降维;使用lstm增加红外热成像图像数据降维后空间特征的时序特征;得到基于红外热成像图像的特征;

[0156]

使用cnn对微光图像数据进行空间特征提取;使用resnet对微光图像空间特征进行数据降维;使用lstm增加微光图像数据特征的时序特征,得到基于微光图像的特征。

[0157]

本发明所设计的一种基于红外微光望远镜的多源融合唇语识别方法,使用红外与微光融合的望远镜在不同光照环境,从远距离获取目标对象唇部区域的多源图像信息,通过机器学习和深度学习算法进行多源融合的唇部特征提取与建模,并使用语言模型进行文本合成和输出。这种唇语识别的数据获取与处理系统为复杂光照环境、远距离和特殊应用场合提供了更加安全可靠的信息获取与交互方式。弥补了单一视频数据来源特征提取和唇部图像识别的局限性,通过多源数据特征融合建模极大地提高了唇语识别的准确性。拓展了唇语识别技术的应用范围和场景,为唇语识别技术的发展提供了新的方向。

[0158]

以上仅为本技术的实施例而已,并不用于限制本技术。对于本领域技术人员来说,本技术可以有各种更改和变化。凡在本技术的精神和原理之内所作的任何修改、等同替换、改进等,均应包含在本技术的权利要求范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。