1.本发明涉及计算机视觉技术领域,尤其涉及一种基于表征一致性提高双目立体匹配网络泛化的方法。

背景技术:

2.从图像中估计深度是许多计算机视觉应用中的一个基本问题,如自动驾驶和机器人导航。立体匹配是对此任务的解决方案,它找到了立体图像对之间的匹配对应关系,并通过三角测量恢复深度。

3.立体匹配通常包括四个步骤:匹配代价计算、代价聚合、视差回归和视差细化。最近,基于传统方法的成本计算过程开发了端到端立体匹配网络(pyramid stereo matching network.ieee conference on computer vision andpattern recognition,2018),(group-wise correlation stereo network.ieeeconference on computer vision and pattern recognition,2019),并在公共基准上实现了最先进的精度。然而,这些方法的泛化能力较差,在训练集中未出现过的场景上的性能普遍表现较差,难以推广到未见的场景。实现泛化能力的常用方法是学习领域不变表示,一些立体匹配方法试图通过进行特征级对齐获得域不变特征来解决这个问题。例如,通过引入域规范化层,可以降低学习特征对域变化的敏感性(domain-invariant stereo matching networks. ieee conference on computer vision,2020)。根据若干启发式匹配函数得出的置信度分数也可以被视为一种域不变表示(matching-space stereo networksfor cross-domain generalization.2020international conference on 3d vision, 2020)。这些工作将输入投影到域不变的特征空间中,减少了对特定域的外观属性的依赖,并在不同数据集中对常见的图像变化显示出更强的鲁棒性。然而以上方法只对特定域有效,也无法推广到任何未见域中。

4.虽然图像内容在不同的域之间有很大的差异,但在大多数情况下,匹配像素在立体视点之间具有一致的表达式,从而保证稳定的匹配代价体计算,以生成可靠的非奇偶性映射。进一步将这一观察扩展到高级通道,该通道将直接从rgb图像构建的匹配代价体与公共网络相结合,以处理该rgb匹配代价体。这样一个具有一致立体表示的简单通道也显示显著改善了域泛化性能。然而,当学习到的特征用于构建立体网络中的匹配代价体时,这种一致性不再被保留。定量评估表明,无论选择何种网络架构,匹配点之间的总体特征相似性都不够大(低于0.8)。即使在训练集中,特征也不一致,这表明了对立体特征进行一致约束的必要性。

5.本发明从特征一致性的角度解决立体网络的领域泛化问题,提出了一种立体对比特征损失方法,以增强匹配像素对之间的特征一致性。然而,低层次的特征很容易受到立体视点之间外观变化的影响,从而导致特征在未见域上的一致性降低。为了解决这个问题,在特征提取网络的中间层采用了立体选择性白化损失。白化损失不仅没有明确规定预设特定的特征分布,减少了人为先验不合适的风险。而且它使学习到的特征对立体视点的变化不那么敏感,从而更好地保持特征的一致性。对比损失鼓励特征在训练集中保持一致,而在未

见域上的一致性下降。与对比损失相比,白化损失产生的一致性相对较低,而一致性对域变化具有鲁棒性。联合使用这两种损耗可以减小通道特征差异,从而提高各个域的特征一致性。本发明所提方法本质上是通用的,可以很容易地嵌入到现有的立体匹配网络中,并且不需要访问目标域中的样本。当对合成数据进行训练并推广到四个真实世界的测试集时,本发明所提方法比几种最先进的网络具有更高的性能。

技术实现要素:

6.本发明技术解决问题:克服现有技术的不足,提供一种基于表征一致性提高双目立体匹配网络泛化的方法,该方法以双目图像作为输入,对学习的特征施加对比损失,以保持立体视图之间的一致性。使用选择性的白化损失来限制中间特征表示,这有助于在未见域上保持特征的一致性。与其他现有的双目立体匹配的方法相比,本发明通过两个新的损失函数,即立体对比特征损失和立体选择性白化损失,促进了立体特征的一致性,显着提高了端到端双目立体匹配网络的泛化性能。

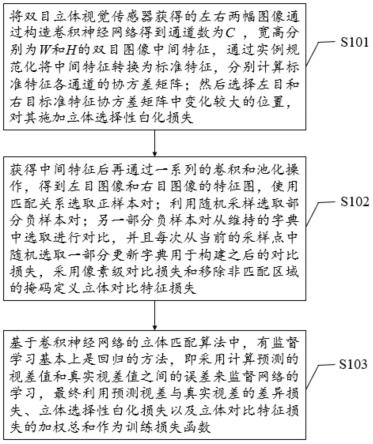

7.具体包括以下步骤:

8.(1)立体选择性白化损失:将双目立体视觉传感器获得的左右两幅图像通过构造卷积神经网络得到通道数为c,宽高分别为w和h的双目图像中间特征,为了减少通道方差优化冲突,通过实例规范化将中间特征转换为标准特征,分别计算标准特征各通道的协方差矩阵;然后选择左目和右目标准特征协方差矩阵中变化较大的位置,这些位置被认为捕捉了过多的双目无关信息,所以对其施加立体选择性白化损失;该损失通过对特征协方差矩阵中变化较大的位置施加约束使其接近于0,以减少中间特征对双目不一致信息的依赖,提高不同域之间的特征一致性;

9.(2)立体对比特征损失:获得中间特征后再通过一系列的卷积和池化操作,得到左目图像和右目图像的特征图,使用匹配关系选取正样本对,所述正样本对通过左目特征图中的查询特征与右目特征图中的关键特征配对得到;利用随机采样选取部分负样本对,所述部分负样本对通过在右特征大小为50

×

50的局部窗口中随机抽取n个不匹配点,形成n个负样本对;另一部分负样本对从维持的字典中选取进行对比,所述字典通过从当前的负样本中随机采样存储所得,并且每次从当前的采样点中随机选取一部分更新字典用于构建之后的对比损失,采用像素级对比损失和移除非匹配区域的掩码定义立体对比特征损失;

10.(3)训练目标:基于卷积神经网络的立体匹配算法中,有监督学习基本上是回归的方法,即采用计算预测的视差值和真实视差值之间的误差来监督网络的学习,最终利用预测视差与真实视差的差异损失、立体选择性白化损失以及立体对比特征损失的加权总和作为训练损失函数。

11.本发明的有益效果如下:

12.本发明与现有技术相比的优点在于:

13.(1)本发明一种基于表征一致性提高双目立体匹配网络泛化的方法,通过立体方法学习匹配点对的不一致表示,并证明立体网络的泛化性能可以通过保持立体特征的一致性来提高。

14.(2)本发明提出了两个新的损失函数,即立体对比特征损失和立体选择性白化损失,以促进立体特征的一致性。

15.(3)大量的实验结果表明本发明的方法可应用于多种立体网络架构,并显示出其对域泛化性能的显著改进。

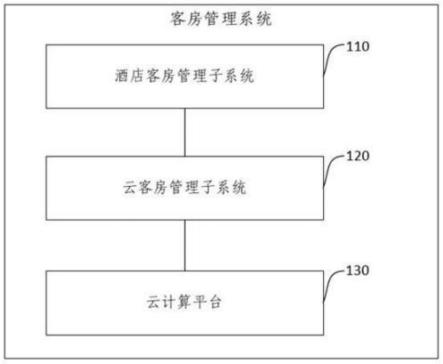

附图说明

16.图1是本发明提供的基于表征一致性提高双目立体匹配网络泛化的方法的流程图;

17.图2是本发明提供的基于表征一致性提高双目立体匹配网络泛化的方法的结构图;

18.图3是本发明提供的立体选择性白化损失示意图;

19.图4是本发明提供的立体对比特征损失示意图。

具体实施方式

20.本发明的目的是提供一种基于表征一致性提高双目立体匹配网络泛化的方法,可嵌入到现有的端到端立体匹配网络中,以解决立体匹配网络的跨域泛化问题。

21.下面将结合附图对本发明加以详细说明,应当指出的是,所描述的实例仅旨在便于对本发明的理解,而对其不起任何限定作用。

22.图1是本发明提供的基于表征一致性提高双目立体匹配网络泛化的方法的流程图。

23.图2是本发明提供的基于表征一致性提高双目立体匹配网络泛化的方法的结构图。本发明提供的基于表征一致性高双目立体匹配网络泛化的方法具体包括:

24.s101:将双目立体视觉传感器获得的左右两幅图像通过构造卷积神经网络得到通道数为c,宽高分别为w和h的双目图像中间特征x。由于低层表示很容易受到立体视图之间外观变化的影响,从而降低不同域之间的特征一致性。因此采用立体选择性白化损失被施加在中间特征表示上,以减少它们对立体不一致信息的依赖,如图3所示是立体选择性白化损失示意图。白化损失旨在消除特征通道之间的相关性,通过强制每个通道的方差项等于1且每对通道之间的协方差等于零来实现。但是,同时优化每通道方差和跨通道方差会导致冲突。为了解决这个问题,通过实例规范化将中间特征转换为标准特征xs,具体实现为:

[0025][0026]

其中和分别表示中间特征x的平均向量和协方差矩阵, diag(σ

μ

)表示σ

μ

的对角元素,

⊙

表示元素-方向与空间维度hw的乘法,是包含1的列向量。然后分别计算标准特征中各通道的协方差矩阵:

[0027][0028]

其中c为通道数,w和h分别为标准特征的宽和高。选择左目和右目标准特征协方差矩阵中变化较大的位置,这些位置被认为捕捉了过多的双目无关信息,所以对其施加立体选择性白化损失,该损失定义为:

[0029][0030]

其中是γ施加立体选择性白化损耗的层数,具体设置为3,γ表示相应的层指数,

σs(x

l

)表示左目图像特征的协方差矩阵,为上三角矩阵,为选择性掩码,用于捕获视图特定信息的特征协方差:

[0031][0032]vi,j

表示通道i和通道j之间的方差矩阵,为协方差矩阵元素的集合,p 表示最高协方差元素,具体设置为p=50%。

[0033]

由于本发明的目标是在不破坏其他特征结构的情况下,对立体视点变化进行中间表示,因此白化损失只需要限制与立体视点变化相关的部分,而不是整个协方差,具体通过左右视图的方差矩阵v捕获视图特定信息的特征协方差,计算如下:

[0034][0035]

其中为方差矩阵,μ

σ

为左目图像特征的协方差矩阵σs(x

l

)与右目图像特征的协方差矩阵σs(xr)的平均值,最终立体选择性白化损失通过对特征协方差矩阵中变化较大的位置施加约束使其接近于0,以减少中间特征对双目不一致信息的依赖,提高不同域之间的特征一致性;

[0036]

s102:获得中间特征后再通过一系列的卷积和池化操作,得到左目图像和右目图像的特征图,然后通过特征图构造代价卷。具体可采用常见的基于深度学习的立体匹配算法如psm-net、ga-net、gwc-net和aa-net等作为基础网络结构获取特征图。特征提取阶段,引入对比的学习机制,即立体对比特征损失,直接对立体视图的特征施加一致性约束。对比学习机制包括一个应用于立体特征的像素级对比损失,以及一个带有动量更新密钥编码器的字典队列,该字典从不同的对中引入了丰富的负样本集,并进一步提高了特征的一致性,如图4所示是立体对比特征损失示意图。

[0037]

如果立体视图中像素矢量的像素坐标位于同一个三维点的投影位置则被认为是一对正样本对,使用左视图的地面真值视差d收集这些正样本对,具体通过左目特征图中的查询特征φ

l

(u,v)与右目特征图中的关键特征φr(u-d,v)配对得到;利用随机采样选取部分负样本对,所述部分负样本对通过在右特征大小为50

×

50的局部窗口中随机抽取n个不匹配点,形成n个负样本对;另一部分负样本对从维持的字典中选取进行对比,所述字典通过从当前的负样本中随机采样存储所得,并且每次从当前的采样点中随机选取一部分更新字典用于构建之后的对比损失。最后采用像素级对比损失和移除非匹配区域的掩码定义立体对比特征损失。像素级对比损失计算公式为:

[0038][0039]

其中表示左目特征图中查询特征φ

l

(u,v)的负样本集,由右特征φr中的n个样本和字典队列中的k个样本组成,φr(u-d,v)表示右目特征图中的关键特征配对,τ是温度超参数,具体设置为n=60,k=6000,τ=0.07。移除非匹配区域的掩码计算公式为:

[0040][0041]

其中重投影误差r计算为双目图像中成对像素位置与地面真实视差值的差值,可作为匹配有效性检查的标准,δ设置为3作为阈值。立体对比特征损失定义为:

[0042][0043]

其中表示像素级对比损失,掩码m(u,v)表示剩余的匹配区域。

[0044]

s103:基于卷积神经网络的立体匹配算法中,有监督学习基本上是回归的方法,即采用计算预测的视差值和真实视差值之间的误差来监督网络的学习,最终利用预测视差与真实视差的差异损失、立体选择性白化损失以及立体对比特征损失的加权总和作为训练损失函数,具体通过以下公式计算:

[0045][0046][0047]

其中是预测的视差值和真实视差值之间的差异损失,n表示图像中的总像素数量,dn表示网络预测出来的视差图,表示已有的真实视差图ground truth,损耗权重(λ

scf

,λ

ssw

)设置为(1.0,0.1)。

[0048]

尽管上面结合附图对本发明进行了描述,但是本发明并不局限于上述的具体实施方式,上述的具体实施方式仅仅是示意性的,而不是限制性的,本领域的普通技术人员在本发明的启示下,在不脱离本发明宗旨的情况下,还可以做出很多变形,这些均属于本发明的保护之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。