1.本发明属于深度学习领域,涉及一种基于双重类别级对抗网络的图像语义分割方法。

背景技术:

2.图像语义分割是指对图像中的每一个像素点进行分类,并通过整合得到了包含语义信息的分割结果,即根据图像的语义对图形进行分割,这里语义是指图像的内容或信息细节。语义分割是图像理解的基础,广泛应用于医学影像分析、自动驾驶、地理信息系统等领域。最初的图像语义分割方法主要基于rdf等机器学习方法和概率图模型,语义分割的结果一般为图中物体的类别。全卷积神经网络(fully convolutional network,fcn)的出现使得深度学习技术开始广泛应用于图像语义分割,此时语义分割可以识别图像中所包含的个体。近年来,基于深度学习的图像语义分割技术得到长足的发展,例如,deeplab系列模型结合了深度卷积神经网络(dcnns)和概率图模型,其中deeplab-v2引用了不同特征层的多分辨率信息,采用了多孔空间金字塔池化结构(aspp),有效地学习不同尺度目标的相关信息,进一步提高目标的分割精度;deeplab-v3 采用可任意控制编-解码器来提高特征的分辨率并恢复原始像素信息,同时采用空洞卷积方法平衡语义分割精度和效率。

3.图像语义分割一般采用监督学习方法,训练样本需要像素级标注信息,人工标注成本较大,一种解决方案是采用合成图像构成的训练集。通常将合成图像数据集称为源域(source domain),真实场景的数据集称为目标域(target domain)。源域和目标域之间往往不可避免地存在着很大的视觉差异,即域偏移(domain shift),如纹理、光照、视角差异等等,这些差异会导致通过源域训练得到的深度学习模型对目标域的分割精度不理想,容易出现过拟合现象,难以泛化到目标域数据集上。域自适应(domain adaptation)是迁移学习在计算机视觉领域中重要技术之一,主要解决当源域和目标域之间的数据分布存在偏差时,如何利用源域数据训练出适应目标域数据的模型。其中,源域中都是带有标注信息的样本,而目标域没有或者只有少数数据有标注信息。现有的域自适应方法,大多采用原图或高层次抽象特征图进行跨域训练,往往会产生语义不一致或类别错分问题。

技术实现要素:

4.发明目的:本专利提出一种基于双重类别级对抗网络的域自适应分割方法,通过提升不同数据集间的自适应水平,有效实现对无标注数据集的语义分割,提高算法的泛化性能。

5.技术方案:本发明提出一种基于双重类别级对抗网络的图像语义分割方法,所述方法包括以下步骤:

6.步骤一:获取图像数据集,获取用于源域的合成图像数据集gta5,即视频游戏数据集,以及虚拟城市数据集synthia,获取用于目标域的真实图像数据集cityscapes,即城市景观数据集,该数据集由训练集和测试集两部分组成,其中训练集用来训练模型,测试集则

用来评估模型的泛化能力;

7.步骤二:构建域间类别级对抗网络,所述域间类别级对抗网络由域间生成器和域间鉴别器组成,其中,域间生成器由特征提取器和两个互斥分类器构成,将步骤一中源域和目标域图像输入域间类别级对抗网络进行协同训练,计算源域和目标域之间的差异;

8.步骤三:计算网络的对抗损失函数并进行两域间的自适应网络的训练:输入图像进行步骤二的操作后,通过两个互斥分类器得到两个预测张量,计算两个张量之间的距离差异由此调整对抗损失大小,使用对抗损失函数训练源域和目标域之间的类别级对抗网络;

9.步骤四:划分目标域图像,利用步骤三中训练好的网络输出目标预测图,计算预测图的信息熵值,根据熵值大小排序,并依据简单比率λe将目标域划分为集合一和集合二两部分,集合一的熵值较小且集合一占总目标域的比例为λe;

10.步骤五:目标域内的自适应训练,将步骤四中的集合一看作源域,其预测图作为伪标签,并将集合二看作目标域,二次利用类别级对抗网络进行域内自适应训练;

11.步骤六:训练总体模型并获得分割结果,将cityscapes中的测试集图像输入步骤五训练好的网络中,以实现对测试集图像的语义分割。

12.其中,步骤一中所述的获取图像数据集包括以下步骤:

13.步骤一:所述的源域数据集gta5和synthia都是合成的虚拟数据,数据集中包含图片信息和逐像素的语义信息作为分割标签;

14.步骤二:所述的目标域数据集cityscapes是现实场景的真实数据,数据集中包含2975幅图像的训练集和500幅图像的测试集,目标域数据不含有任何标签信息。

15.其中,步骤二中,通过以下步骤构建域间类别级对抗网络:

16.步骤1:如图2所示,域间生成器由特征提取器和两个互斥分类器组成,使用残差网络resnet-101在imagenet数据集上的预训练框架作为域间生成器网络的主干部分,即框架的前半部分为特征提取器,进入步骤2;

17.步骤2:复制框架中最后一个分类模块的两个副本,并行排列在特征提取器后作为两个互斥分类器,进入步骤3;

18.步骤3:将源域和目标域图像输入网络中进行协同训练,并进行分割损失计算:

[0019][0020]

其中,样本xs∈rh×w×3是来自源域的图像,ys是其相应的像素标签,c为语义分割的类别数,p

s(h,w,c)

为c类语义在像素(h,w)上的离散分布;y

s(h,w,c)

为c类语义在像素(h,w)上的正确标注概率,如果像素(h,w)属于c类,y

s(h,w,c)

=1,否则y

s(h,w,c)

=0。

[0021]

其中,步骤三中,计算网络的对抗损失函数并进行两域间的自适应网络的训练包括以下步骤:

[0022]

步骤1:训练过程中,两个互斥分类器对输入图像进行逐像素的语义分类,两个分类器c1和c2具有不同的参数,采用最小化两个分类器的余弦相似度来增强它们的卷积层的权值散度,有以下权重差异损失:

[0023][0024]

其中,和是分别将c1和c2的卷积滤波器的权值进行扁平化和串联后得到的向量;

[0025]

步骤2:输入图像进入互斥分类器会输出两个预测张量p

(1)

和p

(2)

,计算两个预测张量的距离差异,将距离差异作为对抗损失的权重,使得分割图上的每个像素都能有不同的权重来调整对抗损失,进入步骤三;

[0026]

步骤三:采用自适应对抗损失函数进行训练:

[0027][0028]

其中,p

(1)

和p

(2)

分别为c1和c2的预测张量,m(

·

,

·

)为余弦距离,参数λ

local

控制对抗损失的自适应权值,ε为一个参数,g1为域间生成器,d1为域间鉴别器,xs为源域图像,x

t

为目标域图像。

[0029]

其中,步骤四中,划分目标域图像包括以下步骤:

[0030]

步骤一:将目标域图像输入上述步骤训练好的类别级对抗网络中,并得到目标域图像的预测图;

[0031]

步骤二:计算目标域预测图中每个像素点的信息熵值:

[0032][0033]

其中,域间生成器g1以目标图像x

t

作为输入,生成像素级的分割预测值p

t(h,w,c)

,对其进行熵映射计算;

[0034]

步骤三:在步骤二的基础上,求出每幅图的熵映射值,并将该值从小到大排列:

[0035][0036]

其中,r(x

t

)是熵图i

t

的平均值,当域间适应网络模型达到最优时,根据域间生成器g1产生的预测分割图计算每个像素为c类语义概率的熵值并且求该熵图的平均值r(x

t

),按照从低到高的次序将目标域熵图进行排序,然后将目标域熵图与原目标域图像一一对应;

[0037]

步骤四:引入超参数λe作为目标域集合一占总目标域的比率,将目标域分为两部分,即集合一的熵图平均值较低为低熵,分割效果较好,而集合二的熵图平均值较高为高熵,分割效果较差,需要对集合二图像进行进一步训练。令x

te

和x

th

分别表示分配给集合一和集合二的目标图像,λe定义如下:

[0038][0039]

其中,|x

te

|是集合一的基数,|x

t

|是整个目标域的基数。

[0040]

其中,步骤五中,目标域内的自适应训练包括以下步骤:

[0041]

步骤一:将上述步骤中划分的目标域集合一看作源域数据集,集合一的预测图作

为伪标签进行辅助训练,将集合二看作目标域数据集,同时利用集合一和集合二进行第二次域间类别级对抗网络模型的训练。

[0042]

其中,步骤六中,训练总体模型并获得分割结果包括以下步骤:

[0043]

步骤一:设置域间自适应和域内自适应的总体损失函数l如下形式:

[0044][0045]

根据以下公式学习目标模型:

[0046][0047]

由于使用了双重类别级对抗网络,其包括有域间和域内两部分参数,分别用i=1和i=2来表示,即l1是域间自适应的总体损失函数,l2则是域内自适应的总体损失函数,g1是域间生成器,g2则是域内生成器,d1是域间鉴别器,d2则是域内鉴别器,则是域内鉴别器,分别为域间自适应的分割损失、权重差异损失和对抗损失函数,别为域间自适应的分割损失、权重差异损失和对抗损失函数,则分别为域内自适应的分割损失、权重差异损失和对抗损失函数,分别为域间自适应中控制权重差异损失和对抗损失的超参数,分别为域内自适应中控制权重差异损失和对抗损失的超参数;

[0048]

步骤二:首先,对模型进行域间自适应训练,以优化模型的g1和d1,其次,基于r(x

t

)对目标图像进行排序,并利用g1生成目标域伪标签,训练域内自适应模型优化g2和d2;

[0049]

步骤三:对跨域适应g1模型进行了70,000次迭代训练后,使用g1生成cityscapes训练集的2975幅图像的分割图和熵图,利用r(x

t

)得到所有目标域图像的分割难易程度系数,r(x

t

)值大则说明分割困难,反之则说明分割容易,利用排序算法将所有图像的r(x

t

)值从小到大排序,并结合λe将目标域划分为两个子集合,即集合一的r(x

t

)值较小且集合一占总目标域的比例为λe,集合二的r(x

t

)值较大且集合二占总目标域的比例为1-λe;

[0050]

步骤四:用sgd优化器训练g1和g2,动量为0.9,初始学习率设置为2.5

×

10-4

,权重衰减设为10-4

,用adam优化器训练d1和d2,初始学习率为10-4

,且在训练期间保持不变,训练时使用512

×

1024大小的图片,将预测图上采样2倍,进行分割结果评估;

[0051]

步骤五:实验采用检测评价函数:

[0052][0053]

对每个类别进行语义分割性能评估,其中tp、fp和fn分别为真正、假正和假负像素的个数,k为类别数。

附图说明

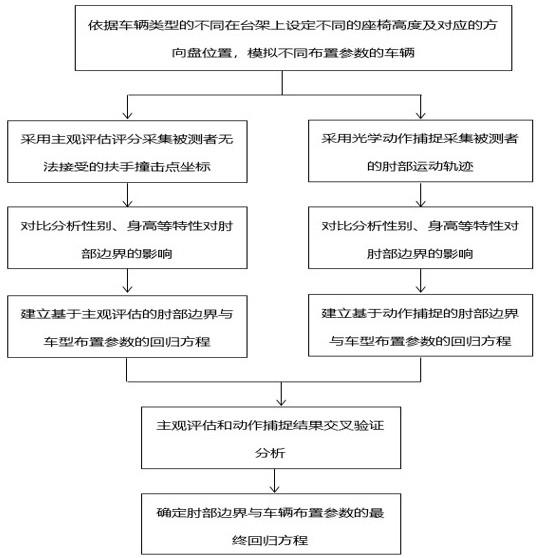

[0054]

图1是本发明所述的一种基于双重类别级对抗网络的图像语义分割方法的整体框架图;

[0055]

图2是本发明中类别级对抗网络的结构示意图。

[0056]

具体实施方法

[0057]

请参阅图1所示,本发明的一种基于双重类别级对抗网络的图像语义分割方法,所

述方法包括以下步骤:

[0058]

步骤一:获取图像数据集,获取用于源域的合成图像数据集gta5,即视频游戏数据集,以及虚拟城市数据集synthia,获取用于目标域的真实图像数据集cityscapes,即城市景观数据集,该数据集由训练集和测试集两部分组成,其中训练集用来训练模型,测试集则用来评估模型的泛化能力;

[0059]

步骤二:构建域间类别级对抗网络,所述域间类别级对抗网络由域间生成器和域间鉴别器组成,其中,域间生成器由特征提取器和两个互斥分类器构成,将步骤一中源域和目标域图像输入域间类别级对抗网络进行协同训练,计算源域和目标域之间的差异;

[0060]

步骤三:计算网络的对抗损失函数并进行两域间的自适应网络的训练:输入图像进行步骤二的操作后,通过两个互斥分类器得到两个预测张量,计算两个张量之间的距离差异由此调整对抗损失大小,使用对抗损失函数训练源域和目标域之间的类别级对抗网络;

[0061]

步骤四:划分目标域图像,利用步骤三中训练好的网络输出目标预测图,计算预测图的信息熵值,根据熵值大小排序,并依据简单比率λe将目标域划分为集合一和集合二两部分,集合一的熵值较小且集合一占总目标域的比例为λe;

[0062]

步骤五:目标域内的自适应训练,将步骤四中的集合一看作源域,其预测图作为伪标签,并将集合二看作目标域,二次利用类别级对抗网络进行域内自适应训练;

[0063]

步骤六:训练总体模型并获得分割结果,将cityscapes中的测试集图像输入步骤五训练好的网络中,以实现对测试集图像的语义分割。

[0064]

其中,步骤一中所述的获取图像数据集包括以下步骤:

[0065]

步骤一:所述的源域数据集gta5和synthia都是合成的虚拟数据,数据集中包含图片信息和逐像素的语义信息作为分割标签;

[0066]

步骤二:所述的目标域数据集cityscapes是现实场景的真实数据,数据集中包含2975幅图像的训练集和500幅图像的测试集,目标域数据不含有任何标签信息。

[0067]

其中,步骤二中,通过以下步骤构建域间类别级对抗网络:

[0068]

步骤1:如图2所示,域间生成器由特征提取器和两个互斥分类器组成,使用残差网络resnet-101在imagenet数据集上的预训练框架作为域间生成器网络的主干部分,即框架的前半部分为特征提取器,进入步骤2;

[0069]

步骤2:复制框架中最后一个分类模块的两个副本,并行排列在特征提取器后作为两个互斥分类器,进入步骤3;

[0070]

步骤3:将源域和目标域图像输入网络中进行协同训练,并进行分割损失计算:

[0071][0072]

其中,样本xs∈rh×w×3是来自源域的图像,ys是其相应的像素标签,c为语义分割的类别数,p

s(h,w,c)

为c类语义在像素(h,w)上的离散分布;y

s(h,w,c)

为c类语义在像素(h,w)上的正确标注概率,如果像素(h,w)属于c类,y

s(h,w,c)

=1,否则y

s(h,w,c)

=0。

[0073]

其中,步骤三中,计算网络的对抗损失函数并进行两域间的自适应网络的训练包括以下步骤:

[0074]

步骤1:训练过程中,两个互斥分类器对输入图像进行逐像素的语义分类,两个分

类器c1和c2具有不同的参数,采用最小化两个分类器的余弦相似度来增强它们的卷积层的权值散度,有以下权重差异损失:

[0075][0076]

其中,和是分别将c1和c2的卷积滤波器的权值进行扁平化和串联后得到的向量;

[0077]

步骤2:输入图像进入互斥分类器会输出两个预测张量p

(1)

和p

(2)

,计算两个预测张量的距离差异,将距离差异作为对抗损失的权重,使得分割图上的每个像素都能有不同的权重来调整对抗损失,进入步骤三;

[0078]

步骤三:采用自适应对抗损失函数进行训练:

[0079][0080]

其中,p

(1)

和p

(2)

分别为c1和c2的预测张量,m(

·

,

·

)为余弦距离,参数λ

local

控制对抗损失的自适应权值,ε为一个参数,g1为域间生成器,d1为域间鉴别器,xs为源域图像,x

t

为目标域图像。

[0081]

其中,步骤四中,划分目标域图像包括以下步骤:

[0082]

步骤一:将目标域图像输入上述步骤训练好的类别级对抗网络中,并得到目标域图像的预测图;

[0083]

步骤二:计算目标域预测图中每个像素点的信息熵值:

[0084][0085]

其中,域间生成器g1以目标图像x

t

作为输入,生成像素级的分割预测值p

t(h,w,c)

,对其进行熵映射计算;

[0086]

步骤三:在步骤二的基础上,求出每幅图的熵映射值,并将该值从小到大排列:

[0087][0088]

其中,r(x

t

)是熵图i

t

的平均值,当域间适应网络模型达到最优时,根据域间生成器g1产生的预测分割图计算每个像素为c类语义概率的熵值并且求该熵图的平均值r(x

t

),按照从低到高的次序将目标域熵图进行排序,然后将目标域熵图与原目标域图像一一对应;

[0089]

步骤四:引入超参数λe作为目标域集合一占总目标域的比率,将目标域分为两部分,即集合一的熵图平均值较低为低熵,分割效果较好,而集合二的熵图平均值较高为高熵,分割效果较差,需要对集合二图像进行进一步训练。令x

te

和x

th

分别表示分配给集合一和集合二的目标图像,λe定义如下:

[0090][0091]

其中,|x

te

|是集合一的基数,|x

t

|是整个目标域的基数。

[0092]

其中,步骤五中,目标域内的自适应训练包括以下步骤:

[0093]

步骤一:将上述步骤中划分的目标域集合一看作源域数据集,集合一的预测图作为伪标签进行辅助训练,将集合二看作目标域数据集,同时利用集合一和集合二进行第二次域间类别级对抗网络模型的训练。

[0094]

其中,步骤六中,训练总体模型并获得分割结果包括以下步骤:

[0095]

步骤一:设置域间自适应和域内自适应的总体损失函数l如下形式:

[0096][0097]

根据以下公式学习目标模型:

[0098][0099]

由于使用了双重类别级对抗网络,其包括有域间和域内两部分参数,分别用i=1和i=2来表示,即l1是域间自适应的总体损失函数,l2则是域内自适应的总体损失函数,g1是域间生成器,g2则是域内生成器,d1是域间鉴别器,d2则是域内鉴别器,则是域内鉴别器,分别为域间自适应的分割损失、权重差异损失和对抗损失函数,别为域间自适应的分割损失、权重差异损失和对抗损失函数,则分别为域内自适应的分割损失、权重差异损失和对抗损失函数,分别为域间自适应中控制权重差异损失和对抗损失的超参数,分别为域内自适应中控制权重差异损失和对抗损失的超参数;

[0100]

步骤二:首先,对模型进行域间自适应训练,以优化模型的g1和d1,其次,基于r(x

t

)对目标图像进行排序,并利用g1生成目标域伪标签,训练域内自适应模型优化g2和d2;

[0101]

步骤三:对跨域适应g1模型进行了70,000次迭代训练后,使用g1生成cityscapes训练集的2975幅图像的分割图和熵图,利用r(x

t

)得到所有目标域图像的分割难易程度系数,r(x

t

)值大则说明分割困难,反之则说明分割容易,利用排序算法将所有图像的r(x

t

)值从小到大排序,并结合λe将目标域划分为两个子集合,即集合一的r(x

t

)值较小且集合一占总目标域的比例为λe,集合二的r(x

t

)值较大且集合二占总目标域的比例为1-λe;

[0102]

步骤四:用sgd优化器训练g1和g2,动量为0.9,初始学习率设置为2.5

×

10-4

,权重衰减设为10-4

,用adam优化器训练d1和d2,初始学习率为10-4

,且在训练期间保持不变,训练时使用512

×

1024大小的图片,将预测图上采样2倍,进行分割结果评估;

[0103]

步骤五:实验采用检测评价函数:

[0104][0105]

对每个类别进行语义分割性能评估,其中tp、fp和fn分别为真正、假正和假负像素的个数,k为类别数。

[0106]

以上所述仅为本发明的实施例,并非因此限制本发明的专利范围,凡是利用本发明说明书及附图内容所做的等效结构或等流程变换,或直接或间接运用在相关技术领域,均同理包括在本发明的专利保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。