1.本发明属于通信信道编码的编码技术领域,涉及一种基于强化学习的极化码屏蔽矩阵构建方法,与穷举法相比,在性能接近的情况下,复杂度也有一定的降低。

背景技术:

2.信道编码技术经历了几代技术的革新与发展,极化码作为近年来所提出的一种编码技术,它是人类已知的第一种能够被严格证明达到信道容量的信道编码方法,所以它一出现就引起了许多人的注意,如今极化码也已经入选了5g标准。极化码的本质就是通过不断地信道分裂与信道联合去将信道极化,极化后分为信道容量趋近于1的无噪声信道和信道容量趋近于0的完全噪声信道。然后将信息比特通过无噪声信道传输,冻结比特通过完全噪声信道进行传输。但是在极化不完全的情况下,有着大量容量在0与1之间的信道,这时候就需要对信道的可靠性进行估计,所以就有许多极化码编码的构建方法被提出。通常,用于构造极化码的极化核矩阵的大小是2

×

2,极化码码长被限制为2的二次幂,这种情况下极化码不能应用于灵活的通信系统,所以为了实现任意码长和编码速率,极化码的编码速率匹配方法就被提出,例如凿孔、缩短和重复等。

3.对于屏蔽技术,d.-m.shin等人提出了极化矩阵简化来构造屏蔽极化码。目前穷举法用于删除最大简化极化矩阵指数的行和列。虽然穷举法优于随机打孔方法,但是这种方法也只能够应用于短码。k.niu等人提出了另外一种删余方法,可以统一地选择删余位,但是在信道传输时省略了屏蔽比特,而且它的对应对数似然比值(log-likelihood ratio,llr)被设置为0,所以在性能上有一定的损失。为了提高它的性能,r.wang等人提出了一种叫做缩短技术的新屏蔽技术,在这种方法中,缩短比特在接收处被设定为已知的,其llr值被设定为无穷大,因此与传统的屏蔽极化码相比,该方法有了一定性能上的提升。

4.在这些屏蔽技术中,高斯近似(gaussian approximation,ga)可以用来确定冻结比特的位置和错误概率。从ga的结果中,我们观察到,凿孔技术可以在低码率下有更低的错误概率,而缩短技术在高码率下有更低的错误概率。因此,找到能够在任意码率下提供更好性能的屏蔽极化码是一个关键的技术问题。传统的屏蔽方案缺乏解码稳定性,所以人工智能等一些比较前沿的方法也成为了这一问题的备选解决方案,其中遗传算法就已经在屏蔽矩阵构建领域有了相关的应用,而本发明提出了一种基于强化学习的极化码屏蔽矩阵构建方法,相比穷举法在保证性能的前提下能有一定复杂度下降。

技术实现要素:

5.本发明为了解决极化码的最佳屏蔽模式的选择问题,提供了一种基于强化学习的极化码屏蔽矩阵构建方法,主要由三部分构成,将屏蔽矩阵构造过程类比为马尔可夫决策过程、构建强化学习模型并设置相关参数和用q-learning算法对模型进行训练。并且由于奖励值主要由译码器的误帧率所决定,所以这种方法可用于许多不同的信道条件。相对于穷举法在保证性能的情况下有一定复杂度的下降。

6.本发明的基本构思:在进行极化码的屏蔽矩阵构建时,因为凿孔技术在低码率情况下有更好的性能,缩短技术在高码率下性能更好,所以结合这两种技术提出一种基于强化学习的极化码屏蔽矩阵构建方法。由于强化学习是一种在线学习的算法,所以它的训练数据都是在训练过程中产生的,只要设定好相关的状态、动作与奖励值,调整好相关的参数,模型就能得到理想的结果。本发明的模型进行训练时,首先强化学习模型进行凿孔位与缩短位的选择,然后根据其译码得到的奖励值进行模型的更新,并在进行下一轮的凿孔位与缩短位的选择时,根据新的模型确定,不断循环训练,直到获得的屏蔽矩阵达到收敛。

7.基于以上的设计构思,本发明所采用的设计方案为:强化学习主要是建立于马尔可夫决策过程的基础上,智能体采取动作从而改变自己的状态获得奖励与环境发生交互的循环过程。而屏蔽矩阵构造的过程就可类比为马尔可夫决策过程,其中一次训练的过程主要分为三个阶段。

8.第一个阶段为动作-状态-动作的反复进行。本发明的模型有三个动作,分别为非屏蔽位,凿孔位和缩短位。新状态则为智能体采取动作后转移到的下一个状态,它的状态就是已探索选择的动作组成的矩阵,并且它只根据前一个状态来进行下一次动作的选择。如果选择过程中非屏蔽位的数量少于设定的数量,则提前终止探索并且直接赋予一个负的奖励值,这个奖励值不需要根据译码结果而定。如果最后获得的矩阵中非屏蔽位数量和设定的数量相等,则其获得的矩阵如公式(1)所示。

9.p={p

np

,p

p

,ps}

ꢀꢀꢀ

(1)

10.其中p

np

为非屏蔽位,p

p

为凿孔位,ps为缩短位。

11.第二个阶段则为奖励值的获取,本发明模型的奖励值主要根据译码器的误帧率而定。在进行译码的过程中,因为有凿孔位与缩短位,所以需要针对对应的比特位置进行初始llr赋值。对于凿孔位,其对应的比特位置的初始llr值被设置为0,而缩短位对应的比特位置初始llr值被设置为无穷。

12.第三个阶段就是进行模型的学习,本发明使用了强化学习的q-learning算法来得到一个好的策略,q-learning算法会构建一个q表,当达到一个状态时,动作就会根据q表的值来进行选择。

13.这三个阶段则是训练一次模型的整个流程,循环往复,当得到的屏蔽矩阵达到收敛后,则输出最佳的屏蔽矩阵,其中信息比特的位置选取还是用高斯近似来选取。

14.本发明相对现有技术具有的优点和有益效果为:

15.1)本发明相比于穷举法,在保证性能的前提下有一定程度的复杂度下降。

16.2)本发明所涉及到的强化学习模型只会在训练时需要一定的时间,而当训练结束后,在进行屏蔽模式的运用时不会消耗多余的时间。

17.3)本发明可采用强化学习中的深度强化学习算法,其训练过程中需要存储的数据量也会大大减少。

附图说明

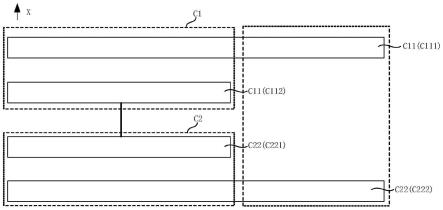

18.图1为本发明基于强化学习的极化码屏蔽矩阵构建方法的整体框图;

19.图2为本发明将屏蔽矩阵类比为马尔可夫决策过程的对比图;

20.图3为本发明的强化学习模型图;

21.图4为本发明的强化学习模型训练图;

22.图5为码长为16且码率为11/16的极化码的屏蔽矩阵图;

具体实施方式

23.下面结合附图对本发明作进一步详细描述,以下实施例有助于对本发明的理解,是比较好的应用实例,但不应看作是对本发明的限制。

24.如图1所示,基于强化学习的极化码屏蔽矩阵构建方法的整体框图分为三部分,将屏蔽矩阵构造过程类比为马尔可夫决策过程、构建强化学习模型并设置相关参数和用q-learning算法对模型进行训练。

25.如图2所示,将极化码的屏蔽矩阵构造过程类比为马尔可夫链决策过程,动作为当前比特的非屏蔽位、凿孔位或缩短位的选择,状态为当前已经选择的比特位置动作组合起来的矩阵,奖励值在最后一个比特位置为1-fer,其余比特为0。

26.如图3所示,强化学习模型主要包含状态空间、动作空间、奖励值还有探索策略的设计,其中在当前交织的信息比特分布下,初始状态为空字符串,状态为由元素0、1和2组成的长度为n的向量,其中0为非屏蔽比特,1为凿孔比特,2为缩短比特,也就是n码长的一种编码结构矩阵。对于探索策略模型使用的贪婪策略,探索率随episode的增大而降低,其计算如公式(2)。

[0027][0028]

其中λ为当前探索率,t为当前episode。

[0029]

如图4所示,强化学习的训练过程如下,首先p矩阵初始化,其初始化为空矩阵,然后模型进行动作选择,动作选择完后判断当前p矩阵中非屏蔽位的数量是否大于设定值,如果大于则进行下一次的动作选择,这时候的奖励值为0,如果小于则进行下一次判断,判断屏蔽位的数量是否等于设定值,如果不相等则奖励值设为负值,相等则根据译码得到的误帧率来确定奖励值,其计算如公式(3)。

[0030]

r=1-fer

ꢀꢀꢀ

(3)

[0031]

模型会根据奖励值更新q表,然后反复进行前面的步骤,直到p矩阵收敛后停止训练并输出最终的p矩阵。

[0032]

如图5所示,码长n=16,m=11的情况下,初始p矩阵先是设为空矩阵,然后根据动作来转移状态,第一次动作为字符0,所以状态转移后的状态即为动作加入后的矩阵,不断进行此操作,直到达到最后的完整p矩阵。

[0033]

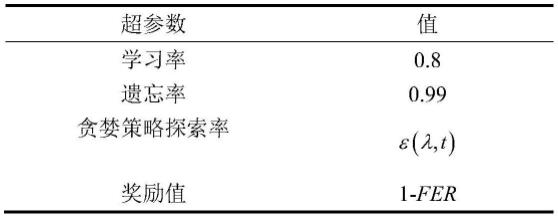

本实例采用的强化学习模型具体参数如表1所示,训练的最大episode为t,并且译码器的误帧率是在至少c个帧的情况下获得,使用的算法为q-learning算法。对于n码长的极化码,一次译码的复杂度为o(nlogn)。对于穷举法,样本数为m,如果当前信噪比能达到的最低误帧率为ε,则m>>1/ε,而且有种屏蔽矩阵构造需被遍历,其中p1为凿孔位数量,p2为缩短位数量,所以穷举法复杂度为本发明方法复杂度为o(ctnlogn),随着码长的增加,本发明方法复杂度低于穷举法。

[0034]

表1强化学习模型的一些参数设置

[0035][0036]

上述实施例不以任何形式限制本发明,凡采用本发明的相似结构、方法及其相似变化方式所获得的技术方案,均在本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。