技术特征:

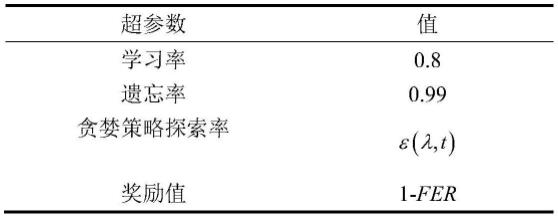

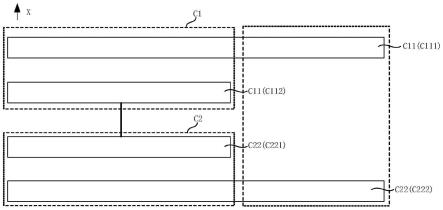

1.一种基于强化学习(reinforcement learning,rl)的极化码屏蔽矩阵构建方法。该方法将凿孔矩阵的构造过程类比为马尔可夫决策过程,然后构建相应的强化学习模型,包括环境与智能体的状态、动作和奖励值,并且使用q-learning算法进行模型的训练。2.根据权利要求1所述的强化学习模型对环境与智能体的状态、动作和奖励值进行设置,其初始状态设定为空矩阵,动作为0、1或者2的字符,奖励值根据译码的误帧率而定。在动作选择后,将动作字符加入前一个状态对应的矩阵中,转移到新状态,重复直到达到最终状态,然后进行译码获取奖励值,这种状态-动作-状态的反复转移过程也就是模型探索最佳屏蔽矩阵的过程,其中非最终状态的奖励值为0或-1。3.根据权利要求2所述的强化学习模型,其特征在于:所述的强化学习模型需要合适的训练过程,在训练模型方面,包含如下步骤:1)设定好本次训练中的极化码的码长为n,非屏蔽位数量为m,凿孔位数量与缩短位数量的和为n-m。2)从初始状态出发进行动作的选择,在状态-动作-状态的转移过程中,若当前非屏蔽位数量小于m,当前比特的奖励值设为0,若大于m,则奖励值为-1。最终状态的奖励值根据译码误帧率而定。3)在获取完奖励值后更新模型,本发明模型使用的是q-learning算法。

技术总结

本发明提供了一种基于强化学习的极化码屏蔽矩阵构建方法,该方法能根据当前信道条件选择最佳的凿孔位置与缩短位置,从而获得相应的屏蔽矩阵。主要内容包括:将屏蔽矩阵构造过程类比为马尔可夫决策过程,并且通过强化学习进行模型的构建;根据屏蔽矩阵的性质,对模型的各种参数进行相应的设置;采用Q-learning算法在训练时对模型进行Q表的更新,并且根据Q表进行动作的选择。由于模型最终状态的奖励值只由译码的误帧率所决定,所以适用于不同的信道。本发明方法相对穷举法在保证性能的情况下复杂度有一定的降低。复杂度有一定的降低。复杂度有一定的降低。

技术研发人员:谢锟钰

受保护的技术使用者:中国计量大学

技术研发日:2022.03.09

技术公布日:2022/6/4

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。