用于操作动力系统的系统和方法

1.本发明涉及一种操作包括内燃机的动力系统的方式,并且尤其涉及一种实现用于发动机和排放管理的策略的方式,其对于具有可电加热催化剂的车辆是有利的。本发明改进了具有驱动源(电动机em、内燃机ice)和排放控制设备(特别是可电加热催化剂(ehc))的组合的系统。这种系统的不同自由度的优化可以降低燃料消耗或提高燃料效率,而同时满足排放限制。

2.传动系统的电气化对于降低燃料消耗和满足越来越严格的污染物排放限制非常重要。这些目标也必须在真实的驾驶条件下实现。

3.用于混合动力电动车辆(hev)的改进控制策略必须考虑与内燃机(ice)、电动机(em)、和可电加热催化剂(ehc)所需的能量相关的参数。这种策略应控制内燃机和电动机之间的扭矩分配、分配给电加热催化剂的功率等。通过这样做,与常规传动系统相比,混合动力车辆的能量消耗可以显著降低。

4.混合动力电动车辆(hev)通常包括牵引(或高压)电池,该电池用作电能存储器,并为电驱动或牵引电动机或机器提供动力以进行推进。这种高压电池可以处于800v、400v或48v。诸如电池之类的电能存储器与电动机一起实现了动能回收、内燃机的负载点适配、扭矩辅助和增压。

5.混合动力配置还可以实现将排放限制在法规限制内的稳健的排放管理,其独立于驾驶条件。例如,在低负载和短距离行程期间,其中由内燃机供应很少热,废气温度可以由于来自可电加热催化剂的热而增加或增强。在替代方案中,内燃机上的负载可以使用电动机的断开扭矩来增加。这继而减少了达到催化转化器的起燃温度的时间,因而提高了催化转化器的污染物转化效率。因此,在预计车辆的催化剂的温度预期降低到阈值以下时,电功率被供应到电加热催化剂。可替代地,或者同时地,在预计车辆的催化剂的温度预期降低到阈值以下的情况下或在预计车辆的催化剂的温度预期降低到阈值以下时,可以增加电动机的制动扭矩。

6.在高负载阶段中,或当废气温度很高时,催化剂可能会超过其最优温度范围。这导致低转化效率。在这种情况下,内燃机的负载可能由于来自电动机的扭矩支持而降低,这减少了原始排放质量流,并起到降低催化转化器的温度的作用。负载可以是当前负载,或基于预测信息的预计负载。因此,在车辆的催化剂的温度预期升高到阈值以上的情况下或在车辆的催化剂的温度预期升高到阈值以上时,可以增加电动机的增压扭矩。

7.在任何时候,目标或约束都是提供驾驶员所需求的扭矩、将电池充电状态(soc)保持在规定限制内、并将规定排放和预计规定排放(诸如nox)保持在规定限制内。车辆的操作模型可用于根据优化目标来优化组件的操作模式。

8.必要的控制策略可呈现为用于多个自由度的控制策略,这些自由度相互作用以影响燃料消耗和排放:a)内燃机和电动机之间的扭矩分配;b)针对可电加热催化剂的电功率;c)内燃机的燃烧模式;

d)档位的选择、变档;以及e)舒适功能,诸如加热和空调。

9.控制策略可以使用不同的人工智能技术来实现。一种这样的技术是强化学习(rl)。控制策略可以通过学习或训练阶段、其后跟着可选的测试阶段来开发。测试阶段可能是必要的,以确保经训练和实现的控制策略满足强制性排放要求。在正常操作期间学习或调整参数可以是可能的,或者可以是不可能的。

10.通过对不同自由度的适当调节,控制策略可以最小化燃料消耗和排放两者,其优势如下所示。

附图说明

11.图1示出了包括废气后处理系统的hev架构的布局;图2示出了强化学习配置;图3示出了训练、测试、操作的步骤;图4示出了控制自由度的步骤;以及图5示出了与soc相关的决策曲线。

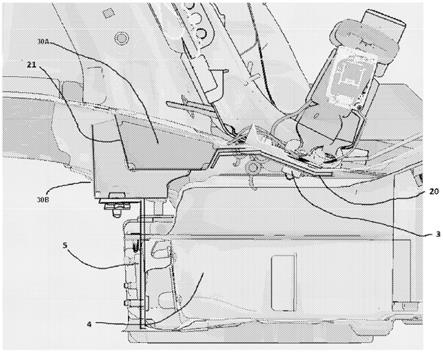

12.在图1中示出了作为100的混合动力车辆的一个实施例的主要元件。连接被示出为机械101、电气102、燃料流103和废气104。在废气流中,可电加热催化剂(ehc)110在柴油氧化催化剂(doc)111之前。废气然后传到选择性催化还原112。内燃机120从燃料供应121接收燃料。在该实施例中,内燃机和电动机130经由带135机械连接。去往和来自电动机130的电力可以传到电池135、可电加热催化剂110和示为136的其他辅助负载。来自内燃机和/或电动机的机械能经由离合器140和变速箱145传到车轮150。

13.图2示出了强化学习系统200的原理元件。强化学习(rl)代理230向环境240提供动作向量a

t 210。环境可以是真实的物理环境(诸如混合动力车辆),或者它可以是模拟环境,其中混合动力车辆的主要元件在软件中建模。环境将动作向量作为输入,并生成结果所得的状态向量s

t 220和回报向量r

t 225。动作向量包含与自由度相对应的值或元件,以及操作车辆所需的任何附加动作或控制元件。例如,动作向量a

t

可以包含值,其确定多少燃料要被供应到内燃机,或者多少电流要被供应到可电加热催化剂,或者多少电流要被电动机供应到例如电池。可以在动作向量中设置或由动作向量操作的操作模式的其他设置或控制包括车辆速度或目标速度、用于电池的目标充电状态(soc)、混合动力模式(例如,回收、滑行)的选择、尿素或adblue注射时间和量、以及用于过滤器再生(例如,柴油dpf再生)的时间点、或换档和/或档位选择。

14.回报向量r

t 225包含与要优化的环境方面相对应的信息。例如,回报向量可以包含用于co2、nox、燃料消耗的环境值,以及与环境或排放考虑相关的其他值。状态向量s

t

和回报向量r

t

作为输入返回到rl代理。

15.动作向量中的值将确定如何使用自由度,并且rl代理将使用回报向量和状态向量来优化动作向量。rl代理所指定的下一个动作向量将确定ice和em之间的扭矩分配、针对ehc的电功率(输入或输出)、以及ice的燃烧模式。通过这种方式,操作模型也将预计未来的燃料消耗和排放。因此,车辆的操作模型被用于根据所选择的优化目标来优化组件的操作模式,诸如在始终遵守排放限制的同时使燃料消耗最小化。

16.在动作向量和/或状态向量中也可以考虑其他因素。例如,附加自由度可能包括换档和档位选择、addblue注射、加热和冷却等。

17.控制策略可以使用混合动力电动车辆的不同模式的基于成本的比较来实现。基于成本比较,策略可以决定多种模式中的哪一种最适合当前操作点和soc。在一个实施例中,这些模式可以被定义为电池充电、电池放电和零电池电流。对于每种模式和操作点,计算满足驾驶员所要求的机械动力和后处理系统所要求的热约束的成本。成本术语被定义为由负载点移动引起的燃料功率增加或减少与电池功率的增量的比率。放电成本可以表示为与耗尽的电池功率相比的节省的燃料功率。另一方面,充电成本可能是用于恢复电池功率的附加燃料功率。因此,最高成本在放电模式下最优,并且最低成本在充电模式下最优。通过分别找到最低或最高成本,可以找到用于ehc的扭矩设定点和功率。在在线应用期间,可以基于每种模式与成本标准的成本比较来选择混合动力模式。该标准将soc映射到用于充电模式的最大限制和用于放电模式的最小限制,如图5所示。对于高于最低成本的放电成本,选择放电。对于最高成本以下的充电成本,选择充电。

18.转到图3,示出了训练、测试和操作的步骤。在第一步骤310中,执行训练以找到最优操作模型。在该实施例中,使用图2所示的回路和模拟环境来确定操作模型。向rl代理提供不同的操作状态和由回报向量给出的结果所得的回报。生成各种动作向量,其继而改变模拟环境的状态。rl代理继而使用状态向量作为参考来评估结果所得的回报向量。

19.步骤310包括已经通过模拟驾驶条件的步骤而准备的操作模型,以及在模拟期间优化内燃机120、可电加热催化剂110和电动机130的使用,以最小化燃料消耗和排放两者。

20.当已经找到最优操作模型时,这可以被传到可选的测试步骤320。在具有测试步骤的实施例中,使用不同的模拟环境来将操作模型验证为始终符合关于排放条件的规定。例如,用于确定操作模型的模拟环境可以由大量的模拟训练轨迹组成,诸如500个轨迹(汽车行程),并且测试模拟环境可以由相似或更少数量的不同验证轨迹组成,诸如400个轨迹(汽车行程)。通过这种方式,学习行为可以在被用于产品中之前被验证。同样,如果训练数据中存在弱点,则可以标识不正确的学习行为,并在必要时校正。

21.rl代理可以学习按照根据信号的方式来调整排放简档,以保持在规定限制内。特别地,ehc可以基于信号来激活。如果在真实环境中信号缺失,则使用操作模型的车辆可能不再满足规定要求,因为ehc没有正确操作。

22.一旦已经找到操作模型,并且在某些实施例中已经测试和验证,则在步骤330,在车辆中提供并使用操作模型,以在真实操作环境中使用。在步骤330中,操作模型被用于提供动作向量a

t 210,其优化自由度,并且提供操作例如内燃机ice120、可电加热催化剂110和电动机em 130所需的控制信号或操作模式。在优选实施例中,从动作向量a

t

导出的操作模式可操作,以操作可电加热催化剂和/或电动机和/或内燃机。将设置操作模式以实现优化目标。

23.在某些实施例中,进一步的步骤340是可能的。在步骤340中,操作模型适配成进一步优化操作,例如在燃料效率或排放方面。然后可以在步骤330中使用操作模型。在其他实施例中,设定点可以取自成本比较方法。

24.示例车辆中使用的废气后处理系统(ats)可以由可电加热催化剂(ehc)110、柴油

氧化催化剂(doc)111和选择性催化还原催化剂(scr)112组成。表1中给出了此类示例hev的主要参数。

25.表1. 示例车辆参数。

26.相同的发明构思可以用于具有不同功率水平的各种车辆中。

27.强化学习(rl)的一个实施例是通过如图2所示的代理-环境接口,其使用图4的步骤。在步骤410中,代理在时间t观察到环境的状态s

t

和回报r

t

,然后通过生成动作向量a

t

来执行动作。在步骤420,环境接收动作向量a

t

并对其做出反应。在稍后的时间t 1,环境在步骤430已经做出反应,并且随着环境过渡到新的状态而生成状态向量s

t

和回报向量r

t

。然后,在410,rl代理从模拟环境中读取新生成的状态向量s

t

和回报向量r

t

,并将动作向量反馈回模型,以计算结果所得的新状态。rl代理的目标是在学习过程结束之前搜索最大化累积回报的策略。

28.代理基于当前回报相比于未来回报来对决策进行加权:对于折扣因子=0,代理选择贪婪决策以得到即时回报;随着接近1,代理更倾向于未来回报。

29.对于rl代理而言,存在不同的方式来开发试操作模型。一个实施例是基于近端策略优化(ppo),它跨各种类型的任务示出良好的性能。ppo是一种策略梯度方法,其中策略是随机的,并基于当前状态而建模为参数化概率分布,从其对动作进行采样。

30.代理和所谓的“批评家”的输入特征是从车辆状态的观察结果而计算的。在与基于操作距离的限制相关的一个实施例中,从车辆速度v导出特征,其取决于行进距离x(t)是大于还是小于诸如5 km的距离。在轨迹开始时,排放限制较高,并且在一定距离(例如,5 km)后,排放必须低于所定义的排放限制。

31.另一个特征被计算为累积的nox排放,其与行进距离进行比较并乘以nox限制(例如60mg/km)。附加的输入是电池soc的充电状态、废气温度texh和tscr。回报被定义为与(负)燃料质量成比例,其与排出的co2成比例。如果nox排放超过限制,则增加惩罚。

32.在一个实施例中,代理由用于p(ehc)和tq(em)控制的单个线性层神经网络组成,其中仅将tscr和soc作为输入。对于燃烧模式i(ice),线性层输出被添加到完全连接网络,其中在隐藏层中具有泄漏-relu激活和30个神经元。tanh激活被用于计算tq(em)。正输出可以从0缩放至作为tq(em,max)的em的当前最大扭矩,并且负输出可以从0缩放至tq(em,min)。tq(em,max)和tq(em,min)两者均取决于soc,并且经受em的降额。

33.在一个实施例中,电加热的代理的输出被缩放到从零至最大可能加热功率p(ehc,max)的范围,其受限于soc和4kw的物理限制。

34.模型的线性部分利用合理的值进行初始化,其使soc和t

scr

保持在可控范围内,因

为已知的是,scr效率朝向低温和高温会显著下降。

35.在训练期间,在训练数据上重复评估模型。在所有训练迹线上满足nox限制且在这些中具有最低燃料消耗的模型被选择为用于测试的最终模型。

36.在图5中示出了用于基于充电状态soc(500)优化成本的决策曲线。最低放电成本示出为510,并且最高充电成本示出为520。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。