1.本发明涉及一种基于强化蒸馏的跨语言属性级情感分类方法,属于语义识别中跨语言属性级情感分类情感分类技术领域。

背景技术:

2.目前的机器翻译工具大多基于通用领域的平行语料进行训练,在翻译领域性较强的文本时难免引入翻译噪声词,这些噪声词包括非常用词、翻译歧义等往往会导致翻译语料质量下滑。同时,翻译模型解码过程中会存在曝光偏差问题,导致翻译语言与自然语言之间存在较为明显的表达差异。以上问题均是造成翻译语料与真实语料间领域差异问题的主要原因。

3.不同于传统的跨语言文本分类或跨语言句子级情感分类,属性级情感分类并不依赖于句子整体语义,而是依赖于与该属性相关的一组词或短语,这需要建模属性与句子之间细粒度的交互关系。而机器翻译结果中噪声词的存在则会加大模型细粒度建模的难度,因为注意力机制(例如自注意力)是基于“软性”的信息选择机制,多余的噪声词可能导致分散注意力权重甚至出现权重分配错误。另一方面,基于属性级情感分类仅依赖于与该属性相关的一组词或短语而与句子整体语义无关,那么只需要将注意力权重集中在决定属性情感的情感关键词上即可。此外,属性情感极性的判别依赖于与该属性相关的描述语语义而非具体的语言形式,仅仅利用翻译后的目标语言语料训练模型而忽略了源语言语料中丰富的属性情感信息是一种资源浪费。直觉上来说,作为资源丰富且高质量的源语言语料,其包含的属性情感信息比目标翻译语料更加准确和可靠,如果在训练过程中能够利用源语言语料中包含的属性情感信息帮助目标语言分类器进行训练,那么跨语言属性级情感分类的性能将进一步得到提升。

技术实现要素:

4.为解决上述问题,本发明提供了一种基于强化蒸馏的跨语言属性级情感分类方法,针对基于机器翻译的语料迁移方法中的问题并结合跨语言属性级情感分类的特点提出强化自注意力机制建模属性级表示。

5.为了达到上述目的,本发明提供如下技术方案:

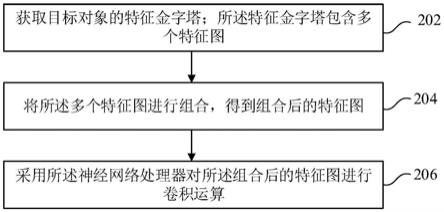

6.一种基于强化蒸馏的跨语言属性级情感分类方法,包括如下步骤:

7.步骤一,基于源语言语料训练一个教师网络,基于知识蒸馏框架将源语言语料中的属性情感信息迁移到学生网络的目标分类器中;

8.步骤二,采用属性敏感的序列选择器根据特定的属性从目标翻译句子序列中选择属性情感相关的信息,并作为模型的中间模块向目标分类器提供去噪后的句子序列表示;

9.步骤三,使用自注意力层构建基于跨语言蒸馏的目标分类器,建模属性序列与去噪后的目标翻译句子序列间的细粒度交互。

10.进一步的,所述序列选择器使用lstm网络建模策略网络p

π

,并利用策略梯度算法

学习一个最优策略π(a

1:n

),策略网络p

π

通过定义回报学习最优策略,并以概率p

π

(ai|si;θr)决定是否选择xi。

11.进一步的,所述策略网络的状态、动作和回报的定义如下:

12.·

状态:第i个时间步的状态定义为si;根据给定的属性,状态需要提供足够的信息来决定是否选择xi,因此状态si由以下三部分构成:

[0013][0014]

其中,hi是lstm第i个时间步的隐状态表示,vi是第i个词xi的向量表示,va是属性向量表示;

[0015]

·

动作:策略网络p

π

以概率p

π

(ai|si;θr)执行动作ai∈{0,1},并且使用逻吉斯特函数来计算此概率:

[0016]

a=[a1,a2,...,an]~p

π

(a|s;θr)

[0017]

其中θr为策略网络参数,~表示采样操作,s表示状态,a表示动作,wr与br表示可训练参数;

[0018]

·

回报:定义一个属性敏感的回报r,该定义集成了属性情感分类损失和跨语言蒸馏损失,对于一个训练样本《xs,x

t

,y》回报定义如下:

[0019][0020]

其中θ

src

为教师网络参数,θ

tgt

为学生网络参数,γn

′

/n为惩罚项防止过拟合。

[0021]

进一步的,所述步骤二和步骤三具体包括如下过程:

[0022]

对于目标翻译句子表示属性表示通过序列选择器获得去噪后的句子表示hd,即:

[0023]

a=[a1,a2,

…

,an]=rats(hs,υa)

[0024]

hd=hs~a

[0025]

其中,rats表示序列选择器,生成动作序列a,~表示从hs中将所有位置ai=1的向量提取出来拼接成新的句子序列表示;

[0026]

接着,在基于跨语言蒸馏的目标分类器中借助助自注意力层建模属性与去噪句子表示之间的细粒度交互:

[0027]

h=selfattention(ha,hd)

[0028]

最后,利用平均池化层和全连接层来计算每个类别的非归一化概率,即q=[q1,q2,...,qk],其中k表示类别数;通过软化softmax层,将概率进行归一化:

[0029][0030]

其中t表示温度,当t=1时退化为softmax函数。

[0031]

进一步的,对于所述序列选择器中的策略网络,利用基于策略梯度的reinforce算法进行优化;参数θr的优化目标即最大化期望回报关于参数θr的策略梯度定义如下:

[0032][0033]

其中d表示数据集大小,n表示句子序列长度,表示表示第i个样本第t时间步的动作,表示第i个样本第t时间步的状态。

[0034]

进一步的,对于目标分类器的参数θ

tgt

,利用反响传播算法进行优化;寻求参数θ

tgt

使得目标分类器的属性情感分类损失最小化:

[0035][0036]

其中,《xs,x

t

》分别表示源语言训练样本和目标翻译训练样本,θ

src

为教师网络参数,θ

tgt

为学生网络参数;知识蒸馏框架下教师网络参数在训练过程中需要被冻结。

[0037]

进一步的,在模型训练初期,θr不参与训练过程,当参数θ

tgt

在开发集上的损失开始收敛后,则开始对参数θr和θ

tgt

一起进行训练。

[0038]

进一步的,教师网络采用谷歌官方提供的bertbase模型进行训练,学生网络的目标分类器使用多头自注意力层建模属性与去噪后句子序列之间的交互关系,由3层transformer编码器子模块构成。句子序列最大长度设置为60,属性序列最大长度为5,词向量维度为768,句子序列和属性序列共享目标语言编码器。

[0039]

进一步的,模型使用adam优化器进行优化,初始学习率设置为1e-5用于训练学生网络,知识蒸馏温度t设置为3,回报中的惩罚项参数γ设置为1e-5。此外,模型训练的批次大小取值为32,训练迭代轮数为10,为了减小过拟合的影响,神经元随机失活率设置为0.3。

[0040]

与现有技术相比,本发明具有如下优点和有益效果:

[0041]

1.本发明利用序列选择器对目标翻译句子进行去噪,仅挑选情感关键词与后续属性建模细粒度交互,丢弃情感无关词和噪声词,去噪过程降低了模型建模属性级交互的难度,使得后续的软注意力权重分配更加集中;同时缓解了翻译语料与真实语料之间的领域偏差问题。

[0042]

2.在知识蒸馏框架下训练目标分类器,一旦训练完成便不再依赖机器翻译工具,从而能够充分利用源语言语料中的属性情感信息,且使得目标分类器具有更强的泛化能力。

[0043]

3.本发明模型能够充分利用源语言与目标翻译中有效的属性情感信息,同时更好地建模句子与属性之间的细粒度交互。

[0044]

4.通过实验表明,本发明在情感分类的各方面性能都较基线方法有了一定提升。

附图说明

[0045]

图1是本发明属性级情感分类情感关键词示意图;

[0046]

图2是本发明实现架构图;

[0047]

图3是本发明模型序列选择器示意图;

[0048]

图4是本发明模型目标分类器示意图。

具体实施方式

[0049]

以下将结合具体实施例对本发明提供的技术方案进行详细说明,应理解下述具体实施方式仅用于说明本发明而不用于限制本发明的范围。

[0050]

本发明提出的一种基于强化蒸馏的跨语言属性级情感分类方法,包括如下步骤:

[0051]

步骤一,基于源语言语料训练一个教师网络,基于知识蒸馏框架将源语言语料中的属性情感信息迁移到学生网络的目标分类器中;这样能够充分利用源语言语料中的属性情感信息,且使得目标分类器具有更强的泛化能力。

[0052]

步骤二,采用属性敏感的序列选择器根据特定的属性从目标翻译句子序列中选择属性情感相关的信息,并作为模型的中间模块向目标分类器提供去噪后的句子序列表示;去噪过程降低了模型建模属性级交互的难度,同时缓解了域差异问题。

[0053]

步骤三,使用自注意力层构建基于跨语言蒸馏的目标分类器,建模属性序列与去噪后的目标翻译句子序列间的细粒度交互。

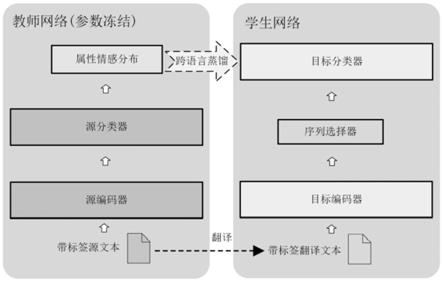

[0054]

图1展示了一个属性级情感分类情感关键词示意图。实现本发明的整体架构如图2所示,包括教师网络和学生网络。教师网络采用谷歌官方提供的bertbase模型进行训练,学生网络的目标分类器使用多头自注意力层建模属性与去噪后句子序列之间的交互关系,由3层transformer编码器子模块构成。句子序列最大长度设置为60,属性序列最大长度为5,词向量维度为768,句子序列和属性序列共享目标语言编码器。本发明中创新重点为两个核心模块:(1)属性敏感的序列选择器;(2)基于跨语言蒸馏的目标分类器。

[0055]

本发明提出了一种基于强化注意力机制的序列选择器,具体地说,序列选择器根据特定的属性从目标翻译句子序列中选择属性情感相关的信息,并作为模型的中间模块向目标分类器提供去噪后的句子序列表示。本发明使用了强化学习算法,即策略梯度训练一个序列选择器,该选择器会学习一个最优策略进行序列选择。序列选择器的构架如图3所示。

[0056]

在序列选择器中,为了充分考虑上下文信息以及序列选择的历史信息,本发明中使用了lstm网络来建模策略网络p

π

,并且利用策略梯度算法来学习得到一个最优策略π(a

1:n

),策略网络p

π

通过定义回报学习最优策略,并以概率p

π

(ai|si;θr)决定是否选择xi,在此状态、动作和回报的定义如下:

[0057]

·

状态.第i个时间步的状态定义为si。根据给定的属性,状态需要提供足够的信息来决定是否选择xi,因此状态si由以下三部分构成:

[0058][0059]

其中,hi是lstm第i个时间步的隐状态表示,vi是第i个词xi的向量表示,va是属性向量表示。

[0060]

·

动作.策略网络p

π

以概率p

π

(ai|si;θr)执行动作ai∈{0,1}。并且使用逻吉斯特函数来计算此概率:

[0061]

a=[a1,a2,...,an]~p

π

(a|s;θr)

[0062]

其中θr为策略网络参数,~表示采样操作,s表示状态,a表示动作,wr与br表示可训练参数。

[0063]

·

回报.为了鼓励策略网络p

π

做出正确的决策,本发明中定义一个属性敏感的回报r,该定义集成了属性情感分类损失和跨语言蒸馏损失。具体来说,对于一个训练样本《

xs,x

t

,y》回报定义如下:

[0064][0065]

其中θ

src

为教师网络参数,θ

tgt

为学生网络参数,γn

′

/n为惩罚项防止过拟合。

[0066]

给定一个带属性标注的目标翻译句子序列s

tgt

=x1,x2,...,xn,序列选择器会生成一个等长的二值序列a=a1,a2,...,an,其中当ai=1时表示xi被选择,当ai=0时,表示xi被丢弃。通过这种方式,序列选择器扮演了一种硬注意机制的角色,它可以根据特定的属性词从翻译句子中选择一组决定属性情感极性的情感关键词用于属性情感分类并丢弃其他情感无关词和噪声词,这可以减少模型建模细粒度属性级表示的难度,使得后续的软注意力权重分配更加集中。通过丢弃情感无关词和翻译噪声词,也可以在一定程度上缓解翻译语料与真实语料之间的领域偏差问题。

[0067]

通过序列选择器,我们对目标翻译句子序列进行词选择从而过滤掉噪声词,在此基础之上,通过一个目标分类器用于建模属性表示与去噪后句子表示之间的细粒度交互,其框架如图4所示。

[0068]

对于目标翻译句子表示属性表示通过序列选择器我们可以获得去噪后的句子表示hd。即:

[0069]

a=[a1,a2,...,an|=rats(hs,υa)

[0070]

hd=hs~a

[0071]

其中,rats表示序列选择器,生成动作序列a,~表示从hs中将所有位置ai=1的向量提取出来拼接成新的句子序列表示。接着,在基于跨语言蒸馏的目标分类器中借助自注意力层建模属性与去噪句子表示之间的细粒度交互:

[0072]

h=selfattention(ha,hd)

[0073]

最后,利用平均池化层和全连接层来计算每个类别的非归一化概率,即q=[q1,q2,...,qk],其中k表示类别数。通过软化softmax层,将概率进行归一化,

[0074][0075]

其中t表示温度,当t=1时退化为softmax函数。由于温度值越高使得概率分布的信息熵越大,包含的类别信息越丰富,因此在知识蒸馏框架中,通常选择较高的温度值最大化地利用教师网络中的类别知识帮助学生网络进行训练。

[0076]

最后采取优化策略来获得性能更好的模型。所述优化策略,基于强化注意力的跨语言属性级情感分类模型参数被分为两部分,一部分是序列选择器部分的策略网络参数θr,另一部分是目标分类器参数θ

tgt

。对于所述序列选择器中的策略网络,我们利用基于策略梯度的reinforce算法进行优化。参数θr的优化目标即最大化期望回报关于参数θr的策略梯度定义如下:

[0077][0078]

其中d表示数据集大小,n表示句子序列长度,表示表示第i个样本第t时间步的

动作,表示第i个样本第t时间步的状态。

[0079]

对于目标分类器的参数θ

tgt

,本发明利用反响传播算法进行优化。具体来说,寻求参数θ

tgt

使得目标分类器的属性情感分类损失最小化。

[0080][0081]

其中,《xs,x

t

》分别表示源语言训练样本和目标翻译训练样本,θ

src

为教师网络参数,θ

tgt

为学生网络参数。并且知识蒸馏框架下教师网络参数在训练过程中需要被冻结。

[0082]

在模型训练初期,θr将不参与训练过程,这意味着序列选择器不会丢弃任何序列,当参数θ

tgt

在开发集上的损失开始收敛后,则开始对参数θr和θ

tgt

一起进行训练。

[0083]

为了验证本发明相对于其他模型的优势,进行了一系列的对比实验。实验的步骤主要包括三个方面,首先是数据准备;然后模型训练;最后是通过训练好的模型进行测试,展示模型的效果。

[0084]

1)数据准备

[0085]

本实验使用的语料资源来自于semeval-2016公开的属性级标注语料以及苏宁易购电商平台的公开语料,为了全面评估跨语言属性情感分类模型的性能,语料包含了两个领域的评论文本,分别是餐饮领域和笔记本领域。在餐饮领域数据集上,我们将英文作为源语言,西班牙文、俄文作为目标语言进行跨语言属性级情感分类研究;在笔记本领域数据集上,我们将英文作为源语言,中文作为目标语言进行研究。实验过程中,训练集和开发集均选择源语言语料或其目标翻译语料,不使用额外的带标注目标语料资源,训练集与开发集比例为8:2。表1展示了使用机器翻译工具翻译前后的训练语料统计情况。

[0086]

表1

[0087][0088]

2)模型训练

[0089]

训练时,模型使用adam优化器进行优化,初始学习率设置为1e-5用于训练学生网络,知识蒸馏温度t设置为3,回报中的惩罚项参数γ设置为1e-5。此外,模型训练的批次大小取值为32,训练迭代轮数为10,为了减小过拟合的影响,神经元随机失活率设置为0.3。

[0090]

为了证明本发明提出的基于强化蒸馏的跨语言属性级情感分类方法的有效性,我们在相同数据集上选择如下基准模型与本发明提出的rekd作为对比:

[0091]

·

mtdan:该方法将源语言翻译为目标语言。基于目标翻译语料,利用翻译后的语料训练一个深度平均网络(deepaverage network)生成用于情感分类的句子向量表示。最终构建一个目标语言情感分类模型,在测试阶段直接用真实目标语言语料进行测试。

[0092]

·

ataelstm(s2t):该方法将源语言翻译为目标语言。基于目标翻译语料,利用lstm网络建模属性表示和句子表示,并利用注意力机制将属性表示添加到句子表示中,生成属性级句子表示用于情感分类。最终构建一个目标语言情感分类模型,在测试阶段直接用真实目标语言语料进行测试。

[0093]

·

ataelstm(t2s):该方法基于源语言语料,利用lstm网络建模属性表示和句子表示,并利用注意力机制生成属性级句子表示用于情感分类。最终构建一个源语言情感分类器,在测试阶段使用机器翻译工具将真实语料翻译为源语言进行测试。

[0094]

·

cldkcnn:该方法基于源语言语料训练一个教师网络,利用卷积神经网络作为语言编码器并通过跨语言蒸馏将情感信息迁移到学生网络中。最终构建一个目标语言情感分类器,在测试阶段直接使用真实目标语言语料进行测试。

[0095]

·

mbert:该方法基于源语言语料,构建《属性,句子》对作为模型输入建模属性级句子表示,经平均池化层得到的向量表示用于情感分类。利用mbert的跨语言表示能力,在测试阶段直接用真实目标语言语料进行测试。

[0096]

·

mbertsl:该方法基于自学习(selflearning)框架,利用源语言语料构建《属性,句子》对作为模型输入训练一个源语言属性情感分类器,然后利用mbert的跨语言表示能力结合选择机制对无标注目标语言语料进行预测,通过不断的迭代扩大目标语言语料完成目标语言属性级情感分类。在测试阶段直接用真实目标语言语料进行测试。

[0097]

·

dualbert:该方法基于源语言语料和其目标翻译语言语料,在训练阶段利用源语言语料中的情感信息辅助目标语言分类器进行属性级情感分类。最终构建一个以双语言文本作为输入的情感分类器,在测试阶段需要真实目标语言语料和其对应源语言翻译进行测试。

[0098]

·

transmatch:该方法将源语言翻译为目标语言。基于目标翻译语料和无标注真实目标语言语料,利用目标语言编码器分别编码属性、目标翻译句子和真实句子表示,然后引入领域判别器与编码器对抗训练生成领域无关的特征表示,同时利用目标翻译语料进行属性级情感分类训练。在测试阶段直接用真实目标语言语料进行测试。

[0099]

·

rekd:该方法基于源语言语料训练一个教师网络,利用强化蒸馏方法对目标翻译句子去噪,并通过多头注意力层构建的目标分类器建模属性级句子表示,去噪过程降低了模型建模属性级交互的难度,同时缓解了域差异问题。最终构建一个目标语言分类器,在测试阶段直接使用真实目标语言语料进行测试。

[0100]

3)实验结果

[0101]

将准备好的数据应用于上述模型,可得到如表2所示结果。结果中显示了训练后模型在测试集上的准确率及f1-measure,这些评价指标值越大则说明模型的表现越出色。

[0102]

表2

[0103][0104]

从表2可看到提出的基于强化蒸馏的跨语言属性情感分类方法要优于其他基准模型,取得了最优的结果。从实验结果可以看出mtdan方法将源语言语料翻译为目标语言,并利用深度平均网络建模句子级表示。但是该过程忽略了属性与句子表示之间的细粒度交互过程,最终得到的句子表示并不包含属性信息,因此该方法较其他基准模型表现较差。这也证明了属性级情感分类任务中建模属性级交互的重要性。通过对比ataelstm(s2t)与ataelstm(t2s)可以发现正向翻译的结果要比反向翻译差,主要原因在于正向翻译方法利用机器翻译工具将源语言语料翻译为目标语言语料,但翻译结果质量较低,使基于目标翻译语料训练出的模型性能较差,即误差传播。而反向翻译方法基于源语言语料训练一个源语言情感分类器,在测试阶段将目标语言翻译为源语言,该分类器使用的源语言语料质量较高、性能较好,即使在测试阶段使用质量较差的翻译语料也依然能保持较好的性能。

[0105]

其次,cldkcnn方法利用跨语言蒸馏也取得了较优的性能,证明了跨语言蒸馏方法的有效性。但是相比于rekd,该方法使用卷积神经网络构建目标语言编码器,忽略了属性与句子表示之间的交互关系,同时也忽略了翻译句子中的噪声问题。而rekd方法使用属性敏感的序列选择器过滤目标翻译句子中的噪声词,并利用多头自注意力网络作为目标分类器建模属性级句子表示作为最终分类依据,因此rekd方法取得了显著的提升。再者,mbert在不借助任何外部语料和机器翻译工具的条件下取得了不错的性能,这也说明了目前跨语言预训练模型的潜力。mbertsl方法在mbert的基础上,结合自学习框架以迭代的方式不断扩大目标语言训练集大小,最终构建一个具备目标语言分类能力的属性情感分类模型。该方法较mbert取得较为显著的提升,也证明了自学习框架在跨语言任务中的有效性。而本方法提出的rekd方法优于其他所有基准模型。

[0106]

本发明方案所公开的技术手段不仅限于上述实施方式所公开的技术手段,还包括由以上技术特征任意组合所组成的技术方案。应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也视为本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。