1.本发明属于数字电视广播领域,针对数字电视和音频通过不同设备进行音频和视频渲染时,提供一种跨设备和系统的音视频同步渲染的方法和系统。

背景技术:

2.随着视听传播技术的发展与媒介生态的变化,观众对视频的清晰度和逼真性的要求越来越高,视频技术正经历从高清技术向4k/8k超高清技术的演进,随着超高清和互联网技术的发展,为更好地满足新的媒体生态下观众文化生活消费,需要更多的音视频呈现技术来满足观众多样化的需求。2021年2月,中央广播电视总台的8k直播试验,采用了不同以往的呈现技术和方式,在室内外公共大屏对超高清8k节目进行直播,获得了业界和观众的好评,目前总台在直播试验的基础上,正积极推进8k超高清技术研究,开展公共大屏服务平台的建设。

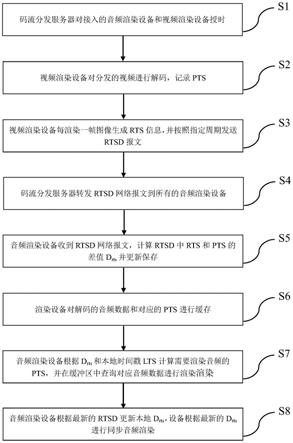

3.公共大屏位于开放空间,环境噪声比较复杂,大屏播放系统除了给观众带来视觉上的享受外,也需要为每个观众提供独立的声音呈现方式提升听觉上的体验,因此公共大屏的音频系统提供了手机接收同步广播音频功能。视频通过公共大屏呈现,音频通过互联网分发到手机或者其它专用音频渲染设备进行呈现。现有的家庭电视、影院和音响系统,音视频解码和渲染是在同一个设备或者本地互联的几个设备来完成,音视频同步的机制通过解码设备来完成。但是对于公共大屏系统采用异构独立的音视频渲染设备的方式,系统连接如图2所示,码流分发系统(服务器)对码流通过不同网络分别分发音视频流到视频解码器和音频解码器,音频解码器和视频解码器处于不同的网络,其中,rtsd表示渲染时间戳数据,ntp表示网络时间协议。目前的同步机制不能解决异构跨网络间的音视频同步技术要求,需要有新的方法来解决跨网络音视频同步问题,。

4.解决以上问题及缺陷的难度为:现有解码器的音视频同步机制根据码流的pts进行同步,对于异构跨设备系统,因为音视频采用独立分发的方式,音视频设备间的pts相互独立不能相互通信沟通,均采用独立自由解码方式进行解码和渲染,因此观众通过手机或者其它音频收听设备收听到的声音与大屏的画面会不同步。

5.解决以上问题及缺陷的意义为:可以给观众提供更好的音视频体验,呈现同步的音视频内容,需要发明一种跨设备和网络的音视频同步方法解决音视频同步问题

技术实现要素:

6.本发明提供了一种跨设备和系统的音视频同步渲染的方法,在传输流音视频解码时间戳(dts)和显示时间戳(pts)基础上,增加渲染时间戳(rts)参数,rts参数通过网络视频渲染设备传递到音频渲染设备,音频渲染设备根据收到的视频rts参数调整渲染时间,实现音视频在不同系统和设备中同步渲染。

7.本发明的技术方案如下:

8.根据本发明的一个发明,提供了一种跨设备和系统的音视频同步渲染的方法,包

括以下步骤:s1:码流分发服务器对接入的音频渲染设备和视频渲染设备授时;s2:视频渲染设备对分发的视频进行解码,解码数据放入渲染缓冲区,记录当前解码帧的显示时间戳(pts);s3:视频渲染设备每渲染一帧图像生成渲染时间戳(rts)信息和渲染时间戳数据(rtsd)网络报文,并按照指定周期发送渲染时间戳数据(rtsd)网络报文;s4:码流分发服务器转发渲染时间戳数据(rtsd)网络报文到所有的音频渲染设备;s5:音频渲染设备每收到一个渲染时间戳数据(rtsd)网络报文,计算渲染时间戳数据(rtsd)网络报文中的渲染时间戳(rts)和显示时间戳(pts)的差值d

rts

并更新保存;s6:音频渲染设备开始解码后,对解码后的音频数据和对应的显示时间戳(pts)进行缓存;s7:音频渲染设备根据d

rts

和本地时间戳计算需要渲染音频的渲染时间戳(rts),并在缓冲区中查询对应的音频数据进行渲染;以及s8:音频渲染设备根据最新的渲染时间戳数据(rtsd)更新本地d

rts

,并根据最新的d

rts

进行同步音频渲染。

9.优选地,在上述跨设备和系统的音视频同步渲染的方法中,在步骤s1中,授时采用网络时间协议,音视频渲染设备收到网络时间协议(ntp)时间后,解析网络时间协议(ntp)报文并根据网络时间协议(ntp)的时间信息更新本地时间。

10.优选地,在上述跨设备和系统的音视频同步渲染的方法中,在步骤s3中,视频渲染设备每渲染一帧图像,根据设备本地时间戳(lts)信息生成渲染时间戳(rts),同时生成包含当前渲染帧的显示时间戳(pts)和渲染时间戳(rts)信息的渲染时间戳数据(rtsd)网络报文,视频渲染设备每隔一定时间周期对最近一帧图像的rtsd报文回传到码流分发服务器,

11.优选地,在上述跨设备和系统的音视频同步渲染的方法中,在步骤s3中,在步骤s3中,渲染时间戳(rts)可采用显示时间戳(pts)一样的数据格式和时间戳精度。

12.优选地,在上述跨设备和系统的音视频同步渲染的方法中,在步骤s3中,在步骤s8中,音频渲染设备每收到一个渲染时间戳数据(rtsd)网络报文时,执行一次s5步骤计算d

rts

,并与本地保存的d

rts

信息进行对比,当根据渲染时间戳数据(rtsd)计算的d

rts

与本地d

rts

超出指定的范围,则更新音频渲染设备的d

rts

信息,同时通知音频渲染设备重新执行步骤s6和s7

13.根据本发明的另一方面,提供了一种跨设备和系统的音视频同步渲染的应用系统,包括:码流分发服务器、视频解码渲染设备和音频解码渲染设备,其中,码流分发服务器对接入的音视频解码渲染设备进行网络时间协议(ntp)授时,分发音视频码流到视频解码渲染设备,同时提取音频码流分发到音频解码渲染设备;视频解码渲染设备开始解码后生成渲染时间戳(rts)通过码流分发服务器传递到音频解码渲染设备;以及音频解码渲染设备接收到渲染时间戳(rts)后根据渲染时间戳(rts)信息进行同步渲染。

14.根据本发明的技术方案,产生的有益效果是:

15.本发明是针对同一音视频码流在不同网络上独立的音视频解码设备进行解码和渲染的使用场景,提供一种音视频同步渲染的方法,特别针对公共大屏音视频呈现场景,视频通过公共大屏呈现,音频通过手机或者其它音频接收设备呈现,通过本发明方法,可以实现音视频同步渲染呈现。

16.为了更好地理解和说明本发明的构思、工作原理和发明效果,下面结合附图,通过具体实施例,对本发明进行详细说明如下:

附图说明

17.为了更清楚地说明本发明具体实施方式或现有技术中的技术方案,下面将对具体实施方式或现有技术描述中所需要使用的附图作简单地介绍。

18.图1是本发明的跨设备和系统的音视频同步渲染的方法的详细流程图;

19.图2是本发明的的应用系统图。

具体实施方式

20.为使本发明的目的、技术方法及优点更加清晰,下面结合附图及具体实例,对本发明做进一步的详细说明。这些实例仅仅是说明性的,而并非对本发明的限制。

21.图1是本发明的一种跨设备和系统的音视频同步渲染的方法的详细流程图,包括以下步骤。

22.s1:码流分发服务器对接入的音频渲染设备和视频渲染设备授时,授时采用网络时间协议(ntp),音视频渲染设备收到ntp时间后,解析ntp报文并根据ntp的时间信息更新本地时间。

23.s2:视频渲染设备对分发的视频进行解码,解码数据放入渲染缓冲区,记录当前解码帧(即图像帧)的显示时间戳(pts)。

24.s3:视频渲染设备每渲染一帧图像生成rts信息和渲染时间戳数据(rtsd)网络报文,并按照指定周期发送渲染时间戳数据(rtsd)网络报文。具体地,视频渲染设备每渲染一帧图像,根据设备本地时间戳(lts)信息生成rts,同时生成包含当前渲染帧pts和rts信息的渲染时间戳数据(rtsd)网络报文,视频渲染设备每隔一定时间周期对最近一帧图像的rtsd报文回传到码流分发服务器,rts可采用pts一样的数据格式和时间戳精度。

25.s4:码流分发服务器转发rtsd网络报文到所有的音频渲染设备。具体地,码流分发服务器每收到一个rtsd网络报文,向接入的所有的音频渲染设备进行广播、组播或者其他网络通信协议。

26.s5:音频渲染设备每收到一个rtsd网络报文,计算rtsd网络报文中的rts和pts的差值d

rts

并更新保存,即将计算后的d

rts

更新到音频渲染设备保存(即更新到本地保存)。

27.以pts格式为例d

rts

计算公式如下:

28.①

vt

pts

=((d

pts1

&0x0e)《《29 (d

pts2

&0xff)《《22 (d

pts3

&0xfe)《《15 (d

pts4

&0xff)《《7 (d

pts5

&0xfe)》》1)

29.vt

pts

为根据pts值计算的视频显示时间,

30.d

pts1

、d

pts2

、d

pts3

、d

pts4

、d

pts5

为传输流中pts对应的字节内容,

31.0x表示字节内容为16进制。

32.②

vt

rts

=((d

rts1

&0x0e)《《29 (d

rts2

&0xff)《《22 (d

rts3

&0xfe)《《15 (d

rts4

&0xff)《《7 (d

rts5

&0xfe)》》1)

33.vt

rts

为根据rts值计算的视频渲染时间,

34.d

rts1

、d

rts2

、d

rts3

、d

rts4

、d

rts5

为rts网络报文中对应的字节内容。

35.③drts

=vt

pts-vt

rts

36.d

rts

为vt

pts

和vt

rts

为差值。

37.s6:音频渲染设备开始解码后,对解码后的音频数据和对应的pts进行缓存。

38.s7:音频渲染设备根据drts和本地时间戳lts计算需要渲染音频的pts,并在缓冲区中查询对应的音频数据进行渲染。以pts格式为例计算公式如下:

39.①

t

lts

=((d

lts1

&0x0e)《《29 (d

lts2

&0xff)《《22 (d

lts3

&0xfe)《《15 (d

lts4

&0xff)《《7 (d

lts5

&0xfe)》》1)

40.t

lts

为根据lts值计算的本地时间,

41.d

lts1

、d

lts2

、d

lts3

、d

lts4

、d

lts5

本地时间对应的字节内容。

42.②

at

pts

=t

lts

d

rts

43.at

pts

为根据lts时间和rts时间计算的音频渲染时间。

44.s8:音频渲染设备根据最新的rtsd更新本地d

rts

,并根据最新的d

rts

进行同步音频渲染。具体地,音频渲染设备每收到一个rtsd网络报文时,执行一次s5步骤计算d

rts

,并与本地保存的d

rts

信息进行对比,当根据rtsd计算的d

rts

(即,网络报文rtsd的d

rts

)与本地d

rts

超出指定的范围,则更新音频渲染设备的d

rts

信息,同时通知渲染设备重新执行步骤s6和s7。

45.本发明的跨设备和系统的音视频同步渲染的典型的应用系统,如图2所示,包括:码流分发服务器(例如,图2中的服务器(码流分发系统))、视频解码渲染设备(例如,图2中的视频渲染设备/系统)和音频解码渲染设备(例如,图2中的音频渲染设备/系统1,音频渲染设备/系统2,音频渲染设备/系统3),其中,码流分发服务器对接入的音视频解码渲染设备进行ntp授时,分发音视频码流到视频解码渲染设备,同时提取音频码流分发到音频解码渲染设备;视频解码渲染设备开始解码后生成rts通过码流分发服务器传递到音频解码渲染设备;以及音频解码渲染设备接收到rts后根据rts信息进行同步渲染。

46.本发明的跨设备和系统的音视频同步渲染的方法,在传输流音视频解码时间戳(dts)和显示时间戳(pts)基础上,增加渲染时间戳(rts)参数,rts参数通过网络视频渲染设备传递到音频渲染设备,音频渲染设备根据收到的视频rts参数调整渲染时间,实现音视频在不同系统和设备中同步渲染。

47.以上说明是依据发明的构思和工作原理的最佳实施例。上述实施例不应理解为对本权利要求保护范围的限制,依照本发明构思的其他实施方式和实现方式的组合均属于本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。