1.本公开涉及显示器。更具体地,本公开涉及沉浸式显示器。

背景技术:

2.如息屏显示(always-on display)和氛围(ambient)或辅助模式的高级特征可用于诸如智能电话、平板电脑和智能电视机的大多数智能设备上。尽管由于用户持续使用智能电话的增加,智能电话的关机时间已减少,但诸如智能电视机的其他智能设备的关机时间显著增加。当用户没在主动观看电视机上的任何内容时,氛围模式特征在智能电视机中被广泛地使用。

3.目前,传统的智能电视机在氛围模式下显示各种图像。这些图像是由智能电视机随机选择的,并且以非特定的顺序显示。此外,这些图像可能不对应于任何特定类别。作为结果,显示的图像没有主题或相关性。这样的无关的图像无法捕获用户的注意力。即使用户以氛围模式观看一些这样的图像,用户也倾向于对图像没有兴趣。此外,用于特定位置处的智能电视机的有关图像可能不一定与另一个位置中的智能电视机有关。

4.作为结果,传统的智能电视机无法为用户提供有用、愉悦和有关的体验。

5.因此,有对为用户提供有关体验的改进的显示系统和改进的显示方法的需要。

6.以上信息仅作为背景信息呈现,以协助理解本公开。关于以上中的任何内容是否可能适用于作为关于本公开的现有技术,没有作出决定,并且没有作出断言。

技术实现要素:

7.技术问题

8.本公开的各方面将至少解决上述问题和/或劣势并且将至少提供下述优势。因此,本公开的一方面将提供用于沉浸式显示系统的装置和方法以及沉浸式显示方法。

9.问题的解决方案

10.本概述既不旨在辨识本公开的必要特征,也不旨在用于确定或限制本公开的范围。

11.附加的方面将部分地在随后的描述中阐述,并且部分地将从描述中变得清晰,或者可以通过呈现的实施例的实践而获知。

12.根据本公开的一方面,提供了一种沉浸式显示方法。该沉浸式显示方法包括获得图像。场景分析模块辨识图像中的一个或多个对象。场景分析模块确定辨识的对象的一个或多个视觉特性。优先化模块基于对应的视觉特性向每个对象分配优先级值。音频确定模块基于对应的对象的优先级值从数据库中检索对应于对象的一个或多个音频文件。音频确定模块确定与检索的音频文件相关联的一个或多个音频特性。音频合成模块基于音频文件的音频特性和对象的优先级值处理音频文件以生成动态合成音频数据。在显示图像时经由扬声器播放动态合成音频数据。

13.根据本公开的另一个方面,提供了一种沉浸式显示系统。沉浸式显示系统包括场

景分析模块、优先化模块、音频确定模块、音频合成模块和扬声器。场景分析模块被配置为获得图像并辨识图像中的一个或多个对象。场景分析模块还确定对象的一个或多个视觉特性。优先化模块被配置为基于对应的视觉特性向每个对象分配优先级值。音频确定模块被配置为基于对应的对象的优先级值从数据库中检索对应于对象的一个或多个音频文件。音频确定模块还确定与检索的音频文件相关联的一个或多个音频特性。音频合成模块被配置为基于音频文件的音频特性和对象的优先级值处理音频文件以生成动态合成音频数据。扬声器被配置为在显示图像时播放动态合成音频。

14.根据本公开的另一个方面,在图像中捕获并由场景分析模块辨识的对象是能够发出声音的对象。

15.根据本公开的另一个方面,提供了优先化模块。优先化模块包括对象分类模块和上下文学习模块。对象分类模块被配置为从场景分析模块接收对象的视觉特性,并且基于对应的视觉特性将辨识的对象分类为可听对象(例如,能够发出声音的对象)和不可听对象(例如,不能够发出声音的对象)。上下文学习模块被配置为基于对应的视觉特性计算每个可听对象的优先级值。

16.根据本公开的另一个方面,提供了沉浸式显示系统。沉浸式显示系统包括反馈模块。反馈模块被配置为从用户接收反馈。反馈模块还将接收的反馈提供给优先化模块。

17.根据本公开的另一个方面,上下文学习模块还被配置为接收反馈并基于对应的视觉特性和接收的反馈计算每个可听对象的更新的优先级值。

18.根据本公开的另一个方面,反馈是以下中的一个或多个:(i)用户的注意时间,(ii)用户的眼睛注视,(iii)动态合成音频的音量水平的改变,(iv)用户的一个或多个面部表情,以及(v)由用户提供的主动反馈。

19.根据本公开的另一个方面,音频确定模块还被配置为接收对象的优先级值和对应的视觉特性,并将优先级值与预定义的置信度分数进行比较。音频确定模块还从数据库中检索与具有大于预定义的置信度分数的优先级值的对象对应的音频文件。此后,音频确定模块将检索的音频文件的音频特性存储在数据库中。

20.根据本公开的另一个方面,沉浸式显示系统包括关联模块和生成模块。关联模块被配置为辨识具有辨识的对象的图像内的一个或多个感兴趣区域。关联模块还基于辨识的对象的视觉特性从辨识的对象当中辨识一个或多个关键对象。此后,关联模块从数据库中检索对应于关键对象的一个或多个外部动态对象。生成模块被配置为生成或定义用于外部动态对象的一个或多个飞行路径,并渲染结果图像,使得外部动态对象表现出沿着图像的对应的感兴趣区域内的对应的飞行路径移动。

21.根据本公开的另一个方面,由关联模块辨识的关键对象是能够在外部环境中的路径中移动的对象。

22.根据本公开的另一个方面,场景分析模块还被配置为基于辨识的对象确定场景。这里,场景对应于图像中捕获的信息。

23.根据本公开的另一个方面,对象包括图像中描绘的以下中的一个或多个:(i)一个或多个物理对象,(ii)一个或多个人物的一个或多个面部表情,(iii)一个或多个地理地标,以及(iv)一个或多个预定义人物。

24.根据本公开的另一个方面,对象的视觉特性包括以下中的一个或多个:(i)由对象

在图像上占用的面积,(ii)亮度,(iii)色度,(iv)对象的外观,(v)对象的深度,以及(vi)图像的透视图(perspective)。

25.根据本公开的另一个方面,音频特性包括以下中的一个或多个:(i)增益、(ii)振幅、(iii)采样频率、(iv)比例因子、(v)声音音程、(vi)流派,以及(vii)音高。

26.根据本公开的另一个方面,沉浸式显示系统包括传感器模块和氛围分析模块。传感器模块被配置为提供由一个或多个传感器生成的一个或多个输入。氛围分析模块被配置为基于来自传感器模块的输入来确定氛围信息。

27.根据本公开的另一个方面,优先化模块基于对应的视觉特性和氛围信息向每个对象分配优先级值。

28.根据本公开的另一个方面,音频合成模块基于音频文件的音频特性、对象的优先级值和氛围信息生成动态合成音频。

29.根据本公开的另一个方面,氛围信息包括与以下中的一个或多个相关联的信息:(i)一个或多个氛围灯,(ii)显示器附近的一个或多个人物,(iii)显示器附近的一个或多个对象,(iii)天气,(iv)一个或多个事件,(v)用户的一个或多个动作,(vi)时间,(vii)一天中的时间,(viii)位置,(ix)预定时间表,以及(x)与周围环境相关联的上下文信息。

30.根据本公开的另一个方面,提供了一种沉浸式显示方法。该沉浸式显示方法包括获得图像。场景分析模块辨识图像中的一个或多个对象。对象确定模块确定辨识的对象的一个或多个视觉特性和一个或多个音频特性。优先化模块基于对应的视觉特性和音频特性向每个对象分配优先级值。媒体分析模块基于辨识的对象的视觉特性、音频特性和优先级值来检索对应于辨识的对象的一个或多个外部媒体元素。显示处理模块同时将外部媒体元素连同图像一起渲染。

31.根据本公开的另一个方面,提供了一种沉浸式显示系统。沉浸式显示系统包括场景分析模块、对象分析模块、优先化模块、媒体分析模块、以及显示处理模块。场景分析模块被配置为辨识图像中的一个或多个对象。对象分析模块被配置为确定辨识的对象的一个或多个视觉特性和一个或多个音频特性。优先化模块被配置为基于对应的视觉特性和音频特性向每个对象分配优先级值。媒体分析模块被配置为基于辨识的对象的视觉特性、音频特性和优先级值从本地数据库检索对应于辨识的对象的一个或多个外部媒体元素。显示处理模块还被配置为同时将外部媒体元素连同图像一起渲染。

32.根据本公开的另一个方面,外部媒体元素是以下中的至少一个:(i)动态合成音频文件,以及(ii)外部动态对象。

33.根据本公开的另一个方面,提供了沉浸式显示系统。沉浸式显示系统包括扬声器,该扬声器被配置为在显示图像时播放动态合成音频文件。

34.根据本公开的另一个方面,沉浸式显示系统包括音频确定模块和音频合成模块。音频确定模块被配置为基于对象的优先级值从数据库检索对应于对象的一个或多个音频文件。音频确定模块还确定用于检索的音频文件的一个或多个音频特性。音频合成模块被配置为基于音频文件的音频特性和对象的优先级值处理音频文件以生成动态合成音频数据。

35.根据本公开的另一个方面,由场景分析模块辨识的对象是能够发出声音的对象。

36.根据本公开的另一个方面,沉浸式显示系统包括生成模块。生成模块被配置为在

图像上渲染外部动态对象。

37.根据本公开的另一个方面,沉浸式显示系统包括关联模块。关联模块被配置为辨识图像内的一个或多个感兴趣区域。这里,感兴趣区域中具有辨识的对象。关联模块还被配置为基于辨识的对象的视觉特性从辨识的对象当中辨识一个或多个关键对象。此后,关联模块基于关键对象从数据库中检索外部动态对象。这里,外部动态对象与对应的关键对象相关。此后,关联模块生成或定义用于外部动态对象的一个或多个飞行路径。

38.根据本公开的另一个方面,生成模块还被配置为渲染结果图像,使得外部动态对象表现出在对应的感兴趣区域内沿着图像上对应的飞行路径移动。

39.根据本公开的另一个方面,由关联模块辨识的关键对象是能够在外部环境中的路径中移动的对象。

40.根据本公开的另一个方面,对象包括图像中描绘的以下中的一个或多个:(i)一个或多个物理对象,(ii)一个或多个人物的一个或多个面部表情,(iii)一个或多个地理地标,以及(iv)一个或多个预定义人物。

41.根据本公开的另一个方面,对象的视觉特性包括以下中的一个或多个:(i)由对象在图像上占用的面积,(ii)亮度,(iii)色度,(iv)对象的外观,(v)对象的深度,以及(vi)图像的透视图。

42.根据本公开的另一个方面,音频特性包括以下中的一个或多个:(i)增益、(ii)振幅、(iii)采样频率、(iv)比例因子、(v)声音音程、(vi)流派,以及(vii)音高。

43.根据本公开的另一个方面,沉浸式显示系统包括氛围分析模块。氛围分析模块被配置为基于接收的传感器输入来从传感器模块接收一个或多个传感器输入并且确定氛围信息。

44.根据本公开的另一个方面,优先化模块基于对应的视觉特性和氛围信息向每个对象分配优先级值。

45.根据本公开的另一个方面,音频合成模块基于音频文件的音频特性、对象的优先级值和氛围信息生成动态合成音频。

46.根据本公开的另一个方面,氛围信息包括以下中的一个或多个的信息:(i)一个或多个氛围灯,(ii)显示器附近的一个或多个人物,(iii)显示器附近的一个或多个对象,以及(iii)天气,(iv)一个或多个事件,(v)用户的一个或多个动作,(vi)时间,(vii)一天中的时间,(viii)位置,(ix)预定时间表,以及(x)与周围环境相关联的上下文信息。

47.根据本公开的另一个方面,当本地数据库不包含外部媒体元素时,媒体分析模块从外部服务器检索对应于辨识的对象的外部媒体元素。

48.根据本公开的另一个方面,媒体分析模块将从外部服务器检索的外部媒体元素存储到本地数据库中。

49.本公开的其他方面、优势和显著特征将从结合附图公开了本公开的各种实施例的以下详细描述中对本领域技术人员变得清晰。

附图说明

50.本公开的某些实施例的上述和其他方面、特征和优势将从结合附图的以下描述而更加清晰,其中:

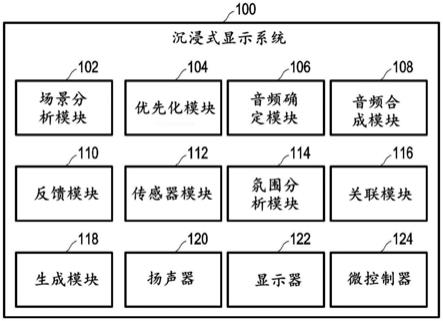

51.图1示出了根据本公开的实施例的沉浸式显示系统的示意框图;

52.图2示出了根据本公开的实施例的场景分析模块的示意框图;

53.图3示出了根据本公开的实施例的优先化模块的示意框图;

54.图4示出了根据本公开的实施例的音频确定模块的示意框图;

55.图5示出了根据本公开的实施例的音频合成模块和数据库的示意框图;

56.图6示出了根据本公开的实施例的传感器模块的示意框图;

57.图7示出了根据本公开的实施例的关联模块的示意框图;

58.图8示出了根据本公开的实施例的生成模块和显示模块的示意框图;

59.图9a、9b、9c、9d和9e示出了根据本公开的各种实施例的沉浸式显示方法的示意表示;

60.图10a和10b示出了根据本公开的实施例的沉浸式显示方法的示意表示;

61.图11a和11b示出了根据本公开的实施例的沉浸式显示方法的示意表示;

62.图12示出了根据本公开的实施例的氛围分析的示意表示;

63.图13示出了根据本公开的实施例的场景分析的示意表示;

64.图14示出了根据本公开的实施例的场景分析的示意表示;

65.图15示出了根据本公开的实施例的动态对象确定的示意表示;

66.图16示出了根据本公开的实施例的感兴趣区域确定的示意表示;

67.图17示出了根据本公开的实施例的动态对象生成的示意表示;

68.图18示出了根据本公开的实施例的飞行路径生成的示意表示;

69.图19示出了根据本公开的实施例的动态对象渲染的示意表示;

70.图20示出了根据本公开的实施例的沉浸式显示系统的示意框图;

71.图21是示出了根据本公开的实施例的沉浸式显示方法的流程图;

72.图22是示出了根据本公开的实施例的沉浸式显示方法的流程图;

73.图23是示出了根据本公开的实施例的生成动态合成音频的方法的流程图;

74.图24是根据本公开的实施例的基于场景分析的音频关联的图示表示;

75.图25是根据本公开的实施例的基于场景分析的音频关联的图示表示;

76.图26是根据本公开的实施例的基于氛围分析的音频关联的图示表示;

77.图27是根据本公开的实施例的基于氛围分析的音频关联的图示表示;

78.图28是根据本公开的实施例的各种音频关联的图示表示;

79.图29是根据本公开的实施例的基于面部表情的音频关联的图示表示;

80.图30是根据本公开的实施例的基于图像分析的音频关联的图示表示;

81.图31是根据本公开的实施例的基于氛围分析的动态对象关联的图示表示;

82.图32是根据本公开的实施例的基于相机输入的动态对象关联的图示表示;

83.图33是根据本公开的实施例的在感兴趣区域中渲染动态对象的方法的图示表示;

84.图34是根据本公开的实施例的基于接近度输入的动态对象关联的图示表示;

85.图35是根据本公开的实施例的基于传感器输入的动态对象关联的图示表示;

86.图36是根据本公开的实施例的渲染动态对象的方法的图示表示;以及

87.图37是根据本公开的实施例的图像转换的方法的图示表示。

88.贯穿附图,相同附图标记将被理解为指代相同的部件、组件和结构。

具体实施方式

89.提供参考附图的以下描述以协助全面理解由权利要求及其等同物限定的本公开的各种实施例。它包括各种具体细节以协助理解,但这些将仅被视为示例性的。因此,本领域普通技术人员将认识到,在不脱离本公开的范围和精神的情况下,可以对本文描述的各种实施例做出各种改变和修改。此外,为了清楚和简洁,可以省略对众所周知的功能和构造的描述。

90.在以下描述和权利要求中使用的术语和词语不限于书目意义,而仅由发明人使用以使得能够清楚且一致地理解本公开。因此,本领域技术人员应当清晰,提供本公开的各种实施例的以下描述仅用于说明目的,而不用于限制由所附权利要求及其等同物限定的本公开的目的。

91.将理解单数形式“一”、“一个”和“所述”包括复数所指事物,除非上下文另有明确规定。因此,例如,对“组件表面”的引用包括对一个或多个这样的表面的引用。

92.此外,附图内的组件和/或模块之间的连接不旨在限制于直接连接。反而,这些组件和模块可以由中间组件和模块修改、重新格式化或以其他方式改变。

93.本公开中对“一个实施例”或“一实施例”的引用意味着结合该实施例描述的特定特征、结构、特性或功能被包括在本公开的至少一个实施例中。说明书中各个地方出现的短语“在一个实施例中”不一定全都指代同一实施例。

94.本公开的各种实施例提供了一种沉浸式显示方法和沉浸式显示系统。

95.在本公开的实施例中,提供了一种沉浸式显示方法。沉浸式显示方法包括获得图像。场景分析模块辨识图像中的一个或多个对象。场景分析模块确定辨识的对象的一个或多个视觉特性。优先化模块基于对应的视觉特性向每个对象分配优先级值。音频确定模块基于对应的对象的优先级值从数据库中检索对应于对象的一个或多个音频文件。音频确定模块确定与检索的音频文件相关联的一个或多个音频特性。音频合成模块基于音频文件的音频特性和对象的优先级值处理音频文件以生成动态合成音频数据。在显示图像时经由扬声器播放动态合成音频数据。

96.在本公开的另一个实施例中,提供了一种沉浸式显示系统。沉浸式显示系统包括场景分析模块、优先化模块、音频确定模块、音频合成模块和扬声器。场景分析模块被配置为获得图像并辨识图像中的一个或多个对象。场景分析模块还确定对象的一个或多个视觉特性。优先化模块被配置为基于对应的视觉特性向每个对象分配优先级值。音频确定模块被配置为基于对应的对象的优先级值从数据库中检索对应于对象的一个或多个音频文件。音频确定模块还确定与检索的音频文件相关联的一个或多个音频特性。音频合成模块被配置为基于音频文件的音频特性和对象的优先级值处理音频文件以生成动态合成音频数据。扬声器被配置为在显示图像时播放动态合成音频。

97.在图像中捕获并由场景分析模块辨识的对象是能够发出声音的对象。

98.优先化模块包括对象分类模块和上下文学习模块。对象分类模块被配置为从场景分析模块接收对象的视觉特性,并且基于对应的视觉特性将辨识的对象分类为可听对象(例如,能够发出声音的对象)和不可听对象(例如,不能够发出声音的对象)。上下文学习模块被配置为基于对应的视觉特性计算每个可听对象的优先级值。

99.沉浸式显示系统还包括反馈模块。反馈模块被配置为从用户接收反馈。反馈模块

还将接收的反馈提供给优先化模块。

100.上下文学习模块还被配置为接收反馈并基于对应的视觉特性和接收的反馈计算每个可听对象的更新的优先级值。

101.反馈是以下中的一个或多个:(i)用户的注意时间,(ii)用户的眼睛注视,(iii)动态合成音频的音量水平的改变,(iv)用户的一个或多个面部表情,以及(v)由用户提供的主动反馈。

102.音频确定模块还被配置为接收对象的优先级值和对应的视觉特性,并将优先级值与预定义的置信度分数进行比较。音频确定模块还从数据库中检索与具有大于预定义的置信度分数的优先级值的对象对应的音频文件。此后,音频确定模块将检索的音频文件的音频特性存储在数据库中。

103.沉浸式显示系统还包括关联模块和生成模块。关联模块被配置为辨识具有辨识的对象的图像内的一个或多个感兴趣区域。关联模块还基于来自辨识的对象当中的视觉特性辨识出辨识的对象中的一个或多个关键对象。此后,关联模块从数据库中检索对应于关键对象的一个或多个外部动态对象。生成模块被配置为生成或定义用于外部动态对象的一个或多个飞行路径,并渲染结果图像,使得外部动态对象表现出在对应的感兴趣区域内沿着图像上对应的飞行路径移动。

104.由关联模块辨识的关键对象是能够在外部环境中的路径中移动的对象。

105.场景分析模块还被配置为基于辨识的对象确定场景。这里,场景对应于图像中捕获的信息。

106.对象包括图像中描绘的以下中的一个或多个:(i)一个或多个物理对象,(ii)一个或多个人物的一个或多个面部表情,(iii)一个或多个地理地标,以及(iv)一个或多个预定义人物。

107.对象的视觉特性包括以下中的一个或多个:(i)由对象在图像上占用的面积,(ii)亮度,(iii)色度,(iv)对象的外观,(v)对象的深度,以及(vi)图像的透视图。

108.音频特性包以下中的一个或多个:(i)增益、(ii)振幅、(iii)采样频率、(iv)比例因子、(v)声音音程、(vi)流派,以及(vii)音高。

109.沉浸式显示系统还包括传感器模块和氛围分析模块。传感器模块被配置为提供由一个或多个传感器生成的一个或多个输入。氛围分析模块被配置为基于来自传感器模块的输入来确定氛围信息。

110.优先化模块基于对应的视觉特性和氛围信息向每个对象分配优先级值。

111.音频合成模块基于音频文件的音频特性、对象的优先级值和氛围信息生成动态合成音频。

112.氛围信息包括与以下中的一个或多个相关联的信息:(i)一个或多个氛围灯,(ii)显示器附近的一个或多个人物,(iii)显示器附近的一个或多个对象,以及(iii)天气,(iv)一个或多个事件,(v)用户的一个或多个动作,(vi)时间,(vii)一天中的时间,(viii)位置,(ix)预定时间表,以及(x)与周围环境相关联的上下文信息。

113.在本公开的实施例中,提供了一种沉浸式显示方法。沉浸式显示方法包括检索图像。场景分析模块辨识图像中的一个或多个对象。对象确定模块确定辨识的对象的一个或多个视觉特性和一个或多个音频特性。优先化模块基于对应的视觉特性和音频特性向每个

对象分配优先级值。媒体分析模块基于辨识的对象的视觉特性、音频特性和优先级值来检索对应于辨识的对象的一个或多个外部媒体元素。显示处理模块同时将外部媒体元素连同图像一起渲染。

114.在本公开的另一个实施例中,提供了一种沉浸式显示系统。沉浸式显示系统包括场景分析模块、对象分析模块、优先化模块、媒体分析模块、以及显示处理模块。场景分析模块被配置为辨识图像中的一个或多个对象。对象分析模块被配置为确定辨识的对象的一个或多个视觉特性和一个或多个音频特性。优先化模块被配置为基于对应的视觉特性和音频特性向每个对象分配优先级值。媒体分析模块被配置为基于辨识的对象的视觉特性、音频特性和优先级值来检索对应于辨识的对象的一个或多个外部媒体元素。显示处理模块还被配置为同时将外部媒体元素连同图像一起渲染。

115.外部媒体元素是以下中的至少一个:(i)动态合成音频文件,以及(ii)外部动态对象。

116.沉浸式显示系统还包括扬声器,该扬声器被配置为在显示图像时播放动态合成音频文件。

117.沉浸式显示系统还包括音频确定模块和音频合成模块。音频确定模块被配置为基于对象的优先级值从数据库检索对应于对象的一个或多个音频文件。音频确定模块还确定用于检索的音频文件的一个或多个音频特性。音频合成模块被配置为基于音频文件的音频特性和对象的优先级值处理音频文件以生成动态合成音频数据。

118.由场景分析模块辨识的对象是能够发出声音的对象。

119.沉浸式显示系统还包括生成模块。生成模块被配置为在图像上渲染外部动态对象。

120.沉浸式显示系统还包括关联模块。关联模块被配置为辨识图像内的一个或多个感兴趣区域。这里,感兴趣区域中具有辨识的对象。关联模块还被配置为基于辨识的对象的视觉特性从辨识的对象当中辨识一个或多个关键对象。此后,关联模块基于关键对象从数据库中检索外部动态对象。这里,外部动态对象与对应的关键对象相关。此后,关联模块生成用于外部动态对象的一个或多个飞行路径。

121.生成模块还被配置为渲染结果图像,使得外部动态对象表现出在对应的感兴趣区域内沿着图像上对应的飞行路径移动。

122.由关联模块辨识的关键对象是能够在外部环境中的路径中移动的对象。

123.对象包括图像中描绘的以下中的一个或多个:(i)一个或多个物理对象,(ii)一个或多个人物的一个或多个面部表情,(iii)一个或多个地理地标,以及(iv)一个或多个预定义人物。

124.对象的视觉特性包括以下中的一个或多个:(i)由对象在图像上占用的面积,(ii)亮度,(iii)色度,(iv)对象的外观,(v)对象的深度,以及(vi)图像的透视图。

125.音频特性包括以下中的一个或多个:(i)增益、(ii)振幅、(iii)采样频率、(iv)比例因子、(v)声音音程、(vi)流派,以及(vii)音高。

126.沉浸式显示系统还包括氛围分析模块。氛围分析模块被配置为基于接收的传感器输入来从传感器模块接收一个或多个传感器输入并且确定氛围信息。

127.优先化模块基于对应的视觉特性和氛围信息向每个对象分配优先级值。

128.音频合成模块基于音频文件的音频特性、对象的优先级值和氛围信息生成动态合成音频。

129.氛围信息包括以下中的一个或多个的信息:(i)一个或多个氛围灯,(ii)显示器附近的一个或多个人物,(iii)显示器附近的一个或多个对象,(iii)天气,(iv)一个或多个事件,(v)用户的一个或多个动作,(vi)时间,(vii)一天中的时间,(viii)位置,(ix)预定时间表,以及(x)与周围环境相关联的上下文信息。

130.在又一个实施例中,当本地数据库不包含外部媒体元素时,媒体分析模块从外部服务器检索对应于辨识的对象的外部媒体元素。

131.在又一个实施例中,媒体分析模块将从外部服务器检索的外部媒体元素存储到本地数据库中。

132.根据本公开的实施例示出了沉浸式显示系统(100)的示意框图图1。

133.参照图1,沉浸式显示系统(100)包括场景分析模块(102)、优先化模块(104)、音频确定模块(106)、音频合成模块(108)、反馈模块(110)、传感器模块(112)、氛围分析模块(114)、关联模块(116)、生成模块(118)、扬声器(120)、显示器(122)和微控制器(124)。

134.沉浸式显示系统(100)可以安装在电子设备中,诸如但不限于智能电话、平板电脑、智能电视机等。沉浸式显示系统(100)可以以独立的方式实现在设备上。可替代地,沉浸式显示系统(100)可以在服务器或网络服务器上实现并且作为基于网络的服务提供给电子设备。

135.在示例中,当电子设备处于氛围模式时,即,当用户没在主动使用电子设备或者未选择要在电子设备处显示的内容时,实现本公开。

136.显示器(122)显示图像。显示器(122)的示例包括但不限于电视机屏幕、智能电话屏幕、智能电视机屏幕和平板电脑屏幕。显示器(122)可以是发光二极管(led)、液晶显示器(lcd)、有机发光二极管(oled)、有源矩阵有机发光二极管(amoled)或超级有源矩阵有机发光二极管(samoled)屏幕。显示器(122)可以具有各种分辨率。本领域普通技术人员将理解,本公开不限于显示器(122)的任何类型或任何分辨率。

137.微控制器(124)被配置为实施本公开的沉浸式显示方法。微控制器(124)包括至少一个处理器和存储器(两者在图1中未示出)。处理器被配置为执行存储在存储器中的多个机器可读指令。

138.扬声器(120)被配置为播放音乐和/或音频文件。扬声器(120)的音量和模式可以是可由用户按照用户的要求来控制或编程。

139.根据本公开的实施例示出了场景分析模块(102)的示意框图图2。

140.参照图2,场景分析模块(102)包括对象检测模块(202)、场景检测模块(204)、视觉处理模块(206)、地标检测模块(208)和眼睛注视检测模块(210)。

141.在示例中,场景分析模块(102)可以获得在显示器(122)上显示的图像。在一个实施例中,当用户正在主动使用电子设备或正在电子设备处显示选择的内容时,场景分析模块(102)可以获得在显示器(122)上显示的图像。在另一个示例中,场景分析模块(102)可以从外部图像源(图1中未示出)获得图像。场景分析模块(102)辨识图像中的一个或多个对象。对象的示例包括但不限于物理对象、用户的面部表情、地理地标和一个或多个预定义的人物。

142.在示例中,场景分析模块(102)可以使用人工智能(ai)技术以用于对象检测和场景确定。例如,场景分析模块(102)可以使用人物、地标、面部表情和/或一个或多个模式识别技术,诸如你只看一次(yolo)、单次多框检测器(ssd)、卷积神经网络(cnn)、基于区域的cnn(rcnn)、长短期记忆(lstm)等。这些ai技术可以容易地在上述诸如智能电话或智能电视机的电子设备上实现。在示例中,这些ai技术由沉浸式显示系统(100)使用神经处理单元(npu)实现。

143.场景分析模块(102)可以针对检测的对象提取各种参数,诸如但不限于大小、定位、深度等。场景分析模块(102)还可以提取关于检测的对象的上下文信息。在示例中,当图形交换格式(gif)文件显示在显示器(122)上时,场景分析模块(102)处理gif文件的每一帧。

144.对象检测模块(202)检测图像中的对象。在示例中,对象检测模块(202)使用图像处理和图像识别技术来检测图像中的对象。在示例中,对象检测模块(202)使用机器学习和人工智能技术来检测图像中的对象。在另一个示例中,对象检测模块(202)被训练为在沉浸式显示系统(100)的初始化期间使用机器学习技术检测对象。

145.场景检测模块(204)检测与图像相关联的场景或环境。例如,场景检测模块(204)确定图像是关于室内场景还是室外场景。在示例中,场景检测模块(204)使用图像处理和图像识别技术来检测场景。

146.视觉处理模块(206)确定辨识的对象的一个或多个视觉特性。视觉特性的示例包括但不限于由图像中被辨识的对象占用的面积、亮度、色度、辨识的对象的外观、对象的深度或图像的透视图。

147.地标检测模块(208)检测图像中一个或多个著名或众所周知的纪念碑或地标的存在。在示例中,地标检测模块(208)使用图像处理和图像识别技术来检测图像中的纪念碑或地标。

148.眼睛注视检测模块(210)检测用户的眼睛注视。例如,眼睛注视检测模块(210)检测用户是否正在看显示器(122)。眼睛注视检测模块(210)还可以检测用户正在看的方向或对象。在示例中,眼睛注视检测模块(210)使用由相机捕获的信息来确定用户的眼睛注视。

149.根据本公开的实施例示出了优先化模块(104)的示意框图图3。

150.参照图3,优先化模块(104)包括对象分类模块(302)、上下文学习模块(304)和氛围优先化模块(306)。

151.优先化模块(104)从场景分析模块(102)接收关于辨识的对象和辨识的对象的视觉特性的信息。优先化模块(104)基于对象的对应的视觉特性为每个辨识的对象分配优先级值。

152.对象分类模块(302)从场景分析模块(102)接收关于辨识的对象和对应于辨识的对象的视觉特性的信息。对象分类模块(302)基于对应的视觉特性将辨识的对象分类为可听对象和不可听对象。这里,可听对象是图像中辨识的、能够发出声音的对象,而不可听对象是图像中辨识的、不能够发出声音的对象。对象分类模块(302)向上下文学习模块(304)提供关于可听对象和可听对象的对应的视觉特性的信息。

153.上下文学习模块(304)基于对应的视觉特性将优先级值分配给可听对象。在示例中,与不太可能对结果音频文件有影响的可听对象相比,可能被感知为主导为图像生成的

音频文件的可听对象被分配更高的优先级。在另一个示例中,与图像中较远地出现的可听对象相比,图像中较近地出现的可听对象被分配更高的优先级。在又一示例中,与具有较低声音强度的可听对象(即,较安静的对象)相比,具有较大声音强度的可听对象(即,较大声的对象)被分配更高的优先级。在示例中,根据百分比值分配可听对象的优先级值。在另一个示例中,根据相对数值分配可听对象的优先级值。在又一个示例中,根据绝对数值分配可听对象的优先级值。

154.氛围优先化模块(306)基于氛围信息向可听对象分配优先级值。在示例中,和与氛围信息无关的可听对象相比,与氛围信息有关的可听对象被分配更高的优先级值。例如,当氛围信息指示降雪时,诸如雪花的有关对象可以被分配更高的优先级值。氛围优先化模块(306)还可以基于辨识的场景向可听对象分配优先级值。在示例中,和与辨识的场景无关的可听对象相比,与辨识的场景有关的可听对象被分配更高的优先级值。例如,当辨识的场景指示室内庆祝事件时,诸如花彩或横幅的有关对象可能被分配更高的优先级值。

155.根据本公开的实施例示出了音频确定模块(106)的示意框图图4。

156.参照图4,音频确定模块(106)包括音频属性分析模块(402)和音频选择模块(404)。

157.根据本公开的实施例示出了音频合成模块和数据库的示意框图图5。

158.参照图5,音频合成模块(108)与数据库(504)通信。虽然没有在图5中示出,但音频确定模块106也可以与数据库(504)通信。音频合成模块(108)包括音频生成单元(502)。数据库(504)包括关联数据(506)、音频数据(508)、上下文数据(510)、视觉模型参数数据(512)以及训练和测试数据(514)。

159.音频数据(508)是音频文件的储存库。

160.关联数据(506)包括关于音频文件的信息和与可能的可听对象相关联的信息,所述可能的可听对象与音频文件相关联。

161.上下文数据(510)包括关于存储的音频文件的上下文的信息。

162.视觉模型参数数据(512)包括关于与音频文件相关联的可能的视觉特性的信息。

163.训练和测试数据(514)包括训练算法和测试算法。

164.音频确定模块(106)接收关于可听对象的信息和对应的优先级值。音频确定模块(106)将可听对象的优先级值与预定义的置信度分数进行比较。如果可听对象的优先级值大于预定义的置信度分数,则音频确定模块(106)从数据库(504)中检索对应于可听对象的音频文件。如果可听对象的优先级值不大于预定义的置信度分数,则音频确定模块(106)丢弃可听对象并检查下一个可听对象。音频选择模块(404)检索对应于优先级值大于或等于置信度分数的可听对象的音频文件。属性分析模块(402)确定检索的音频文件的一个或多个音频特性。音频特性的示例包括但不限于增益、振幅、采样频率、比例因子、声音音程、流派以及音高。音频确定模块(106)将检索的音频文件的音频特性存储在数据库(504)中。

165.在示例中,音频确定模块(106)还向检索的音频文件分配音频权重。在示例中,音频权重确定音频文件被混合以形成动态合成音频数据的比例。在示例中,音频确定模块(106)使用诸如短时傅立叶变换(stft)的ai技术来辨识与存储在数据库(504)中的音频文件相关联的流派并从音频文件中提取元数据。

166.音频确定模块(106)向音频合成模块(108)提供音频文件和音频权重。音频合成模

块(108)混合音频文件以生成动态合成音频数据。音频生成单元(502)基于音频文件的音频特性和对应的可听对象的优先级值,从音频文件生成动态合成音频数据。音频生成单元(502)向扬声器(120)提供生成的动态合成音频。

167.音频合成模块(108)使用音频混合器将多个音频文件组合成单个组合音频文件。音频合成模块(108)可以调整诸如增益、比例因子、采样频率、衰减等的音频参数以使组合的音频听起来舒缓或愉悦。在示例中,音频合成模块(108)使用wavenet或生成对抗网络(gan)技术来产生动态合成音频数据。在另一个示例中,使用机器学习算法训练音频合成模块(108)以基于输入音频和音频参数生成原始音乐。在示例性实施例中,动态合成音频数据包括由音频合成模块(108)生成的原始音乐。

168.扬声器(120)被配置为在图像显示在显示器(122)上时播放动态合成音频数据,从而为电子设备的用户提供沉浸式体验。

169.有利地,生成动态合成音频数据所需的时间小于图像转换时间。这为用户提供了无缝且不间断的沉浸式体验。由于生成动态合成音频数据所需的时间小于图像转换时间,因此在连同对应的动态合成音频文件一起地显示两个连续图像之间没有延迟或滞后。因此,用户可以瞬间感知图像和同时播放的动态合成音频。

170.图6示出了根据本公开的实施例的传感器模块的示意框图。

171.参照图6,传感器模块(112)包括照度传感器(602)、相机(604)、温度传感器(606)、麦克风(608)、接近度传感器(610)和运动检测器(612)。

172.照度传感器(602)检测电子设备周围的照度水平或量。例如,照度传感器(602)检测智能电视机所位于的房间照明昏暗还是照明良好。或者例如,照度传感器(602)确定房间是由自然光还是由人造光照明。

173.相机(604)捕获电子设备周围的视频或图像。在示例中,相机馈送或相机输入可以用于确定房间是否被占用。相机(604)也可以用于捕获面部表情或眼睛注视。相机馈送也可以用于确定房间中的场景。相机馈送还可以用于确定可见的天气状况,诸如降雨、降雪、沙尘暴等。由氛围分析模块(114)确定的氛围信息中包括从相机馈送获得的所有上述信息。

174.温度传感器(606)可以用于检测电子设备附近的温度。

175.麦克风(608)可以用于捕获用户在电子设备附近所说的单词或句子。由麦克风(608)捕获的音频可以用于辨识用户的情绪。麦克风(608)还可以捕获在电子设备附近播放的歌曲。

176.接近度传感器(610)可以用于确定用户在电子设备附近存在。

177.运动检测器(612)可以用于检测房间内的占用,即房间是否被占用,以及还有占用房间的一定数量的人物。

178.来自照度传感器(602)、相机(604)、温度传感器(606)、麦克风(608)、接近度传感器(610)和运动检测器(612)的馈送被提供给氛围分析模块(114)作为传感器输入。

179.氛围分析模块(114)基于传感器输入生成氛围信息。氛围信息的示例包括但不限于氛围照明、电子设备附近的人物、显示器附近的对象以及天气、事件、用户的动作、时间、一天中的时间、位置、预定时间表和与电子设备周围相关联的上下文信息。

180.在示例中,氛围分析模块(114)生成指示房间内光强度的氛围信息。例如,房间内的明亮的灯可能与愉快的情绪相关联,而昏暗的灯可能与阴郁的情绪相关联。在另一个实

例中,氛围分析模块(114)还可以检测节日、一天中的时间、天气等。

181.沉浸式显示系统(100)基于氛围信息提供动态合成音频数据。例如,优先化模块(104)基于对应的视觉特性和氛围信息为每个可听对象分配优先级值。音频合成模块(108)基于音频文件的音频特性、可听对象的优先级值和氛围信息生成动态合成音频数据。

182.例如,优先化模块(104)可以基于视觉特性(诸如大小、定位、焦点、相对深度等)和氛围信息(诸如光强度、事件、天气等)分配优先级值。在示例中,优先化模块(104)使用上下文ai技术向对象分配优先级值。优先化模块(104)可以确定与可听对象相关联的音频的类型,例如,连续音频可以与海浪相关联,而间歇或周期性音频可以与在图像中检测到的鸟相关联。上下文ai可以基于图像的前景和背景、图像的上下文、用户的历史等来确定对象的音频权重。

183.反馈模块(110)接收来自用户的反馈并向优先化模块(104)提供反馈。上下文学习模块(304)从反馈模块(110)接收反馈,基于对应的视觉特性和接收的反馈计算每个可听对象的更新优先级值。反馈的示例包括但不限于用户的注意时间、用户的眼睛注视、动态合成音频的音量水平的改变、用户的一个或多个面部表情、以及由用户提供的主动反馈。此外,在示例中,当动态合成音频连同图像一起播放时,上下文ai也可以分析用户的兴趣。

184.根据本公开的实施例示出了关联模块(116)的示意框图图7。

185.参照图7,关联模块(116)包括动态对象确定模块(702)和感兴趣区域确定模块(704)。

186.感兴趣区域确定模块(704)辨识一个或多个感兴趣区域。感兴趣区域是图像中具有辨识的对象的一个或多个部分。关联模块(116)在辨识的对象中确定一个或多个关键对象。关键对象是能够在外部环境中的路径中移动的对象。动态对象确定模块(702)从外部数据库(未示出)检索对应于关键对象的一个或多个外部动态对象。关联模块(116)向生成模块(118)提供关于外部动态对象的信息。

187.图8示出了根据本公开的实施例的生成模块和显示模块的示意性框图。

188.参照图8,生成模块(118)与显示模块(802)通信。生成模块(118)包括动态对象生成模块(804)、飞行路径生成模块(806)和动态对象渲染模块(808)。显示模块(802)控制显示器(122)。

189.动态对象生成模块(804)生成一个或多个动态对象。飞行路径生成模块(806)为外部动态对象生成一个或多个飞行路径,使得外部动态对象表现出沿着对应的飞行路径移动。飞行路径是图像中感兴趣区域内的、外部动态对象沿着其渲染的一个或多个踪迹或轨迹。

190.动态对象渲染模块(808)在图像上的对应的感兴趣区域内的对应的飞行路径上渲染外部动态对象。

191.在示例中,生成模块(118)还确定外部动态对象的动画类型。动画的示例包括但不限于淡入、淡出等。例如,动态对象渲染模块(808)按照确定的动画风格渲染动态对象。

192.显示模块(802)混合图像和外部动态对象以显示其中具有动画的外部动态对象和图像的沉浸式图像。沉浸式图像显示在显示器(122)上。

193.图9a至图9e示出了根据本公开各种实施例的沉浸式显示方法的示意表示。

194.参照图9a,场景分析模块(102)接收多个图像帧。场景分析模块(102)辨识图像内

诸如海浪、人物、鸟、山和岩石的对象。

195.参照图9b,场景分析模块(102)向优先化模块(104)提供辨识的对象。优先化模块(104)基于辨识的对象是否能够生成声音将对象分类为可听对象和不可听对象。例如,优先化模块(104)将海浪、鸟和人物分类为可听对象,将山和岩石分类为不可听对象。

196.优先化模块(104)分别向海浪、鸟和人物分配优先级值pv1、pv2和pv3。对象的对应的音频权重分别为av1、av2、av3。

197.参照图9c,在优先化模块(104)向音频确定模块(106)提供可听对象和对应的优先级值之后,音频确定模块(106)将对象的优先级值与阈值置信度分数进行比较。例如,海浪和鸟具有大于或等于阈值置信度分数的对应的优先级值(pv1和pv2),并且人物具有小于阈值置信度分数的优先级值(pv3)。因此,音频确定模块(106)检索分别对应于海浪和鸟的第一和第二音频文件。

198.参照图9d,在音频确定模块(106)向音频合成模块(108)提供第一和第二音频文件以及对应的音频权重之后,音频合成模块(106)基于对应的音频权重和对象的优先级值混合第一和第二音频文件以生成动态合成音频文件。

199.参照图9e,音频合成模块(108)向扬声器(120)提供动态合成音频文件。扬声器(120)播放动态合成音频文件并且显示器(122)显示图像,使得同时呈现动态合成音频文件和图像,从而向用户提供沉浸式和愉悦的体验。

200.图10a和10b示出了根据本公开的实施例的沉浸式显示方法的示意表示。

201.参照图10a,在1处,场景分析模块(102)辨识图像内的对象。例如,可以使用机器学习(ml)或分布式深度学习(dl)技术(诸如,r-cnn、yolo、面部表情识别(recognition)模型等)执行对象辨识(identification)。

202.在2处,优先化模块(104)将对象分类为可听和不可听对象。优先化模块(104)向可听对象分配优先级值。例如,可以使用基于上下文ai模型的算法或使用基于规则的算法来执行对象的分类。

203.在3处,音频确定模块(106)检索具有大于或等于阈值置信度分数的优先级值的对象的音频文件。在示例性实施例中,可以基于与对象相关联的类别或流派来搜索音频文件和内容服务器储存库上存储的音频文件。

204.参照图10b,在4处,音频合成模块(108)生成动态合成音频数据。例如,音频混合可以用于混合音频样本以产生结果音频文件。

205.在5处,显示器(122)显示图像并且扬声器(120)同时播放动态合成音频数据。

206.在6处,反馈模块(110)向优先化模块(104)提供反馈。

207.图11a和11b示出了根据本公开的实施例的沉浸式显示方法的示意表示。

208.参照图11,在1处,场景分析模块(102)基于图像辨识场景。

209.在2处,动态对象确定模块(702)从数据库中检索外部动态对象。

210.在3处,感兴趣区域确定模块(704)确定图像内的感兴趣区域。

211.参照图11b,在4处,动态对象生成模块(804)生成动态对象。

212.在5处,飞行路径生成模块(806)为外部动态对象生成飞行路径。

213.在6处,动态对象渲染模块(808)在显示器(122)上的图像的对应的感兴趣区域内沿着对应的飞行路径渲染外部动态对象。

214.图12示出了根据本公开的实施例的氛围分析的示意表示。

215.参照图12,氛围分析模块(114)接收传感器输入,诸如亮度数据、接近度数据、温度数据、天气数据、位置数据和图像分析。氛围分析模块(114)基于传感器输入生成氛围信息。氛围分析模块(114)向场景分析模块(102)和关联模块(116)提供氛围信息。

216.图13示出了根据本公开的实施例的场景分析的示意表示。

217.参照图13,场景分析模块(102)基于图像识别场景。场景分析模块(102)还辨识图像中的关键对象。

218.图14示出了根据本公开的实施例的场景分析的示意表示。

219.参照图14,场景分析模块(102)基于图像辨识场景。场景分析模块(102)还辨识图像中的关键对象。

220.图15示出了根据本公开的实施例的动态对象确定的示意表示。

221.参照图15,动态对象确定模块(702)确定对应于关键对象的外部动态对象。

222.图16示出了根据本公开的实施例的感兴趣区域确定的示意表示。

223.参照图16,感兴趣区域确定模块(704)确定图像内的感兴趣区域。

224.图17示出了根据本公开的实施例的动态对象生成的示意性表示。

225.参照图17,动态对象生成模块(804)生成对应于关键对象的动态对象。

226.图18是根据本公开的实施例的飞行路径生成的示意表示。

227.参照图18,飞行路径生成模块(806)生成用于外部动态对象的飞行路径。

228.图19示出了根据本公开的实施例的动态对象渲染的示意表示。

229.参照图19,动态合成渲染模块(808)在图像上的对应的感兴趣区域内沿着对应的飞行路径渲染外部动态对象。

230.图20示出了根据本公开的实施例的沉浸式显示系统(2000)的示意框图。

231.参照图20,沉浸式显示系统(2000)包括场景分析模块(2002)、优先化模块(2004)、音频确定模块(2006)、音频合成模块(2008)、反馈模块(2010)、传感器模块(2012)、氛围分析模块(2014)、关联模块(2016)、生成模块(2018)、扬声器(2020)、显示器(2022)、微控制器(2024)、对象分析模块(2026)、媒体分析模块(2028)、显示处理模块(2030)和本地数据库(2032)。

232.场景分析模块(2002)被配置为辨识图像中的一个或多个对象。对象分析模块(2026)被配置为确定辨识的对象的一个或多个视觉特性和一个或多个音频特性。优先化模块(2004)被配置为基于对应的视觉特性和音频特性向每个对象分配优先级值。媒体分析模块(2028)被配置为基于辨识的对象的视觉特性、音频特性和优先级值,从本地数据库(2032)检索对应于辨识的对象的一个或多个外部媒体元素。

233.本地数据库(2032)存储外部媒体元素的储存库。媒体分析模块(2028)搜索本地数据库(2032)以检索对应于辨识的对象的外部媒体元素。当在本地数据库(2032)中没有找到对应于辨识的图像的外部媒体元素时,媒体分析模块(2028)从外部服务器(未示出)检索对应于辨识的图像的元素。

234.此外,媒体分析模块(2028)通过在本地数据库(2032)中存储从外部服务器检索的外部媒体元素来更新本地数据库(2032)的储存库。在示例中,媒体分析模块(2028)实时更新本地数据库(2032)。

235.显示处理模块(2030)被配置为同时将外部媒体元素连同图像一起渲染。

236.外部媒体元素包括以下中的一个或多个:动态合成音频文件和外部媒体元素。

237.在示例中,沉浸式显示系统(2000)在功能上类似于沉浸式显示系统(100)。

238.在沉浸式显示系统(2000)中,可以连同以下两者一起提供图像:动态合成音频和外部媒体元素。在这种情况下,由于动画的外部媒体对象在显示器上移动,因此图像在视觉上对用户是愉悦的,并且由于动态合成音频,因此听起来是愉悦的。

239.图21是示出了根据本公开的实施例的沉浸式显示方法的流程图。

240.参照图21,在操作2102处,场景分析模块(102)获得图像。

241.在操作2104处,场景分析模块(102)辨识图像中的对象。

242.在操作2106处,场景分析模块(102)确定辨识的对象的视觉特性。

243.在操作2108处,优先化模块(104)向可听对象分配优先级值。

244.在操作2110处,音频确定模块(106)从数据库(504)中检索音频文件。

245.在操作2112处,音频确定模块(106)确定音频文件的音频特性并将音频特性存储在数据库(504)中。

246.在操作2114处,音频合成模块(108)生成动态合成音频数据。

247.在操作2116处,扬声器(120)在屏幕(122)上显示图像时播放动态合成音频文件。

248.图22是示出了根据本公开的实施例的沉浸式显示方法的流程图。

249.参照图22,在2202处,场景分析模块(2002)检索图像。

250.在2204处,场景分析模块(2002)辨识图像中的对象。

251.在操作2206处,对象分析模块(2026)确定对象的音频特性和视觉特性。

252.在2208处,优先化模块(2004)向对象分配优先级值。

253.在操作2210处,媒体分析模块(2028)检索外部媒体元素。

254.在操作2212处,显示处理模块(2030)在图像上渲染外部媒体元素。

255.图23是示出了根据本公开的实施例的生成动态合成音频数据的方法的流程图。

256.参照图23,在操作2302处,场景分析模块(102)辨识图像中的对象。

257.在操作2304处,优先化模块(104)将对象分类为可听和不可听对象。

258.在操作2306处,音频确定模块(106)基于音频权重对对象进行优先化。

259.在操作2308处,音频确定模块(106)将对象的音频权重与阈值置信度分数进行比较。

260.如果在操作2308处,音频确定模块(106)确定对象的音频权重大于或等于阈值置信度分数,则音频确定模块执行操作2310。

261.在操作2310处,音频确定模块(106)搜索对应于对象的匹配音频文件。

262.在操作2312处,音频确定模块(106)确定检索的音频文件的音频属性。

263.在操作2314处,音频合成模块(108)生成动态合成音频。

264.如果在操作2308处,音频确定模块(106)确定对象的音频权重小于阈值置信度分数,则音频确定模块执行操作2316。

265.在操作2316处,音频确定模块(106)丢弃对象并检查下一个对象。

266.图24是根据本公开的实施例的基于场景分析的音频关联的图示表示。

267.参照图24,沉浸式显示系统(100)基于场景分析模块(102)检测的场景关联音频。

当场景分析模块(102)检测到海浪的场景时,播放对应于海浪的音频。当场景分析模块(102)检测到森林的场景时,播放对应于森林的音频。当场景分析模块(102)检测到人物站在沙滩处的场景时,播放对应于沙滩的音频。

268.图25是根据本公开的实施例的基于场景分析的音频关联的图示表示。

269.参照图25,沉浸式显示系统(100)使用由氛围分析模块(114)提供的氛围信息、基于由场景分析模块(102)检测的场景关联音频。当场景分析模块(102)检测到儿童生日派对的场景时,播放对应于生日派对的音频。当场景分析模块(102)检测到派对的场景时,播放对应于派对的音频,诸如爵士/流行音乐。

270.图26是根据本公开的实施例的基于氛围分析的音频关联的图示表示。

271.参照图26,沉浸式显示系统(100)基于由氛围分析模块(114)提供的氛围信息来关联音频。当氛围分析模块(114)检测到晴天时,播放舒缓的音乐。

272.图27是根据本公开的实施例的基于氛围分析的音频关联的图示表示。

273.参照图27,沉浸式显示系统(100)基于由氛围分析模块(114)提供的氛围信息来关联音频。当氛围分析模块(114)检测到雨天时,播放对应于雨或风的音频。

274.图28是根据本公开的实施例的各种音频关联的图示表示。

275.参照图28,沉浸式显示系统(100)基于地理位置关联音频。例如,位于印度的沉浸式显示系统(100)播放印度国歌连同图像,而位于一些其他国家的沉浸式显示系统(100)播放该国家的国歌连同图像。

276.图29是根据本公开的实施例的基于面部表情的音频关联的图示表示。

277.参照图29,沉浸式显示系统(100)基于用户的面部表情播放音频。例如,当用户的面部表情为快乐的表情时,沉浸式显示系统(100)播放快乐的歌曲。类似地,当用户的面部表情是悲伤的表情时,沉浸式显示系统(100)播放舒缓的音乐。或者当用户的面部表情是愤怒的表情时,沉浸式显示系统(100)播放励志歌曲。

278.图30是根据本公开的实施例的基于图像分析的音频关联的图示表示。

279.参照图30,沉浸式显示系统(100)在智能电话上实现。当用户点击智能电话的屏幕上显示的图像时,由智能电话播放对应于该图像的音频。

280.图31是根据本公开的实施例的基于氛围分析的动态对象关联的图示表示

281.参照图31,沉浸式显示系统(100)基于由氛围分析模块(114)提供的氛围信息来选择动态对象。这里,场景分析模块(102)基于氛围信息确定场景是生日派对。因此,沉浸式显示系统(100)基于气球的上下文相关性(即,气球广泛用于生日庆祝)选择气球作为动态对象。因此,沉浸式显示系统(100)在图像上显示飞起来的气球。

282.图32是根据本公开的实施例的基于相机输入的动态对象关联的图示示图

283.参照图32,沉浸式显示系统(100)基于由氛围分析模块(114)提供的氛围信息来关联动态对象。当氛围分析模块(114)检测到雨天或冬天时,显示对应于雨(诸如水)或冬季(诸如雪花)的动态对象。

284.图33是根据本公开的实施例的在感兴趣区域中渲染动态对象的方法的图示表示。

285.参照图33,沉浸式显示系统(100)按照对象的自然移动生成动态对象的飞行路径。例如,沉浸式显示系统(100)将蝴蝶显示为悬停在图像中显示的花朵上方的动态对象。此外,沉浸式显示系统(100)可以显示蝴蝶从一个花朵飞到另一个花朵,以便于模仿现实世界

中蝴蝶的移动。

286.图34是根据本公开的实施例的基于接近度输入的动态对象关联的图示表示。

287.参照图34,沉浸式显示系统(100)基于用户与显示器(122)的接近度来修改动态对象的显示。例如,当用户非常靠近显示器(122)时,沉浸式显示系统(100)可以显示蝴蝶消失。

288.图35是根据本公开的实施例的基于传感器输入的动态对象关联的图示表示。

289.参照图35,沉浸式显示系统(100)基于由氛围分析模块(114)提供的氛围信息来关联动态对象。当氛围分析模块(114)确定房间照明良好时,沉浸式显示系统(100)在图像中显示强光。类似地,当氛围分析模块(114)确定房间照明昏暗时,沉浸式显示系统(100)在图像中显示昏暗的光。

290.图36是根据本公开的实施例的渲染动态对象的方法的图示表示。

291.参照图36,沉浸式显示系统(100)基于场景分析模块(102)检测的场景关联动态对象。例如,当场景分析模块(102)检测到水下场景时,沉浸式显示系统(100)将游泳的鱼显示为动态对象。在另一个实例中,当场景分析模块(102)检测到花园场景时,沉浸式显示系统(100)将飞行的鸟显示为动态对象。在另一个实例中,当场景分析模块(102)检测到瀑布场景时,沉浸式显示系统(100)将飞行的鸟显示为动态对象。在另一个实例中,当场景分析模块(102)检测到山峰场景时,沉浸式显示系统(100)将飞行的龙显示为动态对象。

292.图37是根据本公开的实施例的图像转换方法的图示表示。

293.参照图37,沉浸式显示系统(100)在图像中的多个感兴趣区域中显示动态对象。例如,当图像描绘两个花瓶时,沉浸式显示系统(100)将飞行的蝴蝶显示为动态对象。这里,沉浸式显示系统(100)在第一时刻处显示第一花瓶上飞行的蝴蝶,并且在第二时刻处显示第二花瓶上飞行的蝴蝶。

294.应该注意的是,描述仅说明了本公开的原理。因此将理解,本领域技术人员将能够设计尽管本文没有明确描述但是体现了本公开的原理的各种布置。

295.此外,本文中列举的所有示例主要明确旨在仅用于说明目的,以帮助读者理解由发明人为推进技术而贡献的概念和原理,并且将被解释为不限于这样的具体列举的示例和状况。

296.虽然已经参考本公开的各种实施例示出和描述了本公开,但是本领域技术人员将理解,在不脱离由所附权利要求及其等效物定义的本公开的精神和范围的情况下,可以在其中进行形式和细节的各种改变。上述特征可以以各种方式组合以形成多个变体。因此,本公开不限于上述具体实施例,而仅受所附权利要求及其等效物的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。