1.本发明属于遥感信息智能处理技术领域,具体涉及一种基于时空信息辅助的无人机视频车辆跟踪方法。

背景技术:

2.随着车辆数目的快速增长,道路交通管理面临的问题越来越复杂。利用监控摄像头获取监控视频,可以使交通管理部门直观的了解当前道路的信息,从而制定更加有效的管理策略。目前,基于监控视频的车辆跟踪算法主要包括:(1)基于车辆轨迹特征进行车辆跟踪;(2)基于车辆外观特征进行车辆跟踪。其中,基于车辆轨迹特征进行车辆跟踪的方法为:将车辆运动的历史轨迹与卡尔曼滤波、粒子滤波、背景差分等算法相结合预测车辆的位置。在车辆运动方向变化较小时,跟踪稳定性好;基于车辆外观特征进行车辆跟踪的方法为:采用相关滤波、均值漂移等算法获取目标车辆的外观特征,如haar特征、sift特征以及hog特征等,再通过特征匹配获取车辆的位置信息。在车辆特征清晰时,车辆跟踪精确度高。

3.但上述算法主要应用于地面监控视频中,而传统的地面监控设备主要部署于路口的龙门架上,监控视角有限。若对特定车辆进行持续跟踪监控,需要推算车辆可能会经过的所有路口,然后对所有路口的视频画面进行检测,不仅会导致误跟踪,同时若路口未部署监控摄像头,会直接导致跟踪失败。

4.随着无人机技术不断成熟,为道路车辆跟踪提供了新的解决思路。不同于传统的地面监控设备,利用无人机进行跟踪,具有成本低,快速、机动、监控范围广的特点,不仅能够动态的对目标进行实时定位与跟踪,还能够进一步利用无人机对目标车辆提供语音信息传递、物品快速送达等服务。

5.但无人机视频拍摄高度较高,且视频中往往包含大量车辆,而目标车辆在每帧图像中所占的像素少,直接对整帧图像进行车辆特征匹配费时费力,且会产生大量干扰特征,导致车辆误跟踪问题。同时,无人机在车辆跟踪过程中,由于车辆行驶方向不断变化,目标车辆本身的旋转使得其与提供的目标车辆模板产生变化,导致目标车辆得分图响应弱,降低车辆跟踪准确度。

技术实现要素:

6.针对现有技术存在的缺陷,本发明提供一种基于时空信息辅助的无人机视频车辆跟踪方法,可有效解决上述问题。

7.本发明采用的技术方案如下:

8.本发明提供一种基于时空信息辅助的无人机视频车辆跟踪方法,包括以下步骤:

9.步骤1,确定需要跟踪的目标车辆s;

10.步骤2,无人机对地面进行拍摄,获得无人机视频数据;将无人机视频数据的每一视频帧作为图像帧;

11.步骤3,按图像帧生成顺序,依次对各个图像帧进行车辆特征识别,判断每个图像

帧是否包含目标车辆s,如果不包含,则继续对下一图像帧进行车辆特征识别,直到定位到包含目标车辆s的图像帧,然后执行步骤4;如果包含,则表明成功搜索到目标车辆s,执行步骤4;

12.将首次识别到包含目标车辆s的图像帧设为第0图像帧frm(0),在第0图像帧frm(0)中确定包含目标车辆s的车辆结果框box(0),再一步确定车辆结果框box(0)的位置信息,包括:车辆结果框box(0)的宽w0,高h0以及中心点坐标p0(x0,y0);

13.步骤4,从第0图像帧frm(0)搜索到目标车辆s开始,采用时空信息辅助的无人机视频车辆跟踪方法,对后续的图像帧frm(t)中的目标车辆s进行跟踪;其中,t=(1,2,

…

,end)表示当前图像帧距离第0图像帧frm(0)的帧数,end表示跟踪结束时图像帧的帧数;

14.对于图像帧frm(t),采用以下方法,追踪到目标车辆s在图像帧frm(t)的位置:

15.步骤4.1,在图像帧frm(t)中,确定车辆疑似位置区域,从而得到车辆疑似位置图z(t);

16.具体的,以当前图像帧frm(t)为参考,则图像帧frm(t-1)表示为当前图像帧frm(t)的前一图像帧,图像帧frm(t-2)表示为图像帧frm(t-1)的前一图像帧;

17.提取图像帧frm(t-1)的车辆结果框box(t-1)和图像帧frm(t-2)的车辆结果框box(t-2)的位置信息,根据车辆结果框box(t-2)向车辆结果框box(t-1)方向的变化趋势,在图像帧frm(t)中,确定车辆疑似位置区域,从而得到车辆疑似位置图z(t);

18.步骤4.2,确定浅层类内特征图f

shallow

map(tb)和深层类间特征图f

deep

map(tb):

19.将步骤3中通过车辆特征识别确定的车辆结果框box(0)作为目标车辆的车辆模板框tb,依次经过conv1、conv2、conv3卷积层,得到浅层类内特征图f

shallow

map(tb);将浅层类内特征图f

shallow

map(tb)继续输入到conv4、conv5卷积层,得到深层类间特征图f

deep

map(tb);

20.步骤4.3,对车辆疑似位置图z(t)进行特征提取,得到深层车辆疑似特征图f

deep

map(z):

21.将步骤4.1得到的车辆疑似位置图z(t)经过conv1、conv2卷积层提取特征,得到初始车辆疑似特征图f

init

map(z);然后,以浅层类内特征图f

shallow

map(tb)作为卷积核,对初始车辆疑似特征图f

init

map(z)进行卷积,得到浅层车辆疑似特征图f

shallow

map(z),进而加强初始车辆疑似特征图f

init

map(z)中目标车辆的响应程度;最后,将浅层车辆疑似特征图f

shallow

map(z)经过conv4卷积核进行特征提取,得到深层车辆疑似特征图f

deep

map(z);

22.步骤4.4,获取目标车辆得分图scoremap:

23.步骤4.4.1,判断当前帧数t是否大于历史车辆跟踪结果信息辅助帧数k,若t≤k,则执行步骤4.4.2;若t>k,则执行步骤4.4.3;

24.步骤4.4.2,t≤k时,目标车辆得分图scoremap的获取方法:

25.当t≤k时,以深层类间特征图f

deep

map(tb)作为卷积核,对深层车辆疑似特征图f

deep

map(z)进行卷积,输出目标车辆得分图scoremap,进而抑制深层车辆疑似特征图f

deep

map(z)中非车辆类别物体的响应程度;然后执行步骤4.5;

26.步骤4.4.3:t>k时,目标车辆得分图scoremap的获取方法:

27.步骤4.4.3.1,当t>k时,提取历史最接近k个车辆结果框,分别为:图像帧frm(t-1)的车辆结果框box(t-1),图像帧frm(t-2)的车辆结果框box(t-2)...,图像帧frm(t-k)的

车辆结果框box(t-k);

28.其中,图像帧frm(t-1)表示当前图像帧frm(t)的前一帧,

…

,图像帧frm(t-k)表示当前图像帧frm(t)的前第k帧;

29.上述k个历史车辆结果框中不仅包含目标车辆的特征信息,还包含目标车辆在时间序列中的变化信息;

30.步骤4.4.3.2,将车辆结果框box(t-1),车辆结果框box(t-2),...,车辆结果框box(t-k)依次输入conv1至conv5卷积层中,分别得到对应历史帧的深层类间特征图f

deep

map(b

t-1

),f

deep

map(b

t-2

),

…

,f

deep

map(b

t-k

);

31.步骤4.4.3.3,将历史帧的深层类间特征图f

deep

map(b

t-1

),f

deep

map(b

t-2

),

…

,f

deep

map(b

t-k

)分别与步骤4.2得到的深层类间特征图f

deep

map(tb)相减,得到k个深层区别特征图;

32.将k个深层区别特征图通过concat串联,得到历史变化特征图f

change

map(b);将历史变化特征图f

change

map(b)通过1*1*n的卷积核进行特征融合,输出包含n个通道的历史变化特征融合图f

merge

map(b);

33.步骤4.4.3.4,将历史变化特征融合图f

merge

map(b)输入到n分类的全连接网络fcn中,得到1*1*n的权重向量w;

34.将权重向量w与历史变化特征融合图f

merge

map(b)互卷积,得到加权后历史变化特征融合图f

merge

map(b)

′

;

35.步骤4.4.3.5,将加权后历史变化特征融合图f

merge

map(b)

′

与深层类间特征图f

deep

map(tb)采用串联concat()方式融合后,输入到卷积层conv

1*1

,得到增强历史信息特征图f

ehc

map(tb);

36.表达式为:

[0037][0038]

其中:为加权后历史变化特征融合图f

merge

map(b)

′

的系数;

[0039]

以增强历史信息特征图f

ehc

map(tb)作为卷积核,对深层车辆疑似特征图f

deep

map(z)进行卷积,输出目标车辆得分图scoremap;然后执行步骤4.5;

[0040]

步骤4.5,根据目标车辆得分图scoremap,在图像帧frm(t)中确定车辆结果框box(t),即为在图像帧frm(t)中追踪到的目标车辆s所在位置:

[0041]

步骤4.5.1,目标车辆得分图scoremap中的每个像素点均具有特征值,将特征值最高的点坐标,映射到图像帧frm(t)中,其在图像帧frm(t)的坐标即为图像帧frm(t)的待检测的车辆结果框box(t)的中心点坐标,表示为:p

t

(x

t

,y

t

);

[0042]

步骤4.5.2,将目标车辆得分图scoremap输入到包含两个3*3卷积核的卷积层conv6,得到偏移量特征图,此时偏移量特征图包含两个图层,分别用于预测车辆结果框宽度偏移量和车辆结果框高度偏移量;

[0043]

将偏移量特征图进行全局最大值池化,得到当前图像帧frm(t)车辆结果框box(t)与上一图像帧frm(t-1)车辆结果框box(t-1)的宽偏移量w

′

t

和高偏移量h

′

t

;

[0044]

步骤4.5.3,将上一图像帧frm(t-1)的车辆结果框box(t-1)宽w

t-1

与宽偏移量w

′

t

相加,得到当前图像帧frm(t)的车辆结果框box(t)的宽w

t

,将上一图像帧frm(t-1)的车辆结果框box(t-1)高h

t-1

与高偏移量h

′

t

相加,得到当前图像帧frm(t)的车辆结果框box(t)的

高h

t

,因此,在图像帧frm(t)中,以p

t

(x

t

,y

t

)作为中心点,宽为w

t

,高为h

t

,从而在图像帧frm(t)中确定车辆结果框box(t),即为在图像帧frm(t)中追踪到的目标车辆s所在位置;

[0045]

步骤5,将图像帧frm(t)作为图像帧frm(t-1),返回步骤4,对下一图像帧进行目标车辆s跟踪。

[0046]

优选的,步骤4.1具体方法为:

[0047]

步骤4.1.1,获取车辆结果框box(t-1)的中心点坐标p

t-1

(x

t-1

,y

t-1

),宽为w

t-1

,高为h

t-1

;

[0048]

获取车辆结果框box(t-2)的中心点坐标p

t-2

(x

t-2

,y

t-2

)、宽为w

t-2

,高为h

t-2

;

[0049]

步骤4.1.2,根据车辆结果框box(t-1)的中心点坐标和车辆结果框box(t-2)的中心点坐标,采用下式,计算车辆结果框box(t-1)和车辆结果框box(t-2)之间的坐标方位角α:

[0050][0051]

其中:

[0052]

若y

t-1-y

t-2

=0∨t=1,则α=90

°

;

[0053]

步骤4.1.3,采用下式,根据坐标方位角α确定车辆疑似区域的宽wz和高hz,增加目标运动方向的空间信息:

[0054][0055]

其中:

[0056]

四个方向north、south、east、west根据目标车辆的运动方向设置;

[0057]

北方向north={(0,40∪(320,360}

[0058]

南方向south={140

°

,220

°

}

[0059]

东方向east={50,130}

[0060]

西方向west={230,310}

[0061]

β1和β2分别为宽放大系数和高放大系数;

[0062]

步骤4.1.4,根据(x

t-1

,y

t-1

,wz,hz)在图像帧frm(t)截取车辆疑似区域,得到车辆疑似位置图z(t)。

[0063]

本发明提供的一种基于时空信息辅助的无人机视频车辆跟踪方法具有以下优点:

[0064]

本发明提供的一种基于时空信息辅助的无人机视频车辆跟踪方法,一旦检索到目标车辆后,采用时空信息辅助快速追踪方法,可准确快速的实现对目标车辆的持续实时追踪,能够有效避免车辆发现再丢失的问题,因此,本发明大大提高车辆检索追踪的应用价值,对于车辆检索追踪方向有着重要意义。

附图说明

[0065]

图1为本发明提供的一种基于时空信息辅助的无人机视频车辆跟踪方法的流程示意图;

[0066]

图2为本发明提供的增强历史信息特征图f

ehc

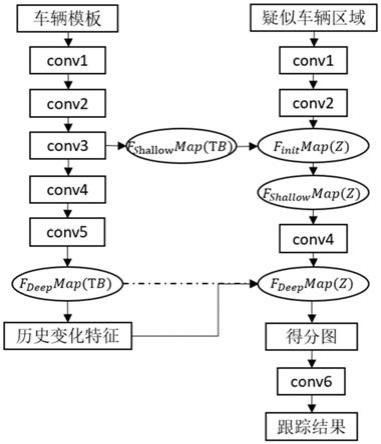

map(tb)的生成过程图。

具体实施方式

[0067]

为了使本发明所解决的技术问题、技术方案及有益效果更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅用以解释本发明,并不用于限定本发明。

[0068]

因此,针对无人机视频数据进行车辆跟踪还存在的诸多问题,本发明提供一种基于时空信息辅助的无人机视频车辆跟踪方法,先采用车辆区域搜索算法,利用目标上下文信息辅助定位目标车辆位置,同时减少搜索区域以外车辆对跟踪的影响;后通过历史目标车辆信息与目标车辆模板信息相融合,提高得分图中目标车辆的响应程度,对提高无人机视频下车辆跟踪的应用价值有着重要意义。

[0069]

参考图1,本发明提供一种基于时空信息辅助的无人机视频车辆跟踪方法,包括以下步骤:

[0070]

步骤1,确定需要跟踪的目标车辆s;

[0071]

例如,预先获得需要跟踪的目标车辆s的图片等。

[0072]

步骤2,无人机对地面进行拍摄,获得无人机视频数据;将无人机视频数据的每一视频帧作为图像帧;

[0073]

步骤3,按图像帧生成顺序,依次对各个图像帧进行车辆特征识别,判断每个图像帧是否包含目标车辆s,如果不包含,则继续对下一图像帧进行车辆特征识别,直到定位到包含目标车辆s的图像帧,然后执行步骤4;如果包含,则表明成功搜索到目标车辆s,执行步骤4;

[0074]

将首次识别到包含目标车辆s的图像帧设为第0图像帧frm(0),在第0图像帧frm(0)中确定包含目标车辆s的车辆结果框box(0),再一步确定车辆结果框box(0)的位置信息,包括:车辆结果框box(0)的宽w0,高h0以及中心点坐标p0(x0,y0);

[0075]

车辆结果框box(0)为第0图像帧frm(0)中包含目标车辆s的矩形框。

[0076]

本步骤中,无人机首先在大范围区域进行目标车辆s的搜索,直到搜索定位到目标车辆s。

[0077]

步骤4,从第0图像帧frm(0)搜索到目标车辆s开始,采用时空信息辅助的无人机视频车辆跟踪方法,对后续的图像帧frm(t)中的目标车辆s进行跟踪;其中,t=(1,2,

…

,end)表示当前图像帧距离第0图像帧frm(0)的帧数,end表示跟踪结束时图像帧的帧数;

[0078]

对于图像帧frm(t),采用以下方法,追踪到目标车辆s在图像帧frm(t)的位置:

[0079]

步骤4.1,在图像帧frm(t)中,确定车辆疑似位置区域,从而得到车辆疑似位置图z(t);

[0080]

具体的,以当前图像帧frm(t)为参考,则图像帧frm(t-1)表示为当前图像帧frm(t)的前一图像帧,图像帧frm(t-2)表示为图像帧frm(t-1)的前一图像帧;

[0081]

提取图像帧frm(t-1)的车辆结果框box(t-1)和图像帧frm(t-2)的车辆结果框box

(t-2)的位置信息,根据车辆结果框box(t-2)向车辆结果框box(t-1)方向的变化趋势,在图像帧frm(t)中,确定车辆疑似位置区域,从而得到车辆疑似位置图z(t);

[0082]

步骤4.1具体方法为:

[0083]

步骤4.1.1,获取车辆结果框box(t-1)的中心点坐标p

t-1

(x

t-1

,y

t-1

),宽为w

t-1

,高为h

t-1

;

[0084]

获取车辆结果框box(t-2)的中心点坐标p

t-2

(x

t-2

,y

t-2

)、宽为w

t-2

,高为h

t-2

;

[0085]

步骤4.1.2,根据车辆结果框box(t-1)的中心点坐标和车辆结果框box(t-2)的中心点坐标,采用下式,计算车辆结果框box(t-1)和车辆结果框box(t-2)之间的坐标方位角α:

[0086][0087]

其中:

[0088]

若y

t-1-y

t-2

=0∨t=1,则α=90

°

;

[0089]

步骤4.1.3,采用下式,根据坐标方位角α确定车辆疑似区域的宽wz和高hz,增加目标运动方向的空间信息:

[0090][0091]

其中:

[0092]

四个方向north、south、east、west根据目标车辆的运动方向设置;

[0093]

北方向north={(0,40∪(320,360}

[0094]

南方向south={140

°

,220

°

}

[0095]

东方向east={50,130}

[0096]

西方向west={230,310}

[0097]

β1和β2分别为宽放大系数和高放大系数;例如,β1和β2均为5。

[0098]

步骤4.1.4,根据(x

t-1

,y

t-1

,wz,hz)在图像帧frm(t)截取车辆疑似区域,得到车辆疑似位置图z(t)。

[0099]

步骤4.2,确定浅层类内特征图f

shallow

map(tb)和深层类间特征图f

deep

map(tb):

[0100]

将步骤3中通过车辆特征识别确定的车辆结果框box(0)作为目标车辆的车辆模板框tb,依次经过conv1、conv2、conv3卷积层,得到浅层类内特征图f

shallow

map(tb);将浅层类内特征图f

shallow

map(tb)继续输入到conv4、conv5卷积层,得到深层类间特征图f

deep

map(tb);

[0101]

本步骤中,以车辆结果框box(0)作为目标车辆的车辆模板框tb,原因为:特定车辆图像信息能够增加大量具体的车辆细节特征,包括车身损伤与粘贴物、以及外饰等等。因此当检测搜索网络发现目标车辆s后,截取无人机视角下该车辆图像的box(0),并将其设为目标模板,使网络能够获得更多目标车辆的特征。

[0102]

步骤4.3,对车辆疑似位置图z(t)进行特征提取,得到深层车辆疑似特征图f

deep

map(z):

[0103]

将步骤4.1得到的车辆疑似位置图z(t经过conv1、conv2卷积层提取特征,得到初始车辆疑似特征图f

init

map(z);然后,以浅层类内特征图f

shallow

map(tb)作为卷积核,对初始车辆疑似特征图f

init

map(z)进行卷积,得到浅层车辆疑似特征图f

shallow

map(z),进而加强初始车辆疑似特征图f

init

map(z)中目标车辆的响应程度;最后,将浅层车辆疑似特征图f

shallow

map(z)经过conv4卷积核进行特征提取,得到深层车辆疑似特征图f

deep

map(z);

[0104]

步骤4.4,获取目标车辆得分图scoremap:

[0105]

步骤4.4.1,判断当前帧数t是否大于历史车辆跟踪结果信息辅助帧数k,若t≤k,则执行步骤4.4.2;若t>k,则执行步骤4.4.3;

[0106]

例如,历史车辆跟踪结果信息辅助帧数k设置为5,当t≤k时,表明当前帧数t距离第0图像帧frm(0)较近,此时,只需要采用步骤4.4.2的方法,即可得到目标车辆得分图scoremap;当t>k,表明当前帧数t距离第0图像帧frm(0)较远,因此,为防止误追踪,提高追踪准确率,采用步骤4.4.3的方法,得到目标车辆得分图scoremap。

[0107]

步骤4.4.2,t≤k时,目标车辆得分图scoremap的获取方法:

[0108]

当t≤k时,以深层类间特征图f

deep

map(tb)作为卷积核,对深层车辆疑似特征图f

deep

map(z)进行卷积,输出目标车辆得分图scoremap,进而抑制深层车辆疑似特征图f

deep

map(z)中非车辆类别物体的响应程度;然后执行步骤4.5;

[0109]

步骤4.4.3:t>k时,目标车辆得分图scoremap的获取方法:

[0110]

步骤4.4.3.1,当t>k时,提取历史最接近k个车辆结果框,分别为:图像帧frm(t-1)的车辆结果框box(t-1),图像帧frm(t-2)的车辆结果框box(t-2)...,图像帧frm(t-k)的车辆结果框box(t-k);

[0111]

其中,图像帧frm(t-1)表示当前图像帧frm(t)的前一帧,

…

,图像帧frm(t-k)表示当前图像帧frm(t)的前第k帧;

[0112]

上述k个历史车辆结果框中不仅包含目标车辆的特征信息,还包含目标车辆在时间序列中的变化信息;

[0113]

步骤4.4.3.2,将车辆结果框box(t-1),车辆结果框box(t-2),...,车辆结果框box(t-k)依次输入conv1至conv5卷积层中,分别得到对应历史帧的深层类间特征图f

deep

map(b

t-1

),f

deep

map(b

t-2

),

…

,f

deep

map(b

t-k

);

[0114]

步骤4.4.3.3,将历史帧的深层类间特征图f

deep

map(b

t-1

),f

deep

map(b

t-2

),

…

,f

deep

map(b

t-k

)分别与步骤4.2得到的深层类间特征图f

deep

map(tb)相减,得到k个深层区别特征图;

[0115]

将k个深层区别特征图通过concat串联,得到历史变化特征图f

change

map(b);将历史变化特征图f

change

map(b)通过1*1*n的卷积核进行特征融合,输出包含n个通道的历史变化特征融合图f

merge

map(b);

[0116]

步骤4.4.3.4,将历史变化特征融合图f

merge

map(b)输入到n分类的全连接网络fcn中,得到1*1*n的权重向量w;

[0117]

将权重向量w与历史变化特征融合图f

merge

map(b)互卷积,得到加权后历史变化特征融合图f

merge

map(b)

′

;

[0118]

步骤4.4.3.5,将加权后历史变化特征融合图f

merge

map(b)

′

与深层类间特征图f

deep

map(tb)采用串联concat()方式融合后,输入到卷积层conv

1*1

,得到增强历史信息特征图f

ehc

map(tb);

[0119]

表达式为:

[0120][0121]

其中:为加权后历史变化特征融合图f

merge

map(b)

′

的系数;

[0122]

通过结合车辆的历史特征,缓解网络在跟踪过程出现的误跟踪问题。但过大时,会使网络过分依赖历史特征,忽略当前特征,造成目标漂移。作为一种优选方式,

[0123]

以增强历史信息特征图f

ehc

map(tb)作为卷积核,对深层车辆疑似特征图f

deep

map(z)进行卷积,输出目标车辆得分图scoremap;然后执行步骤4.5;

[0124]

目标车辆得分图scoremap不仅包含了完整的目标车辆s的特征信息,还融合历史帧中跟踪车辆的特征信息,缓解了无人机视野中由于目标车辆过小造成的特征匮乏和目标车辆自身旋转引起特征分布变化导致的特征响应弱的问题,使跟踪车辆在车辆特征图中的特征位置更显著。

[0125]

步骤4.4.3.3到步骤4.4.3.5参考图2,为增强历史信息特征图f

ehc

map(tb)的生成过程图。

[0126]

步骤4.5,根据目标车辆得分图scoremap,在图像帧frm(t)中确定车辆结果框box(t),即为在图像帧frm(t)中追踪到的目标车辆s所在位置:

[0127]

步骤4.5.1,目标车辆得分图scoremap中的每个像素点均具有特征值,将特征值最高的点坐标,映射到图像帧frm(t)中,其在图像帧frm(t)的坐标即为图像帧frm(t)的待检测的车辆结果框box(t)的中心点坐标,表示为:p

t

(x

t

,y

t

);

[0128]

步骤4.5.2,将目标车辆得分图scoremap输入到包含两个3*3卷积核的卷积层conv6,得到偏移量特征图,此时偏移量特征图包含两个图层,分别用于预测车辆结果框宽度偏移量和车辆结果框高度偏移量;

[0129]

将偏移量特征图进行全局最大值池化,得到当前图像帧frm(t)车辆结果框box(t)与上一图像帧frm(t-1)车辆结果框box(t-1)的宽偏移量w

′

t

和高偏移量h

′

t

;

[0130]

步骤4.5.3,将上一图像帧frm(t-1)的车辆结果框box(t-1)宽w

t-1

与宽偏移量w

′

t

相加,得到当前图像帧frm(t)的车辆结果框box(t)的宽w

t

,将上一图像帧frm(t-1)的车辆结果框box(t-1)高h

t-1

与高偏移量h

′

t

相加,得到当前图像帧frm(t)的车辆结果框box(t)的高h

t

,因此,在图像帧frm(t)中,以p

t

(x

t

,y

t

)作为中心点,宽为w

t

,高为h

t

,从而在图像帧frm(t)中确定车辆结果框box(t),即为在图像帧frm(t)中追踪到的目标车辆s所在位置;

[0131]

步骤5,将图像帧frm(t)作为图像帧frm(t-1),返回步骤4,对下一图像帧进行目标车辆s跟踪。

[0132]

通过以上方法,当在某个时刻拍摄到包含目标车辆s的第0图像帧frm(0),以第0图像帧frm(0)为起点,将第0图像帧frm(0)的车辆结果框box(0)作为车辆模板框tb,采用步骤4.4.2的方法对后续连续k张图像帧进行目标车辆s的追踪。对于后续连续k张图像帧,一方面,基于前两张图像帧确定本张图像帧中的车辆疑似位置区域,实现目标车辆疑似范围不断修正功能;另一方面,本张图像帧均与车辆结果框box(0)进行图像融合处理,由于车辆结果框box(0)是包含目标车辆s特征信息最完整的图像,并且,本张图像帧距离第0图像帧frm

(0)较近,所以,图像融合后得到的车辆特征图更能代表目标车辆s特征,实现本张图像帧中目标车辆s的准确定位追踪。

[0133]

但是,当追踪到距离第0图像帧frm(0)较远的图像帧时,例如,追踪到图像帧frm(6)时,由于其距离第0图像帧frm(0)较远,因此,需要采用本发明步骤4.4.3的方法,实现目标车辆s的准确定位追踪。通过步骤4.4.3,首先,由于无人机飞行过程中存在拍摄角度的变化,因此历史车辆结果框中包含与车辆模板框tb不同的特征,通过将历史车辆结果框的特征和车辆模板框tb的特征融合能够增强车辆模板框tb的特征表达,实现目标车辆尺度较小时的准确跟踪。其次,车辆结果框中会包含少量背景,而目标车辆周围的背景可以辅助定位,随着时间的推移,目标车辆所处的背景发生变化,车辆模板框tb中所包含的背景难以满足当前车辆的跟踪需求,但直接将历史帧的车辆结果框作为新的车辆模板极易引起模板污染导致跟踪失败,因此通过将车辆模板框tb和历史车辆结果框进行特征融合,既可以缓解车辆模板框tb不被污染,还可以获得车辆当前的背景信息,进而对车辆的准确定位跟踪起到辅助作用。最后,当目标车辆的运动方向发生改变时,车辆在车辆结果框中的特征分布会与车辆模板框tb中的特征分布不同。但基于运动的连贯性,此时车辆的特征分布会与其相近帧相似,通过将与当前帧相近历史帧的车辆结果框和车辆模板框tb的特征融合,使增强历史信息特征图中包含变化后的目标车辆特征分布,实现目标车辆s的长时间准确定位跟踪。

[0134]

本发明提供一种基于时空信息辅助的无人机视频车辆跟踪方法,先采用车辆区域搜索算法,利用目标上下文信息辅助定位目标车辆位置,同时减少搜索区域以外车辆对跟踪的影响;后通过历史目标车辆信息与目标车辆模板信息相融合,提高得分图中目标车辆的响应程度,对提高无人机视频下车辆跟踪的应用价值有着重要意义。

[0135]

以上所述仅是本发明的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。