1.本发明属于图像处理技术领域,涉及红外与可见光图像融合技术,尤其涉及基于稠密空洞卷积和双重注意机制的红外与可见光图像融合系统及方法。

背景技术:

2.图像融合是将两个或多个传感器获得的同一场景的图像信息进行有机整合。融合图像更有利于人类与机器视觉感知和其它图像处理任务,如:图像增强、人脸识别、特征提取和目标检测等。由于图像融合技术可以丰富图像的信息及视觉效果,因此,已被广泛应用于计算机视觉、医学成像、视觉监控、目标检测及追踪、摇杆测量等诸多领域。

3.红外图像由感知红外波段并将热辐射信息转换成灰度图像的红外传感器捕捉得到;红外图像对比度强,但分辨率低。可见光图像通过可见光传感器捕获丰富空间信息的反射光生成,所生成的可见光图像纹理细节较为丰富,但易受光照强度、浓雾等因素干扰。鉴于两者的互补特性,红外和可见光图像融合技术成为图像融合技术研究及应用中的一个重要发展方向。

4.图像融合旨在最大程度地整合多源异构信息,将来源不同的图像融合成内容丰富的单一图像。依据图像类别,图像融合可分为多模态图像融合、多曝光度图像融合、多聚焦图像融合和多光谱图像融合。红外和可见光图像融合是多模态图像融合领域的一个重要分支。近些年,已经提出了基于传统框架和基于学习的相关融合算法。从算法处理流程分析,红外和可见光图像融合基本可分为三个部分:异构特征信息提取、融合规则构造和融合图像重建。

5.典型的传统融合方法在空间域或变换域内测量像素或区域的活动水平,根据特定的融合规则实现图像融合。大致可以分为基于稀疏表示的方法、基于多尺度变换的方法、基于子空间的方法、基于显著性的方法以及混合方法。传统融合方法探究已久,尽管在融合性能和图像质量方面已经取得了令人瞩目的成果,但仍旧存在一些难点或缺点需要解决。首先,由于红外和可见光图像多样性的存在,现有传统方法中手工设计的融合规则一般会限制融合性能,一些融合图像会存在边缘伪影、特征重叠或细节缺失的现象[;其次,在融合效率方面,当前一些融合方法存在融合信息冗余、计算强度较高的缺点,不适于大批量高频次生成融合对象等实时性要求高的情形。

[0006]

最近,基于深度学习的方法在该领域有了一定的发展,它利用强大的非线性神经单元拟合目标图像,在融合性能上愈发吸引研究者目光。基于学习的图像融合方法基本采用卷积神经网络,典型网络结构体现为编码器模型和生成对抗器模型。前者通过参数可学习的滤波器提取源图像的代表性特征,完成特征级图像重构;后者利用生成器和对抗器间的对抗博弈学习源图的强度、纹理和对比度。这些方法虽然在一定程度上达到了一些不错性能,但它们要么提取单一尺度特征,要么通过下采样方式提取多尺度特征,在融合阶段源图像部分信息丢失,从而影响图像融合质量。而且,在融合策略方面,采用的规则诸如取平均、取最大或引入基于softmax算子的注意力机制,但均不具备广泛的自适应图像融合能

力。

技术实现要素:

[0007]

针对传统图像融合技术中存在的融合图像质量差、效率低以及缺少自适应能力等问题,本发明目的旨在提供一种红外与可见光图像融合系统及方法,基于稠密空洞卷积和双重注意机制,能够在获取密集多尺度特征的同时,实现对特征的自适应细化调节,最终重建出高质量的融合图像。

[0008]

本发明的发明思路为:首先基于稠密空洞卷积原理,进行特征提取,获得密集的多尺度特征;随后基于双重注意机制,自适应地细化聚合金字塔形特征;最后结合上述传递的特征信息及来自跳转连接的补偿信息联合起来重建,生成高质量的融合图像。

[0009]

基于上述发明思路,本发明提供的红外与可见光图像融合系统,其包括分别用于提取红外图像和可见光图像特征的多尺度特征提取单元、位于多尺度特征提取单元后的特征筛选单元和图像重构单元;

[0010]

所述多尺度特征提取单元,用于分别对红外图像和可见光图像进行多层空洞卷积处理得到红外图像和可见光图像对应的多尺度特征;

[0011]

所述特征筛选单元,基于双重注意机制,对多尺度特征提取单元提取的多尺度特征进行筛选;

[0012]

所述图像重构单元,用于将筛选后的红外图像特征和可见光图像特征进行融合。

[0013]

上述多尺度特征提取单元,包括输入层和膨胀率依次递增的多层级联的稠密空洞卷积模块;所述输入层用于分别对红外图像和可见光图像进行原始特征提取;所述稠密空洞卷积模块用于对输入的特征进行空洞卷积处理;后一层稠密空洞卷积模块的输入由当前层之前的所有稠密空洞卷积模块的输出及输入层提取的原始特征在通道维度上进行拼接得到。输入层可以采用二维卷积层,用于将红外图像/可见光图像转换到特征空间。多层级联的稠密空洞卷积模块用于聚集多尺度特征。相比于池化操作,空洞卷积在保持特征图分辨率不变的同时能够增加感受野。借助于稠密网络densenets连接,小膨胀率的空洞卷积层的输出会馈送到膨胀率更大的空洞卷积层,这些来自不同采样尺度的特征图和通过输入层获得的原始特征图统一在通道维度进行拼接并充当后一层的输入,这种堆叠空洞卷积的方式解决了单一空洞卷积在像素上存在采样稀疏的问题,能够得到密集的尺度多样的特征金字塔。

[0014]

为方便阐释,本发明把第l层稠密空洞卷积模块的输出表示为y

l

,可以表示为如下公式:

[0015][0016]

式中,[y

l-1

,y

l-2

,

…

,y0]表示拼接第l层的前面所有稠密空洞卷积模块和输入层的输出,值得注意的是,作为输入层的卷积层(其膨胀率d=1)的输出表示为y0。表示卷积核大小为k,膨胀率为d

l

的第l层空洞卷积算子,可简述为:

[0017]

[0018]

式中,(

·

)表示某个像素信息,x表示稠密空洞卷积模块的输入,w[n]表示卷积窗的第n个参数。

[0019]

第l层稠密空洞卷积模块的感受野r可表述为:

[0020][0021]

本发明的各稠密空洞卷积模块采样尺度上下限range为:

[0022]

range=[r

min

,r

max

]

ꢀꢀꢀ

(4)

[0023]

式中,r

min

取第一层稠密空洞卷积网络的感受野r

max

取各层稠密空洞卷积模块感受野之和,即

[0024]

这样的采样尺度范围的分布可以保证网络学习到多尺度上的特征分布,使融合结果与源图更具有结构层次上的相似性。另外,虽然用于红外图像和可见光图像特征提取的多尺度特征提取单元在网络结构上一致,但在训练时依据红外图像和可见光图像各自独立的特性会使两个相应的多尺度特征提取单元得到不同的参数分布。

[0025]

上述特征筛选单元,许多视觉任务应用注意力机制来加权视觉场景中的感兴趣区域。红外和可见光图像融合的目标是同时保留视觉细节和显著的热辐射目标。通过多尺度特征提取单元获得的密集特征具有不同的重要信息,为了合理利用各尺度特征,本发明在多尺度特征提取单元后面引入级联的通道注意力和空间注意力机制,主要由两个连续的eca net模块和空间子模块组成特征筛选单元,采用不降维的局部跨信道交互策略和自适应选择一维卷积核大小的方法实现通道上的注意选择,而且所述eca net模块和空间子模块的输入数据补偿连接到输出端相加,具体为:将提取的多尺度特征输入到eca net模块,eca net模块的输出值与eca net模块的输入值相加后输入空间子模块;空间子模块的输出值与输入值相加,其结果作为特征筛选单元的最终输出。所述eca net包括依次设置的全局平均池化层,一维卷积层和sigmoid函数;所述空间子模块包括依次设置的并联的最大池化层和均值池化层,二维卷积层,sigmoid函数。与此同时,把两种注意机制的输入补偿连接到输出端相加,由于通过卷积的注意机制在网络流动过程中存在信息丢失,因此这种做法一方面可以保证原始注意分支特征筛选的能力,一方面能弥补网络加深导致显著特征丢失的情况。

[0026]

上述图像重构单元包括若干连续的卷积层。本发明中可以采用若干连续的结构相同的卷积层。每个卷积层后依次设置批量归一化模块和relu函数。最后一层卷积层输出融合图像。虽然本发明提供的图像融合系统不包含上采样和下采样,但卷积和滤波效果或多或少会导致源图像纹理细节的丢失。因此,本发明中将多尺度特征提取单元除最后一层稠密空洞卷积模块以外其他稠密空洞卷积模块的通道维度上拼接输出(即当前层、当前层之前的所有稠密空洞卷积模块的输出及输入层的输出在通道维度上拼接得到)跳跃连接引入图像重构单元对称的卷积层,以传输更有用的潜在纹理特征信息进行重建。这里,采用的对称的跳跃连接方式,例如倒数第二层稠密空洞卷积模块的通道维度上拼接输出跳跃连接至图像重构单元的第二层卷积层,倒数第三层稠密空洞卷积模块的通道维度上拼接输出跳跃连接至图像重构单元的第三层卷积层,以此类推。考虑到红外图像和可见光图像的不同特征,本发明设计了一个前馈算子来对稠密空洞卷积模块的通道拼接输出进行传播特征选择,可以表示为:

[0027][0028]

式中,φ表示通过元素选择平均方式进行操作;和分别表示可见光图像和红外图像中第l层稠密空洞卷积模块的通道维度上拼接输出的特征图,表示对应稠密空洞卷积模块的补偿特征。这些跳跃连接加快了该框架的收敛速度,使图像融合的性能更加令人满意。

[0029]

上述红外与可见光图像融合系统,还包括参数优化单元,用于依据图像重构单元得到的红外图像和可见光图像的融合图像,按照损失函数获取损失值,再基于梯度下降算法对系统参数进行优化。损失函数能够确定网络训练的拟合方向。在本发明提供的损失函数中,设置了两个损失项:像素损失l

pixel

和结构相似性损失l

ssim

。像素损失项确保融合图像包含源图像的强度信息,结构相似性损失项确保融合图像和源图像在亮度、结构和对比度三个级别上的内容一致性。这两个损失项共同制约了网络的学习方向,弥补了单一损失项的不足。

[0030]

损失函数公式如下:

[0031]

l

total

=λ1l

pixel

l

ssim

ꢀꢀꢀꢀ

(6)

[0032]

式中,λ1表示等系数,用于平衡各损失权重,l

pixel

表示融合图像和源图间的像素差异,l

ssim

表示融合图像和源图间的结构相似性。

[0033]

l

pixel

按照以下公式确定:

[0034][0035]

式中,i

ir

、i

vis

和o分别表示输入红外图像矩阵、可见光图像矩阵和融合图像矩阵,w

ir

表示用于动态衡量i

ir

损失部分的自适应图像权重,表示f范数的平方;

[0036]

l

ssim

按照以下公式确定:

[0037]

l

ssim

=w

ir

[1-ssim(o,i

ir

)] (1-w

ir

)[1-ssim(o,i

vis

)]

ꢀꢀꢀ

(8)

[0038]

式中,ssim(

·

)计算图像间的结构相似性(参见wang z,bovik a c,sheikh h r,et al.image quality assessment:from error visibility to structural similarity[j].ieee transactions on image processing,2004,13(4):600-612)。

[0039]

对于评估每个源图像的权重,首要考虑的是在具有较高权重的图像中保留较多的信息。它体现在可见光图像和红外图像中噪声较小的区域、纹理信息丰富的区域以及像素强度突出的区域。图像的噪声、纹理与图像质量紧密相关,而像素强度表现的是图像的信息量,因此,本发明综合考虑图像的信息量和质量,在训练过程中动态计算每一对红外图和可见光图的信息保留度权重。

[0040]

本发明使用图像二维熵来度量其信息量,公式如下:

[0041][0042]

式中,(j,m)表示一个二元组,由表示图像中第j个像素位置的灰度值及其邻域内m个像素的灰度均值组成,二元组通过矩形窗口的采样形式在图像上获取,p

jm

表示(j,m)在图像中获取的所有二元组内出现的频率比,size=c*h*w表示总像素个数,c表示通道数,h表示图像的高,w表示图像的宽;窗口大小可以根据图像尺寸来设定,m的取值为矩形窗口内所

有像素点数减1。与一维熵相比,二维熵可以突出反映图像中像素位置的灰度信息和像素邻域内灰度分布的综合特征。在图像质量方面,本发明采用无参考图像质量评估器brisque(参见mittal a ,moorthy a k,bovik a c.no-reference image quality assessment in the spatial domain[j].image processing,ieee transactions on,2012,21(12):p.4695-4708),把图像的质量好坏按分数分为0-100,数字越大代表图像质量越差。本发明中,以iqa表示图像质量,通过取无参考图像质量评估器brisque得分的倒数,并将其扩大至二维熵值的同一数值量级得到。因此,自适应图像权重w

ir

可以表述为:

[0043][0044]

其中,en

ir

和iqa

ir

分别表示图像对中的红外图像的信息量和质量,k取ir(红外)或vis(可见光),λ2为给定系数,本发明中取值为100。w

ir

表示图像对中的红外图像的信息量和质量占图像对总信息量和质量的比重,最终生成的权重w

ir

影响损失项来约束网络逼近最佳融合性能学习。

[0045]

本发明进一步提供了上述一种红外与可见光图像融合方法,其包括以下步骤:

[0046]

s1分别对红外图像和可见光图像进行多层空洞卷积处理得到红外图像和可见光图像对应的多尺度特征;

[0047]

s2基于双重注意机制,对提取的多尺度特征进行筛选,从而分别对红外图像和可见光图像特征权重进行调整;

[0048]

s3将步骤s2筛选出的红外图像特征和可见光图像特征进行融合处理,输出红外图像和可见光图像的融合图像。

[0049]

上述步骤s1中,对红外图像和可见光图像处理的过程相同,目的是基于不同采样尺度来提取特征,具体包括以下分步骤:

[0050]

s21分别对红外图像和可见光图像进行特征提取,得到红外图像和可见光图像的原始特征;

[0051]

s22分别对提取的红外图像和可见光图像原始特征进行多层空洞卷积处理,得到相应的多尺度特征;后一层空洞卷积处理的输入由当前空洞卷积处理之前的所有空洞卷积处理输出及红外图像或可见光图像原始特征在通道维度上进行拼接得到。

[0052]

上述步骤s2中,目的是对提取的多尺度特征中筛选出具有重要信息的特征。所述双重注意机制包括通道注意力机制和空间注意力机制,基于通道注意力机制和空间注意力机制处理的输入数据补偿相加到输出数据。

[0053]

上述步骤s3中,目的是对经筛选后的特征进行融合得到红外图像和可见光图像特征的融合图像。具体实现方式为:将步骤s2筛选出的红外图像特征和可见光图像特征经多次连续卷积处理得到融合图像。为了提升图像融合效果,减少图像纹理细节丢失,进一步融合过程中,将步骤s1中除最后一层空洞卷积处理之外的其他各级空洞卷积处理结果拼接输出跳跃连接引入本步骤对称的卷积处理中。

[0054]

当对前面给出的红外与可见光图像融合系统进行训练时,除了将利用采集的红外图像以及相应的可见光图像构建训练集输入到红外与可见光图像融合系统按照上述步骤获取融合图像外,还进一步包括以下步骤:

[0055]

s4基于步骤s3得到的融合图像,按照以下损失函数获取损失值,并基于梯度下降

算法对系统参数进行优化;

[0056]

l

total

=λ1l

pixel

l

ssim

ꢀꢀꢀꢀ

(6)

[0057]

式中,λ1表示等系数,用于平衡各损失权重,l

pixel

表示融合图像和源图(包括红外图像和可见光图像)间的像素差异,l

ssim

表示融合图像和源图(红外图像和可见光图像)间的结构相似性。

[0058]

训练过程中,重复步骤s1-s4,直至系统收敛,即使图像融合系统表现收敛至良好且稳定(即损失值趋于稳定)的水平。

[0059]

为了提升对系统的训练效果,可以通过裁剪(例如上、下、左、右、中心等裁剪方式),垂直旋转和/或水平翻转等方式对采集的红外图像以及相应的可见光图像进行预处理,来实现数据扩增。将预处理后的图像转换至灰度空间,以此得到的图像数据来构建训练集。

[0060]

上述l

pixel

和l

ssim

具体确定方法如前所述。

[0061]

本发明可以采用本领域已经披露的常规优化算法对图像融合系统的网络参数进行优化。本发明中基于梯度下降算法寻找最优解,采用的是adam算法。

[0062]

综上所述,本发明借鉴多尺度上下文信息聚集的方法,设计了一个稠密连接的空洞卷积模块提取多尺度特征,该特征提取器在不损失图像分辨率的条件下获得大范围的感受野并最终生成密集的金字塔状特征。在特征融合阶段,本发明舍去了繁琐的手工融合规则,转而采用eca net模块和空间子模块的注意力级联模块,从大量数据中学习获得各尺度特征重要权重,接着被增强或被抑制的特征拼接在同一空间维度进行图像重构。双重注意力模块有选择性的强调或削弱特征图的局部或全局信息,在一定程度上促进了网络的信息流通,加快收敛速度。在细节保留方面,本发明从特征提取模块中引出两个以上跳跃连接并经信息前馈算子传递到对应的图像重构卷积层,以补偿信息损失。在另一方面,考虑到不同红外和可见光图像所包含的信息量不同,本发明设计了一种混合图像二阶熵和图像无参质量评估的信息保留度策略,用以生成损失权重指导网络拟合方向。

[0063]

本发明提供的红外与可见光图像融合系统及方法具有以下有益效果:

[0064]

(1)本发明支持任意尺度图像输入,首先通过主要由多层级联的稠密空洞卷积模块提取密集多尺度特征,然后通过基于双重注意力机制的eca net模块和空间子模块进行特征筛选,再由若干卷积层组成的图像重构单元完成图像重构,从而得到细节清晰的红外和可见光融合图像。

[0065]

(2)本发明在tno和vifb两组公共红外和可见光图像数据集上进行了定性和定量的实验,并且在相应的评价指标上具有优异的表现。

[0066]

(3)本发明将双分支特征提取网络和附加前馈算子的跳跃连接结合,特征提取网络的输入是红外和可见图对,跳跃连接支路经前馈算子有选择性地保留红外和可见光图像的信息传递量,网络更容易收敛。

[0067]

(4)本发明提供了一种新的综合评估图像质量的信息度保留策略,训练阶段能够动态地决定图像融合的方向,从而是该图像融合系统泛化能力更强,白天和晚上场景均适用。

附图说明

[0068]

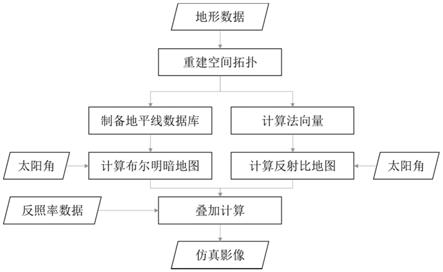

图1为本实施例提供的基于稠密空洞卷积和双重注意机制的红外与可见光图像融合系统的结构示意图。

[0069]

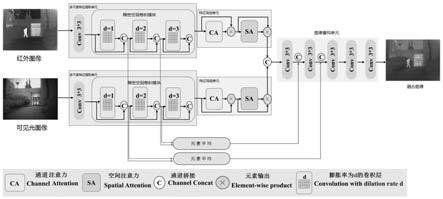

图2为本实施例提供的特征筛选单元结构示意图;k

′

表示自适应卷积窗口大小,f

ep

(

·

),f

mp,ap

(

·

)依次表示全局池化运算和并联的最大池化、平均池化运算,σ表示sigmoid运算,add表示相加运算。

[0070]

图3为msvd、gtf、fpde、tif、fusiongan、ganmcc、u2fusion和实施例2提供的图像融合系统对tno数据集上的kaptein_1123进行红外图像和可见光图像融合得到的融合图像;其中包含背景标记和显著目标标记(人),下方为背景标记区域的放大图。

[0071]

图4为msvd、gtf、fpde、tif、fusiongan、ganmcc、u2fusion和实施例2提供的图像融合系统对tno数据集上的street进行红外图像和可见光图像融合得到的融合图像;其中包含背景标记和显著目标标记(人),下方为背景标记区域的放大图。

[0072]

图5为msvd、gtf、fpde、tif、fusiongan、ganmcc、u2fusion和实施例2提供的图像融合系统对tno数据集上随机选择的21对图像进行测试结果;其中,箱型线框内三角形表示均知,横线表示中位数。

[0073]

图6msvd、gtf、fpde、tif、fusiongan、ganmcc、u2fusion和实施例2提供的图像融合系统对vifb数据集中的running序列进行红外图像和可见光图像融合得到的融合图像;其中包含背景标记和显著目标标记(人),下方为背景标记区域的放大图。

[0074]

图7为msvd、gtf、fpde、tif、fusiongan、ganmcc、u2fusion和实施例2提供的图像融合系统对vifb数据集上的21对图像进行测试结果;其中,箱型线框内三角形表示均知,横线表示中位数。

[0075]

图8为ours w/o d、ours w/o a和ours图像融合系统分别对tno数据集上的两对带吉普车和球的士兵图像进行红外图像和可见光图像融合得到的融合图像;其中包含背景标记和显著目标标记(车窗里边的人),下方为背景标记区域的放大图。

[0076]

图9为基于vot-rgbt2019基准的视频序列人脸跟踪结果;从上到下的三排分别是红外线、rgb和融合图像;每列显示该序列帧的跟踪状态,其中地面实况、红外、rgb和融合图像的结果用不同大小的框标记,通过放大可以获得更好的视图。

[0077]

融合评估策略

[0078]

图像评估是一个复杂的问题,不同的图像类型需要不同的图像评估策略。迄今为止,还没有专门的评价指标应用于红外和可见光图像融合领域,因此,为了客观的反映融合图像质量,本发明通过定性和定量的评估策略评价图像质量。其中,定性评估的方式采取同state-of-the-art方法相比较,从符合人类视觉感知的角度给出融合图像的质量描述。定量评估的方式应用包括结构相似性ssim、视觉信息保真度vif、差异相关性之和scd和空间频率sf在内的4项指标,从图像内容、视觉质量到频域等多种角度综合评估图像质量。这4项指标数值越大,融合图像性能越好。

[0079]

(1)视觉信息保真度(vif)度量测量融合图像的信息保真度,其与人类视觉系统一致,具体参见(参见y.han,y.cai,y.cao,and x.xu,a new image fusion performance metric based on visual information fidelity,inf.fusion,vol.14,no.2,pp.127

–

135,apr.2013)。

[0080]

(2)ssim由亮度、结构和对比度三部分相乘组成,通过模拟图像损失和失真计算图像间的结构相似性:

[0081][0082]

其中,x,f分别对应于图像x,f在滑动窗口内的图像块,σ

xf

和σ

x

,σf分别为对应滑窗内的协方差和方差,u

x

,uf分别为对应滑窗内的均值,而c1、c2、c3为参数,确定方法参见wang z,bovik a c,sheikh h r,et al.image quality assessment:from error visibility to structural similarity[j].ieee transactions on image processing,2004,13(4):600-612。这里用x表示红外和可见光图像,f表示融合图像,取红外图像和可见光图像分别与融合图像的结构相似性两项的平均值作为评估指标ssim。

[0083]

(3)scd衡量从源图像传输到融合图像的信息量,是一种相关性的度量指标,

[0084]

scd定义为:

[0085]

scd=r(d1,s1) r(d2,s2)

ꢀꢀꢀꢀꢀ

(12)

[0086]

其中,r(

·

)表示相关系数,可通过下式计算得到:

[0087][0088]

其中,s1、s2分别表示红外图像和可见光图像,d1、d2均表示融合图像,dk(i,j)和sk(i,j)表示图像中的任一像素点,分别表示dk,sk的平均像素值。

[0089]

(4)sf度量图像的梯度分布,可有效揭示图像的纹理和细节,定义如下:

[0090][0091]

其中,

[0092]

表示f(i,j)表示融合图像,m、n分别表示融合图像高和宽。

具体实施方式

[0093]

结合附图对本发明各实施例的技术方案进行清楚、完整的描述,显然,所描述实施例仅仅是本发明的一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动的前提下所得到的所有其它实施例,都属于本发明。

[0094]

实施例1

[0095]

本实施例提供的基于稠密空洞卷积和双重注意机制的红外与可见光图像融合系统,如图1所示,其包括分别用于提取红外图像和可见光图像特征的两个多尺度特征提取单元、位于多尺度特征提取单元后的特征筛选单元和图像重构单元;

[0096]

多尺度特征提取单元,用于分别对红外图像和可见光图像进行多层空洞卷积处理得到红外图像和可见光图像对应的多尺度特征;

[0097]

特征筛选单元,基于双重注意机制,对多尺度特征提取单元提取的多尺度特征进行筛选;

[0098]

图像重构单元,用于将筛选后的红外图像特征和可见光图像特征进行融合。

[0099]

如图1所示,多尺度特征提取单元包括输入层和膨胀率依次递增的三层级联的稠密空洞卷积模块,输入层用于分别对红外图像和可见光图像进行原始特征提取;稠密空洞卷积模块用于对输入的特征进行空洞卷积处理。本实施例以二维卷积层a作为输入层,二维卷积层a的卷积核大小3*3。三层级联的稠密空洞卷积模块的膨胀率依次为d=1,2,3,其卷积核大小固定适用k=3,每层卷积个数都为16,填充padding值和对应卷积层的膨胀率相同以保证输出特征图分辨率不变。后一层稠密空洞卷积模块的输入由当前层之前的所有稠密空洞卷积模块的输出及卷积层a的输出在通道维度上拼接得到。

[0100]

本实施例把第l层稠密空洞卷积模块的输出表示为y

l

,可以表示为如下公式:

[0101][0102]

式中,[y

l-1

,y

l-2

,

…

,y0]表示拼接第l层的前面所有稠密空洞卷积模块和卷积层a的输出,值得注意的是,卷积层a的输出表示为y0。表示卷积核大小为k,膨胀率为d

l

的第l层空洞卷积算子,可简述为:

[0103][0104]

式中,(

·

)表示某个像素信息,x表示稠密空洞卷积模块的输入,w[n]表示卷积窗的第n个参数。

[0105]

第l层稠密空洞卷积模块的感受野r可表述为:

[0106][0107]

本发明的特征提取器采样尺度上下限range为:

[0108][0109]

式中,r

min

取第一层稠密空洞卷积网络的感受野r

max

取各层稠密空洞卷积模块感受野之和,即

[0110]

采样尺度范围[3,15]的分布可以保证多尺度特征提取单元学到多尺度上的特征分布,使融合结果与源图更具有结构层次上的相似性。另外,尽管双分支特征提取线路在网络结构上一致,但在训练时依据红外和可见光图像各自独立的特性会得到不同的参数分布。

[0111]

如图1及图2所示,特征筛选单元包括连续的eca net模块和空间子模块。eca net模块包括依次设置的全局平均池化层,一维卷积层b和sigmoid函数。空间子模块包括依次设置的并联的最大池化层和均值池化层,二维卷积层c,sigmoid函数。全局平均池化层用于对输入的特征数据进行全局池化运算(图2中用f

gp

(

·

)表示)。一维卷积层b的卷积核大小为3,一维卷积层b输出的特征数据与eca net模块的输入数据经sigmoid运算(图2中用σ表示)后与eca net模块的输入数据相加得到空间子模块的输入数据。空间子模块的最大池化层和均值池化层并联设置,用于对eca net模块输出的特征数据依次进行最大池化和平均池化运算(图2中用f

mp,ap

(

·

)表示)。最大池化层和均值池化层输出在通道维度上拼接在一起形成二维卷积层c的输入,二维卷积层c的输出与eca net模块输出数据经sigmoid运算(图2

中用σ表示)后与eca net模块输出数据相加得到空间子模块的输出数据。

[0112]

如图1所示,图像重构单元包括连续的五个二维卷积层(卷积层d~卷积层h,每个卷积层的卷积核大小为3*3,每层的填充和步长均设置为1。每个卷积层后依次设置批量归一化模块和relu函数。本实施例中,将前两层稠密空洞卷积模块的通道拼接输出的两个跳跃连接引入图像重构单元特征重建部分的第二层和第三层(其中第一层稠密空洞卷积模块(即倒数第三层稠密空洞卷积模块)的通道拼接输出跳跃连接至图像重构单元的卷积层f;第二层稠密空洞卷积模块(即倒数第二层稠密空洞卷积模块)的通道拼接输出跳跃连接至图像重构单元的卷积层e),以传输更有用的潜在纹理特征信息进行重建。考虑到红外图像和可见光图像的不同特征,本实施例设计了一个前馈算子来选择传播特征,可以表示为:

[0113][0114]

式中,和分别表示可见光图像和红外图像中第l层稠密空洞卷积模块的通道拼接输出的特征图像素矩阵,表示对应稠密空洞卷积模块的补偿特征,φ表示通过元素选择平均方式进行操作,这里是指对和对应位置的像素值相加再取平均。

[0115]

实施例2

[0116]

本实施例中采用的训练用数据来自flir数据集中的代表性场景,总计221对(参见xu h,ma j,jiang j,et al.u2fusion:a unified unsupervised image fusion network[j].ieee transactions on pattern analysis and machine intelligence,2020)。

[0117]

本实施例提供了实施例1中基于稠密空洞卷积和双重注意机制的红外与可见光图像融合系统的训练方法,所使用的训练集,按照以下步骤得到:

[0118]

s01通过裁剪(例如上、下、左、右和中心等裁剪方式),垂直旋转和水平翻转方式对图像进行预处理,来实现数据扩增得到4420对。

[0119]

s02将预处理后的图像转换至灰度空间,图像转化为灰度图像;

[0120]

s03通过常规最近邻插值法将图像裁剪至128*128大小。

[0121]

然后利用得到的训练集按照以下步骤对图像融合系统进行训练:

[0122]

s1将训练集中红外图像和可见光图像分别输入至两个多尺度特征提取单元,利用两个多尺度特征提取单元分别对红外图像和可见光图像进行多尺度特征提取。

[0123]

本步骤包括以下分步骤:

[0124]

s11利用输入层对输入的红外图像/可见光图像进行特征提取,得到红外图像/可见光图像原始特征;

[0125]

s12将提取的原始特征发送至膨胀率依次递增的三层级联的稠密空洞卷积模块,进行多尺度特征提取;后一层稠密空洞卷积模块的输入由当前层之前的所有稠密空洞卷积模块的输出及输入层的输出在通道维度上拼接得到;所有稠密空洞卷积模块的输出以及输入层的输出通道拼接得到最终输出的多尺度特征。

[0126]

s2利用特征筛选单元的eca net模块和空间子模块依次对从红外图像/可见光图像提取的多尺度特征进行筛选,从而分别对红外图像和可见光图像特征权重进行调整。

[0127]

本步骤具体为:将提取的多尺度特征输入到eca net模块,eca net模块的输出值与eca net模块的输入值相加后输入空间子模块;空间子模块的输出值与输入值相加,其结果作为特征筛选单元的最终输出。

[0128]

s3利用图像重构单元将步骤s2筛选出的红外图像特征和可见光图像特征进行融合处理,输出红外图像和可见光图像的融合图像。

[0129]

本步骤具体为:将步骤s2筛选出的红外图像特征和可见光图像特征输入至图像重构单元的五个连续的卷积层处理。在处理过程中,将第二层稠密空洞卷积模块(即倒数第二层稠密空洞卷积模块)的通道拼接输出跳跃连接至图像重构单元的卷积层e,与卷积层d的输出在通道维度上进行拼接,得到卷积层e的输入数据;第一层稠密空洞卷积模块(即倒数第三层稠密空洞卷积模块)的通道拼接输出跳跃连接至图像重构单元的卷积层f,与卷积层e的输出在通道维度上进行拼接,得到卷积层f的输入数据。

[0130]

s4基于步骤s3得到的融合图像,按照以下损失函数获取损失值,并基于梯度下降算法对系统参数进行优化;

[0131]

l

total

=λ1l

pixel

l

ssim

ꢀꢀꢀꢀ

(6)

[0132]

式中,λ1表示等系数,l

pixel

表示融合图像和源图间的像素差异,l

ssim

表示融合图像和源图间的结构相似性。

[0133]

l

pixel

按照以下公式确定:

[0134][0135]

式中,i

ir

、i

vis

和o分别表示输入红外图像矩阵、可见光图像矩阵和融合图像矩阵,w

ir

表示用于动态衡量i

ir

损失部分的权重,表示f范数的平方。

[0136]

l

ssim

按照以下公式确定:

[0137]

l

ssim

=w

ir

[1-ssim(o,i

ir

)] (1-w

ir

)[1-ssim(o,i

vis

)]

ꢀꢀꢀ

(8)

[0138]

式中,ssim(

·

)计算图像间的结构相似性(参见wang z,bovik a c,sheikh h r,et al.image quality assessment:from error visibility to structural similarity[j].ieee transactions on image processing,2004,13(4):600-612)。

[0139]

自适应图像权重w

ip

可以表述为:

[0140][0141]

其中,en

ir

和iqa

ir

分别表示图像对中的红外图像的信息量和质量,k取ir或vis,λ2为给定系数,取值为100。

[0142]

本实施例使用图像二维熵来度量其信息量,公式如下:

[0143][0144]

式中,(j,m)表示一个二元组,由图像中第j个像素位置的灰度值及其邻域内m个像素的灰度均值组成,二元组通过矩形窗口的采样形式在图像上获取,p

jm

表示(j,m)在图像中获取的所有二元组内出现的频率比,size=c*h*w表示总像素个数,c表示通道数,h表示图像的高,w表示图像的宽;本实施例中,窗口大小为3*3,m=8。在图像质量方面,本实施例采用无参考图像质量评估器brisque(参见mittal a,moorthy a k,bovik a c.no-reference image quality assessment in the spatial domain[j].image processing,ieee transactions on,2012,21(12):p.4695-4708),把图像的质量好坏按分数分为0-100,数字越大代表图像质量越差。本实施例中,以iqa表示图像质量,通过取无参考图像质量评估器

brisque得分的倒数、并将其扩大至二维熵值的同一数值量级得到。

[0145]

本步骤中,采用adam算法对图像融合系统的参数进行优化,学习率lr为1

×

10-4

,该算法中存在两个参数α和β,其值为α=25、β=0.1。具体优化过程如下:

[0146]

1、

[0147]

2、

[0148]

其中,第一项表示损失函数对图像融合系统的参数θ求导取得梯度,第二项表示利用adam算法和梯度来对参数θ进行优化更新,lr表示学习率。

[0149]

重复步骤s1-s4,直至系统收敛,即使图像融合系统表现收敛至良好且稳定(即损失值趋于稳定)的水平。

[0150]

应用例1

[0151]

将tno数据集中的kaptein_1123和street(参见toet a.tno image fusion dataset.figshare.data,2014.https://figshare.com/articles/tn image fusion dataset/1008029)输入到实施例2训练好的图像融合系统按照以下步骤进行操作:

[0152]

s1将待融合的红外图像和可见光图像分别输入至两个多尺度特征提取单元,利用两个多尺度特征提取单元分别对红外图像和可见光图像进行多尺度特征提取;

[0153]

s2利用特征筛选单元对从红外图像和可见光图像提取的多尺度特征通过特征筛选单元进行筛选;

[0154]

s3利用图像重构单元将步骤s2筛选出的红外图像特征和可见光图像特征进行融合处理,输出红外图像和可见光图像的融合图像。

[0155]

上述步骤s1-s3与实施例2中图像融合系统训练方法中的步骤s1-s3操作相同,这里不再赘述。

[0156]

最终所得融合图像如图3和图4所示。

[0157]

为了综合评估本发明获取的融合图像效果,进一步采用基于多尺度变化的方法msvd、基于子空间分解的方法fpde、基于显著性目标的方法tif、基于全变差的方法gtf以及3种基于深度学习的方法fusiongan、ganmcc和u2fusion对tno数据集中的kaptein_1123和street进行红外图像和可见光图像的融合,融合图像如图3和图4所示。

[0158]

从图3中可以看出,fusiongan和gtf产生的融合图像整体风格偏暗,具有较多的红外图像底色,尤其在放大标记区域,丢失了可见光图像对应区域内的亮度信息。方法msvd、fpde、u2fusion和ganmcc产生的融合图像引入了不同程度的噪声,放大标记区域可见一斑(最好放大观察),这样的噪声最终影响图像质量。相比而言,tif方法产生的融合图像具有很高的显著目标(即人)保留度,但人周围存在黑色伪影,此外放大标记区域内的两颗树间存在一小块亮斑。而本发明图像融合方法获取的融合图像在保证红外目标对比度的同时,具有更少的噪声,细节更丰富,放大观察标记区域可见。

[0159]

从图4中可以看出,方法fusiongan和gtf仍旧保留有红外显著目标,但是放大标记区域中的广告牌亮度过低。方法fpde在放大标记区域有更为明显的噪声,方法msvd和ganmcc在广告牌上则因为噪声呈现出雾蒙蒙的视觉效果,而u2fusion整体上更为偏重可见光图像的底色,融入的红外显著信息不够。方法tif的红框区域亮度、对比度较高,但是在广告牌左下角中引入了较为沉重的黑色伪影,损失图像质量。相比之下,本发明图像融合方法

获取的融合图像在放大标记区域缺少亮度,但对比度适中,且噪声更少,综合性能更佳。为了更清晰的揭示本发明的优异性。相关实验数据见表1所示。

[0160]

本应用例进一步利用实施例2训练好的图像融合系统对tno数据集上随机选取的21进行红外图像和可见光图像融合测试,并利用ssim、scd、sf、vif四个指标进行定量分析,测试结果见表1和图5所示。

[0161]

为了综合评估本发明获取的融合图像效果,进一步采用msvd(参见naidu,v.:image fusion technique using multi-resolution singular value decomposition.defence science journal 61(5),479

–

484(2011))、基于子空间分解的方法fpde(参见bavirisetti,d.p.,xiao,g.,liu,g.:multi-sensor image fusion based on fourth order partial differential equations.in:2017 20th international conference on information fusion(fusion),pp.1

–

9(2017).doi 10.23919/icif.2017.8009719)、基于显著性目标的方法tif(参见bavirisetti,d.p.,dhuli,r.:two-scale image fusion of visible and infrared images using saliency detection.infrared physics&technology 76,52

–

64(2016))、基于全变差的方法gtf(参见ma,j.,chen,c.,li,c.,huang,j.:infrared and visible image fusion via gradient transfer and total variation minimization.information fusion 31,100

–

109(2016))以及3种基于深度学习的方法fusiongan(参见ma,j.,wei,y.,liang,p.,chang,l.,jiang,j.:fusiongan:agenerative adversarial network for infrared and visible image fusion.information fusion 48,11

–

26(2019))、ganmcc(参见ma,j.,zhang,h.,shao,z.,liang,p.,xu,h.:ganmcc:agenerative adversarial network with multiclassification constraints for infrared and visible image fusion.ieee transactions on instrumentation and measurement pp(99),1

–

1(2020))和u2fusion(参见xu,h.,ma,j.,jiang,j.,guo,x.,ling,h.:u2fusion:aunified unsupervised image fusion network.ieee transactions on pattern analysis and machine intelligence(2020))对tno数据集中选取的21对图像进行红外图像和可见光图像融合测试,测试结果见表1和图5所示。

[0162]

表1分别在两个公共数据集上对21对图像进行定量比较结果

[0163][0164]

从表1及图5的统计结果可以看到,本发明在ssim、sf和vif三个指标上拥有最高平均值、最高中位数。其中ssim的评价表明了本发明获取的融合图像很好的延续了输入源图的结构信息,sf的评价表明了本发明的融合图像具有丰富的空间域信息,vif的评价表明了本发明的融合图像在细节上具有优异的性能,更符合人类视觉感知。对于指标scd,尽管本

发明的方法未能取得最好的性能,但是从定性比较可以看出本发明的融合图像可以同时兼具红外热辐信息和可见光图像的纹理细节信息。这些结果表明,本发明提供的图像融合系统及方法能够高效互补利用红外和可见光图像的优势信息,同时兼具最少的噪声,得到更为鲁棒的融合图像。

[0165]

应用例2

[0166]

为了验证本发明提供的图像融合系统及方法拥有高质量的泛化能力,本应用例在具有挑战性的vifb数据集上作了上述相同的定性定量分析实验。vifb数据集是可见红外图像融合领域内的第一个基准,由zhang等人提出(参见zhang x,ye p,xiao g.vifb:a visible and infrared image fusion benchmark[c]//ieee/cvf conference on computer vision and pattern recognition workshops.ieee,2020)。该数据集集成了21个图像对,涵盖了广泛的环境和工作背景。由于vifb数据集中的可见光图像是彩色图像,本发明采用实施例2训练得到的图像融合系统按照以下融合策略执行:将可见光图像转换到ycbcr颜色空间并提取y通道信息和红外图像按照应用例1中给出的步骤s1-s3进行融合,最后,得到的融合图像通过逆变换同可见光图像的cb和cr通道结合转换成rgb图像,测试结果见表1、图6和图7所示。

[0167]

为了综合评估本发明获取的融合图像效果,进一步采用msvd、基于子空间分解的方法fpde、基于显著性目标的方法tif、基于全变差的方法gtf以及3种基于深度学习的方法fusiongan、ganmcc和u2fusion对vifb数据集中选取的21个图像对进行红外图像和可见光图像融合测试,测试结果见表1、图6和图7所示。

[0168]

就定性比较结果而言,本应用例使用图6所示的图像序列来讨论。与可见光图像相比,可以观察到现有技术中七种方法的结果都有不同程度的颜色失真,这在很大程度上是由于纳入了红外信息。然而,在放大标记区域,可以清楚地看到,本发明提供的方法能够保留可见图像中存在的更多颜色和纹理细节,其次是具有更明显模糊感的竞争方法fpde。突出目标所代表的目标区域,本发明提供你的方法中的人物目标有效地结合了重要的红外辐射信息,同时具有较高的特征纹理信息。vifb数据集的定量比较结果如表1及图7所示。与tno数据集的整体性能相比,本发明提供的图像融合系统只获得了两个最佳平均值(ssim和vif)和一个次优值(sf)。ssim和vif的评价结果表明,该方法能最有效地保留源图像的结构信息,获得最佳的视觉效果。sf计算梯度值的总和,这对无噪图像具有更客观的评价,而在相同内容下,有噪图像将具有更高的值。tif和u2fusion的视觉结果可以证明这一点。显然,放大标记区域中的噪声较多,这将对sf值产生积极影响。总体而言,本发明提供的图像融合系统在具有挑战性的vifb数据集上实现了最佳性能,并且具有很强的泛化能力。

[0169]

应用例3

[0170]

本应用例基于应用例1中提供的数据集及方法。

[0171]

在实施例1提供的图像融合系统中,密集的多尺度特征提取器由膨胀率依次增大的稠密空洞卷积模块组成,特征图的自适应权重调整由基于双重注意力机制的特征筛选单元完成。为了验证这两部分功能对融合性能的影响,本应用例在tno数据集上执行了消融实验。

[0172]

为了进行消融实验,本应用例构建了两个对比系统(ours w/o d和ours w/o a)。ours w/o d相对于实施例1中提供的图像融合系统(ours),缺少多尺度特征提取单元(d)。

ours w/o a相对于实施例1中提供的图像融合系统(ours),缺少特征筛选单元(a)。w/o表示(without)没有。

[0173]

按照实施例2提供的训练方法分别对两个对比系统进行训练,并利用训练好的两个对比系统及实施例2训练好的图像融合系统分别对tno数据集中的两对带吉普车和球的士兵图像进行测试,测试结果见表2及图8所示。

[0174]

表2三种图像融合系统分别在tno数据集上两对图像进行定量比较结果

[0175][0176]

如表2所示,d的存在将显著改善融合图像的ssim和scd指标,a在影响sf和vif方面发挥积极作用。当缺乏密集的多尺度特征提取单元时,图像融合系统无法利用多尺度特征信息,从而导致融合图像捕获的枝叶信息在像素级对比度不足,如图8所示。这种视觉效果也作用于天空中的云和车窗内的人,使他们难以从周围的背景中分离出来。此外,融合图像在不使用模块a的情况下获得了较少的纹理细节,该模块侧重于特征信息的差异调整。从红盒中放大的区域可以很容易地观察到,在没有模块a的情况下,红外图像传输的天空云层信息基本上是不可见的。另一个不容忽视的事实是,scd在没有模块a的情况下得分最高。这可能是因为当增强或抑制某些特征时,会丢失源图像的一些相关信息。当网络中存在模块d和a时,从图8中可以清楚地看出,本发明提供的图像融合系统获取的融合图像继承了最一致的对比度和细节。总之,通过上述实验验证了本发明提供的图像融合系统中多尺度特征提取单元和特征筛选单元的有效性。

[0177]

应用例4

[0178]

图像融合服务于更高级的视觉任务。为了检验本发明提供的图像融合系统及方法更进一步应用的可行性,本发明实施了视觉对象跟踪实验(vot)。

[0179]

在本发明的实验中,选用商汤团队开源的siamrpn composed of backbone(主体为alexnet结构)alexnet作为在最新的vot-rgbt2019数据集上进行短期单目标跟踪实验。vot-rgbt2019是委员会在2019年新引入的rgb和热辐短期跟踪子挑战(thermal infrared short-term tracking sub-challenge),它总共包含60个短视频序列。本应用例随机选取了其中30个视频序列采用实施例2训练好的图像融合系统按照以下融合策略执行:将可见光图像转换到ycbcr颜色空间并提取y通道信息和红外图像按照应用例1中给出的步骤s1-s3进行融合,最后,得到的融合图像通过逆变换同可见光图像的cb和cr通道结合转换成rgb图像,并提供了以人脸为目标的部分序列帧的实验结果,如图9所示。

[0180]

在定量指标评估方面,我们沿用算法siamrpn所选用的三个指标(accuracy(准确性)、robustness(稳健性)和eao(期望平均重叠率)),评估结果见表3。表中,accuracy统计每帧预测的bounding box(对象追踪框)与gt(真值)的intersection-over-union(交叠率),用来评价跟踪器在单个测试序列下跟踪目标的准确度,数值越大,准确度越高。robustness评价稳定性,数值越大,稳定性越差,同每个视频序列跟丢的次数正相关.而eao是预期平均重叠率的缩写,是跟踪器在一个短时图像序列上的非重置重叠的期望值。

[0181]

在vot-rgbt2019基准实验结果中,可以看到融合结果在三个指标上均取得了最高

值。显然,融合结果兼具可见光和红外图像的主要信息,具有更明显的特征,因而能够被追踪器更轻松并且更高精度地检测到目标。这表明,本发明提供的图像融合系统在融合动态的红外目标和避免失真方面同样具有相当大的优势。

[0182]

表3vot-rgbt2019数据集上随机30个视频序列的图像融合测试结果

[0183][0184]

此外,依据应用例1中tno数据集和应用例2中vifb数据集的时间复杂度(分析结果见表4所示)对本发明提供的图像融合系统的运行效率进行解释。

[0185]

表4tno、vifb数据集上随机21个图像对的时间复杂度分析结果

[0186][0187]

在本发明中,所有可见图像均转换为灰度空间,然后进行处理,因此,所有涉及比较的方法只考虑融合过程中的时间消耗,而没有源图像信道分离或融合的运算开销。总的来说,由于在cpu上执行复杂的算术运算,传统方法具有更高的时间成本。在基于深度学习的方法中,u2fusion和本发明提供的图像融合方法相比,gans使用相对简单的卷积网络实现了更高的运算效率。为了进一步评估两者之间的差异,当输入图像具有固定大小(如128*128)时,本发明提供的图像融合方法比u2fusion具有更低的计算复杂度。具体来说,本发明提供的方法总共有164k个训练参数和2.9g的触发器,而u2fusion的相应值分别为659k和216g。总之,虽然本发明提供的方法在vifb数据集中未能击败u2fuion,但在tno数据集中取得了最好的性能,这仍然证明了本发明提供的图像融合方法具有相当的效率。

[0188]

综上所述,本发明文提供的基于稠密空洞卷积和双重注意机制的红外与可见光图像融合系统是一种端到端的红外和可见光图像融合网络dfdafuse。首先,我们的融合网络通过密集连接的空洞卷积模块扩展卷积块,在不损失特征图分辨率的情况下捕获源图像的金字塔形特征。然后,通过序列eca net和空间通道注意模块对聚集的多尺度特征信息进行自适应细化。在训练过程中,所设计的图像信息保持策略可以动态测量源图像的权重,指导网络的拟合方向。本发明在两个公共数据集tno和vifb上进行的定性和定量实验表明,该方法能够有效地融合红外和可见光图像中的突出信息,生成综合性能最高的融合图像。融合图像结合了红外和可见光图像的主要信息,可以有效提取并利用源图的优势信息,比如上述各应用例中的显著目标,在可见光源图中看不到,但是在融合图像中可以清楚的显现,说明融合图像中囊括了红外信息。同样,融合图像中也包含了红外源图中没有,可见光图像有的信息。此外,消融实验证明本发明网络的每个模块都对融合图像产生了积极的影响,扩展实验进一步表明本发明在其他视觉任务中仍具有应用潜力,本发明具有很好的泛化性。

[0189]

本领域内的技术人员应明白,本发明的实施例可提供为方法、系统、或计算机程序产品。因此,本发明可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本发明可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产

品的形式。

[0190]

本发明是参照根据本发明实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0191]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0192]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

[0193]

最后应当说明的是:以上实施例仅用于说明本发明的技术方案而非对其保护范围的限制,尽管参照上述实施例对本发明进行了详细的说明,所属领域的普通技术人员应当理解:本领域技术人员阅读本发明后依然可对发明的具体实施方式进行种种变更、修改或者等同替换,但这些变更、修改或者等同替换,均在发明待批的权利要求保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。