1.本发明涉及仿生视觉与无人机导航定位技术领域,具体涉及一种基于海马、内嗅皮层的类脑视觉导航方法。

背景技术:

2.在无人机导航定位技术中,视觉导航技术在城市街道等环境中发挥着越来越重要的作用。但是由于视觉导航系统的误差将随着时间的推移而累积,很难保证视觉导航系统长期具有较高的位置精度,因此视觉导航系统的精度远不能满足无人机的长航时需求,这就导致了大多数无人机过分依赖于卫星导航。但是卫星导航信号在城市街道中又极易受到干扰。因此如何有效的较少累积位置误差,提高视觉导航系统的智能性,成为了科学界研究的热点。

技术实现要素:

3.发明目的:为了解决现有技术中视觉导航系统位置误差随时间累积导致无法满足无人机长航时需求的问题,本发明提供一种基于海马、内嗅皮层的类脑视觉导航方法。

4.技术方案:一种基于海马、内嗅皮层的类脑视觉导航方法,包括以下步骤:

5.(1)建立速度细胞模型、头方向细胞模型、位置细胞模型及网格细胞模型;所述速度细胞模型用于根据图像解算出速度信息;头方向细胞模型用于将速度信息转化为方位信息;位置细胞模型用于对输入图像进行场景识别,并将识别出的熟悉场景的位置信息输出给网格细胞模型;网格细胞模型用于将速度信息和方位信息整合为相应的位置信息;网格细胞接收位置细胞模型提供的位置信息进行激活重置,校正位置误差,输出精确的导航信息;

6.(2)获取无人机拍摄图像,将图像输入速度细胞模型,解算出速度信息,再将速度信息输入头方向细胞模型,转换为方位信息;

7.(3)将速度信息和方位信息输入网格细胞模型,转换为相应的位置信息;

8.(4)将无人机拍摄图像输入位置细胞模型,位置细胞模型中预存储有模板场景图像,将输入图像与模板场景图像进行匹配,判断是否为熟悉场景,若为熟悉场景,则将匹配度高的模板场景图像的位置信息传递给网格细胞模型,执行步骤(5);若非熟悉场景,执行步骤(6);

9.(5)网格细胞接收到来自位置细胞模型的位置信息,对步骤(3)转换得到的位置信息进行激活重置,校正位置误差,输出精确校正的导航信息位置信息。;

10.(6)网格细胞直接输出步骤(3)得到的位置信息。

11.进一步地,步骤(1)、(2)中,所述速度细胞模型包括光流算法模块、orb算法模块及平方根容积卡尔曼滤波器,光流算法模块、orb算法模块的输出端连接平方根容积卡尔曼滤波器输入端;将光流算法模块由无人机拍摄图像解算出的x,y方向的速度作为观测量,将orb算法模块由无人机拍摄图像解算出的x、y方向的速度作为状态量,将观测量与状态量输

入平方根容积卡尔曼滤波器,进行速度的无缝融合得到速度信息。

12.进一步地,步骤(1)、(2)中,所述头方向细胞模型包括反三角函数变换模块,将速度细胞模型输出的速度信息经反三角函数变化转化为方位信息。

13.进一步地,步骤(1)、(3)中,所述网格细胞模型包括路径积分器,将速度信息和方位信息通过路径积分器转换为相应的位置信息。

14.进一步地,步骤(1)、(4)中,所述位置细胞模型包括扫描线强度算法模块和自适应局部仿射匹配模块,利用图像的灰度信息和特征点信息,对场景图像进行识别检测。

15.进一步地,步骤(4)中,位置细胞模型判断是否为熟悉场景包括:

16.获取无人机拍摄图像,从图像提取每个像素列的像素强度值,利用扫描线强度计算每个像素列的像素强度值之和,再归一化获得一维向量,计算公式如下:

[0017][0018]

其中,cj表示第j列归一化后的像素强度值之和,其中m表示图像像素的行数,i表示图像像素的第i行,n表示图像像素的列数,j表示图像像素的第j列;

[0019]

从预先存储在位置细胞模型中的模板场景图像中提取感兴趣区域(roi),与拍摄的图像的相应区域进行对比,得到图像相似度,计算公式如下:

[0020][0021]

其中,β表示两图像的相似程度,当β小于阈值α时认为两张图像匹配成功,认为无人机来到了熟悉的场景;w是roi图像的宽,r表示像素偏移,s表示偏移量,cj表示模板图像的第j列归一化后的像素强度值之和,c

′j表示拍摄的图像的第j列归一化后的像素强度值之和,abs(s)表示偏移量的绝对值。

[0022]

进一步地,步骤(4)中,si算法是基于图像灰度信息的图像匹配算法,匹配速度较快,但是精度较差,因此经过si算法得到匹配成功的图像后,还需要利用自适应局部仿射匹配算法对离群值进行检测剔除,adalam算法的检测速度较慢,但是精度较高,因此adalam算法包括:

[0023]

先通过最近邻匹配算法找到匹配成功的图像的特征点初始匹配信息;

[0024]

再通过比率测试得到每个特征点的置信度得分,将半径r内得分最高的特征点作为“种子点”;

[0025]

以“种子点”为中心,寻找支持“种子点”的匹配点集,对于两张图像上确定的匹配“种子点”(y1,y2),nj表示种子点的对应关系,则有:

[0026][0027]

其符合相似变换,即旋转和缩放若最近邻匹配中匹

配的特征点(p1,p2)=((y1,d1,σ1,a1),(y2,d2,σ2,a2))满足下述约束关系:

[0028][0029]

则被纳入到支持“种子点”的匹配点集mj,其中a

p

=a

2-a1,σ

p

=σ

2-σ1表示两个匹配点间的角度和尺度差异,r1和r2分别表示两张图像“种子点”的扩散半径,k是一个超参数,表示邻域之间的重叠程度,ta和t

σ

表示旋转和缩放的置信度阈值;

[0030]

假设匹配对之间符合局部仿射变换,对每个匹配点集mj应用该假设,剔除部分错误匹配信息,保留局部一致性较好的匹配点。

[0031]

进一步地,步骤(1)、(5)中,网格细胞模型接收到位置细胞模型传输的位置信息后,网格细胞进行激活重置,导航系统调整路径积分器,校正位置误差,输出校正后的位置信息。

[0032]

有益效果:本发明提供一种基于海马、内嗅皮层的类脑视觉无人机导航方法,与传统视觉导航技术以及卫星等现代导航方法相比,本发明基于高等动物的导航原理,具备体积小、成本低、自主性强、隐蔽性好等优点;且每当无人机来到熟悉场景时,便可通过熟悉场景模板图像的位置信息对无人机获取到的位置信息进行校正,以减少累计误差,使其误差不随时间积累,可以满足无人机长航时的需求;信号来自周围的环境信息,能够充分利用周围的环境信息,进行无人机自主导航定位,具有较高的精度和准确度。

附图说明

[0033]

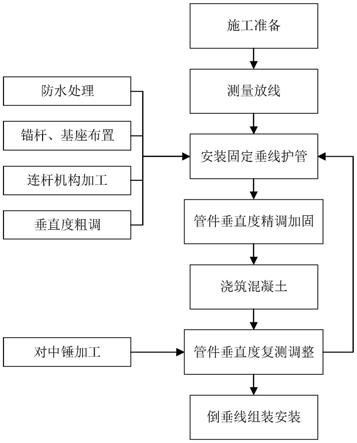

图1为基于海马、内嗅皮层的类脑视觉无人机导航系统的整体框图;

[0034]

图2为速度细胞、头方向细胞内部机制的建立示意图;

[0035]

图3为位置细胞内部机制的建立示意图;

[0036]

图4为实验结果对比图。

具体实施方式

[0037]

如图1所示为基于海马、内嗅皮层的类脑视觉无人机导航系统的示意框图,通过相机获取外界图像信息,对速度、头方向、网格、位置细胞建模,将图像信息转化为精确的位置信息。基于海马、内嗅皮层的类脑视觉无人机导航方法,包括以下步骤:

[0038]

(1)建立速度细胞模型、头方向细胞模型、位置细胞模型及网格细胞模型;所述速度细胞模型用于根据图像解算出速度信息;头方向细胞模型用于将速度信息转化为方位信息;位置细胞模型用于对输入图像进行场景识别,并将识别出的熟悉场景的位置信息输出给网格细胞模型;网格细胞模型用于将速度信息和方位信息整合为相应的位置信息,网格细胞接收位置细胞模型提供的位置信息进行激活重置,校正位置误差,输出精确的导航信息。下面针对每个模型最进一步详细说明:

[0039]

如图2为速度、头方向细胞内部相关机制的建立,将其产生的速度和方位信息通过网格细胞的路径积分器产生相关位置信息。所述速度细胞模型包括光流算法模块、orb算法模块及平方根容积卡尔曼滤波器,光流算法模块、orb算法模块的输出端连接平方根容积卡尔曼滤波器输入端;将光流算法模块由无人机拍摄图像解算出的x,y方向的速度作为观测

量,将orb算法模块由无人机拍摄图像解算出的x、y方向的速度作为状态量,将观测量与状态量输入平方根容积卡尔曼滤波器,进行速度的无缝融合得到速度信息。

[0040]

所述头方向细胞模型包括反三角函数变换模块,将速度细胞模型输出的速度信息经反三角函数变化转化为方位信息。

[0041]

所述网格细胞模型包括路径积分器,将速度信息和方位信息通过路径积分器转换为相应的位置信息。

[0042]

如图3,所述位置细胞模型包括扫描线强度算法(si)模块和自适应局部仿射匹配(adalam)模块,位置细胞内部将图像灰度信息和特征点信息相结合,充分利用扫描线强度算法(si)的速度和自适应局部仿射匹配(adalam)的精度优势,对场景图像有精确的识别检测。位置细胞模型内部机制的建立,相比于其他算法,其结合图像灰度信息和特征点信息,具有良好的速度和精度优势。

[0043]

(2)获取无人机拍摄图像,将图像输入速度细胞模型,解算出速度信息,再将速度信息输入头方向细胞模型,转换为方位信息。

[0044]

(3)将速度信息和方位信息输入网格细胞模型,转换为相应的位置信息。

[0045]

(4)将无人机拍摄图像输入位置细胞模型,位置细胞模型中预存储有模板场景图像,将输入图像与模板场景图像进行匹配,判断是否为熟悉场景,若为熟悉场景,则将匹配度高的模板场景图像的位置信息传递给网格细胞模型。

[0046]

其中,位置细胞模型判断是否为熟悉场景包括:

[0047]

获取无人机拍摄图像,从图像提取每个像素列的像素强度值,利用扫描线强度计算每个像素列的像素强度值之和,再归一化获得一维向量,计算公式如下:

[0048][0049]

其中,cj表示第j列归一化后的像素强度值之和,其中m表示图像像素的行数,i表示图像像素的第i行,n表示图像像素的列数,j表示图像像素的第j列;

[0050]

在无人机上进行图像获取时,由于此时的相机相对高度与倾角保持相同,可以认为此时的获取的图像只有水平偏差。因此可以从预先存储在位置细胞模型中的模板场景图像中提取感兴趣区域(roi),与拍摄的图像相应区域进行对比,得到图像相似度,计算公式如下:

[0051][0052]

其中,β表示两图像的相似程度,β越小表示两张图像越相似,当β小于阈值α时认为两张图像匹配成功,认为无人机来到了熟悉的场景;w是roi图像的宽,r表示像素偏移,s表示偏移量,cj表示模板图像的第j列归一化后的像素强度值之和,c

′j表示拍摄的图像的第j列归一化后的像素强度值之和,abs(s)表示偏移量的绝对值。

[0053]

si算法是基于图像灰度信息的图像匹配算法,匹配速度较快,但是精度较差,因此

经过si算法得到匹配成功的图像后,还需要利用自适应局部仿射匹配算法(adalam)对离群值进行检测剔除,adalam算法的检测速度较慢,但是可以有效的提高图像匹配精度。具体包括:

[0054]

先通过最近邻匹配算法找到匹配成功的图像的特征点初始匹配信息;

[0055]

再通过比率测试挑选一定数量置信度高且分布较好的“种子点”。如通过比率测试得到每个特征点的置信度得分,将半径r内得分最高的特征点作为“种子点”;

[0056]

以“种子点”为中心,寻找支持“种子点”的匹配点集,对于两张图像上确定的匹配“种子点”(y1,y2),nj表示种子点的对应关系,则有:

[0057][0058]

其符合相似变换,即旋转和缩放若最近邻匹配中匹配的特征点(p1,p2)=((y1,d1,σ1,a1),(y2,d2,σ2,a2))满足下述约束关系:

[0059][0060]

则被纳入到支持“种子点”的匹配点集mj,其中a

p

=a

2-a1,σ

p

=σ

2-σ1表示两个匹配点间的角度和尺度差异,r1和r2分别表示两张图像“种子点”的扩散半径,k是一个超参数,表示邻域之间的重叠程度,ta和t

σ

表示旋转和缩放的置信度阈值;

[0061]

假设匹配对之间符合局部仿射变换,对每个匹配点集mj应用该假设,剔除部分错误匹配信息,保留局部一致性较好的匹配点。

[0062]

其中ransac的思想被采用去找到最小解集去拟合仿射矩阵,通过局部仿射变换验证每一个匹配点集中匹配信息的一致性,保留局部一致性较好的匹配点。

[0063]

若位置细胞模型识别出熟悉场景,则将该熟悉场景的模板图像的位置信息发送至网格细胞模型,执行步骤(5);若未识别出熟悉场景,则执行步骤(6)。

[0064]

(5)网格细胞接收到来自位置细胞模型的位置信息,网格细胞对步骤(3)转换得到的位置信息进行激活重置,导航系统调整路径积分器,校正位置误差,输出导航信息。例如,无人机经过熟悉的地点,位置细胞模型识别到熟悉的地点场景,将地点场景精确的位置信息p1发送到网格细胞模型,网格细胞模型接收到来自位置细胞模型精确的位置信息p1,系统调整路径积分器将当前存在误差的位置信息(步骤3转换得到的位置信息p)拉回到p1,校正路径积分中存在的累积位置误差,输出校正后的位置信息。

[0065]

(6)网格细胞模型直接输出步骤(3)转换得到的位置信息。

[0066]

图4为不同模型算法的实验结果对比,其中使用本方案进行多次重复测试,见图中实线部分,从图中可以清晰的看到本方法具有良好的精度优势。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。