1.本发明属于感官替代技术领域,特别是涉及一种基于听觉的辅助空间感知系统及方法。

背景技术:

2.世界卫生组织所公布的数据显示,世界上大约有2.53亿人患有视力障碍。由于视觉的缺失,视障人士在日常生活出行中面临着诸多困难。而随着社会的发展,视障人士的生活质量、出行水平受到了越来越多的关注。帮助视障人士感知空间,进而提高该群体的行走能力,便利其生活,是亟需解决的问题。

3.目前,辅助盲人行走的传统方式主要为盲杖和导盲犬。但是,它们都存在着一些不足之处,比如盲杖的探测范围有限,而导盲犬的培养成本高、适用场合有限制。同时,这些传统导盲方式只能够帮助视障人士避开路上的障碍物,却不能使他们了解周围环境的空间结构和场景信息。

4.随着计算机科学和传感器技术的发展,感官替代装置被研究用于视障人士的空间感知辅助研究。由于听觉有着直观性强、可利用参数多的特点,大部分的感官替代装置尝试使用听觉信号来代替视觉信号,向使用者提供场景信息。但是,这些研究往往存在着两个方面的问题:提供空间信息不足而无法满足视障者的需求,或者提供过于冗余的信息而使得实用性不强。

技术实现要素:

5.本发明针对现有技术的不足,提供一种基于听觉的辅助空间感知系统及方法,利用听觉代替视觉,将空间场景信息转化为非语音空间音频信号或语音描述信号,不仅辅助视障者在行走过程中有效躲避障碍物,提高使用者的空间认知感,而且能有效传递环境信息,提升使用者的场景理解能力。

6.一种基于听觉的辅助空间感知系统,包括数据采集模块、人机交互模块、控制模块、行走模式模块和凝视模式模块,其中人机交互模块与控制模块相连接,控制模块、数据采集模块与行走模式模块、凝视模式模块相连接。

7.数据采集模块用以采集空间场景信息,包括深度图像数据流和rgb图像数据流。

8.人机交互模块用以传达用户指令,向控制模块发送行走模式指令和凝视模式指令。

9.控制模块根据人机交互模块的行走模式指令处理数据采集模块获取的深度图像数据,并将深度图像信息映射到空间音频上,通过耳机输出空间音频;控制模块根据人机交互模块的凝视模式指令从数据采集模块获取的rgb图像数据中构建语义信息,合成并通过耳机输出相应语音。

10.行走模式模块用于对空间场景中的物体方位和距离信息进行探测与输出,包括:深度图像预处理子模块,用于处理深度图像数据流;空间音频生成子模块,用于将深度图像

信息映射到音频参数上,并对音频进行空间化处理;空间音频输出子模块,用于输出空间音频。

11.凝视模式模块用于对空间场景中物体的属性和状态信息进行识别与输出,包括:rgb图像语义构建子模块,用于将rgb图像数据流转换为句子;语音合成子模块,用于将句子转换为语音;语音输出子模块,用于输出语音信号。

12.一种利用上述基于听觉的辅助空间感知系统实现的行走模式辅助空间感知方法,包括以下几个步骤:

13.步骤101,接收数据采集模块实时传送的深度图像数据流,对每一帧深度图像进行空值的填充,即将空值像元的八邻域非空像元值的平均值赋给该空值像元,遍历图像执行该操作直至图像中没有空值;

14.步骤102,对步骤101处理后的深度图像进行高斯低通滤波处理,以滤除图像中的噪音和模糊细节;

15.步骤103,对步骤102所得到的深度图像进行下采样处理,将原始尺寸为225

×

315的图像下采样至5

×

7;

16.步骤104,将步骤103经过下采样处理的深度图像像元值映射到音频参数上;

17.步骤105,利用头相关函数技术,对步骤104生成的音频信息进行空间化处理,即将像元在图像中的坐标(x,y)映射到声源位置上;

18.步骤106,实时输出空间音频至用户所佩戴的耳机,该音频传递空间结构信息的非语音声音。

19.而且,所述步骤103中下采样规则为:将待求解像元的八邻域中最小像元值赋予该待求解像素。

20.而且,所述步骤104中图像信息转化为音频的规则为:提取图像中每一列的最小像元,并设定阈值d,比较最小像元与阈值d的大小;当最小像元值小于等于d时,表示该位置的物体离使用者距离较近,将最小像元值映射到嘟声的响度和音高上,像元值越小,表示物体离得越近,映射的嘟声的响度越大、音高越高,反之,则响度越小、音高越低,以此提示使用者躲避障碍物;当最小像元值大于d时,表示该位置的物体离使用者距离较远,暂时不会构成碰撞威胁,此时使用响度和音高固定的水滴声表示该像元信息,该水滴声可被视为一种提示物体距离较远的“安全音”。

21.而且,所述步骤105中空间化处理后,嘟嘟声或水滴声是有空间感的,使用者会感受到它们传来的方向,具体映射规则如下式所示:

22.θ=-120

°

30

°×yꢀꢀ

(1)

[0023][0024]

式中,x为像元在图像中的行号,y为像元在图像中的列号,以头颅中心为原点o构建三维坐标系,x轴经过人耳,y轴经过鼻子,z轴垂直于xoy平面,θ为声源位置与原点o的连线和yoz平面所形成的水平角,为声源位置与原点o的连线和xoy平面所形成的高度角。

[0025]

而且,所述步骤106中对于每一帧深度图像,将产生7个不同水平角的音频片段,这些音频片段被按照从左到右的顺序依次播放;当音频为水滴声时,表示该位置的物体离使用者距离较远;当音频为嘟声时,表示该位置的物体离使用者距离小于d米,嘟声的音调越

高、响度越大,距离越近;使用者可以根据音频的音色、音调、响度和声源位置信息,判断障碍物的距离、方位,从而在行走过程中躲避障碍物。

[0026]

一种利用上述基于听觉的辅助空间感知系统实现的凝视模式辅助空间感知方法,包括以下几个步骤:

[0027]

步骤201,接受数据采集模块实时传送的rgb图像,通过调取微软提供的computer vision api服务,生成图像的英文描述性文本;

[0028]

步骤202,通过百度翻译api服务,将步骤1生成的英文文本转化为中文文本;

[0029]

步骤203,基于python软件中的pyttsx模块,将步骤2生成的中文文本转化为语音;

[0030]

步骤204,实时输出语音至用户所佩戴的耳机,该语音为一个对当前视野场景信息的描述性句子。

[0031]

与现有技术相比,本发明具有以下优点:

[0032]

1)本发明提供的系统包括行走模式和凝视模式两种工作模式,对应两种基于听觉的辅助空间感知方法,两种方法相结合可以满足视障用户在不同场景下的不同使用需求。

[0033]

2)行走模式辅助空间感知方法使用可听化技术将空间场景信息实时转化为空间音频信号,使视障者能够快速获取空间结构信息,有效地帮助视障者在行走过程中躲避障碍物,提高空间认知感。行走模式辅助空间感知方法提供了更大的空间信息量,有效解决了现有感官替代装置提供空间信息不足无法满足视障者需求的问题。

[0034]

3)凝视模式辅助空间感知方法将空间场景信息实时转化为语音朗读出来,使视障者快速获取空间场景的描述性信息,有效帮助视障者获取环境信息,提升场景理解能力。凝视模式辅助空间感知方法提供了更精炼集中的空间描述性信息,有效解决了现有感官替代装置提供冗余的信息导致实用性不强的问题。

附图说明

[0035]

图1为本发明实施例基于听觉的辅助空间感知系统的结构原理图。

[0036]

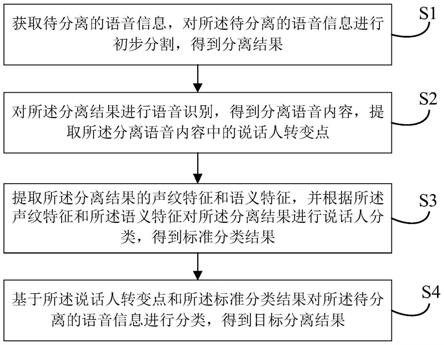

图2为本发明行走模式辅助空间感知方法的流程图。

[0037]

图3为本发明行走模式辅助空间感知方法中所使用的声源位置水平角θ、高度角的示意图。

[0038]

图4为本发明凝视模式辅助空间感知方法的流程图。

具体实施方式

[0039]

本发明提供一种基于听觉的辅助空间感知系统及方法,利用听觉替代视觉,将空间场景信息转化为非语音空间音频信号或语音描述信号,辅助使用者感知空间和理解场景。

[0040]

下面结合附图和实施例对本发明的技术方案作进一步说明。

[0041]

如图1所示,本发明提供一种基于听觉的辅助空间感知系统,包括:数据采集模块、人机交互模块、控制模块、行走模式模块和凝视模式模块,其中人机交互模块与控制模块相连接,控制模块、数据采集模块与行走模式模块、凝视模式模块相连接。

[0042]

数据采集模块用以采集空间场景信息,包括深度图像数据流和rgb图像数据流。

[0043]

人机交互模块用以传达用户指令,向控制模块发送行走模式指令和凝视模式指

令。

[0044]

控制模块根据人机交互模块的行走模式指令处理数据采集模块获取的深度图像数据,并将深度图像信息映射到音频参数上,通过耳机输出空间音频;控制模块根据人机交互模块的凝视模式指令从数据采集模块获取的rgb图像数据中构建语义信息,合成并通过耳机输出相应语音。

[0045]

行走模式模块用于对空间场景中的物体方位和距离信息进行探测与输出,包括:深度图像预处理子模块,用于处理深度图像数据流;空间音频生成子模块,用于将深度图像信息映射到音频参数上,并对音频进行空间化处理;空间音频输出子模块,用于输出空间音频。

[0046]

凝视模式模块用于对空间场景中物体的属性和状态信息进行识别与输出,包括:rgb图像语义构建子模块,用于将rgb图像数据流转换为句子;语音合成子模块,用于将句子转换为语音;语音输出子模块,用于输出语音信号。

[0047]

通过设置人机交互模块,可以使用户自由选择模式,通过不同类型的声音输出获取周围空间场景的不同类型的信息;通过设置行走模式模块,可以使用户快速感知周围环境的空间结构,帮助用户掌握障碍物的方位和距离信息,从而有效避开障碍物,确保用户在行走过程中的安全;通过设置凝视模式模块,可以使用户快速获取周围环境的描述性信息,有助于用户理解空间场景。

[0048]

该系统包括行走模式和凝视模式两种工作模式,对应两种基于听觉的辅助空间感知方法:行走模式辅助空间感知方法和凝视模式辅助空间感知方法。行走模式辅助空间感知方法使用可听化技术将空间场景信息实时转化为空间音频信号,使视障者能够快速获取空间结构信息,有效地帮助视障者在行走过程中躲避障碍物,提高空间认知感。凝视模式辅助空间感知方法将空间场景信息实时转化为语音朗读出来,使视障者快速获取空间场景的描述性信息,有效帮助视障者获取环境信息,提升场景理解能力。

[0049]

如图2所示,行走模式辅助空间感知方法包括以下步骤:

[0050]

步骤101,接收数据采集模块实时传送的深度图像数据流,对每一帧深度图像进行空值的填充,即将空值像元的八邻域非空像元值的平均值赋给该空值像元,遍历图像执行该操作直至图像中没有空值。

[0051]

步骤102,对步骤101处理后的深度图像进行高斯低通滤波处理,以滤除图像中的噪音和模糊细节。

[0052]

步骤103,对步骤102所得到的深度图像进行下采样处理,将原始尺寸为225

×

315的图像下采样至5

×

7,下采样规则为:将待求解像元的八邻域中最小像元值赋予该待求解像素。

[0053]

步骤104,将步骤103经过下采样处理的深度图像像元值映射到音频参数上。

[0054]

图像信息转化为音频的规则为:提取图像中每一列的最小像元,并设定阈值d(本实施例中d取3米),比较最小像元与阈值d的大小。当最小像元值小于等于d时,表示该位置的物体离使用者距离较近,将最小像元值映射到嘟声的响度和音高上,像元值越小,表示物体离得越近,映射的嘟声的响度越大、音高越高,反之,则响度越小、音高越低,以此提示使用者躲避障碍物。当最小像元值大于d时,表示该位置的物体离使用者距离较远,暂时不会构成碰撞威胁,此时使用响度和音高固定的水滴声表示该像元信息,该水滴声可被视为一

种提示物体距离较远的“安全音”。

[0055]

步骤105,利用头相关函数技术,对步骤104生成的音频信息进行空间化处理,即将像元在图像中的坐标(x,y)映射到声源位置上。空间化处理后,嘟嘟声或水滴声是有空间感的,使用者会感受到它们传来的方向。

[0056]

具体映射规则如下式所示:

[0057]

θ=-120

°

30

°×yꢀꢀ

(1)

[0058][0059]

式中,x为像元在图像中的行号,y为像元在图像中的列号,如图3所示,以头颅中心为原点o构建三维坐标系,x轴经过人耳,y轴经过鼻子,z轴垂直于xoy平面。θ为声源位置与原点o的连线和yoz平面所形成的水平角,为声源位置与原点o的连线和xoy平面所形成的高度角。

[0060]

步骤106,实时输出空间音频至用户所佩戴的耳机,该音频传递空间结构信息的非语音声音。

[0061]

对于每一帧深度图像,将产生7个不同水平角的音频片段,这些音频片段被按照从左到右的顺序依次播放。当音频为水滴声时,表示该位置的物体离使用者距离较远;当音频为嘟声时,表示该位置的物体离使用者距离小于d米,嘟声的音调越高、响度越大,距离越近。使用者可以根据音频的音色、音调、响度和声源位置信息,判断障碍物的距离、方位,从而在行走过程中躲避障碍物。

[0062]

如图3所示,凝视模式辅助空间感知方法包括以下步骤:

[0063]

步骤201,接受数据采集模块实时传送的rgb图像,通过调取微软提供的computer vision api服务,生成图像的英文描述性文本。

[0064]

步骤202,通过百度翻译api服务,将步骤201生成的英文文本转化为中文文本。

[0065]

步骤203,基于python软件中的pyttsx模块,将步骤202生成的中文文本转化为语音。

[0066]

步骤204,实时输出语音至用户所佩戴的耳机,该语音为一个对当前视野场景信息的描述性句子。

[0067]

本文中所描述的具体实施例仅仅是对本发明精神作举例说明。本发明所属技术领域的技术人员可以对所描述的具体实施例做各种各样的修改或补充或采用类似的方式替代,但并不会偏离本发明的精神或者超越所附权利要求书所定义的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。