1.本公开涉及计算机应用技术领域,具体涉及一种文本处理方法、装置、电子设备及计算机可读存储介质。

背景技术:

2.在法院开庭之前,经常需要根据当前案件的客观事实文本,比如,原告起诉书和/或被告答辩状等,获取当前案件的主要争议焦点,以便于法官根据主要争议焦点了解当前案件的整体概括,并在法院庭审阶段根据主要争议焦点向原告或被告提问。由于客观事实文本为非结构化的文本,不具有树状或者网状等拓扑结构,因此,如何从非结构化的客观事实文本中提取争议焦点成为亟待解决的技术问题。

技术实现要素:

3.为了解决相关技术中的问题,本公开实施例提供一种文本处理方法、装置、电子设备及计算机可读存储介质。

4.第一方面,本公开实施例中提供了一种文本处理的方法。

5.具体地,所述文本处理方法,包括:

6.基于第一文本数据,通过处理器利用第一模型获取与所述第一文本数据相对应的第一语义向量序列{e1,e2,

…

,e

m

},其中,e

i

为向量,i=1~m;

7.基于第二文本数据,通过处理器利用所述第一模型获取与所述第二文本数据相对应的第二语义向量序列{d1,d2,

…

,d

n

},其中,d

j

为向量,j=1~n;

8.基于所述第一语义向量序列{e1,e2,

…

,e

m

},通过处理器利用第二模型获取与所述第一语义向量序列{e1,e2,

…

,e

m

}相对应的第三语义向量序列{q1,q2,

…

,q

m

},其中,q

i

为向量;

9.基于所述第二语义向量序列{d1,d2,

…

,d

n

},通过处理器利用所述第二模型获取与所述第二语义向量序列{d1,d2,

…

,d

n

}相对应的第四语义向量序列{h1,h2,

…

,h

n

},其中,h

j

为向量;

10.基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据。

11.结合第一方面,本公开在第一方面的第一种实现方式中,所述第一文本数据和所述第二文本数据包含彼此对应的内容,所述目标文本数据的内容与所述第一文本数据和所述第二文本数据中相对应的内容相关联;和/或

12.所述第二文本数据包括对所述第一文本数据中的至少部分内容的应答,所述目标文本数据包括与所述第一文本数据和/或所述第二文本数据有关的文本数据;和/或

13.所述目标文本数据与所述第一文本数据和所述第二文本数据中彼此有争议的文本数据相关联。

14.结合第一方面,本公开在第一方面的第二种实现方式中,所述基于所述第三语义

向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据,包括:

15.将所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量序列{h1,h2,

…

,h

r

},其中,h

k

为向量,r=n m,k=1~r;

16.基于所述拼接向量序列{h1,h2,

…

,h

r

},通过第三模型,获取第五语义向量序列{v1,v2,

…

,v

r

},其中,v

k

为向量;

17.根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据。

18.结合第一方面的第二种实现方式,本公开在第一方面的第三种实现方式中,所述根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据,包括:

19.基于所述第五语义向量序列{v1,v2,

…

,v

r

},通过第四模型,获取第一聚合向量v1;

20.将所述第一聚合向量v1输入全连接层,获取第二聚合向量v2;

21.将所述第二聚合向量v2经过激活函数作用之后,获取与n个候选目标文本数据相对应的概率分布,所述概率分布包括所述n个候选目标文本数据各自对应的概率;

22.根据所述概率分布,确定所述目标文本数据。

23.结合第一方面的第三种实现方式,本公开在第一方面的第四种实现方式中,还包括通过以下至少一项任务,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行预训练:预测两段文本是否是连续文本、预测文本中被遮蔽的部分、预测对文本执行的操作,其中,根据所述至少一项任务中各任务的损失函数确定所述预训练的整体损失函数,根据所述整体损失函数调整所述第一模型、所述第二模型、所述第三模型和所述第四模型的参数。

24.结合第一方面的第四种实现方式,本公开在第一方面的第五种实现方式中,所述预测两段文本是否是连续文本包括:

25.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本样本数据包括两段不连续文本样本数据;

26.基于所述第一训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

27.结合第一方面的第四种实现方式,本公开在第一方面的第六种实现方式中,所述预测文本中被遮蔽的部分包括:

28.获取第二训练样本数据,其中,所述第二训练样本数据包括通过预设掩码方式处理所述第一文本数据获取的第一文本掩码数据和/或通过所述预设掩码方式处理所述第二文本数据获取的第二文本掩码数据;

29.基于所述第二训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

30.结合第一方面的第四种实现方式,本公开在第一方面的第七种实现方式中,所述预测对文本执行的操作包括:

31.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和/或第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本样本数据包括两段不连续文本样本数据;

32.根据所述第一训练样本数据,获取第三训练样本数据,所述第三训练样本数据包

括对所述第一文本样本数据执行特定动作所获取的第三文本样本数据和/或对所述第二文本样本数据执行所述特定动作获取的第四文本样本数据;

33.基于所述第三训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

34.结合第一方面,本公开在第一方面的第八种实现方式中,所述第一模型包括以下模型中任意一个模型:word2vector模型、glove模型,fasttext模型、bert模型。

35.结合第一方面,本公开在第一方面的第九种实现方式中,所述第二模型包括以下模型中任意一个模型:cnn模型、rnn模型、lstm模型、transformer模型、bert模型、注意力模型。

36.结合第一方面的第二种实现方式,本公开在第一方面的第十种实现方式中,所述第三模型包括以下模型中任意一个模型:transformer模型、注意力模型。

37.结合第一方面的第三种实现方式,本公开在第一方面的第十一种实现方式中,所述第四模型包括注意力模型。

38.第二方面,本公开实施例中提供了一种文本处理的方法。

39.具体地,所述文本处理方法,包括:

40.获得具有关联关系的第一文本和第二文本;

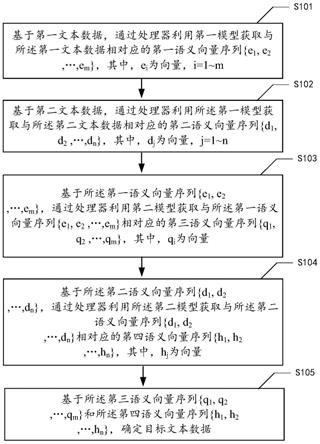

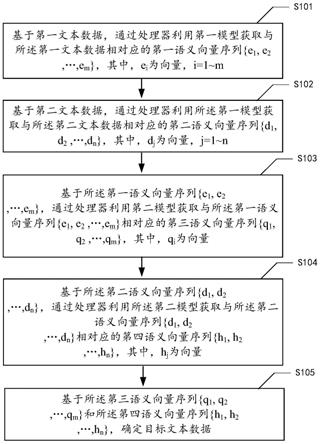

41.获得第一文本的语义向量序列以及第二文本的语义向量序列;

42.对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算和信息聚合,得到所述第一文本和所述第二文本的关联点。

43.结合第二方面,本公开在第二方面的第一种实现方式中,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算,包括:

44.将所述第一文本的语义向量序列和所述第二文本的语义向量序列进行拼接,得到拼接向量;

45.计算所述拼接向量的语义向量序列。

46.结合第二方面的第一种实现方式,本公开在第二方面的第二种实现方式中,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行信息聚合,包括:

47.根据所述拼接向量的语义向量序列得到聚合向量;

48.根据所述聚合向量得到与多个候选关联点相对应的概率分布;

49.根据所述多个候选关联点相对应的概率分布,得到所述第一文本和所述第二文本的关联点。

50.结合第二方面的第二种实现方式,本公开在第二方面的第三种实现方式中,所述根据所述聚合向量得到与多个候选关联点相对应的概率分布,包括:

51.将所述聚合向量输入系统模型的全连接层并经过激活函数作用,得到与多个候选关联点相对应的概率分布。

52.结合第二方面的第三种实现方式,本公开在第二方面的第四种实现方式中,所述方法还包括:

53.对所述系统模型进行预训练;

54.所述预训练包括以下任务的一项或多项:预测两个文本片段是否为连续文本、预测文本中被遮蔽的部分内容、预测对文本执行的操作。

55.结合第二方面的第四种实现方式,本公开在第二方面的第五种实现方式中,所述预测两个文本片段是否为连续文本包括:

56.从第三文本中获得连续的第一片段和第二片段;

57.从所述第三文本中随机选择第三片段;

58.使用所述第三片段替换所述第一片段或所述第二片段;

59.预测所述第三片段与所述第二片段,或者所述第一片段与所述第三片段是否为连续文本。

60.结合第二方面的第四种实现方式,本公开在第二方面的第六种实现方式中,所述预测文本中被遮蔽的部分内容,包括:

61.在所述第一文本和/或所述第二文本中随机选择任意文本片段;

62.以预设的掩码方式处理所述任意文本片段;

63.对处理后的任意文本片段中被遮蔽的部分内容进行预测。

64.结合第二方面的第五种实现方式,本公开在第二方面的第七种实现方式中,所述预测对文本执行的操作包括:

65.在所述第一片段和所述第二片段组成的文本,和/或,所述第一片段和所述第三片段组成的文本,和/或,所述第三片段和所述第二片段组成的文本中,选择任意词进行特定操作;

66.对所述特定操作进行预测,所述特定操作包括删除、替换、无操作。

67.第三方面,本公开实施例中提供了一种文本处理装置。

68.具体地,所述文本处理装置,包括:

69.第一获取模块,被配置为基于第一文本数据,通过处理器利用第一模型获取与所述第一文本数据相对应的第一语义向量序列{e1,e2,

…

,e

m

},其中,e

i

为向量,i=1~m;

70.第二获取模块,被配置为基于第二文本数据,通过处理器利用所述第一模型获取与所述第二文本数据相对应的第二语义向量序列{d1,d2,

…

,d

n

},其中,d

j

为向量,j=1~n;

71.第三获取模块,被配置为基于所述第一语义向量序列{e1,e2,

…

,e

m

},通过处理器利用第二模型获取与所述第一语义向量序列{e1,e2,

…

,e

m

}相对应的第三语义向量序列{q1,q2,

…

,q

m

},其中,q

i

为向量;

72.第四获取模块,被配置为基于所述第二语义向量序列{d1,d2,

…

,d

n

},通过处理器利用所述第二模型获取与所述第二语义向量序列{d1,d2,

…

,d

n

}相对应的第四语义向量序列{h1,h2,

…

,h

n

},其中,h

j

为向量;

73.确定模块,被配置为基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据。

74.结合第三方面,本公开在第三方面的第一种实现方式中,所述第一文本数据和所述第二文本数据包含彼此对应的内容,所述目标文本数据的内容与所述第一文本数据和所述第二文本数据中相对应的内容相关联;和/或

75.所述第二文本数据包括对所述第一文本数据中的至少部分内容的应答,所述目标文本数据包括与所述第一文本数据和/或所述第二文本数据有关的文本数据;和/或

76.所述目标文本数据与所述第一文本数据和所述第二文本数据中彼此有争议的文本数据相关联。

77.结合第三方面,本公开在第三方面的第二种实现方式中,所述基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据,包括:

78.将所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量序列{h1,h2,

…

,h

r

},其中,h

k

为向量,r=n m,k=1~r;

79.基于所述拼接向量序列{h1,h2,

…

,h

r

},通过第三模型,获取第五语义向量序列{v1,v2,

…

,v

r

},其中,v

k

为向量;

80.根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据。

81.结合第三方面的第二种实现方式,本公开在第三方面的第三种实现方式中,所述根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据,包括:

82.基于所述第五语义向量序列{v1,v2,

…

,v

r

},通过第四模型,获取第一聚合向量v1;

83.将所述第一聚合向量v1输入全连接层,获取第二聚合向量v2;

84.将所述第二聚合向量v2经过激活函数作用之后,获取与n个候选目标文本数据相对应的概率分布,所述概率分布包括所述n个候选目标文本数据各自对应的概率;

85.根据所述概率分布,确定所述目标文本数据。

86.结合第三方面的第三种实现方式,本公开在第三方面的第四种实现方式中,还包括:

87.第一预训练模块,被配置为通过以下至少一项任务,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行预训练:预测两段文本是否是连续文本、预测文本中被遮蔽的部分、预测对文本执行的操作,其中,根据所述至少一项任务中各任务的损失函数确定所述预训练的整体损失函数,根据所述整体损失函数调整所述第一模型、所述第二模型、所述第三模型和所述第四模型的参数。

88.结合第三方面的第四种实现方式,本公开在第三方面的第五种实现方式中,所述预测两段文本是否是连续文本包括:

89.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本样本数据包括两段不连续文本样本数据;

90.基于所述第一训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

91.结合第三方面的第四种实现方式,本公开在第三方面的第六种实现方式中,所述预测文本中被遮蔽的部分包括:

92.获取第二训练样本数据,其中,所述第二训练样本数据包括通过预设掩码方式处理所述第一文本数据获取的第一文本掩码数据和/或通过所述预设掩码方式处理所述第二文本数据获取的第二文本掩码数据;

93.基于所述第二训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

94.结合第三方面的第四种实现方式,本公开在第三方面的第七种实现方式中,所述预测对文本执行的操作包括:

95.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和/或第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本

样本数据包括两段不连续文本样本数据;

96.根据所述第一训练样本数据,获取第三训练样本数据,所述第三训练样本数据包括对所述第一文本样本数据执行特定动作所获取的第三文本样本数据和/或对所述第二文本样本数据执行所述特定动作获取的第四文本样本数据;

97.基于所述第三训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

98.结合第三方面,本公开在第三方面的第八种实现方式中,所述第一模型包括以下模型中任意一个模型:word2vector模型、glove模型,fasttext模型、bert模型。

99.结合第三方面,本公开在第三方面的第九种实现方式中,所述第二模型包括以下模型中任意一个模型:cnn模型、rnn模型、lstm模型、transformer模型、bert模型、注意力模型。

100.结合第三方面的第二种实现方式,本公开在第三方面的第十种实现方式中,所述第三模型包括以下模型中任意一个模型:transformer模型、注意力模型。

101.结合第三方面的第三种实现方式,本公开在第三方面的第十一种实现方式中,所述第四模型包括注意力模型。

102.第四方面,本公开实施例中提供了一种文本处理装置。

103.具体地,所述文本处理装置,包括:

104.第五获取模块,被配置为获得具有关联关系的第一文本和第二文本;

105.第六获取模块,被配置为获得第一文本的语义向量序列以及第二文本的语义向量序列;

106.第七获取模块,被配置为对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算和信息聚合,得到所述第一文本和所述第二文本的关联点。

107.结合第四方面,本公开在第四方面的第一种实现方式中,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算,包括:

108.将所述第一文本的语义向量序列和所述第二文本的语义向量序列进行拼接,得到拼接向量;

109.计算所述拼接向量的语义向量序列。

110.结合第四方面的第一种实现方式,本公开在第四方面的第二种实现方式中,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行信息聚合,包括:

111.根据所述拼接向量的语义向量序列得到聚合向量;

112.根据所述聚合向量得到与多个候选关联点相对应的概率分布;

113.根据所述多个候选关联点相对应的概率分布,得到所述第一文本和所述第二文本的关联点。

114.结合第四方面的第二种实现方式,本公开在第四方面的第三种实现方式中,所述根据所述聚合向量得到与多个候选关联点相对应的概率分布,包括:

115.将所述聚合向量输入系统模型的全连接层并经过激活函数作用,得到与多个候选关联点相对应的概率分布。

116.结合第四方面的第三种实现方式,本公开在第四方面的第四种实现方式中,所述装置还包括:

117.第二预训练模块,被配置为对所述系统模型进行预训练;

118.所述预训练包括以下任务的一项或多项:预测两个文本片段是否为连续文本、预测文本中被遮蔽的部分内容、预测对文本执行的操作。

119.结合第四方面的第四种实现方式,本公开在第四方面的第五种实现方式中,所述预测两个文本片段是否为连续文本包括:

120.从第三文本中获得连续的第一片段和第二片段;

121.从所述第三文本中随机选择第三片段;

122.使用所述第三片段替换所述第一片段或所述第二片段;

123.预测所述第三片段与所述第二片段,或者所述第一片段与所述第三片段是否为连续文本。

124.结合第四方面的第四种实现方式,本公开在第四方面的第六种实现方式中,所述预测文本中被遮蔽的部分内容,包括:

125.在所述第一文本和/或所述第二文本中随机选择任意文本片段;

126.以预设的掩码方式处理所述任意文本片段;

127.对处理后的任意文本片段中被遮蔽的部分内容进行预测。

128.结合第四方面的第五种实现方式,本公开在第四方面的第七种实现方式中,所述预测对文本执行的操作包括:

129.在所述第一片段和所述第二片段组成的文本,和/或,所述第一片段和所述第三片段组成的文本,和/或,所述第三片段和所述第二片段组成的文本中,选择任意词进行特定操作;

130.对所述特定操作进行预测,所述特定操作包括删除、替换、无操作。

131.第五方面,本公开实施例提供了一种电子设备,包括存储器和处理器,其中,所述存储器用于存储一条或多条计算机指令,其中,所述一条或多条计算机指令被所述处理器执行以实现如第一方面、第一方面的第一种实现方式至第十一种实现方式、第二方面、第二方面的第一种实现方式至第七种实现方式任一项所述的方法。

132.第六方面,本公开实施例中提供了一种计算机可读存储介质,其上存储有计算机指令,该计算机指令被处理器执行时实现如第一方面、第一方面的第一种实现方式至第十一种实现方式、第二方面、第二方面的第一种实现方式至第七种实现方式任一项所述的方法。

133.根据本公开实施例提供的技术方案,获得具有关联关系的第一文本和第二文本,获得第一文本的语义向量序列以及第二文本的语义向量序列,对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算和信息聚合,得到所述第一文本和所述第二文本的关联点。本公开的实施例可以应用于法院庭审应用场景,通过起诉书和答辩状的各自上下文语义信息以及交互语义信息,获取可以推荐给法官进行候选的争议焦点,从而使获取的争议焦点可以与起诉书和答辩状的语义信息相对应,并可以提高推荐的争议焦点的准确度。

134.应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

附图说明

135.结合附图,通过以下非限制性实施方式的详细描述,本公开的其它特征、目的和优点将变得更加明显。在附图中:

136.图1示出根据本公开的实施例的文本处理方法的流程图;

137.图2示出根据本公开实施例的基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据的示意图;

138.图3示出根据本公开实施例的将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行预训练的示意图;

139.图4示出根据本公开实施例的文本处理方法的应用场景示意图;

140.图5示出根据本公开的实施例的文本处理方法的流程图;

141.图6示出根据本公开实施例的对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算和信息聚合,得到所述第一文本和所述第二文本的关联点的示意图;

142.图7示出根据本公开实施例的对所述系统模型进行预训练的示意图;

143.图8示出根据本公开实施例的文本处理方法的应用场景示意图;

144.图9示出根据本公开的实施例的文本处理装置的结构框图;

145.图10示出根据本公开的实施例的文本处理装置的结构框图;

146.图11示出根据本公开的实施例的电子设备的结构框图;

147.图12示出适于用来实现根据本公开实施例的文本处理方法的计算机系统的结构示意图。

具体实施方式

148.下文中,将参考附图详细描述本公开的示例性实施例,以使本领域技术人员可容易地实现它们。此外,为了清楚起见,在附图中省略了与描述示例性实施例无关的部分。

149.在本公开中,应理解,诸如“包括”或“具有”等的术语旨在指示本说明书中所公开的特征、数字、步骤、行为、部件、部分或其组合的存在,并且不欲排除一个或多个其他特征、数字、步骤、行为、部件、部分或其组合存在或被添加的可能性。

150.另外还需要说明的是,在不冲突的情况下,本公开中的实施例及实施例中的特征可以相互组合。下面将参考附图并结合实施例来详细说明本公开。

151.法律知识图谱是关联事实与法律知识的纽带,图谱中存储着法律相关的知识节点,比如本金争议、利息约定、抵押担保、夫妻共同债务等,这些节点是法律知识体系中的重要概念与抽象。通常,法律知识图谱具有树状或网状的拓扑结构,用于表达复杂的法律关系,如利息-还清部分借款利息,违约损失-律师费、调查费等其他损失等。知识图谱的构建既可以由算法自动构建,也可以人工构建。而争议焦点的生成,可以看成由原被告的起诉书、答辩状内容,映射到图谱中的某个知识节点,进而把非结构化的文本信息进行结构化。每个节点即对应一个争议焦点。由于客观事实文本为非结构化的文本,不具有树状或者网状等拓扑结构,因此,如何基于非结构化的客观事实文本获取争议焦点成为亟待解决的技术问题。

152.需要注意的是,本公开的技术方案可以用于处理非结构化的文本,也可以用于处

理结构化的文本。

153.图1示出根据本公开的实施例的文本处理方法的流程图。如图1所示,所述文本处理方法包括以下步骤s101-s105:

154.在步骤s101中,基于第一文本数据,通过处理器利用第一模型获取与所述第一文本数据相对应的第一语义向量序列{e1,e2,

…

,e

m

},其中,e

i

为向量,i=1~m;

155.在步骤s102中,基于第二文本数据,通过处理器利用所述第一模型获取与所述第二文本数据相对应的第二语义向量序列{d1,d2,

…

,d

n

},其中,d

j

为向量,j=1~n;

156.在步骤s103中,基于所述第一语义向量序列{e1,e2,

…

,e

m

},通过处理器利用第二模型获取与所述第一语义向量序列{e1,e2,

…

,e

m

}相对应的第三语义向量序列{q1,q2,

…

,q

m

},其中,q

i

为向量;

157.在步骤s104中,基于所述第二语义向量序列{d1,d2,

…

,d

n

},通过处理器利用所述第二模型获取与所述第二语义向量序列{d1,d2,

…

,d

n

}相对应的第四语义向量序列{h1,h2,

…

,h

n

},其中,h

j

为向量;

158.在步骤s105中,基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据。

159.根据本公开的实施例,所述第一文本数据和所述第二文本数据包含彼此对应的内容;和/或所述第二文本数据包括对所述第一文本数据中的至少部分内容的应答。

160.根据本公开的实施例,可以获取第一文本数据和第二文本数据,其中,第一文本数据和第二文本数据可以包含彼此对应的内容,例如,包含相同或相近的主题。或者,第二文本数据可以包括对第一文本数据中的至少部分内容的应答,例如第二文本数据可以包括第一文本数据的答复文本数据。例如,在法院庭审应用场景中,第一文本数据可以包括原告的起诉书,第二文本数据可以包括被告的答辩状。

161.根据本公开的实施例,可以对第一文本数据进行分词处理,获取第一分词数据集合,其中,第一分词数据集合包括第一文本数据的分词结果,本公开对分词处理方法不做具体限定,可以根据实际需要进行选择。

162.根据本公开的实施例,为了获取第一文本数据的语义信息,可以利用第一模型获取与第一分词数据集合中的每个分词相对应的向量表示,并获取第一语义向量序列{e1,e2,

…

,e

m

},其中,e

i

为第i个分词的词向量,从而通过第一模型引入第一文本数据的语义信息。本公开对第一模型不做具体限定,只要可以实现将文本数据转换为嵌入(embedding)向量的模型均在本公开实施例的保护范围之内,比如,第一模型可以包括以下模型中任意一个模型:word2vector模型、glove模型,fasttext模型或bert(bidirectional encoder representations from transformers,基于变换器的双向编码器表示)模型等。

163.根据本公开的实施例,可以对第二文本数据进行分词处理,获取第二分词数据集合,其中,第二分词数据集合包括第二文本数据的分词结果,本公开对分词处理方法不做具体限定,可以根据实际需要进行选择。为了获取第二文本数据的语义信息,可以利用第一模型获取与第二分词数据集合中的每个分词相对应的向量表示,并获取第二语义向量序列{d1,d2,

…

,d

n

},其中,d

j

为第j个分词的词向量,从而通过第一模型引入第二文本数据的语义信息。

164.根据本公开的实施例,为了获取第一文本数据的上下文语义信息,可以利用第二

模型,基于包含了第一文本数据语义信息的第一语义向量序列{e1,e2,

…

,e

m

},通过学习m个向量e

i

之间的内部关联关系,获取第三语义向量序列{q1,q2,

…

,q

m

},其中,q

i

为向量,从而通过第二模型引入第一文本数据的上下文语义信息。第二模型可以为训练好的深度学习模型,本公开对其不做具体限定,可以根据实际需要进行选择,例如,第二模型可以包括以下模型中任意一个模型:cnn模型、rnn模型、lstm模型、transformer模型、bert模型、注意力模型等,其中,注意力模型可以包括自注意力模型(self attention)、多头注意力模型(multi-head attention)或han(hierarchical attention networks,多层注意力)模型等。

165.根据本公开的实施例,为了获取第二文本数据的上下文语义信息,可以利用第二模型,基于包含了第二文本数据语义信息的第二语义向量序列{d1,d2,

…

,d

n

},通过学习n个向量d

j

之间的内部关联关系,获取第四语义向量序列{h1,h2,

…

,h

n

},其中,h

j

为向量,从而通过第二模型引入第二文本数据的上下文语义信息。

166.根据本公开的实施例,可以根据包含了第一文本数据的上下文语义信息的第三语义向量序列{q1,q2,

…

,q

m

},以及包含了第二文本数据的上下文语义信息的第四语义向量序列{h1,h2,

…

,h

n

},获取第一文本数据和第二文本数据的交互语义信息,并基于第一文本数据和第二文本数据的交互语义信息确定目标文本数据。

167.根据本公开的实施例,所述目标文本数据的内容与所述第一文本数据和/或所述第二文本数据相关联;和/或所述目标文本数据包括与所述第一文本数据和/或所述第二文本数据有关的文本数据;和/或所述目标文本数据与所述第一文本数据和所述第二文本数据中彼此有争议的文本数据相关联。

168.根据本公开的实施例,目标文本数据的内容与第一文本数据和/或第二文本数据相关联,例如,第一文本数据和第二文本数据包含彼此对应的内容时,目标文本数据的内容可以与上述彼此对应的内容相关联。

169.或者,目标文本数据可以包括与第一文本数据和/或第二文本数据有关的文本数据,例如,第二文本数据包括对第一文本数据中的至少部分内容的应答时,目标文本数据可以包括与上述至少部分内容和/或应答内容有关的文本数据。

170.或者,目标文本数据可以包括与第一文本数据和第二文本数据中彼此有争议的文本数据相关联,例如,第一文本数据和第二文本数据包含彼此有争议的文本数据时,目标文本数据可以与上述彼此有争议的文本数据相关联。

171.例如,在法院庭审应用场景中,第一文本数据可以包括原告的起诉书,第二文本数据可以包括被告的答辩状,目标文本数据可以包括根据起诉书和答辩状提取的多个争议焦点。

172.根据本公开实施例提供的技术方案,基于第一文本数据,通过处理器利用第一模型获取与第一文本数据相对应的第一语义向量序列{e1,e2,

…

,e

m

},基于第二文本数据,通过处理器利用第一模型获取与第二文本数据相对应的第二语义向量序列{d1,d2,

…

,d

n

},基于第一语义向量序列{e1,e2,

…

,e

m

},通过处理器利用第二模型获取与第一语义向量序列{e1,e2,

…

,e

m

}相对应的第三语义向量序列{q1,q2,

…

,q

m

},基于第二语义向量序列{d1,d2,

…

,d

n

},通过处理器利用第二模型获取与第二语义向量序列{d1,d2,

…

,d

n

}相对应的第四语义向量序列{h1,h2,

…

,h

n

},基于第三语义向量序列{q1,q2,

…

,q

m

}和第四语义向量序列

{h1,h2,

…

,h

n

},确定目标文本数据。本公开的实施例通过第一文本数据和第二文本数据的各自上下文语义信息以及交互语义信息,获取目标文本数据,从而可以使获取的目标文本数据可以与第一文本数据和第二文本数据的语义信息相对应,并可以提高目标文本数据的准确度。本公开的实施例可以应用于法院庭审应用场景,通过起诉书和答辩状的各自上下文语义信息以及交互语义信息,获取可以推荐给法官进行候选的争议焦点,从而使获取的争议焦点可以与起诉书和答辩状的语义信息相对应,并可以提高推荐的争议焦点的准确度。

173.根据本公开的实施例,所述步骤s105,即基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据,包括:

174.将所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量序列{h1,h2,

…

,h

r

},其中,h

k

为向量,r=n m,k=1~r;

175.基于所述拼接向量序列{h1,h2,

…

,h

r

},通过第三模型,获取第五语义向量序列{v1,v2,

…

,v

r

},其中,v

k

为向量;

176.根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据。

177.图2示出根据本公开实施例的基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据的示意图。

178.如图2所示,为了获取第一文本数据与第二文本数据的语义信息,可以将包含了第一文本数据的上下文语义信息的第三语义向量序列{q1,q2,

…

,q

m

}以及包含了第二文本数据的上下文语义信息的第四语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量序列{h1,h2,

…

,h

r

}。

179.根据本公开的实施例,为了获取第一文本数据与二文本数据的交互语义信息,可以利用第三模型,基于包含了第一文本数据与二文本数据的上下文语义信息的拼接向量序列{h1,h2,

…

,h

r

},通过学习r个向量h

k

之间的相互关联关系,获取第五语义向量序列{v1,v2,

…

,v

r

},其中,第五语义向量序列{v1,v2,

…

,v

r

}可以用于表征以下至少一种或多种语义信息:第一文本数据的上下文语义信息、第二文本数据的上下文语义信息、第一文本数据与第二文本数据的交互语义信息。第三模型可以为训练好的深度学习模型,本公开对其不做具体限定,可以根据实际需要进行选择,例如,第三模型可以包括以下模型中任意一个模型:transformer模型、注意力模型等,其中,注意力模型可以包括自注意力模型、多头注意力模型或han模型等。

180.根据本公开的实施例,所述根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据,包括:

181.基于所述第五语义向量序列{v1,v2,

…

,v

r

},通过第四模型,获取第一聚合向量v1;

182.将所述第一聚合向量v1输入全连接层,获取第二聚合向量v2;

183.将所述第二聚合向量v2经过激活函数作用之后,获取与n个候选目标文本数据相对应的概率分布,所述概率分布包括所述n个候选目标文本数据各自对应的概率;

184.根据所述概率分布,确定所述目标文本数据。

185.如图2所示,为了有效提取第五语义向量序列{v1,v2,

…

,v

r

}的关键语义特征,可以利用第四模型,分别获取r个向量v

k

在第五语义向量序列{v1,v2,

…

,v

r

}中相对应的权重,通过对r个向量v

k

以及相对应的权重进行加权求和,获取第一聚合向量v1。第四模型202可以为

训练好的注意力模型,本公开对其不做具体限定,可以根据实际需要进行选择,例如,第四模型202可以包括以下模型中任意一个模型:自注意力模型、多头注意力模型或han模型等。

186.根据本公开的实施例,可以将包括第一文本数据语义信息与第二文本数据语义信息的第一聚合向量v1,与预设的文本数据之间建立映射关系。例如,可以预先确定n个候选目标文本数据,根据第一聚合向量v1在n个候选目标文本数据中确定目标文本数据。

187.根据本公开的实施例,可以将第一聚合向量v1输入至全连接层,获取第二聚合向量v2,其中,第二聚合向量v2的维度与候选目标文本数据的数量相同,即第二聚合向量v2的维度为n。

188.例如,在法院庭审应用场景中,可以在法律知识图谱的拓扑结构节点上确定n个争议焦点,比如,“借款催讨”、“夫妻共同债务”等争议焦点。可以将法律知识图谱中的争议焦点作为候选目标文本数据,基于第一聚合向量v1在候选目标文本数据中确定与起诉书和答辩状相关的目标文本数据,即起诉书和答辩状的争议焦点。

189.根据本公开的实施例,可以将第二聚合向量v2经过激活函数作用之后,获取概率分布,其中,概率分布表示n个候选目标文本数据属于目标文本数据的概率。某个候选目标文本数据对应的概率越大,代表该候选目标文本数据属于目标文本数据的可能性越大。

190.根据本公开的实施例,根据概率分布,可以将k个候选目标文本数据确定为目标文本数据。例如,可以将概率分布中最高的k个概率相对应的候选目标文本数据确定为目标文本数据,其中,1≤k≤n且为整数。

191.例如,在法院庭审应用场景中,第一文本数据可以包括原告的起诉书,第二文本数据可以包括被告的答辩状,可以利用起诉书和答辩状获取第五语义向量序列{v1,v2,

…

,v

r

},并基于第五语义向量序列{v1,v2,

…

,v

r

}以及法律知识图谱的n个争议焦点,确定k个争议焦点。

192.由于本公开的实施例中的文本处理方法涉及到第一模型、第二模型、第三模型和第四模型,在预训练第一模型、第二模型、第三模型和第四模型时,这些模型包括大量的参数,且大部分参数都是随机初始化的。当本公开的实施例的文本处理方法应用的技术领域或者应用场景包括的训练数据较少时,例如,当本公开的实施例的文本处理方法运用到法院庭审的应用场景时,由于可以获取的起诉书或者答辩状等训练数据不多,导致根据随机初始化的参数训练第一模型、第二模型、第三模型和第四模型时,很难收敛或者不能获取预期的训练效果。

193.根据本公开的实施例,还包括通过以下至少一项任务,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行预训练:预测两段文本是否是连续文本、预测文本中被遮蔽的部分、预测对文本执行的操作,其中,根据所述至少一项任务中各任务的损失函数确定所述预训练的整体损失函数,根据所述整体损失函数调整所述第一模型、所述第二模型、所述第三模型和所述第四模型的参数。

194.图3示出根据本公开实施例的将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行预训练的示意图。

195.如图3所示,为了使本公开的实施例中的文本处理方法所涉及的第一模型、第二模型、第三模型和第四模型获取更好的初始化参数,提高模型收敛效率和预期训练效果,可以通过以下一项或多项任务,将第一模型、第二模型、第三模型和第四模型作为整体进行预训

练:第一任务301即预测两段文本是否是连续文本、第二任务302即预测文本中被遮蔽的部分、第三任务303即预测对文本执行的操作。

196.根据本公开的实施例,可以根据至少一项任务中各任务的损失函数确定预训练的整体损失函数,例如通过对各任务的损失函数求和来确定预训练的整体损失函数。例如,假设预训练仅包括第一任务301时,可以根据第一任务301的损失函数确定预训练的整体损失函数;又例如,假设包括第一任务301、第二任务302和第三任务303时,可以对第一任务301、第二任务302和第三任务303的损失函数求和来确定预训练的整体损失函数。可以根据整体损失函数调整第一模型、第二模型、第三模型和第四模型的参数,以便于使第一模型、第二模型、第三模型和第四模型获取更好的初始化参数,从而提高模型收敛效率和预期训练效果。

197.根据本公开的实施例,所述预测两段文本是否是连续文本包括:

198.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本样本数据包括两段不连续文本样本数据;

199.基于所述第一训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

200.如图3所示,为了实现第一任务301即预测两段文本是否是连续文本的训练目标,可以获取第一训练样本数据。本公开对第一训练样本数据的来源以及获取方式不做具体限定。

201.根据本公开的实施例,可以基于第一文本数据和/或第二文本数据获取第一训练样本数据。比如,第一文本数据包括起诉书a,第二文本数据包括答辩状b,可以在起诉书a和/或答辩状b中随机抽取两段连续文本样本数据(a1,b1),即可以获取第一文本样本数据。可以以一定的概率在起诉书a和/或答辩状b中随机选择一段其他的文本样本数据c1,并用文本样本数据c1替换文本样本数据a1或文本样本数据b1,从而获取两段不连续文本样本数据(c1,b1)或(a1,c1),即第二文本样本数据。

202.根据本公开的实施例,还可以不基于第一文本数据和/或第二文本数据获取第一训练样本数据,例如,可以从以下任意一个或多个文本数据中获取第一训练样本数据:其他起诉书(不包括起诉书a)、其他答辩状(不包括答辩状b)、其他法律文件(不包括起诉书和答辩状类型文件,比如,公开的裁判文件等),从而可以增加训练样本数据的数量。

203.根据本公开的实施例,可以基于第一训练样本数据,将第一模型、第二模型、第三模型和第四模型作为整体进行训练,以便于获取两段文本的相互关联关系,例如,句子与句子之间的相互关联关系。

204.根据本公开的实施例,所述预测文本中被遮蔽的部分包括:

205.获取第二训练样本数据,其中,所述第二训练样本数据包括通过预设掩码方式处理所述第一文本数据获取的第一文本掩码数据和/或通过所述预设掩码方式处理所述第二文本数据获取的第二文本掩码数据;

206.基于所述第二训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

207.如图3所示,为了实现第二任务302即预测文本中被遮蔽的部分的训练目标,可以

获取第二训练样本数据,本公开对第二训练样本数据的来源以及获取方式不做具体限定。

208.根据本公开的实施例,可以基于第一文本数据和/或第二文本数据获取第二训练样本数据。比如,第一文本数据包括起诉书a,第二文本数据包括答辩状b,可以在起诉书a中随机抽取一段文本样本数据a2,可以在答辩状b中随机抽取一段文本样本数据b2。可以通过预设掩码方式处理文本样本数据a2获取第一文本掩码数据,例如,以一定的概率随机选择文本样本数据a2中预设比例的分词,采用掩码(mask)代替原始分词,从而获取第一文本掩码数据。可以采用上述预设掩码方式处理文本样本数据b2获取第二文本掩码数据。

209.根据本公开的实施例,可以基于第二训练样本数据,将第一模型、第二模型、第三模型和第四模型作为整体进行训练,以便于获取文本中两个分词的相互关联关系,和/或分词与文本的相互关联关系,例如,词与词之间的相互关联关系,和/或词与句子之间的相互关联关系。

210.根据本公开的实施例,所述预测对文本执行的操作包括:

211.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和/或第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本样本数据包括两段不连续文本样本数据;

212.根据所述第一训练样本数据,获取第三训练样本数据,所述第三训练样本数据包括对所述第一文本样本数据执行特定动作所获取的第三文本样本数据和/或对所述第二文本样本数据执行所述特定动作获取的第四文本样本数据;

213.基于所述第三训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

214.如图3所示,为了实现第三任务303即预测对文本执行的操作的训练目标,可以基于第一训练样本数据获取第三训练样本数据,本公开对第一训练样本数据和第三训练样本数据的来源以及获取方式不做具体限定。

215.根据本公开的实施例,可以基于第一文本数据和/或第二文本数据获取第一训练样本数据。比如,第一文本数据包括起诉书a,第二文本数据包括答辩状b,可以在起诉书a和/或答辩状b中随机抽取两段连续文本样本数据(a1,b1),即可以获取第一文本样本数据。可以以一定的概率在起诉书a和/或答辩状b中随机选择一段其他的文本样本数据c1,并用文本样本数据c1替换文本样本数据a1或文本样本数据b1,从而获取两段不连续文本样本数据(c1,b1)或(a1,c1),即第二文本样本数据。

216.根据本公开的实施例,还可以不基于第一文本数据和/或第二文本数据获取第一训练样本数据,例如,可以从以下任意一个或多个文本数据中获取第一训练样本数据:其他起诉书(不包括起诉书a)、其他答辩状(不包括答辩状b)、其他法律文件(不包括起诉书和答辩状类型文件,比如,公开的裁判文件等),从而可以增加训练样本数据的数量。

217.根据本公开的实施例,可以基于第一训练样本数据,获取第三训练样本。可以对第一文本样本数据执行特定动作获取第三文本样本数据,和/或对第二文本样本数据执行特定动作获取第四文本样本数据,其中,特定动作包括但不限于“删除”、“替换”或“无操作”。例如,对于第一文本样本数据(a1,b1)中的分词可以进行随机的删除或替换,或者不执行任何的操作,获取第三文本样本数据。或者,对于第二文本样本数据(c1,b1)或(a1,c1)中的词可以进行随机的删除或替换,或者不执行任何的操作,获取第四文本样本数据。

218.根据本公开的实施例,可以基于第三训练样本数据,将第一模型、第二模型、第三模型和第四模型作为整体进行训练,在不依赖于人工标注数据的情形下,可以使预训练的第一模型、第二模型、第三模型和第四模型的参数收敛至更好的范围,从而提高预训练的第一模型、第二模型、第三模型和第四模型的鲁棒性。

219.图4示出根据本公开实施例的文本处理方法的应用场景示意图。如图4所示,应用场景包括服务器400,为了描述的方便,图4的应用场景中仅绘制了一个服务器400,应当了解的是,该示例仅为示例使用,并非是对于本公开的限制,本公开中的服务器400的数量、种类可以根据实际需要进行设定,本公开对此不作具体限定。同时,本公开实施例的应用场景将以法院庭审为例进行说明,但本公开不限于此,而是也适用于其他应用场景。

220.服务器400可以获取第一文本数据(起诉书)和第二文本数据(答辩状)。为了获取起诉书和答辩状各自的语义信息,基于起诉书,可以利用第一模型获取与起诉书相对应的第一语义向量序列{e1,e2,

…

,e

m

},其中,第一语义向量序列{e1,e2,

…

,e

m

}可以用于表征起诉书的语义信息;基于答辩状,可以利用第一模型获取与答辩状相对应的第二语义向量序列{d1,d2,

…

,d

n

},其中,第二语义向量序列{d1,d2,

…

,d

n

}可以用于表征答辩状的语义信息。

221.根据本公开的实施例,为了获取起诉书和答辩状各自的上下文语义信息,基于第一语义向量序列{e1,e2,

…

,e

m

},可以利用第二模型获取与第一语义向量序列{e1,e2,

…

,e

m

}相对应的第三语义向量序列{q1,q2,

…

,q

m

},其中,第三语义向量序列{q1,q2,

…

,q

m

}可以用于表征起诉书的上下文语义信息;基于第二语义向量序列{d1,d2,

…

,d

n

},可以利用第二模型获取与第二语义向量序列{d1,d2,

…

,d

n

}相对应的第四语义向量序列{h1,h2,

…

,h

n

},其中,第四语义向量序列{h1,h2,

…

,h

n

}可以用于表征答辩状的上下文语义信息。

222.根据本公开的实施例,为了获取起诉书和答辩状的交互语义信息,可以将第三语义向量序列{q1,q2,

…

,q

m

}以及第四语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量序列{h1,h2,

…

,h

r

}。基于拼接向量序列{h1,h2,

…

,h

r

},可以利用第三模型,获取第五语义向量序列{v1,v2,

…

,v

r

},其中,第五语义向量序列{v1,v2,

…

,v

r

}可以用于表征以下至少一种或多种语义信息:起诉书的上下文语义信息、答辩状的上下文语义信息、起诉书与答辩状的交互语义信息。

223.根据本公开的实施例,为了有效提取第五语义向量序列{v1,v2,

…

,v

r

}的关键语义特征,可以利用第四模型,获取第一聚合向量v1。可以将第一聚合向量v1输入至全连接层,获取第二聚合向量v2,从而可以将第一聚合向量v1映射到法律知识图谱的n个争议焦点所在空间。第二聚合向量v2经过激活函数作用之后,可以获取候选争议焦点属于n个争议焦点中的某个争议焦点的相应概率,从而根据上述概率分布,确定k个争议焦点。

224.本公开的实施例可以应用于法院庭审应用场景,通过起诉书和答辩状的各自上下文语义信息以及交互语义信息,获取可以推荐给法官进行候选的争议焦点,从而使获取的争议焦点可以与起诉书和答辩状的语义信息相对应,并可以提高推荐的争议焦点的准确度。

225.图5示出根据本公开的实施例的文本处理方法的流程图。如图5所示,所述文本处理方法包括以下步骤s501-s503:

226.在步骤s501中,获得具有关联关系的第一文本和第二文本;

227.在步骤s502中,获得第一文本的语义向量序列以及第二文本的语义向量序列;

228.在步骤s503中,对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算和信息聚合,得到所述第一文本和所述第二文本的关联点。

229.根据本公开的实施例,所述第一文本和所述第二文本包含彼此对应的内容;和/或所述第二文本包括对所述第一文本中的至少部分内容的应答。

230.根据本公开的实施例,可以获取具有关联关系的第一文本和第二文本,其中,第一文本和第二文本可以包含彼此对应的内容,例如,包含相同或相近的主题。或者,第二文本可以包括对第一文本中的至少部分内容的应答,例如第二文本可以包括第一文本的答复文本数据。例如,在法院庭审应用场景中,第一文本可以包括原告的起诉书,第二文本可以包括被告的答辩状。

231.根据本公开的实施例,可以对第一文本进行分词处理,获取第一分词集合,其中,第一分词集合包括第一文本的分词结果,本公开对分词处理方法不做具体限定,可以根据实际需要进行选择。

232.根据本公开的实施例,为了获取第一文本的语义信息,可以利用第一模型获取与第一分词集合中的每个分词相对应的向量表示,并获取第一语义向量序列{e1,e2,

…

e

m

},其中,e

i

为第i个分词的词向量,i=1~m,从而通过第一模型引入第一文本的语义信息。本公开对第一模型不做具体限定,只要可以实现将文本数据转换为嵌入(embedding)向量的模型均在本公开实施例的保护范围之内,比如,第一模型可以包括以下模型中任意一个模型:word2vector模型、glove模型,fasttext模型或bert(bidirectional encoder representations from transformers,基于变换器的双向编码器表示)模型等。

233.根据本公开的实施例,可以对第二文本进行分词处理,获取第二分词集合,其中,第二分词集合包括第二文本的分词结果,本公开对分词处理方法不做具体限定,可以根据实际需要进行选择。为了获取第二文本的语义信息,可以利用第一模型获取与第二分词集合中的每个分词相对应的向量表示,并获取第二语义向量序列{d1,d2,

…

,d

n

},其中,d

j

为第j个分词的词向量,j=1~n,从而通过第一模型引入第二文本的语义信息。

234.根据本公开的实施例,为了获取第一文本的上下文语义信息,可以利用第二模型,基于包含了第一文本语义信息的第一语义向量序列{e1,e2,

…

,e

m

},通过学习m个向量e

i

之间的内部关联关系,获取第一文本的语义向量序列{q1,q2,

…

,q

m

},其中,q

i

为向量,从而通过第二模型引入第一文本的上下文语义信息。第二模型可以为训练好的深度学习模型,本公开对其不做具体限定,可以根据实际需要进行选择,例如,第二模型可以包括以下模型中任意一个模型:cnn模型、rnn模型、lstm模型、transformer模型、bert模型、注意力模型等,其中,注意力模型可以包括自注意力模型(self attention)、多头注意力模型(multi-head attention)或han(hierarchical attention networks,多层注意力)模型等。

235.根据本公开的实施例,为了获取第二文本的上下文语义信息,可以利用第二模型,基于包含了第二文本语义信息的第二语义向量序列{d1,d2,

…

,d

n

},通过学习n个向量d

j

之间的内部关联关系,获取第二文本的语义向量序列{h1,h2,

…

,h

n

},其中,h

j

为向量,从而通过第二模型引入第二文本的上下文语义信息。

236.根据本公开的实施例,可以对包含了第一文本的上下文语义信息的第一文本的语义向量序列{q1,q2,

…

,q

m

},以及包含了第二文本的上下文语义信息的第二文本的语义向量序列{h1,h2,

…

,h

n

},进行交互计算和信息聚合,从而获取第一文本和第二文本的交互语义

信息,并基于第一文本和第二文本的交互语义信息确定第一文本和第二文本的关联点。

237.根据本公开的实施例,所述关联点与所述第一文本和/或所述第二文本相关联;和/或所述关联点包括与所述第一文本和/或所述第二文本有关的文本;和/或所述关联点与所述第一文本和所述第二文本中彼此有争议的文本相关联。

238.根据本公开的实施例,关联点与第一文本和/或第二文本相关联,例如,第一文本和第二文本包含彼此对应的内容时,关联点可以与上述彼此对应的内容相关联。

239.或者,关联点可以包括与第一文本和/或第二文本有关的文本,例如,第二文本包括对第一文本中的至少部分内容的应答时,关联点可以包括与上述至少部分内容和/或应答内容有关的文本数据。

240.或者,关联点可以包括与第一文本和第二文本中彼此有争议的文本相关联,例如,第一文本和第二文本包含彼此有争议的文本时,关联点可以与上述彼此有争议的文本相关联。

241.例如,在法院庭审应用场景中,第一文本可以包括原告的起诉书,第二文本可以包括被告的答辩状,关联点可以包括根据起诉书和答辩状提取的多个争议焦点。

242.根据本公开实施例提供的技术方案,获得具有关联关系的第一文本和第二文本,并获得第一文本的语义向量序列以及第二文本的语义向量序列,通过对第一文本的语义向量序列和第二文本的语义向量序列进行交互计算和信息聚合,得到第一文本和第二文本的关联点。本公开的实施例通过第一文本和第二文本的语义信息,获取关联点,从而可以使获取的关联点可以与第一文本和第二文本的语义信息相对应,并可以提高关联点的准确度。本公开的实施例可以应用于法院庭审应用场景,通过起诉书和答辩状的语义信息,获取可以推荐给法官进行候选的争议焦点,从而使获取的争议焦点可以与起诉书和答辩状的语义信息相对应,并可以提高推荐的争议焦点的准确度。

243.图6示出根据本公开实施例的对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算和信息聚合,得到所述第一文本和所述第二文本的关联点的示意图。

244.根据本公开的实施例,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算,包括:

245.将所述第一文本的语义向量序列和所述第二文本的语义向量序列进行拼接,得到拼接向量;

246.计算所述拼接向量的语义向量序列。

247.如图6所示,可以将包含了第一文本的上下文语义信息的第一文本的语义向量序列{q1,q2,

…

,q

m

}以及包含了第二文本的上下文语义信息的第二文本的语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量{h1,h2,

…

,h

r

},r=n m。

248.根据本公开的实施例,为了获取第一文本与第二文本的交互语义信息,可以利用第三模型601,基于包含了第一文本与第二文本的上下文语义信息的拼接向量{h1,h2,

…

,h

r

},通过学习r个向量h

k

之间的相互关联关系,k=1~r,获取拼接向量的语义向量序列{v1,v2,

…

,v

r

},其中,拼接向量的语义向量序列{v1,v2,

…

,v

r

}可以用于表征以下至少一种或多种语义信息:第一文本的上下文语义信息、第二文本的上下文语义信息、第一文本与第二文本的交互语义信息。第三模型可以为训练好的深度学习模型,本公开对其不做具体限定,可

以根据实际需要进行选择,例如,第三模型可以包括以下模型中任意一个模型:transformer模型、注意力模型等,其中,注意力模型可以包括自注意力模型、多头注意力模型或han模型等。

249.根据本公开的实施例,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行信息聚合,包括:

250.根据所述拼接向量的语义向量序列得到聚合向量;

251.根据所述聚合向量得到与多个候选关联点相对应的概率分布;

252.根据所述多个候选关联点相对应的概率分布,得到所述第一文本和所述第二文本的关联点。

253.如图6所示,为了有效提取拼接向量的语义向量序列{v1,v2,

…

,v

r

}的关键语义特征,可以利用第四模型,分别获取r个向量v

k

在拼接向量的语义向量序列{v1,v2,

…

,v

r

}中相对应的权重,通过对r个向量v

k

以及相对应的权重进行加权求和,获取聚合向量v1。第四模型可以为训练好的注意力模型,本公开对其不做具体限定,可以根据实际需要进行选择,例如,第四模型可以包括以下模型中任意一个模型:自注意力模型、多头注意力模型或han模型等。

254.根据本公开的实施例,可以预设多个候选关联点,例如,在法院庭审应用场景中,可以在法律知识图谱的拓扑结构节点上确定n个争议焦点,比如,“借款催讨”、“夫妻共同债务”等争议焦点,可以将法律知识图谱中的n个争议焦点作为n个候选关联点。

255.根据本公开的实施例,可以将包括第一文本与第二文本交互语义信息的聚合向量v1,与预设的多个候选关联点之间建立映射关系,从而获取多个候选关联点相对应的概率分布,其中,概率分布表示该候选关联点属于第一文本和第二文本的关联点的概率。某个候选关联点的相应概率越大,代表该候选关联点属于第一文本和所第二文本的关联点的可能性越大。例如,可以预设n个候选关联点,并根据聚合向量v1,得到n个候选关联点相对应的概率分布,比如,在法院庭审应用场景中,可以在法律知识图谱的拓扑结构节点上确定n个争议焦点,并根据聚合向量v1,得到n个争议焦点相对应的概率分布。

256.根据本公开的实施例,根据多个候选关联点相对应的概率分布,可以将其中一个或者多个概率较大的候选关联点确定为第一文本和第二文本的关联点。例如,在获取n个候选关联点相对应的概率分布之后,可以将概率分布中最大的k个概率相对应的候选关联点确定为关联点,其中,1≤k≤n且为整数。

257.例如,在法院庭审应用场景中,第一文本可以包括原告的起诉书,第二文本可以包括被告的答辩状,可以利用起诉书和答辩状获取拼接向量的语义向量序列{v1,v2,

…

,v

r

},并基于拼接向量的语义向量序列{v1,v2,

…

,v

r

}得到聚合向量v1,可以根据聚合向量v1以及法律知识图谱的n个争议焦点,得到n个争议焦点相对应的概率分布,从而确定第一文本和第二文本的k个关联点,即k个争议焦点。

258.根据本公开的实施例,所述根据所述聚合向量得到与多个候选关联点相对应的概率分布,包括:

259.将所述聚合向量输入系统模型的全连接层并经过激活函数作用,得到与多个候选关联点相对应的概率分布。

260.根据本公开的实施例,可以将聚合向量v1输入系统模型的全连接层,获取全连接

向量v2,其中,全连接向量v2的维度与多个候选关联点的数量相同,例如,假设有n个候选关联点,则全连接向量v2的维度为n。可以将全连接向量v2经过激活函数作用,得到与多个候选关联点相对应的概率分布,本公开对激活函数不做具体限定,可以根据实际需要进行选择,例如,可以为sigmoid函数等。

261.由于本公开的实施例中的文本处理方法涉及到系统模型,系统模型可以包括上述第一模型、第二模型、第三模型、第四模型和全连接层等,在预训练系统模型时,系统模型包括大量的参数,且大部分参数都是随机初始化的。当本公开的实施例的文本处理方法应用的技术领域或者应用场景包括的训练数据较少时,例如,当本公开的实施例的文本处理方法运用到法院庭审的应用场景时,由于可以获取的起诉书或者答辩状等训练数据不多,导致根据随机初始化的参数训练系统模型时,系统模型很难收敛或者不能获取预期的训练效果。

262.根据本公开的实施例,所述文本处理方法,还包括:

263.对所述系统模型进行预训练;

264.所述预训练包括以下任务的一项或多项:预测两个文本片段是否为连续文本、预测文本中被遮蔽的部分内容、预测对文本执行的操作。

265.图7示出根据本公开实施例的对所述系统模型进行预训练的示意图。

266.如图7所示,为了使本公开的实施例中的文本处理方法所涉及的系统模型获取更好的初始化参数,并提高系统模型收敛效率和预期训练效果,可以通过以下一项或多项任务,对系统模型进行预训练:第四任务701即预测两个文本片段是否为连续文本、第五任务702即预测文本中被遮蔽的部分内容、第六任务703即预测对文本执行的操作。

267.根据本公开的实施例,可以根据上述至少一项内容中各内容的损失函数确定预训练的系统模型的损失函数,例如通过对各内容的损失函数求和来确定预训练的系统模型的损失函数。例如,假设预训练仅包括第四任务701时,可以根据第四任务701的损失函数确定预训练的系统模型的损失函数;又例如,假设预训练包括第四任务701、第五任务702和第六任务703时,可以对第四任务701、第五任务702和第六任务703的损失函数求和来确定预训练的系统模型的损失函数。可以根据系统模型的损失函数调整系统模型的参数,以便于使系统模型获取更好的初始化参数,从而提高系统模型收敛效率和预期训练效果。

268.根据本公开的实施例,所述预测两个文本片段是否为连续文本包括:

269.从第三文本中获得连续的第一片段和第二片段;

270.从所述第三文本中随机选择第三片段;

271.使用所述第三片段替换所述第一片段或所述第二片段;

272.预测所述第三片段与所述第二片段,或者所述第一片段与所述第三片段是否为连续文本。

273.如图7所示,为了实现第四任务701即预测两个文本片段是否为连续文本的训练目标,可以从第三文本中随机获得连续的第一片段和第二片段(a1,b1)。可以以一定的概率在第三文本中随机选择第三片段c1,并用第三片段c1替换第一片段a1或第二片段b1,从而获取两段不连续文本片段(c1,b1)或(a1,c1)。可以通过预测第三片段与第二片段(c1,b1),或者第一片段与第三片段(a1,c1)是否为连续文本,调整系统模型的参数。例如,在法院庭审应用场景中,第三文本可以包括起诉书、答辩状或其他法律文件(比如,公开的裁判文件

等),从而可以增加系统模型预训练样本的数量。

274.根据本公开的实施例提供的技术方案,基于第四任务701即预测两个文本片段是否为连续文本训练整体模型,可以获取两段文本的相互关联关系,例如,句子与句子之间的相互关联关系。

275.根据本公开的实施例,所述预测文本中被遮蔽的部分内容,包括:

276.在所述第一文本和/或所述第二文本中随机选择任意文本片段;

277.以预设的掩码方式处理所述任意文本片段;

278.对处理后的任意文本片段中被遮蔽的部分内容进行预测。

279.如图7所示,为了实现第五任务702即预测文本中被遮蔽的部分内容的训练目标,可以在第一文本和/或第二文本中随机选择任意文本片段。比如,第一文本包括起诉书a,第二文本包括答辩状b,可以在起诉书a中随机抽取一段文本片段a2,可以在答辩状b中随机抽取一段文本片段b2。可以通过预设的掩码方式处理文本片段a2获取处理后的任意文本片段,例如,以一定的概率随机选择文本片段a2中预设比例的分词,采用掩码(mask)代替原始分词,从而获取处理后的任意文本片段a3。可以采用上述预设的掩码方式处理文本片段b2获取处理后的任意文本片段b3。可以通过预测处理后的任意文本片段a3和/或处理后的任意文本片段b3中被遮蔽的部分内容,调整系统模型的参数。

280.根据本公开的实施例提供的技术方案,基于第五任务702即预测文本中被遮蔽的部分内容训练整体模型,可以获取文本中两个分词的相互关联关系,和/或分词与文本的相互关联关系,例如,词与词之间的相互关联关系,和/或词与句子之间的相互关联关系。

281.根据本公开的实施例,所述预测对文本执行的操作包括:

282.在所述第一片段和所述第二片段组成的文本,和/或,所述第一片段和所述第三片段组成的文本,和/或,所述第三片段和所述第二片段组成的文本中,选择任意词进行特定操作;

283.对所述特定操作进行预测,所述特定操作包括删除、替换、无操作。

284.如图7所示,为了实现第六任务703即预测对文本执行的操作的训练目标,可以在第一片段和第二片段组成的文本(a1,b1),和/或,第一片段和第三片段组成的文本(a1,c1),和/或,第三片段和第二片段组成的文本(c1,b1)中,选择任意词进行特定操作,其中,特定操作包括但不限于“删除”、“替换”或“无操作”。例如,对于第一片段和第二片段组成的文本(a1,b1)、第一片段和第三片段组成的文本(a1,c1)、或第三片段和第二片段组成的文本(c1,b1)中的分词可以进行随机的删除或替换,或者不执行任何的操作。可以通过对上述特定操作进行预测,调整系统模型的参数。

285.根据本公开的实施例提供的技术方案,基于第六任务703即预测对文本执行的操作训练整体模型,在不依赖于人工标注数据的情形下,可以使预训练的整体模型的参数收敛至更好的范围,从而提高预训练的整体模型的鲁棒性。

286.图8示出根据本公开实施例的文本处理方法的应用场景示意图。如图8所示,应用场景包括服务器800,为了描述的方便,图8的应用场景中仅绘制了一个服务器800,应当了解的是,该示例仅为示例使用,并非是对于本公开的限制,本公开中的服务器800的数量、种类可以根据实际需要进行设定,本公开对此不作具体限定。同时,本公开实施例的应用场景将以法院庭审为例进行说明,但本公开不限于此,而是也适用于其他应用场景。

287.服务器800可以获取具有关联关系的第一文本(起诉书)和第二文本(答辩状)。为了获取起诉书和答辩状各自的语义信息,基于起诉书,可以利用第一模型获取与起诉书相对应的第一语义向量序列{e1,e2,

…

,e

m

},其中,第一语义向量序列{e1,e2,

…

,e

m

}可以用于表征起诉书的语义信息;基于答辩状,可以利用第一模型获取与答辩状相对应的第二语义向量序列{d1,d2,

…

,d

n

},其中,第二语义向量序列{d1,d2,

…

,d

n

}可以用于表征答辩状的语义信息。

288.根据本公开的实施例,为了获取起诉书和答辩状各自的上下文语义信息,基于第一语义向量序列{e1,e2,

…

,e

m

},可以利用第二模型获取与第一语义向量序列{e1,e2,

…

,e

m

}相对应的第一文本的语义向量序列{q1,q2,

…

,q

m

},其中,第一文本的语义向量序列{q1,q2,

…

,q

m

}可以用于表征起诉书的上下文语义信息;基于第二语义向量序列{d1,d2,

…

,d

n

},可以利用第二模型获取与第二语义向量序列{d1,d2,

…

,d

n

}相对应的第二文本的语义向量序列{h1,h2,

…

,h

n

},其中,第二文本的语义向量序列{h1,h2,

…

,h

n

}可以用于表征答辩状的上下文语义信息。

289.根据本公开的实施例,为了获取起诉书和答辩状的交互语义信息,可以将第一文本的语义向量序列{q1,q2,

…

,q

m

}以及第二文本的语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量{h1,h2,

…

,h

r

}。基于拼接向量{h1,h2,

…

,h

r

},可以利用第三模型,获取拼接向量的语义向量序列{v1,v2,

…

,v

r

},其中,拼接向量的语义向量序列{v1,v2,

…

,v

r

}可以用于表征以下至少一种或多种语义信息:起诉书的上下文语义信息、答辩状的上下文语义信息、起诉书与答辩状的交互语义信息。

290.根据本公开的实施例,为了有效提取拼接向量的语义向量序列{v1,v2,

…

,v

r

}的关键语义特征,可以利用第四模型,获取聚合向量v1。可以将聚合向量v1输入至系统模型的全连接层,获取全连接向量v2,从而可以将聚合向量v1映射到法律知识图谱的n个候选关联点(n个争议焦点)所在空间。全连接向量v2经过激活函数作用之后,可以获取n个候选关联点(n个争议焦点)相对应的概率分布,从而根据上述概率分布,确定k个关联点(k个争议焦点)。

291.本公开的实施例可以应用于法院庭审应用场景,通过起诉书和答辩状的各自上下文语义信息以及交互语义信息,获取可以推荐给法官进行候选的争议焦点,从而使获取的争议焦点可以与起诉书和答辩状的语义信息相对应,并可以提高推荐的争议焦点的准确度。

292.图9示出根据本公开的实施例的文本处理装置的结构框图。其中,该装置可以通过软件、硬件或者两者的结合实现成为电子设备的部分或者全部。如图9所示,所述文本处理装置900包括第一获取模块910、第二获取模块920、第三获取模块930、第四获取模块940和确定模块950。

293.所述第一获取模块910被配置为基于第一文本数据,通过处理器利用第一模型获取与所述第一文本数据相对应的第一语义向量序列{e1,e2,

…

,e

m

},其中,e

i

为向量,i=1~m;

294.所述第二获取模块920被配置为基于第二文本数据,通过处理器利用所述第一模型获取与所述第二文本数据相对应的第二语义向量序列{d1,d2,

…

,d

n

},其中,d

j

为向量,j=1~n;

295.所述第三获取模块930被配置为基于所述第一语义向量序列{e1,e2,

…

,e

m

},通过处理器利用第二模型获取与所述第一语义向量序列{e1,e2,

…

,e

m

}相对应的第三语义向量序列{q1,q2,

…

,q

m

},其中,q

i

为向量;

296.所述第四获取模块940被配置为基于所述第二语义向量序列{d1,d2,

…

,d

n

},通过处理器利用所述第二模型获取与所述第二语义向量序列{d1,d2,

…

,d

n

}相对应的第四语义向量序列{h1,h2,

…

,h

n

},其中,h

j

为向量;

297.所述确定模块950被配置为基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据。

298.根据本公开的实施例,所述第一文本数据和所述第二文本数据包含彼此对应的内容,所述目标文本数据的内容与所述第一文本数据和所述第二文本数据中相对应的内容相关联;和/或

299.所述第二文本数据包括对所述第一文本数据中的至少部分内容的应答,所述目标文本数据包括与所述第一文本数据和/或所述第二文本数据有关的文本数据;和/或

300.所述目标文本数据与所述第一文本数据和所述第二文本数据中彼此有争议的文本数据相关联。

301.根据本公开的实施例,所述基于所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

},确定目标文本数据,包括:

302.将所述第三语义向量序列{q1,q2,

…

,q

m

}和所述第四语义向量序列{h1,h2,

…

,h

n

}进行拼接处理,获取拼接向量序列{h1,h2,

…

,h

r

},其中,h

k

为向量,r=n m,k=1~r;

303.基于所述拼接向量序列{h1,h2,

…

,h

r

},通过第三模型,获取第五语义向量序列{v1,v2,

…

,v

r

},其中,v

k

为向量;

304.根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据。

305.根据本公开的实施例,所述根据所述第五语义向量序列{v1,v2,

…

,v

r

},确定所述目标文本数据,包括:

306.基于所述第五语义向量序列{v1,v2,

…

,v

r

},通过第四模型,获取第一聚合向量v1;

307.将所述第一聚合向量v1输入全连接层,获取第二聚合向量v2;

308.将所述第二聚合向量v2经过激活函数作用之后,获取与n个候选目标文本数据相对应的概率分布,所述概率分布包括所述n个候选目标文本数据各自对应的概率;

309.根据所述概率分布,确定所述目标文本数据。

310.根据本公开的实施例,还包括:第一预训练模块960,被配置为通过以下至少一项任务,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行预训练:预测两段文本是否是连续文本、预测文本中被遮蔽的部分、预测对文本执行的操作,其中,根据所述至少一项任务中各任务的损失函数确定所述预训练的整体损失函数,根据所述整体损失函数调整所述第一模型、所述第二模型、所述第三模型和所述第四模型的参数。

311.根据本公开的实施例,所述预测两段文本是否是连续文本包括:

312.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本样本数据包括两段不连续文本样本数据;

313.基于所述第一训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所

述第四模型作为整体进行训练。

314.根据本公开的实施例,所述预测文本中被遮蔽的部分包括:

315.获取第二训练样本数据,其中,所述第二训练样本数据包括通过预设掩码方式处理所述第一文本数据获取的第一文本掩码数据和/或通过所述预设掩码方式处理所述第二文本数据获取的第二文本掩码数据;

316.基于所述第二训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

317.根据本公开的实施例,所述预测对文本执行的操作包括:

318.获取第一训练样本数据,其中,所述第一训练样本数据包括第一文本样本数据和/或第二文本样本数据,所述第一文本样本数据包括两段连续文本样本数据,所述第二文本样本数据包括两段不连续文本样本数据;

319.根据所述第一训练样本数据,获取第三训练样本数据,所述第三训练样本数据包括对所述第一文本样本数据执行特定动作所获取的第三文本样本数据和/或对所述第二文本样本数据执行所述特定动作获取的第四文本样本数据;

320.基于所述第三训练样本数据,将所述第一模型、所述第二模型、所述第三模型和所述第四模型作为整体进行训练。

321.根据本公开的实施例,所述第一模型包括以下模型中任意一个模型:word2vector模型、glove模型,fasttext模型、bert模型。

322.根据本公开的实施例,所述第二模型包括以下模型中任意一个模型:cnn模型、rnn模型、lstm模型、transformer模型、bert模型、注意力模型。

323.根据本公开的实施例,所述第三模型包括以下模型中任意一个模型:transformer模型、注意力模型。

324.根据本公开的实施例,所述第四模型包括注意力模型。

325.图10示出根据本公开的实施例的文本处理装置的结构框图。其中,该装置可以通过软件、硬件或者两者的结合实现成为电子设备的部分或者全部。如图10所示,所述文本处理装置1000包括第五获取模块1010、第六获取模块1020和第七获取模块1030。

326.所述第五获取模块1010被配置为获得具有关联关系的第一文本和第二文本;

327.所述第六获取模块1020被配置为获得第一文本的语义向量序列以及第二文本的语义向量序列;

328.所述第七获取模块1030被配置为对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算和信息聚合,得到所述第一文本和所述第二文本的关联点。

329.根据本公开的实施例,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行交互计算,包括:

330.将所述第一文本的语义向量序列和所述第二文本的语义向量序列进行拼接,得到拼接向量;

331.计算所述拼接向量的语义向量序列。

332.根据本公开的实施例,所述对所述第一文本的语义向量序列和所述第二文本的语义向量序列进行信息聚合,包括:

333.根据所述拼接向量的语义向量序列得到聚合向量;

334.根据所述聚合向量得到与多个候选关联点相对应的概率分布;

335.根据所述多个候选关联点相对应的概率分布,得到所述第一文本和所述第二文本的关联点。

336.根据本公开的实施例,所述根据所述聚合向量得到与多个候选关联点相对应的概率分布,包括:

337.将所述聚合向量输入系统模型的全连接层并经过激活函数作用,得到与多个候选关联点相对应的概率分布。

338.根据本公开的实施例,所述装置还包括:

339.第二预训练模块1040,被配置为对所述系统模型进行预训练;

340.所述预训练包括以下任务的一项或多项:预测两个文本片段是否为连续文本、预测文本中被遮蔽的部分内容、预测对文本执行的操作。

341.根据本公开的实施例,所述预测两个文本片段是否为连续文本包括:

342.从第三文本中获得连续的第一片段和第二片段;

343.从所述第三文本中随机选择第三片段;

344.使用所述第三片段替换所述第一片段或所述第二片段;

345.预测所述第三片段与所述第二片段,或者所述第一片段与所述第三片段是否为连续文本。

346.根据本公开的实施例,所述预测文本中被遮蔽的部分内容,包括:

347.在所述第一文本和/或所述第二文本中随机选择任意文本片段;

348.以预设的掩码方式处理所述任意文本片段;

349.对处理后的任意文本片段中被遮蔽的部分内容进行预测。

350.根据本公开的实施例,所述预测对文本执行的操作包括:

351.在所述第一片段和所述第二片段组成的文本,和/或,所述第一片段和所述第三片段组成的文本,和/或,所述第三片段和所述第二片段组成的文本中,选择任意词进行特定操作;

352.对所述特定操作进行预测,所述特定操作包括删除、替换、无操作。

353.本公开还公开了一种电子设备,图11示出根据本公开的实施例的电子设备的结构框图。

354.如图11所示,所述电子设备1100包括存储器1101和处理器1102;其中,

355.所述存储器1101用于存储一条或多条计算机指令,其中,所述一条或多条计算机指令被所述处理器1102执行以实现根据本公开的实施例的方法。

356.图12示出适于用来实现根据本公开实施例的文本处理的计算机系统的结构示意图。

357.如图12所示,计算机系统1200包括处理单元1201,其可以根据存储在只读存储器(rom)1202中的程序或者从存储部分1208加载到随机访问存储器(ram)1203中的程序而执行上述实施例中的各种处理。在ram1203中,还存储有系统1200操作所需的各种程序和数据。处理单元1201、rom 1202以及ram 1203通过总线1204彼此相连。输入/输出(i/o)接口1205也连接至总线1204。

358.以下部件连接至i/o接口1205:包括键盘、鼠标等的输入部分1206;包括诸如阴极射线管(crt)、液晶显示器(lcd)等以及扬声器等的输出部分1207;包括硬盘等的存储部分1208;以及包括诸如lan卡、调制解调器等的网络接口卡的通信部分1209。通信部分1209经由诸如因特网的网络执行通信处理。驱动器1210也根据需要连接至i/o接口1205。可拆卸介质1211,诸如磁盘、光盘、磁光盘、半导体存储器等等,根据需要安装在驱动器1210上,以便于从其上读出的计算机程序根据需要被安装入存储部分1208。其中,所述处理单元1201可实现为cpu、gpu、tpu、fpga、npu等处理单元。

359.特别地,根据本公开的实施例,上文描述的方法可以被实现为计算机软件程序。例如,本公开的实施例包括一种计算机程序产品,其包括有形地包含在及其可读介质上的计算机程序,所述计算机程序包含用于执行上述方法的程序代码。在这样的实施例中,该计算机程序可以通过通信部分1209从网络上被下载和安装,和/或从可拆卸介质1211被安装。

360.附图中的流程图和框图,图示了按照本公开各种实施例的系统、方法和计算机程序产品的可能实现的体系架构、功能和操作。在这点上,流程图或框图中的每个方框可以代表一个模块、程序段或代码的一部分,所述模块、程序段或代码的一部分包含一个或多个用于实现规定的逻辑功能的可执行指令。也应当注意,在有些作为替换的实现中,方框中所标注的功能也可以以不同于附图中所标注的顺序发生。例如,两个接连地表示的方框实际上可以基本并行地执行,它们有时也可以按相反的顺序执行,这依所涉及的功能而定。也要注意的是,框图和/或流程图中的每个方框、以及框图和/或流程图中的方框的组合,可以用执行规定的功能或操作的专用的基于硬件的系统来实现,或者可以用专用硬件与计算机指令的组合来实现。

361.描述于本公开实施例中所涉及到的单元或模块可以通过软件的方式实现,也可以通过可编程硬件的方式来实现。所描述的单元或模块也可以设置在处理器中,这些单元或模块的名称在某种情况下并不构成对该单元或模块本身的限定。

362.作为另一方面,本公开还提供了一种计算机可读存储介质,该计算机可读存储介质可以是上述实施例中电子设备或计算机系统中所包含的计算机可读存储介质;也可以是单独存在,未装配入设备中的计算机可读存储介质。计算机可读存储介质存储有一个或者一个以上程序,所述程序被一个或者一个以上的处理器用来执行描述于本公开的方法。

363.以上描述仅为本公开的较佳实施例以及对所运用技术原理的说明。本领域技术人员应当理解,本公开中所涉及的发明范围,并不限于上述技术特征的特定组合而成的技术方案,同时也应涵盖在不脱离所述发明构思的情况下,由上述技术特征或其等同特征进行任意组合而形成的其它技术方案。例如上述特征与本公开中公开的(但不限于)具有类似功能的技术特征进行互相替换而形成的技术方案。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。