1.本发明属于无人机技术领域,具体涉及一种多机空战决策方法。

背景技术:

2.无人飞行战斗机决策的目的是使其能够在战斗中占据优势取胜或者转劣势为优势,研究的关键就是设计出高效的自主决策机制。无人飞行战斗机的自主决策是关于如何在空战中根据实战环境实时制定战术计划或选择飞行动作的机制,该决策机制的优劣程度反映了无人飞行战斗机在现代化空战中的智能化水平。自主决策机制的输入是与空战有关的各种参数,如飞行器的飞行参数,武器参数和三维空间场景参数以及敌我双方的相对关系,决策过程是系统内部的信息处理和计算决策过程,输出是决策制定的战术计划或某些特定的飞行动作。

3.目前,研究空战战术决策方法基本可以分为两类,第一类为传统基于规则的非学习策略主要包括微分对策法,专家系统,影响图法和矩阵博弈算法等,它们的决策策略一般是固定的,无法完整地覆盖复杂且瞬时变化的多机空战的问题,第二类是基于智能算法的自我学习策略主要包括人工免疫系统,遗传算法,迁移学习,近似动态规划算法和强化学习等,通过自身的经验来优化自身决策模型的结构和参数。自我学习的策略自适应性强,能够应对势态复杂多变的空战战场环境。

4.随着空战技术的发展,现代化无人机空战已经不拘泥于以前一架飞机对一架飞机的作战环境,编队协同意味着多对多的无人机攻击模式,无人机之间的相互掩护,协同攻击也成为多机空战决策的重要组成部分。

5.多智能体多机战术决策的难点,主要体现在(1)多异构智能体合作。(2)实时对抗及动作持续性。(3)非完整信息博弈和强不确定性。(4)巨大的搜索空间及多复杂任务。随着以深度强化学习为核心的人工智能技术的突破和发展,为指挥信息系统的智能化开拓了新的技术途径,也为复杂的多智能体多机空决策带来了新的解决方法。

技术实现要素:

6.为了克服现有技术的不足,本发明提供了一种基于多智能体强化学习的多机空战决策方法,首先建立无人机的六自由度模型、导弹模型、神经网络归一化模型、战场环境模型、态势判断和目标分配模型;然后采用mappo算法作为多智能体强化学习算法,在具体空战环境的基础上设计相应的回报函数;最后将构建的无人机模型和多智能体强化学习算法进行结合,生成最终的基于多智能体强化学习的多机协同空战决策方法。本发明方法有效解决了传统的多智能体协同空战计算量大,难以应对需要实时结算瞬息万变的战场态势的问题。

7.本发明解决其技术问题所采用的技术方案包括如下步骤:

8.步骤1:假定对战双方无人机为我方和敌方,我方无人机为红机,敌方无人机为蓝机;建立无人机的六自由度模型、导弹模型、神经网络归一化模型、战场环境模型、态势判断

和目标分配模型;

9.步骤2:采用mappo算法作为多智能体强化学习算法,在具体空战环境的基础上设计相应的回报函数;

10.步骤3:将步骤1构建的无人机模型和步骤2中的多智能体强化学习算法进行结合,生成最终的基于多智能体强化学习的多机协同空战决策方法。

11.进一步地,所述步骤1中,建立无人机的飞机模型、导弹模型、神经网络归一化模型、战场环境模型、态势判断和目标分配模型,具体步骤如下:

12.步骤1

‑

1:建立无人机的飞机模型;

13.步骤1

‑1‑

1:输入无人机的状态s

r

=[v

r

,γ

r

,φ

r

,x

r

,y

r

,h

r

],依次为无人机的速度v

r

,俯仰角γ

r

,滚转角φ

r

,三轴位置(x

r

,y

r

,h

r

);

[0014]

步骤1

‑1‑

2:构建无人机六自由度模型和七个动作;动作选用无人机的切向过载、法向过载和滚转角来进行动作编码,即式(1)中的来表示仿真中每个时刻下采取的动作,经过编码,动作包括定常平飞、加速、减速、左转弯、右转弯、向上拉起、向下俯冲共七个动作;

[0015][0016]

其中,v表示无人机的速度,n

x

表示无人机的切向过载,θ表示无人机的俯仰角,ψ表示无人机的偏航角,n

z

表示无人机的法向过载,表示无人机的滚转角,t表示无人机状态的更新时间,g表示重力加速度;

[0017]

步骤1

‑1‑

3:输入无人机需要执行的动作;

[0018]

步骤1

‑1‑

4:通过龙格库塔解算出飞机执行完动作后的状态;

[0019]

步骤1

‑1‑

5:更新飞机状态;

[0020]

步骤1

‑

2:构建导弹模型;

[0021]

步骤1

‑2‑

1:决定导弹性能的参数为最大离轴发射角最大最小攻击距离d

mmax

和d

mmin

、最大和最小不可逃逸距离d

mkmax

和d

mkmin

、以及圆锥角

[0022]

假设导弹攻击区是静态的,且只关注最大攻击距离、最大不可逃逸距离与圆锥角;攻击区记为area

ack

,满足:

[0023][0024]

其中,d

t

表示红机到蓝机的距离,q

t

表示红机到蓝机的视线角;pos(target)表示蓝机的位置;

[0025]

不可逃逸区记为area

dead

,满足:

[0026]

[0027]

当蓝机进入红机的攻击区内,以一定概率被击毁;

[0028]

步骤1

‑2‑

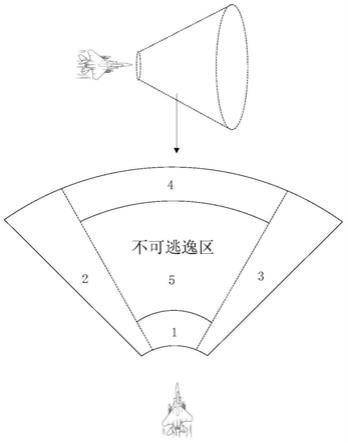

2:对攻击区进行划分;

[0029]

当且d

mk min

<d<d

mk max

时,蓝机处于攻击区的

⑤

区;

[0030]

当且d

m min

<d<d

mk min

时,蓝机处于攻击区的

①

区;

[0031]

当且d

mk max

<d<d

m max

时,蓝机处于攻击区的

④

区;

[0032]

当且d

m min

<d<d

m max

,蓝机处于攻击区的

②

区或者

③

区;具体在

②

区或

③

区通过红机和蓝机的相对位置进行判断,红机和蓝机的相对位置如式(4):

[0033][0034]

其中,δx、δy、δi分别表示红机和蓝机在x轴方向、y轴方向和z轴方向的距离差,x

b

、y

b

、z

b

分别表示蓝机在x轴方向、y轴方向和z轴方向的位置,x

r

、y

r

、z

r

分别表示红机在x轴方向、y轴方向和z轴方向的位置;

[0035]

如果则蓝机相对于红机位于右侧,即攻击区的

③

区,如果则蓝机相对于红机位于左侧,即攻击区的

②

区;

[0036]

综上所述,攻击区的具体划分如下:

[0037][0038]

步骤1

‑2‑

3:当蓝机处于区域

⑤

时,蓝机在红机的不可逃逸区内,导弹命中概率最大;当蓝机处于其他区域时候,导弹命中概率为0到1的一个函数,命中概率的大小与距离、脱离角、偏离角以及飞行方向有关;当导弹命中概率小于0.3时,认为导弹无法命中,此时不能发射导弹;具体击毁概率如下:

[0039][0040]

其中,p

a

表示与蓝机机动相关联的击毁概率,p

d

表示与距离相关联的击毁概率,position(aircraft_aim)表示蓝机所处我方攻击区的区域;

[0041]

步骤1

‑2‑

4:发射导弹的具体步骤如下:

[0042]

步骤1

‑2‑4‑

1:输入红机与蓝机的距离d、脱离角aa、偏离角ata、位置和速度;

[0043]

步骤1

‑2‑4‑

2:构建导弹模型,设定导弹数量;

[0044]

步骤1

‑2‑4‑

3:根据距离d和脱离角ata判断蓝机是否处于红机的攻击区;

[0045]

步骤1

‑2‑4‑

4:当蓝机处于红机攻击区,判断蓝机处于攻击区的哪一部分;

[0046]

步骤1

‑2‑4‑

5:判断蓝机相对于红机的速度方向;

[0047]

步骤1

‑2‑4‑

6:计算此时导弹的命中率;

[0048]

步骤1

‑2‑4‑

7:判断导弹是否命中;

[0049]

步骤1

‑

3:神经网络归一化模型;

[0050]

步骤1

‑3‑

1:输入无人机的状态变量;

[0051]

步骤1

‑3‑

2:归一化速度

[0052]

步骤1

‑3‑

3:归一化角度

[0053]

步骤1

‑3‑

4:归一化位置

[0054]

步骤1

‑3‑

5:对归一化后的红机与蓝机的位置做差;

[0055]

步骤1

‑3‑

6:输出数据;

[0056]

步骤1

‑

4:构建战场环境模型;

[0057]

步骤1

‑

5:态势判断和目标分配模型;

[0058]

步骤1

‑5‑

1:输入红机和蓝机的状态,包括速度、俯仰角、偏航角和三轴位置;

[0059]

步骤1

‑5‑

2:根据俯仰角和偏航角算出各自的角度优势φ

t

为目标进入角,φ

f

为目标方位角;

[0060]

步骤1

‑5‑

3:根据三轴位置算出各自的距离优势

[0061]

步骤1

‑5‑

4:根据速度和三轴位置中的高度算出各自的能量优势

[0062]

步骤1

‑5‑

5:结合角度、速度和能量优势算出综合优势s=c1s

a

c2s

r

c3e

g

,c1、c2和c3均为加权系数;

[0063]

步骤1

‑5‑

6:根据综合优势对目标进行排序,生成目标分配矩阵;

[0064]

步骤1

‑5‑

7:根据目标分配矩阵,输出对目标的分配。

[0065]

进一步地,所述步骤2中,采用mappo算法作为多智能体强化学习算法,将集中式训练、分布式执行框架与ppo算法相结合,形成mappo算法,在具体空战环境的基础上设计相应的回报函数,具体步骤如下:

[0066]

回报函数由四个子回报函数组成,分别是高度回报函数,速度回报函数,角度回报函数和距离回报函数;具体如下:

[0067]

步骤2

‑

1:输入无人机状态s

r

=[v

r

,γ

r

,φ

r

,x

r

,y

r

,h

r

];

[0068]

步骤2

‑

2:计算高度差δh=h

r

‑

h

b

并计算高度差奖励r_h,h

r

、h

b

分别为红机的高度和蓝机的高度,高度单位为米:

[0069][0070]

步骤2

‑

3:计算红机的高度安全奖励:

[0071][0072]

步骤2

‑

4:计算总的高度奖励r

h

=r_h r_h_self;

[0073]

步骤2

‑

5:计算速度差δh=v

r

‑

v

b

并计算速度差奖励,v

r

、v

b

分别表示红机的速度和蓝机的速度,速度单位为米/秒:

[0074][0075]

步骤2

‑

6:计算红机的速度安全奖励:

[0076][0077]

步骤2

‑

7:计算总的速度奖励r

v

=r_v r_v_self;

[0078]

步骤2

‑

8:计算红机和蓝机的偏离角aa和脱离角ata;

[0079]

步骤2

‑

9:计算得到角度奖励

[0080]

步骤2

‑

10:计算红机和蓝机的距离,当脱离角ata小于60度时候,得到距离奖励

[0081]

步骤2

‑

11:设置不同的权重将各个奖励求和得到连续奖励r

c

=a1·

r

a

a2·

r

h

a3·

r

v

a4·

r

d

,a1、a2、a3和a4分别表示不同的权重。

[0082]

进一步地,所述步骤3中,将步骤1构建的无人机模型和步骤2中的多智能体强化学习算法进行结合,生成最终的基于多智能体强化学习的多机协同空战决策方法,具体如下:

[0083]

步骤3

‑

1:多智能体强化学习算法由策略网络和价值网络组成,价值网络负责对策略网络选出的动作进行评价从而指导策略网络的更新;价值网络的输入是上一时刻中无人机自身、友机和敌机的速度、俯仰角、偏航角、x方向位置、y方向位置、高度以及所选取的动

作;策略网络的输入是无人机自身的速度、俯仰角、偏航角、x方向位置、y方向位置和高度,策略网络的输出为选择的动作;

[0084]

步骤3

‑

2:首先红机和蓝机都先根据自己的策略网络的初始参数选择初始动作,在战场环境模型中执行动作得到新的状态,接着计算奖励,再将红机和蓝机的状态、奖励和动作打包归一化存入多智能体强化学习算法的经验回放库;当存够设定的数据之后,红机与蓝机的价值网络对经验回放库的数据进行采样,将红机与蓝机的状态联合,从而策略网络对策略进行更新,然后无人机将自身的状态作为自己的策略网络的输入,策略网络根据自身的状态选择该架无人机的动作,再由无人机执行得到新的数据,循环往复进行。

[0085]

本发明的有益效果如下:

[0086]

(1)本发明方法有效解决了传统的多智能体协同空战计算量大,难以应对需要实时结算瞬息万变的战场态势的问题。

[0087]

(2)本发明方法所形成的基于多智能体强化学习的多机协同空战决策算法有效解决了多智能体决策中多异构智能体合作、实时对抗及动作持续性、巨大的搜索空间及多复杂任务等问题。

[0088]

(3)本发明所形成的基于多智能体强化学习的多机协同空战决策算法中包含了战场环境构建模块、归一化模块、强化学习模块、飞机模块、导弹模块、奖励模块和目标分配模块,能够根据战场环境和态势信息建立决策模型。

[0089]

(4)本发明能够实现多机空战决策输出,强化学习算法可以根据不同场景单独训练,决策算法具有良好的输入/输出接口和模块化快速移植特点。

附图说明

[0090]

图1为本发明无人机攻击区横截面示意图。

[0091]

图2为本发明战场环境模块流程图。

[0092]

图3为本发明多智能体多机空战决策算法设计框架。

[0093]

图4为本发明方法各个模块之间的关系图。

[0094]

图5为本发明实施例2v2空战初始占位图。

[0095]

图6为本发明实施例空战双方速度变化图。

[0096]

图7为本发明实施例空战双方高度变化图。

[0097]

图8为本发明实施例空战双方态势变化图。

[0098]

图9为本发明实施例空战双方轨迹图。

具体实施方式

[0099]

下面结合附图和实施例对本发明进一步说明。

[0100]

一种基于多智能体强化学习的多机空战决策方法,包括如下步骤:

[0101]

步骤1:假定对战双方无人机为我方和敌方,我方无人机为红机,敌方无人机为蓝机;建立无人机的六自由度模型、导弹模型、神经网络归一化模型、战场环境模型、态势判断和目标分配模型;

[0102]

步骤2:采用mappo算法作为多智能体强化学习算法,在具体空战环境的基础上设计相应的回报函数;

[0103]

步骤3:将步骤1构建的无人机模型和步骤2中的多智能体强化学习算法进行结合,生成最终的基于多智能体强化学习的多机协同空战决策方法。

[0104]

进一步地,所述步骤1中,建立无人机的飞机模型、导弹模型、神经网络归一化模型、战场环境模型、态势判断和目标分配模型,具体步骤如下:

[0105]

步骤1

‑

1:建立无人机的飞机模型;

[0106]

首先根据地面惯性坐标系下的三维空间运动学方程构建无人机六自由度模型,然后根据无人机的切向过载、法相过载和滚转角构建飞机的七个动作,当飞机选择执行其中任一个动作时,通过龙格库塔更新动作完成后的状态;

[0107]

步骤1

‑1‑

1:输入无人机的状态s

r

=[v

r

,γ

r

,φ

r

,x

r

,y

r

,h

r

],依次为无人机的速度v

r

,俯仰角γ

r

,滚转角φ

r

,三轴位置(x

r

,y

r

,h

r

);

[0108]

步骤1

‑1‑

2:构建无人机六自由度模型和七个动作;

[0109][0110]

步骤1

‑1‑

3:输入无人机需要执行的动作;

[0111]

步骤1

‑1‑

4:通过龙格库塔解算出飞机执行完动作后的状态;

[0112]

步骤1

‑1‑

5:更新飞机状态;

[0113]

步骤1

‑

2:构建导弹模型;

[0114]

步骤1

‑2‑

1:决定导弹性能的参数为最大离轴发射角最大最小攻击距离d

mmax

和d

mmin

、最大和最小不可逃逸距离d

mkmax

和d

mkmin

、以及圆锥角

[0115]

为了简化问题,假设导弹攻击区是静态的,且只关注最大攻击距离、最大不可逃逸距离与圆锥角;攻击区记为area

ack

,满足:

[0116][0117]

其中,q

t

表示红机到蓝机的视线角;pos(target)表示蓝机的位置;

[0118]

不可逃逸区记为area

dead

,满足:

[0119][0120]

当蓝机进入红机的攻击区内,以一定概率被击毁;

[0121]

为更好地确定这个概率,如附图1所示,对攻击区进行了进一步的分析。

[0122]

步骤1

‑2‑

2:对攻击区进行划分;

[0123]

当且d

mk min

<d<d

mk max

时,蓝机处于攻击区的

⑤

区;

[0124]

当且d

mmin

<d<d

mk min

时,蓝机处于攻击区的

①

区;

[0125]

当且d

mk max

<d<d

m max

时,蓝机处于攻击区的

④

区;

[0126]

当且d

m min

<d<d

m max

,蓝机处于攻击区的

②

区或者

③

区;具体在

②

区或

③

区通过红机和蓝机的相对位置进行判断,红机和蓝机的相对位置如式(4):

[0127][0128]

如果则蓝机相对于红机位于右侧,即攻击区的

③

区,如果则蓝机相对于红机位于左侧,即攻击区的

②

区;

[0129]

综上所述,攻击区的具体划分如下:

[0130][0131]

步骤1

‑2‑

3:当蓝机处于区域

⑤

时,蓝机在红机的不可逃逸区内,导弹命中概率最大;当蓝机处于其他区域时候,导弹命中概率为0到1的一个函数,命中概率的大小与距离、脱离角、偏离角以及飞行方向有关;当导弹命中概率小于0.3时,认为导弹无法命中,此时不能发射导弹;具体击毁概率如下:

[0132][0133]

步骤1

‑2‑

4:发射导弹的具体步骤如下:

[0134]

步骤1

‑2‑4‑

1:输入红机与蓝机的距离d、脱离角aa、偏离角ata、位置和速度;

[0135]

步骤1

‑2‑4‑

2:构建导弹模型,设定导弹数量;

[0136]

步骤1

‑2‑4‑

3:根据距离d和脱离角ata判断蓝机是否处于红机的攻击区;

[0137]

步骤1

‑2‑4‑

4:当蓝机处于红机攻击区,判断蓝机处于攻击区的哪一部分;

[0138]

步骤1

‑2‑4‑

5:判断蓝机相对于红机的速度方向;

[0139]

步骤1

‑2‑4‑

6:计算此时导弹的命中率;

[0140]

步骤1

‑2‑4‑

7:判断导弹是否命中;

[0141]

步骤1

‑

3:神经网络归一化模型;

[0142]

归一化可以保证神经网络每一层的输入保持相同的分布梯度下降时,让模型收敛到正确的地方,而在不同量纲下梯度更新方向被带偏。并且归一化到合理范围有利于模型泛化性。

[0143]

步骤1

‑3‑

1:输入无人机的状态变量;

[0144]

步骤1

‑3‑

2:归一化速度

[0145]

步骤1

‑3‑

3:归一化角度

[0146]

步骤1

‑3‑

4:归一化位置

[0147]

步骤1

‑3‑

5:对归一化后的红机与蓝机的位置做差;

[0148]

步骤1

‑3‑

6:输出数据;

[0149]

步骤1

‑

4:构建战场环境模型;

[0150]

步骤1

‑

5:态势判断和目标分配模型;

[0151]

态势判断和目标分配模型通过分析距离威胁、角度优势、能量优势构造综合优势函数,从而构建出空战威胁度模型。然后依据长机获得的所有信息,经过数据融合后,依据目标分配矩阵准则计算目标分配矩阵。然后根据目标分配矩阵选择战术的慎重程度或冒险程度系数,表示飞行员在攻击和规避危险问题上的权衡。

[0152]

步骤1

‑5‑

1:输入红机和蓝机的状态,包括速度、俯仰角、偏航角和三轴位置;

[0153]

步骤1

‑5‑

2:根据俯仰角和偏航角算出各自的角度优势φ

t

为目标进入角,φ

f

为目标方位角;

[0154]

步骤1

‑5‑

3:根据三轴位置算出各自的距离优势

[0155]

步骤1

‑5‑

4:根据速度和三轴位置中的高度算出各自的能量优势

[0156]

步骤1

‑5‑

5:结合角度、速度和能量优势算出综合优势;

[0157]

步骤1

‑5‑

6:根据综合优势对目标进行排序,生成目标分配矩阵;

[0158]

步骤1

‑5‑

7:根据目标分配矩阵,输出对目标的分配。

[0159]

进一步地,所述步骤2中,采用mappo算法作为多智能体强化学习算法,在具体空战环境的基础上设计相应的回报函数,具体步骤如下:

[0160]

mappo算法:

[0161]

由于多机空战场景的状态、动作空间庞大,单个无人机能够探索的空间有限,样本使用效率不高。另外,作为典型的多机系统,多机协同空战问题中,单个无人机的策略不只取决于自身的策略和环境的反馈,同时还受到其他无人机的动作及与其合作关系的影响,所以设计了经验共享机制,该机制包含共享样本经验库和共享网络参数两个方面。所谓共享样本经验库,是将全局环境态势信息、无人机的动作决策信息、无人机执行新动作后的环境态势信息和环境针对该动作反馈的奖励值按照四元组的形式存储进经验回放库,每一个无人机的信息均按照该格式存储进同一个经验回放库中。在更新网络参数时,从经验回放库中提取样本,分别计算不同无人机产生的样本在actor网络和critic网络下的损失值,进

而求得两个神经网络的更新梯度,将不同无人机的样本计算的梯度值进行加权,可以得到全局梯度公式。如附图3所示是基于深度强化学习的多机协同空战决策框架整个框架,共包括七个模块,分别为战场环境构建模块、归一化模块、强化学习模块、飞机模块、导弹模块、奖励模块和目标分配模块。框架的输入量是战场实时态势信息,输出量是所控实体的动作决策方案。原始战场态势信息输入框架后,会首先经过态势处理模块进行加工,数据经过清洗、筛选、提取、打包、归一化以及格式化表示后,将传给深度强化学习模块;深度强化学习模块接收态势信息数据,输出动作决策;策略网络接收深度强化学习模块的动作决策输出,解码封装为平台环境可接受的操作指令,对相应单元进行控制;同时,通过执行新动作获得的新的环境态势以及奖励值与本步决策的环境态势信息、动作决策方案一并被打包存储进经验存储模块,待训练网络时,再将这些样本数据从经验库中提取出来,传入神经网络训练模块进行训练。

[0162]

回报函数由四个子回报函数组成,分别是高度回报函数,速度回报函数,角度回报函数和距离回报函数;这四个回报函数反应了飞机在空中作战时候的能量优势、动能优势和攻击区命中概率的分布,概况了整个空战环境。该回报函数可以反映出当前时刻己机相对于敌机的占位,并且能够引导飞机飞往高奖励值也就是态势较好的地方。具体如下:

[0163]

步骤2

‑

1:输入无人机状态s

r

=[v

r

,γ

r

,φ

r

,x

r

,y

r

,h

r

];

[0164]

步骤2

‑

2:计算高度差δh=h

r

‑

h

b

并计算高度差奖励r_h:

[0165][0166]

步骤2

‑

3:计算红机的高度安全奖励:

[0167][0168]

步骤2

‑

4:计算总的高度奖励r

h

=r_h r_h_self;

[0169]

步骤2

‑

5:计算速度差δh=v

r

‑

v

b

并计算速度差奖励:

[0170][0171]

步骤2

‑

6:计算红机的速度安全奖励:

[0172][0173]

步骤2

‑

7:计算总的速度奖励r

v

=r_v r_v_self;

[0174]

步骤2

‑

8:计算红机和蓝机的偏离角aa和脱离角ata;

[0175]

步骤2

‑

9:计算得到角度奖励

[0176]

步骤2

‑

10:计算红机和蓝机的距离,当脱离角ata小于60度时候,得到距离奖励

[0177]

步骤2

‑

11:设置不同的权重将各个奖励求和得到连续奖励r

c

=a1·

r

a

a2·

r

h

a3·

r

v

a4·

r

d

,a1、a2、a3和a4分别表示不同的权重。

[0178]

进一步地,所述步骤3中,将步骤1构建的无人机模型和步骤2中的多智能体强化学习算法进行结合,生成最终的基于多智能体强化学习的多机协同空战决策方法,具体如下:

[0179]

步骤3

‑

1:步骤1中构建的模型和步骤2的mappo算法以及设计的汇报函数的关系如附图4,多智能体强化学习算法由策略网络和价值网络组成,价值网络负责对策略网络选出的动作进行评价从而指导策略网络的更新;价值网络的输入是上一时刻中无人机自身、友机和敌机的速度、俯仰角、偏航角、x方向位置、y方向位置、高度以及所选取的动作;策略网络的输入是无人机自身的速度、俯仰角、偏航角、x方向位置、y方向位置和高度,策略网络的输出为选择的动作;

[0180]

步骤3

‑

2:首先红机和蓝机都先根据自己的策略网络的初始参数选择初始动作,在战场环境模型中执行动作得到新的状态,接着计算奖励,再将红机和蓝机的状态、奖励和动作打包归一化存入多智能体强化学习算法的经验回放库;当存够设定的数据之后,红机与蓝机的价值网络对经验回放库的数据进行采样,将红机与蓝机的状态联合,从而策略网络对策略进行更新,然后无人机将自身的状态作为自己的策略网络的输入,策略网络根据自身的状态选择该架无人机的动作,再由无人机执行得到新的数据,循环往复进行。

[0181]

具体实施例:

[0182]

双机对战时的情况如图5所示,四架飞机处于同一平面上,红机1和红机2分别处于蓝机1和蓝机2的正前方,蓝机1和蓝机2有接近红机1和红机2的联合攻击区的趋势,红机1和红机2也有接近蓝机1和蓝机2的联合攻击区的趋势。因此红机1和红机2与蓝机1和蓝机2处于均势。

[0183]

在训练结束之后,经过1000次试验后,红方胜利和蓝方胜利的次数如表1所示。可以得出红方胜率为51.8%,蓝方胜率为48.2%。

[0184]

表1红方胜利和蓝方胜利的次数

[0185]

情况次数红机1击中蓝机1226红机1击中蓝机2129红机2击中蓝机10红机2击中蓝机2163蓝机1击中红机1330蓝机1击中红机20蓝机2击中红机1152蓝机2击中红机20

[0186]

以红机1击中蓝机1为例进行分析。

[0187]

红机1选择的动作是[right,right,right,right,acc,acc,acc,acc,acc,acc,acc,acc,acc,acc]。

[0188]

红机2选择的动作是[right,right,acc,right,acc,acc,acc,acc,acc,acc,acc,acc,acc,acc]。

[0189]

蓝机1选择的动作是[right,right,right,right,acc,acc,acc,acc,acc,acc,acc,acc,acc,acc]。

[0190]

蓝机2选择的动作是[right,right,right,right,acc,acc,acc,acc,acc,acc,acc,acc,acc,acc]。

[0191]

仿真结果图如图6

‑

图8所示,实线代表红机1,虚线代表红机2,虚点线代表蓝机1,点曲线代表蓝机2。如图6所示,蓝机2的速度最高,具有最大的速度优势,红机1和红机2的速度远远不如蓝机1和蓝机2。由图7可以看出,蓝机1和蓝机2在高度优势上不如红机红机1和红机2,由图8可以看出,红机1、红机2、蓝机1和蓝机2都在安全飞行,因此它们的初始态势都为正,随着空战的进行蓝机1和蓝机2对红机1进行夹击,蓝机1和蓝机2的态势逐渐上升,而红机1的态势逐渐变劣,随后红方两架飞机也开始对蓝机2进行夹击,蓝方的态势下降,红方的态势上升,最后蓝方先完成对红机1的夹击,并且蓝机2发射导弹,成功命中红机1,蓝2的态势上升,掌握战场主动权。

[0192]

如图9为四架无人机轨迹图。

[0193]

综合各个仿真结果,证明了本发明所设计的基于多智能体强化学习的多机协同空战决策算法的有效性,有效解决了传统的多智能体协同空战计算量大,难以应对需要实时结算瞬息万变的战场态势的问题,同时有效解决了多智能体决策中多异构智能体合作、实时对抗及动作持续性、巨大的搜索空间及多复杂任务等问题,能够根据战场环境和态势信息建立决策模型;能够实现多机空战决策输出,强化学习算法可以根据不同场景单独训练,决策算法具有良好的输入/输出接口和模块化快速移植特点。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。