1.本发明属于网络资源分配技术领域,具体涉及一种基于网络切片的网络资源动态分配方法。

背景技术:

2.网络切片作为5g(5th generation mobile communication technology,第五代移动通信技术)的关键技术之一,它能够在共享物理网络设施的基础上创建并维护多个定制的独立的逻辑网络,针对5g不同类型的应用场景定制专用网络切片的形式提高了网络的异构性、灵活性、可伸缩性、盈利性和未来网络服务的安全性,

3.实际应用过程中网络切片的网络资源是实时动态变化的,但由于sla(service level agreement,服务水平协议)的限制,现有技术对于网络切片的网络资源分配只能采取静态资源分配的方式,sla是在一定开销下,为了保障服务的性能和可靠性,服务提供商与用户间或服务提供商之间定义的一种双方认可的协定,静态资源分配的方式会使网络切片占用大量不必要的网络资源,会导致网络资源的浪费,且由于网络切片总是额外占用过多的网络资源,导致系统可分配给新网络切片的网络资源少,以至于系统容量小。

4.因此,如何使服务提供商在不违反sla的前提下合理的分配网络切片的网络资源,避免网络资源的浪费,是本领域技术人员有待解决的技术问题。

技术实现要素:

5.本发明的目的是为了解决现有技术无法合理地分配网络切片的网络资源,造成网络资源的浪费,提出了一种基于网络切片的网络资源动态分配方法。

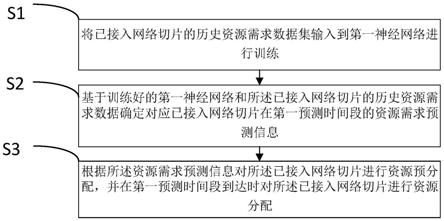

6.本发明的技术方案为:一种基于网络切片的网络资源动态分配方法,,包括以下步骤:

7.s1、将已接入网络切片的历史资源需求数据集输入到第一神经网络进行训练;

8.s2、基于训练好的第一神经网络和所述已接入网络切片的历史资源需求数据确定对应已接入网络切片在第一预测时间段的资源需求预测信息;

9.s3、根据所述资源需求预测信息对所述已接入网络切片进行资源预分配,并在第一预测时间段到达时对所述已接入网络切片进行资源分配。

10.进一步地,所述资源需求预测信息具体包括预测节点资源量和预测链路资源量。

11.进一步地,所述步骤s3中具体通过如下公式对已接入网络切片进行资源预分配,具体为确定出已接入网络切片在所述第一预测时间段内的预分配节点资源量和预分配链路资源量:

12.13.其中,

14.式中,为已接入网络切片i在第一预测时间段t的预分配节点资源量,已接入网络切片i在第一预测时间段t的预分配链路资源量,为已接入网络切片i在第一预测时间段t的预测节点资源量,为已接入网络切片i在第一预测时间段t的预测链路资源量,n

t

为在第一预测时间段t时系统中已接入网络切片的数量,γ

d

≥1代表节点资源冗余度,γ

l

≥1代表链路资源冗余度,γ

′

d

≥0和γ

l

′

≥0为加在对应预测值上的偏移量,d为系统节点资源总量,l为链路资源总量。

15.进一步地,所述方法还包括以下步骤:

16.a1、实时接收所有待接入网络切片的接入请求,并将所有接入请求存储在请求队列中;

17.a2、确定出所有已接入网络切片在第二预测时间段内占用的总节点资源量和总链路资源量;

18.a3、在预设接入时间点到达时,依次决策请求队列中接入请求是否在第二预测时间段内接入,若是,则将对应接入请求在所述第二预测时间段到达时进行接入,若否,则继续决策下一个接入请求,直到所述请求队列中所有接入请求均已决策完毕。

19.进一步地,所述步骤a2中确定总节点资源量和总链路资源量具体通过如下公式进行确定:

[0020][0021]

式中,为所述总节点资源量,为所述总链路资源量,t

sys

为系统资源需求预测窗口长度,和分别为第i个已接入网络切片在第二预测时间段[t

ac

1,t

ac

t

sys

]中某一时刻t将要占用的节点资源量和链路资源量,t

ac

为预设接入时间点,n

t

为第二预测时间段中某一时刻t时系统中已接入网络切片的数量。

[0022]

进一步地,所有网络切片分为高质量网络切片和低质量网络切片。

[0023]

进一步地,所述步骤a3中决策接入请求是否在第二预测时间段内接入具体通过如下公式进行决策:

[0024][0025]

式中,t

start

为接入请求对应的待接入网络切片实例化时间点,t

ac

为决策时间点,和分别为所有网络切片在第二预测时间段时刻t占用的总节点资源量和总链路资源量,t

adm

为接入窗口大小,t

dur

为接入请求对应的待接入网络切片的存活时长,d

max

和l

max

分别是可分配的节点资源上限和链路资源上限,若该用户请求高质量的网络切片,则若该用户请求标准质量的网络切片,则若该用户请求标准质量的网络切片,则d为系统节点资源总量,l为系统链路资源总量,为高质量网络切片的节

点资源上限,为高质量网络切片的链路资源上限,为标准质量网络切片的节点资源上限,为标准质量网络切片的链路资源上限。

[0026]

进一步地,在所述步骤a3中,每决策出一个需要在第二预测时间段内接入的接入请求时,还会即时对所述总节点资源量和所述总链路资源量进行更新,并在所述总节点资源量和所述总链路资源量更新后决策下一个接入请求。

[0027]

进一步地,通过如下公式对所述总节点资源量和所述总链路资源量进行更新:

[0028][0029]

式中,为更新后的总节点资源量,为更新后的总链路资源量,为更新前的总节点资源量,为更新前的总链路资源量,d

max

和l

max

分别是可分配的节点资源上限和链路资源上限,t

start

为接入请求对应的待接入网络切片实例化时间点,t

dur

为接入请求对应的待接入网络切片的存活时长。

[0030]

与现有技术相比,本发明具备以下有益效果:

[0031]

(1)本发明通过将所述网络切片的历史资源需求数据集输入到预设神经网络进行训练,基于训练好的第一神经网络和所述已接入网络切片的历史资源需求数据确定对应已接入网络切片在第一预测时间段的资源需求预测信息确定所述网络切片预测时间段内的资源需求预测信息,所述预测时间段包括多个时间点,所述资源需求预测信息包括每一个时间点对应的资源需求预测值,根据所述资源需求预测信息对所述网络切片进行资源预分配,并在下一个时间点到达时对所述网络切片进行资源分配,实现了服务提供商在不违反sla的前提下合理的分配网络切片的网络资源,避免了网络资源的浪费。

[0032]

(2)本发明提出的网络资源预分配算法能够利用资源需求预测信息动态地分配各个网络切片的节点资源和链路资源,避免分配多余资源造成浪费,提高了资源利用率,降低了网络切片资源成本。

[0033]

(3)本发明提出的接入控制算法能够利用预测信息辅助接入决策,避免过于保守接入策略导致的系统资源浪费,降低了用户请求的等待时长。

附图说明

[0034]

图1所示为本发明实施例提供的一种网络切片的网络资源动态分配方法的流程示意图;

[0035]

图2所示为本发明实施例中编码器

‑

解码器长短期记忆神经网络的结构示意图。

具体实施方式

[0036]

下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

[0037]

如背景技术中所述,现有技术无法使服务提供商在不违反sla的前提下高效地分

配网络切片的网络资源。

[0038]

因此,本技术提出了一种基于网络切片的网络资源动态分配方法,如图1所示为本技术实施例提出的一种基于网络切片的网络资源动态分配方法的流程示意图,该方法包括以下步骤:

[0039]

步骤s1、将已接入网络切片的历史资源需求数据集输入到第一神经网络进行训练。

[0040]

在具体应用场景中,第一预设神经网络具体为带偏好的编码器

‑

解码器长短期记忆神经网络(encoder

‑

decoder lstm with preference),也即lstm

‑

p,其结构图如图2所示,每个lstm单元由100个神经元组成;同一层的lstm是不同时刻的同一lstm单元;编码器由两个lstm单元组成,以资源需求历史信息作为输入,其输出为历史窗口t

obs

的最后一时刻第二个lstm的隐藏状态;转接器将编码器输出转换成解码器的输入格式;解码器由单个lstm单元组成,其输出是预测窗口t

pre

中每个时刻lstm的隐藏状态;全连接层是由timedistributed(

·

)封装的单个神经元,基于解码器的输出数据计算预测的资源需求信息,并将其输出到输出层。

[0041]

在本技术实施例中,第一预测神经网络的训练过程也即所述步骤s1具体包括以下分步骤:

[0042]

s11、将所述历史资源需求数据集输入到所述第一预测神经网络的编码器中得到编码器输出数据:

[0043]

s12、将所述编码器输出数据输入到所述第一预测神经网络的解码器中得到解码器输出数据;

[0044]

s13、将所述解码器输出数据输入到所述第一预测神经网络的全连接层中得到预测序列;

[0045]

s14、基于损失函数确定出所述预测序列和真实值之间的预测损失,并基于预测损失调整所述第一神经网络的参数值;

[0046]

s15、将步骤s11至步骤s14作为一次迭代,并在达到预设迭代次数后结束训练。

[0047]

具体的,将已接入网络切片的历史资源需求数据集输入到lstm

‑

p的编码器中,对于每个时刻t按如下公式计算和输出第二个lstm单元最终的隐藏状态也即编码器输出数据,计算公式具体为:

[0048][0049]

转接器将编码器的输出转换成解码器输入格式后输入到解码器中,令t=

1,

…

,t

pre

,按目标函数计算输出1到t

pre

内每个时刻lstm的隐藏状态,即也即解码器输出数据。

[0050]

将解码器的输出h3作为全连接层的输入,计算其中,w

f

和b

f

为全连接层的神经网络参数,具体数值由训练过程得到。输出预测序列

[0051]

当时刻t

p

,将lstm

‑

p用于预测第i个已接入网络切片的节点资源需求时,输入序列且输出序列将lstm

‑

p用于预测第i个已接入网络切片的链路资源需求时输入序列且输出序列且输出序列

[0052]

当资源需求预测值高于实际值y

(t)

时,服务提供商将按预测信息分配过多的资源给网络切片,导致额外的资源成本开销;当资源需求预测值低于实际值时,服务提供商按预测信息分配给网络切片的资源将低于实际需求,违反sla,导致赔付高额违约金。根据网络切片业务的特点,设计了如下损失函数,以反映资源过配置和sla违反对服务提供商的经济损失:

[0053][0054]

其中:

[0055][0056]

β>1表示对服务提供商违反sla的惩罚力度,y为真实值,为预测值。

[0057]

服务提供商将历史网络切片资源使用情况数据作为训练集,作为训练过程的损失函数,采用梯度下降法或其变种方法训练预测器lstm

‑

p,在迭代式的训练过程中不断地调整神经网络参数、降低损失函数值,以保证预测器的高准确度和低sla违反率。

[0058]

利用搭建好的lstm

‑

p预测器,实现对网络切片系统中活跃切片的资源预分配,并对等待队列中的待服务切片请求执行接入控制,以优化资源利用率。

[0059]

需要说明的是,以上神经网络仅是本技术中一种具体实现方式,本领域技术人员可根据实际情况灵活选择设置不同的神经网络,这并不影响本技术的保护范围。

[0060]

步骤s2、基于训练好的第一神经网络和所述已接入网络切片的历史资源需求数据确定对应已接入网络切片在第一预测时间段的资源需求预测信息。

[0061]

在本技术实施例中,所述资源需求预测信息具体包括预测节点资源量和预测链路资源量。

[0062]

步骤s3、根据所述资源需求预测信息对所述已接入网络切片进行资源预分配,并在第一预测时间段到达时对所述已接入网络切片进行资源分配。

[0063]

在本技术实施例中,中具体通过如下公式对已接入网络切片进行资源预分配,具体为确定出已接入网络切片在所述第一预测时间段内的预分配节点资源量和预分配链路

资源量:

[0064][0065]

其中,

[0066]

式中,为已接入网络切片i在第一预测时间段t的预分配节点资源量,已接入网络切片i在第一预测时间段t的预分配链路资源量,为已接入网络切片i在第一预测时间段t的预测节点资源量,为已接入网络切片i在第一预测时间段t的预测链路资源量,n

t

为在第一预测时间段t时系统中已接入网络切片的数量,γ

d

≥1代表节点资源冗余度,γ

l

≥1代表链路资源冗余度,γ

′

d

≥0和γ

l

′

≥0为加在对应预测值上的偏移量,d为系统节点资源总量,l为链路资源总量。

[0067]

在本技术实施例中,所述方法还包括以下步骤:

[0068]

a1、实时接收所有待接入网络切片的接入请求,并将所有接入请求存储在请求队列中;

[0069]

a2、确定出所有已接入网络切片在第二预测时间段内占用的总节点资源量和总链路资源量;

[0070]

a3、在预设接入时间点到达时,依次决策请求队列中接入请求是否在第二预测时间段内接入,若是,则将对应接入请求在所述第二预测时间段到达时进行接入,若否,则继续决策下一个接入请求,直到所述请求队列中所有接入请求均已决策完毕。

[0071]

在具体应用场景中,会实时接收待接入网络切片的接入请求也即来自用户的网络切片请求,并将其存储在请求队列中,另外,本技术中预先设置了预设接入时间点,然后会先确定出所有已接入网络切片在第二预测时间段占用的总节点资源量和总链路资源量,从而决策待接入请求是否接入。

[0072]

在本技术实施例中,所述步骤a2中确定总节点资源量和总链路资源量具体通过如下公式进行确定:

[0073][0074]

式中,为所述总节点资源量,为所述总链路资源量,t

sys

为系统资源需求预测窗口长度,和分别为第i个已接入网络切片在第二预测时间段[t

ac

1,t

ac

sys

]中某一时刻t将要占用的节点资源量和链路资源量,t

ac

为预设接入时间点,n

t

为第二预测时间段中某一时刻t时系统中已接入网络切片的数量。

[0075]

具体的,确定总节点资源量和总链路资源量时,先确定每一个已接入网络切片在第二预测时间段占用的节点资源量和链路资源量,然后将所有已接入网络切片在第二预测时间段占用的节点资源量和总链路资源量进行求和。

[0076]

需要说明的是,确定已接入网络切片在第二预测时间段占用的节点资源量和链路资源量具体通过第二神经网络进行预测得到,第二神经网络同第一神经网络一样,均是

lstm,预测公式也同第一神经网络一样。

[0077]

在本技术实施例中,所有网络切片分为高质量网络切片和低质量网络切片。

[0078]

在本技术实施例中,所述步骤a3中决策接入请求是否在第二预测时间段内接入具体通过如下公式进行决策:

[0079][0080]

式中,t

start

为接入请求对应的待接入网络切片实例化时间点,t

ac

为决策时间点,和分别为所有网络切片在第二预测时间段时刻t占用的总节点资源量和总链路资源量,t

adm

为接入窗口大小,t

dur

为接入请求对应的待接入网络切片的存活时长,d

max

和l

max

分别是可分配的节点资源上限和链路资源上限,若该用户请求高质量的网络切片,则若该用户请求标准质量的网络切片,则若该用户请求标准质量的网络切片,则d为系统节点资源总量,l为系统链路资源总量,为高质量网络切片的节点资源上限,为高质量网络切片的链路资源上限,为标准质量网络切片的节点资源上限,为标准质量网络切片的链路资源上限。

[0081]

具体的,上限是人为给每个切片设定的占用资源最大值,将每个切片占用资源闲置在一定范围内,避免某个切片占用系统大部分资源。

[0082]

其中,系统节点资源总量d具体是服务提供商可用的节点资源总量,也即系统中可分配给网络切片的节点资源总量,系统链路资源总量l具体是服务商可用的链路资源总量,也即系统中可分配给网络切片的链路资源总量。

[0083]

在本技术实施例中,在所述步骤a3中,每决策出一个需要在第二预测时间段内接入的接入请求时,还会即时对所述总节点资源量和所述总链路资源量进行更新,并在所述总节点资源量和所述总链路资源量更新后决策下一个接入请求。

[0084]

在本技术实施例中,通过如下公式对所述总节点资源量和所述总链路资源量进行更新:

[0085][0086]

式中,为更新后的总节点资源量,为更新后的总链路资源量,为更新前的总节点资源量,为更新前的总链路资源量,d

max

和l

max

分别是可分配的节点资源上限和链路资源上限,t

start

为接入请求对应的待接入网络切片实例化时间点,t

dur

为接入请求对应的待接入网络切片的存活时长。

[0087]

具体的,更新后的总节点资源量和更新后的总链路资源量,在决策下一个接入请求时,其代表符号会变成总节点资源量和总链路资源量更新前的代表符号,在预设接入时间点到达后且。

[0088]

本领域的普通技术人员将会意识到,这里所述的实施例是为了帮助读者理解本发明的原理,应被理解为本发明的保护范围并不局限于这样的特别陈述和实施例。本领域的普通技术人员可以根据本发明公开的这些技术启示做出各种不脱离本发明实质的其它各种具体变形和组合,这些变形和组合仍然在本发明的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。