一种基于ar智能眼镜的局部图像识别方法及系统

技术领域

1.本发明涉及ar智能眼镜技术领域,更具体地说,本发明涉及一种基于ar智能眼镜的局部图像识别方法及系统。

背景技术:

2.ar智能眼镜基于第一视角的交互方式,通过镜片将虚拟信息内容展示在用户的视场中,为用户提供增强现实的感官体验,是ar技术的智能终端硬件载体。

3.ar智能眼镜的应用范围广泛,可应用于工业、安防、医疗、教育等多个领域。如在工业领域,ar智能眼镜具有“实时虚实结合信息”的远程监控和指导功能,通过提供沉浸式和交互式的远程通讯体验,可辅助一线工作人员完成设备安装、维护、检修等工作。ar智能眼镜打破时间、地点和人物的限制,有效解决到现场指导成本高、因故障延误产生的经济损失、多人同步作业协调困难等问题;在安防领域,ar智能眼镜具有实时人脸或车牌识别、人证对比、远程调度、协同指挥等功能,可实现信息传递可视化和实时化,提升工作人员收集、处理信息的能力及效率;在医疗领域,佩戴ar智能眼镜的医生可通过第一视角拍摄手术过程,由远程的医生专家回传的画面进行远程指导,实现医生之间的实时和精准信息互动,提高诊断效率和优化医疗资源;在教育领域,ar智能眼镜以可视化和立体化的形式,将传统课堂的灌输式教学转变为寓教于乐的互动式教学。

4.但现有技术中的ar智能眼镜在进行局部图像识别时,往往容易被无用的信息干扰,从而降低产品的用户体验。

5.在所述背景技术部分公开的上述信息仅用于加强对本公开的背景的理解,因此它可以包括不构成对本领域普通技术人员已知的现有技术的信息。

技术实现要素:

6.为了克服现有技术的上述缺陷,本发明的实施例提供一种基于ar智能眼镜的局部图像识别方法及系统,本发明所要解决的技术问题是:如何避免进行图像识别时被无用信息所干扰,从而提高用户体验。

7.为实现上述目的,本发明提供如下技术方案:一种基于ar智能眼镜的局部图像识别方法,具体包括如下步骤:

8.步骤一:建立参照集:在原型网络的嵌入空间中定义若干个样本;

9.步骤二:一致性校准标定:对ar智能眼镜摄像头进行图像畸变校正和标定;

10.步骤三:获取眼睛运动坐标:采用瞳孔

‑

角膜反射光斑法或mems眼球追踪技术,来识别人眼图像并计算眼球运动向量,并将人眼的运动行为数字化,转化为计算机系统计算的电子信号;

11.步骤四:获取人眼在周围真实世界的映射关系:根据内嵌映射算法分别获取人眼注视点在眼镜成像屏幕和前置摄像头画面的坐标位置;

12.步骤五:启动局部图像识别程序:

13.(1)边缘探测:从待识别的图像中抽出线条,并检测出图像边缘或者抽出图像轮廓;

14.(2)二值图像处理:对检测出的二值化图像进行修正,使得图像更加清晰;

15.(3)将图像映射成嵌入向量:充分利用节点在原型网络中的拓扑关系,给出节点的隐含向量表示,从而将离散空间中的网络节点嵌入到高维空间中;

16.(4)定义图像原型:利用神经网络的非线性映射将输入图像映射到嵌入空间中,此时嵌入空间中参照集的加权平均值即为图像原型;

17.(5)计算测试点到原型图像之间的距离:通过计算嵌入到空间中的观察图像和对应样本原型表达的距离来排除视觉环境下无用图像信息的干扰;

18.步骤六:局部图像的传输处理:将局部图像通过以太网上传至云端服务器处理,并对图像进行运算、语义分割处理、识别、比对,接着将获得的相关运算结果从云端服务器通过以太网回传至智能眼镜终端进行内容呈现。

19.在一个优选地实施方式中,上述步骤五的(1)中进行图像边缘探测时所用到的算法为微分算法或掩模算法。

20.在一个优选地实施方式中,上述步骤五的(2)中二值图像处理包括以下操作:

21.a、膨胀使粒子变大:对图像进行膨胀处理之后再进行收缩处理,以修正图像的凹槽;

22.b、收缩使粒子变小:对图像进行收缩处理之后再进行膨胀处理,以修正图像的凸槽;

23.c、清除孤立点:清除由一个像素构成的对象以及修正由一个像素构成的孔;

24.d、清除粒子:清除任意面积以下的对象;

25.e、清除超大粒子:清除任意面积以上的对象;

26.f、洞穴填充:填充任意范围。

27.一种基于ar智能眼镜的局部图像识别系统,该系统包括有dm6437处理核心和与dm6437处理核心呈双向连接的ar智能眼镜终端以及云端服务器,所述ar智能眼镜终端用于捕捉周围环境的图像并将其上传至dm6437处理核心进行处理,所述dm6437处理核心用于对获取的局部图像进行系列处理并通过以太网传输至云端服务器,所述云端服务器用于对图像进行运算、语义分割处理、识别、比对,并将结果回传至ar智能眼镜终端进行内容呈现。

28.在一个优选地实施方式中,所述dm6437处理核心包括对ar智能眼镜摄像头进行图像畸变校正和标定的图像畸变校正与标定单元、识别人眼图像并计算眼球运动向量的人眼运动坐标获取单元、获取人眼注视点在眼镜成像屏幕和前置摄像头画面的坐标位置的映射关系获取单元和对采集图像进行识别的图像识别单元。

29.本发明的技术效果和优点:

30.本发明通过采用微分算法或掩模算法对视野内的图像进行边缘探测,并对探测处的二值化图像进行修正,使采集图像更加清晰,同时将视野内的图像嵌入到高维空间中,并通过计算嵌入到空间中的观察图像和对应样本原型表达的距离来排除视觉环境下无用图像信息的干扰,从而大大提高了用户体验感。

附图说明

31.附图用来提供对本发明技术方案的进一步理解,构成本发明的一部分,本发明的实施例及其说明用于解释本发明,并不构成对本发明的不当限定。

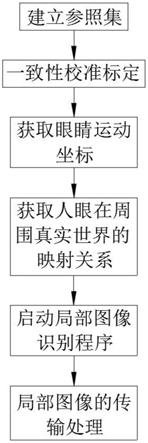

32.图1为本发明的局部图像识别流程图。

33.图2为本发明的局部图像识别系统框图。

具体实施方式

34.现在将参考附图更全面地描述示例实施方式。然而,示例实施方式能够以多种形式实施,且不应被理解为限于在此阐述的范例;相反,提供这些示例实施方式使得本公开的描述将更加全面和完整,并将示例实施方式的构思全面地传达给本领域的技术人员。附图仅为本公开的示意性图解,并非一定是按比例绘制。图中相同的附图标记表示相同或类似的部分,因而将省略对它们的重复描述。

35.此外,所描述的特征、结构或特性可以以任何合适的方式结合在一个或更多示例实施方式中。在下面的描述中,提供许多具体细节从而给出对本公开的示例实施方式的充分理解。然而,本领域技术人员将意识到,可以实践本公开的技术方案而省略所述特定细节中的一个或更多,或者可以采用其它的方法、组元、步骤等。在其它情况下,不详细示出或描述公知结构、方法、实现或者操作以避免喧宾夺主而使得本公开的各方面变得模糊。

36.本发明提供了如图1所示的一种基于ar智能眼镜的局部图像识别方法,具体包括如下步骤:

37.步骤一:建立参照集:在原型网络的嵌入空间中定义若干个样本;

38.步骤二:一致性校准标定:对ar智能眼镜摄像头进行图像畸变校正和标定,得到真实世界坐标与ar眼镜成像屏幕和智能眼镜前置摄像头画面三者之间的坐标的投影关系;

39.步骤三:获取眼睛运动坐标:采用瞳孔

‑

角膜反射光斑法或mems眼球追踪技术,来识别人眼图像并计算眼球运动向量,并将人眼的运动行为数字化,转化为计算机系统计算的电子信号;

40.步骤四:获取人眼在周围真实世界的映射关系:根据内嵌映射算法分别获取人眼注视点在眼镜成像屏幕和前置摄像头画面的坐标位置;

41.步骤五:启动局部图像识别程序:

42.(1)边缘探测:从待识别的图像中抽出线条,并检测出图像边缘或者抽出图像轮廓;

43.(2)二值图像处理:利用微分算法(现有技术)或掩模算法(现有技术)对检测出的二值化图像进行修正,使得图像更加清晰;

44.具体地,二值图像处理包括以下操作:

45.a、膨胀使粒子变大:对图像进行膨胀处理之后再进行收缩处理,以修正图像的凹槽;

46.b、收缩使粒子变小:对图像进行收缩处理之后再进行膨胀处理,以修正图像的凸槽;

47.c、清除孤立点:清除由一个像素构成的对象以及修正由一个像素构成的孔;

48.d、清除粒子:清除任意面积以下的对象;

49.e、清除超大粒子:清除任意面积以上的对象;

50.f、洞穴填充:填充任意范围;

51.(3)将图像映射成嵌入向量:充分利用节点在原型网络中的拓扑关系,给出节点的隐含向量表示,从而将离散空间中的网络节点嵌入到高维空间中;

52.(4)定义图像原型:利用神经网络的非线性映射将输入图像映射到嵌入空间中,此时嵌入空间中参照集的加权平均值即为图像原型;

53.具体地,该过程中编码器将图形映射到嵌入空间后,每个图像都会生成一个协方差矩阵,而后对采集到的局部图像产生的协方差矩阵进行聚类;

54.(5)计算测试点到原型图像之间的距离:通过计算嵌入到空间中的观察图像和对应样本原型表达的距离来排除视觉环境下无用图像信息的干扰,从而将目标图像转化成了在特征向量空间中的最临近问题;

55.步骤六:局部图像的传输处理:将局部图像通过以太网上传至云端服务器处理,并对图像进行运算、语义分割处理、识别、比对,接着将获得的相关运算结果从云端服务器通过以太网回传至智能眼镜终端进行内容呈现。

56.本发明提供了如图2所示的一种基于ar智能眼镜的局部图像识别系统,该系统包括有dm6437处理核心和与dm6437处理核心呈双向连接的ar智能眼镜终端以及云端服务器,所述ar智能眼镜终端用于捕捉周围环境的图像并将其上传至dm6437处理核心进行处理,所述dm6437处理核心用于对获取的局部图像进行系列处理并通过以太网传输至云端服务器,所述云端服务器用于对图像进行运算、语义分割处理、识别、比对,并将结果回传至ar智能眼镜终端进行内容呈现。

57.进一步的,所述dm6437处理核心包括对ar智能眼镜摄像头进行图像畸变校正和标定的图像畸变校正与标定单元、识别人眼图像并计算眼球运动向量的人眼运动坐标获取单元、获取人眼注视点在眼镜成像屏幕和前置摄像头画面的坐标位置的映射关系获取单元和对采集图像进行识别的图像识别单元。

58.在上述局部图像识别系统中,dm6437包括一个视频处理子系统(vpss),带2个可配置的视频/图像外设:一个视频处理前端vpfe用于视频捕捉,一个视频处理后端vpbe用于视频输出。

59.1)vpfe包括1个ccdc(ccd控制器),1个预览引擎previewer,histogram(直方图)module,auto

‑

exposure/white balance/focus module(h3a),and resizer。ccdc与通用视频解码器,cmos传感器以及ccds(charge oupled devies)相连。previewer是一个实时图像处理引擎,它从cmos传感器或ccd获取图像数据,并将之从rgb bayer类型转换成yuv422。histogram和h3a模块提供原始色彩数据的统计信息供dm6437使用。resizer模块接受图像数据,并可以分别在水平和垂直方向从1/4x到4x做缩放处理。

60.2)vpbe则包括一个osd(on

‑

screen display engine)和一个视频编码器(venc)。osd引擎可以处理2个独立的视频窗口和2个独立的osd窗口,其他配置包括2个视频窗口,1个osd窗口,1个专门的窗口允许多达8级的alpha blending(混合)。venc提供4个54mhz的dacs,并提供composite ntsc/pal视频,s

‑

video和/或component视频输出,另外它还提供高达24

‑

bit的数字视频输出至rgb888接口。数字视频可以是8/16

‑

bit bt.656和/或ccir.601的水平和垂直同步独立输出。

61.以上只通过说明的方式描述了本发明的某些示范性实施例,毋庸置疑,对于本领域的普通技术人员,在不偏离本发明的精神和范围的情况下,可以用各种不同的方式对所描述的实施例进行修正。因此,上述附图和描述在本质上是说明性的,不应理解为对本发明权利要求保护范围的限制。

62.最后应说明的几点是:首先,在本技术的描述中,需要说明的是,除非另有规定和限定,术语“安装”、“相连”、“连接”应做广义理解,可以是机械连接或电连接,也可以是两个元件内部的连通,可以是直接相连,“上”、“下”、“左”、“右”等仅用于表示相对位置关系,当被描述对象的绝对位置改变,则相对位置关系可能发生改变;

63.其次:本发明公开实施例附图中,只涉及到与本公开实施例涉及到的结构,其他结构可参考通常设计,在不冲突情况下,本发明同一实施例及不同实施例可以相互组合;

64.最后:以上所述仅为本发明的优选实施例而已,并不用于限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。