1.本说明书涉及自然语言处理(nlp)和ai问答(qa)领域,尤其是一种情境化问答方法。

背景技术:

2.自然语言处理(nlp)被定义为人工智能的分支,专注于使用自然语言进行人与计算机之间的交互。问答(qa)代表了nlp的核心研究领域之一。

3.在qa任务中,给模型一组数据(上下文),该数据集可能由单词和数字组成,然后问一个关于文本的问题。理想的模型会根据上下文输入来解释问题,并提供由人预先确定的正确答案。

4.例如,当被提问到“yuan dynasty的中文名称是什么?”时,该模型参考预先存在的上下文数据,通过端到端神经网络模型的组成层,将上述提问解释为一串单词。

技术实现要素:

5.为更好地应用模型来分析数据集并给出问题的准确回答,本发明创造性地对模型进行了改进。

6.本发明提供一种情境化问答方法,包括:(a)接收以字母数字或字母形式表示英语句子、单词或字符的文档数据集;(b)计算每个单词和字符的向量,并在上下文单词之间生成语义上有意义的连接;(c)以问题的形式接收用户查询;(d)响应接收到用户查询,为文档数据赋值赋予数值向量,所述数值向量表示该查询中的每个单词、文本、数字和字符之间的关系;(e)根据用户提出的查询,计算概率最高的单词和句子;(f)输出语义等效查询或文档注意机制的表示;(g)根据先前的表示,确定最佳的情境化答案。

7.实施本发明,有如下有益技术效果:

8.使用具有训练文本嵌入特征的nlp模型来分析、测试和评估提问,使用叠加转换器类型模型层的创新方法来计算最高概率词来回答与查询数据相关的问题。准确度的级别以百分比来表示,以衡量qa模型的整体性能。该模型可以提供一个非常准确的答案,性能十分优秀。

附图说明

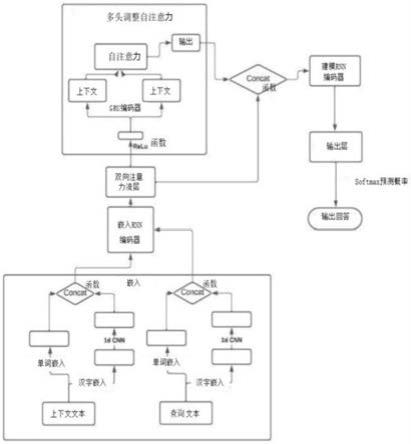

9.图1是本发明情境化问答方法包含步骤和流程的示意图;

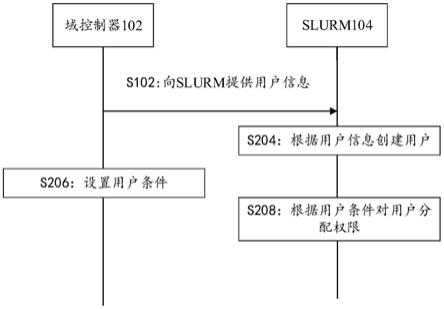

10.图2是本发明情境化问答方法中多头自注意力层示意图。

具体实施方式

11.下面结合附图和实施例对本发明实施例作进一步的详细说明,下述实施例在以本发明技术方案为前提下进行实施,可以理解的是,此处所描述的具体实施例仅仅用于解释本发明实施例,而非对本发明的限定。另外还需要说明的是,为了便于描述,附图中仅示出

了与本发明实施例相关的部分而非全部内容。

12.在更加详细地讨论示例性实施例之前应当提到的是,一些示例性实施例被描述成作为流程图描绘的处理或方法。当其操作完成时所述处理可以被终止,但是还可以具有未包括在附图中的附加步骤。所述处理可以对应于方法、函数、规程、子例程、子程序等等。

13.参考图1

‑

2,本发明提供一种情境化问答方法,包括:

14.(a)接收以字母数字或字母形式表示英语句子、单词或字符的文档数据集;

15.(b)计算每个单词和字符的向量,并在上下文单词之间生成语义上有意义的连接;

16.(c)以问题的形式接收用户查询;

17.(d)响应接收到用户查询,为文档数据赋值赋予数值向量,所述数值向量表示该查询中的每个单词、文本、数字和字符之间的关系;

18.(e)根据用户提出的查询,计算概率最高的单词和句子;

19.(f)输出语义等效查询或文档注意机制的表示;

20.(g)根据先前的表示,确定最佳的情境化答案。

21.图1是一个流程图,说明了可用于实现下文所述改进的技术的nlp模型的六层。本技术中使用的nlp模型由嵌入层、编码层、双向注意力流层、多头自注意力层、模型编码层、输出层这六层组成。

22.嵌入层将查询和上下文嵌入到向量表示中。

23.嵌入层(layers.embedding)。

24.给定一些输入词索引,w1,...,w

k

∈n,嵌入层执行嵌入查找,将索引转换为单词嵌入v1,...,v

k

∈r

d

。为上下文和提问均执行该操作,上下文产生嵌入c1,...,c

n

∈r

d

,提问产生嵌入q1,...,q

m

∈r

d

。

25.在嵌入层中,我们通过以下两步进一步细化嵌入过程:

26.1.我们认为,每个嵌入有维数h:让w

proj

∈r

hxd

是一个由参数组成的可学习矩阵,每个嵌入向量v

i

被映射到h

i

=w

proj

v

i

∈r

h

。

27.2.我们应用高速网络来细化嵌入的表示。给定一个输入矢量h

i

,单层高速网络进行计算:

[0028][0029][0030][0031]

式中,w

g

,w

t

∈r

hxh

,bg,b

t

∈r

h

为可学习参数(g为“gate”,t为“tansform”)。我们使用一个两层的高速网络来转换每个隐藏向量hi,这意味着我们两次应用上述转换,每次转换使用不同的可学习参数。

[0032]

编码层采用嵌入层的输出作为输入,并使用长短期记忆网络(lstm)对序列进行编码。这使模型即使在处理嵌入序列后也能“记住”它们。

[0033]

双向注意力流层从上下文流向查询,以及从查询流向上下文。该层的主要目的是突出和强调查询词与上下文词之间的匹配。这是为了提高查询的准确性和整体文档可理解性。

[0034]

多头自注意力层看到,将上下文分为“关键信息,查询和值”三个头(考虑上下文的3个随机样本),然后将这三个头与该上下文自身一起输入注意力层,以便这些头(这些头构

成了上下文内的一些词)可以与其他单词相匹配。然后将这些“关键信息,查询和值”输出的头,输入到按比例缩放的点积中。如图2所示。

[0035]

模型编码层确保所有数据都是从注意力层捕获的。

[0036]

模型层的任务是细化注意力层之后的向量序列。由于模型层位于注意力层之后,所以上下文表示在到达模型层时以问题为条件。因此,模型层根据问题汇集上下文表示之间的时间信息。类似于编码层,我们使用双向lstm给定的输入向量g

i

∈r

8h

,模型层计算:

[0037][0038][0039][0040]

模型层与编码层的不同之处在于,我们在编码层中使用单层lstm,而在模型层中使用双层lstm。

[0041]

输出层的任务是生成一个与上下文中每个位置对应的概率向量:p

start

,p

end

∈r

n

。如符号标记所示,p

start

(i)是回答跨度从位置i开始的预测概率,类似地,p

end

(i)是回答跨度结束于位置i的预测概率。(有关预测无答案的详细信息,请参阅下面的预测无答案部分)

[0042]

具体来说,输出层以注意力层输出的g1,...,g

n

∈r

8h

和模型层输出m1,...,m

n

∈r

2h

作为输入。输出层将双向lstm应用于模型层输出,对每个m

i

产生一个向量m

i’,通过下面公式得出:

[0043][0044][0045][0046]

现在,设g∈r

8h

×

n

是具有g1,...,g

n

列的矩阵,并使m1,...,m

n

∈r

2h

×

n

,就类似于,使矩阵分别具有列m1,...,m

n

和m

i’,...,m

n’。为了最终产生p

start

和p

end

,输出层进行下列计算:

[0047]

p

star

t=softmax(w

start

[g;m]) p

end

=softmax(w

end

[g;m

′

]),

[0048]

其中,w

start

,w

end

∈r1×

10h

是可学习的参数。在代码中,请注意,softmax函数运算使用了上下文掩码,并且为了数值稳定性,并因为f.nll_loss函数期望对数概率,我们在log

‑

space函数中计算了所有的概率。

[0049]

以上所述,仅为本发明的具体实施方式,所属领域的技术人员可以清楚地了解到,为了描述的方便和简洁,上述描述的系统、模块和单元的具体工作过程,可以参考前述方法实施例中的对应过程,在此不再赘述。应理解,本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到各种等效的修改或替换,这些修改或替换都应涵盖在本发明的保护范围之内。。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。