1.本发明涉及图像数据处理领域,尤其涉及一种多模态特征融合网络的图像描述生成方法。

背景技术:

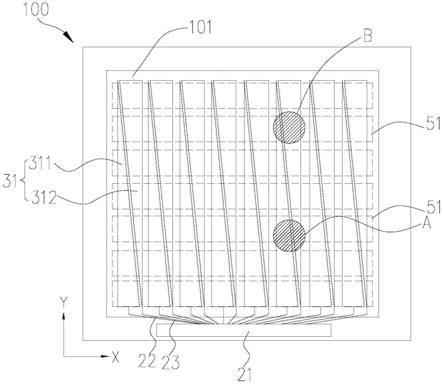

::2.理解一幅图像很大程度上依赖于所获得的图像特征,用于获取特征的技术包括传统的机器学习技术和深度机器学习技术。传统的机器学习技术,提取lbps、sift和hog等人工特征,将它们或它们的组合送入svm等分类器,用于确定对象类别,这种方法存在两个缺点,一是这些人工特征都是面向任务的,从量大而且具有多样性的数据集中提取此类特征是不可行的;二是真实世界的数据复杂而且具有不同的语义解释。相反,深度机器学习技术,可以从训练集中自动学习特征,而且适合处理量大且具有多样性的数据集。3.现有的lstm‑a、plstm‑a‑2、vs‑lstm、daa、rfnet、up‑down和vsv‑vrv‑pos等代表性模型,图像特征的提取和利用不够充分、语义鸿沟依然存在。技术实现要素:4.本发明的目的在于提供一种多模态特征融合网络的图像描述生成方法,旨在更好地挖掘隐含层向量和对象特征的关联性,实现更高的图像描述生成性能。5.为实现上述目的,本发明提供了一种多模态特征融合网络的图像描述生成方法,包括构建多模态特征融合网络;6.在up‑down模型基础架构上设计解码端;7.将多模态特征融合网络融入到解码端,形成基于多模态特征融合网络的图像描述生成模型;8.训练基于多模态特征融合网络的图像描述生成模型;9.输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证。10.其中,所述多模态特征融合网络由多层特征融合模块级联而成,每一层由注意力模块和循环神经网络组合而成;每层都有都包括局部特征信息和全局特征信息,所述局部特征信息用于注意力模块的使用;所述全局特征信息作为循环神经网络的初始向量。11.其中,所述构建多模态特征融合网络的具体步骤是:12.将当前层特征融合模块的特征输出嵌入到下一层的特征融合模块中;13.通过注意力模块将上一层的融合特征传递到所述当前层的循环神经网络中,循环神经网络每一时间步的输入为当前的隐含层和加权融合注意力;14.将所述下一层每一时刻循环单元的输出结果拼接起来,形成最终的融合向量组;15.每层的循环融合网络后设置前馈神经网络进行处理,该所述前馈神经网络由两个线性变换组成,两个线性变换之间使用relu激活函数连接;16.然后使用残差连接和层标准化;17.对池化层级特征向量依次相加,并通过学习嵌入矩阵参数得到全局层级特征。18.其中,所述解码端由生成注意权重注意网络和生成单词语言网络构成。19.其中,所述训练基于多模态特征融合网络的图像描述生成模型的具体方式是:使用交叉熵损失和cider优化来训练模型。20.其中,所述输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证的具体步骤是:21.输入测试图像并初始化生成模型参数;22.使用adam优化器对captioningmodel模型进行交叉熵损失训练寻找最小值;23.使用self‑criticaltrainingstrategy通过cider‑d奖赏继续优化训练;24.采用波束搜索策略进行推理测试;25.对模型进行评价。26.本发明的一种多模态特征融合网络的图像描述生成方法,提出一种多模态特征融合网络(mff‑net),使用多模态结构扩展传统编解码框架,以增强对象特征之间的相关性。mff‑net使用循环神经网络构建层级结构来融合编码特征,且使用注意力机制来加权输入信息,以此让编码器提取的单一图像特征相互关联,增强特征交互。实验结果表明,mff‑net模型方法达到了与最先进的方法竞争的性能,在mscocokarpathy离线测试split上达到了126.5cider‑d分数,在官方在线测试服务器上达到了123.2cider‑d(c40)分数。27.本发明的有益效果如下:28.提出利用循环神经网络结合注意力学习融合图像特征,这是对单一编解码器模型的扩展,能更好的获取内在特征的序列关联性;在编码器和解码器之间应用了融合网络,以层次结构相互连接,并在解码器端融合了的层级特征向量。这样能充分挖掘对象特征之间更高层级的相互关系,生成更加详细的图像描述;提出的方法具备通用性,可以应用于其他编解码框架的视觉‑语言任务中。在mscoco数据集上与最先进的方法相比,图像描述模型实现了具有竞争力的性能。附图说明29.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。30.图1是本发明的一种多模态特征融合网络的图像描述生成方法的流程图;31.图2是本发明的构建多模态特征融合网络的流程图;32.图3是本发明的输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证的流程图;33.图4是本发明的一种多模态特征融合网络架构图。具体实施方式34.下面详细描述本发明的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,旨在用于解释本发明,而不能理解为对本发明的限制。35.请参阅图1~图4,本发明提供一种多模态特征融合网络的图像描述生成方法,包括:36.s101构建多模态特征融合网络;37.所述多模态特征融合网络由多层特征融合模块级联而成,每一层由注意力模块和循环神经网络组合而成;每层都有都包括局部特征信息和全局特征信息,所述局部特征信息用于注意力模块的使用;所述全局特征信息作为循环神经网络的初始向量。注意力模块用于图像区域特征和循环神经网络序列特征两者模态间的信息交互,循环神经网络用于增强特征之间的关联和融合不同的图像局部特征。38.具体步骤是:39.s201将当前层特征融合模块的特征输出嵌入到下一层的特征融合模块中;40.以第i(0≤i<m)层的输出为例。首先它们被嵌入到第i 1层的特征融合模块中:[0041][0042]其中fi 1代表mff‑net的第i 1层的特征输出。[0043]ffm(·)代表特征融合模块(即mff‑net)的输出。[0044]fi代表mff‑net的第i(0≤i<m)层的特征输出。[0045]代表fi的均值,[0046][0047]fi代表mff‑net的第i(0≤i<m)层的特征输出,它共有k个分量,每个分量用表示。[0048][0049]代表fi中k个分量的均值。[0050]其中hi 1是通过特征融合模块输出的隐藏状态,ffm(·)表示特征融合模块,表示第i层的池化层级特征。注意的是,f0是使用fasterr‑cnn目标检测方法提取的图像区域特征[0051]s202通过注意力模块将上一层的融合特征传递到所述当前层的循环神经网络中,循环神经网络每一时间步的输入为当前的隐含层和加权融合注意力;[0052][0053]代表i 1层在t 1时刻的网络隐状态,[0054]rnn[·]代表循环神经网络的输出。[0055]代表i 1层在t时刻的权重系数。[0056]代表i 1层在t时刻的网络隐状态。[0057][0058]表示第i层的第i个特征在t时刻的权重系数。[0059]表示融合层需要学习的视觉参数。[0060]tanh(·)表示双曲正切激活函数。[0061]表示第i层mff‑net输出特征的第i个分量。[0062]wmf和wmh表示融合层需要学习的视觉参数。[0063]表示第i 1层mff‑net网络在t时刻的隐状态。[0064][0065]表示第i层的t时刻全部特征的权重系数。[0066]softmax(·)表示归一化到[0,1]的操作。[0067][0068]表示第i 1层在t时刻对特征学习得到的关注结果。[0069]表示第i层的第i个特征在t时刻的被关注程度,即权重系数。[0070]表示第i层mff‑net输出特征的第i个分量。[0071]其中,隐含层初始化状态为上一层的池化层级特征wmf,wmh和是融合层需要学习的视觉参数;是t时刻学习得到的关注结果。注意,这里融合方式使用门控循环单元(gru),因为它不仅能在保留长期序列信息下减少梯度消失问题,而且相对lstm参数更少更容易收敛。[0072]s203将所述下一层每一时刻循环单元的输出结果拼接起来,形成最终的融合向量组;[0073]将第i 1层每一时刻循环单元的输出结果拼接起来,形成最终的hi 1融合向量组。[0074][0075]hi 1表示第i 1层的融合向量组。[0076]concat(·)表示向量连接操作。[0077]分别代表第i 1层时刻1、2、…、t的循环单元的隐状态(即循环单元的输出结果)。[0078]符号“[·,·]”表示向量拼接操作。[0079]s204每层的循环融合网络后设置前馈神经网络进行处理,该所述前馈神经网络由两个线性变换组成,两个线性变换之间使用relu激活函数连接;[0080]在每一子层的循环融合网络后是一个前馈神经网络(ffn),该网络由两个线性变换组成,两个线性变换之间使用relu激活函数:[0081]ffn(x)=w2relu(w1x b1) b2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ(18)[0082]fi 1=ffn(hi 1)ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ(19)[0083]x表示ffn网络的输入向量。[0084]ffn(x)表示前馈神经网络的输出。[0085]表示ffn学习参数。[0086]relu表示激活函数。[0087]表示ffn学习参数。[0088]b1表示w1的偏置项。[0089]b2表示w2的偏置项。[0090]是i 1块的输出。[0091]hi 1表示第i 1层的融合向量。[0092]ffn(·)表示前馈神经网络的输出。[0093]其中,是i 1块的输出。[0094]s205然后使用残差连接和层标准化;[0095]每个子层之后使用残差连接和层标准化,这里省略它们以进行简明的解释。[0096][0097]表示全局层级特征。[0098]wg和wf为连接参数。[0099]tanh(·)表示双曲正切激活函数。[0100]表示第i层mff‑net网络输出特征向量的均值。代表v的均值。[0101]m表示mff‑net网络总共有多少层数。[0102]s206对池化层级特征向量依次相加,并通过学习嵌入矩阵参数得到全局层级特征。[0103]为了鼓励学习层级之间的相互作用关系,促进多模态信息交互,对池化层级特征向量依次相加,并通过学习wg,和wf嵌入矩阵参数,得到全局层级特征[0104]s102在up‑down模型基础架构上设计解码端;[0105]所述解码端由生成注意权重注意网络和生成单词语言网络构成。[0106]up‑down模型有着卓越的表现,使用其作为本模型方法的基础框架。这个框架有两个lstm堆积组成,一个生成注意权重的注意lstmatt,一个生成单词的语言lstmlang。它们在t时刻的隐含状态分别表示为和[0107]在较高的层次上,lstm的隐藏状态被建模为:[0108]ht=lstm(xt,ht‑1)ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ(1)[0109]其中ht和ht‑1为lstm网络在t时刻和t‑1时刻的隐藏状态。lstm()表示lstm网络的输出,xt为lstm输入向量。为了便于记法,省略了存储单元的传播。[0110][0111]其中,表示解码端注意力网络在t时刻的隐藏状态;xt‑1表示t‑1时刻的词嵌入向量;表示全局层级特征;表示解码端语言网络在t‑1时刻的隐藏状态;lstmatt()表示注意力网络的映射操作。[0112]对于注意lstm的每一时间步输入,其中xt‑1是前一个词嵌入、是前一个语言lstm的隐藏状态向量。是来自mff‑net的全局层级特征,它为注意lstm提供了图像的多层级融合信息。多模态特征融合网络细节将在第3.2节中说明。[0113]对给定图像i经过多模态特征融合网络的m个子层后,其输出融合特征fm可以表示为:[0114][0115]其中,代表mff‑net最后一层融合特征fm的第i个分量,每个分量为d维的实数。[0116]语言模型lstm的输入由注意加权图像特征与当前注意lstm的隐藏状态连接而成:[0117][0118]其中lstmlang代表语言网络,attt表示语言网络lstmlang在t时刻的注意力,表示注意力网络lstmatt在t时刻的隐状态,表示语言网络lstmlang在t时刻的隐状态;lstmlang表示语言网络的映射输出。[0119]其中,attt是fi的加权和:[0120][0121]αt=softmax(at)ꢀꢀꢀꢀ(6)[0122][0123]其中waf和wah是学习视觉注意部分的参数。[0124]是f的相关权值,其和为1,即attt是f的加权和,表示要生成单词的最相关位置。[0125]αt,i表示第i层t时刻对特征的关注程度,即权重系数。[0126]tanh表示双曲正切激活函数[0127]softmax(·)表示归一化到[0,1]的操作。[0128]表示mff‑net第m层的第i个融合特征分量。[0129]使用符号y1:t引用一个单词序列(y1,...,yt),在每个时间步长t下,给定对可能输出单词的条件分布:[0130][0131]p(yt|y1:t‑1)单词序列的条件概率。[0132]softmax(·)表示归一化到[0,1]的操作。[0133]wp表示映射输出的学习参数[0134]bp表示映射输出的偏置[0135]表示语言lstm网络在t时刻的隐状态。[0136]对完整输出序列的分布计算为条件分布的乘积:[0137][0138]p(y1∶t)表示解码端完整输出单词序列的分布概率。[0139]p(yt|y1:t‑1)单词序列的条件概率。[0140]符合表示乘积运算。[0141]s103将多模态特征融合网络融入到解码端,形成基于多模态特征融合网络的图像描述生成模型;[0142]s104训练基于多模态特征融合网络的图像描述生成模型;[0143]具体方式是:使用交叉熵损失和cider优化来训练模型。[0144]在给定目标地真值序列和带有参数θ的描述模型的情况下,通过优化交叉熵(xe)lxe对mff‑net进行训练:[0145][0146]lxe(θ)表示损失函数。[0147]表示参数为θ的联合概率分布。[0148]表示t时刻的预测输出。[0149]表示t时刻的输入。[0150]自强化学习应用于描述模型以来,大量研究都使用该方法来优化训练。为了进行公平的比较,从交叉熵训练的模型初始化,寻求最小的负期望分数:[0151][0152]lr(·)表示强化学习的奖赏函数。[0153]θ表示模型的优化参数。[0154]pθ表示参数θ的分布。[0155]e表示y1∶t服从pθ分布时r(y1∶t)的数学期望。[0156]r(y1:t)表示通过解码当前模型生成句子获得的分数。[0157]其中r为cider‑d评分函数。直接用自临界序列训练(scst)优化不可微指标,这种损失的梯度可以近似:[0158][0159]其中:[0160]表示求导操作。[0161]lr(·)表示强化学习的奖赏函数。[0162]符号“≈”表示使用蒙特卡罗方法近似采样。[0163]为采样标题,上标“s”代表句子。[0164]定义贪婪解码当前模型得到的基线得分。[0165]pθ表示参数θ的分布.[0166]s105输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证。[0167]具体步骤是:[0168]s301输入测试图像并初始化生成模型参数;[0169]首先在数据预处理部分,将训练图像集中图像标注语句的所有单词全部转换为小写字母,并以出现次数大于指定阈值的单词建立单词库,在本文实验中单词阈值设为5。在实验部分,使用mscoco2014captions数据集来评估提出的方法。mscoco数据集包含123,287张图像,每个图像标有5个标题,包括82,783张训练图像和40,504张验证图像。mscoco也提供了40,775张图片作为在线评估的测试集。theoffline“karpathy″datasplit用于离线性能比较,这种分割在之前的工作中得到了广泛的应用,其中113,287张带有5个标题的图像进行训练,并用5000张图像用于验证,5000张图像用于测试。为了对本文所提出的模型方法进行定量的性能评价,并与其他方法进行比较,使用了标准的自动评估指标,其中包括bleu,meteor,rouge‑l常规机器翻译的度量指标,以及专门用于imagecaptioning的cider‑d和spice度量指标。[0170]s302使用adam优化器对captioningmodel模型进行交叉熵损失训练寻找最小值;[0171]整个imagecaptioning框架主要是用pytorch实现的,用adam进行优化。在实验的参数方面,up‑down模型遵循的设置,语言lstm的隐藏状态维度设置为1000,注意lstm和单词嵌入维度设置为1000,注意层的维度是512。使用预先训练的faster‑rcnn模型从pool‑5层中提取2048维的目标特征。在特征融合网络中,使用soft‑attention作为融合注意力网络,使用gru作为融合编码器。融合gru的输入维度维数为1000,隐藏状态维数为1000,层级之间的传递维数为1000。在训练模型方面,遵循up‑down模型中的训练策略,首先使用adam优化器以5e‑4的学习速度对captioningmodel模型进行交叉熵损失训练寻找最小值,批次大小为10,历时30个epochs,并每5个周期增加0.05的预定抽样概率。[0172]s303使用self‑criticaltrainingstrategy通过cider‑d奖赏继续优化训练;[0173]使用self‑criticaltrainingstrategy通过cider‑d奖赏继续优化训练,以5e‑5的学习速率,重量衰减为1e‑5,批处理大小设置为10,历时30个epochs。[0174]s304采用波束搜索策略进行推理测试;[0175]在推理测试方面,采用波束搜索策略,并将波束大小设为2。[0176]s305对模型进行评价。[0177]同时使用传统的imagecaptioning评价指标对模型进行评价。[0178]在表1和表2中报告了模型在offlinecocokarpathytestsplit的性能表现。为了与其他模型公平地进行性能比较,模型都是基于编解码器框架的生成方法。比较的模型包括:lstm‑a,获取高层语义属性特征嵌入到解码器中加以利用;plstm‑a‑2*,利用lstm并行融合解码器部分的动态语义和视觉信息;vs‑lstm,使用语义属性特征替换低级视觉特性;daa,自适应注意视觉语义区域和文本内容;rfnet,融合多个cnn网络的编码特征形成对解码器的表示;up‑down,采用较快的r‑cnn对象检测方法作为编码器,使用两层lstm作为解码器;vsv‑vra‑pos,将pos标签引入到语言模型中,并设计视觉骨架向量来约束pos语言模型;zhaoetal.,采用基于检索的方法,查询相似的图像对应标题作为额外的文本特征信息用于生成模型中;scst,首次提出使用scst优化评价指标;sr‑pl通过自我检索指导产生有判别力的句子;stack‑cap,提出了一个由粗到细的堆叠注意力模型;sem,提出了语义增强网络和极难否定挖掘方法;vres afs,使用先前的视觉上下文来考虑当前的序列推理。[0179]table1.experimentofourproposedfeaturefusionnetworkonthemscocokarpathytestsplitwithbothcross‑entropyloss.testresultsshowthatourproposedmethodshaveobviousimprovementoverourbaseline.b‑1/b‑4/m/r/c/sreferstobleu1/bleu4/meteor/rouge‑l/cider/spicescores.[0180][0181]table2.theresultsofoursystemwhichisoptimizedbycideroptimizationonthemscocokarpathysettestsplit.[0182][0183]在表1和表2中,分别公布了本文的多模态特征融合网络(mff‑net)与上述其他模型在交叉熵损失优化训练和optimizedforcider‑dscore结果分数。可以看到,模型在大部分指标上与其他模型比较都获得了最高的分数。也从在线coco测试服务器上对的模型进行了评估。如表3所示,总共比较了7个模型,并详细说明了使用5个参考标题(c5)和40个参考标题(c40)的官方测试图像的性能。可以看出,mff‑net在大多数指标上的得分优于其他模型。[0184]table3.resultsofoursystemwithcideroptimizationoncocoonlinetestingserver.c5andc40denotetheofficialtestingimagesetwith5and40referencecaptionsrespectively.[0185][0186]为了证明提出的方法的有效性和通用性,也实现了提出的方法与其他编解码模型的比较:stack‑cap,att2all和adaptive。对以上三种模型做了对比实验如表4所示,结果表明所提出的方法对于大多数encoder‑decoder模型具有广泛的适用性。具体来说,提出的方法平均在adaptive上提高了3.4%,在att2all上提高了3.3%,在stack‑cap上提高2.1%。[0187]table4.performanceofourproposedapproachisbetterthanthatofotherencoder‑decodermodelsafter15epochsofcross‑entropylosstraining.[0188][0189][0190]表5显示了一些示例,其中每个实例包含的mff‑net和强大的up‑down基线生成的图像描述以及人为标注的3个groundtruth(gt)。从这些示例中,发现基线模型生成的标题符合语言逻辑,但描述内容不够准确,与图像内容不太匹配。而mff‑net生成的标题相对准确且更具描述性。具体来说,的mff‑net在以下三个方面具有优势:1)mff‑net反映出图像中对象之间的相互作用关系,第一个实例中,mff‑net能知道一只黑狗是坐在一盘食物旁边的地板上;第二个实例中,mff‑net能知道一个人头上顶着一串香蕉;2)mff‑net对图像中对象的计数更为准确。在第三个例子的图像中有两个橘子一个香蕉。然而,的mff‑net能够正确计数,基线模型只能找到一个橘子一个香蕉;3)mff‑net生成的图像描述更生动形象。在第四个例子的图像中,一只黑白相间的牛在田野上站着。虽然mff‑net和基线模型都能准确的生成描述句子,但mff‑net生成的句子更具丰富性。整体来说,mff‑net具有这些优势,因为它序列融合了图像中原本单一的对象特征,使其特征之间具备关联性,并且通过层级连接方式精炼出更加丰富的语义信息。[0191]table5.examplesofcaptionsgeneratedbymff‑netandabaselinemodelaswellasthecorrespondinggroundtruths.[0192][0193][0194]为了更好的检验多模态特征融合网络(mff‑net)在图像编码器和句子解码器中对图像字幕的影响,如表6所示,与其他具有不同设置的模型进行消融研究。首先设置一个基础模型,它是最原始的框架结构。下一步,对模型进行扩展,在编码器和解码器之间加入了的mff‑net,并设置循环神经网络使用lstm和gru两种不同的融合方式,发现都取得了较好的性能,但显然使用gru效果更好且更容易收敛。然后,在gru基础上使用了多头注意力网络,发现性能有所下降,从而验证使用gru加传统的注意力的方式能够取得最佳性能。表明在基础模型的输入端使用了全局层级特征替换之前的全局池化特征,发现在替换之后,模型的效果有了一定提高。此外,为了说明特征融合的性能与mff‑net层数的数量关系,在使用了全局融合层级特征基础上设置了层数变量,结果发现在融合网络中叠加层数可以提高性能,从而验证了融合网络层级之间交互的有效性。然而,当叠加到3层时,并没有观察到显著的性能提高。推测,叠加更多的层数而增加的参数可能导致过拟合,在一定程度上阻碍了以这种方式更高层级的融合。[0195]table6.theresultsof15epochsofcrossentropylossoptimizationformulti‑modefeaturefusionnetworkablationresearch.[0196][0197]本文提出了一种新的多模态特征融合机制,以提高captioningmodel生成图像‑文本匹配的语句性能。的模型设计使用循环神经网络结合注意力方式对目标特征进行关联融合,并提出结构层级化,帮助融合网络学习图像的细粒度信息,增强多层信息交互性。为了验证的模型性能,在coco数据集上进行的大量实验证明了mff‑net模型的有效性,实现了与最先进的方法相比的竞争性能。也在其他传统的模型架构上进行了实验,并证实了提出的方法可以应用于所有captioningmodel。在未来的工作中,将继续探索特征融合方式,尝试引入其他注意力网络,并设计更加有效的融合架构。[0198]以上所揭露的仅为本发明一种较佳实施例而已,当然不能以此来限定本发明之权利范围,本领域普通技术人员可以理解实现上述实施例的全部或部分流程,并依本发明权利要求所作的等同变化,仍属于发明所涵盖的范围。当前第1页12当前第1页12

背景技术:

::2.理解一幅图像很大程度上依赖于所获得的图像特征,用于获取特征的技术包括传统的机器学习技术和深度机器学习技术。传统的机器学习技术,提取lbps、sift和hog等人工特征,将它们或它们的组合送入svm等分类器,用于确定对象类别,这种方法存在两个缺点,一是这些人工特征都是面向任务的,从量大而且具有多样性的数据集中提取此类特征是不可行的;二是真实世界的数据复杂而且具有不同的语义解释。相反,深度机器学习技术,可以从训练集中自动学习特征,而且适合处理量大且具有多样性的数据集。3.现有的lstm‑a、plstm‑a‑2、vs‑lstm、daa、rfnet、up‑down和vsv‑vrv‑pos等代表性模型,图像特征的提取和利用不够充分、语义鸿沟依然存在。技术实现要素:4.本发明的目的在于提供一种多模态特征融合网络的图像描述生成方法,旨在更好地挖掘隐含层向量和对象特征的关联性,实现更高的图像描述生成性能。5.为实现上述目的,本发明提供了一种多模态特征融合网络的图像描述生成方法,包括构建多模态特征融合网络;6.在up‑down模型基础架构上设计解码端;7.将多模态特征融合网络融入到解码端,形成基于多模态特征融合网络的图像描述生成模型;8.训练基于多模态特征融合网络的图像描述生成模型;9.输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证。10.其中,所述多模态特征融合网络由多层特征融合模块级联而成,每一层由注意力模块和循环神经网络组合而成;每层都有都包括局部特征信息和全局特征信息,所述局部特征信息用于注意力模块的使用;所述全局特征信息作为循环神经网络的初始向量。11.其中,所述构建多模态特征融合网络的具体步骤是:12.将当前层特征融合模块的特征输出嵌入到下一层的特征融合模块中;13.通过注意力模块将上一层的融合特征传递到所述当前层的循环神经网络中,循环神经网络每一时间步的输入为当前的隐含层和加权融合注意力;14.将所述下一层每一时刻循环单元的输出结果拼接起来,形成最终的融合向量组;15.每层的循环融合网络后设置前馈神经网络进行处理,该所述前馈神经网络由两个线性变换组成,两个线性变换之间使用relu激活函数连接;16.然后使用残差连接和层标准化;17.对池化层级特征向量依次相加,并通过学习嵌入矩阵参数得到全局层级特征。18.其中,所述解码端由生成注意权重注意网络和生成单词语言网络构成。19.其中,所述训练基于多模态特征融合网络的图像描述生成模型的具体方式是:使用交叉熵损失和cider优化来训练模型。20.其中,所述输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证的具体步骤是:21.输入测试图像并初始化生成模型参数;22.使用adam优化器对captioningmodel模型进行交叉熵损失训练寻找最小值;23.使用self‑criticaltrainingstrategy通过cider‑d奖赏继续优化训练;24.采用波束搜索策略进行推理测试;25.对模型进行评价。26.本发明的一种多模态特征融合网络的图像描述生成方法,提出一种多模态特征融合网络(mff‑net),使用多模态结构扩展传统编解码框架,以增强对象特征之间的相关性。mff‑net使用循环神经网络构建层级结构来融合编码特征,且使用注意力机制来加权输入信息,以此让编码器提取的单一图像特征相互关联,增强特征交互。实验结果表明,mff‑net模型方法达到了与最先进的方法竞争的性能,在mscocokarpathy离线测试split上达到了126.5cider‑d分数,在官方在线测试服务器上达到了123.2cider‑d(c40)分数。27.本发明的有益效果如下:28.提出利用循环神经网络结合注意力学习融合图像特征,这是对单一编解码器模型的扩展,能更好的获取内在特征的序列关联性;在编码器和解码器之间应用了融合网络,以层次结构相互连接,并在解码器端融合了的层级特征向量。这样能充分挖掘对象特征之间更高层级的相互关系,生成更加详细的图像描述;提出的方法具备通用性,可以应用于其他编解码框架的视觉‑语言任务中。在mscoco数据集上与最先进的方法相比,图像描述模型实现了具有竞争力的性能。附图说明29.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。30.图1是本发明的一种多模态特征融合网络的图像描述生成方法的流程图;31.图2是本发明的构建多模态特征融合网络的流程图;32.图3是本发明的输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证的流程图;33.图4是本发明的一种多模态特征融合网络架构图。具体实施方式34.下面详细描述本发明的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,旨在用于解释本发明,而不能理解为对本发明的限制。35.请参阅图1~图4,本发明提供一种多模态特征融合网络的图像描述生成方法,包括:36.s101构建多模态特征融合网络;37.所述多模态特征融合网络由多层特征融合模块级联而成,每一层由注意力模块和循环神经网络组合而成;每层都有都包括局部特征信息和全局特征信息,所述局部特征信息用于注意力模块的使用;所述全局特征信息作为循环神经网络的初始向量。注意力模块用于图像区域特征和循环神经网络序列特征两者模态间的信息交互,循环神经网络用于增强特征之间的关联和融合不同的图像局部特征。38.具体步骤是:39.s201将当前层特征融合模块的特征输出嵌入到下一层的特征融合模块中;40.以第i(0≤i<m)层的输出为例。首先它们被嵌入到第i 1层的特征融合模块中:[0041][0042]其中fi 1代表mff‑net的第i 1层的特征输出。[0043]ffm(·)代表特征融合模块(即mff‑net)的输出。[0044]fi代表mff‑net的第i(0≤i<m)层的特征输出。[0045]代表fi的均值,[0046][0047]fi代表mff‑net的第i(0≤i<m)层的特征输出,它共有k个分量,每个分量用表示。[0048][0049]代表fi中k个分量的均值。[0050]其中hi 1是通过特征融合模块输出的隐藏状态,ffm(·)表示特征融合模块,表示第i层的池化层级特征。注意的是,f0是使用fasterr‑cnn目标检测方法提取的图像区域特征[0051]s202通过注意力模块将上一层的融合特征传递到所述当前层的循环神经网络中,循环神经网络每一时间步的输入为当前的隐含层和加权融合注意力;[0052][0053]代表i 1层在t 1时刻的网络隐状态,[0054]rnn[·]代表循环神经网络的输出。[0055]代表i 1层在t时刻的权重系数。[0056]代表i 1层在t时刻的网络隐状态。[0057][0058]表示第i层的第i个特征在t时刻的权重系数。[0059]表示融合层需要学习的视觉参数。[0060]tanh(·)表示双曲正切激活函数。[0061]表示第i层mff‑net输出特征的第i个分量。[0062]wmf和wmh表示融合层需要学习的视觉参数。[0063]表示第i 1层mff‑net网络在t时刻的隐状态。[0064][0065]表示第i层的t时刻全部特征的权重系数。[0066]softmax(·)表示归一化到[0,1]的操作。[0067][0068]表示第i 1层在t时刻对特征学习得到的关注结果。[0069]表示第i层的第i个特征在t时刻的被关注程度,即权重系数。[0070]表示第i层mff‑net输出特征的第i个分量。[0071]其中,隐含层初始化状态为上一层的池化层级特征wmf,wmh和是融合层需要学习的视觉参数;是t时刻学习得到的关注结果。注意,这里融合方式使用门控循环单元(gru),因为它不仅能在保留长期序列信息下减少梯度消失问题,而且相对lstm参数更少更容易收敛。[0072]s203将所述下一层每一时刻循环单元的输出结果拼接起来,形成最终的融合向量组;[0073]将第i 1层每一时刻循环单元的输出结果拼接起来,形成最终的hi 1融合向量组。[0074][0075]hi 1表示第i 1层的融合向量组。[0076]concat(·)表示向量连接操作。[0077]分别代表第i 1层时刻1、2、…、t的循环单元的隐状态(即循环单元的输出结果)。[0078]符号“[·,·]”表示向量拼接操作。[0079]s204每层的循环融合网络后设置前馈神经网络进行处理,该所述前馈神经网络由两个线性变换组成,两个线性变换之间使用relu激活函数连接;[0080]在每一子层的循环融合网络后是一个前馈神经网络(ffn),该网络由两个线性变换组成,两个线性变换之间使用relu激活函数:[0081]ffn(x)=w2relu(w1x b1) b2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ(18)[0082]fi 1=ffn(hi 1)ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ(19)[0083]x表示ffn网络的输入向量。[0084]ffn(x)表示前馈神经网络的输出。[0085]表示ffn学习参数。[0086]relu表示激活函数。[0087]表示ffn学习参数。[0088]b1表示w1的偏置项。[0089]b2表示w2的偏置项。[0090]是i 1块的输出。[0091]hi 1表示第i 1层的融合向量。[0092]ffn(·)表示前馈神经网络的输出。[0093]其中,是i 1块的输出。[0094]s205然后使用残差连接和层标准化;[0095]每个子层之后使用残差连接和层标准化,这里省略它们以进行简明的解释。[0096][0097]表示全局层级特征。[0098]wg和wf为连接参数。[0099]tanh(·)表示双曲正切激活函数。[0100]表示第i层mff‑net网络输出特征向量的均值。代表v的均值。[0101]m表示mff‑net网络总共有多少层数。[0102]s206对池化层级特征向量依次相加,并通过学习嵌入矩阵参数得到全局层级特征。[0103]为了鼓励学习层级之间的相互作用关系,促进多模态信息交互,对池化层级特征向量依次相加,并通过学习wg,和wf嵌入矩阵参数,得到全局层级特征[0104]s102在up‑down模型基础架构上设计解码端;[0105]所述解码端由生成注意权重注意网络和生成单词语言网络构成。[0106]up‑down模型有着卓越的表现,使用其作为本模型方法的基础框架。这个框架有两个lstm堆积组成,一个生成注意权重的注意lstmatt,一个生成单词的语言lstmlang。它们在t时刻的隐含状态分别表示为和[0107]在较高的层次上,lstm的隐藏状态被建模为:[0108]ht=lstm(xt,ht‑1)ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ(1)[0109]其中ht和ht‑1为lstm网络在t时刻和t‑1时刻的隐藏状态。lstm()表示lstm网络的输出,xt为lstm输入向量。为了便于记法,省略了存储单元的传播。[0110][0111]其中,表示解码端注意力网络在t时刻的隐藏状态;xt‑1表示t‑1时刻的词嵌入向量;表示全局层级特征;表示解码端语言网络在t‑1时刻的隐藏状态;lstmatt()表示注意力网络的映射操作。[0112]对于注意lstm的每一时间步输入,其中xt‑1是前一个词嵌入、是前一个语言lstm的隐藏状态向量。是来自mff‑net的全局层级特征,它为注意lstm提供了图像的多层级融合信息。多模态特征融合网络细节将在第3.2节中说明。[0113]对给定图像i经过多模态特征融合网络的m个子层后,其输出融合特征fm可以表示为:[0114][0115]其中,代表mff‑net最后一层融合特征fm的第i个分量,每个分量为d维的实数。[0116]语言模型lstm的输入由注意加权图像特征与当前注意lstm的隐藏状态连接而成:[0117][0118]其中lstmlang代表语言网络,attt表示语言网络lstmlang在t时刻的注意力,表示注意力网络lstmatt在t时刻的隐状态,表示语言网络lstmlang在t时刻的隐状态;lstmlang表示语言网络的映射输出。[0119]其中,attt是fi的加权和:[0120][0121]αt=softmax(at)ꢀꢀꢀꢀ(6)[0122][0123]其中waf和wah是学习视觉注意部分的参数。[0124]是f的相关权值,其和为1,即attt是f的加权和,表示要生成单词的最相关位置。[0125]αt,i表示第i层t时刻对特征的关注程度,即权重系数。[0126]tanh表示双曲正切激活函数[0127]softmax(·)表示归一化到[0,1]的操作。[0128]表示mff‑net第m层的第i个融合特征分量。[0129]使用符号y1:t引用一个单词序列(y1,...,yt),在每个时间步长t下,给定对可能输出单词的条件分布:[0130][0131]p(yt|y1:t‑1)单词序列的条件概率。[0132]softmax(·)表示归一化到[0,1]的操作。[0133]wp表示映射输出的学习参数[0134]bp表示映射输出的偏置[0135]表示语言lstm网络在t时刻的隐状态。[0136]对完整输出序列的分布计算为条件分布的乘积:[0137][0138]p(y1∶t)表示解码端完整输出单词序列的分布概率。[0139]p(yt|y1:t‑1)单词序列的条件概率。[0140]符合表示乘积运算。[0141]s103将多模态特征融合网络融入到解码端,形成基于多模态特征融合网络的图像描述生成模型;[0142]s104训练基于多模态特征融合网络的图像描述生成模型;[0143]具体方式是:使用交叉熵损失和cider优化来训练模型。[0144]在给定目标地真值序列和带有参数θ的描述模型的情况下,通过优化交叉熵(xe)lxe对mff‑net进行训练:[0145][0146]lxe(θ)表示损失函数。[0147]表示参数为θ的联合概率分布。[0148]表示t时刻的预测输出。[0149]表示t时刻的输入。[0150]自强化学习应用于描述模型以来,大量研究都使用该方法来优化训练。为了进行公平的比较,从交叉熵训练的模型初始化,寻求最小的负期望分数:[0151][0152]lr(·)表示强化学习的奖赏函数。[0153]θ表示模型的优化参数。[0154]pθ表示参数θ的分布。[0155]e表示y1∶t服从pθ分布时r(y1∶t)的数学期望。[0156]r(y1:t)表示通过解码当前模型生成句子获得的分数。[0157]其中r为cider‑d评分函数。直接用自临界序列训练(scst)优化不可微指标,这种损失的梯度可以近似:[0158][0159]其中:[0160]表示求导操作。[0161]lr(·)表示强化学习的奖赏函数。[0162]符号“≈”表示使用蒙特卡罗方法近似采样。[0163]为采样标题,上标“s”代表句子。[0164]定义贪婪解码当前模型得到的基线得分。[0165]pθ表示参数θ的分布.[0166]s105输入测试图像,对基于多模态特征融合网络的图像描述生成模型的性能进行验证。[0167]具体步骤是:[0168]s301输入测试图像并初始化生成模型参数;[0169]首先在数据预处理部分,将训练图像集中图像标注语句的所有单词全部转换为小写字母,并以出现次数大于指定阈值的单词建立单词库,在本文实验中单词阈值设为5。在实验部分,使用mscoco2014captions数据集来评估提出的方法。mscoco数据集包含123,287张图像,每个图像标有5个标题,包括82,783张训练图像和40,504张验证图像。mscoco也提供了40,775张图片作为在线评估的测试集。theoffline“karpathy″datasplit用于离线性能比较,这种分割在之前的工作中得到了广泛的应用,其中113,287张带有5个标题的图像进行训练,并用5000张图像用于验证,5000张图像用于测试。为了对本文所提出的模型方法进行定量的性能评价,并与其他方法进行比较,使用了标准的自动评估指标,其中包括bleu,meteor,rouge‑l常规机器翻译的度量指标,以及专门用于imagecaptioning的cider‑d和spice度量指标。[0170]s302使用adam优化器对captioningmodel模型进行交叉熵损失训练寻找最小值;[0171]整个imagecaptioning框架主要是用pytorch实现的,用adam进行优化。在实验的参数方面,up‑down模型遵循的设置,语言lstm的隐藏状态维度设置为1000,注意lstm和单词嵌入维度设置为1000,注意层的维度是512。使用预先训练的faster‑rcnn模型从pool‑5层中提取2048维的目标特征。在特征融合网络中,使用soft‑attention作为融合注意力网络,使用gru作为融合编码器。融合gru的输入维度维数为1000,隐藏状态维数为1000,层级之间的传递维数为1000。在训练模型方面,遵循up‑down模型中的训练策略,首先使用adam优化器以5e‑4的学习速度对captioningmodel模型进行交叉熵损失训练寻找最小值,批次大小为10,历时30个epochs,并每5个周期增加0.05的预定抽样概率。[0172]s303使用self‑criticaltrainingstrategy通过cider‑d奖赏继续优化训练;[0173]使用self‑criticaltrainingstrategy通过cider‑d奖赏继续优化训练,以5e‑5的学习速率,重量衰减为1e‑5,批处理大小设置为10,历时30个epochs。[0174]s304采用波束搜索策略进行推理测试;[0175]在推理测试方面,采用波束搜索策略,并将波束大小设为2。[0176]s305对模型进行评价。[0177]同时使用传统的imagecaptioning评价指标对模型进行评价。[0178]在表1和表2中报告了模型在offlinecocokarpathytestsplit的性能表现。为了与其他模型公平地进行性能比较,模型都是基于编解码器框架的生成方法。比较的模型包括:lstm‑a,获取高层语义属性特征嵌入到解码器中加以利用;plstm‑a‑2*,利用lstm并行融合解码器部分的动态语义和视觉信息;vs‑lstm,使用语义属性特征替换低级视觉特性;daa,自适应注意视觉语义区域和文本内容;rfnet,融合多个cnn网络的编码特征形成对解码器的表示;up‑down,采用较快的r‑cnn对象检测方法作为编码器,使用两层lstm作为解码器;vsv‑vra‑pos,将pos标签引入到语言模型中,并设计视觉骨架向量来约束pos语言模型;zhaoetal.,采用基于检索的方法,查询相似的图像对应标题作为额外的文本特征信息用于生成模型中;scst,首次提出使用scst优化评价指标;sr‑pl通过自我检索指导产生有判别力的句子;stack‑cap,提出了一个由粗到细的堆叠注意力模型;sem,提出了语义增强网络和极难否定挖掘方法;vres afs,使用先前的视觉上下文来考虑当前的序列推理。[0179]table1.experimentofourproposedfeaturefusionnetworkonthemscocokarpathytestsplitwithbothcross‑entropyloss.testresultsshowthatourproposedmethodshaveobviousimprovementoverourbaseline.b‑1/b‑4/m/r/c/sreferstobleu1/bleu4/meteor/rouge‑l/cider/spicescores.[0180][0181]table2.theresultsofoursystemwhichisoptimizedbycideroptimizationonthemscocokarpathysettestsplit.[0182][0183]在表1和表2中,分别公布了本文的多模态特征融合网络(mff‑net)与上述其他模型在交叉熵损失优化训练和optimizedforcider‑dscore结果分数。可以看到,模型在大部分指标上与其他模型比较都获得了最高的分数。也从在线coco测试服务器上对的模型进行了评估。如表3所示,总共比较了7个模型,并详细说明了使用5个参考标题(c5)和40个参考标题(c40)的官方测试图像的性能。可以看出,mff‑net在大多数指标上的得分优于其他模型。[0184]table3.resultsofoursystemwithcideroptimizationoncocoonlinetestingserver.c5andc40denotetheofficialtestingimagesetwith5and40referencecaptionsrespectively.[0185][0186]为了证明提出的方法的有效性和通用性,也实现了提出的方法与其他编解码模型的比较:stack‑cap,att2all和adaptive。对以上三种模型做了对比实验如表4所示,结果表明所提出的方法对于大多数encoder‑decoder模型具有广泛的适用性。具体来说,提出的方法平均在adaptive上提高了3.4%,在att2all上提高了3.3%,在stack‑cap上提高2.1%。[0187]table4.performanceofourproposedapproachisbetterthanthatofotherencoder‑decodermodelsafter15epochsofcross‑entropylosstraining.[0188][0189][0190]表5显示了一些示例,其中每个实例包含的mff‑net和强大的up‑down基线生成的图像描述以及人为标注的3个groundtruth(gt)。从这些示例中,发现基线模型生成的标题符合语言逻辑,但描述内容不够准确,与图像内容不太匹配。而mff‑net生成的标题相对准确且更具描述性。具体来说,的mff‑net在以下三个方面具有优势:1)mff‑net反映出图像中对象之间的相互作用关系,第一个实例中,mff‑net能知道一只黑狗是坐在一盘食物旁边的地板上;第二个实例中,mff‑net能知道一个人头上顶着一串香蕉;2)mff‑net对图像中对象的计数更为准确。在第三个例子的图像中有两个橘子一个香蕉。然而,的mff‑net能够正确计数,基线模型只能找到一个橘子一个香蕉;3)mff‑net生成的图像描述更生动形象。在第四个例子的图像中,一只黑白相间的牛在田野上站着。虽然mff‑net和基线模型都能准确的生成描述句子,但mff‑net生成的句子更具丰富性。整体来说,mff‑net具有这些优势,因为它序列融合了图像中原本单一的对象特征,使其特征之间具备关联性,并且通过层级连接方式精炼出更加丰富的语义信息。[0191]table5.examplesofcaptionsgeneratedbymff‑netandabaselinemodelaswellasthecorrespondinggroundtruths.[0192][0193][0194]为了更好的检验多模态特征融合网络(mff‑net)在图像编码器和句子解码器中对图像字幕的影响,如表6所示,与其他具有不同设置的模型进行消融研究。首先设置一个基础模型,它是最原始的框架结构。下一步,对模型进行扩展,在编码器和解码器之间加入了的mff‑net,并设置循环神经网络使用lstm和gru两种不同的融合方式,发现都取得了较好的性能,但显然使用gru效果更好且更容易收敛。然后,在gru基础上使用了多头注意力网络,发现性能有所下降,从而验证使用gru加传统的注意力的方式能够取得最佳性能。表明在基础模型的输入端使用了全局层级特征替换之前的全局池化特征,发现在替换之后,模型的效果有了一定提高。此外,为了说明特征融合的性能与mff‑net层数的数量关系,在使用了全局融合层级特征基础上设置了层数变量,结果发现在融合网络中叠加层数可以提高性能,从而验证了融合网络层级之间交互的有效性。然而,当叠加到3层时,并没有观察到显著的性能提高。推测,叠加更多的层数而增加的参数可能导致过拟合,在一定程度上阻碍了以这种方式更高层级的融合。[0195]table6.theresultsof15epochsofcrossentropylossoptimizationformulti‑modefeaturefusionnetworkablationresearch.[0196][0197]本文提出了一种新的多模态特征融合机制,以提高captioningmodel生成图像‑文本匹配的语句性能。的模型设计使用循环神经网络结合注意力方式对目标特征进行关联融合,并提出结构层级化,帮助融合网络学习图像的细粒度信息,增强多层信息交互性。为了验证的模型性能,在coco数据集上进行的大量实验证明了mff‑net模型的有效性,实现了与最先进的方法相比的竞争性能。也在其他传统的模型架构上进行了实验,并证实了提出的方法可以应用于所有captioningmodel。在未来的工作中,将继续探索特征融合方式,尝试引入其他注意力网络,并设计更加有效的融合架构。[0198]以上所揭露的仅为本发明一种较佳实施例而已,当然不能以此来限定本发明之权利范围,本领域普通技术人员可以理解实现上述实施例的全部或部分流程,并依本发明权利要求所作的等同变化,仍属于发明所涵盖的范围。当前第1页12当前第1页12

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。