1.本发明属于视频跟踪识别技术领域,涉及到跟踪算法与深度学习,以及人工神经网络技术。

背景技术:

2.在视频监控、人机交互、智能交通等领域有着广泛应用的目标跟踪方法,按照处理方式的不同可以分为两类:一类是生成模型类,另一类是判别模型类。生成模型类是对跟踪的目标建立模型并识别,在下一帧图像中搜索与当前模型中最为相似的区域作为预测区域。比较经典的算法有卡尔曼滤波与粒子滤波等。这种通过单一数学模型描述待跟踪目标的方法,不能全面利用图像的背景信息,当受到光照变化,运动模糊,目标旋转等情况下,会对模型建立产生较大影响。判别模型类是将目标模型和背景信息同时考虑在内,提取图像中的特征值,根据两者的差异进行在线学习并对分类器做相应的训练,该方法可以较好的提高跟踪精度。

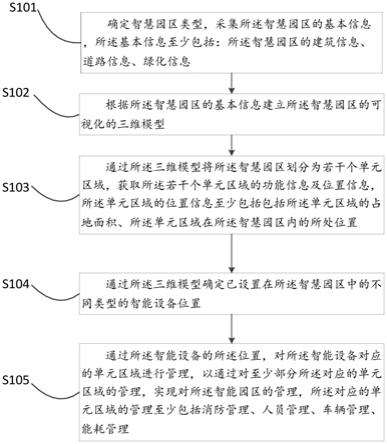

技术实现要素:

3.本发明的目的是以核相关滤波算法(kernel correlation filter,kcf)滤波器为基础模型,提出一种响应置信度多特征融合的核相关滤波目标跟踪方法。该方法可满足视频实时性的要求,在信号采集、目标跟踪、特征分析、图像识别中具有一定的应用价值。

4.本发明是通过以下技术方案实现的。

5.本发明所述的一种响应置信度多特征融合的核相关滤波目标跟踪方法,包括如下步骤:

6.(s01)利用平均峰相关能量(average peak

‑

to

‑

correlation energy,apce)和输出的响应峰值作为跟踪置信度,结合方向梯度直方图(histogram of oriented gradient,hog)特征与降维后的颜色特征(color naming,cn)融合机制进行特征权重分配。

7.假设视频目标跟踪区域的大小为m

×

n像素,则该区域第t帧图像的apce值p

t

计算如下:

[0008][0009]

其中,g

max,t

,g

min,t

和g

m,n,t

分别是第t帧图像在跟踪区域内的最大响应值、最小响应值和位置(m,n)处的响应值。

[0010]

将第t帧的特征权重公式写为:

[0011]

[0012]

式中ω

hog,t

和ω

cn,t

分别为hog特征和cn特征在第t帧的权重。

[0013]

(s02)基于响应置信度的大小设置学习率分段更新策略,以解决目标受干扰可能带来的误差。

[0014]

为了避免学习模型更新而导致错误,结合响应图峰值变化的结果,计算大于0.5倍峰值的响应值个数f

med

与大于0.28倍峰值的响应值个数f

major

。设响应置信度:

[0015]

f=f

med

/f

major

(3)

[0016]

当干扰比较少时,图像峰值高,高响应值点比较集中且占比小,没有多峰现象,所以f的值较小。当受到干扰时,响应图峰值变低,产生多峰现象,高响应值的点占比增加,f的值增大。

[0017]

同时得出第t帧的分段更新模型策略为:

[0018][0019][0020]

其中η

cn

和η

hog

分别代表cn特征的学习率和hog特征的学习率,f

cn

和f

hog

分别代表cn特征的响应置信度和hog特征的响应置信度。

[0021]

(s03)特征失效下的模型跟踪判别自适应调整,以提高目标识别算法的鲁棒性。

[0022]

多特征融合机制权重分配可提高跟踪精确度,但是如果出现某一特征跟踪失效,产生相反的预测位置时,使用(s01)公式(2)加权的更新方式就会引入额外的误差。这种情况下就只需要选择响应置信度f最大的那个特征进行单一特征的位置更新,这样不仅可以提高算法的鲁棒性,还可以用来解决跟踪失效的模糊错判问题。

[0023]

(s04)采用视频主要属性对目标跟踪评估算法的有效性进行分析测试,评估方法采用距离精确度(distance precision,dp)、成功率(success rate,sr)作为评价标准。

[0024]

所述的距离精确度dp是通过统计中心位置误差(center location error,cle)小于某一设定阈值ε的帧数n

num

占视频序列总长度n

all

的比值。

[0025][0026]

其中,中心位置误差cle是指跟踪目标位置(x

t

,y

t

)与真实位置(x

g

,y

g

)间的距离,计算公式如下:

[0027][0028]

所述的成功率sr是通过统计覆盖域(overlap region,or)大于某一设定阈值θ的帧数n

num

占所有测试视频序列总长度n

all

的比值,其计算公式:

[0029]

[0030]

其中,覆盖域or是根据人工标注的实际目标框和跟踪算法得到的跟踪框之间的重叠面积之比,来衡量算法的跟踪性能。

[0031][0032]

其中|

·

|代表区域中的像素数目,r

t

、r

g

分别表示跟踪算法得到的预测区域和实际的目标区域,or的取值范围为0到1。

[0033]

本发明利用特征响应图的峰值与平均峰值相关能量值的乘积,对hog特征和cn特征得出的预测位置进行自适应融合,并提出了一种新的置信度判断方法。通过对模型的跟踪情况和特征的有效性检测,采用分段式更新策略,避免了模型污染,提高了位置融合的可靠性和复杂环境中跟踪的鲁棒性。

附图说明

[0034]

图1为basketball部分视频序列的特征权重变化。其中(a)为视频中的#572帧;(b)为视频中的#600帧;(c)为视频中的#624帧;(d)为视频中的#630帧;(e)为视频中的#636帧;(f)为视频中的#641帧;(g)为视频帧数与(hog,cn)特征权重ω的关系图。白色边框与黑边白色箭头是跟踪的目标。

[0035]

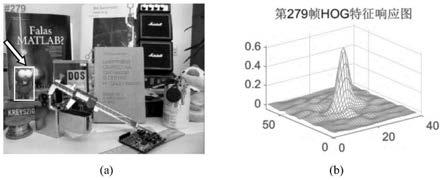

图2为目标跟踪正常及三维响应图。(a)为实际应用场景中的#279帧;(b)为#279帧hog特征响应的三维响应图。白色边框与黑边白色箭头是跟踪的目标。

[0036]

图3为目标受到遮挡及三维响应图。(a)为目标受到遮挡场景中的#449帧;(b)为#449帧hog特征响应的三维响应图。白色边框与黑边白色箭头是跟踪的目标。

[0037]

图4为目标快速移动及三维响应图。(a)为目标快速移动场景中的#543帧;(b)为#543帧hog特征响应的三维响应图。白色边框与黑边白色箭头是跟踪的目标。

[0038]

图5为目标发生旋转及三维响应图。(a)为目标发生旋转场景中的#955帧;(b)为#955帧hog特征响应的三维响应图。白色边框与黑边白色箭头是跟踪的目标。

[0039]

图6为目标运动模糊时的cn特征与hog特征响应图。(a)为目标运动模糊场景中的#549帧;(b)为#945帧cn特征响应的三维响应图;(c)为#945帧hog特征响应的三维响应图。白色边框与黑边白色箭头是跟踪的目标。

具体实施方式

[0040]

本发明将跟踪得到的响应图与理想的响应图进行比较,判断跟踪过程是否顺利。当跟踪过程顺利时,方向梯度直方图(histogram of oriented gradient,hog)特征与降维后的颜色特征(color naming,cn)特征得到的跟踪方向一致,分别计算各自的响应峰值与平均峰相关能量(average peak

‑

to

‑

correlation energy,apce),用以对预测位置进行加权融合。通过计算高响应值点在响应图上层的占比,来判断目标的跟踪情况,进而调整学习率的大小;然后用两种特征的平均峰相关能量(apce)和最大响应峰值的乘积来加权融合目标位置。以下将结合附图,通过实施实例作进一步说明。

[0041]

(1)多特征融合机制权重分配目标跟踪。

[0042]

hog和cn两种特征相互融合可以弥补各自的缺点,但如果只是用简单的特征层相

加方式进行融合,不进行权重分配,就会出现某一特征跟踪精度下降时,整体的跟踪性能下降的情况。本发明首先使用主成分分析(primary component analysis,pca)法对cn特征降维,提高运算速度,然后利用平均峰相关能量(apce)和输出的响应峰值作为跟踪置信度,进行权重分配。

[0043]

为确认该权重分配方法的有效性,采用otb

‑

2013数据集中的basketball视频序列进行验证(参见图1)。

[0044]

从图1可以看到在572帧到624帧之间,目标主要是在进行平移操作,形变较小,得到的特征权重变化图中hog的特征权重高于cn。而之后目标产生形变和旋转,hog特征权重显著下降。这表明该融合算法在不同的条件下能够实现自适应改变。

[0045]

(2)基于响应置信度的分段更新策略的目标跟踪。

[0046]

kcf算法在每一帧学习中都使用相同的学习率来更新模型。而在实际的应用场景中,由于背景杂乱、形变、遮挡等原因,使用相同的学习率更新容易将不可靠的跟踪结果引入到模型当中。模型误差的累计将导致跟踪失败,因此在跟踪质量较差的情况下应适当减小学习率。

[0047]

响应图的峰值和波动可以一定程度上反应跟踪的质量,当跟踪结果较为理想时,响应图是只有一个尖峰,其他区域平滑的图像,而且响应峰值越高,周边区域越平滑,跟踪效果越好,如图2。当跟踪过程中出现如遮挡(见图3)、运动模糊(见图4)、旋转(见图5)等复杂情况时,得到的响应图会与理想的高斯模型产生较大偏差,响应图的峰值就会变低,顶部变宽,产生多峰现象。此时就减小模型更新速率或停止更新模型,并对hog特征与cn特征得到的跟踪方向进行判断,如果两种特征得出的预测位置差异过大,则选择响应图更接近理想高斯模型的特征进行更新,以此达到跟踪的最优匹配。

[0048]

(3)特征失效下的模型跟踪判别。

[0049]

多特征融合机制虽然可以自适应的进行权重分配,提高跟踪精确度,但是如果出现某一特征跟踪失效,产生相反的预测位置时,再使用加权的更新方式就会引入额外的误差。

[0050]

如图6,由于图像在第549帧时产生运动模糊,hog特征的跟踪精度下降。可以看到物体原本向左运动,cn特征得到的响应最高峰在左侧,但hog特征由于受到干扰,得到的响应最高峰却在右侧。此时两种特征得出的预测位置截然相反,不适合使用位置融合机制,根据响应置信度f最大值来进行单一特征的位置更新。

[0051]

(4)目标跟踪定量分析测试。

[0052]

为了评估本发明算法(ours)的有效性,在otb

‑

2013数据集上选取了具有代表性的30组视频序列来与samf、dsst、kcf、cn算法进行对比。所选视频的主要属性包括以下11种:

[0053]

·

14组光照变化(illuminationvariation,iv);

[0054]

·

23组平面外旋转(out

‑

of

‑

plane rotation,opr);

[0055]

·

13组尺度变换尺度变化(scale variation,sv);

[0056]

·

19组遮挡(occlusion,occ);

[0057]

·

11组变形(deformation,def);

[0058]

·

7组运动模糊(motion blur,mb);

[0059]

·

8组快速移动(fast motion,fm);

[0060]

·

20组平面内旋转(in

‑

plane rotation,ipr);

[0061]

·

3组离开视野(out of view,ov);

[0062]

·

10组背景复杂(background clutters,bc);

[0063]

·

2组低分辨率(low resolution,lr)。

[0064]

评估方法采用otb

‑

2013数据集中提出的距离精确度(distance precision,dp)、成功率(success rate,sr)及跟踪速度(frames per second,fps)作为评价标准。

[0065]

具体本发明算法(ours),samf算法(scale adaptive multiple feature,尺度自适应多特征),dsst算法(discriminative scale space tracking,判别尺度空间跟踪),kcf算法(kernel correlation filter,核相关滤波算法),cn算法(color naming,颜色名)在11种主要属性下的精确度dp和成功率sr结果如表1、表2所示,每组的最优结果用加粗显示。

[0066]

表1五种算法在11种属性下的精确度dp

[0067][0068]

表2五种算法在11种属性下的成功率sr

[0069][0070]

从表1和表2中可以看到,对比主流的相关滤波跟踪算法,本发明算法的精确度dp和成功率sr大多数属性下要优于其他算法。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。