1.本发明涉及数据处理技术领域,具体领域为一种企业大数据分析平台。

背景技术:

2.现有的产品,是运用传统的数据处理方法实现,相关技术人员直接编写存储过程从业务平台查询数据,最后将数据渲染到网页。但现有产品存在以下缺点:1. 随时企业的发展,数据体量急剧增长,根据现有技术无法满足当前数据量的处理能力,存在处理速度慢、数据存储等问题;2. 企业目前处在发展数据字化阶段,业务平台随之增多,现有技术无法将所有平台的数据进行集中管理、关联起来,存在信息数据孤岛现象。

技术实现要素:

3.本发明的目的在于提供一种企业大数据分析平台,以解决上述背景技术中提出的问题。

4.为实现上述目的,本发明提供如下技术方案:一种企业大数据分析平台,包括数据采集层、数据存储层、数据处理层以及数据应用层,所述数据采集层用于将数据由各个关系型数据库抽取至所述数据存储层,所述数据存储层用于接收所述数据采集层以及所述数据处理层传输的数据,所述数据处理层用于对所述数据存储层对数据进行清洗和转换,并存储在所述数据存储层,所述数据应用层用于将所述数据处理层处理后的数据进行可视化输出展示。

5.优选的,所述数据采集层包括sqoop组件和flume组件,所述sqoop组件根据用户指定的sal或阻断参数,从数据库中读取数据,所述flume组件接收采集到的数据并进行临时存储,最终将数据发送至指定位置。

6.优选的,所述数据存储层包括hdfs组件、hbase组件以及kafka组件,所述hdfs组件用于文件上传以及文件获取,所述hbase组件用于文件的读写,所述kafka组件用于消息处理。

7.优选的,所述数据处理层包括mapreduce组件、spark组件以及hive组件,所述mapreduce组件用于对输入的文件进行分区和排序,所述spark组件基于内存计算框架进行实时数据处理,所述hive组件用于数据仓库的统计分析。

8.优选的,所述数据应用层包括报表应用、运营分析以及风险管控等方式。

9.与现有技术相比,本发明的有益效果是:一种企业大数据分析平台,通过分别设置数据采集层、数据存储层、数据处理层以及数据应用层,加快了数据的传输速度,批处理方式进行数据传输;打通了大数据存储组件与rdbms之间的数据导入导出;可以分布式存储大文件、大批量文件;为各类分布式运算框架提供数据存储服务,从而可为业务员解决数据使用不方便、方法繁琐、手工报表多等问题,提高业务员工作效率;帮助企业经营者随时随地了解公司经营情况;为企业运营者精细化管理提供数据支持;从海量数据中挖掘有价值的数据,帮助业务发现/分析问题、寻找规律、预测信息、风险管控等功能。

附图说明

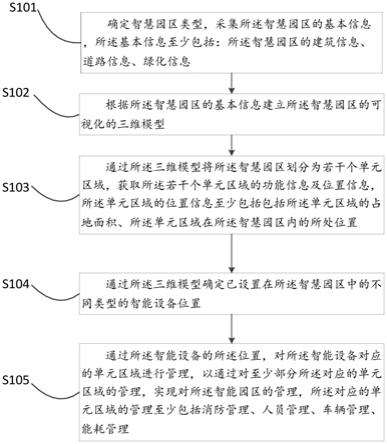

10.图1为本发明的工作原理示意图。

11.图中:1

‑

数据采集层、2

‑

数据存储层、3

‑

数据处理层、4

‑

数据应用层。

具体实施方式

12.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

13.请参阅图1,本发明提供一种技术方案:一种企业大数据分析平台,包括数据采集层1、数据存储层2、数据处理层3以及数据应用层4,所述数据采集层1用于将数据由各个关系型数据库抽取至所述数据存储层2,所述数据存储层2用于接收所述数据采集层1以及所述数据处理层3传输的数据,所述数据处理层3用于对所述数据存储层2对数据进行清洗和转换,并存储在所述数据存储层2,所述数据应用层4用于将所述数据处理层3处理后的数据进行可视化输出展示。

14.具体而言,所述数据采集层1包括sqoop组件和flume组件,sqoop组件为从关系型数据库(mysql)数据导入hdfs、hive等组件的工具或者从hdfs、hive导入到关系型数据库中;所述sqoop组件根据用户指定的sal或阻断参数,从数据库中读取数据,从而加快了数据的传输速度,批处理方式进行数据传输;并打通了大数据存储组件与rdbms之间的数据导入导出,flume组件是一个分布式、高可靠、高可用的服务,用于分布式的海量日志的高效收集、聚合、移动系统。其核心就是一个agent,这个agent对外有两个进行交互的地方,一个是接受数据的输入——source,一个是数据的输出sink,sink负责将数据发送到外部指定的目的地。source接收到数据之后,将数据发送给channel,chanel作为一个数据缓冲区会临时存放这些数据,随后sink会将channel中的数据发送到指定的地方。

15.具体而言,所述数据存储层2包括hdfs组件、hbase组件以及kafka组件,所述hdfs组件用于文件上传以及文件获取,其中文件上传时,客户端发起写文件请求,namenode检查上传文件的命名空间是否存在,创建者是否有权操作,最后返回状态告知客户端是否可以上传数据;客户端按照分块配置大小将文件块,然后请求namenode需要上传文件块,副本数是3个;namenode检测自己管理下的datanode是否满足要求,然后返回给客户端三台datenode节点信息;client端根据返回的datanode信息选择datenode进行存储数据。进行文件获取时,client发起hadoop fs

ꢀ–

get请求;namenode检查该文件信息,文件的分块信息和每个块所对应哪个datenode以及备份信息和备份信息所在位置;根据namenode信息,请求各个文件块对应的datanode节点获取文件;合并下载的数据块,形成完整文件。所述hbase组件用于文件的读写,所述hbase组件的写工作原理:client通过zookeeper的调度,向hregionserver发出写数据请求,在hregion中写数据;数据被写入hregion的memstore,直到memstore;memstore中的数据被flush成一个storefile;随着storefile文件的不断增多,当其数量增长到一定阈值后,触发compact合并操作,将多个storefile合并成一个storefile,通是进行版本合并和数据删除;storefile通过不断的compact合并操作,逐步形成越来越大的storefile;单个storefile

大小超过一定阈值后,触发split操作,把当前hregion split成2个新的hregion。父hregion会下线,新split出的2个子hregion会被hmaster分配到相应的hregionserver 上,使得原先1个hregion的压力得以分流到2个hregion上。

16.读工作原理:client访问zookeeper,查找

‑

root

‑

表,获取.meta表信息;从.meta表查找,获取存放目标数据的hrgion信息,从而找到对应的hregionserver;通过hregionserver获取需要查找的数据;hregionserver的内存分为memstore和blockcache两部分,memstore主要用于写数据,blockcache主要用于读数据。读请求先到memstore中查数据,查不到就到blockcache中查,再查不到就会到storefile上读,并把读的结果放入blockcache;所述kafka组件用于消息处理,kafka是一个分布式、支持分区的(partition)、多副本的(replica),基于zookeeper协调的分布式消息系统,它的最大的特性就是可以实时的处理大量数据以满足各种需求场景;生产者客户端应用程序产生消息:客户端连接对象将消息包装到请求中发送到服务端;服务端的入口也有一个连接对象负责接收请求,并将消息以文件的形式存储起来;服务端返回响应结果给生产者客户端。

17.消费者客户端应用程序消费消息:客户端连接对象将消费信息也包装到请求中发送给服务端;服务端从文件存储系统中取出消息;服务端返回响应结果给消费者客户端;客户端将响应结果还原成消息并开始处理消息。

18.所述kafka组件具有高吞吐量、低延迟;可扩展性;持久性、可靠性;容错性;高并发等特点。

19.具体而言,所述数据处理层3包括mapreduce组件、spark组件以及hive组件,所述mapreduce工作时,输入的文件会被切分成多个块,每一块都有一个maptask,map阶段的输出结果会先写到内存缓冲区写到磁盘,然后由缓冲区写到磁盘上。默认的缓冲区默认的缓冲区大小是100m,溢出的百分比是0.8,也就是说当缓冲区中达到80m的时候就会往磁盘上写。如果map计算完成后的中间结果没有达到80m,最终也是要写到磁盘上的,因为它最终还是要形成文件。那么,在往磁盘上写的时候会进行分区和排序。一个map的输出可能有多个这个的文件,这些文件最终会合并成一个,这就是这个map的输出文件。从而可以分布式处理大批量数据,处理速度快;spark是快速、通用、可扩展性的分布式计算引擎;通过actorsystem创建masteractor,启动定时器,定时检查与接收worker节点的发送消息;worker节点主动向master发送注册消息;master接收worker的注册请求,然后将注册信息保存起来,并向worker返回一个注册成功的消息;worker接收到master注册成功的消息后,启用定时器,定时向master发送心跳报活,master接收到worker发送来的心跳消息后,更新worker上一次的心跳时间;先创建taskscheduler即taskschedulerimpl接着又创建sparkdeployschedulerbackend对资源参数创建appclient与master注册application,并替每个taskset创建taskmanager负责监控此taskset中任务的执行情况;master接收到clientactor的任务描述之后,将任务描述信息保存起来,然后

clientactor返回消息,告知clientactor任务注册成功,接下来master进行资源调度;master跟worker通信,然后让worker启动executor;executor向driver发送注册消息,driver接收到executor注册消息后,响应注册成功的消息;executor接收到driver注册成功的消息后,本进程中创建executor的引用对象;driver中taskschedulerimp向executor发送launchtask消息,executor将创建一个线程池作为所提交的task任务的容器;task接收到launchtask消息后,准备运行文件初始化与反序列化,就绪后,调用task的run方法,其中每个task所执行的函数是应用在rdd中的一个独立分区上;task运行完成,向taskmanager汇报情况,并且释放线程资源;所有task运行结束之后,executor向worker注销自身,释放资源。所述hive组件用于数据仓库的统计分析,hive是建立在 hadoop 上的数据仓库基础构架。它提供了一系列的工具,可以用来进行数据提取转化加载(etl),这是一种可以存储、查询和分析存储在 hadoop 中的大规模数据的机制。用户提交查询等任务给driver。编译器获得该用户的任务plan。编译器compiler根据用户任务去metastore中获取需要的hive的元数据信息。编译器compiler得到元数据信息,对任务进行编译,先将hiveql转换为抽象语法树,然后将抽象语法树转换成查询块,将查询块转化为逻辑的查询计划,重写逻辑查询计划,将逻辑计划转化为物理的计划(mapreduce), 最后选择最佳的策略。将最终的计划提交给driver。driver将计划plan转交给executionengine去执行,获取元数据信息,提交给jobtracker或者sourcemanager执行该任务,任务会直接读取hdfs中文件进行相应的操作。 获取执行的结果。取得并返回执行结果;hive可以通过sql语句快速实现简单的mapreduce统计,不必开发专门的mapreduce应用开发程序,更适合数据仓库的统计分析。

20.具体而言,所述数据应用层4包括报表应用、运营分析以及风险管控等方式,通过各种方式将处理过后的数据进行展示。

21.工作原理:本发明使用时,数据采集层1用于将数据由各个关系型数据库抽取至数据存储层2,数据存储层2用于接收数据采集层1以及数据处理层3传输的数据,数据处理层3用于对数据存储层2对数据进行清洗和转换,并存储在数据存储层2,数据应用层4用于将数据处理层1处理后的数据进行可视化输出展示。

22.尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。