1.本技术涉及语音识别领域,更具体的说,是涉及一种语音识别方法和装置。

背景技术:

2.车载语音识别在车端通过对话的形式进行人机交互,用于将乘客的语音信息转化为相应的文本,并通过后续的模块使得车机系统作出相应的回应。

3.现有技术中,智能出行领域的车载语音识别采用基于rnn(recurrent neural network,循环神经网络)和ctc(connectionist temporal classification,混合链接时序分类)的深度神经网络的端到端语音识别模型。音频信息通过时间窗特征提取后的数据传入rnn网络中。由于最基本的rnn网络可能会导致梯度爆炸或者梯度消失的问题,因此现在大多用lstm(long short

‑

term memory,长短期记忆网络)网络来学习发音特征与信号的静动态特性,其网络的神经单元中包括三个“门(gate)”分别为“忘记门”、“输入门”和“输出门”,单元结构示意图如图1所示。

4.其中,“忘记门”的计算公式为f

(t)

=σ(w

f

[x

(t)

,h

(t

‑

1)

] b

f

),通过sigmoid(s型生长曲线)的处理后的值为一个0

‑

1之间的值,决定了前一层的状态值c

(t

‑

1)

中有多少需要舍弃;“输入门”决定什么样的输入信息应该保留在输出的状态值c

(t)

中,其计算公式为i

t

=σ(w

i

[x

(t)

,h

(t

‑

1)

] b

i

),c

′

t

=tanh(w

f

[x

(t)

,h

(t

‑

1)

] b

f

)。通过忘记门和输入门,可以得到新的输出值状态值c

(t)

,其组成为忘记了无效信息的前层输出状态值和处理后的本层输入的和,计算公式可以写为c

t

=f

(t)

·

c

(t

‑

1)

i

t

。对于新的预测输出h

(t)

则由上层输出、本次输入以及处理后的新的输出状态来共同决定,其计算公式为h

t

=tanh(c

(t)

)*σ(w

o

[x

(t)

,h

(t

‑

1)

] b

o

)。

[0005]

lstm模型的输出值长度通常远远大于标签值,对齐是十分困难的,ctc则是一种避开输入与输出手动对齐的一种方式。基于ctc的模型中引入了空白值的概念,每个预测的分类对应的一整段语音中的一个尖峰,其他不是尖峰的位置认为是空白。对于一段输入的语音,ctc并不关心每一个音素持续了多长时间,最后只输出相对性的尖峰序列。对于一对输入输出(x,y)来说,输入x的后验概率可以表示为所有映射为y的路径之和,ctc的目标是将此后验概率概率最大化,以得到可能性最大的预测输出,即将下式概率最大化:

[0006][0007]

其中p

t

(a

t

|x)表示的是网络模型在t时刻的输出概率。乘法为某一条路径的所有字符概率的积,加法为所有路径的概率之和,并采用动态规划的思想来对查找路径进行剪枝,获得ctc的损失函数。lstm模型的输出经过全连接层连接ctc损失函数作为训练目标,并接入n

‑

gram学习上下文信息,输出最小单位的后验概率。

[0008]

此模型虽然收敛性较好,但是模型中使用的rnn为循环结构,根据其单元特性可以看出,后一时刻rnn单元的预测必须基于前时刻的预测结果,因此训练难以并行化,当rnn单元较多时循环的时间过长,训练效率低。

技术实现要素:

[0009]

有鉴于此,本技术提供了一种语音识别方法,如下:

[0010]

一种语音识别方法,包括:

[0011]

获取待识别语音数据;

[0012]

对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;

[0013]

基于预设的编码器对于所述第一语音数据进行编码处理,得到第二语音数据,所述预设编码器中包括深度可分离卷积神经网络层和多头注意力算法层;

[0014]

基于预设的解码器对于所述第二语音数据进行处理得到识别结果,所述解码器包括多头注意力算法模块和混合链接时序分类模块。

[0015]

可选的,上述的方法,其特征在于,所述基于预设的编码器对于所述第一语音数据进行编码处理,得到第二语音数据,包括:

[0016]

基于所述深度可分离卷积神经网络层对于所述第一语音数据进行处理,得到第一编码数据;

[0017]

基于多头注意力算法层对于所述第一编码数据进行处理得到第二语音数据。

[0018]

可选的,上述的方法,其特征在于,所述基于所述深度可分离卷积神经网络层对于所述第一语音数据进行处理,得到第一编码数据,包括:

[0019]

将所述第一语音数据依次经过所述深度可分离卷积神经网络层中设置的深度可分离卷积层、第一批量标准化层、第一非线性激活层、逐点卷积层、第二批量标准化层以及第二非线性激活层的处理,得到第一编码数据。

[0020]

可选的,上述的方法,其特征在于,所述基于多头注意力算法层对于所述第一编码数据进行处理得到第二语音数据,包括:

[0021]

将所述第一编码依次经过所述多头注意力算法层中设置的第一注意力编码层、四层编码层以及第二注意力编码层的处理,得到第二语音数据,所述第二语音数据的编码序列的长度与第一编码数据的长度相等。

[0022]

可选的,上述的方法,其特征在于,所述基于预设的解码器对于所述第二语音数据进行处理得到识别结果,包括:

[0023]

基于多头注意力算法模块对于所述第二语音数据进行处理,得到第一结果;

[0024]

至少基于混合链接时序分类模块对于所述第二语音数据进行处理,得到第二结果;

[0025]

基于线性插值规则对所述第一结果和第二结果进行处理,得到解码结果,所述解码结果包括了至少两个候选输出序列以及所述候选输出序列对应解码分值;

[0026]

选择解码分值满足预设条件的候选输出序列作为识别结果。

[0027]

可选的,上述的方法,其特征在于,所述基于多头注意力算法模块对于所述第二语音数据进行处理,得到第一结果,包括:

[0028]

获取第二语音数据的上下文信息;

[0029]

将所述第二语音数据以及所述第二语音数据的上下文信息依次经过所述多头注意力算法模块中设置的第一注意力解码层、四层解码层以及第二注意力解码层的处理,得到第三结果;

[0030]

对于第三结果进行线性变换处理和归一化处理,得到第一结果。

[0031]

可选的,上述的方法,其特征在于,所述至少基于混合链接时序分类模块对于所述第二语音数据进行处理,得到第二结果,包括:

[0032]

对于所述第二语音数据进行归一化处理,得到归一化处理后的第二语音数据;

[0033]

基于所述混合链接时序分类算法模块对于归一化处理后的述第二语音数据进行损失处理,得到第二结果。

[0034]

一种语音识别装置,包括:

[0035]

获取单元,用于获取待识别语音数据;

[0036]

预处理单元,用于对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;

[0037]

编码单元,用于对于所述第一语音数据进行编码处理,得到第二语音数据,所述编码单元中包括深度可分离卷积神经网络层和多头注意力算法层;

[0038]

解码单元,用于对于所述第二语音数据进行处理得到识别结果,所述解码单元包括多头注意力算法模块和混合链接时序分类模块。

[0039]

一种处理器,其特征在于,所述处理器用于运行程序,其中,所述程序运行时执行如上述任意一项所述的方法。

[0040]

一种计算机可读存储介质,其特征在于,所述存储介质包括存储的程序,其中,所述程序执行如上述任意一项所述的方法。

[0041]

经由上述的技术方案可知,与现有技术相比,本技术提供了一种语音识别方法,包括:获取待识别语音数据;对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;基于预设的编码器对于所述第一语音数据进行编码处理,得到第二语音数据,所述预设编码器中包括深度可分离卷积神经网络层和多头注意力算法层;基于预设的解码器对于所述第二语音数据进行处理得到识别结果,所述解码器包括多头注意力算法模块和混合链接时序分类模块。本方案中,编码器中采用了深度可分离卷积神经网络层和多头注意力算法层,深度可分离卷积神经网络的计算量更小,摒弃rnn网络使得在进行语音识别时可以进行并行计算,大大减少了识别所用的时间,提高了时效性;而且解码器包括多头注意力算法模块和混合链接时序分类模块,识别结果更精准。

附图说明

[0042]

为了更清楚地说明本技术实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据提供的附图获得其他的附图。

[0043]

图1为现有技术中lstm网络神经单元结构示意图;

[0044]

图2为本技术提供的一种语音识别方法实施例1的流程图;

[0045]

图3为本技术提供的一种语音识别方法实施例2的流程图;

[0046]

图4为本技术提供的一种语音识别方法实施例2中编码器中深度可分离卷积神经网络层示意图;

[0047]

图5为本技术提供的一种语音识别方法实施例2中编码器中多头注意力算法层示

意图;

[0048]

图6为本技术提供的一种语音识别方法实施例2中编码器中注意力编码层示意图;

[0049]

图7为本技术提供的一种语音识别方法实施例2中注意力变换过程示意图;

[0050]

图8为本技术提供的一种语音识别方法实施例3的流程图;

[0051]

图9为本技术提供的一种语音识别方法实施例3中解码器中多头注意力算法模块示意图;

[0052]

图10为本技术提供的一种语音识别方法实施例中多头注意力算法的编码

‑

解码过程示意图;

[0053]

图11的为本技术提供的一种语音识别方法的装置实施例的结构示意图;

[0054]

图12为应用场景中本技术中的语音识别装置的示意图。

具体实施方式

[0055]

下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

[0056]

如图2所示的,为本技术提供的一种语音识别方法实施例1的流程图,该方法应用于一电子设备,该方法包括以下步骤:

[0057]

步骤s201:获取待识别语音数据;

[0058]

其中,该待识别语音数据可以是车载语音相关场景中的语音数据。

[0059]

具体的,该语音数据包括语音文件、标注文本等格式,本技术中干部对于语音数据的具体格式做限制。

[0060]

步骤s202:对于所述待识别语音数据进行预处理,提取得到第一语音数据;

[0061]

其中,所述第一语音数据包括预设维特征值。

[0062]

其中,该预处理包括:预加重、分帧、加窗、快速傅里叶变换以及mfcc(mel frequency cepstrum coefficient,mel频率倒谱系数)提取等处理。

[0063]

具体实施中,该第一语音数据包括80维高分辨率特征和3维基频共83维特征值。

[0064]

其中,高分辨率特征采用梅尔(mel)尺度滤波器组系数。

[0065]

具体的,该基频与声音的音高特性相对应,在语音识别中与音调息息相关,能够辅助带声调的语言的语音识别,因此在语音识别中加入了基频的特征值。

[0066]

步骤s203:基于预设的编码器对于所述第一语音数据进行编码处理,得到第二语音数据,所述预设编码器中包括深度可分离卷积神经网络层和多头注意力算法层;

[0067]

其中,该编码器(encoder)中包括深度可分离卷积神经网络层和多头注意力算法层。

[0068]

本技术的编码器在多头注意力算法的基础上加入基于深度可分离卷积神经网络,相对于传统数据处理网络(rnn和和ctc),计算量更小、时效性更高、且预测精度更好。

[0069]

后续实施例中会针对该编码器对于第一语音数据进行处理的具体过程做详细解释,本实施例中不做详述。

[0070]

步骤s204:基于预设的解码器对于所述第二语音数据进行处理得到识别结果,所

述解码器包括多头注意力算法模块和混合链接时序分类模块。

[0071]

其中,该解码器中包括多头注意力算法模块和混合链接时序分类模块。

[0072]

本技术的解码器(decoder)使用多头注意力算法和ctc,不丢失重要的信息,且输出的序列对齐效果更好。

[0073]

具体的,该解码器输出的识别结果具体可以是语音文本,该语音文本是与步骤s201获取的待识别语音数据对应的文本。

[0074]

后续实施例中会针对该解码器对于第二语音数据进行处理的具体过程做详细解释,本实施例中不做详述。

[0075]

需要说明的是,本方案中,基于深度学习中的深度可分离卷积神经网络、多头注意力算法和ctc算法的混合模型对用户的语音内容进行转文字识别,在保留了多头注意力算法并行计算的优点的前提下混合ctc算法,有效解决多头注意力算法解码无约束的问题,该方法可以加快训练收敛速度同时加快解码速度,保证可以快速的识别一些操作指令并让车机作出相应的操作,并且提高了文本识别率,有效提升用户体验。

[0076]

综上,本实施例提供的一种语音识别方法,包括:获取待识别语音数据;对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;基于预设的编码器对于所述第一语音数据进行编码处理,得到第二语音数据,所述预设编码器中包括深度可分离卷积神经网络层和多头注意力算法层;基于预设的解码器对于所述第二语音数据进行处理得到识别结果,所述解码器包括多头注意力算法模块和混合链接时序分类模块。本方案中,编码器中采用了深度可分离卷积神经网络层和多头注意力算法层,深度可分离卷积神经网络的计算量更小,摒弃rnn网络使得在进行语音识别时可以进行并行计算,大大减少了识别所用的时间,提高了时效性;而且解码器包括多头注意力算法模块和混合链接时序分类模块,识别结果更精准。

[0077]

如图3所示的,为本技术提供的一种语音识别方法实施例2的流程图,该方法应用于一电子设备,该方法包括以下步骤:

[0078]

步骤s301:获取待识别语音数据;

[0079]

步骤s302:对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;

[0080]

其中,步骤s301

‑

302与实施例1中的步骤s201

‑

202一致,本实施例中不做赘述。

[0081]

步骤s303:基于所述深度可分离卷积神经网络层对于所述第一语音数据进行处理,得到第一编码数据;

[0082]

其中,该深度可分离卷积神经网络利用了深度卷积和逐点卷积相结合的方法,对于第一语音数据进行处理。

[0083]

其中,所述步骤s303,具体包括:

[0084]

将所述第一语音数据依次经过所述深度可分离卷积神经网络层中设置的深度可分离卷积层、第一批量标准化(batch normalization)层、第一非线性激活层、逐点卷积层、第二批量标准化层以及第二非线性激活层的处理,得到第一编码数据。

[0085]

其中,该深度可分离卷积层采用的为3

×

3深度卷积层,其步长设置为2,该逐点卷积层采用的是1

×

1普通卷积层。

[0086]

具体的,该非线性激活层采用的是relu6非线性激活。

[0087]

如图4所示的为编码器中深度可分离卷积神经网络层示意图,该深度可分离卷积神经网络层依次设置有:3

×

3深度可分离卷积层(步长为2)、批量标准化层、非线性激活层、1

×

1普通卷积层、批量标准化层、非线性激活层,其中箭头表示了数据传递的方向。

[0088]

需要说明的是,本实施例中,在一层深度可分离卷积神经网络层中使用两个relu6非线性激活层能够增加模型的非线性变化,增强模型的泛化能力,能较好的保持网络的鲁棒性,提高网络的预测精度。

[0089]

步骤s304:基于多头注意力算法层对于所述第一编码数据进行处理得到第二语音数据;

[0090]

其中,所述第二语音数据的编码序列的长度与第一编码数据的长度相等。

[0091]

其中,该多头注意力算法层采用了6层的多头自注意力机制。

[0092]

如图5所示的为编码器中多头注意力算法层示意图,依次设置有:注意力编码层(attention encoder layer)、四层编码层(encoder layer*4)以及注意力编码层(attention encoder layer),其中,箭头表示了数据传递的方向。

[0093]

其中,该步骤s304,具体如下:

[0094]

将所述第一编码依次经过所述多头注意力算法层中设置的第一注意力编码层、四层编码层以及第二注意力编码层的处理,得到第二语音数据。

[0095]

如图6所示的为注意力编码层示意图,依次设置有三个矩阵qkv(8维的矩阵)、标准化层(layer norm)、前馈层(feed forword)以及标准化层(layer norm)。

[0096]

具体的,第一编码数据通过8层qkv矩阵得到的结果与该第一编码数据进行标准化处理得到处理结果;该处理结果经过前馈处理与未经过前馈处理的处理结果进行标准化处理,得到输出结果,即第二语音数据。

[0097]

需要说明的是,由于上一网络层的输出会作为下一网络层的输入,因此会产生协变量转移的现象。因此,标准化层的作用是使得同层网络的所有隐藏单元共享均值和方差,通过固定网络层的输入分布(固定输入的均值和方差)来降低协变量转移的影响,每个时刻加权后的输入通过标准化被重新调整在合适的范围,很大程度避免了梯度消失、梯度爆炸问题,隐藏状态的传递更加稳定。

[0098]

该前馈层具体包括了两层:第一层是一个线性激活函数,第二层是relu激活函数,因此,该前馈处理包括了先进行线性激活处理再进行relu激活处理。

[0099]

如图7所示的为注意力变换过程示意图,多头注意力机制则将q、k、v三个矩阵通过不同的映射矩阵映射到不同的空间,每个空间为一个头,使得模型能够从多个空间进行注意力的学习,最后将得到的多个表征进行拼接,映射到原来的空间,得到最终的注意力结果。

[0100]

具体的,该qkv矩阵是给加入了位置编码的输入语音特征值x

embedding

分配三个不同的权重w

q

、w

k

和w

v

,该x

embedding

包括了c1、c2

……

cn,x

embedding

经过线性映射后形成的三个矩阵,具体为q(query)、k(key)、v(value):

[0101]

q=linear(x

embedding

)=x

embedding

w

q

[0102]

k=linear(x

embedding

)=x

embedding

w

k

[0103]

v=linear(x

embedding

)=x

embedding

w

v

[0104]

其中v的每一行代表每个字向量的数学表达,对q、k、v矩阵做如下的变换可以得到

注意力矩阵:

[0105][0106]

其中,q矩阵和k矩阵经过上述变换得到注意力矩阵(attention)n

×

n维矩阵,该注意力矩阵经过softmax归一化处理后与v矩阵得到处理得到注意力结果——缩放点积注意力(scaled dot

‑

produce attention)。

[0107]

需要说明的是,本技术中,注意力编码层采用的6层的多头自注意力机制,由于自注意力机制有较强的上下文学习能力和快速计算的能力,可以获得输入数据的上下文相关信息。

[0108]

而后续步骤中,将该将编码序列作为解码层的输入数据,将输入数据上下文信息和标签上下文信息再进行注意力机制的计算,可以获得输入数据和输出标签相关的注意力信息,使得模型具有较强的推断能力和收敛速度。

[0109]

其中,得益于注意力机制,注意力机制会将长句子的所有位置的信息进行计算,如图7所示,c1与所有的cn都会进行一次计算,因此能够得到标签的上下文信息。

[0110]

步骤s305:基于预设的解码器对于所述第二语音数据进行处理得到识别结果,所述解码器包括多头注意力算法模块和混合链接时序分类模块。

[0111]

其中,步骤s305与实施例1中的步骤s204一致,本实施例中不做赘述。

[0112]

综上,本实施例提供的一种语音识别方法中,所述基于预设的编码器对于所述第一语音数据进行编码处理,得到第二语音数据,包括:基于所述深度可分离卷积神经网络层对于所述第一语音数据进行处理,得到第一编码数据;基于多头注意力算法层对于所述第一编码数据进行处理得到第二语音数据。本方案中,在多头注意力算法的基础上加入基于深度可分离卷积神经网络。深度可分离卷积神经网络利用深度卷积和逐点卷积相结合的方法,使得计算量小,时效性高。

[0113]

如图8所示的,为本技术提供的一种语音识别方法实施例3的流程图,该方法应用于一电子设备,该方法包括以下步骤:

[0114]

步骤s801:获取待识别语音数据;

[0115]

步骤s802:对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;

[0116]

步骤s803:基于预设的编码器对于所述第一语音数据进行编码处理,得到第二语音数据,所述预设编码器中包括深度可分离卷积神经网络层和多头注意力算法层;

[0117]

其中,步骤s801

‑

803与实施例1中的步骤s201

‑

203一致,本实施例中不做赘述。

[0118]

步骤s804:基于多头注意力算法模块对于所述第二语音数据进行处理,得到第一结果;

[0119]

其中,多头注意力算法模块有给数据的重点部分划分更多的注意力的优势,即使是较长的数据中,也能够中间抓住重点,不丢失重要的信息。

[0120]

其中,所述步骤s804,包括:

[0121]

步骤s8041:获取第二语音数据的上下文信息;

[0122]

其中,该第二语音数据的上下文信息是所述编码器中多头注意力算法层对于第一编码数据处理得到的。

[0123]

步骤s8042:将所述第二语音数据以及所述第二语音数据的上下文信息依次经过所述多头注意力算法模块中设置的第一注意力解码层、四层解码层以及第二注意力解码层的处理,得到第三结果;

[0124]

其中,将该编码器处理得到的第二语音数据以及其上下文信息结合标注标签上下文信息进行注意力机制处理,将第二语音数据和输出标签做计算,获得第二语音数据以及输出标签相关的注意力信息。

[0125]

具体的,基于该第二语音数据和输出标签的联系,使得后续的步骤中的线性变换处理和归一化处理的收敛速度更快,提高该解码器的准确度。

[0126]

图9是本实施例中解码器中多头注意力算法模块示意图,该多头注意力算法模块依次设置有:注意力解码层(attention decoder layer)、四层解码层(decoder layer*4)以及注意力解码层(attention decoder layer),其中,箭头表示了数据传递的方向。

[0127]

步骤s8043:对于第三结果进行线性变换处理和归一化处理,得到第一结果。

[0128]

其中,该第一结果中包括候选输出序列的注意力得分。

[0129]

步骤s805:至少基于混合链接时序分类模块对于所述第二语音数据进行处理,得到第二结果;

[0130]

具体的,所述步骤s805,包括:

[0131]

步骤s8051:对于所述第二语音数据进行归一化处理,得到归一化处理后的第二语音数据;

[0132]

步骤s8052:基于所述混合链接时序分类算法模块对于归一化处理后的述第二语音数据进行损失处理,得到第二结果。

[0133]

具体的,先将该解码器输出的第二语音数据进行softmax归一化处理,在将归一化处理后的数据输入ctc模块的损失函数层,得到第二结果。

[0134]

该第二结果包括了候选输出序列的ctc得分。

[0135]

步骤s806:基于线性插值规则对所述第一结果和第二结果进行处理,得到解码结果,所述解码结果包括了至少两个候选输出序列以及所述候选输出序列对应解码分值;

[0136]

其中,解码器中基于该第一结果和第二结果进行波束搜索(beam search),设定权重值,针对ctc处理结果和注意力处理结果分别设置权重。

[0137]

如,候选输出序列的注意力得分为p

attention

,ctc得分为p

ctc

,为注意力得分设定权重为γ,ctc得分设定权重为(1

‑

γ),基于线性插值规则计算其对数的分数和,得到最终的解码得分p

h

为:

[0138]

ln(p

h

)=γln(p

attention

) (1

‑

γ)ln(p

ctc

)

[0139]

其中,基于上述的线性插值规则,对于第一结果和第二结果中的各个候选输出序列计算得到解码分值。

[0140]

需要说明的是,ctc算法只关心一个输入序列到一个输出序列的结果,即只会关心预测输出的序列是否和真实的序列是否接近,不会关心预测输出序列中每个结果在时间点上是否和输入的序列正好对齐,因此,该解码器采用多头注意力算法和ctc相结合,在多头注意力算法的基础上将ctc概率考虑在内,可以在解码过程中使用ctc概率强制执行对齐操作,避免了相同帧的循环和大的跳动的情况的出现,提高模型的收敛速度。

[0141]

步骤s807:选择解码分值满足预设条件的候选输出序列作为识别结果。

[0142]

其中,对于各个候选输出序列的解码分值进行排序,从中选择满足预设条件的候选输出序列作为识别结果。

[0143]

具体实施中,进行波束搜索时,对于第一结果和第二结果中得到的候选输出序列进行线性插值计算处理,得到的n(n为正整数)个候选输出序列作为候选输出序列。

[0144]

具体实施中,该预设条件可以是解码分值最高,解码分值最高表征了其对应的候选输出序列是与输入的待识别语音最匹配的识别内容。

[0145]

综上,本实施例提供的一种语音识别方法中,所述基于预设的解码器对于所述第二语音数据进行处理得到识别结果,包括:基于多头注意力算法模块对于所述第二语音数据进行处理,得到第一结果;至少基于混合链接时序分类模块对于所述第二语音数据进行处理,得到第二结果;基于线性插值规则对所述第一结果和第二结果进行处理,得到解码结果,所述解码结果包括了至少两个候选输出序列以及所述候选输出序列对应解码分值;选择解码分值最高的候选输出序列作为识别结果。本方案中,在多头注意力算法的基础上将ctc概率考虑在内,可以在解码过程中使用ctc概率强制执行对齐操作,避免了相同帧的循环和大的跳动的情况的出现,提高模型的收敛速度。

[0146]

如图10所示的为本方案中涉及的多头注意力算法的编码

‑

解码过程示意图,其中,编码部分应用于编码器中,解码部分应用于解码器中生成第一结果。其中,虚线左侧为编码部分,虚线右侧为解码部分。

[0147]

其中,编码部分包括:输入嵌套层、注意力编码层一、4层编码层以及注意力编码层二。其中,注意力编码层如左侧虚线框中结构,包括:qkv矩阵(8维),标准化层一、前馈层以及标准化层二。

[0148]

其中,该编码部分的输入为深度可分离卷积神经网络层输出的数据。

[0149]

其中,解码部分包括:输出嵌套层、注意力解码层一、4层解码层、注意力解码层二、softmax归一化层以及输出层。

[0150]

其中,编码部分的注意力编码层二分别输出数据给注意力解码层一、4层解码层、注意力解码层二。

[0151]

其中,注意力解码层如右侧虚线框中结构,包括:qkv矩阵(8维)一、标准化层一、qkv矩阵(8维)二、标准化层二、前馈层以及标准化层三。

[0152]

其中,编码器输出内容经过vqk矩阵一处理后处理结果经过标准化层一的标准化处理输出给该qkv矩阵(8维)二中v矩阵,编码器输出内容输出给qkv矩阵(8维)二中的kq矩阵,该qkv矩阵(8维)二的处理结果和qkv矩阵(8维)一的处理结果经过标准化处理后,其与继续经过前馈层处理的结果组合经过标准化处理,得到的结果输出给4层解码层处理。

[0153]

与上述本技术提供的一种语音识别方法实施例相对应的,本技术还提供了应用该语音识别方法的装置实施例。

[0154]

如图11所示的为本技术提供的一种语音识别方法的装置实施例的结构示意图,该装置包括以下结构:获取单元1101、预处理单元1102、编码单元1103以及解码单元1104。

[0155]

其中,获取单元1101,用于获取待识别语音数据;

[0156]

其中,预处理单元1102,用于对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;

[0157]

其中,编码单元1103,用于对于所述第一语音数据进行编码处理,得到第二语音数

据,所述编码单元中包括深度可分离卷积神经网络层和多头注意力算法层;

[0158]

其中,解码单元1104,用于对于所述第二语音数据进行处理得到识别结果,所述解码单元包括多头注意力算法模块和混合链接时序分类模块。

[0159]

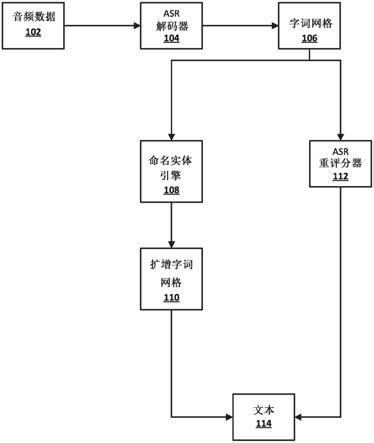

如图12所示的为应用场景中本技术中的语音识别装置的示意图,包括:预处理器1201、编码器1202、解码器1203。

[0160]

其中,预处理器,用于对采集到的语音进行预处理,得到80维高分辨率特征和3维基频共83维特征值。

[0161]

其中,编码器1202包括深度可分离卷积神经网络层和多头注意力算法层。

[0162]

其中,解码器1202包括了多头注意力算法层、全连接层、ctc算法层、输出层。

[0163]

其中,编码器处理得到的数据分别输入多头注意力算法层和全连接层,该全连接层用于对数据进行归一化处理后将处理结果输出给ctc算法层,该ctc算法层输出的结果与该多头注意力算法层输出的结果进行加权计算,得到识别结果,输出层输出该识别结果。

[0164]

其中,该编码单元和解码单元的具体功能参考前述语音识别方法实施例中的解释,本实施例中不做详述。

[0165]

综上,本实施例提供的一种语音识别装置,包括:获取单元,用于获取待识别语音数据;预处理单元,用于对于所述待识别语音数据进行预处理,提取得到第一语音数据,所述第一语音数据包括预设维特征值;编码单元,用于对于所述第一语音数据进行编码处理,得到第二语音数据,所述编码单元中包括深度可分离卷积神经网络层和多头注意力算法层;解码单元,用于对于所述第二语音数据进行处理得到识别结果,所述解码单元包括多头注意力算法模块和混合链接时序分类模块。本方案中,编码单元中采用了深度可分离卷积神经网络层和多头注意力算法层,深度可分离卷积神经网络的计算量更小,摒弃rnn网络使得在进行语音识别时可以进行并行计算,大大减少了识别所用的时间,提高了时效性;而且解码单元包括多头注意力算法模块和混合链接时序分类模块,识别结果更精准。

[0166]

与上述本技术提供的一种语音识别方法实施例相对应的,本技术还提供了应用该语音识别方法的处理器实施例。

[0167]

一种处理器,该处理器用于运行程序,其中,所述程序运行时执行上述方法实施例所提供的方法语音识别方法。

[0168]

具体的,处理器可以是一个中央处理器cpu(central processing unit),或者是特定集成电路asic(application specific integrated circuit),或者是被配置成实施本发明实施例的一个或多个集成电路。

[0169]

与上述本技术提供的一种语音识别方法实施例相对应的,本技术还提供了一种计算机可读存储介质实施例。

[0170]

一种计算机可读存储介质,所述存储介质包括存储的程序,其中,所述程序执行上述方法实施例所提供的方法语音识别方法。

[0171]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例提供的装置而言,由于其与实施例提供的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0172]

对所提供的实施例的上述说明,使本领域专业技术人员能够实现或使用本技术。

对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本技术的精神或范围的情况下,在其它实施例中实现。因此,本技术将不会被限制于本文所示的这些实施例,而是要符合与本文所提供的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。