1.本发明涉及车牌检测技术领域,特别涉及一种基于深度学习技术的复杂场景下的车牌检测识别方法以及系统。

背景技术:

2.传统的车牌检测方法一般利用opencv检测等方法,复杂场景下精度较低,鲁棒性较差,不能达到实际落地应用的效果;而现有的基于深度的车牌检测技术一般通过三个步骤,包括车牌定位、车牌字符分割和字符识别,此方法时效性较差,且对于复杂场景检测性能较低。

3.现有技术一公开了一种基于opencv的车牌检测方法,主要分为以下步骤:

4.1.车辆检测。通过读取图片或视频,基于混合高斯模型的背景差分法以及形态学的方法,通过设定像素点数阈值检测出车辆区域。

5.2.车牌区域粗定位。调整图片大小并进行颜色转换,利用直方图均衡化、形态学(腐蚀膨胀)、滤波、边缘检测以及开闭运算得到最大连通区域,从而得到车牌的候选区域。

6.3.车牌区域精确定位。对候选区域进行颜色空间转化(蓝色,大部分车牌为蓝色)并进行均衡化。通过设定蓝色颜色空间阈值找到非零点集所在的最大矩形区域,并利用边缘检测算子和霍夫变换进行水平矫正,得到变换后的图像。对变换后的图像进行灰度变换,并通过设定阈值得到精确定位的车牌图像。

7.4.车牌字符分割。对车牌进行垂直投影,并求出投影平均值,通过搜索投影值对每个字符进行分割,并对其进行归一化,二值化得到字符。

8.5.车牌字符识别。通过训练多个支持向量机对单个汉字、字符或者数字进行分类。

9.但是上述现有技术一存在如下缺点:

10.1.此方法广泛和扩展性较差,仅支持对于正面车辆图像的检测识别,不能够应用于多角度车辆检测。

11.2.此方法对于图像质量要求较为严格,光照强度和拍摄角度等外界客观因素对应方法影响较大,复杂场景下性能较差。

12.3.字符识别严重依赖于字符分割精度,字符分割精度依赖于图片质量,导致识别精度较差。

13.4.字符识别对二值化图片进行单字符识别,舍去了字符的很多重要特征,识别精度差。

14.现有技术二公开了一种基于深度学习技术的车牌检测识别方法,一般包括一下步骤:

15.1.车牌定位模块。获取图像作为yolo框架输入,得到车牌的矩形框。

16.2.车牌字符分割模块。对车牌进行垂直投影,并求出投影平均值,通过搜索投影值对每个字符进行分割,并对其进行归一化,二值化得到字符。

17.3.车牌字符识别模块。利用循环神经网络进行字符识别。

18.但是现有技术二有如下缺点:

19.1.现有的车牌检测识别,对于车牌定位一般采用目标检测的方法如yolo框架,其缺点在于yolo框架只能生成矩形框,虽然一般会进行校正,但对于倾斜程度较大的车牌其检测效果并不好,直接影响到车牌字符分割和车牌字符识别的精度。

20.2.现有技术将车牌分割和车牌识别技术分为两步进行处理,且车牌字符分割采用垂直投影的方法,对于外界客观因素对其影响较大,并且两个模型的联合出现累计误差,从而减少整个模型的精度。

技术实现要素:

21.发明所要解决的问题

22.本发明的主要目的是提供一种复杂场景下的车牌检测识别方法以及系统,以提高整个模型的精度,满足负责场景的高精度识别,并进行多种颜色车牌检测。

23.用于解决问题的方案

24.本发明一实施方式是一种复杂场景下的车牌检测识别方法,包括如下步骤:

25.步骤s1:采集车辆视频流,并在视频流中提取图片数据;

26.步骤s2:构建车辆局部定位模块,并将图片数据作为车辆局部定位模块的训练数据,得到车牌局部定位模型;

27.步骤s3:构建车牌角点检测模块,并将车牌局部定位模块的输出作为车辆角点检测的训练数据,得到车牌角点检测模型;

28.步骤s4:对视频流按照静止帧提取待检测的视频图像序列;

29.步骤s5:将视频图片序列输入局部定位模块,得到带有车牌的车辆局部图片并输出局部图片的位置信息和车牌颜色信息;

30.步骤s6:将局部定位模块的输出作为车牌角点检测模块的输入,得到车牌角点信息和外接矩形框信息;

31.步骤s7:根据得到的车牌角点信息和外接矩形信息进行图片矫正;

32.步骤s8:构建车牌识别模块,将车牌图片作为车牌识别模型的训练数据,得到车牌识别模型;

33.步骤s9:将步骤s7中的矫正的图片作为车牌识别模块输入,得到图片识别结果。

34.优选地,所述步骤s2包括如下子步骤:

35.步骤s21:利用线性插值的方法调整图像大小为固定值;

36.步骤s22:利用神经网络框架提取高级特征;

37.步骤s23:通过多尺度特征融合的方法,进行反采样,输出为颜色分类分支和位置信息分支。

38.优选地,颜色分类分支采用softmax回归算法,位置信息分支采用smothl1非线性函数,softmax和smothl1公式分别具体为:

39.softmax:

40.smothl1:

41.其中,在softmax函数中,y

j

为j个颜色的类别概率,x

i

为第i个节点值,x

j

为第j个节点值;在smothl1中,y为预测的坐标值,为真实的坐标值,其中坐标包括左上角坐标和右下角坐标。

42.优选地,所述步骤s3包括如下子步骤:

43.步骤s31:利用车辆局部定位模块的输出图片作为输入;

44.步骤s32:利用padding方式将图像调整到固定大小;

45.步骤s33:利用神经网络框架提取高级特征,输出三个分支,其中三个分支包括,置信度得分信息、外接矩形位置信息和角点位置信息。

46.优选地,所述置信度得分信息采用sigmoid回归算法,所述外接矩形位置信息和所述角点位置信息分支采用smothl1非线性函数,sigmoid的公式具体如下:

47.sigmoid:

48.其中,z=wx b,x为输出节点值,w为所对应权重值,b为所对应的偏置值,y为输出有目标的概率值,若y>0.5,则表示检测到车牌,反之,没有检测到车牌。

49.优选地,所述步骤s8包括如下子步骤:

50.步骤s81:利用线性插值方式将矫正后图像调整到固定大小,作为车牌识别模块的输入;

51.步骤s82:通过神经网络框架提取高级特征,得到68x18的特征图,通过贪心算法对车牌进行字符识别,并通过ctc loss进行反向传播。

52.本发明还提供一种复杂场景下的车牌检测识别方法,包括如下步骤:

53.步骤s1’:采集车辆视频流,并在视频流中提取图片数据;

54.步骤s2’:构建车辆局部定位模块,并将图片数据作为车辆局部定位模块的训练数据,得到车辆局部定位模型;

55.步骤s3’:构建车牌角点检测模块,并将车牌局部定位模块的输出作为车辆角点检测的训练数据,得到车牌角点检测模型;

56.步骤s4’:对视频流按照静止帧提取待检测的视频图像序列;

57.步骤s5’:将视频图片序列输入车牌角点检测模块,得到车牌角点信息和外接矩形框信息;

58.步骤s6’:根据得到的车牌角点信息和外接矩形信息进行图片矫正;

59.步骤s7’:构建车牌识别模块,将车牌图片作为车牌识别模型的训练数据,得到车牌识别模型;

60.步骤s8’:将步骤s6’中的矫正的图片作为车牌识别模块输入,得到图片识别结果。

61.本发明还提供一种复杂场景下的车牌检测识别系统,包括:

62.图片提取单元,其采集车辆视频流,并在视频流中提取图片数据;

63.车辆局部定位单元,其构建车辆局部定位模块,并将图片数据作为车辆局部定位模块的训练数据,得到车牌局部定位模型;

64.车牌角点检测单元,其构建车牌角点检测模块,并将车牌局部定位模块的输出作为车辆角点检测的训练数据,得到车牌角点检测模型;

65.图片矫正单元,其进行图片矫正;以及

66.车牌识别单元,其构建车牌识别模块,将车牌图片作为车牌识别模型的训练数据,得到车牌识别模型,根据图片矫正单元所矫正的图片作为车牌识别模块输入,得到图片识别结果。

67.优选地,所述图片矫正单元包括:

68.提取视频图像序列单元,其对视频流按照静止帧提取待检测的视频图像序列;

69.位置和颜色获取单元,其将视频图片序列输入局部定位模块,得到带有车牌的车辆局部图片并输出局部图片的位置信息和车牌颜色信息;

70.信息获取单元,其将局部定位模块的输出作为车牌角点检测模块的输入,得到车牌角点信息和外接矩形框信息;以及

71.矫正单元,其根据得到的车牌角点信息和外接矩形信息进行图片矫正。

72.发明的效果

73.与现有技术相比,本发明具有如下有益效果:

74.本发明为避免yolo框架的弊端,并不直接用yolo框架进行精准定位,而是先利用yolo框架进行局部定位,提高模型精度的同时,也用来获取车牌的颜色,以适用于各种颜色的车牌。

75.本发明对于车牌字符分割和车牌字符识别同时预测,提高了模型精度和时效性。

76.本发明通过收集大量不同角度的车牌,对数据集进行标注,并摒弃了传统的分为两步的车牌字符分割和车牌字符识别算法,从而提高了模型的时效性。同时,增加了时效性较高的局部定位模块,从而提高了模型复杂场景下的车牌识别精度,本发明具有较强的实际应用性。

附图说明

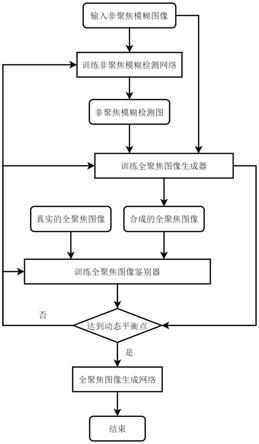

77.图1是本发明的一种复杂场景下的车牌检测识别方法流程图。

78.图2是本发明的一种复杂场景下的车牌检测识别方法流程示意图。

79.图3是本发明的一种复杂场景下的车牌检测识别方法另一实施例流程图

80.图4是本发明的一种复杂场景下的车牌检测识别系统框图。

81.附图标记说明

82.1:车牌检测识别系统;11:图片提取单元;12:车辆局部定位单元;13:车牌角点检测单元;14:图片矫正单元;15:车牌识别单元;141:提取视频图像序列单元;142:位置和颜色获取单元;143:信息获取单元;144:矫正单元。

具体实施方式

83.下面将结合本发明实施例中的图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有付出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。并且,在此处需要进一步强调的是,以下的具体实施例提

供的优选的技术方案,各方案(实施例)之间是可以相互配合或结合使用的。

84.如图1所示,本发明提供一种基于深度学习技术的复杂场景下的车牌检测识别方法流程图,该方法包括以下步骤:

85.步骤s1:采集车辆视频流,并在视频流中提取图片数据;

86.步骤s2:构建车辆局部定位模块,并将图片数据作为车辆局部定位模块的训练数据,得到车牌局部定位模型;

87.步骤s3:构建车牌角点检测模块,并将车牌局部定位模块的输出作为车辆角点检测的训练数据,得到车牌角点检测模型;

88.步骤s4:对视频流按照静止帧提取待检测的视频图像序列;

89.步骤s5:将视频图片序列输入局部定位模块,得到带有车牌的车辆局部图片并输出局部图片的位置信息和车牌颜色信息;

90.步骤s6:将局部定位模块的输出作为车牌角点检测模块的输入,得到车牌角点信息和外接矩形框信息;

91.步骤s7:根据得到的车牌角点信息和外接矩形信息进行图片矫正;

92.步骤s8:构建车牌识别模块,将车牌图片作为车牌识别模型的训练数据,得到车牌识别模型;

93.步骤s9:将步骤s7中的矫正的图片作为车牌识别模块输入,得到图片识别结果。

94.如图2所示,本发明提供一种基于深度学习技术的复杂场景下的车牌检测识别方法流程示意图,在步骤s2的构建车辆局部定位模块中,对收集到的大量不同角度不同场景下的车辆数据进行人工标注,标注框为含有车牌的车辆局部矩形框,将车辆数据正负样本比例设为1:3,以卷积神经网络模型作为框架对模型进行训练,并将标注数据作为训练集和验证集以及测试集,其中,训练数据集和验证数据集以及测试集的比例为8:1:1,用测试数据集测试模型精度,若测试精度达不到98%,迭代训练模型,直到模型精度达到98%;

95.所述步骤s2包括如下子步骤:

96.步骤s21:利用线性插值的方法调整图像大小为固定值;

97.步骤s22:利用神经网络框架提取高级特征;

98.步骤s23:通过多尺度特征融合的方法,进行反采样,输出为颜色分类分支和位置信息分支,其中,颜色分类分支采用softmax回归算法,位置信息分支采用smothl1非线性函数,softmax和smothl1公式分别具体为:

99.softmax:

100.smothl1:

101.其中,在softmax函数中,y

j

为j个颜色的类别概率,x

i

为第i个节点值,x

j

为第j个节点值;在smothl1中,y为预测的坐标值,为真实的坐标值,其中坐标包括左上角坐标和右下角坐标。

102.在步骤s3的构建车辆角点检测模块中,对步骤s2的构建车辆局部定位模块的输出

作为此模块的训练验证测试集进行人工标注,其标注为不规则车牌的四个角点坐标,将所有数据正负样本比例设为1:3,以卷积神经网络模型作为框架对模型进行训练,将标注后的车牌局部定位模块的输出作为车辆角点检测的训练验证测试集,训练数据集和验证数据集以及测试数据集比例为8:1:1,用测试数据集测试模型精度,若测试精度达不到96%,迭代训练模型,直到模型精度达到96%;

103.所述步骤s3包括如下子步骤:

104.步骤s31:利用车辆局部定位模块的输出图片作为输入;

105.步骤s32:利用padding方式将图像调整到固定大小;

106.步骤s33:利用神经网络框架提取高级特征,输出三个分支,其中三个分支包括,置信度得分信息、外接矩形位置信息和角点位置信息,置信度得分信息采用sigmoid回归算法,外接矩形位置信息和角点位置信息分支采用smothl1非线性函数,softmax和smothl1公式在步骤s23中已说明,sigmoid的公式具体如下:

107.sigmoid:

108.其中,z=wx b,x为输出节点值,w为所对应权重值,b为所对应的偏置值,y为输出有目标的概率值,若y>0.5,则表示检测到车牌,反之,没有检测到车牌。

109.在步骤s7中,利用霍夫直线检测和透视变换对检测的车牌角点进行图片矫正;

110.在步骤s8的构建车牌识别模块中,对步骤s7输出即矫正后的车牌数据作为训练数据集进行人工标注,将正负样本设为1:3,以循环神经网络模型作为框架对模型进行训练,将矫正后的车牌图片作为车牌识别模型的训练验证测试数据集,训练数据集和验证数据集以及测试数据集比例为8:1:1,用测试数据集测试模型精度,若测试精度达不到96%,迭代训练模型,直到模型精度达到96%;

111.所述步骤s8包括如下子步骤:

112.步骤s81:利用线性插值方式将矫正后图像调整到固定大小,作为车牌识别模块的输入;

113.步骤s82:通过神经网络框架提取高级特征,得到68x18的特征图,通过贪心算法对车牌进行字符识别,并通过ctc loss进行反向传播。

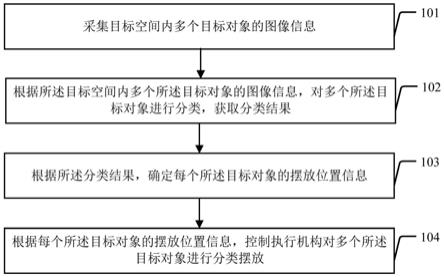

114.如图3所示,为本发明一种复杂场景下的车牌检测识别方法另一实施例流程图,当需求为单颜色车牌且在一般的场景下(不包括雪天、雨天等恶劣条件)使用时,可以舍弃局部定位模块,从而进一步提高时效性。因此,本发明的复杂场景下的车牌检测识别方法还可以包括如下步骤:

115.步骤s1’:采集车辆视频流,并在视频流中提取图片数据;

116.步骤s2’:构建车辆局部定位模块,并将图片数据作为车辆局部定位模块的训练数据,得到车辆局部定位模型;

117.步骤s3’:构建车牌角点检测模块,并将车牌局部定位模块的输出作为车辆角点检测的训练数据,得到车牌角点检测模型;

118.步骤s4’:对视频流按照静止帧提取待检测的视频图像序列;

119.步骤s5’:将视频图片序列输入车牌角点检测模块,得到车牌角点信息和外接矩形框信息;

120.步骤s6’:根据得到的车牌角点信息和外接矩形信息进行图片矫正;

121.步骤s7’:构建车牌识别模块,将车牌图片作为车牌识别模型的训练数据,得到车牌识别模型;

122.步骤s8:将步骤s6’中的矫正的图片作为车牌识别模块输入,得到图片识别结果。

123.如图4所示,是本发明基于深度学习技术的复杂场景下的车牌检测识别系统框图,本发明的车牌检测识别系统1包括图片提取单元11、车辆局部定位单元12、车牌角点检测单元13、图片矫正单元14以及车牌识别单元15。

124.图片提取单元11,其采集车辆视频流,并在视频流中提取图片数据;

125.车辆局部定位单元12,其构建车辆局部定位模块,并将图片数据作为车辆局部定位模块的训练数据,得到车牌局部定位模型;

126.车牌角点检测单元13,其构建车牌角点检测模块,并将车牌局部定位模块的输出作为车辆角点检测的训练数据,得到车牌角点检测模型;

127.图片矫正单元14,其进行图片矫正;以及

128.车牌识别单元15,其构建车牌识别模块,将车牌图片作为车牌识别模型的训练数据,得到车牌识别模型,根据图片矫正单元所矫正的图片作为车牌识别模块输入,得到图片识别结果。

129.在图片矫正单元14中,包括:提取视频图像序列单元141、位置和颜色获取单元142、信息获取单元143以及矫正单元144。

130.提取视频图像序列单元141,其对视频流按照静止帧提取待检测的视频图像序列;

131.位置和颜色获取单元142,其将视频图片序列输入局部定位模块,得到带有车牌的车辆局部图片并输出局部图片的位置信息和车牌颜色信息;以及

132.信息获取单元143,其将局部定位模块的输出作为车牌角点检测模块的输入,得到车牌角点信息和外接矩形框信息;以及

133.矫正单元144,其根据得到的车牌角点信息和外接矩形信息进行图片矫正。

134.综上所述,本发明设计一种基于深度学习技术的复杂场景下的各种颜色车牌检测识别方法。此方法主要分为三个步骤进行检测识别,分别进行车牌局部定位、车牌角点检测和车牌字符识别。通过车牌局部定位模块,进行粗滤定位,并得到车牌颜色;通过车牌角点检测模块进行车牌精准定位,得到车牌的角点坐标;最后通过车牌识别模块对车牌字符进行识别。

135.本发明在通过局部定位模块,可以检测各种颜色的车牌,包括蓝色、绿色和黄色,使得发明可以广泛应用;通过精准定位模块得到角点并进行透视变换和霍夫变换,并进行车牌字符识别,通过两步定位模块并进行位置矫正,并进行识别,使得模型可以在任何复杂场景下进行高精度识别。本发明在模型中选择较小的网络框架并进行修改调优,并将车牌字符分割和车牌字符识别用同一模型同时输出,使得模型可以真正的完成实时的车牌检测识别,真正的实现落地应用。

136.本领域普通技术人员可以理解:附图只是一个实施例的示意图,附图中的模块或流程并不一定是实施本发明所必须的。

137.本领域普通技术人员可以理解:实施例中的装置中的模块可以按照实施例描述分布于实施例的装置中,也可以进行相应变化位于不同于本实施例的一个或多个装置中。上

述实施例的模块可以合并为一个模块,也可以进一步拆分成多个子模块。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。