1.本发明属于图像和视频处理技术领域,特别涉及一种基于图像外扩和美学引导的构图方法。

背景技术:

2.如今,随着数码相机的快速发展,手机上相机的性能日益强大。人们越来越习惯于记录生活中精彩时刻,并分享到社交媒体上。虽然摄影的硬件条件逐渐降低,但是摄影的技巧和方法依旧是必须的。对于业余用户,拍摄具有美感照片并非易事。专业摄影师会考虑他们想要表达的主题和整体场景构图,他们需要在拍摄前调整相机的焦距,光圈等参数。由于缺乏专业的摄影知识和技巧,大众在拍摄时难以一次拍摄出具有良好构图的照片。虽然用户可以使用图像编辑工具来对图像进行离线后处理,但是处理过程稍显繁琐。在过去的几十年中,研究人员提出了很多图像编辑的方法,其中图像裁剪技术已经成为当前最常用的方法。图像裁剪通过突显重要内容或删除不需要的场景来修改图像的构图。它在原图的范围内搜寻一个最佳的矩形框,只保留框中的内容。手动裁剪图像的工具已经被广泛使用,用户只需缩放,拖动矩形框到合适位置即可实现裁剪。研究人员将注意力转到更加智能的自动裁剪算法上,早期的方法主要依靠人工提取的特征来评价构图优劣。随着深度学习的快速发展,各种基于深度神经网络的方法也随之而来。尽管现有的图像裁剪方法在一定程度上取得了出色的结果,但是这些方法只能作为固定照片的后处理技术。这些算法假设拍摄的图像有多余的内容,并且可以通过去除冗杂部分来得到良好的构图。但当关键对象太靠近图像边界时,现有的裁剪方法就无能为力了。因此,最佳的裁剪框不应该局限于给定图像内部,算法需要跨越图像的边界以找到最佳的构图框。

技术实现要素:

3.本发明目的是为了克服现有技术的上述不足,提供一种基于图像内容外扩和美学引导的构图方法。

4.为了解决上述问题,算法需要考虑图像之外的内容。然而,在图像外部自动进行裁剪非常具有挑战性。这里有两个主要的问题需要解决:1.该算法应能够判断当前图像是否需要借助图像之外的内容,并且计算出需要外扩的长度。2.图像的外扩部分应与原图保持语义一致,并能够有效地在外扩后的图内搜索最佳构图。

5.本发明提出了一种基于图像内容外扩和美学引导的构图方法,该方法自动调整输入图像的视域,并在调整后的视域内寻找最符合美学原理的候选框,不仅可以在图像内部,而且可以在图像外部进行裁剪,从而有效地搜寻合理的构图。

6.具体包含以下步骤:

7.a.将原始图像输入到视域评估模块,评估原始图像的视域范围能否找到合适的构图,若否,则预测图像边界需要扩充多少;

8.b.将步骤a确定的待调整视域范围的图像输入到图像内容补全模块,补全调整视

域后未知区域的内容;

9.c.将调整视域后的图像输入到候选框选择模块,在保证候选框内图像生成质量的前提下,选择最符合美学原理的候选框。

10.本发明将图像外部未知的内容考虑到候选框的选择中,使得不仅可以在图像内部而且可以在图像外部进行裁剪。

11.为了实现上述技术方案,本发明建立了视域评估模块,图像内容补全模块,候选框选择模块。其中,视域评估模块由特征提取网络,超网络和评估网络三部分而成,超网络根据特征提取网络提取的特征,动态地生成评估网络的权重。图像内容补全模块由编码器和生成网络组成。候选框选择模块包括了候选框调整模块和美学得分预测模块。候选框调整模块调整预定义候选框的位置,将预定义的候选框往生成图像质量好的方向移动。美学得分预测模块根据候选框内的图像内容,给出相应的美学得分。在推理过程中,首先使用候选框调整模块调整预定义候选框的位置,再使用美学得分预测模块从调整后的候选框中选择美学得分最高的候选框作为最终结果。通过候选框调整模块和美学得分预测模块的相互制约,使得最终结果在图像质量和美学之间取得平衡。

12.本发明的优点和有益效果:

13.本发明方法通过允许候选框跨过图像边界,给予了候选框的选择更多的自由度,能很好的解决当显著性物体靠近图像边界时,现有方法无法获得好的构图的问题。实验表明,该模型选取的最佳构图,其效果超越了现有其他神经网络模型的构图能力。

附图说明

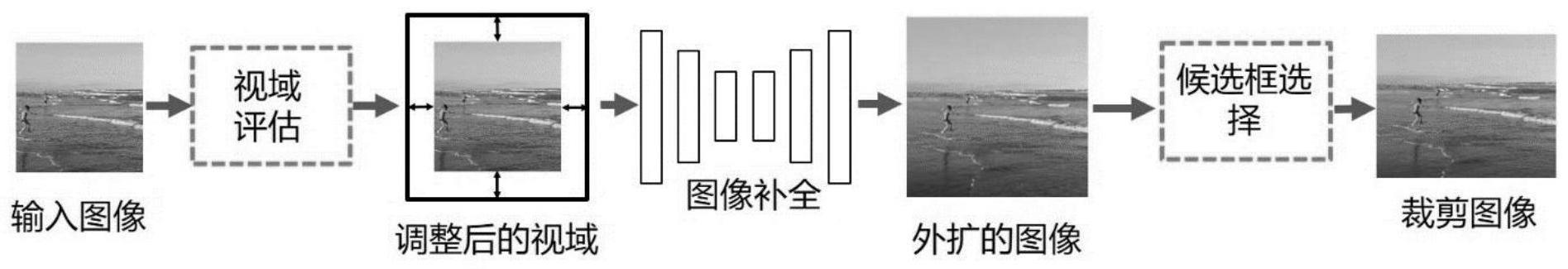

14.图1是本发明一个实施例中所提供的一种基于图像内容外扩和美学引导的神经网络构图方法的流程图;

15.图2是本发明一个实施例中所提供的一种基于图像内容的视域评估的流程图;

16.图3是本发明一个实施例中所提供的一种图像内容补全模块的流程图。

17.图4是本发明一个实施例中所提供的一种候选框选择模块的流程图。

18.图5为基于图像内容外扩和美学引导的神经网络构图算法与现有基于神经网络的构图方法的结果对比。其中(a)输入的图像,(b)gaic[3]方法的结果,(c)wsic[4]方法的结果,(d)vpn[5]方法的结果,(e)本方法的结果。

具体实施方式

[0019]

下面结合附图,对本发明的具体实施方式作进一步详细描述。以下实例用于说明本发明,但不用来限制本发明的范围。

[0020]

参照图1,表示整个基于图像内容外扩和美学引导的神经网络构图方法的流程图。首先,将原始图像输入到视域评估模块,评估原始图像的视域能否找到理想的构图,若否,则预测图像边界需要扩充多少。待调整视域范围的图像输入到图像内容补全模块,补全调整视域后未知区域的内容。最后,调整视域的图像输入到候选框选择模块,在保证候选框内图像生成质量的前提下,选择最符合美学原理的候选框。

[0021]

参照图2,输入原始图片,首先使用视域评估模块中的特征提取网络提取图片的语义特征,然后用超网络动态的生成评估网络的权重,最后使用评估网络计算原始图片是否

需要改变视域,若需要改变视域范围,则给出图像边缘外扩的比例。评估视域范围被视为五分类任务,外扩的比例分别为0%,12.5%,25%,37.5%和50%。外扩的比例0%为保持输入原始图片不变。需要外扩的图像内容被打上相应的蒙版,待后续图像内容补全模块补全。特征提取网络使用resnet50[1],超网络由三个1

×

1的卷积网络和四个权重生成分支组成,评估网络由四层全连接层组成。视域评估模块使用交叉熵作为损失函数进行训练,训练的标签来自于gaicd[3]数据集。

[0022]

参照图3,输入待调整视域范围的图像和相应的蒙版,使用一个编码器网络将其映射到stylegan的隐空间中,得到潜变量,然后再将潜变量输入到stylegan[2]中生成完整图像。图像内容补全模块采用对抗损失进行训练。x和分别是真值图像和生成图像。

[0023][0024]

其中,d表示为判别器,e表示为数学期望,表示为真值图像分布,表示为生成图像分布。除此之外,为了保证生成图像的质量,还使用了度量重建结果和原图之间差异的l1重建损失:

[0025][0026]

和感知损失:

[0027][0028]

其中φ

l

(

·

)表示为vgg

‑

19[6]网络的第l层的特征提取层,在本发明中l=4;‖

·

‖1为l1重建损失,‖

·

‖2为l2重建损失。

[0029]

图像内容补全模块的全部loss函数为:

[0030]

l

total

=λ

adv

l

adv

λ

rec

l

rec

λ

per

l

per

,

[0031]

其中λ

rec

=10,λ

adv

=0.02,λ

per

=1。

[0032]

参照图4,候选框选择模块包含两个分支,上面一个分支是候选框调整模块,预测每个候选框的偏移量,用于根据局部图像生成质量调整每个候选框的位置。下面一个分支为美学得分预测模块,用于预测每个候选框内图像内容的美学得分。在进行推理的时候,首先调整候选框的位置,保障候选框内图像的生成质量,然后从调整后的候选框中选择美学得分最高的候选框作为最理想的构图。候选框调整模块和美学得分预测模块共享特征提取部分的参数,候选框调整模块由三个全连接层组成,美学得分预测模块也由三个全连接层组成。美学得分预测模块采用huberloss分别对扩充后的图像和对应的真实图像进行训练。g

i,j

和p

i,j

分别是扩充图像的第j个候选框的真实美学得分和预测美学得分。p

i,j

是对应的真实图像r的第j个候选框。

[0033][0034]

huber loss如下:

[0035][0036]

候选框调整模块采用对抗损失最小化候选框内生成图像i

e

的分布v

e

和对应真实图

像i

r

的分布v

r

:

[0037][0038]

其中d表示为判别器,e表示为数学期望。

[0039]

候选框选择模块的全部loss函数为:

[0040]

l

total

=λ

hub

l

huh

λ

adv

l

adv

,

[0041]

其中λ

hub

=1,λ

adv

=0.1。

[0042]

参照图5,本发明所提方法与现有基于神经网络的构图算法的可视化比较,其中gaic[3],wsic[4]和vpn[5]都无法在显著性物体靠近图像边缘时获得好的构图。本发明设计的新的基于图像内容外扩和美学引导的构图方法可以有效地适当的将裁剪框移动到图像边界外,解决现有的方法只能从图像边界内选取理想构图的问题,从而取得更好的构图。

[0043]

参考文献:

[0044]

[1]he,kaiming,et al."deep residual learning for image recognition."proceedings of the ieee conference on computer vision and pattern recognition.2016.

[0045]

[2]karras,tero,samuli laine,and timo aila."a style

‑

based generator architecture for generative adversarial networks."proceedings of the ieee/cvf conference on computer vision and pattern recognition.2019.

[0046]

[3]zeng,hui,et al."reliable and efficient image cropping:a grid anchor based approach."proceedings of the ieee/cvf conference on computer vision and pattern recognition.2019.

[0047]

[4]lu,peng,et al."weakly supervised real

‑

time image cropping based on aesthetic distributions."proceedings of the 28th acm international conference on multimedia.2020.

[0048]

[5]wei,zijun,et al."good view hunting:learning photo composition from dense view pairs."proceedings of the ieee conference on computer vision and pattern recognition.2018.

[0049]

[6]karen simonyan,and andrew zisserman."very deep convolutional networks for large

‑

scale image recognition."in international conference on learning representations.2015

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。