1.本发明属于园林机械及人工智能领域,具体涉及一种用于智能割草机器人的环境感知方法及系统。

背景技术:

2.随着科技的不断发展,人力资源的不断上升,智能割草机器人市场也随之火热,但目前的智能割草机器人领域大多使用单一的传感器对外部环境或者自身状态进行感知,比如当前绝大多数较高级的智能割草机器人仅使用超声波传感器对外部障碍物进行检测,很难应对复杂的室外环境。

3.目前不少智能割草机器人使用预埋线等方式构建割草区域,再进一步,采用电子虚拟栅栏的方式构建区域,使用全球定位系统(global positioning system,gps)与惯性测量单元(inertial measurement unit imu)等进行自身位置的感知,但gps的的精度难以保证,imu的累计误差也可能导致割草机的路径出错。而在其他领域,有提出视觉和激光雷达的融合感知的方法,但激光雷达因为其成本等因素在智能割草机器人领域并不适用。而对于使用视觉传感器进行的环境感知,有研究者提出一种基于全景图像的智能割草机器人,通过构建全景地图来提高割草机器人的环境感知能力。此外也有提出使用相机和超声波来进行障碍物感知避障的方案。

4.但上述这些方案只能应对简单的环境,在复杂的室外环境下,视觉,超声波等诸传感器需要面对如:草地凹凸不平或树与建筑物阴影、乌云、阴天等因素导致的环境光线变化,这些因素会极大影响传感器的感知效果。此外运动的宠物、行走的成人、奔跑的孩童、桌椅用具等一系列动静态因素,会导致这些孤立的传感器很难提供足够的信息让处理器进行相应处理得到更好的感知效果,而且对于过多的环境参数决策系统很难综合处理。

技术实现要素:

5.为了克服上述智能割草机器人在复杂室外环境中面临的环境感知困难的问题,本发明提供一种用于智能割草机器人的环境感知方法及系统,通过多个传感器的融合感知,将感知到的环境分为不同的场景。有效的将复杂的环境信息转化为有限个不同的场景,以此作为决策系统的输入。

6.本发明提供一种用于智能割草机器人的环境感知方法,包括在智能割草机器人上安装相机、惯性测量单元imu、全球导航卫星系统gnss、里程计、水滴传感器、光敏传感器、超声波传感器,其中:

7.相机用于感知环境的语义信息和进行多目标检测;

8.超声波传感器用于低光照下相机从感知正常到无法感知这段时间的补充感知,通过决策级融合进行目标检测;

9.光敏传感器用于获取光照强度、根据光照强度来确定相机和超声波的融合感知权重,从而可以较好检测到各种光照环境下的目标;

10.水滴传感器用于判断环境下雨情况,与阈值做比较以此作为是否继续工作的感知参数;

11.imu、gnss、里程计用于融合定位实现边界判断;

12.具体包括以下步骤:

13.s1、智能割草机器人获取环境雨水情况,与设定的阈值比较并判断是否继续工作;

14.s2、智能割草机器人获取环境光强并采用相机和超声波模块进行融合实现环境感知与目标检测和跟踪;

15.s3、智能割草机器人通过基于卡尔曼滤波的融合定位算法获取当前自身高精度位置信息;

16.s4、通过步骤2和步骤3获取的信息进行场景判断;

17.s5、以对应的场景信息作为决策系统的输入进行决策。

18.进一步,所述步骤s2具体包括:

19.s21:获取光敏传感器的数据得到光照强度p;

20.s22:将p与设定的光照强度阈值w进行比较;

21.s23:若p》w,将使用相机进行目标检测与跟踪,以实现环境多目标的检测及语义信息的提取,并和事先构建好的语义地图比较从而进行下一步决策;

22.s24:若p《w,表明环境光强低,相机不能有效获取语义等环境信息,在相机完全失效前存在一段过渡期,此时使用相机和超声波进行融合的目标检测,在对两者的识别结果根据p的大小分配不同的权重进行决策级融合,以实现障碍物的识别;

23.s25:输出融合后的结果,实现目标检测与跟踪。

24.具体的融合结果m可以由公式(1)表示:

25.m=f1(p)x1 f2(p)x2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

26.其中x1表示相机的目标检测结果f1(p)表示相机目标检测结果关于光照强度p变化的权重值,x2表示超声波的目标检测结果f2(p)表示超声波目标检测结果关于光照强度p变化的权重值。

27.进一步的,相机和超声波进行目标检测时需要进行联合标定,实现两者的空间和时间同步。

28.进一步,所述步骤s3包括:

29.获取gnss的数据对数据进行预处理,获取imu数据并处理,当处于非初始时刻时,根据卡尔曼更新的反馈对imu进行误差补偿。获取里程计数据并对其进行处理。

30.其中卡尔曼滤波器的状态和测量模型x

′

和z可以分别描述为

31.x

′

=ax w

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

32.z=hx ν

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

33.x表示gnss、imu、里程计三者的状态参数向量,a表示对应的状态转移矩阵,是对目标状态转换的一种猜想模型,w是对应的系统误差,z表示测量观测向量,h表示状态参数到观测参数的转换矩阵,v表示的是观测误差。

34.再对其进行卡尔曼滤波步骤,包括预测和更新两部分,

[0035][0036]

p

k|k-1

=ap

k-1|k-1at

qkꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0037][0038][0039]

p

k|k

=[i-k

khk

]p

k|k-1

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(8)

[0040]

上述式子中,公式(4)表示状态一步预测,公式(5)表示状态一步预测均方误差,公式(6)表示滤波增益,公式(7)表示状态估计,公式(8)表示状态估计协方差;其中表示k-1时刻的状态预测,表示k-1时刻的状态估计,p

k|k-1

是k-1时刻的协方差预测,kk是k时刻的增益,和p

k|k

分别对应k时刻的状态更新和协方差更新,qk是过程激励噪声协方差(系统过程的协方差),表示状态转换矩阵与实际过程之间的误差,rk是量测的协方差,一般可以观测得到,是滤波器的已知条件。

[0041]

进一步,所述步骤s4具体包括:

[0042]

根据步骤s1、步骤s2、步骤s3获取的环境亮度、地图边界、环境障碍物的信息,将环境分为三个层次的场景集合l1、l2、l3。l1包括低亮度场景和常规亮度场景,l2包括边界场景和非边界场景,l3包括无障碍物场景,简单障碍物场景,和多动态障碍物场景。

[0043]

进一步的,所述的三个层次的场景集合的优先级和影响范围l1》l2》l3,即l1场景优先进行判断,并且l1场景会影响l2场景集合,l2场景影响l3场景集合。为了更好理解这里用个例子进行说明,假设l1包含l11和l12两个场景,l2包含l21和l22两个场景,经过感知首先判断出所处环境是l11场景,这时再根据l11场景对应的决策对l2场景进行感知判断若感知为l21场景,则在l11场景对应的决策下进行l21的决策。

[0044]

进一步的对于地图边界包含地图外围边界和内部区域边界如树木、花坛、房屋等不可人为移动的障碍物边界,即构建地图时的边界。其识别过程包括使用相机与先验的语义地图进行判断和使用融合定位的信息和构建的地图进行边界判断。

[0045]

进一步的对于l3场景的区分,根据步骤s2获取的目标信息,将静态目标数量设为ns,动态目标数量设为nd,将ns,nd与设定的对应阈值做比较实现l3障碍物场景的区分。

[0046]

一种用于智能割草机器人的环境感知系统,包括:环境感知模块、位置定位模块、数据分析模块、数据记录模块、数据传输模块;

[0047]

环境感知模块用于获取智能割草机器人周围的环境数据,包括,降雨情况、光照强度数据、语义信息、障碍物信息等;

[0048]

位置定位模块获取智能割草机器人的高精度定位信息,包括里程计信息、imu信息、gnss信息;

[0049]

数据分析模块用于智能割草机器人周围复杂环境的场景识别得到当前场景判断的结果,同时建立基于规则的决策输出信息;

[0050]

数据记录模块,用于对传感器数据以及分析结果初始化信息进行记录;

[0051]

数据传输模块,用于将分析所得数据和记录数据传输到主控制器,包括降雨情况、光照强度数据、语义信息、障碍物信息、里程计信息、imu信息、gnss信息、场景判断信息。

[0052]

与现有技术相比,本发明具有以下优点:

[0053]

1、传统的智能割草机器人不具备复杂环境的融合感知功能,本发明充分利用智能割草机器人搭载的相机、超声波、水滴传感器、光敏传感器、imu、gnss、里程计等传感器进行

信息融合,提高了对环境的感知能力。

[0054]

2、本发明基于光敏传感器测得的数据对相机和超声波的检测结果进行加权融合,提高低光照下的障碍物感知能力。

[0055]

3、本发明设计的基于卡尔曼的自适应融合方法,保证数据的正确加权提高了定位的精准度

[0056]

4、本发明根据获得的传感器数据将复杂的环境分为三个层次,细分复杂的环境,与繁多的传感器数据相比可以更为简洁清晰的作为决策系统的输入。

附图说明

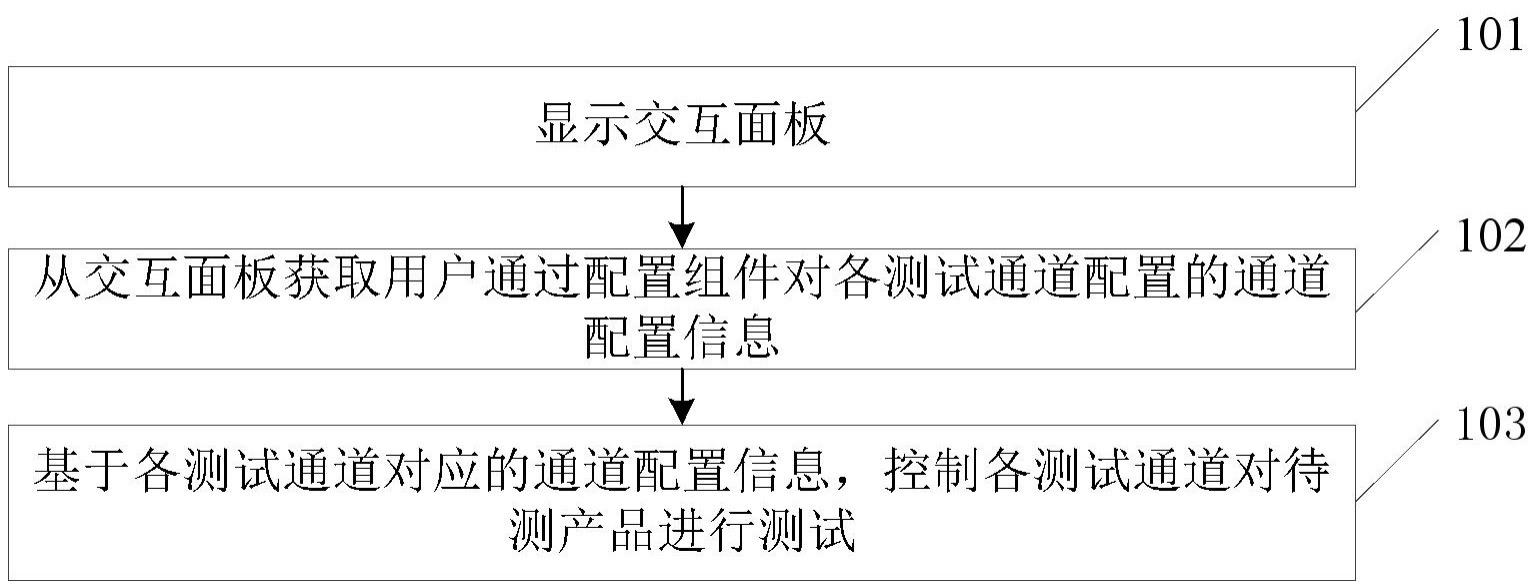

[0057]

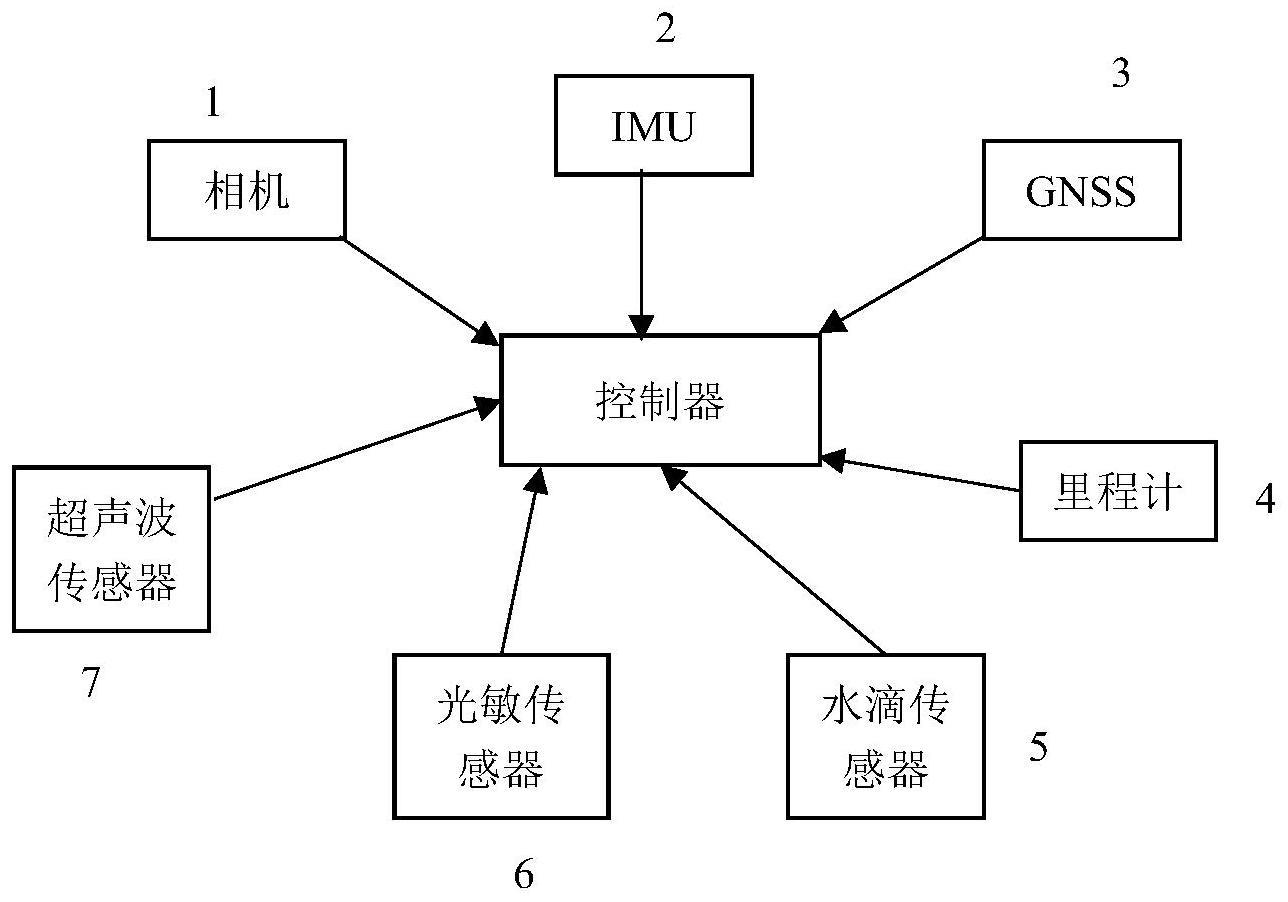

附图1为本发明实施例一所述一种用于智能割草机器人的环境感知方法所使用的装置的结构示意图;

[0058]

附图2为本发明实施例一所述的一种用于智能割草机器人的环境感知方法的多传感器环境状态感知原理示意图;

[0059]

附图3为本发明实施例一所述的一种用于智能割草机器人的环境感知方法的自身状态感知示意图;

[0060]

附图4为本发明实施例一所述提供的一种用于智能割草机器人的环境感知方法的多场景分级感知流程图;

[0061]

附图5为所述附图2中相机与超声波融合感知流程图;

[0062]

附图6为所述附图3中gnss、imu及里程计融合定位流程图;

[0063]

附图7为本发明实施例二提供的一种用于智能割草机器人的环境感知系统的结构示意图;

[0064]

附图8为本发明实施例三提供的一种用于智能割草机器人的环境感知系统的结构示意图;

具体实施方式

[0065]

为使本发明的技术方案更加清楚,以下将结合具体实施例对本发明提供的技术方案进行详细说明,结合附图对本发明做进一步阐述。可以理解的是,此处所描述的具体实施例仅是本发明的部分实施例,用于对本发明进行解释,而非对本发明的限定。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护范围。

[0066]

实施例一

[0067]

附图1为本发明实施例一所述一种用于智能割草机器人的环境感知方法及系统的装置的结构示意图,包括相机单元1、imu单元2、gnss单元3、里程计单元4、水滴传感器单元5、光敏传感器单元6、超声波传感器单元7与控制器。

[0068]

其中:

[0069]

相机用于感知环境的语义信息和进行多目标检测;

[0070]

超声波传感器用于低光照下相机从感知正常到无法感知这段时间的补充感知,通过决策级融合进行目标检测;

[0071]

光敏传感器用于获取光照强度、根据光照强度来确定相机和超声波的融合感知权

重,从而可以较好检测到各种光照环境下的目标;

[0072]

水滴传感器用于判断环境下雨情况,与阈值做比较以此作为是否继续工作的感知参数;

[0073]

imu、gnss、里程计用于融合定位实现边界判断;

[0074]

本实施例可适用于复杂割草机工作环境的感知,与通常的智能割草机任何环境都使用一套感知方案不同,该方法将复杂的环境中多个传感器获取的信息进行融合,将环境分为三个层次的场景集合如附图4所示,从而将复杂环境细分成有限多个场景以此作为决策系统的输入。其中环境感知主要分为两个部分:1、附图2所示的外部环境感知;2、附图3所示的自身状态感知。

[0075]

整体方案包括以下步骤:

[0076]

s110、智能割草机器人通过水滴传感器获取数据并处理得到当前时刻的降雨值。并将其与设定的阈值比较判断割草机是执行继续工作及环境感知决策还是执行返回充电站决策;

[0077]

s120、智能割草机器人获取环境光照强度进行l1层次的场景判断,判断当前场景是否满足附图4所示的常规亮度场景,如果符合,就执行对应决策并采取单一的相机感知的决策以此进行l2边界场景、l3场景周围环境的语义信息和障碍物信息感知与决策;如果符合的是低亮度环境场景,则采用相机和超声波模块进行融合实现环境感知与目标检测以此进行l2、l3感知与决策;需要注意的是,在相机和超声波进行环境检测工作前已经对相机和超声波进行联合标定,实现两者的空间和时间同步,这样才能使两者检测到的目标信息进行对应,提高低光照下超声波检测的目标结果对相机的检测结果进行补偿。整体流程如附图2与图5所示。

[0078]

s121、获取光敏传感器的数据得到光照强度p;

[0079]

s122、将p与设定的光照强度阈值w进行比较;

[0080]

s123、若p》w,将使用相机进行目标检测与跟踪;

[0081]

s124、若p《w,则使用相机和超声波进行目标检测,在对两者的结果根据p的大小分配不同的权重进行融合;

[0082]

s125、输出融合后的结果,实现目标检测与跟踪。

[0083]

具体的融合检测结果m可以由公式(1)表示:

[0084]

m=f1(p)x1 f2(p)x2ꢀꢀꢀꢀꢀꢀꢀ

(1)

[0085]

其中x1表示相机的目标检测结果f1(p)表示相机目标检测结果关于光照强度p变化的权重值,x2表示超声波的目标检测结果f2(p)表示超声波目标检测结果关于光照强度p变化的权重值。

[0086]

s130、智能割草机器人通过获取gnss、imu和里程计的数据信息进行相关预处理,接着基于卡尔曼滤波的融合定位算法获取当前自身高精度位置信息,根据卡尔曼更新的反馈对imu进行误差补偿。附图3描述的是自身位置融合感知的流程,附图6展示的是图3描述的融合定位的具体流程图。

[0087]

s131、系统的状态和测量模型可以分别描述为

[0088]

x

′

=ax w

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0089]

z=hx ν

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0090]

x表示gnss、imu、里程计三者的状态参数向量,a表示对应的状态转移矩阵,是对目标状态转换的一种猜想模型,w是对应的系统误差,z表示测量观测向量,h表示状态参数到观测参数的转换矩阵,ν表示的是观测误差。其中

[0091][0092]

x=merge(x

imu

,x

里程计

,x

gnss

)

ꢀꢀꢀꢀꢀꢀꢀꢀ

(10)

[0093][0094]

w是对应的误差集合,x表示x

imu

,x

里程计

,x

gnss

三者参数的合并,z

gnss

和z

里程计

表示gnss和里程计的观测参数,h

gnss

和h

里程计

表示gnss和里程计对应状态参数到观测参数的转换矩阵。v

gnss

和v

里程计

是各自的观测误差。

[0095]

表示从惯性传感器框架坐标系到地心地固坐标系坐标系的转换矩阵,ωaωg表示的是噪声,上标t表示矩阵的转置。a是状态转移矩阵,如下所示:

[0096][0097]

这里的

×

符号表示斜对称矩阵,即如果有v

×

则表示它是v的斜对称矩阵,e表示单位阵,下标e表示地心地固坐标系,i下标表示惯性系,是地心地固坐标系相对于投影在惯性系的旋转角速率矢量,fb是惯性传感器框架中加速度计输出的比力

[0098]

merge(.)表示统一通用参数并组合变量中不同参数的运算符,其中x

imu

,x

里程计

,x

gnss

分别表示对应的估计参数,具体如下

[0099][0100][0101]

x

里程计

=[δs]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(15)

[0102]

上述参数中bg、ba、δs和δg分别为带有驱动噪声ωg、ωa、εs和ε

δg

的随机行走过程,δtr,δz

wet

建模为白噪声,δn设为常数,利用大气校正后δz

wet

和δi的初始值被设置为零。更为具体的说明:前缀符号δ表示后续参数的校正,φ描述了地心地固坐标系到实际中惯性传感器的坐标系之间的未对准误差矢量。δνe,δre分别表示e即地心地固坐标系下的速度和位置误差矢量,bg,ba分别是imu内的陀螺仪和加速度计的偏置。tr表示接收机时钟偏移,g描述的是多种gnss系统之间如伽利略卫星定位系统、北斗定位系统和gps之间的时钟偏差,i表示电离层在第一频率上的传播延迟,z

wet

表示对流层湿延迟,n表示整数载波相位模糊度。为了对s进行描述,首先对于智能割草机的速度测量进行如公式(16)描述。

[0103][0104]

这里公式(16)其实描述的就是里程计的观测方程,表示从传感器坐标系到车辆

坐标系的转换矩阵,是传感器坐标系下通过imu获取的速度参数,是传感器坐标系相对于投影在此的地心地固坐标系的旋转角速率矢量,表示传感器坐标系中里程表中心的杆臂矢量。是里程计在割草机体坐标系下获得的速度量测值,εv表示观测误差,而s表示智能割草机速度测量中的比例因子。

[0105]zgnss

表示gnss的观测信息,h

gnss

表示gnss状态参数对应的转换矩阵,v

gnss

表示gnss观测的观测误差。由于卫星定位是由多个卫星进行的,所以z

gnss

=(z

gnss1

、z

gnss2

、

···

、z

gnssi

),i表示gnss的数量,同理h

gnss

和v

gnss

也由此结构组成,其中对于第i个gnss的信息表示如下:

[0106][0107][0108][0109]

其中表示伪距和载波相位观测值,表示从接收器到卫星的单位向量的方向余弦,表示接收器天线相位中心相对于地心地固坐标系中imu中心的杠杆臂矢量,γi是与频率相关的系数,是与z

gnssi

相关的系数,ai=[0 1 0],是对应的观测误差。

[0110]

s132、对其进行卡尔曼滤波步骤,包括预测和更新两部分

[0111]

执行状态估计和估计误差协方差的时间更新:

[0112][0113]

p

k|k-1

=ap

k-1|k-1at

qkꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0114]

然后执行状态估计和估计误差协方差的测量更新:

[0115][0116][0117]

p

k|k

=[i-k

khk

]p

k|k-1

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(8)

[0118]

上述式子中,公式(4)表示状态一步预测,公式(5)表示状态一步预测均方误差,公式(6)表示滤波增益,公式(7)表示状态估计,公式(8)表示状态估计协方差;其中表示k-1时刻的状态预测,表示k-1时刻的状态估计,p

k|k-1

是k-1时刻的协方差预测,kk是k时刻的增益,和p

k|k

分别对应k时刻的状态更新和协方差更新,qk是过程激励噪声协方差(系统过程的协方差),表示状态转换矩阵与实际过程之间的误差,rk是量测的协方差,一般可以观测得到,是滤波器的已知条件。

[0119]

s140、附图4是从整体场景划分出发,包括了三个层次的场景集合,其中l1场景包括l2场景集合,l2场景包括l3场景集合,三个层次的场景影响范围l1》l2》l3,首先检测光照强度信息作为输入,得到当前l1层次的具体场景,假设检测到的场景为常规亮度场景,则采用此场景的决策,并采用纯视觉的检测方法来检测周围环境的语义信息和障碍物目标;然

后开始l2边界场景检测,以先前的语义信息和融合定位获取的高精度定位信息作为场景检测的输入,得到当前是否为边界场景,假设检测到的是非边界场景,则执行对应的非边界场景的决策。最后进行l3场景的判断,以视觉获取的目标检测信息和语义信息作为输入,将检测到的动态和静态的障碍物信息与设定好的阈值作比较进行判断,假设判断为多动态障碍物场景,则执行对应的多动态障碍物场景决策。

[0120]

上述过程中对于地图边界的定义,这里的场景边界包含地图外围边界和内部区域边界如树木、花坛、房屋等不可人为移动的障碍物边界,即构建地图时的边界。其识别过程包括使用相机和先验的语义地图进行判断与获得的融合定位的信息和构建的地图进行判断。

[0121]

实施例二

[0122]

参照图7,本发明实施例二提供的一种用于智能割草机器人的环境感知系统,包括:环境感知模块、位置定位模块、数据分析模块、数据记录模块、数据传输模块。

[0123]

环境感知模块用于获取智能割草机器人周围的环境数据,包括,降雨情况、光照强度数据、语义信息、障碍物信息等;

[0124]

位置定位模块获取智能割草机器人的高精度定位信息,包括里程计信息、imu信息、gnss信息;

[0125]

数据分析模块用于智能割草机器人周围复杂环境的场景识别,建立基于规则的决策输出信息,同时得到当前场景判断的结果;

[0126]

数据记录模块,用于对传感器数据以及分析结果初始化信息进行记录;

[0127]

数据传输模块,用于将分析所得数据和记录数据传输到主控制器,包括降雨情况、光照强度数据、语义信息、障碍物信息、里程计信息、imu信息、gnss信息、场景判断信息。

[0128]

在上述各技术方案的基础上,该装置还包括:噪声数据处理模块,用于将环境引起的具有噪声的传感器数据进行去噪。

[0129]

实施例三

[0130]

参照图8,本发明实施例三提供的一种用于智能割草机器人的环境感知系统,包括:环境感知设备、位置定位设备、数据分析设备、通信设备、主控制系统。

[0131]

其中,所述环境感知设备用于获取智能割草机器人周围的环境数据,包括,降雨情况、光照强度数据、语义信息、障碍物信息等;通过对数据的误差处理,特征提取分析处理得到判断场景类别的信息。

[0132]

所述位置定位设备获取智能割草机器人的高精度定位信息,包括里程计信息、imu信息、gnss信息;将数据进行处理,并进行卡尔曼滤波融合得到高精度的定位信息。

[0133]

所述数据分析设备用于智能割草机器人周围复杂环境的场景识别,根据输入的场景判断参数进行场景的判断得到当前场景判断的结果,同时建立基于规则的决策输出信息;

[0134]

所述通信设备,用于各设备间的数据传输与通信,实现信息同步与实时更新,集成多种通信方式和通信协议以满足不同场景的需求,同时保障通信过程中数据的保密性和完整性,避免信息泄露。

[0135]

需要注意的是,在上述多用于智能割草机器人的环境感知装置的实施例中,所包括的各个模块只是按照功能逻辑进行划分的,并不局限于上述的划分,只要能够实现相应

的功能即可;另外,各功能单元的具体名称也只是为了便于相互区分,并不用于限制本发明的保护范围。

[0136]

最后,上述仅为本发明的较佳实施例及所运用技术原理。本领域技术人员会理解,本发明不限于这里所述的特定实施例,对本领域技术人员来说能够进行各种明显的变化、重新调整和替代而不会脱离本发明的保护范围。因此,虽然通过以上实施例对本发明进行了较为详细的说明,但是本发明不仅仅限于以上实施例,在不脱离本发明构思的情况下,还可以包括更多其他等效实施例,而本发明的范围由所附的权利要求范围决定。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。