用于机器学习的设备、计算机程序和计算机实现方法

背景技术:

1.本发明涉及用于机器学习的设备、计算机程序和计算机实现方法。

2.a pac-bayesian bound for lifelong learning,anastasia pentina,christoph h. lampert,arxiv:1311.2838公开了用于机器学习的终身学习设置的方面。

技术实现要素:

3.根据独立权利要求的计算机实现方法、设备和计算机程序提供了改进的机器学习,特别是基于用于训练终身学习系统的目标函数的改进的机器学习。

4.一种用于机器学习的计算机实现方法包括:提供包括多臂老虎机(multi-armed bandit)问题或上下文老虎机(contextual bandit)问题的动作空间和以动作为条件的奖励上的分布的任务;提供超先验,其中该超先验是动作空间上的分布;取决于该超先验来确定超后验,针对该超后验,当使用从该超后验采样的先验时关于未来老虎机任务的期望奖励(expected reward)的下界限(lower bound)具有尽可能大的值,并且其中该超后验是动作空间上的分布。这意味着,任务要么是多臂老虎机问题、要么是上下文老虎机问题。该下界限是pac-贝叶斯泛化界限(generalisation bound),该界限形成了当使用从超后验采样的先验时关于未来老虎机任务的期望奖励的下界限。该下界限被用作用于终身学习的目标函数,其中在观察了任务之后,该超后验被更新,使得它近似地使该下界限最大化。该下界限包含可观察的量,并且因此可以使用来自所观察的任务的训练数据来计算。以这种方式,来自一组所观察的多臂老虎机或上下文老虎机任务的先验知识被转移(transfer)到新的多臂老虎机或上下文老虎机任务。

5.确定超后验可以包括:确定使期望奖励的下界限最大化的超后验。使下界限最大化的超后验被期望将高概率指派给产生关于未来任务的低误差的先验。

6.该方法可以用于将来自一组所观察的多臂老虎机或上下文老虎机任务的先验知识转移到新的多臂老虎机或上下文老虎机任务。许多问题可以要么被表示为多臂老虎机问题、要么被表示为上下文老虎机问题。因此,该方法可以用于将先验知识转移到许多类型的任务。

7.该方法可以包括:取决于从超后验采样的先验来处理传感器数据、特别是数字图像数据或音频数据,以特别地用于对传感器数据进行分类、检测传感器数据中的对象的存在、或者对传感器数据执行语义分割;或者确定机器学习的鲁棒性的度量、特别是当从超后验采样先验时关于下一个任务的期望误差不高于预定值的概率;或者取决于从超后验采样的先验来检测传感器数据中的异常;或者学习用于控制物理系统的策略,并且取决于从超后验采样的先验来确定用于控制物理系统的控制信号。因此,该方法用于将先验知识转移到新的问题、特别是新的分类问题、新的鲁棒性问题、新的异常检测问题和/或新的控制问题。

8.下界限也是机器学习的鲁棒性的度量。超后验还提供了当先验从超后验被采样时关于下一个任务的期望误差的信息。例如,当先验从某个超后验被采样时,期望误差不高于

某个值。

9.该方法可以包括在多个迭代中确定超后验,并且从先前迭代的超后验来采样迭代的先验。因此,在机器学习的迭代中,先验知识是从较早的迭代被转移的。

10.该方法可以包括:从任务上的分布来采样该迭代的任务。处理特别大量的不同任务改进了机器学习的结果。

11.该方法优选地包括:利用超先验来初始化超后验。任何可用的超先验是用于机器学习的良好起始点。

12.该方法可以包括:利用先验来初始化后验;从任务的行为策略集合中确定与任务后验相关联的行为策略,其中该行为策略包括具有概率质量的动作上的分布;从该概率质量来随机地采样或选择动作;取决于该动作从奖励上的分布来采样奖励;确定包括该动作和该奖励的任务数据集;更新任务后验以包括该任务数据集。这为多臂老虎机或上下文老虎机任务提供了非常高效的机器学习,其中所创建的后验将该任务数据集保存为先前迭代的知识。

13.提供任务优选地包括提供包括状态空间以及初始状态上的分布的任务,其中该方法进一步包括从初始状态上的分布来随机地采样或选择初始状态,并且其中奖励上的分布以状态空间的状态和动作为条件。这为上下文老虎机任务提供了非常高效的机器学习。

14.该方法可以包括:利用空集来初始化该任务数据集,并且然后在预定轮数(number of rounds)中更新任务后验。因此,下界限是从来自所观察的任务的训练数据被计算的。

15.确定超后验可以包括:取决于超后验和超先验的kullback-leibler散度来确定下界限。当先验被优化为在所观察的任务上与它在新任务上一样有效时,提供了改进的机器学习的目标。超后验和超先验的kullback-leibler散度提供了从来自所观察的任务的训练数据来确定下界限的良好方法。

16.一种用于机器学习的设备,其特征在于,该设备被配置用于执行根据权利要求1至9中的一项的方法中的步骤。

17.一种计算机程序,其特征在于,该计算机程序包括计算机可读指令,该计算机可读指令当在计算机上被执行时使得计算机执行根据权利要求1至9中的一项的方法。

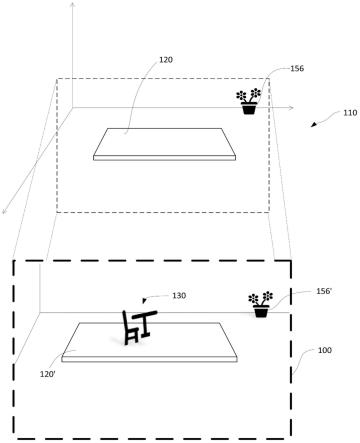

18.进一步的有利实施例是从以下描述和附图中可得出的。在附图中:图1示意性地描绘了用于机器学习的设备的一部分,图2描绘了用于机器学习的方法中的步骤。

19.图1示意性地描绘了用于机器学习的设备100的一部分。设备100包括至少一个处理器102和至少一个存储装置104。该至少一个存储装置104可以存储包括计算机可读指令的计算机程序,该计算机可读指令当在计算机上被执行使得计算机执行将在下面参考图2描述的方法。设备100被配置用于执行该方法中的步骤,特别是当至少一个处理器102执行计算机程序的指令时。

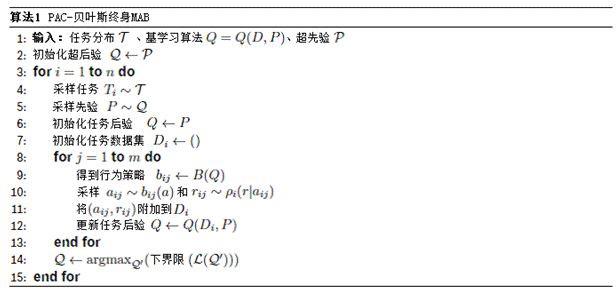

20.该示例中的机器学习的方法使用基学习算法(base learning algorithm)q=q(d,p),并且从步骤200开始。基学习算法返回后验分布q。由于基学习算法使用数据集d和先验p,所以后验在本描述中被写为q(d, p)以使得对d和p的依赖性是清楚的。

21.在步骤200中,该方法包括:提供任务ti。

22.任务ti可以是被表示为一对(couple)的多臂老虎机问题的任务,其包

括多臂老虎机问题的动作空间a(即,一组动作a)、以及以动作a为条件的奖励r上的分布。

23.任务ti可以是被表示为四元组(quadruple)的上下文老虎机问题的任务,其包括动作空间a(即,一组动作a)和状态空间s、以及以动作a和状态s为条件的奖励r上的分布、以及上下文老虎机问题的初始状态上的分布。

24.假定奖励r在0和1之间,并且假定任务ti是从环境t被独立同分布地(i.i.d.)采样的。

25.之后,执行步骤202。

26.在步骤202中,该方法包括:提供超先验。

27.超先验是一组可能的先验分布上的分布。每个先验分布是动作空间a上的分布。

28.之后,执行步骤204。

29.在步骤204中,该方法包括:利用超先验来初始化超后验。超后验是先验分布上的另一个分布。

30.之后,执行步骤206。

31.在步骤206中,该方法包括:从任务t上的分布t来采样迭代i的任务ti。

32.与任务ti相关联的是任务ti的行为策略集合,其包括mi个行为策略。

33.对于多臂老虎机问题,行为策略b

ij

包括具有概率质量b

ij

(a)的动作a上的分布。在该示例中,行为策略b

ij

是动作a上的分布,该分布在迭代i中取决于先前所观察的训练数据其中,对于多臂老虎机任务训练数据集的元素在多臂老虎机任务中分布如下:。

34.对于上下文老虎机问题,行为策略b

ij

包括具有概率质量的以状态s为条件的动作a上的分布。在该示例中,行为策略b

ij

是动作a上的分布,该分布在迭代i中取决于先前所观察的训练数据训练数据集的元素在上下文老虎机任务中分布如下:。

35.之后,执行步骤208。

36.在步骤208中,该方法包括:从先前迭代i-1的超后验来采样迭代i的先验p。

37.之后,执行步骤210。

38.在步骤210中,该方法包括:利用先验p来初始化后验q。

39.之后,执行步骤212。

40.在步骤212中,该方法包括:利用空集来初始化数据集di。

41.之后,执行步骤214。

42.在步骤214中,该方法包括:从任务ti的行为策略集合b

ij

中确定与任务后验q相关联的行为策略b

ij

。

43.之后,执行步骤216。

44.在步骤216中,该方法包括:从行为策略b

ij

的概率质量来随机地采样或选择动作a

ij

。

45.之后,执行步骤218。

46.在步骤218中,该方法包括:针对多臂老虎机问题,取决于动作a

ij

从奖励r上的分布来采样奖励r

ij

。

47.在步骤218中,该方法包括:针对上下文老虎机问题,从初始状态上的分布来随机地采样或选择初始状态s

ij

,并且取决于动作a

ij

从奖励r上的分布来采样奖励r

ij

,奖励r上的分布以状态空间s的状态s和动作a为条件。

48.之后,执行步骤220。

49.在步骤220中,该方法包括:确定包括动作aij和奖励rij的数据集di。

50.数据集di是训练集,对于多臂老虎机问题,它包括mi个可观察的训练数据对:数据集di是训练集,对于上下文老虎机问题,它包括mi个可观察的训练数据三元组:。

51.之后,执行步骤222。

52.在步骤222中,该方法包括:更新后验q以包括数据集di。

53.为此,确定性基学习算法将数据集di和先验p作为输入,并且产生后验q = q(di; p)。

54.任务ti的目标是找到使期望奖励最大化的后验q。多臂老虎机问题的期望奖励是:其中e是期望值。

55.使用数据集di,期望奖励在多臂老虎机问题的示例中被估计为:i{a

ij

=a}是指示器函数,如果a

ij

=a,则它返回1,否则返回0。上下文老虎机问题的

期望奖励是:其中e是相应的期望值,并且其中先验p和后验q是策略的空间上的分布,其中是以状态s为条件的动作a上的分布π(a|s)。

56.使用数据集di,期望奖励在上下文老虎机问题的示例中被估计为:在该示例中,该方法包括在预定轮数m中更新后验q。这意味着,该方法继续步骤214达m轮。

57.之后,执行步骤224。

58.在步骤224中,该方法包括:取决于超先验来确定超后验,针对该超后验,当使用从该超后验采样的先验p时关于未来老虎机任务的期望奖励l的下界限具有尽可能大的值。

59.在该示例中,确定超后验包括确定使期望奖励l的下界限最大化的超后验。

60.在该示例中,多臂老虎机问题的函数下界限是以下目标函数中的一个:是以下目标函数中的一个:是以下目标函数中的一个:是以下目标函数中的一个:是以下目标函数中的一个:

其中,β1和β1是常数,0≤β1,β2≤1,其中并且其中0《δ≤1是置信度参数,因此对于多臂老虎机问题,以下不等式均在训练数据d1...dn和后验q1...qn上以概率1

−

δ成立:δ成立:其中qn表示动作a1...an上的联合分布,其中ai~qi,并且其中pn表示动作a1...an上

的联合分布,其中ai~pi,并且其中并且,并且其中其中,其中mi是用于任务i的训练集样本的数量。

61.对于上下文老虎机问题,可以通过用代替li以及用代替来应用这些目标函数,其中qi和pi是策略πi而不是动作ai上的分布,并且让,其中π

max

是针对任何策略π和任何动作状态的最大可能概率质量。

62.当使用配备有先验的基学习算法q(d

n 1

; p)时,超后验的性能例如通过边际转移奖励(marginal transfer reward)来测量,该边际转移奖励是关于新任务t

n 1

的期望奖励。

63.对于多臂老虎机问题,边际转移奖励是:对于上下文老虎机问题,边际转移奖励是:利用上述函数,该方法不是最大化边际转移奖励,而是最大化关于边际转移奖励的pac-贝叶斯下界限。界限中的一些包含二元kullback-leibler kl散度的逆(inverse)。

64.这意味着,确定超后验包括取决于超后验和超先验的kullback-leibler散度来确定和逼近期望奖励l。

65.在该示例中,超后验是在数量n个迭代i中被确定的。

66.这意味着,该方法继续步骤206达n个迭代。之后,可选地,执行步骤226。

67.在步骤226中,该方法在该示例中包括:取决于从超后验采样的先验来处理传感器数据、特别是数字图像数据或音频数据。传感器可以是麦克风、视频、雷达、激光雷达、超声、运动、热成像或声纳传感器。

68.传感器数据例如被处理以用于对传感器数据进行分类、检测传感器数据中的对象的存在、或者对传感器数据执行语义分割。传感器数据分类例如被框定(frame)为上下文老虎机问题。可以例如关于交通标志、道路表面、行人、车辆的存在或不存在、或类型对图像进行分类。

69.取而代之或者附加地,步骤226可以包括:学习用于控制物理系统的策略,并且取决于从超后验采样的先验来确定用于控制物理系统的控制信号。

70.举例来说,当从超后验采样先验时,可以确定关于下一个任务的期望误差不高于预定值的概率。

71.取而代之或者附加地,步骤226可以包括:确定机器学习的鲁棒性的度量。在该示例中,对于从超后验采样的先验,鲁棒性的度量是期望误差。

72.例如当期望误差小于阈值时,可以使用先验来处理传感器数据,否则,可以采样另一个先验以用于处理传感器数据或确定控制信号。

73.取而代之或者附加地,步骤226可以包括:取决于从超后验采样的先验来检测传感器数据中的异常。在这方面,异常检测问题被框定为多臂老虎机问题。

74.之后,该方法在该示例中结束。

75.下面提供了在用于多臂老虎机问题的机器学习的方法中由计算机采取的步骤的示例:

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。