1.本公开整体涉及外科机器人领域,并且更具体地涉及远程外科指导。

背景技术:

2.微创外科手术(mis)诸如腹腔镜手术涉及旨在在外科规程期间减少组织损伤的技术。例如,腹腔镜规程通常涉及在患者体内(例如,在腹部)形成多个小切口,以及通过切口将一个或多个工具和至少一个内窥镜相机引入患者体内。然后通过使用引入的工具执行外科规程,其中可视化辅助由相机提供。

3.一般来讲,mis提供多重有益效果,诸如减少患者疤痕、减轻患者疼痛、缩短患者恢复期以及降低与患者恢复相关联的医疗费用。在一些实施方案中,可利用外科机器人系统执行mis,该外科机器人系统包括用于基于来自操作者的命令操纵外科器械的一个或多个机器人臂。例如,操作员可提供用于操纵外科器械的命令,同时查看由相机提供并在显示器上向用户显示的图像。

4.外科规程的执行可能需要关于外科手术的不同方面(包括设置、工作流程等)的深入知识和经验。外科机器人系统的使用潜在地增加了外科手术的复杂性。外科医生或助手在术前、术中和术后与处于远程位置的医疗专业人员协作可能是有帮助的。通过远程协作,可改进规程并且可识别和降低风险。

技术实现要素:

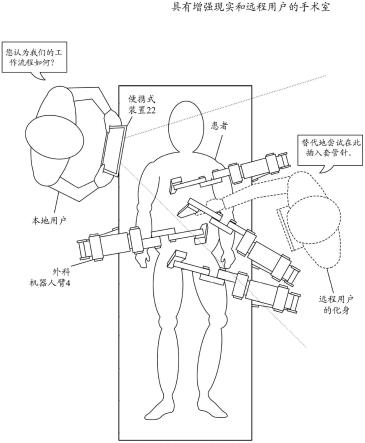

5.通常,外科机器人系统具有允许术前、术中和术后协作的远程指导特征。远程指导特征可提供用于经由远程指导者引导术中规程的直观且稳健的方法。远程用户(“指导者”)佩戴虚拟现实(vr)头戴式设备以编排化身,该化身是指导者的数字表示,其被虚拟地引入到手术室中且由控制或佩戴增强现实(ar)装置(诸如计算机平板、移动智能电话或头戴式设备(例如,增强现实或混合现实眼镜))的本地用户可见。ar是指将虚拟对象(例如,指导者的数字表示)叠加在示出ar用户的物理环境(在这种情况下是手术室)的视频馈送上。虚拟对象通常被集成到用户的物理环境中,例如,通过与物理环境交互。应当理解,为了本公开的目的,术语增强现实和混合现实是可互换的。

6.远程vr用户和本地术中ar用户都被界定在相对于verb机器人系统的共享坐标系中。换句话说,它们具有公共坐标系,使得它们以现实方式共同定位在相同虚拟空间中。远程虚拟现实用户不仅通过化身可见,而且还可创建位于3d空间内的注释和标记,提供机器人臂移动/位置的推荐和示例,以及推荐外科手术台取向/位置。远程用户和本地用户的音频流可在远程用户和本地用户之间来回传输以有助于口头通信。因此,来自远程用户的输入(例如,注释、标记、推荐和/或音频)可向本地用户提供关于外科规程的不同方面的有帮助的见解。

7.继而,物理手术室环境的点云信息可由深度相机捕捉并且传输回虚拟现实环境以供远程用户查看和操纵。通过使用增强现实头戴式设备/平板计算机作为传感器源和数据

生成器,远程vr用户可在vr中构造患者的3d网格,该网格将指示和实现术中引导。

8.在一些实施方案中,系统可包括多个深度相机(例如,rgbd扫描器或等效技术)。深度相机中的至少一者与由手术室(or)中的本地用户操作的便携式电子装置集成。深度相机中的另一者被布置在or中,诸如安装在装备和/或墙壁上。系统可包括外科机器人,诸如用于在外科手术期间支撑患者的机器人臂和平台,以及用于命令外科机器人的移动的控制器。

9.基于a)从外科机器人或控制器接收的机器人信息和b)由多个深度相机对or的感测来生成or的虚拟表示。向虚拟现实头戴式设备传输or的虚拟表示和三维点云数据,其用于向由远程用户佩戴的虚拟现实头戴式设备的显示器呈现虚拟现实环境。以这种方式,远程用户可“看到”在or中正在发生什么并且提供见解。

10.在便携式电子装置处在增强现实中呈现远程用户的虚拟表示。虚拟表示可以是叠加在or的“实况”视频馈送上的图形对象。可基于远程用户的位置来生成远程用户的虚拟表示,使得远程用户的虚拟表示共享公共坐标系,该公共坐标系对于or的虚拟表示、外科机器人和本地用户的便携式电子装置是公共的。换句话说,如果远程用户在or的虚拟表示中朝向患者向前移动(如在虚拟现实头戴式设备中向远程用户示出),则远程用户的化身将同时朝向患者向前移动,如向本地用户显示的增强现实所示。类似地,如果远程用户在向远程用户示出的虚拟现实环境中“指向”患者的部分,则远程用户的化身将在向本地用户示出的增强现实中指向患者的对应部分。这创建本地用户和远程用户之间的“现实”交互并且将本地用户的增强现实与远程用户的虚拟现实合并。

11.可通过远程用户的虚拟表示来指示来自远程用户的输入诸如音频数据(例如,远程用户的语音)和由数字工具(例如,由远程用户保持的手持式用户输入装置)生成的虚拟注释。虚拟表示可以是将远程用户的手势、移动、位置和/或意图传送给用户的人(例如,头和手)的简化呈现、现实表示或符号表示。

附图说明

12.图1示出了根据一些实施方案的手术室中的外科机器人系统的示例。

13.图2示出了根据一些实施方案的具有远程远距指导特征的外科机器人系统。

14.图3示出了根据一些实施方案的在增强现实体验中虚拟地导入手术室中的远程用户。

15.图4示出了根据一些实施方案的虚拟地导入远程用户的虚拟现实体验中的手术室和本地用户。

16.图5示出了根据一些实施方案的用于利用外科机器人系统进行远程指导的方法。

具体实施方式

17.本发明的各个方面和变型的非限制性示例在本文中描述并在附图中示出。

18.参见图1,这是手术场所中的示例性外科机器人系统1的绘画视图。系统1包括用户控制台2、控制塔3,以及在外科机器人平台5(例如,台、床等)处的一个或多个外科机器人臂4。臂4可安装到患者搁置于其上的台或床,如图1的示例所示,或者它们可安装到与台或床分离的手推车。系统1可以结合用于对患者6执行手术的任何数量的装置、工具或附件。例

如,系统1可包括用于执行外科手术的一个或多个外科工具7。外科工具7可以是附接到外科臂4的远侧端部的端部执行器,用于执行外科规程。

19.每个外科工具7可在外科手术期间手动操纵、通过机器人操纵或两者。例如,外科工具7可以是用于进入、查看或操纵患者6的内部解剖结构的工具。在一个方面,外科工具7为可抓持患者的组织的抓持器。外科工具7可被配置为由床边操作者8手动地控制、经由其附接到的外科机器人臂4的致动移动来通过机器人控制、或两者。机器人臂4被示出为台上安装的,但在其他配置中,臂4可安装到手推车、天花板或侧壁,或者安装到另一个合适的结构支撑件。

20.远程操作者9(诸如外科医生或其他人类操作者)可使用用户控制台2以远程操纵臂4和其附接的外科工具7,例如在此称为远程操作。用户控制台2可位于与系统1的其余部分相同的手术室中,如图1所示。然而,在其他环境中,用户控制台2可位于相邻或附近的房间中,或者其可位于远程位置,例如,在不同的建筑物、城市或国家中。用户控制台2可包括座椅10、脚动控件13、一个或多个手持式用户输入装置(uid)14以及至少一个用户显示器15,该用户显示器被配置为显示例如患者6体内的外科手术部位的视图。在示例性用户控制台2中,远程操作者9坐在座椅10中并查看用户显示器15,同时操纵脚动控件13和手持式uid 14,以便远程控制臂4和安装在臂4的远侧端部上的外科工具7。

21.在一些变型中,床边操作者8可以“床上”模式操作系统1,其中床边操作者8(用户)位于患者6的一侧并且同时操纵机器人驱动的工具(附接到臂4的端部执行器),其中用一只手握持手持式uid 14并且用另一只手握持手动腹腔镜工具。例如,床边操作者的左手可操纵手持式uid以控制机器人驱动的工具,而床边操作者的右手可操纵手动腹腔镜工具。在系统1的此特定变型中,床边操作者8可对患者6执行机器人辅助微创外科手术和手动腹腔镜外科手术两者。

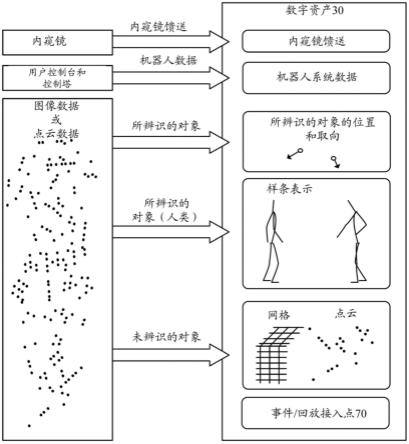

22.在示例性规程(外科手术)期间,为患者6做手术准备并以无菌方式为该患者覆盖消毒盖布以实现麻醉。在机器人系统1的臂处于收起配置或撤回配置时,可手动地执行对外科手术部位的初始触及(以便于触及外科手术部位)。一旦完成触及,就可执行机器人系统1包括其臂4的初始定位或准备。接着,外科手术继续,其中用户控制台2处的远程操作者9利用脚动控制件13和uid 14来操纵各种端部执行器以及可能的成像系统,以执行外科手术。也可由身着消毒手术衣的床边人员(例如,床边操作者8)在手术床或手术台处提供人工辅助,该床边人员可对机器人臂4中的一个或多个臂执行任务,诸如回缩组织、执行手动重新定位以及工具更换。也可存在非消毒人员以在用户控制台2处辅助远程操作者9。当规程或外科手术完成时,系统1和用户控制台2可被配置或设定成一定状态以便于完成术后规程,诸如清洁或消毒以及经由用户控制台2输入或打印保健记录。

23.在一个实施方案中,远程操作者9保持并且移动uid 14以提供输入命令,从而移动机器人系统1中的机器人臂致动器17。uid 14可例如经由控制台计算机系统16通信地耦接到机器人系统1的其余部分。uid 14可生成对应于uid 14的移动的空间状态信号,例如uid的手持式外壳的位置和取向,并且空间状态信号可以是控制机器人臂致动器17的运动的输入信号。机器人系统1可使用源自空间状态信号的控制信号来控制致动器17的成比例运动。在一个实施方案中,控制台计算机系统16的控制台处理器接收空间状态信号并生成对应的控制信号。基于控制致动器17如何通电以移动臂4的区段或连接件的这些控制信号,附接到

臂的对应外科工具的移动可模拟uid 14的移动。类似地,远程操作者9与uid 14之间的交互可生成例如夹持控制信号,该夹持控制信号使外科工具7的抓持器的钳口闭合并夹持患者6的组织。

24.外科机器人系统1可包括若干uid 14,其中为控制相应臂4的致动器和外科工具(端部执行器)的每个uid生成相应的控制信号。例如,远程操作者9可移动第一uid 14以控制位于左机器人臂中的致动器17的运动,其中致动器通过移动臂4中的连杆、齿轮等来响应。类似地,远程操作者9对第二uid 14的移动控制另一个致动器17的运动,这继而移动机器人系统1的其他连杆、齿轮等。机器人系统1可包括固定到患者的右侧的床或台的右臂4,以及位于患者的左侧的左臂4。致动器17可包括一个或多个马达,该一个或多个马达被控制成使得它们驱动臂4的接合部旋转,以例如相对于患者改变附接到该臂的外科工具7的内窥镜或抓持器的取向。同一臂4中的若干致动器17的运动可由从特定uid 14生成的空间状态信号控制。uid 14还可控制相应外科工具抓持器的运动。例如,每个uid 14可生成相应的抓持信号以控制致动器(例如,线性致动器)的运动,该致动器在外科工具7的远侧端部处打开或闭合抓紧器的钳口以抓持患者6体内的组织。

25.在一些方面,平台5和用户控制台2之间的通信可通过控制塔3,该控制塔可将从用户控制台2(并且更具体地从控制台计算机系统16)接收的用户命令转换成传输到机器人平台5上的臂4的机器人控制命令。控制塔3还可将状态和反馈从平台5传输回用户控制台2。机器人平台5、用户控制台2和控制塔3之间的通信连接可经由有线和/或无线链路,使用各种数据通信协议中的任何合适的数据通信协议。任何有线连接可任选地内置于手术室的地板和/或墙壁或天花板中。机器人系统1可向一个或多个显示器提供视频输出,包括手术室内的显示器以及可经由互联网或其他网络访问的远程显示器。还可加密视频输出(视频馈送)以确保隐私,并且视频输出的全部或部分可保存到服务器或电子保健记录系统。

26.图2示出了具有远程特征的外科机器人系统1,该远程特征允许外科医生在术前、术中和术后协作。实时的虚拟现实和增强现实协作平台的发展实现了交互范例,其中远程外科专业人员可从不同位置方便地观察和建议外科手术。

27.处理器24可基于a)机器人信息和b)由一个或多个深度相机(例如,相机21、23)对手术室的感测来生成手术室的虚拟表示。深度相机可包括与由手术室中的本地用户操作的便携式电子装置22集成的至少一个深度相机23,以及在手术室中布置在固定位置处(例如,在墙壁上和/或在装备上)的至少一个静止深度相机21。深度相机可以是rgbd传感器或感测颜色和深度的其他等效技术。

28.机器人信息由图1所示的外科机器人系统的部件生成。例如,外科机器人平台可提供由伺服系统或传感器生成的遥测,该遥测指示平台当前保持在的位置和取向(例如,平台高度和角度)。类似地,外科机器人臂和外科工具的传感器或控制器可提供遥测,该遥测描述外科机器人臂的位置(例如,关节角度)、当前附接到机器人臂的工具类型、工具抓持状态(例如,90%闭合)和活动工具能量。可在控制塔或用户控制台处收集该数据。此外,诸如系统状态(开、关、空闲)或错误代码的系统信息可被收集并且与远程用户共享。

29.处理器可使用机器人信息以基于例如机器人关节角度以及平台高度和角度来生成机器人信息所指示的位置中的相应机器人部件的虚拟表示。这可避免根据由深度相机感测的图像数据外推平台、机器人臂和工具的精确定位的需要,同时还改进包括在手术室的

虚拟表示中的这些部件的虚拟表示的准确性。

30.在一些实施方案中,便携式电子装置22可以是平板计算机或移动智能电话28。增强现实(例如,远程用户和/或其他虚拟对象的表示)被呈现在装置的显示器上,叠加在由装置捕捉的图像流上。另选地,便携式电子装置可以是头戴式装置诸如增强现实或混合现实眼镜39,其具有佩戴在眼睛前方的透明显示器,增强现实被呈现在该透明显示器上。这以“实时”或“实况”方式进行,这意味着增强现实的处理和显示与图像流的捕获同时执行,尽管存在不可避免的延迟诸如缓冲、处理和通信时延。

31.手术室的虚拟表示和三维点云数据被传输到虚拟现实头戴式设备26(由远程用户操作),该虚拟现实头戴式设备用于将虚拟现实环境呈现给虚拟现实头戴式设备的显示器。此处,虚拟现实环境是完全沉浸式的,这意味着向远程用户示出的内容不与远程用户的环境集成,而是远程用户被虚拟地传达到手术室。

32.手术室的虚拟表示可包括手术室和手术室中的部件的三维呈现。在一些情况下,虚拟化手术室可包括元数据诸如装备类型、位置和取向,使得虚拟现实头戴式设备可将那些对象呈现到虚拟现实环境中,从而减小必须被传输到虚拟现实头戴式设备的数据量,例如,如果环境的所有对象的原始3d点云数据要被传输。手术室的虚拟表示可包括在or环境中感测的对象、墙壁、天花板、人员(例如,外科医生、助手等)的网格表示。手术室的虚拟表示可基于由多个深度相机捕获的3d点云数据来构造。

33.虚拟表示可由处理器24生成。处理器可与独立计算机成一体,与控制器、膝上型计算机、由本地用户操作的便携式电子装置或外科机器人系统的其他计算系统集成。

34.然而,应当认识到,对于一些区域,有益的是将原始3d点云数据传输到远程用户,提供更大的细节和分辨率,并且允许远程用户与手术室的感测环境交互的更大能力。该3d点云数据可由便携式电子装置22的深度相机生成,或者由在or中安装在装备或墙壁上的指向感兴趣区域的一个或多个深度相机生成。例如,本地用户可将便携式电子装置的深度相机23瞄准患者身上的感兴趣区域(例如,患者腹部)。该原始3d点云数据可被传输到远程vr头戴式设备以允许远程用户分析和操纵该原始图像数据。

35.例如,远程外科医生可在另一个外科医生正在执行外科手术时对患者执行器官的分割,使得术中人员可接收生理界标上的实时视觉引导。分割是指将图像划分成具有类似属性(诸如灰度级、颜色、纹理、亮度和对比度)的区域的过程。因此,远程用户可细分图像中的对象以帮助识别感兴趣区域(例如,器官、肿瘤、病变、其他异常的部分)。基于原始点云数据,远程用户还可识别患者身上的用作外科机器人器械的入口点的端口的位置。因此,具有可被引导到感兴趣区域的深度相机会允许本地用户向远程用户发送患者的详细扫描。

36.处理器使用由深度相机感测的机器人信息和传感器数据以识别并虚拟地建立外科机器人系统和其部件在ar装置的坐标系中的3d位置和取向。这可通过已知计算机视觉算法(诸如图像分类和对象定位)以及执行从一个坐标系到另一个坐标系的变换以确定公共坐标系来执行。

37.通过该过程,跨外科机器人系统和便携式电子装置布置的深度相机建立公共坐标系并且创建与房间中的机器人臂/台的实时位置/取向匹配的机器人臂/台的虚拟重建。在外科机器人系统的部件被定位在3d空间(例如,控制塔、外科医生桥,以及台和臂)中之后,远程参与者可与or的虚拟重构交互。远程用户的虚拟表示(例如,远程用户的手、身体和/或

头部的取向/位置)传送到相同的相对坐标系中的增强现实用户。

38.对由与便携式电子装置集成的至少一个深度相机所生成的数据执行同时定位和标测(slam)算法,以在公共坐标系中定位便携式电子装置3d空间的位置和取向。

39.本地用户的便携式电子装置和/或处理器24可具有与外科机器人系统的数据连接以使得其可检索实时机器人信息(例如,机器人的臂关节角度、工具类型、工具抓持状态、活动工具能量、臂模式、台位置和取向、病例外科医生,以及故障排除错误代码)。这可用于生成虚拟or并且向本地用户和远程用户提供通知。

40.除了在3d空间中定位外科机器人系统的部件(例如,平台、用户控制台、控制塔、机器人臂)之外,通过由一个或多个深度相机(例如,23和/或21)生成的3d点云流向远程用户发送进入3d术中空间的实况“窗口”。该点云提供来自or的实际深度和rgb数据的实时流,而不是部件位置/取向数据的简化流,其调整远程用户的虚拟现实环境中的外科机器人系统的预呈现部件和or部件。在正确坐标空间中相对于虚拟现实环境的其余部分显示的该点云流解锁远程用户的附加能力。

41.例如,远程用户可通过3d点云数据(或基于3d点云数据生成的网格)更详细地看到患者身体,并且创建针对套管针应当被放置在患者中的位置的数字路点和虚拟引导(参见例如图4)。另外地或另选地,远程用户可创建针对机器人臂应当如何相对于患者身体取向的数字路点和虚拟引导。另外地或另选地,远程用户可给出关于人员应站在手术室中的何处或者装备应被布置在手术室中的何处的有教育的建议。本地用户通过便携式装置22与远程用户交互,如图3所示。

42.图3示出了手术室和放置在手术室中的远程用户的虚拟表示,从而为本地用户创建增强现实体验。远程用户的虚拟表示基于远程用户的位置和来自远程用户的输入在增强现实中呈现给便携式电子装置22的显示器。远程用户的位置共享公共坐标系,即其对于or的虚拟表示和本地用户的便携式电子装置是公共的。

43.远程用户相对于or的位置可使用用户的远程位置处的一个或多个参考点来确定。例如,在远程用户的远程位置处,传感器可被布置在远程用户的周围环境中和/或vr头戴式设备上。可在远程用户的位置中选择(例如,任意地)原点以匹配手术室的空间中的原点。可执行变换以将远程用户的移动和位置映射到or的虚拟表示。因此,可相对于手术室的坐标系计算远程用户的位置和取向,从而允许远程用户虚拟地探索手术室并与手术室交互。

44.如在其他部分中讨论的,本地用户可将可与便携式装置22集成的深度相机瞄准感兴趣位置(诸如患者腹部)。由深度相机生成的原始点云数据可被实时传输到远程用户。虚拟标记和对象可基于由远程用户生成的输入呈现在便携式装置的显示器上,该输入诸如:由数字工具远程生成的虚拟注释、解剖分割数据、套管针放置的指示和先前外科设置。

45.例如,远程用户可使用如图2所示的手持式数字工具27来圈出要切割或移除的区域、标记套管针的入口端口应处于的位置、或者标记需要缝合的位置。这些“标记”可在本地用户的便携式装置中由虚拟对象(例如,线、突出显示区域、或形状)虚拟地表示。

46.如所讨论的,来自远程用户的输入可包括在vr头戴式设备处捕获的音频数据。来自本地用户的音频可同时传输到vr头戴式设备,从而提供双向通信。可使用ip语音(voip)或其他音频通信技术。

47.返回参照图3,当远程用户口头地指示并标记套管针应当插入的位置时,本地用户

可“看到”和“听到”远程用户。远程用户的虚拟存在创建自然远距指导平台。从远程用户向本地用户传送空间上下文3d标记和注释。这可与外科手术的执行同时进行。远程用户可不仅在内窥镜馈送中而且还围绕机器人提供视觉引导,例如,如何对臂进行取向、用于放置内窥镜和工具的位置、第1位助理应站在的位置。远程用户的虚拟表示可包括以下中的一者或多者:a)虚拟现实头戴式设备的虚拟表示,b)指示远程用户的手移动或手位置的虚拟手,以及c)类似于整个人的一部分或整个人的虚拟化身。

48.图4示出了远程用户的虚拟现实体验。远程用户被传达到外科机器人系统所位于的手术室。佩戴vr头戴式设备26的远程用户可探查虚拟空间并且口头地和/或使用诸如数字笔或手持式uid的远程数字工具(例如,图2所示的远程数字工具27)来提供输入。

49.虚拟化or数据和点云数据被传送到vr头戴式设备,在该vr头戴式设备中这用于将or的虚拟表示以及感兴趣点(例如,患者)的详细区域呈现到远程用户的vr头戴式设备的显示器上。此外,本地用户的便携式电子装置22的位置和取向可被传送到虚拟现实头戴式设备。这可用于在虚拟现实环境中呈现便携式电子装置的虚拟表示(例如,在虚拟环境中浮动)和/或本地用户的虚拟表示(例如,化身)。以此方式,远程用户可感觉她正与虚拟or中的本地用户交互。

50.如在其他部分中讨论的,远程用户可使用医疗成像分割以在操作正在行进时突出显示、分割和视觉地注释与操作相关的组织和器官。远程用户可将其自身的先前外科设置加载和叠加到增强现实用户的现有术中设置上,作为针对他们可如何组织其自身的or/机器人的引导。

51.根据一些实施方案,在图5中示出了提供交互式和沉浸式远程指导的方法40。方法可由图1和图2所示的外科机器人系统执行。例如,方法可由处理器24执行,该处理器可与独立计算机成一体、与外科机器人系统1(图1或图2所示)的部件集成、或与图2的便携式电子装置22集成。

52.在操作41处,方法包括基于a)机器人信息和b)由一个或多个深度相机对or的感测来生成or的虚拟表示。深度相机包括与由or中的本地用户操作的便携式电子装置集成的至少一个深度相机,以及布置在or中的至少一个静止深度相机。机器人信息可用于更准确地生成机器人部件(诸如机器人臂、附接到其的工具/器械以及外科平台)的位置。

53.在操作42处,方法包括向虚拟现实头戴式设备传输or的虚拟表示和三维点云数据,其中这用于向由远程用户操作的虚拟现实头戴式设备的显示器呈现虚拟现实环境。or的虚拟表示可包括描述手术室和手术室中的对象的几何形状的网格数据,和/或手术室中的已识别对象的位置和取向数据。远程用户被虚拟地传达到外科手术室中,使得远程用户可分析设置、工作流程或提供其他有帮助的见解以执行外科手术。

54.在操作43处,方法包括基于远程用户的位置和来自远程用户的输入在增强现实中将远程用户的虚拟表示呈现给便携式电子装置的显示器。远程用户的虚拟表示在公共坐标系中呈现,该公共坐标系对于or的虚拟表示和本地用户的便携式电子装置是公共的。可基于由附接到便携式电子装置或与便携式电子装置集成的深度相机捕获的图像数据与由安装在手术室中的深度相机捕获的图像数据之间的变换来确定公共坐标系。

55.方法可连续且实时地执行。例如,连续且同时地执行操作42和操作43以提供本地用户和远程用户之间的相干交互。

56.出于解释的目的,前述描述使用特定命名来提供对本发明的透彻理解。然而,对于本领域的技术人员将显而易见的是,实践本发明不需要具体细节。出于举例说明和描述的目的,已经提供了本发明的特定实施方案的前述说明。它们并非旨在为详尽的或将本发明限制为所公开的具体形式;根据上述教导内容可对本公开进行多种修改和改变。选择和描述实施方案是为了最好地解释本发明的原理及其实际应用,从而使得本领域的其他技术人员能够最好地利用本发明和具有适合于所设想的特定用途的各种修改的各种实施方案。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。