1.本发明涉及边缘计算领域,特别涉及一种基于自动机器学习的边缘计算模型训练方法。

背景技术:

2.为了克服传统it技术所面临的资源利用率低、生产成本高、网络利用率低、能源消耗高等问题,云计算技术应运而生。企业可以利用分布式计算和虚拟化技术搭建数据中心或超级计算机,以无偿或按需求租用的形式向技术人员或企业用户提供硬件资源(服务器、存储器、cpu等)和软件资源(应用软件、集成开发环境等),企业用户只需按照自身的实际需求选择相应的业务,而无须购置、拥有和维修物理的资料设备和数据库。另外,云计算还拥有广泛的网络接入、资源池化、快速弹性伸缩和可计量服务等优势。

3.然而,随着近几年5g技术和物联网技术的快速发展,万物互联时代的到来,网络中接入了大量的终端设备,计算需求出现爆发式增长。其中不乏对计算服务实时性要求高的计算任务,例如无人驾驶、vr游戏和智能家居等。当面对海量数据计算、新兴计算场景、小数据实时处理等方面的挑战时,受限于距离、网络带宽等因素的传统云计算架构难以满足这些计算任务的要求。

4.因此,将云计算的能力下沉到边缘侧、终端侧,通过云端进行统一的交付、运维、管控将会是重要的发展趋势。随着算力从云端下沉到边缘端,一套新的计算体系-云边端协同计算架构也因此而生。其中“云”是传统云数据中心,是边缘计算的管控端;“边”是云数据中心和终端设备之间的边缘节点组成的边缘网络;“端”则是智能终端设备,比如手机、智能家电、各类传感器等。与传统的云计算架构相比,云边端协同计算架构不需要将终端设备产生的计算任务和数据全部上传到云端,只需将小规模、实时的智能分析任务交给就近端的边缘节点处理,拉近了计算资源与客户的距离,可以产生更快的网络服务响应,满足各行业在实时业务、应用智能、安全与隐私保护等方面的需求。

5.尽管如此,由于边缘服务器上的计算资源有限、异构芯片不能协同统一利用、计算资源利用率低等原因,实际上还是会出现计算延迟高等问题。因此,近年来技术人员基于各种技术提出了优化边缘服务器资源利用率、保护数据隐私性、降低计算时延的模型和方法。

6.例如,北京交通大学提出的“一种基于边缘计算的神经网络模型训练方法”(申请号为202210176214.9),通过使用非学习层的方式对模型进行改进,优化边缘端和终端设备间的数据传输,减少通信时延。

7.重庆理工大学提出的“分层边缘计算环境中基于深度强化学习的任务调度方法”(申请号为202111012837.4),以提升调度决策的质量并能在效率与质量之间得到平衡。

8.上海交通大学提出的“一种基于边缘计算的任务调度方法”(申请号为202210007565.7),通过在各区域维护一个策略网络,基于联邦学习的深度强化学习算法进行在线更新网络参数,各区域独立对本区域内实时接收到的任务进行调度,以增强模型扩展性、保护数据隐私性、提高系统性能。

9.上述模型方法都在一定程度上提升了边缘服务器的性能,但没考虑到边缘服务器的异构性和边缘服务器上计算资源有限的问题。为此,本发明将自动机器学习技术运用在边缘计算上,自动训练计算模型,从而得到最优计算模型,减轻了模型开发和维护的成本。同时,考虑到边缘服务器计算资源有限和计算任务对计算时延有要求的问题,通过根据计算任务信息和计算资源情况,对自动机器学习算法的超参数进行学习和约束,使生成的计算模型更具有泛化能力。

技术实现要素:

10.本发明的目的在于克服现有技术的缺点与不足,提供一种基于自动机器学习的边缘计算模型训练方法,该方法能考虑边缘服务器的异构性、资源有限性以及计算任务对计算时延的要求,使生成的计算模型更具有泛化能力,同时减轻模型开发和维护的成本。

11.本发明的目的通过以下的技术方案实现:

12.一种基于自动机器学习的边缘计算模型训练方法,包括以下步骤:

13.步骤1:边缘服务器在训练计算模型之前,获取当前任务队列中每个计算任务的信息矩阵job,以及当前服务器的计算资源矩阵source;

14.步骤2:将计算任务的信息矩阵x1=job与服务器的计算资源矩阵x2=source组成x={x1,x2},将x作为后续神经网络模型的输入;

15.步骤3:将步骤2中的x输入到已经训练好的神经网络模型,最后神经网络模型输出自动机器学习算法的超参数hyperparameters;

16.步骤4:根据步骤3中的超参数hyperparameters,设置好自动机器学习算法的超参数,然后使用输入数据通过自动机器学习算法自动训练出最优机器学习计算模型best

model

。

17.一种基于自动机器学习的边缘计算模型训练方法,包括以下步骤:

18.s1.针对电表读数的图像识别计算任务,提前在atlas 200dk边缘设备上部署能够自动获取不同计算任务在cpu和npu上运行时产生的计算任务的信息矩阵job和服务器的计算资源矩阵source的脚本;

19.s2.在atlas 200dk边缘设备上定期采集m个电表读数的图像识别任务及其产生的信息job,其中job={j1,j2,...,jm},其中j=[runtime,energy,node,t];以及脚本获取到的对应历史数据信息trace={source1,source2,...,sourcem},其中source=[fnode,fmemory,energy];

[0020]

s3.在atlas 200dk边缘设备上部署基于深度学习框架tensorflow的nas自动训练脚本;

[0021]

s4.使用步骤s3中的nas自动训练脚本训练一个最大层数不超过10层,每层宽度不超过300个神经元的dnn神经网络模型model,其输入为x={job,source},输出为识别电表读数的cnn模型的nas自动训练算法预设值超参数hyperparameters=[layers,filters,kernel,loss,seed],其中layers代表cnn的搜索最大层数,filters、kernel代表cnn模型每一层卷积层最大的filters通道数与最大卷积核大小,loss代表选择的损失函数,seed代表cnn的初始种子编号;

[0022]

s5.atlas 200dk边缘设备在训练识别电表读数的cnn模型之前,获取当前任务队列中每个计算任务的信息矩阵job_now,其属性特征包括:计算任务在cpu和npu上运行所需

的大概时间、计算任务在cpu和npu上运行所造成的大概能耗、计算任务在cpu和npu上运行所需的计算节点数量、计算任务的计算时延要求;以及当前atlas 200dk边缘设备的计算资源矩阵source_now,其属性特征包括:atlas 200dk边缘设备上两块npu和cpu上空闲计算节点情况、两块npu和cpu上空闲计算内存、设备当前时间段的平均能耗;

[0023]

s6.将步骤s5中获取到的任务信息矩阵job和计算资源矩阵source作为输入x,x=[job_now,source_now},输入到步骤s4中得到的dnn神经网络模型model中,得到识别电表读数的cnn模型的nas自动训练算法预设值超参数hyperparameters=[6,64,10,softmax,3];

[0024]

s7.将atlas 200dk边缘设备上定期采集的m个电表读数图像统一处理为256*256大小图像配合图像切割程序,形成训练cnn模型的输入数据集input;

[0025]

s8.基于深度学习框架tensorflow,使用s6中获取的hyperparameters设置cnn模型的nas算法的超参数,将步骤s7中生成的input作为训练集,训练出最优的cnn模型best

model

,其包括3层卷积池化层、两层全连接层、损失函数为softmax;

[0026]

s9.使用s8中得到的最优cnn模型best

model

识别电表图像,得到最终的电表读数。

[0027]

所述计算任务的信息矩阵job的属性特征包括:计算任务在不同计算芯片上运行所需的大概时间、计算任务在不同计算芯片上运行所造成的大概能耗、计算任务在不同计算芯片上运行所需的计算节点数量、计算任务的计算时延要求。

[0028]

所述服务器的计算资源矩阵source的属性特征包括不同计算芯片上空闲计算节点情况、不同计算芯片上的空闲计算内存、当前时段的平均能耗。

[0029]

所述神经网络模型是以历史计算任务的信息矩阵job和边缘服务器的计算资源矩阵source作为输入,自动机器学习算法的超参数hyperparameters作为输出,采用交叉熵损失作为损失函数,通过nas使用进化算法、贪婪算法或网格搜索等算法自动训练得到的。

[0030]

通过人为初始化所述nas的超参数pipleine和randomseed,从初始种子出发,不断改变网络结构和权重参数,直至到达约束的模型大小,过程中得到各种模型,根据模型得分选出最优模型。

[0031]

步骤3中,所述自动机器学习算法包括:神经网络架构搜索、超参数优化、cash、自动化数据挖掘、自动强化学习、元学习、自动机器学习的贝叶斯优化、自动机器学习的进化算法、自动机器学习的多目标优化、自动人工智能;

[0032]

其中,神经网络架构搜索的超参数的特征属性包括:约束最终模型结构大小和规模的超参数pipeline;加速模型优化的模型初始种子参数randomseed。

[0033]

步骤4中,所述输入数据为不同计算模型对应的训练集。

[0034]

本发明与现有技术相比,具有如下优点和有益效果:

[0035]

本发明在边缘服务器训练计算模型前获取当前的计算任务信息和服务器计算资源情况;通过nas(neural architecture search)根据计算任务信息和计算资源情况,对自动机器学习算法的超参数进行学习和约束;在确定自动机器学习算法的超参数后,通过自动机器学习算法根据输入数据自动训练出最优的计算模型。与当前边缘服务器上的计算模型不同,本发明在考虑边缘服务器的异构性、资源有限性以及计算任务对计算时延的要求的前提下,通过自动机器学习技术生成计算模型,减轻模型的开发、维护成本,使生成的计算模型更具有泛化能力。

附图说明

[0036]

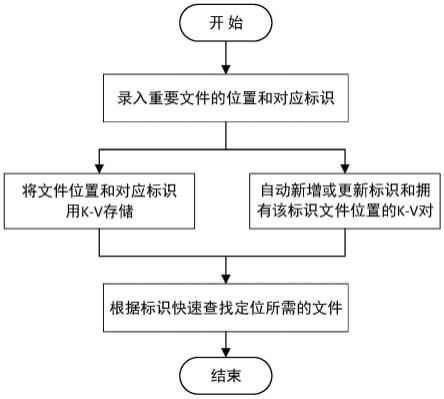

图1为基于自动机器学习的边缘计算模型训练方法的示意图。

[0037]

图2为计算任务的信息矩阵的示意图。

[0038]

图3为边缘服务器计算资源矩阵的示意图。

[0039]

图4为基于自动机器学习的边缘计算模型训练方法的流程图。

具体实施方式

[0040]

下面结合实施例及附图对本发明作进一步详细的描述,但本发明的实施方式不限于此。

[0041]

如图1-4,一种基于自动机器学习的边缘计算模型训练方法,包括以下几个步骤:

[0042]

步骤1:边缘服务器是处于网络末端或“边缘”,更靠近用户的计算机。边缘服务器在训练计算模型之前,应当获取当前任务队列中每个计算任务的信息矩阵job,其属性特征包括:计算任务在不同计算芯片上运行所需的大概时间、计算任务在不同计算芯片上运行所造成的大概能耗、计算任务在不同计算芯片上运行所需的计算节点数量、计算任务的计算时延要求;以及当前服务器的计算资源矩阵source,其属性特征为不同计算芯片上空闲计算节点情况、不同计算芯片上的空闲计算内存、当前时段的平均能耗。

[0043]

计算任务的信息矩阵job包括以下属性:

[0044]

计算任务在不同计算芯片上运行所需的大概时间:

[0045]

runtime

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0046]

=(cpu

runtime

,gpu

runtime

,npu

runtime

…

)

[0047]

计算任务在不同计算芯片上运行造成的大概能耗:

[0048]

energy

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0049]

=(cpu

energy

,gpu

energy

,npu

energy

……

)

[0050]

计算任务在不同计算芯片上运行所需的计算节点数量:

[0051]

node=(cpu

node

,gpu

node

,npu

node

......)

ꢀꢀꢀꢀ

(3)

[0052]

计算任务的计算时延要求t。

[0053]

其中,计算任务在不同计算芯片上运行所需的大概时间、计算任务在不同计算芯片上运行造成的大概能耗和计算任务在不同计算芯片上运行所需的计算节点数量可从历史数据中获取。

[0054]

计算资源矩阵source包括以下属性:

[0055]

服务器上不同计算芯片的空闲计算节点:

[0056]

fnode=(cpuk,gpuk,npuk......)

ꢀꢀꢀꢀ

(4)

[0057]

服务器上不同计算芯片的空闲计算内存:

[0058]

fmemory=(cpum,gpum,npum......)

ꢀꢀꢀꢀ

(5)

[0059]

服务器当前时间段的平均能耗energy。

[0060]

步骤2:将计算任务的信息矩阵x1=job与服务器的计算资源矩阵x2=source组成x={x1,x2}作为后续神经网络模型的输入。

[0061]

步骤3:将步骤2中的x输入到已经训练好的神经网络,最后输出自动机器学习算法的超参数hyperparameters。

[0062]

自动机器学习算法涵盖的10种技术包括:

[0063]

神经网络架构搜索(nas neural architecture search)

[0064]

超参数优化(hpo hyperparameter optimization)

[0065]

cash(combined algorithm selection and hyperparameter optimization)

[0066]

自动化数据挖掘(automated data mining)

[0067]

自动强化学习(autorl automated reinforcement learning)

[0068]

元学习(meta-learning and learning to learn)

[0069]

自动机器学习的贝叶斯优化(bayesian optimization for automl)

[0070]

自动机器学习的进化算法(evolutionary algorithm for automl)

[0071]

自动机器学习的多目标优化(multi-objective optimization for automl)

[0072]

自动人工智能(autoai)

[0073]

以nas(neural architecture search)为例,其超参数的特征属性包括:约束最终模型结构大小和规模的超参数pipeline;加速模型优化的模型初始种子参数random seed。

[0074]

步骤4:根据步骤3中的hyperparameters设置好自动机器学习算法的超参数,然后使用输入数据通过自动机器学习算法自动训练出最优的机器学习计算模型best

model

;输入数据为不同计算模型对应的训练集。

[0075]

所述神经网络模型是以历史计算任务的信息矩阵job和边缘服务器的计算资源矩阵source作为输入,自动机器学习算法的超参数hyperparameters作为输出,采用交叉熵损失作为损失函数,通过nas使用进化算法、贪婪算法或网格搜索等算法自动训练得到的。

[0076]

通过人为初始化nas的超参数pipeline和random seed,从初始种子出发,不断改变网络结构和权重参数,直至到达约束的模型大小,过程中得到各种模型,根据模型得分选出最优模型。

[0077]

在电网的电表智能读数场景下应用本发明方法:

[0078]

针对电表读数的图像识别计算任务,一种基于自动机器学习的边缘计算模型训练方法在华为atlas 200dk边缘设备上的实现,包括以下步骤:

[0079]

s1.提前在atlas 200dk边缘设备上部署能够自动获取不同计算任务在cpu和npu上运行时产生的计算任务信息矩阵job和服务器计算资源矩阵source的脚本。

[0080]

s2.在atlas 200dk边缘设备上定期采集m个电表读数的图像识别任务及其产生的信息job,其中job={j1,j2,...,jm},其中j=[runtime,energy,node,t];以及脚本获取到的对应历史数据信息trace={source1,source2,...,sourcem},其中source=[fnode,fmemory,energy]。

[0081]

s3.在atlas 200dk边缘设备上部署基于深度学习框架tensorflow的nas自动训练脚本。

[0082]

s4.使用s3中的nas自动训练脚本训练一个最大层数不超过10层,每层宽度不超过300个神经元的dnn神经网络模型model。其输入为x={job,source},输出为识别电表读数的cnn模型的nas自动训练算法预设值超参数hyperparameters=[layers,filters,kernel,loss,seed],其中layers代表cnn的搜索最大层数,filters,kernel代表cnn模型每一层卷积层最大的filters通道数与最大卷积核大小,loss代表选择的损失函数,seed代表cnn的初始种子编号。

[0083]

s5:atlas 200dk边缘设备在训练识别电表读数的cnn模型之前,获取当前任务队列中每个计算任务的信息矩阵job_now,其属性特征包括:计算任务在cpu和npu上运行所需的大概时间、计算任务在cpu和npu上运行所造成的大概能耗、计算任务在cpu和npu上运行所需的计算节点数量、计算任务的计算时延要求;以及当前atlas 200dk边缘设备的计算资源矩阵source_now,其属性特征包括:atlas 200dk边缘设备上两块npu和cpu上空闲计算节点情况、两块npu和cpu上空闲计算内存、设备当前时间段的平均能耗。

[0084]

s6:将s5中获取到的任务信息矩阵job和计算资源矩阵source作为输入x,x={job_now,source_now},输入到s4中得到的dnn神经网络模型model中,得到识别电表读数的cnn模型的nas自动训练算法预设值超参数hyperparameters=[6,64,10,softmax,3]。

[0085]

s7:将atlas 200dk边缘设备上定期采集的m个电表读数图像统一处理为256*256大小图像配合图像切割程序,形成训练cnn模型的输入数据集input。

[0086]

s8:基于深度学习框架tensorflow,使用s6中获取的hyperparameters设置cnn模型的nas算法的超参数,将s7中生成的input作为训练集,训练出最优的cnn模型best

model

,其包括3层卷积池化层(filter=[64,32,8],kernel=[4,4,4],stride与padding为默认参数1)、两层全连接层([128,10])、损失函数为softmax。

[0087]

s9:使用s8中得到的最优cnn模型best

model

识别电表图像,得到最终的电表读数。best

model

与人工训练的cnn模型相比,在维持同等推理准确率98.57%的情况下,能耗降低了17%、内存占用降低了11%、推理速度提高了261.25%。

[0088]

综上所述,本发明一种基于自动机器学习的边缘计算模型训练方法具有以下创新点:

[0089]

第一,将自动机器学习技术运用在边缘计算上,减轻模型开发和维护成本。

[0090]

第二,在自动生成模型时考虑到边缘服务器的异构性、资源有限性以及计算任务对计算时延的要求等问题,使生成的计算模型更具有泛化能力。

[0091]

上述实施例为本发明较佳的实施方式,但本发明的实施方式并不受上述实施例的限制,其他的任何未背离本发明的精神实质与原理下所作的改变、修饰、替代、组合、简化,均应为等效的置换方式,都包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。