1.本发明涉及集成电路领域,具体涉及一种高复用度低功耗的脉冲神经网络模型。

背景技术:

2.人类大脑由多层次结构组成,其中包含上百亿的神经元细胞,这些细胞由突触互相连接,这被称为神经网络。与大脑中的神经元相同,脉冲神经网络中的神经元会慢慢累积受到的刺激,达到一定程度后才会释放脉冲信号,以此来传递信息。在模拟人类大脑的层面上,脉冲神经网络相较人工神经网络等要更进一步,它在模型中纳入了时间概念,并且引入了突触来模拟人类大脑中神经元的相连。脉冲神经网络相比前两代神经网络系统具备更高的生物学可信度,同时也有着有更低的功耗和更高的并行性,脉冲神经网络在识别图像和语音数据方面有良好的应用前景。

3.相关技术中,在构建脉冲神经网络时,一般使用深度卷积神经网络,在计算资源消耗上较高,并且抗干扰能力较差,所以需要提供一种可复用网络层计算单元的,且同一网络层层内高并行度的脉冲神经网络。

技术实现要素:

4.本发明的目的在于针对上述现有技术中的问题,提供一种高复用度低功耗的脉冲神经网络模型,通过复用网络层计算单元,大幅度减少计算资源的消耗,并且在同一层网络里,运用并行操作的方式,进一步减少了数据的计算时间。

5.为了实现上述目的,本发明采用如下技术方案:

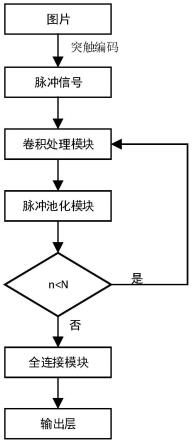

6.一种高复用度低功耗的脉冲神经网络模型,其中所述网络包括编码层,脉冲卷积层,脉冲池化层,全连接层以及脉冲输出层,该网络实现方法包括如下步骤:

7.步骤一、图片数据经过突触模型转换成脉冲信号;

8.步骤二、脉冲卷积层提取信号的多维度信息;

9.步骤三、脉冲池化层对数据进行降维、去除冗余信息;

10.步骤四、全连接层进行特征空间映射。

11.所述步骤一中突触编码模型,通过神经突触的电位衰减,将图片数据转换成t个时间步长的电位信息,便于后续其他网络层进行数据处理;由于是输入层,所以,没有前一层的刺激,每一个时间步长的电位逐级递减。

12.所述的突触编码模型模拟生物中突触的电位更新规则,神经元膜电位随着时间衰减,当有脉冲输入时,进行立即反应,具体更新规则为

13.步骤二中脉冲卷积层,整个网络中有多个卷积层,其卷积核大小相同且可自定义尺寸,便于在数据处理时进行复用处理,突触模型使用的是lif模型,将卷积后的结果传递到突触模型中,依据每一个时间步长的结果与阈值进行对比:如果大于阈值,传递脉冲1到下一层;小于阈值,则进行膜电位正常的衰减。

14.在具体实现过程中,通过状态信号线,判定网络的进程,配置相应卷积层的卷积核大小关键数据,进而进行脉冲卷积处理。

15.脉冲卷积操作,将一个乘法和加法操作作为一个基本的运算单元,每次从内存中读取与卷积核相同尺寸的数据,并行处理与卷积核个数相同的数据,卷积完成后将数据传递到突触模型中。

16.脉冲池化层,脉冲卷积层的脉冲,其数值大小为1或0,在具体池化层搭建时,采用或门电路,以达到最小化资源消耗的作用;并且,具体池化核大小可自定义,以适应不同的应用场景。

17.步骤四中全连接层,复用脉冲卷积处理单元,每次读取卷积核大小尺寸的数据,复用卷积核的处理单元,计算得到最后一层的与分类结果相同数目的数据,进而完成图像数据的分类。

18.不同的场景任务复杂程度不同,需要搭建深度不同的脉冲神经网络,本发明中的网络深度可以根据应用场景自定义设置,以满足不同的场景。

19.与现有技术相比,本发明的具有如下的有益效果:与普通的卷积神经网络相比,引入了时间的概念,运用神经元之间的突触信息传递信号,可以实现低能耗的效果;与普通的脉冲神经网络相比,采用了网络层复用以及卷积复用等方法,进一步节省了计算资源,提高了计算的效率。

附图说明

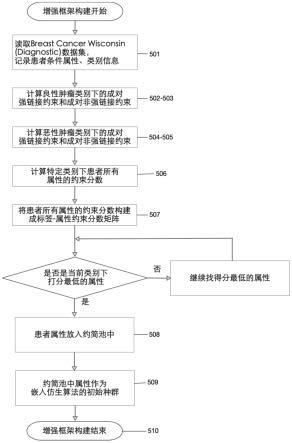

20.图1本发明中脉冲神经网络整体结构示意图;

21.图2本发明中脉冲最大池化操作示意图;

22.图3本发明中全连接层复用卷积层示意图。

具体实施方式

23.下面结合附图对本发明做进一步的详细说明。

24.参见图1,本发明应用于低功耗处理图片分类问题,步骤一、图片数据经过突触模型转换成脉冲信号;步骤二、脉冲卷积层提取信号的多维度信息;步骤三、脉冲池化层对数据进行降维、去除冗余信息;步骤四、全连接层进行特征空间映射,最终输出分类结果。

25.参见图2,本发明中最大池化操作,由于脉冲信号为0,1信号,所以可以利用数字电路中的与门进行操作,图中为2*2最大池化的示例,通过一个4输入的与门,将4个脉冲信号进行“与”操作,得到最大池化后的结果。

26.参见图3,本发明中全连接层对卷积层的复用,其中图(a)代表了内存中全连接层权重的分布,图(b)代表了卷积模块的处理,示例中演示的是3*3的卷积,其中pe表示卷积模块最基本的处理单元:具体操作为从内存中读取权重信息,再依次传到pe单元里,复用卷积层的运算,进行全连接层的处理。

27.本发明的脉冲神经网络模型在结构上包括编码层,脉冲卷积层,脉冲池化层,全连接层以及脉冲输出层。编码层使用电位衰减编码,即在t个时间步长里,由于没有新脉冲的输入,所以神经元膜电位随着时间衰减,直到衰减到静息电位。

[0028][0029]

引入时间常数τm=rc,则:

[0030][0031]

经过编码后,进入到脉冲卷积层,在这一层中,由于每个t时间步长中,神经元的状态有是否发放两种状态,所以,对下一层的神经元会有刺激作用,同时,发放的神经元膜电压会重置到静息电位。

[0032]aj

(t)=(∈*sj)(t),ηi(t)=(v*si)(t)

[0033]

其中,∈(

·

)和v(

·

)分别代表了神经元对于脉冲的响应以及重置函数,对于m层的神经元,如果发放脉冲,则会立即重置膜电位,并且传递脉冲信号到m 1层;如果没有发放脉冲,则会随着时间步长的增加,进行膜电位的衰减。

[0034]

脉冲卷积结束以后,输入到脉冲池化层,由于传入的是0或1信号,所以可以采用4输入的与门进行2*2的最大池化操作。

[0035]

为了进一步提取信号的多维度信息,复用脉冲卷积层,使用同样的卷积核大小,进一步节省计算资源,提高计算速率。

[0036]

第二层脉冲卷积操作后,连接到第二层脉冲池化层,与第一层脉冲池化层同样设计,进行网络层的复用,进而进一步对数据进行降维、去除冗余信息。

[0037]

脉冲池化操作以后,连接全连接层,从内存中读取权重信息,并写到“脉冲卷积核”中,对卷积核进行复用,完成多层全连接层的操作,最后一层全连接层的神经元数量设置为待分类的个数。

[0038]

全连接完成运算以后,得到待分类个数相同的数目的数字,分别代表各自的类别,将数字输入到多重比较器,比较出最大的数字,即分类结果。

[0039]

具体实施时,将权重数据和网络参数存储到外部存储中,通过dma传输到控制器以及具体各个模块中。通过控制器的信号,控制数据的流动以及模块的选择和内部数据处理,图片信息由外部设备传入脉冲神经网络,最终输出类别信息,进而实现分类的效果。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。