1.本发明涉及文本信息抽取技术领域,具体涉及一种长文本的关键要素抽取方法、系统及终端设备。

背景技术:

2.命名实体识别任务旨在从大量的文本数据中获得具有特定意义的实体及实体类别,如人名、地名、机构名等。该任务是自然语言处理的重要子任务之一,并作为一项关键技术为智能问答、知识图谱、句法分析等多项任务提供底层支撑。

3.命名实体识别技术不断发展,从早期基于统计和人工定义规则的方法发展到基于特征工程和机器学习的方法,再到近年来比较受欢迎的基于深度学习的方法,模型识别效果显著提升。随着网络信息资源的激增和智能信息抽取技术的不断发展,通用性的命名实体识别技术难以满足领域命名实体识别的需求,网络长文本关键要素抽取任务更加关注与舆情业务相关的命名实体,然而在网络长文本关键要素抽取过程中存在以下问题:(1)现有技术中面向网络长文本的关键要素抽取算法都是采用深度学习,抽取性能很大程度上依赖于标注语料的规模与质量,由于标注网络长文本语料稀缺,往往难以采集充足的数据来训练模型,不足以使模型捕获到足够的数据模式;现有的研究通常利用小样本学习进行关键要素抽取以有效解决训练样本数据量小的问题,但是传统的小样本学习方案往往采用单一的策略,包括基于数据增强的方法、基于迁移学习的方法、基于主动学习的方法、基于弱监督学习的方法等,在一定程度上存在各自的策略弊端,例如:1)基于主动学习的关键要素抽取方法普遍存在采样准则单一的问题,仅考虑不确定性、多样性等指标之一,且仍需专家参与数据标注过程;2)基于简单数据增强的关键要素抽取方法在扩充数据的过程中易于忽略文本的句法、语义等层面的高阶特征信息,无法针对数据的特点进行全面的建模,导致训练样本质量较低,反而为关键要素抽取模型引入了更多的噪声;3)现有技术未充分结合已有模型的知识及多种策略来对海量未标注网络长文本数据进行有效利用,训练模型的成本仍然较大。

4.(2)与公共领域的命名实体识别不同,网络长文本关键要素抽取任务重点关注与舆情领域密切相关的命名实体,旨在从非结构化的网络长文本中提取舆情命名实体的边界及类别。然而,细粒度的舆情命名实体具有类别繁多、领域特征性较强等特点,例如舆情领域对于“涉事主体”的定义可能会分为“涉事个人”、“涉事自媒体”、“涉事公司”等带有舆情领域性质的要素,这些要素的分类与上下文表述密切相关。现有的网络长文本关键要素抽取方法难以处理舆情命名实体间的长距离依赖特征,易造成实体分类错误。

5.针对现有网络长文本中对关键要素抽取技术存在的高质量文本数据匮乏、抽取精度不高的技术问题,暂未提出有效的解决方案。因此,如何面向少量标注样本和大量未标注样本构建训练样本扩充方案,以及面向网络长文本构建关键要素抽取模型,得到高精度的关键要素抽取结果,已成为当下亟需解决的问题。

6.综上所述,急需一种长文本的关键要素抽取方法、系统及终端设备以解决现有技

术中存在的问题。

技术实现要素:

7.本发明目的在于提供一种长文本的关键要素抽取方法、系统及终端设备,以解决提高长文本关键要素抽取精度的问题。

8.为实现上述目的,本发明提供了一种长文本的关键要素抽取方法,包括以下步骤:步骤一:获取长文本数据集,并将长文本数据集划分为标注样本集l和未标注样本集u;将标注样本集l划分为训练集tr、验证集va和测试集te;将未标注样本集u划分为多个子集;步骤二:对训练集tr进行预处理,获取训练集tr中各训练样本的文本序列和标签序列;步骤三:通过对开源模型进行继续预训练获取多个预训练语言模型,通过预训练语言模型进行模型迁移,得到多个关键要素抽取基模型;步骤四:结合训练集tr中各训练样本的文本序列和标签序列,对训练集tr进行基于语义的数据增强,得到增强集en;步骤五:通过增强集en对多个关键要素抽取基模型进行参数更新;步骤六:对验证集va进行预处理,获取验证集va中各验证样本的文本序列和标签序列后分别输入至各个关键要素抽取基模型中,确定各个关键要素抽取基模型对应的最优关键要素抽取基模型;步骤七:判断是否满足训练停止准则;若满足训练停止准则,执行步骤十,若不满足训练停止准则,执行步骤八;步骤八:将未标注样本集u中的一个子集输入各个最优关键要素抽取基模型中,获取对应的已标注价值样本集;步骤九:将步骤八中获取的已标注价值样本集加入训练集tr中,将步骤八中的子集从未标注样本集u中移除;再重复步骤四至步骤九,直至满足训练停止准则;步骤十:通过最优关键要素抽取基模型对测试集te进行关键要素抽取。

9.优选的,所述步骤三包括:步骤3.1:通过舆情语料库对开源模型进行继续预训练,得到相应的预训练语言模型,所述预训练语言模型包括:deberta模型、lebert模型、cogbert模型、syntaxbert模型和sentence-bert模型;步骤3.2:对部分预训练语言模型进行模型迁移,得到的关键要素抽取基模型包括:deberta-bionlstm-mha-mcrf模型、lebert-bionlstm-mha-mcrf模型和cogbert-bionlstm-mha-mcrf模型。

10.优选的,所述步骤四包括:步骤4.1:定义训练集tr中的第i个训练样本tri的文本序列为si、标签序列为li,通过syntaxbert模型获取文本序列si中各字符的语义向量,并根据文本序列si、标签序列li提取训练样本tri中的各个实体样本形成实体样本子集enti,实体样本子集中的第j个实体样本entj=《strentj,typej》,其中strentj为实体样本entj的字符串表示,typej为实体样本entj的实体类别;

步骤4.2:对strentj的字符的语义向量求平均值,获取实体样本entj对应的实体向量entembj;步骤4.3:将所有训练样本对应的实体样本子集中的实体样本构成训练集的实体样本集ent,计算实体样本集ent中任意两个实体样本的实体向量之间的余弦相似度sim,当sim≥σ且两个实体样本的实体类别相同时,将这两个实体样本分别加入对方的语义邻居集合中,σ为预设的实体相似性阈值;步骤4.4:遍历每一个训练样本tri,若实体样本entj的语义邻居集合不是空集,则在entj的语义邻居集合中选取一个实体样本对entj进行替换,得到增强文本序列s

i*

及其对应的标签序列l

i*

,从而得到待评估的句子对样本pairi=《si,s

i*

》;步骤4.5:通过sentence-bert模型获取每一个待评估的句子对样本的句向量,其中si的句向量为senembi,s

i*

的句向量为senemb

i*

,计算senembi和senemb

i*

之间的余弦相似性simsem,当simsem≥β时,将增强文本序列s

i*

及其对应的标签序列l

i*

作为扩充样本,并将所有的扩充样本加入训练集tr中,得到增强集en;其中β为预设的句子相似性阈值。

11.优选的,所述步骤六中,以整个训练过程中各个关键要素抽取基模型中f1值最高的模型参数作为对应的各个最优关键要素抽取基模型的模型参数。

12.优选的,所述步骤七中,训练停止准则是各个最优关键要素抽取基模型在验证集va上的性能均已达到预设性能阈值α,或者是训练集tr已经达到预设数据量。

13.优选的,所述步骤八包括:步骤8.1:通过最优关键要素抽取基模型对子集us中的各个未标注样本um的文本序列usm进行预测,得到该样本对应的弱标签序列集;其中,m=1,2,

……

z,z为该子集中未标注样本的总数;步骤8.2:根据dropout一致性得分函数计算未标注样本um相较于整体模型的不确定性dacs(um);步骤8.3:通过sentence-bert模型分别获取未标注样本um的句向量senembm以及已标注样本的句向量,并对所有已标注样本的句向量进行聚类,得到d个聚类中心xd,d=1,2,

……

d;步骤8.4:计算未标注样本um与所有聚类中心的最大语义相似性simwt(um);步骤8.5:结合未标注样本um的不确定性和最大语义相似性,计算得到未标注样本um的信息密度info(um);若info(um)≥θ,则在该样本对应的弱标签序列集中,对于各最大概率标签序列对字符wk的预测标签,以出现次数最多的预测标签作为字符wk最终的标签,其中,字符wk为未标注样本um的文本序列usm中的第k个位置的字符;从而得到文本序列usm对应的标签序列ulm,将文本序列usm和标签序列ulm组成已标注价值样本,所有已标注价值样本构成已标注价值样本集vs。

14.优选的,所述步骤8.2中,通过表达式1)和表达式2)计算未标注样本um相较于整体模型的不确定性dacs(um):

ꢀꢀꢀꢀꢀꢀꢀꢀ

1);

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

2);其中,n为未标注样本um的序列长度,j为最优关键要素抽取基模型的模型个数,i和i’是参与计算的两个最优关键要素抽取基模型m*的模型下标,i=1,2,

……

j,i’=1,2,

……

j,且i≠i’;为最优关键要素抽取基模型m

i*

对字符wk的预测标签,为最优关键要素抽取基模型m

i’*

对字符wk的预测标签;所述步骤8.4中,通过表达式3)计算未标注样本um与所有聚类中心的最大语义相似性simwt(um):

ꢀꢀ

3);其中,函数表示min-max归一化函数,cosinesim(senembm,senembd)表示句向量senembm和聚类中心xd的句向量senembd之间的余弦相似度;所述步骤8.5中,通过表达式4)计算得到未标注样本um的信息密度info(um):

ꢀꢀꢀꢀꢀ

4);其中,μ为预设的调控因子。

15.优选的,所述步骤十包括:步骤10.1:将测试集te进行预处理并得到各测试样本的文本序列tsq;步骤10.2:通过完成训练后的各个最优关键要素抽取基模型分别对各测试样本的文本序列tsq进行预测,得到文本序列tsq对应的最大概率标签序列,将所有测试文本的最大概率标签序列构成候选标签序列集;步骤10.3:定义ae为文本序列tsq中的第e个位置的字符,在候选标签序列集中,对于各最大概率标签序列对字符ae的预测标签,以出现次数最多的预测标签作为字符ae最终的标签,从而得到文本序列tsq对应的最终标签序列tlq作为关键要素抽取结果。

16.本发明还提供了一种长文本的关键要素抽取系统,用于实现上述的长文本的关键要素抽取方法,包括定义模块、预处理模块、模型构建模块、数据增强模块、模型优化模块、样本扩充模块和模型测试模块;定义模块:用于获取长文本数据集;预处理模块:用于对文本数据进行预处理,获取文本序列和标签序列;模型构建模块:用于对开源模型进行继续预训练及模型迁移,得到关键要素抽取基模型;数据增强模块:用于对训练集tr进行数据增强,得到增强集en;模型优化模块:用于通过增强集对关键要素抽取基模型进行参数更新;样本扩充模块:用于生成已标注价值样本集,并将已标注价值样本集加入训练集tr中;模型测试模块:用于通过最优关键要素抽取基模型对测试集te进行关键要素抽取。

17.本发明还提供了一种终端设备,包括存储器、处理器以及存储在所述存储器中并

可以在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现上述的长文本的关键要素抽取方法的步骤。

18.应用本发明的技术方案,具有以下有益效果:(1)本发明中,通过使用一种融合数据增强、迁移学习、主动学习、弱监督学习的关键要素抽取方法,在低资源场景下能够筛选出信息量更为丰富的价值样本并精确高效地对其自动标注,同时在尽可能不改变原始文本句法结构和语义的情形下生成大量高质量的标注样本,显著减少了人工标注代价,对未标注样本进行了最大限度的充分利用,有效提升了关键要素抽取模型的性能,并行解决了基于传统小样本学习框架的关键要素抽取方法中生成的标注样本质量较低、要素抽取精度低下、专家标注价值样本的成本仍较高的问题。

19.(2)本发明中,通过在大规模舆情语料库上对开源模型进行继续预训练并对其进行基于参数的迁移学习,预训练语言模型将权重参数迁移至关键要素抽取基模型的共享参数中,构建得到多个可以充分挖掘文本中长距离依赖语义特征的关键要素抽取基模型,并在网络长文本领域数据较少的情况下最大限度地利用已有知识来初始化模型的性能,后续能够通过目标域的网络长文本标注数据对模型进行微调,辅助提升模型在网络长文本关键要素抽取任务上的性能,节约计算资源及成本。

20.(3)本发明中,基于语义进行数据增强,在对网络长文本数据进行数据增强时基于syntaxbert预训练语言模型、sentence-bert预训练语言模型对文本进行编码,相较于传统的预训练语言模型能够更好地编码文本的句法及语义信息,在增强过程中首先使用和原实体属于同一实体类别且和原实体具有相似语义的目标实体对原实体进行替换,得到经过实体替换后的增强句子,进一步保存与原句具有相似语义的增强句子及其标签序列。由于本方法能够高效编码文本的句法及语义信息,并保护实体层面和句子层面的语义特征信息,使得增强数据的质量得到更好的提升,所以本方法能够最大限度地减轻数据增强过程中实体层面及句子层面的语义信息流失,提高增强数据质量的同时显著减少人工标注代价,能够显著提升关键要素抽取模型的抽取精度。

21.(4)本发明中,以整个训练过程中各个关键要素抽取基模型中f1值最高的模型参数作为对应的各个最优关键要素抽取基模型的模型参数,这是因为f1值是精确率和召回率的调和平均值,同时平衡、兼顾了精确率和召回率,是一种更全面的评估指标。

22.(5)本发明中,通过融合dropout一致性指标(即不确定性)和语义相似性指标(即最大语义相似性),利用一种组合查询准则来选择价值样本,该准则既能够使得所选择出来的样本基于当前整体模型是最具有不确定性的,也通过语义相似性考虑了全局内样本的信息量,减缓了离群孤立样本为整体模型带来的负面影响。该组合查询准则相较于传统的主动学习采样准则更加全面地描述了待筛选样本,有利于挑选出信息量更为丰富的样本;使用多个最优关键要素抽取基模型对相同的价值样本进行预测来构建弱监督学习场景,通过实体级别的多模型投票方式对预测实体进行择优推断,进一步发挥不同弱监督模型的优势,可以在若干同质基模型的基础上进一步取得更高的关键要素抽取精度,集成模型相较于单个基模型具有更高的泛化性和鲁棒性。

23.除了上面所描述的目的、特征和优点之外,本发明还有其它的目的、特征和优点。下面将参照图,对本发明作进一步详细的说明。

附图说明

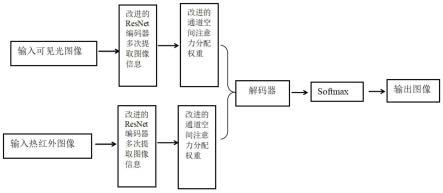

24.构成本技术的一部分的附图用来提供对本发明的进一步理解,本发明的示意性实施例及其说明用于解释本发明,并不构成对本发明的不当限定。在附图中:图1是本技术实施例1中一种长文本关键要素抽取方法的流程图;图2是本技术实施例1的一种长文本的关键要素抽取系统的结构示意图;其中,1、定义模块,2、预处理模块,3、模型构建模块,4、数据增强模块,5、模型优化模块,6、样本扩充模块,7、模型测试模块。

具体实施方式

25.以下结合附图对本发明的实施例进行详细说明,但是本发明可以根据权利要求限定和覆盖的多种不同方式实施。

26.实施例1:参见图1至图2,一种长文本的关键要素抽取方法、系统及终端设备,本实施例应用于网络长文本的关键要素抽取,便于从网络长文本中及时、准确地抽取出关键舆情信息。

27.一种长文本的关键要素抽取方法,参见图1(图中的s1-s10代表步骤一至步骤十),包括以下步骤:步骤一:在网络平台上获取网络长文本数据集,并将长文本数据集划分为标注样本集l和未标注样本集u;将标注样本集l划分为训练集tr、验证集va和测试集te;将未标注样本集u划分为多个子集;步骤二:对训练集tr进行预处理,获取训练集tr中各训练样本的文本序列和标签序列;步骤三:通过对开源模型进行继续预训练获取多个预训练语言模型,通过预训练语言模型进行模型迁移,得到多个关键要素抽取基模型mi;i=1,2,

……

j,j为关键要素抽取基模型的模型个数,具体包括以下子步骤:步骤3.1:从《人民数据》平台,采集约100万条互联网舆情文本,完成舆情语料库的构建;通过舆情语料库对开源模型进行继续预训练,得到相应的预训练语言模型,所述预训练语言模型包括:deberta模型、lebert模型、cogbert模型、syntaxbert模型和sentence-bert模型;步骤3.2:通过基于参数的迁移学习方法对部分所述预训练语言模型进行模型迁移,结合双向有序神经长短期记忆网络(bi-directional ordered neurons long short-term memory,bionlstm)、多头注意力机制(multi-head attention,mha)、添加掩码的条件随机场(masked conditional random field,mcrf),得到相应的关键要素抽取基模型mi,本实施例中,共得到三个关键要素抽取基模型:deberta-bionlstm-mha-mcrf模型(定义为m1)、lebert-bionlstm-mha-mcrf模型(定义为m2)和cogbert-bionlstm-mha-mcrf模型(定义为m3)。

28.通过在大规模舆情语料库上对开源模型进行继续预训练并对其进行基于参数的迁移学习,预训练语言模型将权重参数迁移至关键要素抽取基模型的共享参数中,构建得到多个可以充分挖掘文本中长距离依赖语义特征的关键要素抽取基模型,并在网络长文本领域数据较少的情况下最大限度地利用已有知识来初始化模型的性能,后续能够通过目标

域的网络长文本标注数据对模型进行微调,辅助提升模型在网络长文本关键要素抽取任务上的性能,节约计算资源及成本。

29.步骤四:结合训练集tr中各训练样本的文本序列和标签序列,对训练集tr进行基于语义的数据增强,得到增强集en;具体包括以下子步骤:步骤4.1:定义训练集tr中的第i个训练样本tri的文本序列为si、标签序列为li,通过syntaxbert模型获取文本序列si中各字符的语义向量,并根据文本序列si、标签序列li提取训练样本tri中的各个实体样本形成实体样本子集enti,实体样本子集中的第j个实体样本entj=《strentj,typej》,其中strentj为实体样本entj的字符串表示,typej为实体样本entj的实体类别;步骤4.2:对于实体样本子集enti中的每个实体样本entj,对构成字符串表示strentj的字符的语义向量求平均值,获取实体样本entj对应的实体向量entembj;步骤4.3:将所有训练样本对应的实体样本子集中的实体样本构成训练集的实体样本集ent,计算实体样本集ent中任意两个实体样本的实体向量之间的余弦相似度sim,当sim≥σ且两个实体样本的实体类别相同时,将这两个实体样本分别加入对方的语义邻居集合中,σ为预设的实体相似性阈值;例如,取训练集tr对应的实体样本集ent中的任意两个实体样本ent

x

、enty,这两个实体样本对应的语义邻居集合分别是ne

x

、ney,计算这两个实体样本的实体向量entemb

x

、entemby之间的余弦相似度sim,当sim≥σ且两个实体样本的实体类别type

x

=typey时,若ent

x

∉

ney,则将ent

x

加入ney中,若enty∉

ne

x

,则将enty加入ne

x

中。

30.步骤4.4:遍历每一个训练样本tri,若实体样本entj的语义邻居集合nej不是空集,则在entj的语义邻居集合中随机选取一个实体样本对entj进行替换,得到增强文本序列s

i*

及其对应的标签序列l

i*

,从而得到待评估的句子对样本pairi=《si,s

i*

》;步骤4.5:通过sentence-bert模型获取每一个待评估的句子对样本的句向量,其中si的句向量为senembi,s

i*

的句向量为senemb

i*

,计算senembi和senemb

i*

之间的余弦相似度simsem,当simsem≥β时,将增强文本序列s

i*

及其对应的标签序列l

i*

作为扩充样本,并将所有的扩充样本构建成扩充样本集exp,将扩充样本集exp加入训练集tr中,得到增强集en,即en=tr∪exp;其中β为预设的句子相似性阈值。

31.传统的文本数据增强方案通常基于简单数据增强(easy data augmentation,eda)实现,eda通过同义词替换、随机插入、随机交换和随机删除的加噪策略来生成与原始标注样本相似的扩充样本,但网络长文本关键要素抽取任务受实体上下文语义信息影响较大,将eda直接应用于网络长文本关键要素抽取任务中易生成语义不正确的扩充句子,带来更大的噪声影响,故在数据增强过程中应尽可能地保留实体层面和句子层面的语义信息。

32.针对上述问题,本实施例步骤四基于语义进行数据增强,在对网络长文本数据进行数据增强时基于syntaxbert预训练语言模型、sentence-bert预训练语言模型对文本进行编码,相较于传统的预训练语言模型能够更好地编码文本的句法及语义信息,在增强过程中首先使用和原实体属于同一实体类别且和原实体具有相似语义的目标实体对原实体进行替换,得到经过实体替换后的增强句子,进一步保存与原句具有相似语义的增强句子及其标签序列。由于本方法能够高效编码文本的句法及语义信息,并保护实体层面和句子层面的语义特征信息,使得增强数据的质量得到更好的提升,所以本方法能够最大限度地

减轻数据增强过程中实体层面及句子层面的语义信息流失,提高增强数据质量的同时显著减少人工标注代价,能够显著提升关键要素抽取模型的抽取精度。

33.步骤五:通过增强集en对多个关键要素抽取基模型进行训练,并实现参数更新;步骤六:对验证集va进行预处理,获取验证集va中各验证样本的文本序列和标签序列后分别输入至各个关键要素抽取基模型mi中,确定各个关键要素抽取基模型对应的最优关键要素抽取基模型m

i*

;具体是以整个训练过程中各个关键要素抽取基模型中f1值最高的模型参数作为对应的各个最优关键要素抽取基模型的模型参数,从而获得各个关键要素抽取基模型对应的最优关键要素抽取基模型m

i*

,这是因为f1值是精确率和召回率的调和平均值,同时平衡、兼顾了精确率和召回率,是一种更全面的评估指标。

34.步骤七:判断是否满足训练停止准则;训练停止准则是各个最优关键要素抽取基模型在验证集va上的性能均已达到预设性能阈值α,或者是训练集tr已经达到预设数据量。性能阈值α和预设数据量均根据实际需要进行设定。

35.若满足训练停止准则,执行步骤十,若不满足训练停止准则,执行步骤八;步骤八:将未标注样本集u中的一个子集输入各个最优关键要素抽取基模型中,获取对应的已标注价值样本集;具体包括以下子步骤:步骤8.1:通过最优关键要素抽取基模型m

1*

、m

2*

、m

3*

对子集us中的各个未标注样本um的文本序列usm进行预测,得到文本序列usm对应的最大概率标签序列分别为cl

m1

、cl

m2

、cl

m3

,将每个未标注样本对应的最大概率标签序列作为一组数据加入至该样本对应的弱标签序列集中,得到该样本对应的弱标签序列集clm;其中,m=1,2,

……

z,z为该子集us中未标注样本的总数;步骤8.2:根据dropout一致性得分函数计算未标注样本um相较于整体模型的不确定性dacs(um);具体是通过表达式1)和表达式2)计算未标注样本um相较于整体模型的不确定性dacs(um):

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

1);

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

2);其中,n为未标注样本um的序列长度,j为最优关键要素抽取基模型的模型个数,i和i’是参与计算的两个最优关键要素抽取基模型m*的模型下标,i=1,2,

……

j,i’=1,2,

……

j,且i≠i’;为最优关键要素抽取基模型m

i*

对字符wk的预测标签,为最优关键要素抽取基模型m

i’*

对字符wk的预测标签,字符wk为未标注样本um的文本序列usm中的第k个位置的字符。

36.当dacs(um)的值越大时,表明未标注样本um对于整体模型的不确定性越大,其标注价值也更高。

37.步骤8.3:通过sentence-bert模型获取未标注样本um的句向量senembm;通过

sentence-bert模型获取所有已标注样本的句向量,并对所有已标注样本的句向量进行聚类,得到d个聚类中心xd,d=1,2,

……

d;本实施例中,通过k-means 算法对所有已标注样本的句向量进行聚类。

38.步骤8.4:计算未标注样本um与所有聚类中心的最大语义相似性simwt(um);具体是通过表达式3)计算未标注样本um与所有聚类中心的最大语义相似性simwt(um):

ꢀꢀ

3);其中,函数表示min-max归一化函数,cosinesim(senembm,senembd)表示句向量senembm和聚类中心xd的句向量senembd之间的余弦相似度。

39.当simwt(um)的值越大时,表明未标注样本um属于已知类别的概率越大、所包含信息的代表性更高,反之则表明未标注样本um属于离群样本的概率越大、所包含信息的代表性较低。

40.步骤8.5:结合未标注样本um的不确定性和最大语义相似性,计算得到未标注样本um的信息密度info(um);具体是通过表达式4)计算得到未标注样本um的信息密度info(um):

ꢀꢀꢀꢀꢀꢀ

4);其中,μ为预设的调控因子,通过实际需要进行设置。

41.若info(um)≥θ,则在弱标签序列集clm中,对于各最大概率标签序列对字符wk的预测标签,以出现次数最多的预测标签作为字符wk最终的标签;从而得到文本序列usm对应的标签序列ulm,将文本序列usm和标签序列ulm组成已标注价值样本,所有已标注价值样本构成已标注价值样本集vs,已标注价值样本集vs中包括z

*

个已标注价值样本,z

*

≤z。

42.现有的许多方案都是通过主动学习来减少训练关键要素抽取模型所需的标注成本,常见方法中往往使用单种不确定性指标来筛选价值样本,但忽略了未标注样本之间的分布信息,为有效发挥不同主动学习采样准则在关键要素抽取任务上的优势,本方法通过融合dropout一致性指标(即不确定性)和语义相似性指标(即最大语义相似性),利用一种组合查询准则来选择价值样本,该准则既能够使得所选择出来的样本基于当前整体模型是最具有不确定性的,也通过语义相似性考虑了全局内样本的信息量,减缓了离群孤立样本为整体模型带来的负面影响。该组合查询准则相较于传统的主动学习采样准则更加全面地描述了待筛选样本,有利于挑选出信息量更为丰富的样本。

43.进一步的,使用多个最优关键要素抽取基模型对相同的已标注价值样本进行预测来构建弱监督学习场景,通过实体级别的多模型投票方式对预测实体进行择优推断,进一步发挥不同弱监督模型的优势,可以在若干同质基模型的基础上进一步取得更高的关键要素抽取精度,集成模型相较于单个基模型具有更高的泛化性和鲁棒性。

44.本方法通过有效融合主动学习、弱监督学习两种策略,节省了传统主动学习方法中专家标注数据的昂贵成本,能够筛选出信息量更为丰富的价值样本并精确高效地对其自动标注,显著减少了人工标注代价,充分利用未标注样本来提高关键要素抽取的性能。

45.步骤九:将步骤八中获取的已标注价值样本集vs加入训练集tr中形成新的训练集,可使训练集中的数据量增加,将步骤八中的子集us从未标注样本集u中移除,形成新的未标注样本集;再重复步骤四至步骤九,直至满足训练停止准则;

步骤十:通过最优关键要素抽取基模型对测试集te进行关键要素抽取。

46.步骤10.1:将测试集te进行预处理并得到各测试样本的文本序列tsq;步骤10.2:通过完成训练的各个最优关键要素抽取基模型m

1*

、m

2*

、m

3*

分别对各测试样本的文本序列tsq进行预测,得到文本序列tsq对应的最大概率标签序列tl

q1

、tl

q2

、tl

q3

,将所有测试文本的最大概率标签序列构成候选标签序列集tlq;步骤10.3:定义ae为文本序列tsq中的第e个位置的字符,在候选标签序列集tlq中,对于各最大概率标签序列对字符ae的预测标签,以出现次数最多的预测标签作为字符ae最终的标签,从而得到文本序列tsq对应的最终标签序列tlq作为关键要素抽取结果。

47.本实施例使用了一种融合数据增强、迁移学习、主动学习、弱监督学习的关键要素抽取方法,在低资源场景下能够筛选出信息量更为丰富的价值样本并精确高效地对其自动标注,同时在尽可能不改变原始文本句法结构和语义的情形下生成大量高质量的标注样本,显著减少了人工标注代价,对未标注样本进行了最大限度的充分利用,有效提升了关键要素抽取模型的性能,并行解决了基于传统小样本学习框架的关键要素抽取方法中生成的标注样本质量较低、要素抽取精度低下、专家标注价值样本的成本仍较高的问题。

48.对网络平台进行舆情监测时,通过本发明的方法可以从网络长文本中及时、准确地抽取出关键舆情信息,能够辅佐政府和企业发现网络舆情事件潜在的风险隐患以及焦点,推进舆情监测体系和社会治理能力现代化。

49.一种长文本的关键要素抽取系统,用于实现上述的长文本的关键要素抽取方法,包括定义模块1、预处理模块2、模型构建模块3、数据增强模块4、模型优化模块5、样本扩充模块6和模型测试模块7,如图2所示;定义模块1:用于获取网络长文本数据集,并将网络长文本数据集划分为标注样本集l和未标注样本集u;将标注样本集l划分为训练集tr、验证集va和测试集te;将未标注样本集u划分为多个子集。

50.预处理模块2:用于对训练集tr、验证集va和测试集te中的文本数据进行预处理,获取相应的文本序列和标签序列。

51.模型构建模块3:用于对开源模型进行继续预训练及模型迁移,得到关键要素抽取基模型mi。

52.数据增强模块4:用于对训练集tr进行数据增强,得到增强集en。

53.模型优化模块5:用于通过增强集en对各关键要素抽取基模型mi进行参数更新;将验证集va进行预处理后得到各验证样本的文本序列和标签序列后输入至各关键要素抽取基模型mi中,获取并保存验证集va中f1值最高的最优关键要素抽取基模型m

i*

用于测试集te的关键要素抽取;直至当前情况满足训练停止准则。

54.样本扩充模块6:若当前情况不满足训练停止准则,将未标注样本集u中的一个子集us输入各个最优关键要素抽取基模型m

i*

中进行预测,并通过改进的价值样本采样及标注准则对未标注样本进行筛选,得到已标注价值样本集vs,将获取的已标注价值样本集vs加入训练集tr中形成新的训练集,可使训练集中的数据量增加,将子集us从未标注样本集u中移除,形成新的未标注样本集。

55.模型测试模块7:将测试集te的测试样本的文本序列输入训练后的最优关键要素抽取基模型m

i*

中,得到各模型预测的最大概率标签序列,对各最大概率标签序列进行结果

集成,得到关键要素抽取结果。

56.一种终端设备,包括存储器、处理器以及存储在所述存储器中并可以在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现上述的长文本的关键要素抽取方法的步骤。

57.对比例1:本对比例与实施例1的区别在于,仅采用最优deberta-bionlstm-mha-mcrf模型(m

1*

)对关键要素进行抽取。

58.对比例2:本对比例与实施例1的区别在于,仅采用最优lebert-bionlstm-mha-mcrf模型(m

2*

)对关键要素进行抽取。

59.对比例3:本对比例与实施例1的区别在于,仅采用最优cogbert-bionlstm-mha-mcrf模型(m

3*

)对关键要素进行抽取。

60.对比例4:本对比例与实施例1的区别在于,采用ensemble模型(通过弱监督学习框架融合了m

1*

、m

2*

、m

3*

的集成模型)对关键要素进行抽取。

61.对比例5:本对比例与实施例1的区别在于,采用ensemble(al)模型对关键要素进行抽取,al(active learning)代表使用了主动学习策略。

62.对比例6:本对比例与实施例1的区别在于,采用ensemble(da)模型对关键要素进行抽取,da(data augmentation)代表使用了数据增强策略。

63.实施例1和上述对比例在验证集te上的实验结果如表1所示:表1:通过上表可知,与其他关键要素抽取模型相比,本方法的关键要素抽取模型在测试集上取得了最优的关键要素抽取结果,具有显著的技术效果。

64.以上所述仅为本发明的优选实施例而已,并不用于限制本发明,对于本领域的技

术人员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。