1.本发明涉及自然语言处理技术领域,特别是指一种中文文本智能分级改编方法及装置。

背景技术:

2.文本分级是指将文本按特定的等级体系进行定级,常见如:文本复杂度分级、文本可读性分级等。

3.分级标准是指文本分级所采用的特定等级体系,特指《国际中文教育中文水平等级标准》(gf0025—2021,以下简称《等级标准》)是面向中文作为第二语言的学习者的语言水平等级规范。《等级标准》将学习者中文水平分为“三等九级”,包括初、中、高三等,并以音节、汉字、词汇、语法四种语言基本要素构成“四维基准”。初等包含三个细分级别为1级、2级、3级,中等包括三个细分级别为4级、5级、6级。高等代表最高等级,下面的7、8、9级不再细分量化指标,记为7-9级。

4.基于分级标准的智能改编是指按照特定的分级标准将原文修改为指定的目标等级。

5.智能改编具有非常大的社会价值和现实应用价值。可以将同样的文本内容改写为多个级别,适用于不同人群的阅读、学习需要,这对于分级阅读体系构建,实现精准阅读和高效阅读都有重要的意义,不仅对教育领域有重要意义,对于信息的传播,新知识的扩散都有直接作用。

6.而目前,文本的智能改编通常是通过人工操作进行改编,即改编人员先对需要改编的原始句子进行人工等级标注,然后按照指定的等级对原始句子中的词进行近义词替换。人工改编存在效率低、错误率高的问题。

技术实现要素:

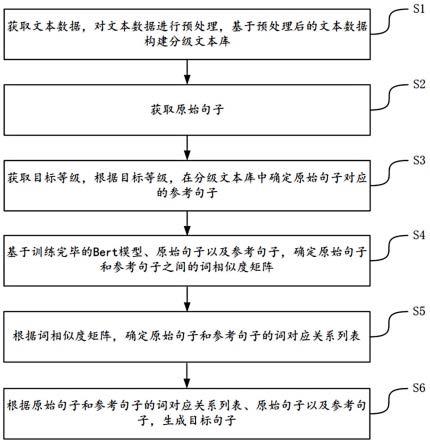

7.本发明实施例提供了一种中文文本智能分级改编方法及装置。所述技术方案如下:一方面,提供了一种中文文本智能分级改编方法,该方法由电子设备实现,该方法包括:s1、获取文本数据,对所述文本数据进行预处理,基于预处理后的文本数据构建分级文本库;s2、获取原始句子,确定所述原始句子的等级;s3、获取目标等级,根据目标等级,在所述分级文本库中确定所述原始句子对应的参考句子;s4、基于训练完毕的bert模型、原始句子以及参考句子,确定所述原始句子和参考句子之间的词相似度矩阵;s5、根据所述词相似度矩阵,确定所述原始句子与参考句子的词对应关系列表;

s6、根据所述原始句子与参考句子的词对应关系列表、所述原始句子以及所述参考句子,生成目标句子。

8.可选地,所述s1中的对所述文本数据进行预处理,基于文本数据以及对应的等级,构建分级文本库,包括:s11、对所述文本数据进行分句处理,得到多个待归类句子;s12、对多个待归类句子分别进行分级处理;s13、将分级处理后的待归类句子存入到分级文本库中对应的分级子库中。

9.可选地,所述s12中的对多个待归类句子分别进行分级处理,包括:s121、根据预设的分级标准,分别确定多个待归类句子中的每个待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级;s122、将所述每个待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级中的最高等级,确定为待归类句子的等级。

10.可选地,所述s3中的获取目标等级,根据目标等级,在所述分级文本库中确定所述原始句子对应的参考句子,包括:s31、获取目标等级,根据所述目标等级,在所述分级文本库中确定所述目标等级对应的目标分级子库,将所述目标分级子库中与所述原始句子的词数相同的多个句子确定为参考句子候选集合;s32、将所述原始句子输入到训练完毕的bert模型中,获取所述原始句子的每个词对应的词向量,对所有词对应的词向量进行平均池化操作,得到所述原始句子的向量表征;s33、将所述参考句子候选集合中的每个候选句子输入到训练完毕的bert模型中,获取每个候选句子的每个词对应的词向量,对所述每个候选句子的所有词对应的词向量进行平均池化操作,得到所述每个候选句子的向量表征;s34、根据所述原始句子的向量表征以及所述每个候选句子的向量表征,确定所述原始句子与所述每个候选句子的相似度,将相似度最大的候选句子确定为所述原始句子的参考句子。

11.可选地,所述s4中的基于训练完毕的bert模型、原始句子以及参考句子,确定所述原始句子和参考句子之间的词相似度矩阵,包括:s41、将所述原始句子输入训练完毕的bert模型中,得到所述原始句子的每个词对应的词向量;s42、将所述参考句子输入训练完毕的bert模型中,得到所述参考句子的每个词对应的词向量;s43、计算原始句子的每个词对应的词向量与所述参考句子的每个词对应的词向量之间的相似度,得到所述原始句子和参考句子之间的词相似度矩阵。

12.可选地,所述s5中的根据所述词相似度矩阵,确定所述原始句子与参考句子的词对应关系列表,包括:s51、设定k=1,x=0,y=0;s52、判断k是否大于n,如果k大于n,则转去执行s56,如果k小于或等于n,则执行s53;其中,n表示所述原始句子的词数量;s53、在所述词相似度矩阵中遍历所有非零元素,将相似度值最大的元素确定为目

标元素,将所述目标元素所在的行数赋值给x,将所述目标元素所在的列数赋值给y;s54、将所述词相似度矩阵的第x行元素均置为0,将所述词相似度矩阵的第y列元素均置为0;s55、将(x,y)记入词对应关系列表中;k=k 1,x=0,y=0,转去执行s52;s56、停止循环,生成词对应关系列表。

13.可选地,所述s6中的根据所述原始句子与参考句子的词对应关系列表、所述原始句子与所述参考句子,生成目标句子,包括:s61、设定j=1;s62、判断j是否大于n,如果j大于n,则执行s66;如果j小于或等于n,则执行s63;其中,n表示所述原始句子的词数量;s63、根据所述原始句子与参考句子的词对应关系列表,判断第j个位置处原始句子的词和参考句子的词是否相同;s64、如果第j个位置处原始句子的词和参考句子的词相同,则将原始句子的词确定为目标句子第j位置处的目标词;s65、如果第j个位置处原始句子的词和参考句子的词不相同,则判断所述原始句子的词的等级是否小于或等于目标等级,如果小于或等于目标等级,则将所述原始句子的词确定为目标句子第j位置处的目标词,如果大于目标等级,则将参考句子的词确定为目标句子第j位置处的目标词;j=j 1;转去执行s62s66、根据目标句子所有位置处的目标词,生成目标句子。

14.另一方面,提供了一种中文文本智能分级改编装置,该装置应用于中文文本智能分级改编方法,该装置包括:构建模块,用于获取文本数据,对所述文本数据进行预处理,基于文本数据以及对应的等级,构建分级文本库;第一确定模块,用于获取原始句子,确定所述原始句子的等级;第二确定模块,用于获取目标等级,根据目标等级,在所述分级文本库中确定所述原始句子对应的参考句子;第三确定模块,用于基于训练完毕的bert模型、原始句子以及参考句子,确定所述原始句子和参考句子之间的词相似度矩阵;第四确定模块,用于根据所述词相似度矩阵,确定所述原始句子与参考句子的词对应关系列表;生成模块,用于根据所述原始句子与参考句子的词对应关系列表、所述原始句子以及所述参考句子,生成目标句子。

15.可选地,所述构建模块,进一步用于:s11、对所述文本数据进行分句处理,得到多个待归类句子;s12、对多个待归类句子分别进行分级处理;s13、将分级处理后的待归类句子存入到分级文本库中对应的分级子库中。

16.可选地,所述构建模块,进一步用于:s121、根据预设的分级标准,分别确定多个待归类句子中的每个待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级;

s122、将所述每个待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级中的最高等级,确定为待归类句子的等级。

17.可选地,所述第二确定模块,进一步用于:s31、获取目标等级,根据所述目标等级,在所述分级文本库中确定所述目标等级对应的分级子库,将所述目标等级对应的分级子库中与所述原始句子的词数相同的多个句子确定为参考句子候选集合;s32、将所述原始句子输入到训练完毕的bert模型中,获取所述原始句子的每个词对应的词向量,对所有词对应的词向量进行平均池化操作,得到所述原始句子的向量表征;s33、将所述参考句子候选集合中的每个候选句子输入到训练完毕的bert模型中,获取每个候选句子的每个词对应的词向量,对所述每个候选句子的所有词对应的词向量进行平均池化操作,得到所述每个候选句子的向量表征;s34、根据所述原始句子的向量表征以及所述每个候选句子的向量表征,确定所述原始句子与所述每个候选句子的相似度,将相似度最大的候选句子确定为所述原始句子的参考句子。

18.可选地,所述第三确定模块,进一步用于:s41、将所述原始句子输入训练完毕的bert模型中,得到所述原始句子的每个词对应的词向量;s42、将所述参考句子输入训练完毕的bert模型中,得到所述参考句子的每个词对应的词向量;s43、计算原始句子的每个词对应的词向量与所述参考句子的每个词对应的词向量之间的相似度,得到所述原始句子和参考句子之间的词相似度矩阵。

19.可选地,所述第四确定模块,进一步用于:s51、设定x=1;s52、判断x是否大于n,如果x大于n,则转去执行s56,如果x小于或等于n,则执行s53;其中,n表示所述原始句子的词数量;s53、在所述词相似度矩阵中遍历所有非零元素,将相似度值最大的元素确定为目标元素,将所述目标元素所在的行数赋值给x,将所述目标元素所在的列数赋值给y;s54、将所述词相似度矩阵的第x行元素均置为0,将所述词相似度矩阵的第y列元素均置为0;s55、将(x,y)记入词对应关系列表中;k=k 1,x=0,y=0,转去执行s52;s56、停止循环,生成词对应关系列表。

20.可选地,所述生成模块,进一步用于:s61、设定j=1;s62、判断j是否大于n,如果j大于n,则执行s66;如果j小于或等于n,则执行s63;其中,n表示所述原始句子的词数量;s63、根据所述原始句子与参考句子的词对应关系列表,判断第j个位置处原始句子的词和参考句子的词是否相同;s64、如果第j个位置处原始句子的词和参考句子的词相同,则将原始句子的词确定为目标句子第j位置处的目标词;

s65、如果第j个位置处原始句子的词和参考句子的词不相同,则判断所述原始句子的词的等级是否小于或等于目标等级,如果小于或等于目标等级,则将所述原始句子的词确定为目标句子第j位置处的目标词,如果大于目标等级,则将参考句子的词确定为目标句子第j位置处的目标词;j=j 1;转去执行s62s66、根据目标句子所有位置处的目标词,生成目标句子。

21.另一方面,提供了一种电子设备,所述电子设备包括处理器和存储器,所述存储器中存储有至少一条指令,所述至少一条指令由所述处理器加载并执行以实现上述中文文本智能分级改编方法。

22.另一方面,提供了一种计算机可读存储介质,所述存储介质中存储有至少一条指令,所述至少一条指令由处理器加载并执行以实现上述中文文本智能分级改编方法。

23.本发明实施例提供的技术方案带来的有益效果至少包括:本发明实施例中,获取文本数据,对所述文本数据进行预处理,基于预处理后的文本数据构建分级文本库;获取原始句子,确定所述原始句子的等级;获取目标等级,根据目标等级,在所述分级文本库中确定所述原始句子对应的参考句子;基于训练完毕的bert模型、原始句子以及参考句子,确定所述原始句子和参考句子之间的词相似度矩阵;根据所述词相似度矩阵,确定所述原始句子与参考句子的词对应关系列表;根据所述原始句子与参考句子的词对应关系列表、所述原始句子以及所述参考句子,生成目标句子。本发明相对于人工改编的方式,智能改编的方式效率更高,适合用于大规模改编场景。同时严格基于等级标准,相对于人工改编的办法,可以减少人为错误,避免人与人个体差异导致的偏差,这样的改编结果更加统一齐整。

附图说明

24.为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

25.图1是本发明实施例提供的一种中文文本智能分级改编方法流程图;图2是本发明实施例提供的一种分级文本库的分级子库结构示意图;图3是本发明实施例提供的一种获得的词对应关系列表示意图;图4是本发明实施例提供的一种生成目标句子的过程示意图;图5是本发明实施例提供的一种中文文本智能分级改编装置框图;图6是本发明实施例提供的一种电子设备的结构示意图。

具体实施方式

26.为使本发明要解决的技术问题、技术方案和优点更加清楚,下面将结合附图及具体实施例进行详细描述。

27.本发明实施例提供了一种中文文本智能分级改编方法,该方法可以由电子设备实现,该电子设备可以是终端或服务器。如图1所示的中文文本智能分级改编方法流程图,该方法的处理流程可以包括如下的步骤:

s1、获取文本数据,对文本数据进行预处理,基于预处理后的文本数据构建分级文本库。

28.一种可行的实施方式中,文本数据可以由文字组成的篇章段落等,用于构建分级文本库,可以从现有的各途径获取数据,例如,扫描数据获取、网络文本抓取、人工编辑等。

29.可选地,s1中的对文本数据进行预处理,基于预处理后的文本数据构建分级文本库,包括:s11、对文本数据进行分句处理,得到多个待归类句子。

30.一种可行的实施方式中,需要说明的是,对文本数据进行分句处理的方法可以采用现有技术中常用的分句方法,如采用深度学习方法等,本发明实施例在此不做赘述。

31.s12、对多个待归类句子分别进行分级处理。

32.可选地,对多个待归类句子分别进行分级处理,可以包括下述步骤s121-s122:s121、根据预设的分级标准,分别确定多个待归类句子中的每个待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级。

33.其中,预设的分级标准是用户预先设置好的文本分级所采用的特定等级体系,优选地,可以是《国际中文教育中文水平等级标准》(gf0025—2021,以下简称《等级标准》)。《等级标准》是面向中文作为第二语言的学习者的语言水平等级规范。《等级标准》将学习者中文水平分为“三等九级”,包括初、中、高三等,并以音节、汉字、词汇、语法四种语言基本要素构成“四维基准”。初等包含三个细分级别为1级、2级、3级,中等包括三个细分级别为4级、5级、6级。高等代表最高等级,下面的7、8、9级不再细分量化指标,记为7-9级。

34.一种可行的实施方式中,s121可以具体包括以下步骤s1211-s1214:s1211、确定待归类句子的所有音节,并对每个音节进行分级。

35.具体地,确定待归类句子的所有音节后,将每个音节在《等级标准》中查找对应的等级,进而确定出每个音节的等级。

36.s1212、确定待归类句子的所有字,并对每个字进行分级。

37.具体地,确定待归类句子的所有字后,将每个字在《等级标准》中查找对应的等级,进而确定出每个字的等级。

38.s1213、确定待归类句子的所有词,并对每个词进行分级。

39.具体地,确定待归类句子的所有词后,将每个词在《等级标准》中查找对应的等级,进而确定出每个词的等级。

40.s1214、确定待归类句子的语法,并确定对应的语法等级。

41.具体地,确定待归类句子的语法后,将语法在《等级标准》中查找对应的等级,进而确定出对应的语法等级。

42.s122、将待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级中的最高等级,确定为待归类句子的等级。

43.举例来说,假设待归类句子是“小明的英语很流利”:(1)确定每个音节对应的等级:xiao:1级;ming:1级;de:1级;ying:2级;yu:1级;hen:1级;liu:2级;li:2级。

44.(2)确定每个字对应的等级:小:1级;明:1级;的:1级;英:2级;语:1级;很:1级;流:2级;利:2级。

45.(3)确定每个词对应的等级:小明:1级;的:1级;英语:2级;很:1级;流利:2级。

46.(4)确定待归类句子对应的语法等级:程度副词-很:1级。

47.在上述所有音节的等级、所有字的等级、所有词的等级以及语法等级中,最高等级为2级,因此,将该待归类句子的等级确定为2级。

48.s13、将分级处理后的待归类句子存入到分级文本库中对应的分级子库中。

49.一种可行的实施方式中,可以按照等级分别建立多个分级子库,然后,将分级处理后的待归类句子存入对应的分级子库中。参照图2,可以建立1级子库、2级子库、3级子库、4级子库、5级子库、6级子库以及7-9级子库,然后将分级处理后的待归类句子存入对应的分级子库中。

50.s2、获取原始句子。

51.一种可行的实施方式中,原始句子是用户想要进行改编的对象句子,原始句子的获取方式可以是用户输入的一句话,也可以是通过网络或数据库等方式获取的,本发明实施例对此不作限定。

52.举例来说,假设用户想要对句子“他的中文很地道”这句话进行改编,则用户可以手动将该句话输入到电子设备中,电子设备接收并将其设定为原始句子。

53.确定原始句子后,可以确定原始句子中的每个词的等级,确定词的等级的方法可以参照上述步骤s122中第(3)个确定词的等级的方法,此处不做赘述。

54.s3、获取目标等级,根据目标等级,在分级文本库中确定原始句子对应的参考句子。

55.一种可行的实施方式中,用户想将原始句子改编成某个等级,这个等级即为目标等级。目标等级的获取方式可以是用户手动输入到电子设备中,也可以是电子设备直接获取预先设置好的等级,本发明实施例对此不作限定。

56.可选地,s3中的获取目标等级,根据目标等级,在分级文本库中确定原始句子对应的参考句子,可以包括以下步骤s31-s34:s31、获取目标等级,根据目标等级,在分级文本库中确定目标等级对应的分级子库,将目标等级对应的分级子库中与原始句子的词数相同的多个句子确定为参考句子候选集合。

57.s32、将原始句子输入到训练完毕的bert模型中,获取原始句子的每个词对应的词向量,对所有词对应的词向量进行平均池化操作,得到原始句子的向量表征。

58.一种可行的实施方式中,将原始句子输入到训练完毕的bert模型中,获取最上层词向量。bert模型以及bert模型的训练方式可以采用现有技术的获取方式,本发明实施例对此不做赘述。

59.s33、将参考句子候选集合中的每个候选句子输入到训练完毕的bert模型中,获取每个候选句子的每个词对应的词向量,对每个候选句子的所有词对应的词向量进行平均池化操作,得到每个候选句子的向量表征。

60.需要说明的是,该步骤使用的bert模型可以与上述步骤s32中使用的bert模型是同一个模型。

61.s34、根据原始句子的向量表征以及每个候选句子的向量表征,确定原始句子与每个候选句子的相似度,将相似度最大的候选句子确定为原始句子的参考句子。

62.一种可行的实施方式中,分别计算原始句子的向量表征与每个候选句子的向量表征之间的余弦距离,作为原始句子与每个候选句子之间的相似度,将余弦距离最大的候选句子确定为原始句子的参考句子。

63.距离来说,用em_o表示原始句子的向量表征,用em_ci表示参考句子候选集合中的第i个候选句子,通过计算cos(em_s, em_ci)的值,来确定原始句子与第i个候选句子的相似度。

64.s4、基于训练完毕的bert模型、原始句子以及参考句子,确定原始句子和参考句子之间的词相似度矩阵。

65.需要说明的是,该步骤中使用的bert模型可以和上述步骤s32以及s33的bert模型是同一个模型。

66.可选地,s4中的基于训练完毕的bert模型、原始句子以及参考句子,确定原始句子和参考句子之间的词相似度矩阵,包括下述步骤s41-s43:s41、将原始句子输入训练完毕的bert模型中,得到原始句子的每个词对应的词向量。

67.需要说明的是,该步骤得到的原始句子的每个词对应的词向量和上述步骤s32中获得的词向量是意义相同的向量特征。

68.s42、将参考句子输入训练完毕的bert模型中,得到参考句子的每个词对应的词向量。

69.需要说明的是,该步骤得到的参考句子的每个词对应的词向量和上述步骤s33中获得的词向量是意义相同的向量特征。

70.s43、计算原始句子的每个词对应的词向量与参考句子的每个词对应的词向量之间的相似度,得到原始句子和参考句子之间的词相似度矩阵。

71.一种可行的实施方式中,假设原始句子的词数量以及参考句子的词数量均为n,通过计算两个词向量之间的余弦距离确定两个词向量之间的相似度,得到的词相似度矩阵为n

×

n的矩阵,具体的计算过程可以如下:用p表示原始句子中第p个词向量em_swp,用q表示原始句子中第q个词向量em_rwq,p以及q均为小于或等于n的正整数,则计算cos(em_swp, em_rwq),将得到的值作为词相似度矩阵中第p行、第q列的元素值。

72.s5、根据词相似度矩阵,确定原始句子与参考句子的词对应关系列表。

73.一种可行的实施方式中,在词相似度矩阵中遍历所有元素,确定元素值最大的元素,即相似度值最大的元素,确定其所在的行数x和列数y,进而可以确定原始句子的第x个词与参考句子的第y个词的相似度最大,将原始句子的第x个词与参考句子的第y个词确定为对应关系,记录(x,y),由于原始句子的第x个词的最相近的词已找到,参考句子的第y个词的最相近的词已找到,因此,将词相似度矩阵中的第x行元素和第y列元素置零,不再参与后续的遍历;再重新执行遍历词相似度矩阵,寻找下一对相似度最大的词组,直到找到n对,结束循环过程,其中,n为原始句子的词数量。

74.具体地,s5中的循环过程可以包括下述步骤s51-s56:

s51、设定k=1。

75.s52、判断k是否大于n,如果k大于n,则转去执行s56,如果k小于或等于n,则执行s53;其中,n表示原始句子的词数量。

76.s53、在词相似度矩阵中遍历所有非零元素,将相似度值最大的元素确定为目标元素,将目标元素所在的行数赋值给x,将目标元素所在的列数赋值给y。

77.s54、将词相似度矩阵的第x行元素均置为0,将词相似度矩阵的第y列元素均置为0。

78.s55、将(x,y)记入词对应关系列表中;k=k 1,x=0,y=0,转去执行s52。

79.s56、停止循环,生成词对应关系列表。

80.s6、根据原始句子与参考句子的词对应关系列表、原始句子以及参考句子,生成目标句子。

81.可选地,s6中的根据原始句子与参考句子的词对应关系列表、原始句子与参考句子,生成目标句子,可以包括以下步骤s61-s66:s61、设定j=1。

82.s62、判断j是否大于n,如果j大于n,则执行s66;如果j小于或等于n,则执行s63;其中,n表示原始句子的词数量。

83.s63、根据原始句子与参考句子的词对应关系列表,判断第j个位置处原始句子的词和参考句子的词是否相同。

84.s64、如果第j个位置处原始句子的词和参考句子的词相同,则将原始句子的词确定为目标句子第j位置处的目标词。

85.s65、如果第j个位置处原始句子的词和参考句子的词不相同,则判断原始句子的词的等级是否小于或等于目标等级,如果小于或等于目标等级,则将原始句子的词确定为目标句子第j位置处的目标词,如果大于目标等级,则将参考句子的词确定为目标句子第j位置处的目标词;j=j 1;转去执行s62。

86.s66、根据目标句子所有位置处的目标词,生成目标句子。

87.一种可行的实施方式中,将目标句子所有位置处的目标词按照顺序排好,组成的句子即为目标句子。

88.举例说明根据原始句子与参考句子的词对应关系列表、原始句子与参考句子,生成目标句子的过程:假设原始句子为“他的中文很地道”,参考句子为“小明的英语很流利”,目标等级为2级,获得的词对应关系列表如图3所示,则生成目标句子的过程参照图4所示:对于第1个位置的词,判断出原始句子的词“他”与参考句子的词“小明”不相同,进而,判断出原始句子的词“他”的等级为1级,小于目标等级2级,因此,将原始句子的词“他”确定为目标句子第1个位置处的目标词;对于第2个位置的词,判断原始句子的词“的”与参考句子的词“的”相同,因此,将原始句子的词“的”确定为目标句子第2个位置处的目标词;对于第3个位置的词,判断原始句子的词“中文”与参考句子的词“英语”不相同,进而判断出原始句子的词“中文”的等级为1级,小于目标等级2级,因此,将原始句子的词“中文”确定为目标句子第3个位置处的目标词;

对于第4个位置的词,判断原始句子的词“很”与参考句子的词“很”相同,因此,将原始句子的词“很”确定为目标句子第4个位置处的目标词;对于第5个位置的词,判断原始句子的词“地道”与参考句子的词“流利”不相同,进而判断出原始句子的词“地道”的等级为7-9级,大于目标等级2级,因此,将参考句子的词“流利”确定为目标句子第5个位置处的目标词。

89.最终将“他”、“的”、“中文”、“很”、“流利”按照顺序组成一句话“他的中文很流利”,即得到目标句子。

90.本发明实施例中,获取文本数据,对所述文本数据进行预处理,基于预处理后的文本数据构建分级文本库;获取原始句子,确定所述原始句子的等级;获取目标等级,根据目标等级,在所述分级文本库中确定所述原始句子对应的参考句子;基于训练完毕的bert模型、原始句子以及参考句子,确定所述原始句子和参考句子之间的词相似度矩阵;根据所述词相似度矩阵,确定所述原始句子与参考句子的词对应关系列表;根据所述原始句子与参考句子的词对应关系列表、所述原始句子以及所述参考句子,生成目标句子。本发明相对于人工改编的方式,智能改编的方式效率更高,适合用于大规模改编场景。同时严格基于等级标准,相对于人工改编的办法,可以减少人为错误,避免人与人个体差异导致的偏差,这样的改编结果更加统一齐整。

91.图5是根据一示例性实施例示出的一种中文文本智能分级改编装置框图。参照图5,该装置500包括:构建模块510,用于获取文本数据,对所述文本数据进行预处理,基于文本数据以及对应的等级,构建分级文本库;第一确定模块520,用于获取原始句子,确定所述原始句子的等级;第二确定模块530,用于获取目标等级,根据目标等级,在所述分级文本库中确定所述原始句子对应的参考句子;第三确定模块540,用于基于训练完毕的bert模型、原始句子以及参考句子,确定所述原始句子和参考句子之间的词相似度矩阵;第四确定模块550,用于根据所述词相似度矩阵,确定所述原始句子与参考句子的词对应关系列表;生成模块560,用于根据所述原始句子与参考句子的词对应关系列表、所述原始句子以及所述参考句子,生成目标句子。

92.可选地,所述构建模块510,进一步用于:s11、对所述文本数据进行分句处理,得到多个待归类句子;s12、对多个待归类句子分别进行分级处理;s13、将分级处理后的待归类句子按照等级存入到分级文本库的分级子库中。

93.可选地,所述构建模块510,进一步用于:s121、根据预设的分级标准,分别确定多个待归类句子中的每个待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级;s122、将所述每个待归类句子的每个音节的等级、每个字的等级、每个词的等级以及语法等级中的最高等级,确定为待归类句子的等级。

94.可选地,所述第二确定模块530,进一步用于:

s31、获取目标等级,根据所述目标等级,在所述分级文本库中确定所述目标等级对应的目标分级子库,将所述目标分级子库中与所述原始句子的词数相同的多个句子确定为参考句子候选集合;s32、将所述原始句子输入到训练完毕的bert模型中,获取所述原始句子的每个词对应的词向量,对所有词对应的词向量进行平均池化操作,得到所述原始句子的向量表征;s33、将所述参考句子候选集合中的每个候选句子输入到训练完毕的bert模型中,获取每个候选句子的每个词对应的词向量,对所述每个候选句子的所有词对应的词向量进行平均池化操作,得到所述每个候选句子的向量表征;s34、根据所述原始句子的向量表征以及所述每个候选句子的向量表征,确定所述原始句子与所述每个候选句子的相似度,将相似度最大的候选句子确定为所述原始句子的参考句子。

95.可选地,所述第三确定模块540,进一步用于:s41、将所述原始句子输入训练完毕的bert模型中,得到所述原始句子的每个词对应的词向量;s42、将所述参考句子输入训练完毕的bert模型中,得到所述参考句子的每个词对应的词向量;s43、计算原始句子的每个词对应的词向量与所述参考句子的每个词对应的词向量之间的相似度,得到所述原始句子和参考句子之间的词相似度矩阵。

96.可选地,所述第四确定模块550,进一步用于:s51、设定k=1;s52、判断k是否大于n,如果k大于n,则转去执行s56,如果k小于或等于n,则执行s53;其中,n表示所述原始句子的词数量;s53、在所述词相似度矩阵中遍历所有非零元素,将相似度值最大的元素确定为目标元素,将所述目标元素所在的行数赋值给x,将所述目标元素所在的列数赋值给y;s54、将所述词相似度矩阵的第x行元素均置为0,将所述词相似度矩阵的第y列元素均置为0;s55、将(x,y)记入词对应关系列表中;k=k 1,x=0,y=0,转去执行s52;s56、停止循环,生成词对应关系列表。

97.可选地,所述生成模块560,进一步用于:s61、设定j=1;s62、判断j是否大于n,如果j大于n,则执行s66;如果j小于或等于n,则执行s63;其中,n表示所述原始句子的词数量;s63、根据所述原始句子与参考句子的词对应关系列表,判断第j个位置处原始句子的词和参考句子的词是否相同;s64、如果第j个位置处原始句子的词和参考句子的词相同,则将原始句子的词确定为目标句子第j位置处的目标词;s65、如果第j个位置处原始句子的词和参考句子的词不相同,则判断所述原始句子的词的等级是否小于或等于目标等级,如果小于或等于目标等级,则将所述原始句子的词确定为目标句子第j位置处的目标词,如果大于目标等级,则将参考句子的词确定为目标

句子第j位置处的目标词;j=j 1;转去执行s62s66、根据目标句子所有位置处的目标词,生成目标句子。

98.本发明实施例中,获取文本数据,对所述文本数据进行预处理,基于预处理后的文本数据构建分级文本库;获取原始句子,确定所述原始句子的等级;获取目标等级,根据目标等级,在所述分级文本库中确定所述原始句子对应的参考句子;基于训练完毕的bert模型、原始句子以及参考句子,确定所述原始句子和参考句子之间的词相似度矩阵;根据所述词相似度矩阵,确定所述原始句子与参考句子的词对应关系列表;根据所述原始句子与参考句子的词对应关系列表、所述原始句子以及所述参考句子,生成目标句子。本发明相对于人工改编的方式,智能改编的方式效率更高,适合用于大规模改编场景。同时严格基于等级标准,相对于人工改编的办法,可以减少人为错误,避免人与人个体差异导致的偏差,这样的改编结果更加统一齐整。

99.图6是本发明实施例提供的一种电子设备600的结构示意图,该电子设备600可因配置或性能不同而产生比较大的差异,可以包括一个或一个以上处理器(central processing units,cpu)601和一个或一个以上的存储器602,其中,所述存储器602中存储有至少一条指令,所述至少一条指令由所述处理器601加载并执行以实现上述中文文本智能分级改编方法的步骤。

100.在示例性实施例中,还提供了一种计算机可读存储介质,例如包括指令的存储器,上述指令可由终端中的处理器执行以完成上述中文文本智能分级改编方法。例如,所述计算机可读存储介质可以是rom、随机存取存储器(ram)、cd-rom、磁带、软盘和光数据存储设备等。

101.本领域普通技术人员可以理解实现上述实施例的全部或部分步骤可以通过硬件来完成,也可以通过程序来指令相关的硬件完成,所述的程序可以存储于一种计算机可读存储介质中,上述提到的存储介质可以是只读存储器,磁盘或光盘等。

102.以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。